Агенты без скриптов: что происходит, когда ИИ сталкивается с реальностью

Агенты на базе MCP сегодня умеют многое: искать в вебе, работать с файлами, строить графики, считать и вызывать внешние API. Но одно дело — демонстрация на единичной задаче, другое — устойчивая работа в реалистичной, меняющейся среде, где ответы сервисов отличаются от прогона к прогону, а на выбор доступно сразу несколько десятков инструментов. Большинство имеющихся бенчмарков этого не отражают: они короткие, синтетические, часто без помех и почти всегда с фиксированным правильным ответом, который устаревает. Авторы LiveMCP-101 попытались закрыть этот пробел.

Что такое LiveMCP-101

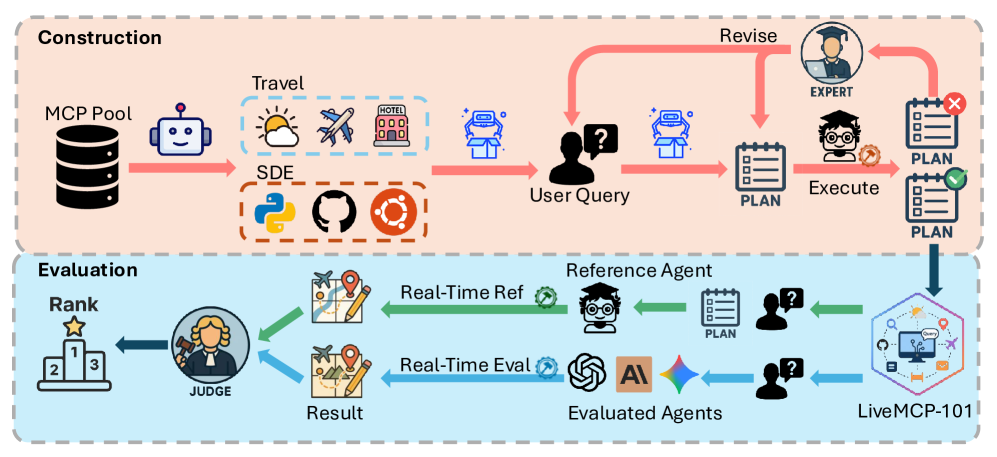

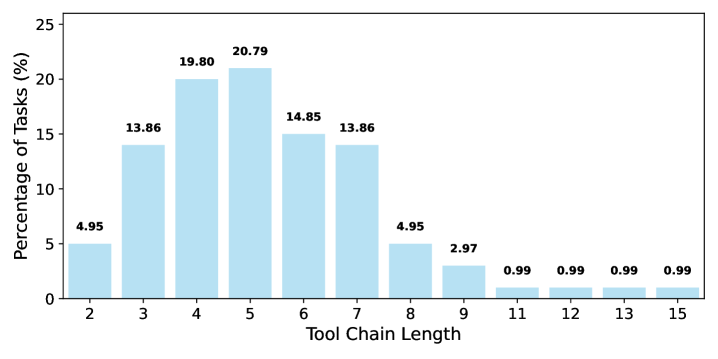

LiveMCP-101 — это набор из 101 реального запроса, который заставляет агента координировать несколько MCP-инструментов. Домены — веб-поиск, работа с файлами, математика [1] и анализ данных. Есть три уровня сложности: 30 простых, 30 средних и 41 сложный. В среднем задача требует около пяти-шести осмысленных шагов, иногда — десятка и больше.

Чтобы сделать оценку устойчивой к «живым» ответам внешних сервисов, авторы отказались от идеи фиксировать сырой API-выход. Вместо этого для каждой задачи подготовлен эталонный план выполнения. Он уточнялся по траектории эталонного агента, пока не начинал стабильно приводить к правильному результату. Такой план — не скрипт ради скрипта, а последовательность осмысленных действий и параметров, которую можно сопоставить с тем, что делает тестируемая модель.

Как это оценивают «вживую»

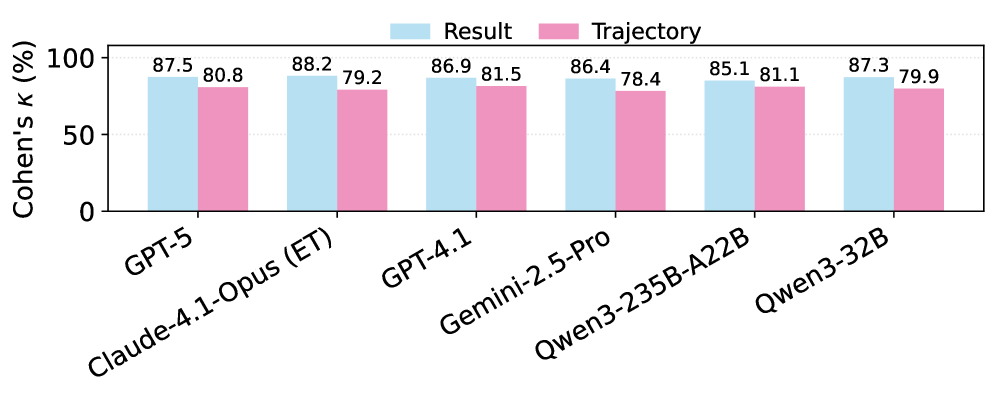

Каждая задача запускается в двух потоках. Первый — референс: агент строго следует плану и получает эталонный выход. Второй — тест: модели дают только формулировку запроса и большой пул MCP-инструментов (15 серверов и 76–125 инструментов). Оценка идет по нескольким метрикам: доля полностью решённых задач (TSR), средний балл результата (ARS), качество траектории (ATS), а также средние токены и число вызовов инструментов. Судья — LLM, чьи оценки проверяли н а согласованность с людьми: совпадение высокое, особенно по итоговым ответам.

Что показали эксперименты

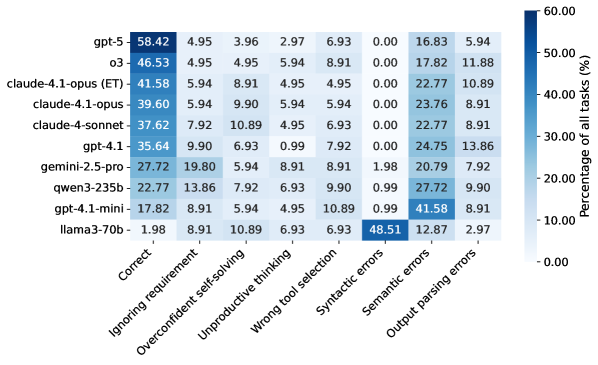

Главное наблюдение простое и важное: даже сильнейшие сегодняшние LLM справляются меньше чем в 60% случаев. Лидер — GPT-5 с TSR 58.42% в среднем по бенчмарку и 39.02% на сложном уровне. Далее — o3 и GPT-5-mini, затем флагманские модели Anthropic. Средний эшелон заметно отстает, а открытые модели — еще сильнее: у лучших из них показатели в районе 20–23% TSR, а у некоторых — единицы процентов.

Качество траектории почти всегда согласуется с качеством ответа: чем осмысленнее и чище путь к решению, тем выше итог. При этом «словоблудие» не спасает: рост потраченных токенов после определенного порога дает у топ-моделей небольшую отдачу. Открытые модели часто тратят больше токенов и больше раз дергают инструменты, но это не конвертируется в надежные ответы. Усиленные рассуждающие цепочки заметно помогают — за счет лучшего планирования и восстановления после ошибок.

Где агенты спотыкаются

Анализ отказов выделяет семь типичных сбоев, которые складываются в три класса:

-

Планирование и оркестрация: игнор требований или раннее завершение; попытка «решить в голове» без нужных инструментов; длинное непродуктивное рассуждение; неверный выбор инструмента.

-

Параметры: синтаксические ошибки [2] (не тот формат или тип), и семантические ошибки (форма правильная, смысл — нет: неверный идентификатор, забытые ограничения).

-

Постобработка: инструмент вернул корректный ответ, но агент его неправильно распарсил.

Доминируют семантические ошибки параметров — у сильных моделей это 16–25% всех неудач, у малых — более 40%. Часто встречается и самоуверенное решение, когда агент игнорирует инструменты и описывает ответ словами.

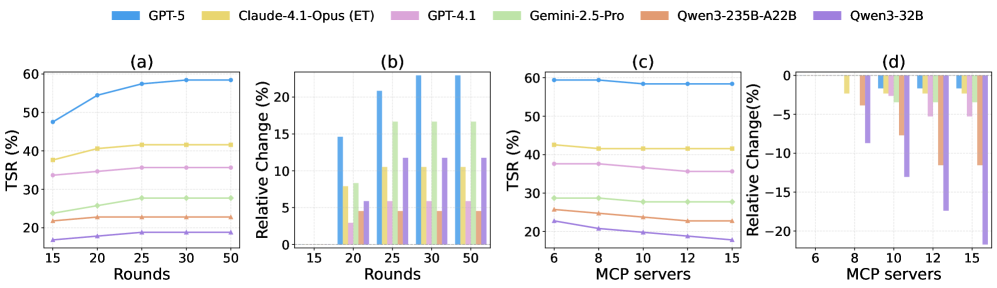

Что меняют настройки

Авторы изучили два рычага. Во-первых, лимит итераций: увеличение примерно до 25 раундов стабильно улучшает успех, дальше — затухание эффекта. Во-вторых, ширина пула инструментов: чем больше серверов, тем чаще слабые и средние модели теряют точность. Топ-модели устойчивее, потому что лучше фильтруют шум и планируют экономнее.

Почему это важно

LiveMCP-101 приближает оценку агентов к реальности: не «идеальный» офлайн-ответ, а работа с меняющимся миром, в большом пространстве инструментов, под контролем эталонного плана. Такой формат помогает фиксировать не только «правильность», но и качество пути, что критично для практических кейсов. Результаты показывают, что главный резерв — в планировании, надежной селекции инструментов, умении подбирать корректные параметры и аккуратно собирать итог. Отдельная тема — эффективность по токенам: нужен разумный баланс между мышлением [3], проверками и ранним завершением. Для открытого стека напрашиваются дообучение на схемах MCP и задачах с шумом, а также методы более строгой верификации промежуточных шагов.

📜 Полная статья [4]

***

Если вам интересна тема ИИ, [5]подписывайтесь на мой Telegram-канал [6] [7]– там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [8]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/19468

URLs in this post:

[1] математика: http://www.braintools.ru/article/7620

[2] ошибки: http://www.braintools.ru/article/4192

[3] мышлением: http://www.braintools.ru/thinking

[4] 📜 Полная статья: https://arxiv.org/abs/2508.15760

[5] : https://t.me/+mP35nQPhgXZmZDYy

[6] подписывайтесь на мой Telegram-канал: https://t.me/+sU9T9hmHPKYwNTYy

[7] : https://t.me/+9nDCqOqSLiM3NTVi

[8] Источник: https://habr.com/ru/articles/946626/?utm_source=habrahabr&utm_medium=rss&utm_campaign=946626

Нажмите здесь для печати.