Почему ИИ галлюцинирует и как он учится управлять миром в матрице — лучшие статьи об ИИ за август 2025

ИИ всё чаще выходит за рамки однотипных задач и начинает демонстрировать качества, похожие на человеческие: он рискует, хитрит, ошибается и… делает это с полной уверенностью в своей правоте. В августовском обзоре — статьи о том, почему модели галлюцинируют и как можно сместить стимулы в сторону честности, зачем агентам память [1] и когнитивные карты, как построить мультиагентные системы без хаоса и что значит по-настоящему интерактивный мир для обучения [2] ИИ; от новых методов борьбы с выдумками и систем глубоких исследований до роботов, умеющих готовить завтрак и ориентироваться в реальном пространстве. В этой статье новые архитектуры, метрики и фреймворки, которые уже меняют подход к созданию ИИ-агентов.

Если хотите быть в курсе новейших исследований в области ИИ, подписывайтесь на Dataism Lab [3] — там ежедневно выходят обзоры свежих научных публикаций. А ещё приглашаю в мой Telegram-канал [4]: здесь я делюсь кейсами внедрения ИИ в бизнес, опытом [5] создания стартапов и личными мыслями о будущем технологий. Поехали!

1. Почему LLM врут с умным видом

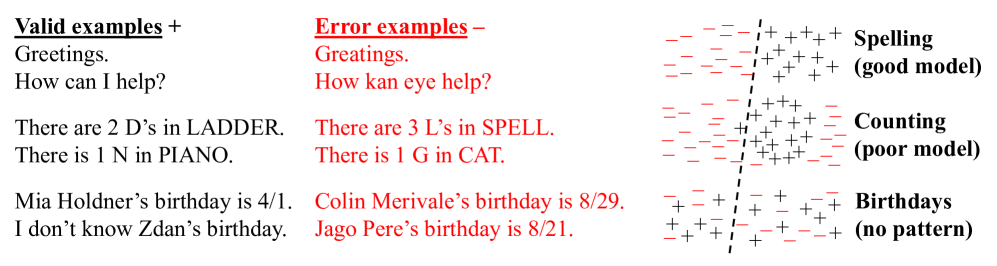

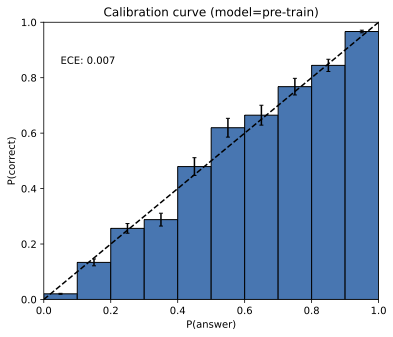

Исследование OpenAI разбирает корень проблемы галлюцинаций LLM: модели часто «уверенно ошибаются», потому что сама цель обучения и оценки подталкивает их к угадыванию. Даже если данные безошибочны, оптимизация по кросс-энтропии заставляет модель генерировать ответы, а бенчмарки с бинарной системой оценки (1 за верно, 0 за неверно и за «не знаю») закрепляют эту стратегию. В итоге выигрывают не самые надёжные модели, а те, что чаще рискуют.

Авторы формализуют проблему через идею «валидно/невалидно» и показывают статистическую закономерность: генеративная ошибка [6] не может быть меньше, чем удвоенная ошибка классификатора, который лишь различает правильность ответа. Особенно это заметно на произвольных фактах (например, датах рождения), где закономерности нет — и там доля ошибок предсказуема. Анализ показывает: постобучение вроде RLHF не убирает галлюцинации, потому что метрики продолжают поощрять догадки вместо безопасного отказа.

Главное предложение исследователей — изменить систему оценки. Если встроить в бенчмарки явный порог уверенности, при котором модель отвечает только в случае высокой вероятности быть правой, а иначе говорит «не знаю», стимулы смещаются в сторону честности. Это позволит формировать LLM, которые не просто сильны в тестах, но и надёжны как помощники: они перестанут выдавать выдумки там, где данных или уверенности мало. Для практики это значит более прозрачное понимание границ возможностей моделей и реальное снижение числа галлюцинаций.

🔍 Подробнее [8]

2. Глубокие исследования без границ: выбираем свою LLM и управляем стратегией поиска

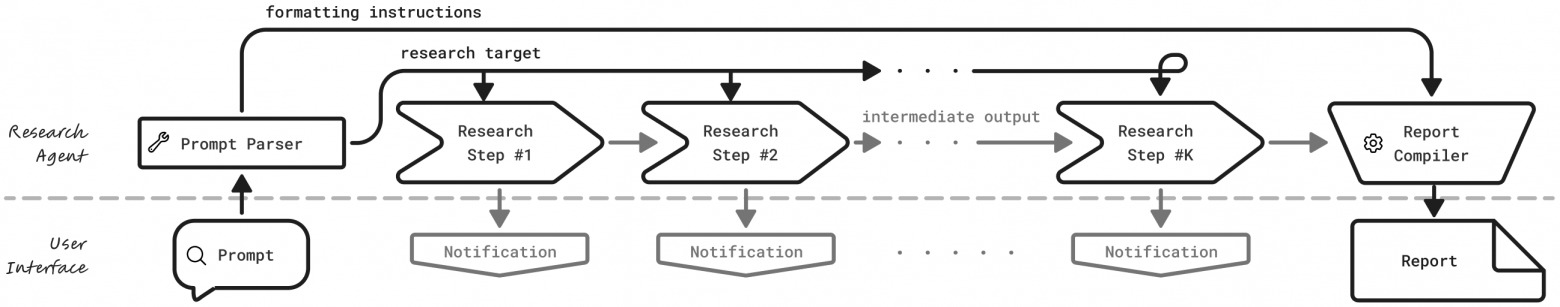

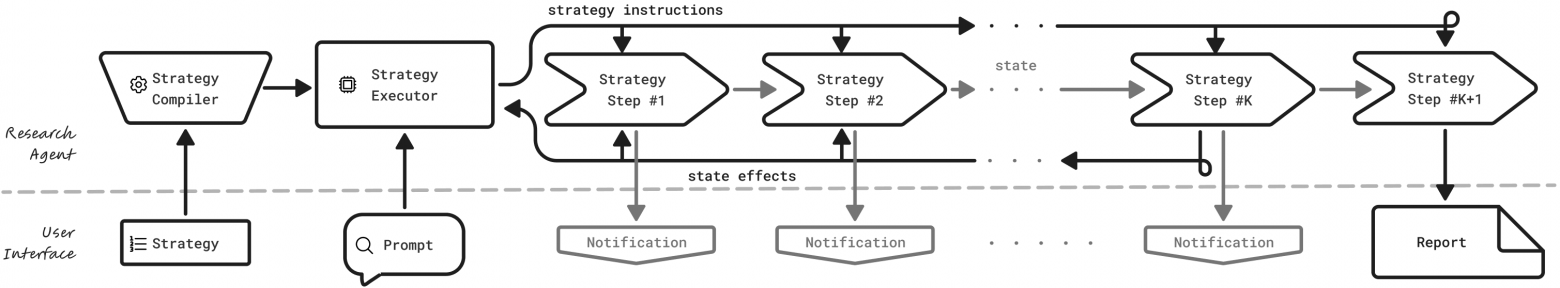

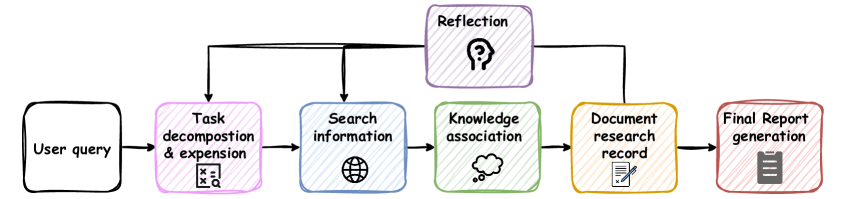

Исследование Universal Deep Research (UDR) нацелено на решение проблемы, которая стоит перед современными инструментами “глубоких исследований”: закрытость и негибкость. Текущие системы вроде Perplexity или OpenAI Deep Research дают хороший результат, но скрывают стратегию поиска и не позволяют пользователю задавать собственные правила проверки источников, менять модель или управлять затратами. Авторы UDR предложили концепцию, где стратегия и модель разведены: пользователь описывает алгоритм шагов на естественном языке, система превращает его в исполняемый код, а LLM используется лишь как вспомогательный интеллект [10].

Такой подход дает сразу несколько преимуществ. Код работает стабильнее длинных промтов, легко проверяется и воспроизводится, а сама оркестрация не зависит от “черного ящика” модели. Благодаря изолированному исполнению повышается безопасность, а прозрачные уведомления и сохранение промежуточных данных позволяют отслеживать каждый шаг исследования. Это снижает риски, дает контроль над источниками и бюджетом, а также делает систему пригодной для критически важных доменов — от финансов до здравоохранения.

В результате UDR открывает новый уровень кастомизации: можно запускать любую стратегию на любой LLM и адаптировать тактику под задачу — от быстрых обзоров до многоступенчатых экспертиз. Это меняет саму логику [11] конкуренции: разработчики моделей сосредотачиваются на качестве рассуждений, а исследователи — на качестве стратегий. Для бизнеса и науки это означает переход к более надежным, прозрачным и воспроизводимым инструментам анализа информации.

🔍 Подробнее [12]

💾 Код [14]

3. Как дообучать LLM на лету с помощью памяти вместо файнтюнинга

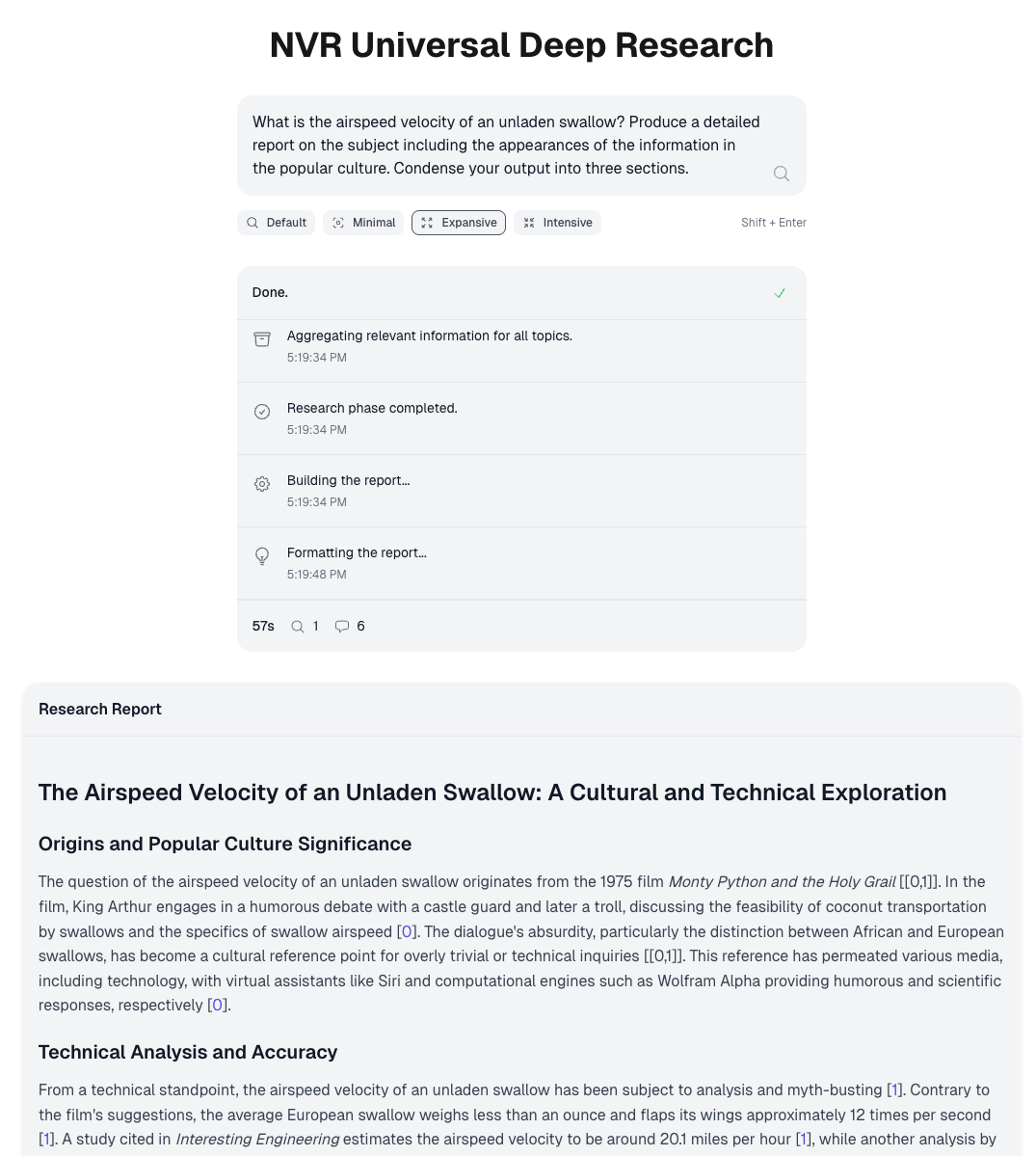

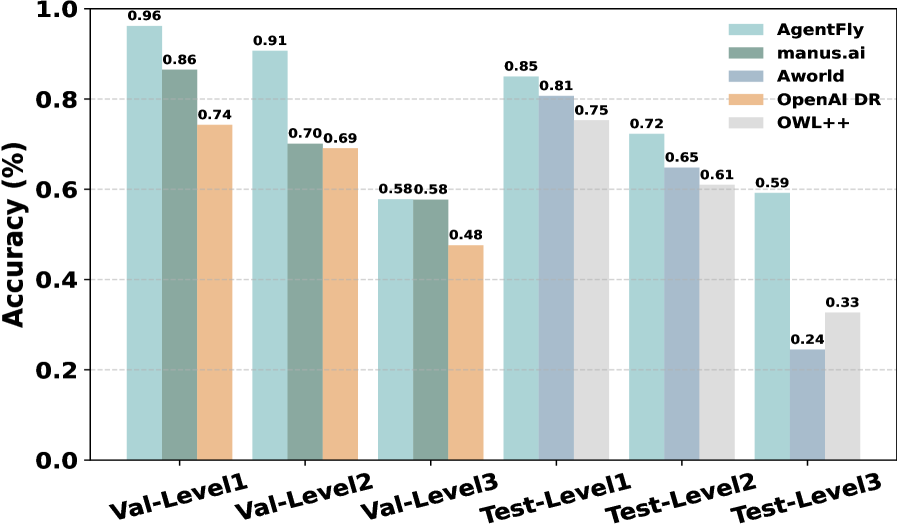

Исследование AgentFly предлагает свежий взгляд на развитие интеллектуальных агентов: вместо традиционного дообучения больших языковых моделей (LLM) с изменением весов здесь делается ставка на память. Авторы исходят из того, что реальные задачи требуют не одного ответа на промт, а цепочки действий — поиска, кода, чтения документов, проверки гипотез. AgentFly хранит опыт прошлых решений в виде кейсов и при встрече с новой задачей извлекает наиболее релевантные, чтобы строить план действий. Такой подход формализован как марковский процесс принятия решений с памятью, где политика выбора кейсов обучается онлайн, а сама LLM остаётся «замороженной».

Испытания показали, что память действительно усиливает агента: на бенчмарках GAIA и DeepResearcher он превзошёл даже модели с классическим дообучением, а на SimpleQA достиг рекордных 95% точности. Особенно заметна польза в задачах вне распределения: перенос стратегий через аналогии дал прирост до 9,6 процентных пунктов. Важным наблюдением стало то, что небольшая, но качественная память работает лучше бесконтрольного накопления данных, а краткие структурированные планы планировщика оказываются продуктивнее длинных размышлений.

Главный вывод исследования: адаптивных агентов можно строить без затратного файнтюнинга. Память превращает обучение в непрерывный процесс — система накапливает успешный опыт и тут же применяет его к новым вызовам. Это открывает дорогу к созданию устойчивых и доступных интеллектуальных помощников для науки, бизнеса и образования. В будущем остаётся решить задачи «гигиены памяти» и организации обмена кейсами между агентами, но сам подход уже приближает нас к системам, которые учатся и действуют так же естественно, как человек.

🔍 Подробнее [15]

💾 Код [17]

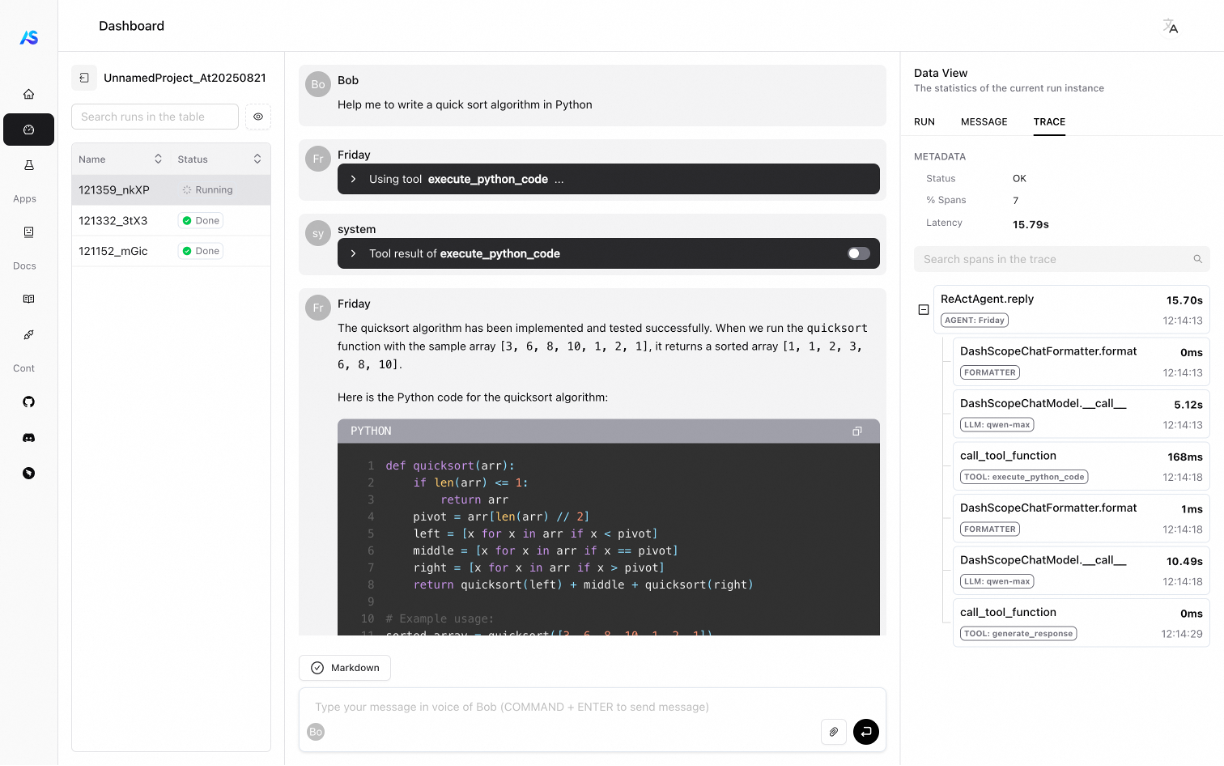

4. Как построить мультиагентную систему, которая реально работает без магии и костылей

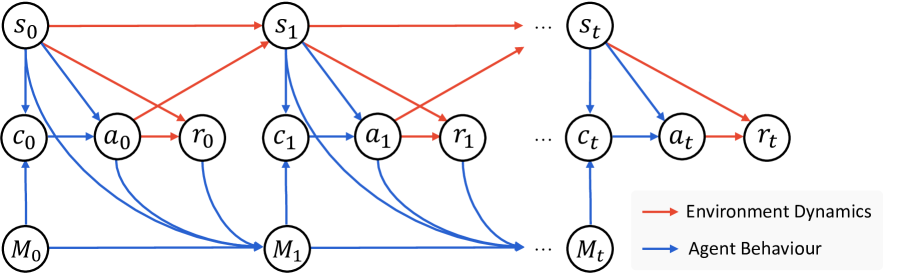

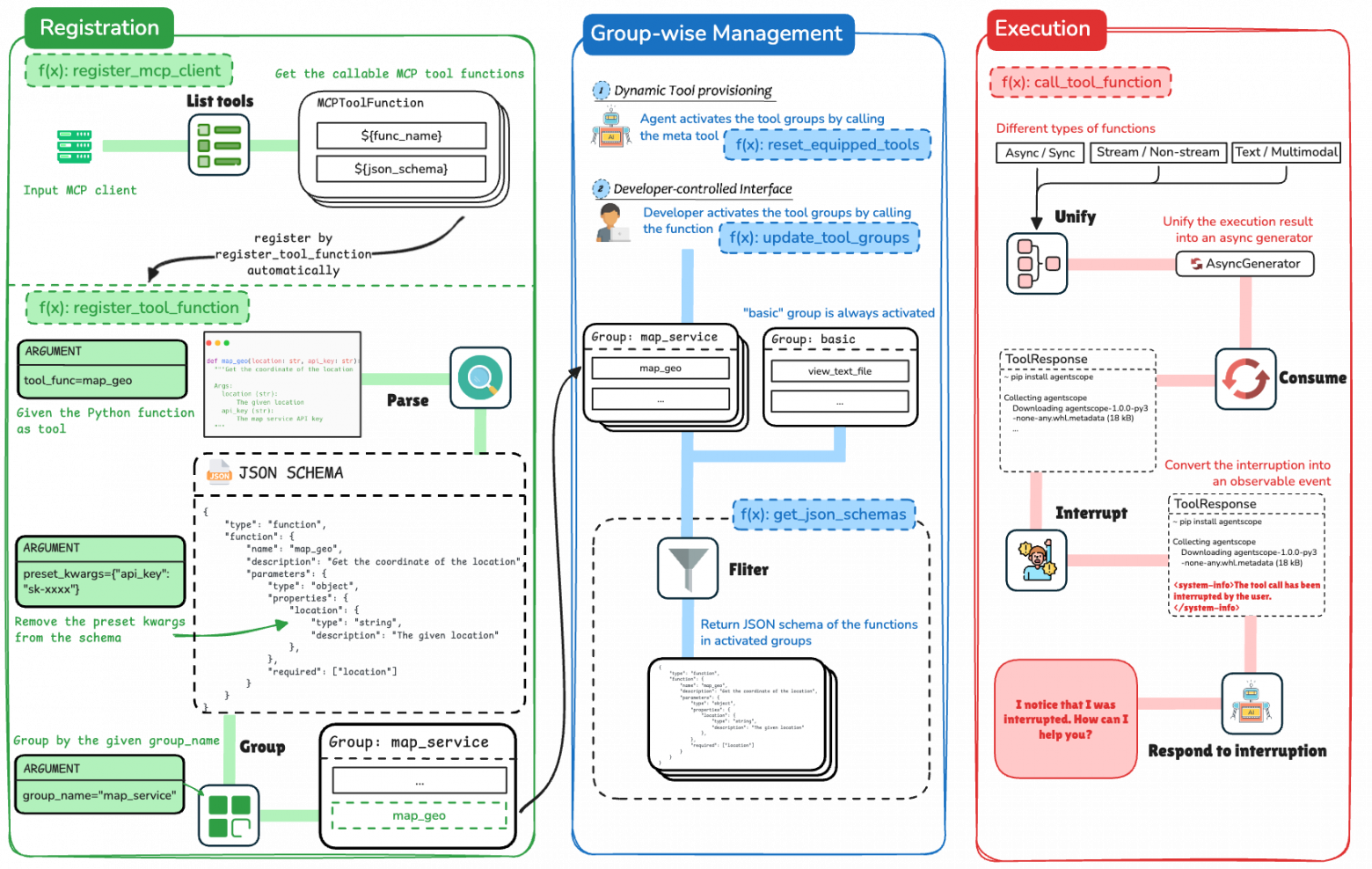

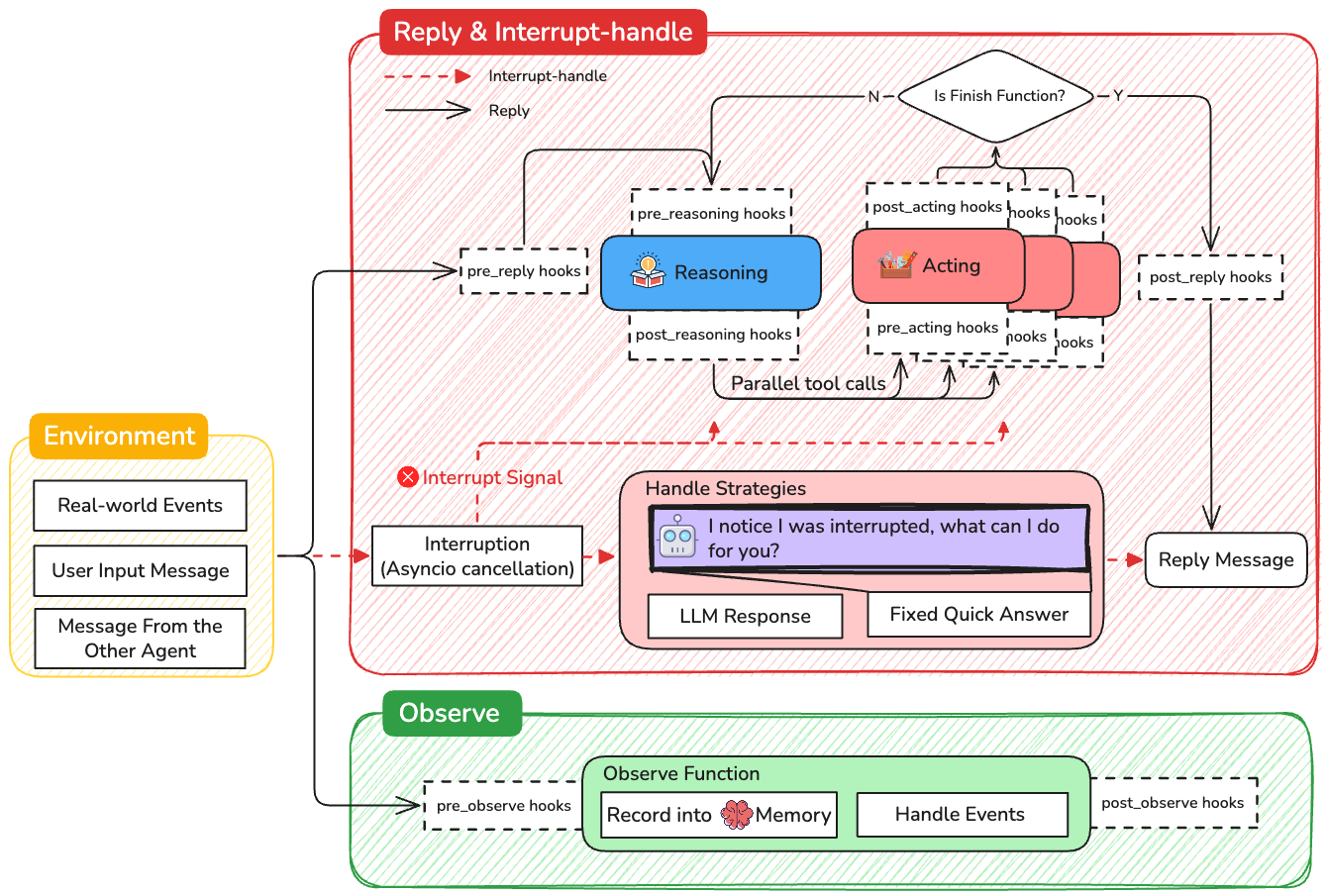

AgentScope 1.0 — это попытка ответить на главный вопрос агентных систем: как сделать так, чтобы LLM не просто болтали, а действовали осмысленно и предсказуемо в реальном окружении. Исследователи предложили фреймворк, который соединяет рассуждение и действие без магии и костылей: единый формат сообщений, унифицированные интерфейсы для разных моделей и инструментов, полноценная память (краткосрочная и долгосрочная), а также парадигму ReAct, где каждый шаг — это мысль, действие и наблюдение. Такой подход позволяет легко подключать API, базы данных или браузер, управлять параллельными вызовами и при этом не терять контроль над сценарием.

На практике AgentScope решает три критические проблемы: сложность интеграции, непредсказуемость поведения [18] и отсутствие нормальной оценки. Единый Toolkit для инструментов упрощает разработку, параллельные и асинхронные вызовы ускоряют сценарии, а встроенные системы оценки и визуализации дают разработчикам прозрачный контроль качества. Важным элементом стала память: агент может запоминать факты и опыт, возвращаться к ним и использовать в новых задачах. Это делает его более устойчивым к длинным процессам и снижает вероятность ошибок.

В результате получаем платформу, которая сокращает время от идеи до работающего агента, повышает скорость и стабильность систем и при этом готова к масштабированию. AgentScope открывает дорогу к мультиагентным сценариям без хаоса: где агенты могут сотрудничать, синхронизировать контекст и выполнять сложные планы. Для бизнеса и исследователей это означает меньше инженерных рисков, больше гибкости и реальную возможность строить надёжные системы — от глубоких исследований до автоматизации процессов.

🔍 Подробнее [19]

💾 Код [21]

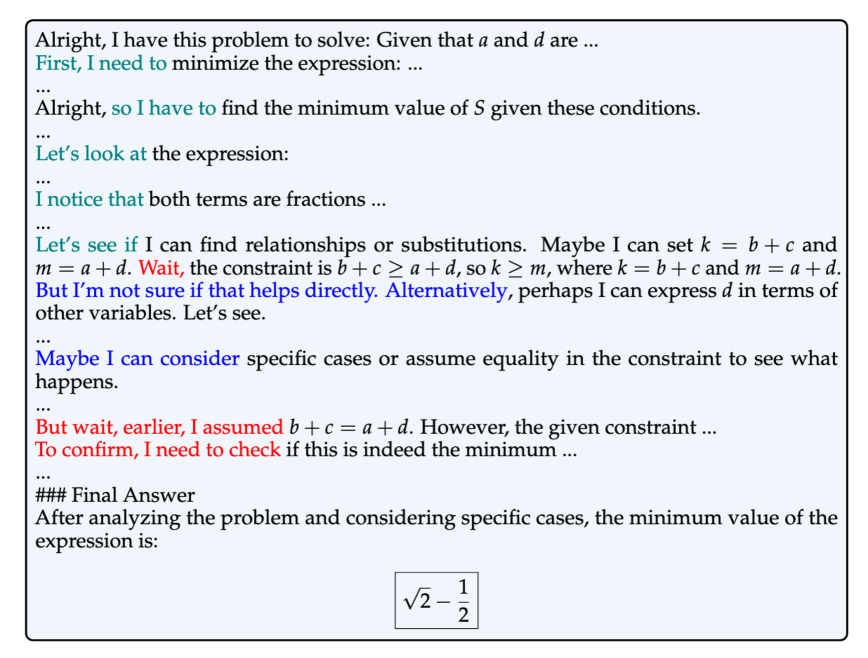

5. Как обучение с подкреплением перестраивает мышление LLM

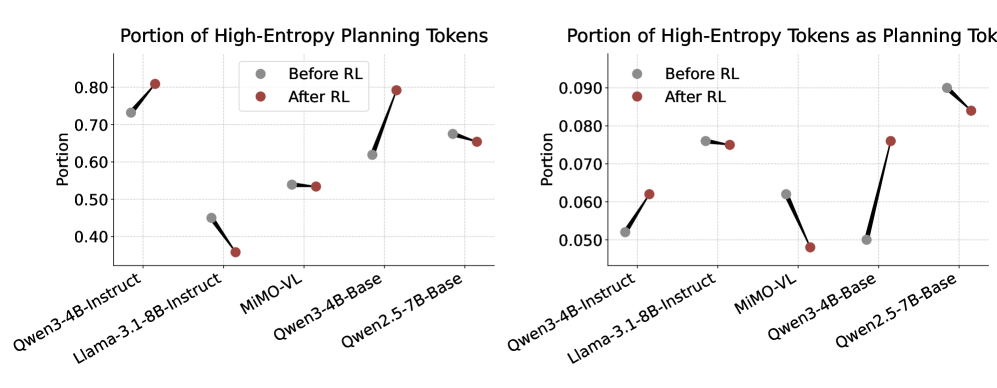

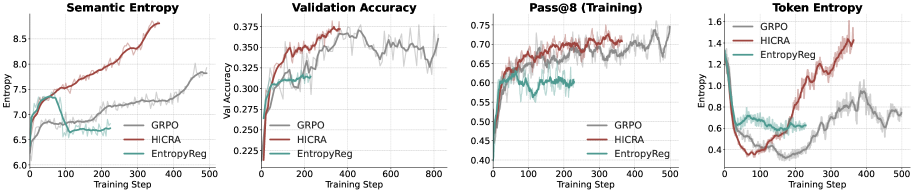

Исследование показывает, что обучение с подкреплением для LLM работает не только как способ повысить точность ответов, но и как инструмент перестройки самой «архитектуры мышления» модели. Авторы выявили две фазы прогресса: сначала модель автоматизирует низкоуровневые операции исполнения, а затем переключается на развитие стратегий — дедукции, ветвления, бэктрекинга. Именно на этом этапе появляются «aha-моменты» и устойчивый рост качества рассуждений. Для анализа они предложили прокси-метрику Strategic Grams — устойчивые n-граммы вроде «let’s try» или «but the problem mentions», которые отделяют планирующие токены от исполняющих.

Главная практическая новинка — метод HICRA (Hierarchy-Aware Credit Assignment). В отличие от классического GRPO, он распределяет «кредит» неравномерно: усиливает позитивный сигнал и смягчает штраф именно на стратегических токенах. Это позволяет расширять репертуар планов и закреплять удачные стратегии, вместо того чтобы случайно увеличивать вариативность исполнения. В экспериментах на Qwen, Llama и MiMO-VL HICRA стабильно обгоняет GRPO, давая особенно заметный прирост на математических и олимпиадных задачах.

Выводы исследования выходят за пределы тестовых наборов: если отделять планирование от исполнения, обучение становится более предсказуемым, а метрики — информативнее. Такой подход может применяться в кодогенерации, научных исследованиях, длинном тексте или мультиагентных системах, где стратегия и исполнение чётко разделимы. По сути, это шаг к тому, чтобы ИИ не просто «считал точнее», а развивал настоящее умение планировать и учиться на собственных стратегиях.

🔍 Подробнее [22]

6. Почему Text-to-SQL до сих пор ломается и как это исправить

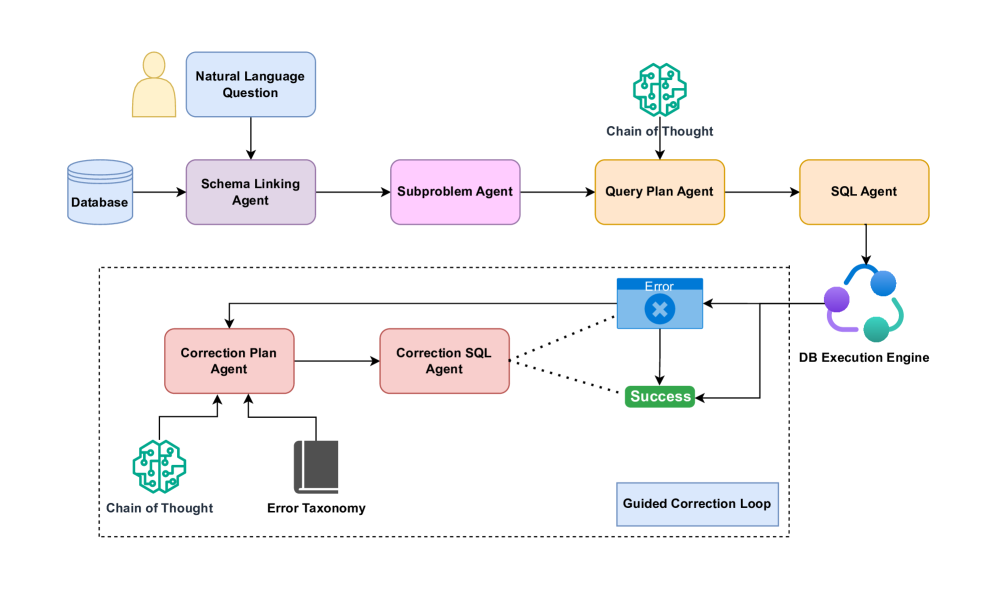

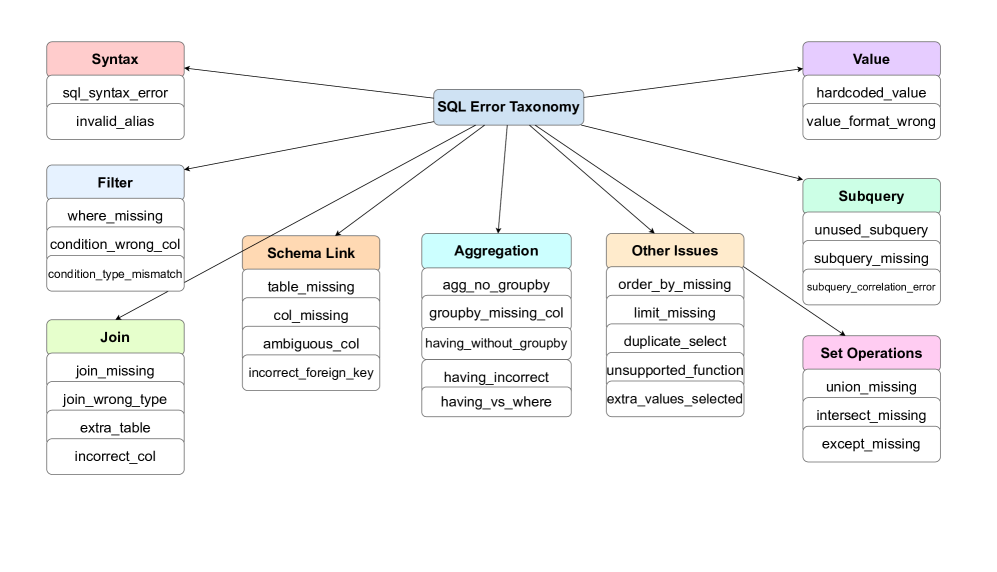

Исследование SQL-of-Thought отвечает на давнюю проблему Text-to-SQL: модели умеют генерировать синтаксически правильные запросы, но часто ошибаются в логике. Вместо бесконечной перегенерации кода по результатам выполнения авторы предлагают структурировать рассуждение модели. Ключевой вклад — многоступенчатый конвейер: от выделения релевантных таблиц и построения плана на естественном языке до генерации SQL и направляемой коррекции через таксономию ошибок. Такой подход превращает задачу из угадывания в осмысленное проектирование запроса.

Главная инновация — система диагностики ошибок. Вместо «неверный результат» модель получает конкретный диагноз: «пропущено соединение», «не хватает GROUP BY» или «ошибка в агрегации». Исправление строится по плану, а не вслепую, что снижает количество бесполезных итераций. Эксперименты на наборах Spider и его усложнённых версиях показали впечатляющие результаты: до 91,6% точности, что превосходит текущие публичные решения. Особенно заметен вклад пошагового плана и направляемой коррекции: отключение этих модулей снижало точность на 5–10%.

Практический вывод прост: системы, которые сначала думают, а потом пишут SQL, стабильнее и дешевле, чем грубая «перегенерация до победы». Более того, мультиагентная архитектура позволяет использовать дорогие рассуждающие модели только там, где это критично, а генерацию SQL доверять более дешёвым. Для бизнеса это означает надёжный переход от «иногда работает» к предсказуемым системам запросов на естественном языке. А в перспективе — возможность дообучать лёгкие модели на типичных ошибках и получать доступные решения для корпоративных баз данных.

🔍 Подробнее [24]

7. Увидел-кликнул-победил: как UItron управляет компьютером по-человечески

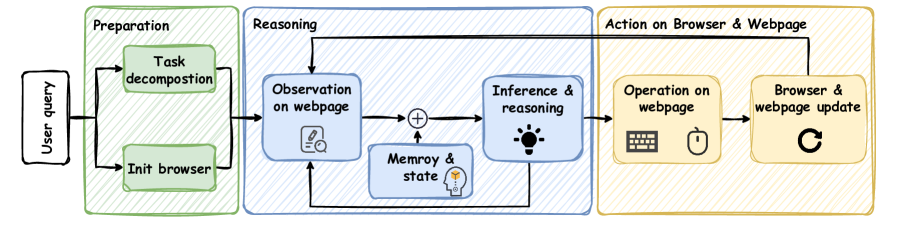

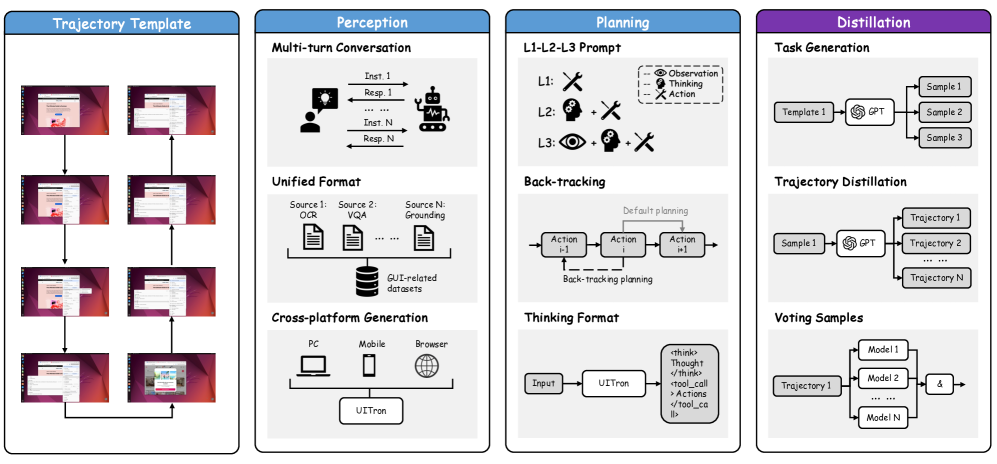

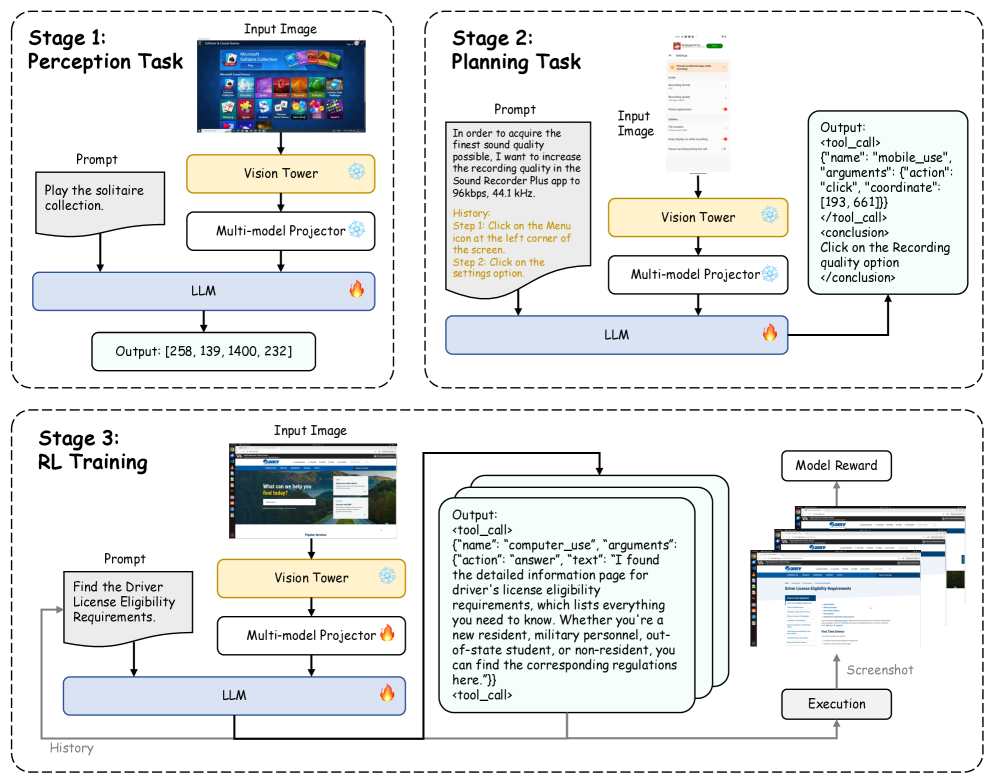

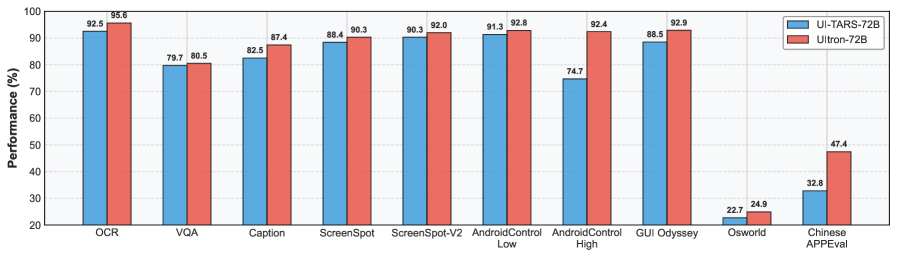

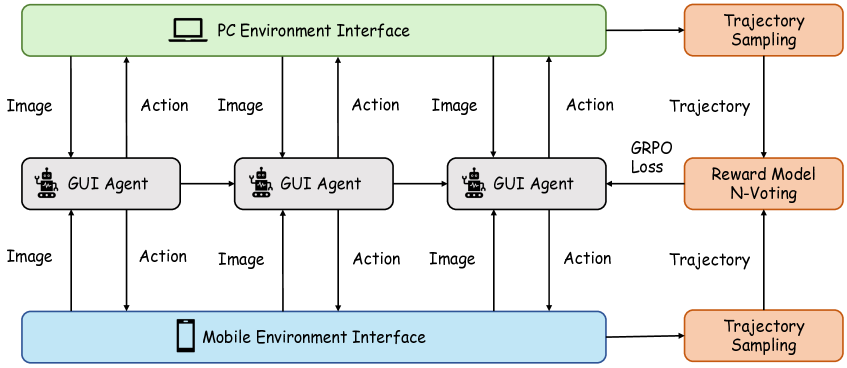

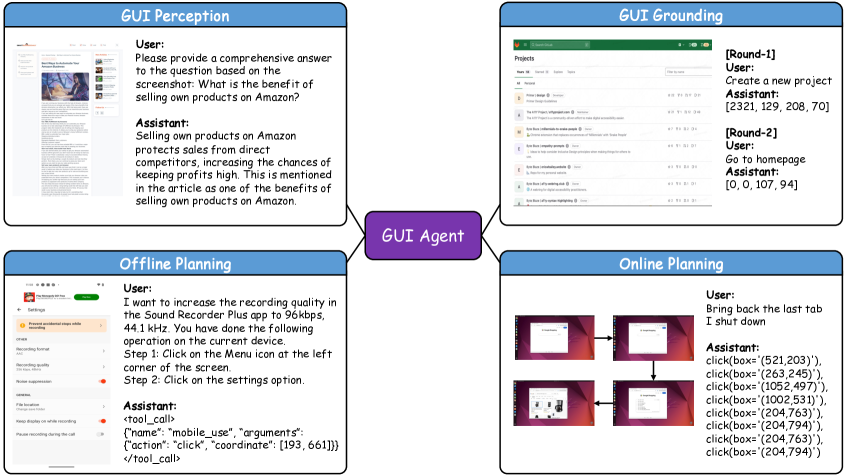

UItron — это попытка научить ИИ взаимодействовать с компьютером так же, как это делает человек: видеть экран целиком, находить нужные элементы, кликать и выстраивать цепочки действий. Авторы отмечают, что основной барьер в развитии подобных систем был не в мощности моделей, а в отсутствии «жизненного опыта» — реальных кликов, свайпов и сложных сценариев. Ранее интерфейсы упрощали до кода или тегов, но при этом терялись нюансы, важные для успешного выполнения задач. Появление визуально-языковых моделей (VLM) открыло путь к новому уровню: теперь агент воспринимает интерфейс глазами пользователя.

Чтобы это работало, команда UItron собрала более миллиона шагов взаимодействия из топ-100 китайских приложений, построила инфраструктуру для симуляции действий и унифицировала разрозненные данные. Агент проходит три этапа обучения: восприятие элементов интерфейса, планирование действий и закрепление через RL. Такой подход позволил ему не только распознавать даже мелкие кнопки, но и продумывать длинные сценарии вроде отправки файла в мессенджере. В тестах UItron заметно превзошёл конкурентов по точности, скорости и устойчивости к обновлениям приложений, а в китайских супераппах показал особенно высокий прирост — до 20% успешности задач.

Главное достижение UItron — создание открытой системы, которую можно развивать и адаптировать под разные языки, приложения и сценарии. Это уже не просто исследовательский прототип, а фундамент для будущих цифровых помощников, способных полноценно работать с интерфейсами и учиться в процессе. В перспективе такие агенты смогут объединяться в мультиагентные системы, обмениваться опытом и выходить за пределы экранов — к взаимодействию с физическими устройствами. По сути, UItron показывает, каким может быть следующий шаг в эволюции человекоподобных ИИ-ассистентов.

🔍 Подробнее [26]

💾 Код [28]

8. ИИ как соавтор: как агенты меняют науку прямо сейчас

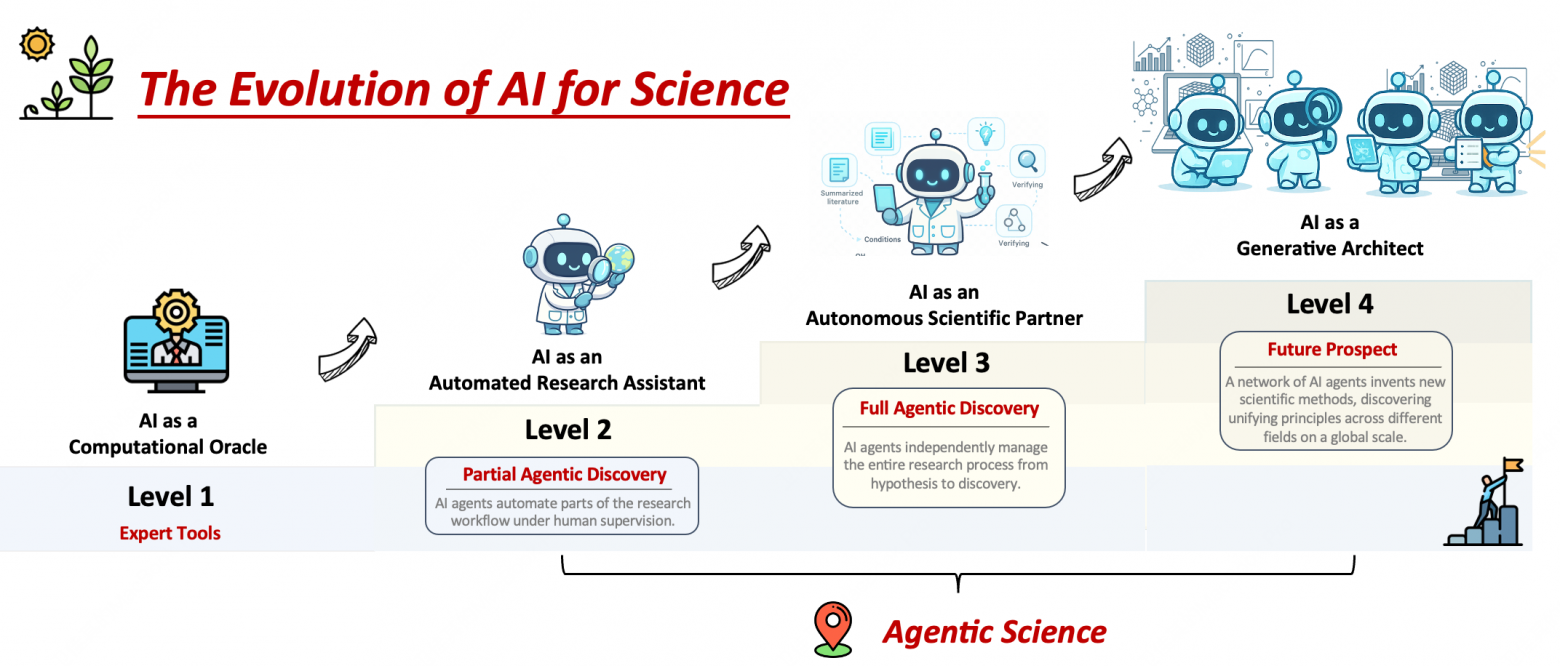

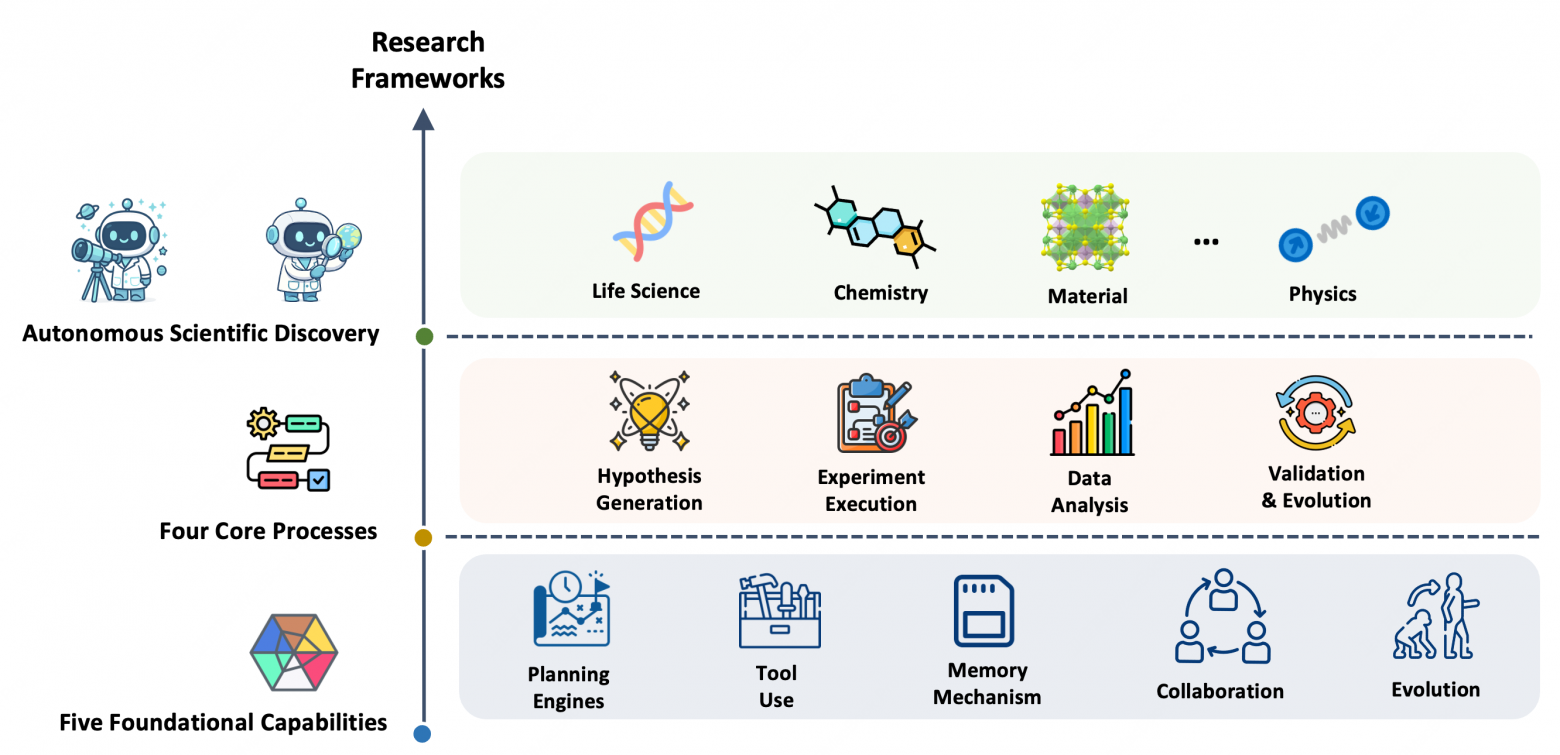

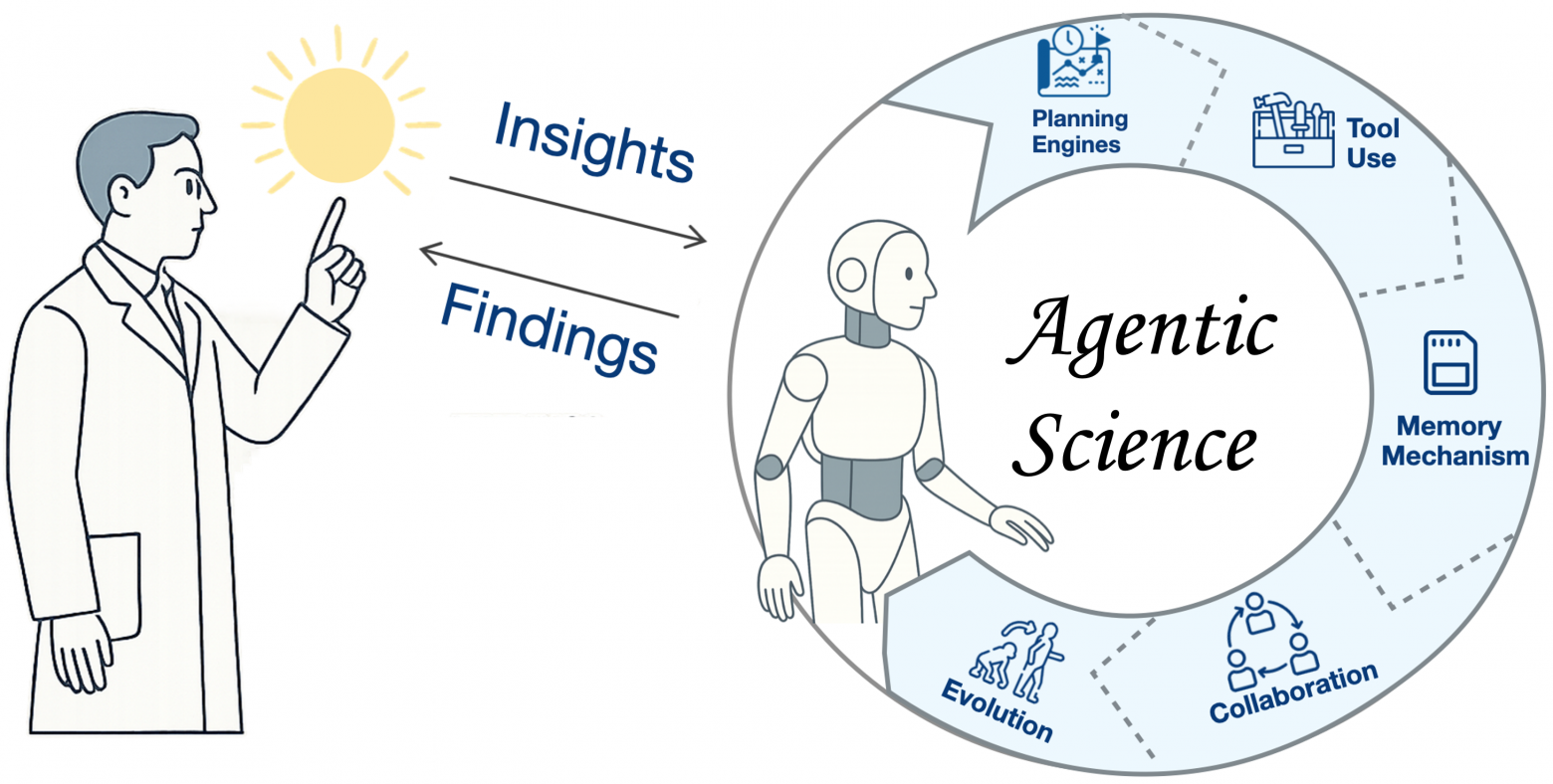

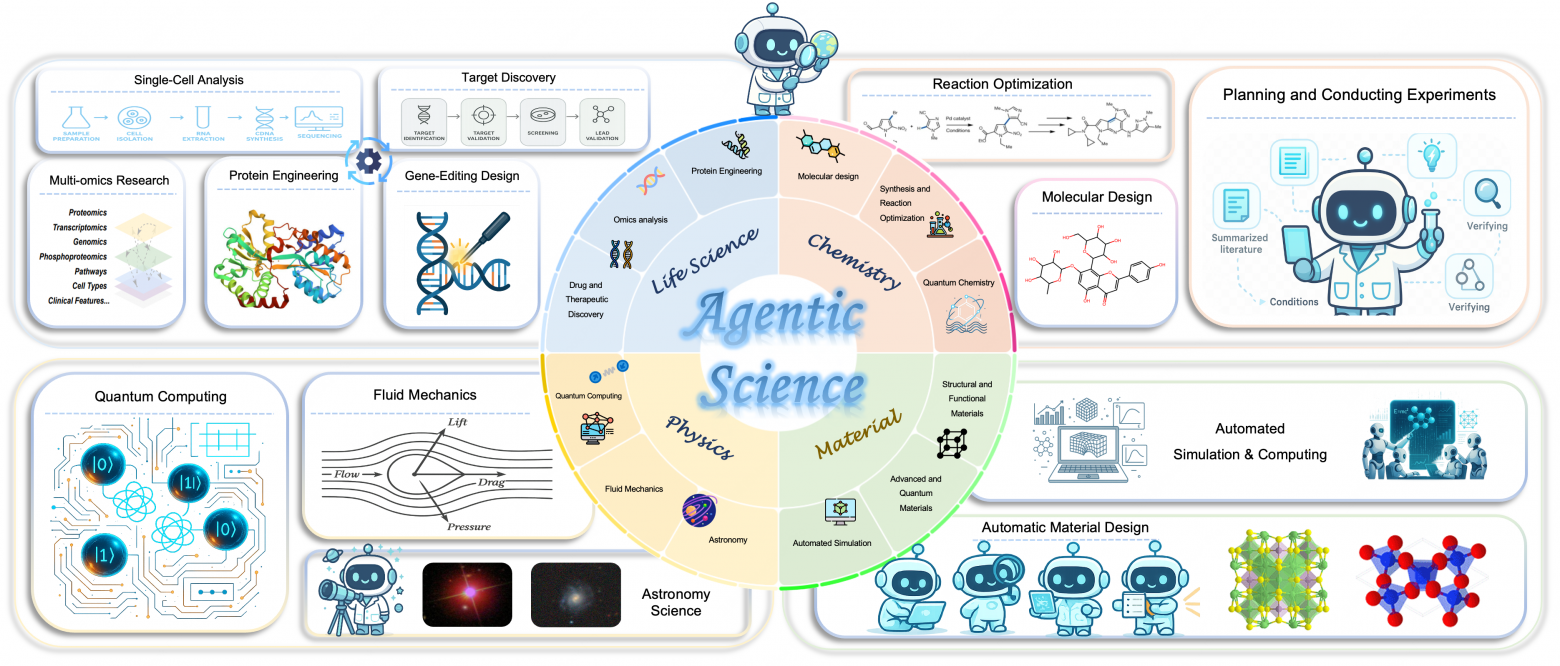

Исследование о Agentic Science предлагает радикальный взгляд на роль искусственного интеллекта в науке [29]. Авторы показывают, как ИИ переходит от уровня «инструмента» к статусу полноценного научного партнёра: он читает литературу, формулирует гипотезы, планирует и проводит эксперименты, анализирует результаты и даже корректирует собственные ошибки. Такой агент работает в замкнутом цикле и способен адаптировать последовательность шагов под задачу и ограничения — от поиска терапевтических мишеней в биотехнологиях до проектирования новых материалов.

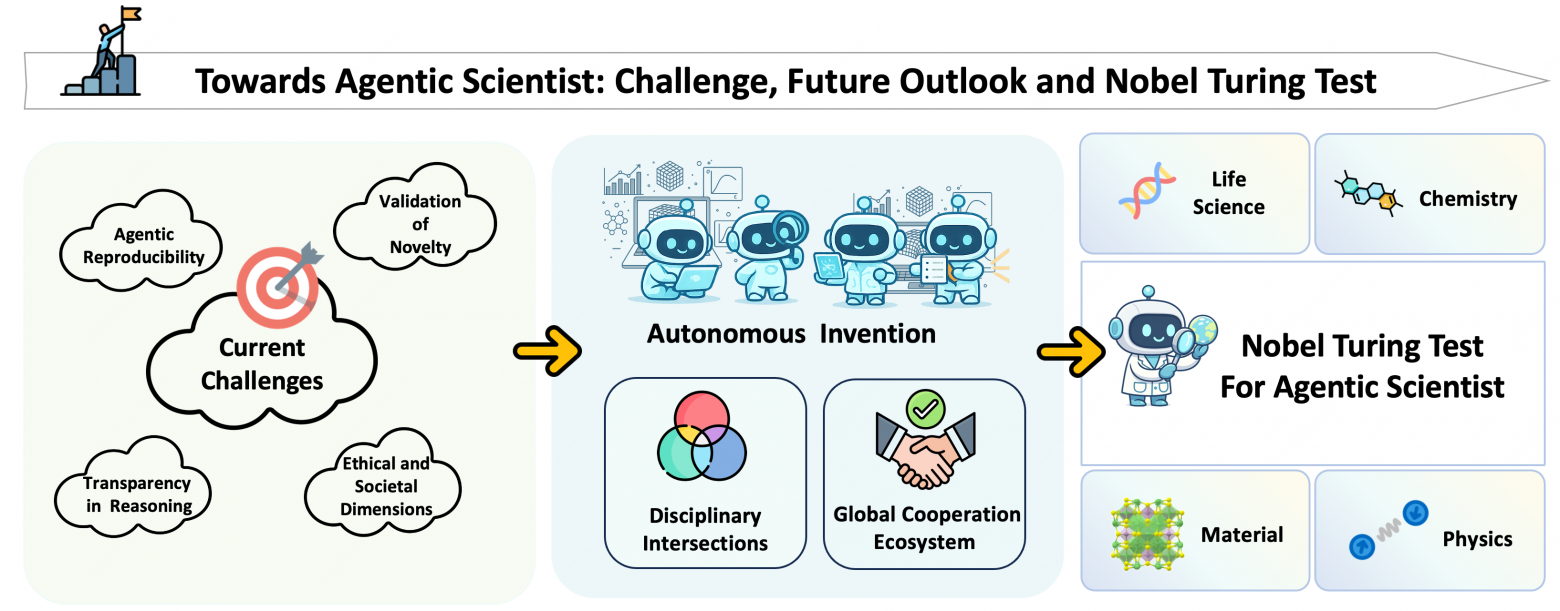

Ключевая идея работы — систематизировать возможности агентных систем в науке. Исследователи выделяют пять базовых способностей (планирование, интеграция инструментов, память, мультиагентность и самоэволюция), которые делают возможным автономное открытие. Фреймворк связывает эти способности с этапами научного процесса и реальными доменами — химией, физикой, биологией, материаловедением. Уже сегодня такие агенты проектируют реакции [31] на роботизированных установках, предлагают новые лекарства и ускоряют моделирование сложных физических процессов.

Однако вместе с прорывами встают новые вызовы: воспроизводимость, прозрачность рассуждений, проверка новизны гипотез и вопросы безопасности. Авторы предлагают дорожную карту развития, которая ведёт от устойчивых и воспроизводимых систем к амбициозной цели — «Нобелевскому тесту Тьюринга», то есть способности агента совершать открытия нобелевского уровня. Для науки это значит не просто ускорение экспериментов, а переход к новой модели сотрудничества, где ИИ становится соавтором, а учёный — стратегом и архитектором научного процесса.

🔍 Подробнее [32]

💾 Код [34]

9. Нажал — и мир двинулся: Matrix-Game 2.0 делает видео интерактивным в реальном времени

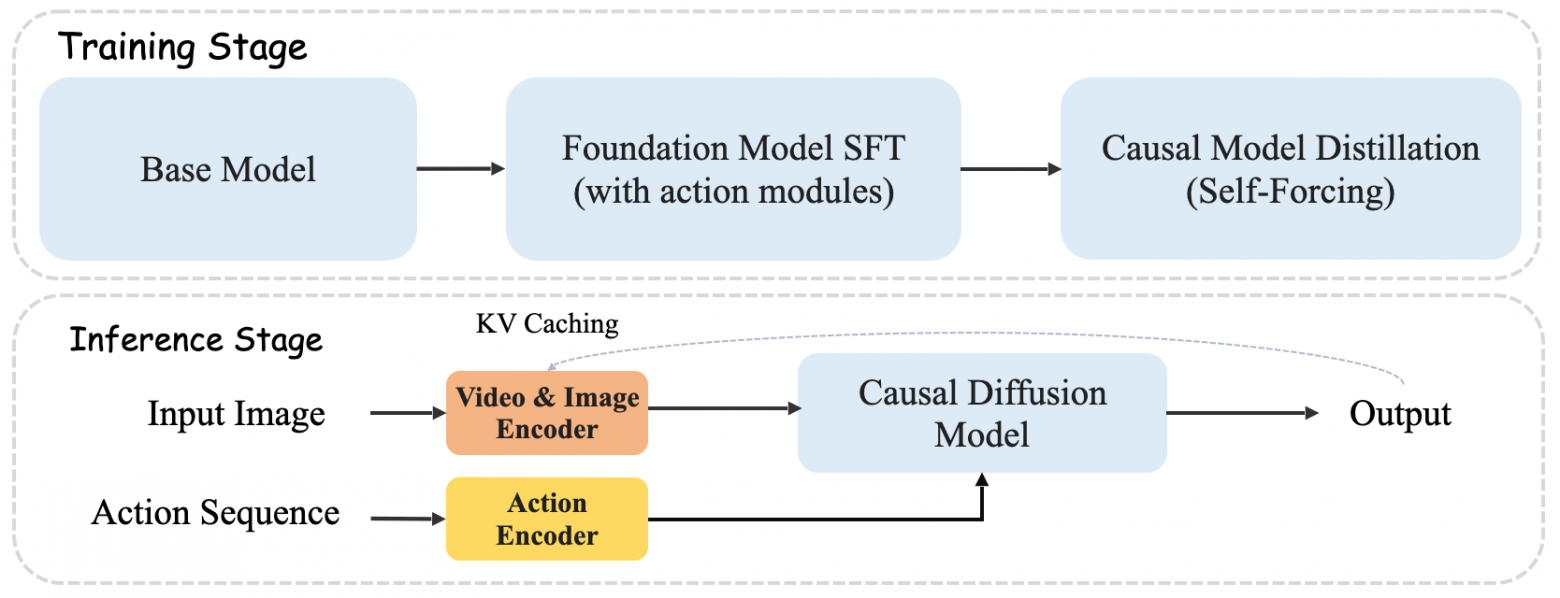

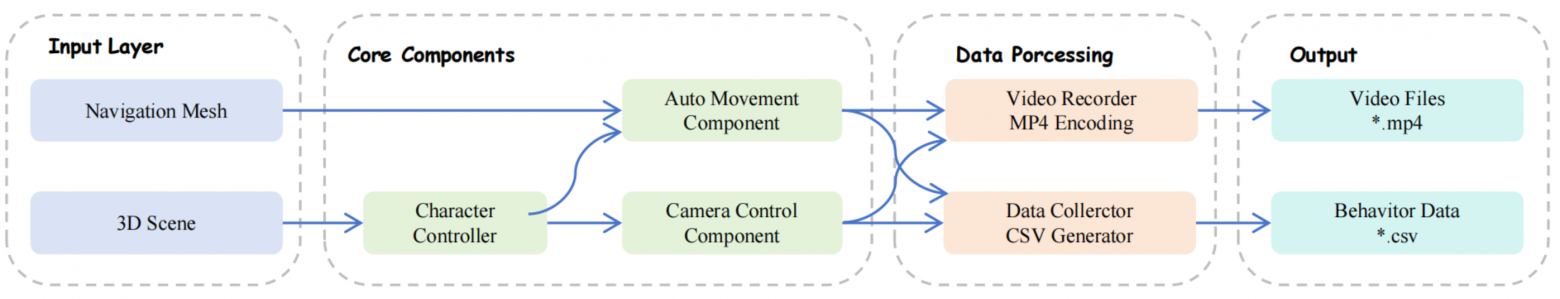

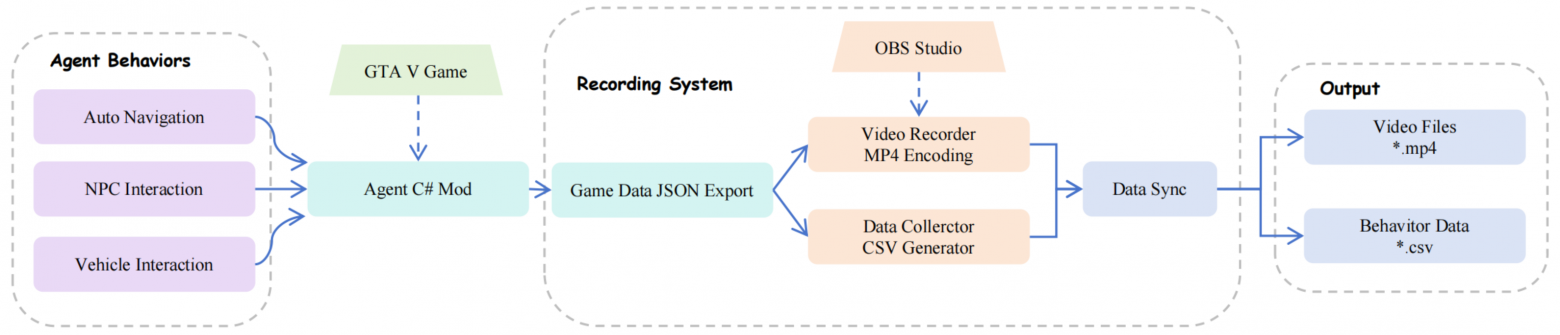

Matrix-Game 2.0 решает ключевую проблему интерактивных моделей мира — как сделать так, чтобы видео реагировало на действия пользователя в реальном времени и не «ломалось» при длинных последовательностях. Для этого авторы построили масштабные пайплайны данных в Unreal Engine и GTA5, собрав более 1200 часов клипов с точной привязкой действий к каждому кадру. Технический прорыв заключается в причинной диффузионной архитектуре с дистилляцией (self-forcing), KV-кэшем и минимальным числом шагов генерации. Итог — потоковое видео 25 кадров в секунду на одной видеокарте с точным контролем мыши и клавиатуры.

Результаты впечатляют: модель стабильно держит качество и динамику на длинных отрезках, превосходит аналоги вроде Oasis и YUME по управляемости и устойчивости, а также сохраняет «память» о сцене без накопления ошибок. При этом Matrix-Game 2.0 показала неожиданный эффект: слишком большие окна памяти портят результат, а сбалансированный KV-кэш, наоборот, помогает модели корректировать собственные огрехи на ходу.

Значимость работы в том, что она открывает путь к по-настоящему интерактивным симуляторам. Это ускоряет обучение агентов для игр, навигации и робототехники, позволяет LLM-моделям тестировать гипотезы в визуальном «песочнице» и делает видеодиффузию прикладным инструментом. Публикация кода и весов превращает Matrix-Game 2.0 не просто в исследование, а в основу для следующего поколения интерактивных ИИ-систем, где мир «откликается» на каждое действие.

🔍 Подробнее [35]

💾 Код [37]

10. Память для роботов: как машины учатся видеть мир осознанно

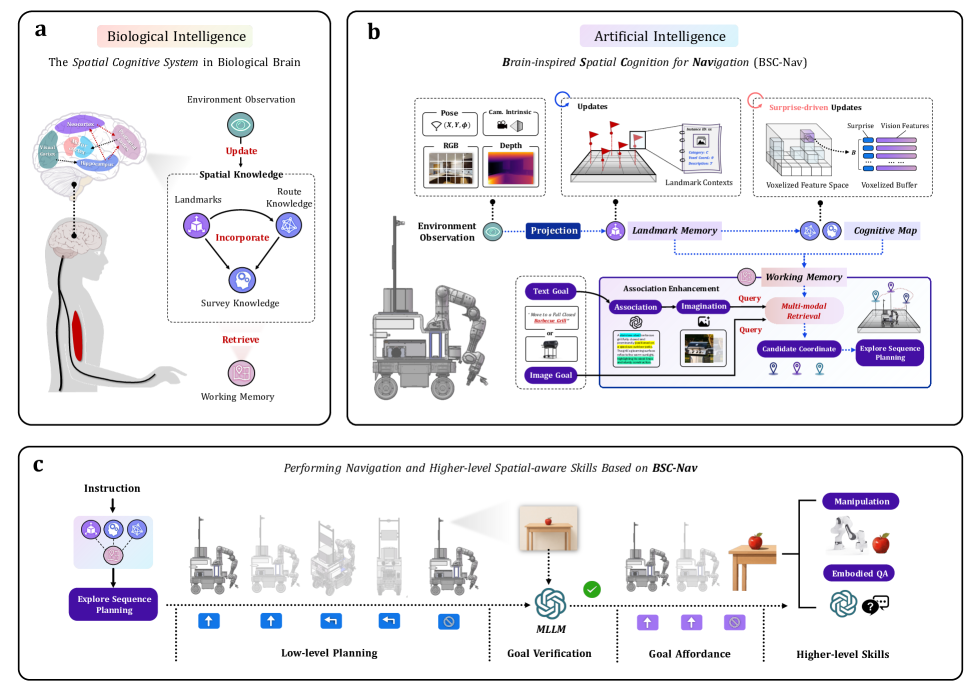

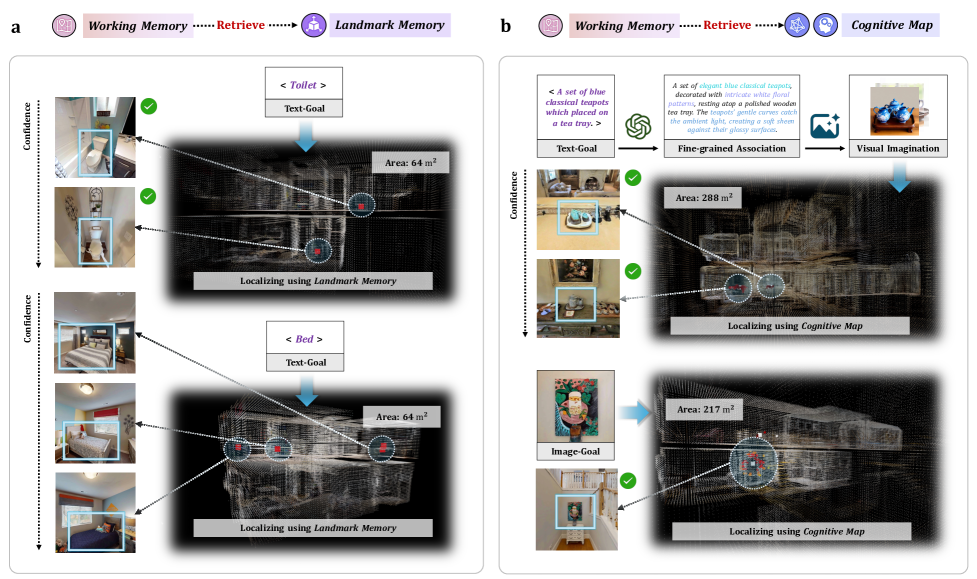

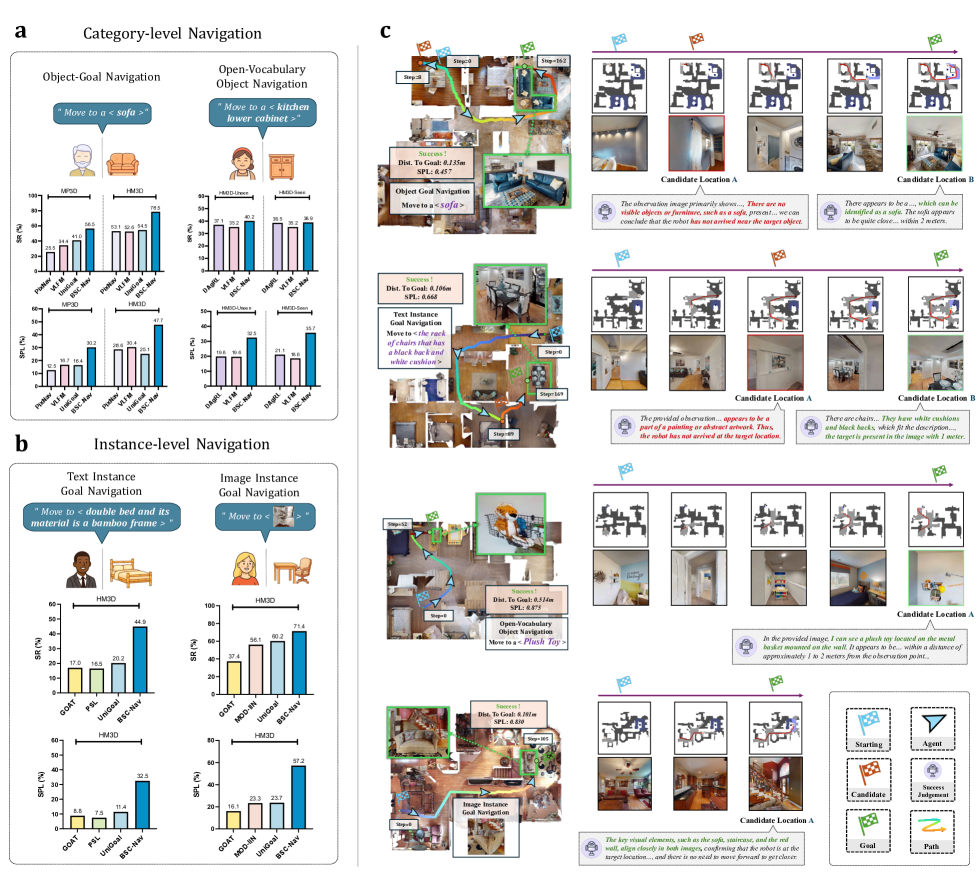

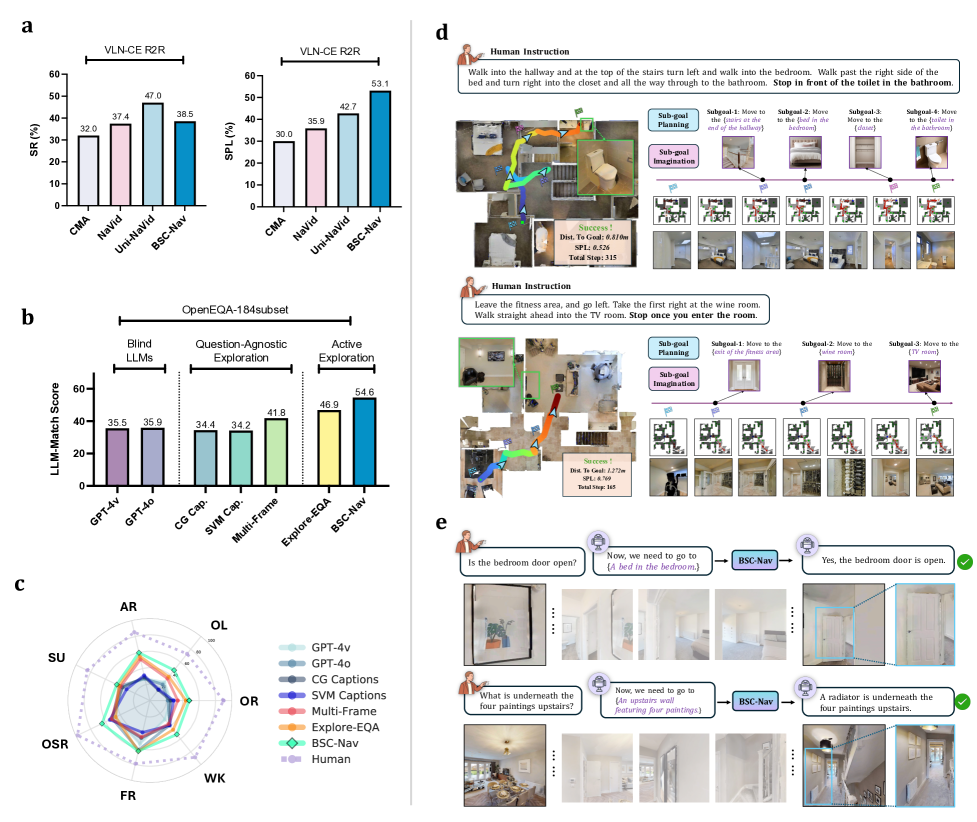

Исследование BSC-Nav поднимает ключевую проблему робототехники: большинство агентов остаются реактивными, действуя по кадрам без долгосрочного понимания пространства. Авторы предлагают решение, вдохновленное работой мозга человека — когнитивную память с тремя уровнями: ориентиры, когнитивная карта и рабочая память. Такая архитектура позволяет не просто «реагировать на картинку», а строить осмысленные маршруты, переиспользовать опыт и гибко адаптироваться под задачу.

Методы сочетают современные инструменты компьютерного зрения [39] (DINOv2, детекторы объектов) и большие языковые модели, которые помогают увязывать семантику запросов с памятью. Важный принцип — «сюрприз»: в память попадает только новое и значимое, что делает систему устойчивой и экономичной. Эксперименты на симуляторах Habitat показали резкий рост точности: до 78,5% успеха на сложных сценах и заметное превосходство над базовыми подходами в задачах поиска по категории, тексту или изображению.

В реальных испытаниях на мобильном роботе BSC-Nav продемонстрировал уверенную работу: от навигации по этажам до многошаговых манипуляций вроде «готовки завтрака». Это подтверждает, что переход от реактивных политик к многоуровневому пространственному мышлению [40] реален. В перспективе такая память позволит создавать роботов, которые ориентируются и действуют в мире так же осмысленно, как человек, — что критически важно для будущих сервисных и домашних помощников.

Робот умеет даже готовит завтрак из нескольких ингредиентов с чередованием движения и действий.

🔍 Подробнее [41]

💾 Код [43]

🎥 Видео [44]

ИИ быстро учится планировать, эффективно работать с памятью, взаимодействовать с окружением и даже формировать собственные стратегии поведения [45]. Вместе с этим растёт и наша ответственность: теперь важно не только делать модели мощнее, но и выстраивать стимулы так, чтобы они были прозрачными и безопасными. Всё это приближает нас к миру, где интеллектуальные помощники смогут действовать устойчиво, сотрудничать друг с другом и поддерживать нас в науке, бизнесе и повседневной жизни. Вопрос в том, как мы сумеем использовать эту автономию — чтобы ИИ стал не конкурентом, а партнёром в создании будущего.

Не забудьте подписаться на мой Telegram-канал [4] — там я делюсь инсайтами из ИИ-индустрии, практическими кейсами внедрения технологий в бизнес и опытом создания ИИ-стартапов. А канал Dataism Lab [3] ежедневно держит вас в курсе самых свежих исследований в области ИИ. Будем вместе впереди в мире технологий!

Автор: andre_dataist

Источник [46]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/19750

URLs in this post:

[1] память: http://www.braintools.ru/article/4140

[2] обучения: http://www.braintools.ru/article/5125

[3] подписывайтесь на Dataism Lab: https://t.me/+OGLQP9cLlWFhZmZi

[4] приглашаю в мой Telegram-канал: https://t.me/+6IWR_ZSRRR05Mjgy

[5] опытом: http://www.braintools.ru/article/6952

[6] ошибка: http://www.braintools.ru/article/4192

[7] подкреплением: http://www.braintools.ru/article/5528

[8] 🔍 Подробнее: https://habr.com/ru/articles/944978/

[9] 📜 Оригинальная статья: https://arxiv.org/abs/2509.04664

[10] интеллект: http://www.braintools.ru/article/7605

[11] логику: http://www.braintools.ru/article/7640

[12] 🔍 Подробнее: https://habr.com/ru/articles/944742/

[13] 📜 Оригинальная статья: https://arxiv.org/abs/2509.00244

[14] 💾 Код: https://github.com/NVlabs/UniversalDeepResearch

[15] 🔍 Подробнее: https://habr.com/ru/articles/940824/

[16] 📜 Оригинальная статья: https://arxiv.org/abs/2508.16153

[17] 💾 Код: https://github.com/Agent-on-the-Fly/Memento

[18] поведения: http://www.braintools.ru/article/9372

[19] 🔍 Подробнее: https://habr.com/ru/articles/941194/

[20] 📜 Оригинальная статья: https://arxiv.org/abs/2508.16279

[21] 💾 Код: https://github.com/agentscope-ai/agentscope

[22] 🔍 Подробнее: https://habr.com/ru/articles/946786/

[23] 📜 Оригинальная статья: https://arxiv.org/abs/2509.03646v1

[24] 🔍 Подробнее: https://habr.com/ru/articles/944010/

[25] 📜 Оригинальная статья: https://arxiv.org/abs/2509.00581

[26] 🔍 Подробнее: https://habr.com/ru/articles/943180/

[27] 📜 Оригинальная статья: https://arxiv.org/abs/2508.21767

[28] 💾 Код: https://github.com/UITron-hub/UItron

[29] науке: http://www.braintools.ru/article/7634

[30] Эволюция: http://www.braintools.ru/article/7702

[31] реакции: http://www.braintools.ru/article/1549

[32] 🔍 Подробнее: https://habr.com/ru/articles/944570/

[33] 📜 Оригинальная статья: https://arxiv.org/abs/2508.14111

[34] 💾 Код: https://github.com/AgenticScience/Awesome-Agent-Scientists

[35] 🔍 Подробнее: https://habr.com/ru/articles/940322/

[36] 📜 Оригинальная статья: https://arxiv.org/abs/2508.13009

[37] 💾 Код: https://github.com/SkyworkAI/Matrix-Game

[38] ассоциативный: http://www.braintools.ru/article/621

[39] зрения: http://www.braintools.ru/article/6238

[40] мышлению: http://www.braintools.ru/thinking

[41] 🔍 Подробнее: https://habr.com/ru/articles/943512/

[42] 📜 Оригинальная статья: https://arxiv.org/abs/2508.17198

[43] 💾 Код: https://github.com/Heathcliff-saku/BSC-Nav

[44] 🎥 Видео: https://drive.google.com/drive/folders/1p1GjpQMQQ-ylmazhjPgqT49AUOcUT3Z-

[45] поведения: http://www.braintools.ru/article/5593

[46] Источник: https://habr.com/ru/articles/949120/?utm_source=habrahabr&utm_medium=rss&utm_campaign=949120

Нажмите здесь для печати.