Инженирия контекста для саморазвивающихся ИИ-агентов

За последние два года стало ясно: многие приложения на базе больших языковых моделей лучше учатся не через дообучение весов, а через заботливую работу с контекстом. В контекст мы кладем системные инструкции, шаги рассуждений, примеры, доменные правила, факты, даже подсказки по работе с инструментами. Это прозрачно, переносимо и работает в рантайме. Плюс прогресс с длинным контекстом и повторным использованием KV-кеша делает этот путь дешевле и практичнее.

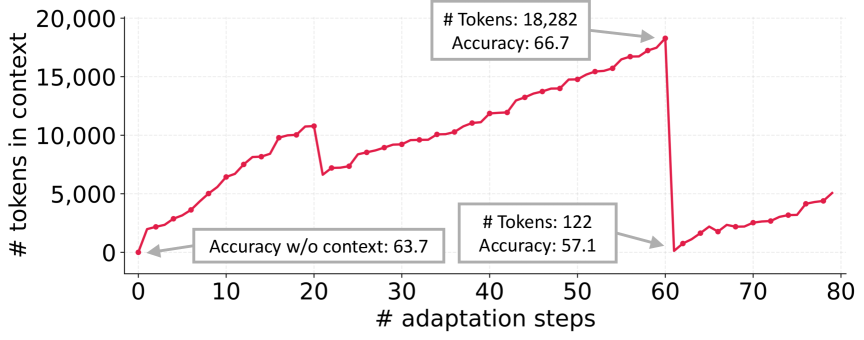

Но есть две неприятные ловушки. Первая — смещение к краткости: оптимизаторы и сами модели склонны ужимать инструкции до общих фраз и забывать [1] про тонкие доменные эвристики. Вторая — коллапс контекста: когда мы переписываем все монолитно, модель сминает наработки в короткую выжимку и роняет качество. В AppWorld авторы наблюдали, как контекст с 18 282 токенов и точностью 66.7 превращался в 122 токена и уже 57.1 — хуже, чем базовый ReAct с 63.7.

Идея работы: контекст как эволюционирующий плейбук

Авторы предлагают ACE — Agentic Context Engineering. Это идея рассматривать контекст как живой плейбук, который растет, уточняется и не боится быть длинным. В отличие от людей, модели неплохо фильтруют релевантность на лету, поэтому детализированный контекст работает на них, а не против них. Ключевой принцип ACE — не переписывать все заново, а вносить аккуратные правки и регулярно чистить дубликаты. Так удается избежать коллапса и сохранить доменные мелочи.

Что именно делает ACE

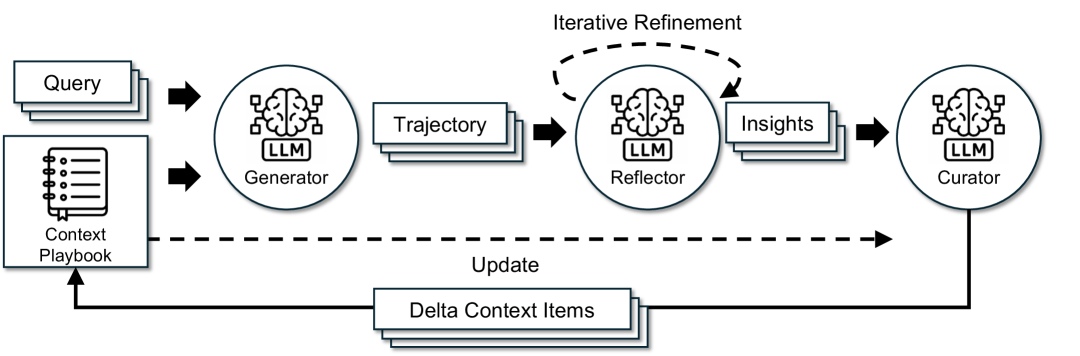

Внутри ACE три роли:

-

Генератор собирает новые траектории и подсвечивает, что сработало, а что нет.

-

Рефлектор извлекает уроки из успехов и ошибок, превращая опыт [2] в понятные правила.

-

Куратор вшивает уроки в контекст через компактные дельта-обновления и мержит их без срыва структуры.

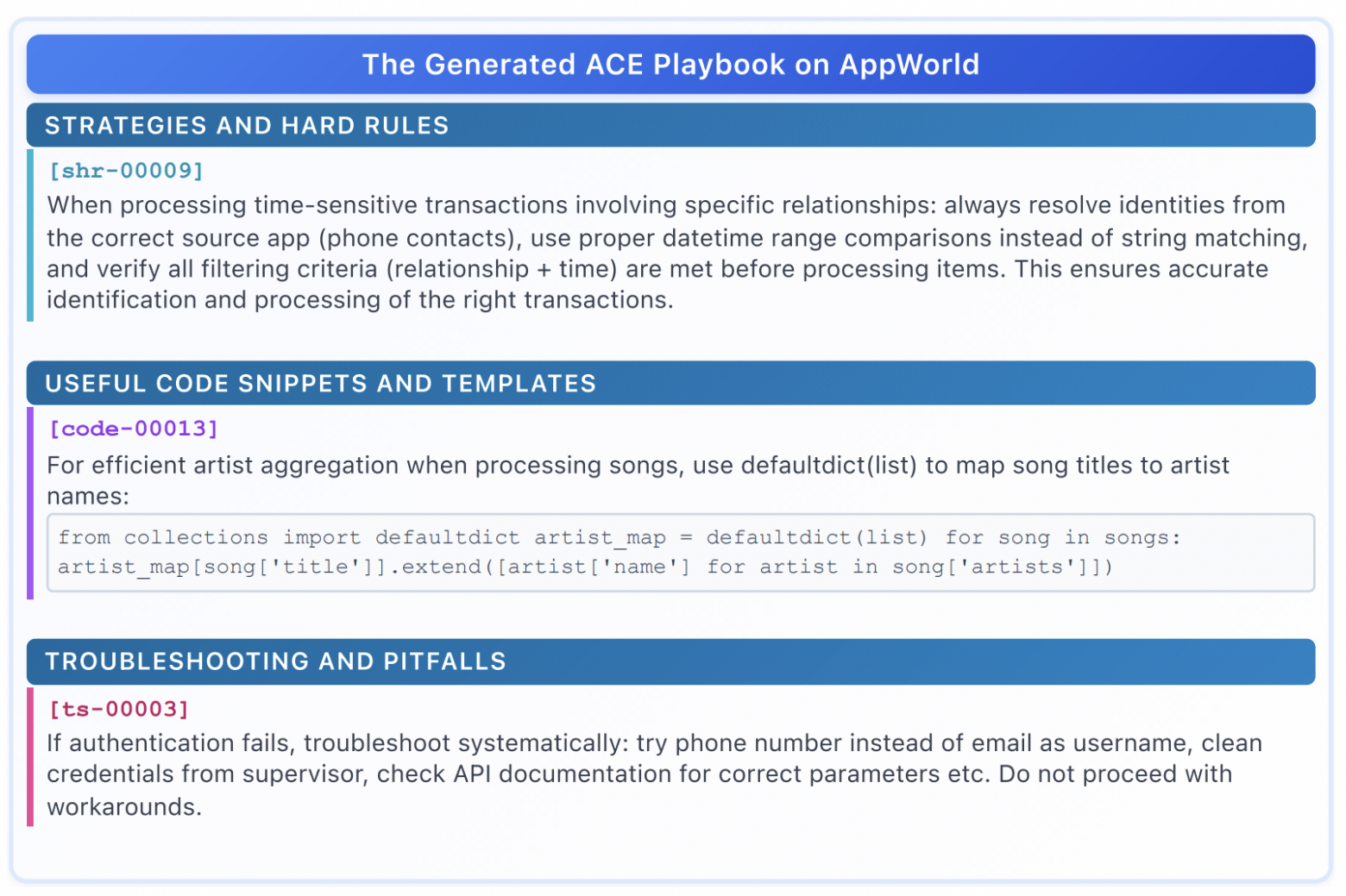

Контекст хранится не как монолит, а как набор буллетов с метаданными: идентификатор, счетчики полезности, содержание (стратегия, частая ошибка [3], доменная подсказка). Дальше работает связка grow-and-refine: растем, когда находим новые ценные кусочки, и регулярно убираем дубликаты по смысловой близости. Итог — плейбук остается объемным, но управляемым и интерпретируемым.

Как это выглядит на практике

В агентных задачах вроде AppWorld ACE обновляет системные промты офлайн и память [4] агента онлайн. В финансовых бенчмарках плейбук включает доменные форматы, шаблоны извлечения и частые ловушки в XBRL. Важно, что ACE может работать без разметки: он опирается на естественные сигналы исполнения — успехи и провалы кода, статусы API, совпадения ответов.

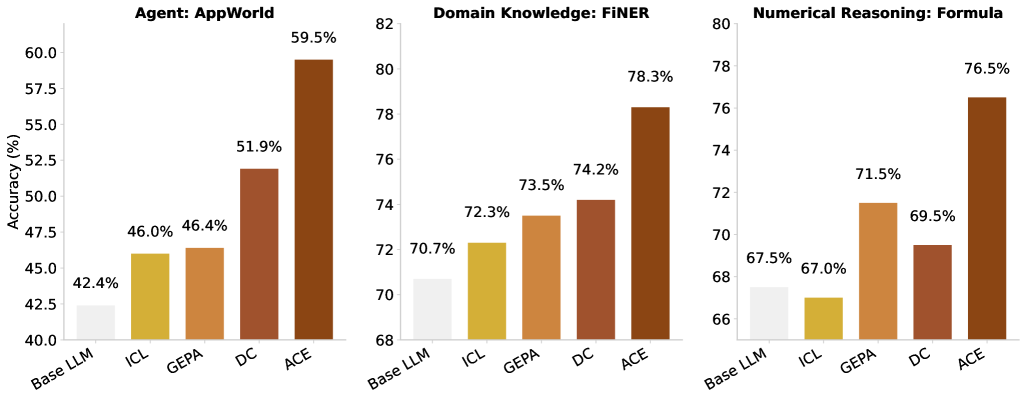

Что показали эксперименты

-

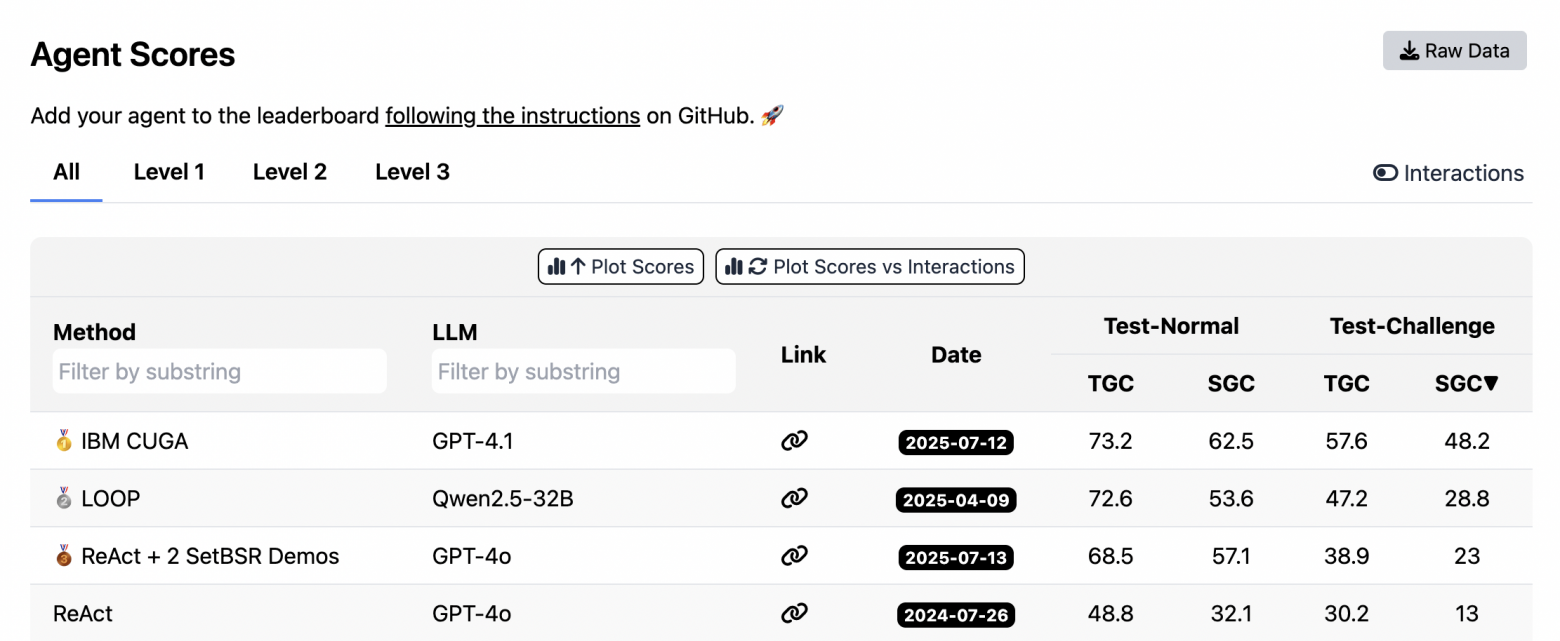

AppWorld. Офлайн ReAct+ACE поднимает средний результат до примерно 59.4% (+17 пунктов к базе) и оказывается на уровне лидера IBM‑CUGA, хотя использует меньшую открытую исходную модель. Онлайн ACE еще сильнее проявляет себя на сложных тестах: средний прирост до +17.1, причем на режиме challenge он опережает IBM‑CUGA.

-

Финансы. На FiNER и Formula ACE дает устойчивый прирост. В офлайн-режиме с разметкой — до среднего 81.9, без разметки — до 77.1. Онлайн ACE тоже выигрывает, особенно когда есть качественный сигнал обратной связи.

-

Стоимость и задержка. Инкрементальные дельты и мердж без LLM экономят ресурсы: до −82–92% по токенам и прогону.

Почему это важно

ACE показывает, что богатый, растущий контекст — не враг эффективности. При грамотном обращении с KV-кешем длинные плейбуки становятся дешевле в обслуживании, а вложения окупаются за счет стабильного прироста качества. Это особенно ценно в непрерывных сценариях, где дообучать веса дорого и рискованно. Контекст остается интерпретируемым, его легче править, проводить селективное разучивание и удовлетворять требованиям приватности и аудита.

Где границы метода

ACE зависит от силы Рефлектора. Если он не умеет извлекать полезные уроки, контекст зашумляется. В очень узких доменах, где модель не может оформить опыт в знания, плейбук попросту не вырастет. И не всем задачам нужен богатый контекст: иногда достаточно одной‑двух стратегий. Максимальная выгода ACE — там, где важны доменные детали, сложные инструменты и длительные цепочки действий, как в мультиагентной системе, взаимодействующей со средой, или в отчетности XBRL.

Короткий вывод

Эта работа снимает два системных барьера контекстной адаптации — тягу к краткости и коллапс. Взамен она предлагает инженерный подход: модульные дельты, рефлексию, рост с очисткой. Результат — самоулучшающиеся приложения на базе LLM, которые учатся быстро, стоят дешевле и не теряют нюансы.

📜 Полная статья [5]

***

Если вам интересна тема ИИ, [6]подписывайтесь на мой Telegram‑канал [7] [8]— там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [9]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/20582

URLs in this post:

[1] забывать: http://www.braintools.ru/article/333

[2] опыт: http://www.braintools.ru/article/6952

[3] ошибка: http://www.braintools.ru/article/4192

[4] память: http://www.braintools.ru/article/4140

[5] 📜 Полная статья: https://arxiv.org/abs/2510.04618

[6] : https://t.me/+mP35nQPhgXZmZDYy

[7] подписывайтесь на мой Telegram‑канал: https://t.me/+MCH4xRxBmo5lMDgy

[8] : https://t.me/+d-7OcUj18oM1NGYy

[9] Источник: https://habr.com/ru/articles/955764/?utm_source=habrahabr&utm_medium=rss&utm_campaign=955764

Нажмите здесь для печати.