Как роботы начинают учиться гораздо быстрее

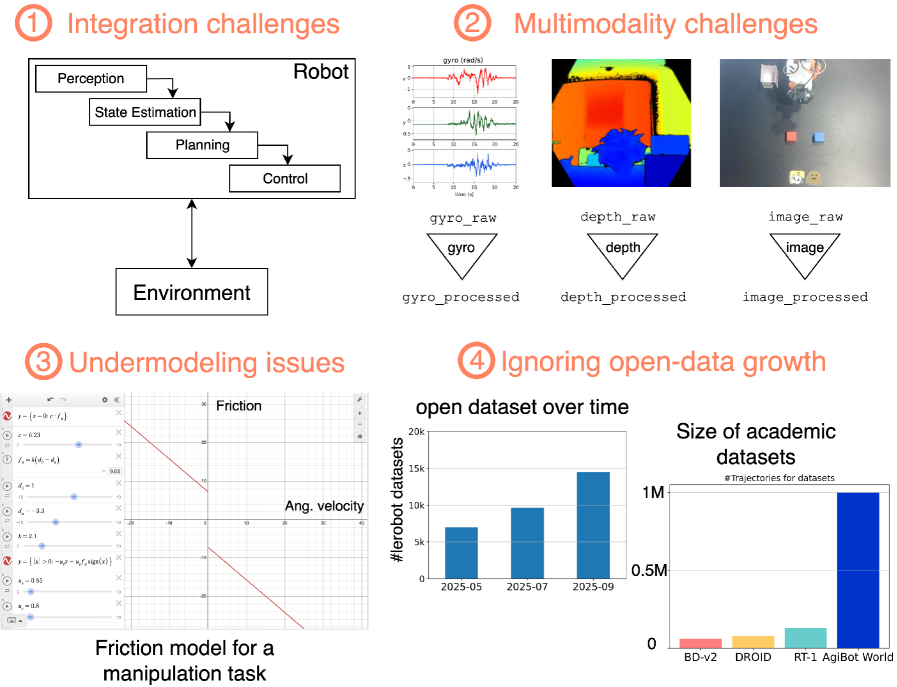

Уже давно робототехника жила по следующим принципам: мы строили карту мира, решали обратную кинематику, настраивали регуляторы, а потом всё снова, когда менялась задача или робот. Это работает в стерильных условиях, но ломается в реальности с шумными сенсорами, контактами и мягкими материалами. Исследователи из Оксфорда предлагают другой путь: когда мир переусложнён для ручного описания объектов, статистика и большие датасеты помогают обобщать мир быстрее и шире.

Что именно сделали исследователи

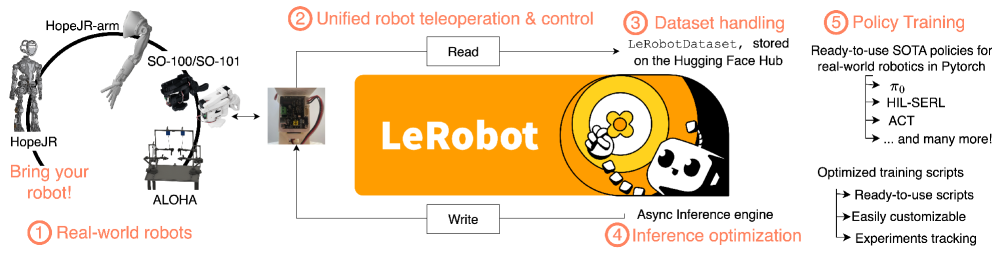

Сердце системы — открытая библиотека lerobot от Hugging Face. Она объединяет низкоуровневое управление реальными роботами, стандартизированный формат данных, быстрые реализации методов RL и имитации, а также удобные скрипты для экспериментов и инференса.

Авторы не переписывают учебники по управлению роботами и глубокому обучению. Вместо этого они показывают, почему идеи обучения на данных и новые модели действий сходятся именно сейчас: от простых контроллеров для одной задачи к универсальным, языково-условным политикам, работающим на разных роботах.

Данные как топливо

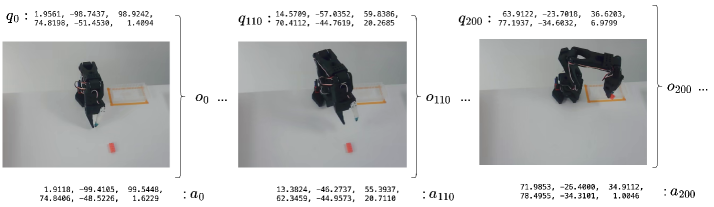

LeRobotDataset — единый формат мультимодальных временных рядов с сенсорикой, моторикой, многокамерным видео и метаданными задач. Он экономно хранит табличные фичи и видео, умеет стримить с Hugging Face Hub без большой RAM, поддерживает оконную выборку истории для политик. То есть можно записать телепоуправление, тут же собрать датасет и запустить обучение, не возясь с разнородными файлами.

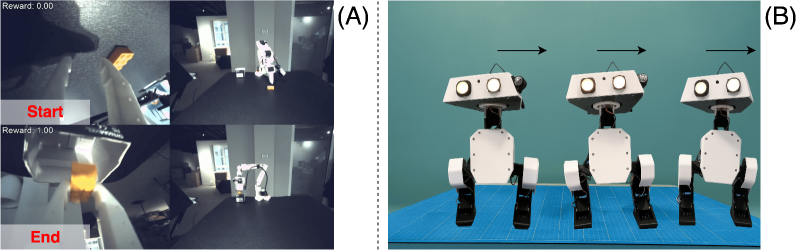

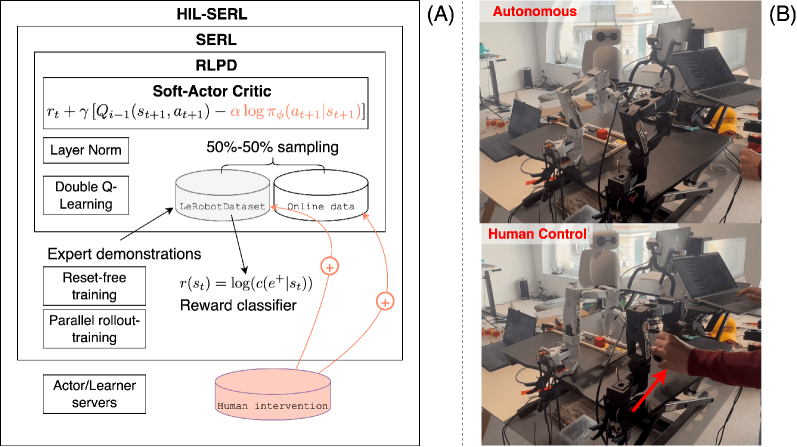

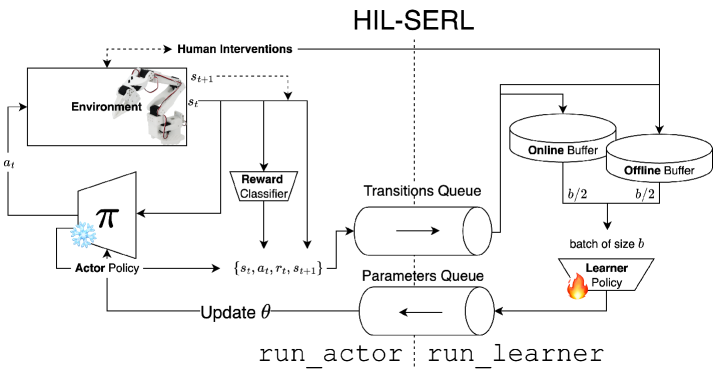

Когда пробовать и ошибаться к месту

Обучение с подкреплением [2] описывает управление как диалог агента со средой. В робототехнике оно привлекательно тем, что позволяет учить политику напрямую по взаимодействиям, без явной модели динамики. Но есть два камня преткновения — безопасность и эффективность. На железе каждая неудачная попытка стоит времени и ресурса.

Авторы показывают, как смягчить эти ограничения:

-

off-policy RL и схемы offline-to-online бережно используют собранные сценарии;

-

классификаторы вознаграждения по примерам успеха/неуспеха заменяют сложную ручную разметку наград;

-

человек может точечно подправлять действия, а система учится быстрее.

В результате появляется практичный пайплайн: учим классификатор награды на открытом датасете, запускаем обучение с подкреплением, добавляем пользовательские вмешательства и смешиваем офлайн и онлайн данные. В работах авторов такой подход выводит сложные манипуляции к почти идеальному успеху за 1–2 часа на доступной платформе.

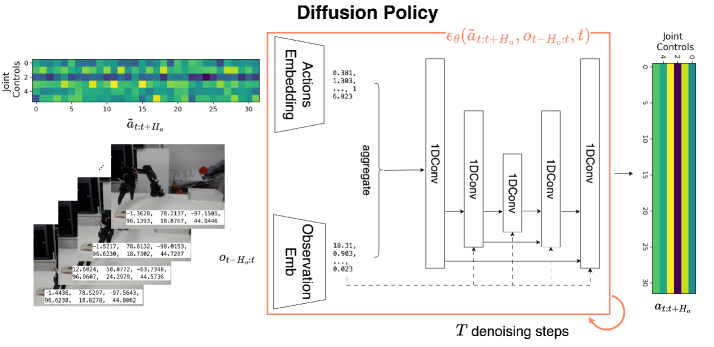

Когда лучше повторять за экспертом

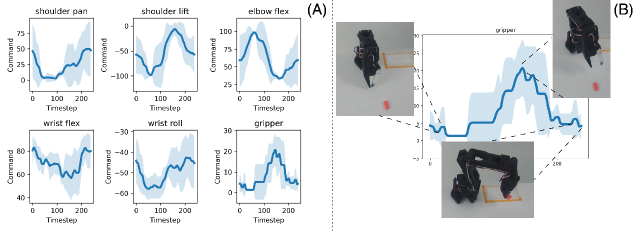

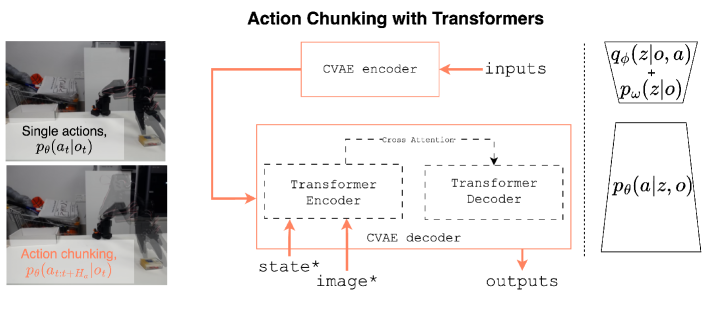

Имитационное обучение снимает ещё два барьера: не нужны симуляторы и проектирование награды. Но простая регрессия действий ломается на мультимодальных демонстрациях и накапливает ошибки [3]. Потому исследователи делают акцент на генеративные политики: диффузионные модели, потоки и трансформеры. Они восстанавливают фрагменты действий по наблюдениям и устойчивее держатся в реальном мире.

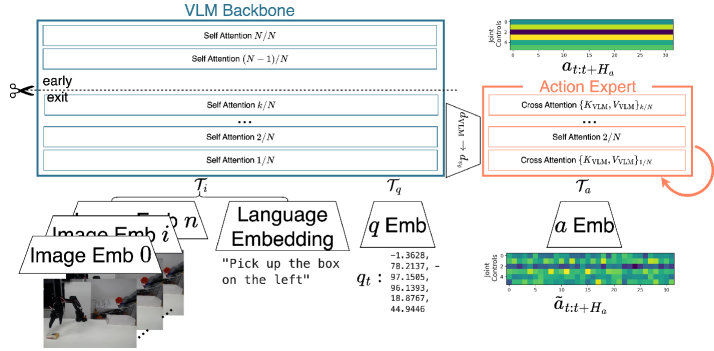

Следующий шаг — универсальные модели. Здесь авторы сопоставляют современные решения: SmolVLA учится на миллионах разнородных демонстраций, используют текстовые инструкции и зрение [4], а действия восстанавливают через flow matching. Интересно то, что такие модели переносятся между задачами и роботами, не теряя в качестве.

Что это даёт на практике

В обзоре есть готовые скрипты для записи данных с робота, создания датасета, обучения классификатора вознаграждения, запуск RL с актором и обучателем, а также быстрый старт для имитации на открытых наборах. Встроенный стриминг с Hugging Face даёт десятки итераций в секунду без копания в хранилищах, а унифицированный API снижает порог входа для лабораторий без дорогих манипуляторов. В итоге можно быстрее превращать свои идеи в работающие политики.

Итак, робототехника вступает в фазу, где интеллект [5] перестаёт быть результатом точных уравнений — и становится свойством данных и архитектур. Это поворотный момент от ручной настройки к самообучающимся системам.

Роботам нужен не один идеальный алгоритм, а связанный набор инструментов: стандартизованные данные, безопасные и эффективные методы RL, сильные генеративные модели для имитации и удобная инфраструктура. Чем больше мы делимся данными и кодом, тем быстрее появятся универсальные, языково‑условные политики, которые уверенно работают на разных задачах и платформах.

📜 Полная статья [6]

💾 Код [7]

***

Если вам интересна тема ИИ, [8]подписывайтесь на мой Telegram‑канал [9] [10]— там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [11]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/20859

URLs in this post:

[1] обучения: http://www.braintools.ru/article/5125

[2] подкреплением: http://www.braintools.ru/article/5528

[3] ошибки: http://www.braintools.ru/article/4192

[4] зрение: http://www.braintools.ru/article/6238

[5] интеллект: http://www.braintools.ru/article/7605

[6] 📜 Полная статья: https://arxiv.org/abs/2510.12403

[7] 💾 Код: https://github.com/fracapuano/robot-learning-tutorial

[8] : https://t.me/+mP35nQPhgXZmZDYy

[9] подписывайтесь на мой Telegram‑канал: https://t.me/+CQrVev1y64Y0N2Fi

[10] : https://t.me/+d-7OcUj18oM1NGYy

[11] Источник: https://habr.com/ru/articles/958020/?utm_source=habrahabr&utm_medium=rss&utm_campaign=958020

Нажмите здесь для печати.