NVIDIA раскрыла секрет ускорения биологических трансформеров — забудьте про медленные GPU

NVIDIA опубликовала подробный гайд по масштабированию биологических моделей, показывая, как эффективнее использовать ресурсы GPU и ускорять обучение [1] больших трансформеров. Основная идея сводится к трём ключевым подходам, каждый из которых решает конкретные проблемы при работе с массивными моделями биологических последовательностей.

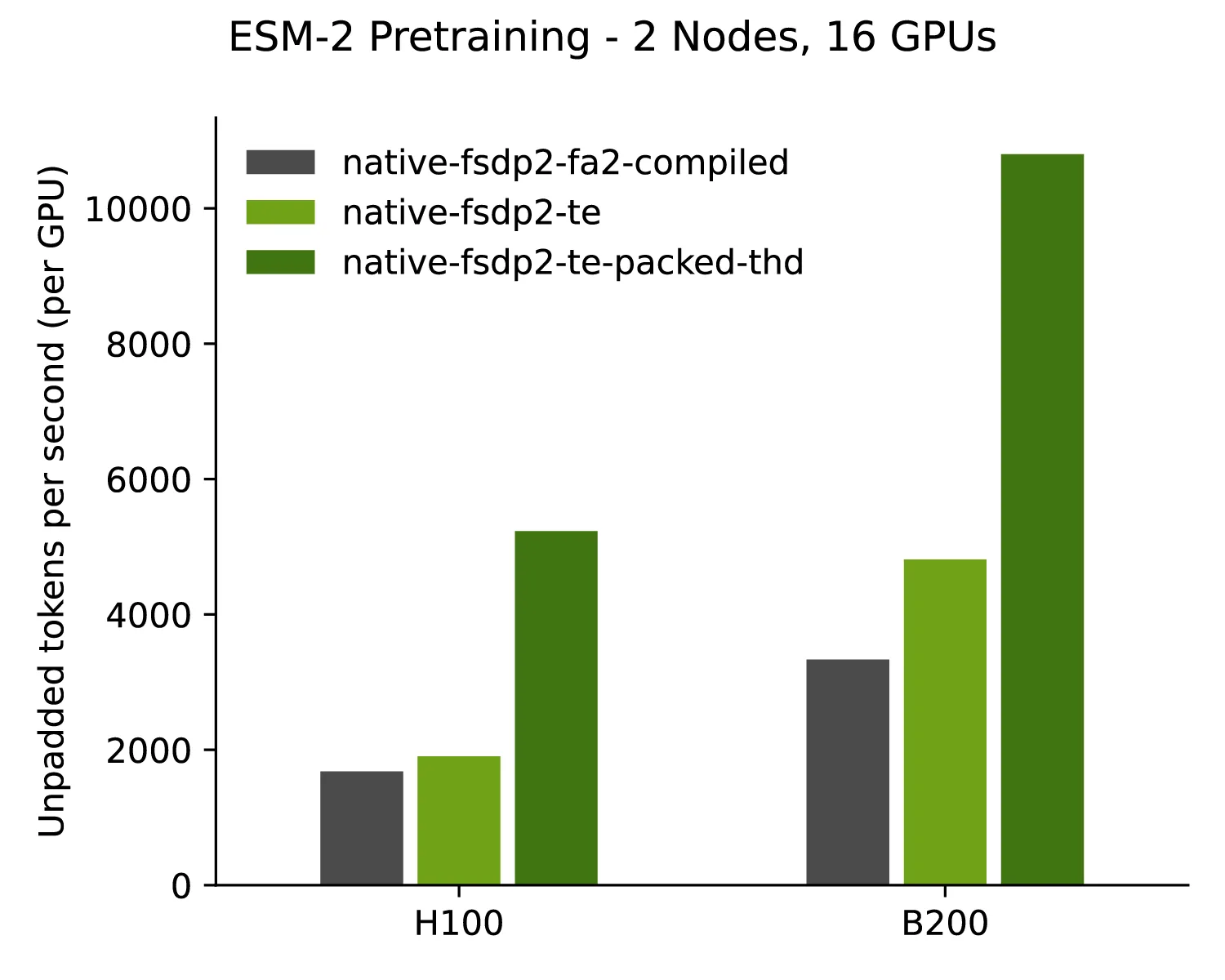

Первый подход – Transformer Engine. Он подменяет стан��артные блоки на оптимизированные версии, которые требуют меньше памяти [2] и быстрее выполняют матричные операции. При этом поддерживаются форматы FP8 и FP4, что позволяет ускорять обучение и инференс без потери точности. Другими словами, это готовое решение для ускорения работы трансформеров с огромными биологическими датасетами.

Второй подход – масштабирование обучения до миллиардов параметров. С помощью FSDP и гибридных режимов параллелизма модель можно разнести по нескольким GPU или узлам, без необходимости вручную собирать сложную конфигурацию. NVIDIA подробно показывает, как правильно распределять вычисления и синхронизировать градиенты, чтобы использовать ресурсы максимально эффективно.

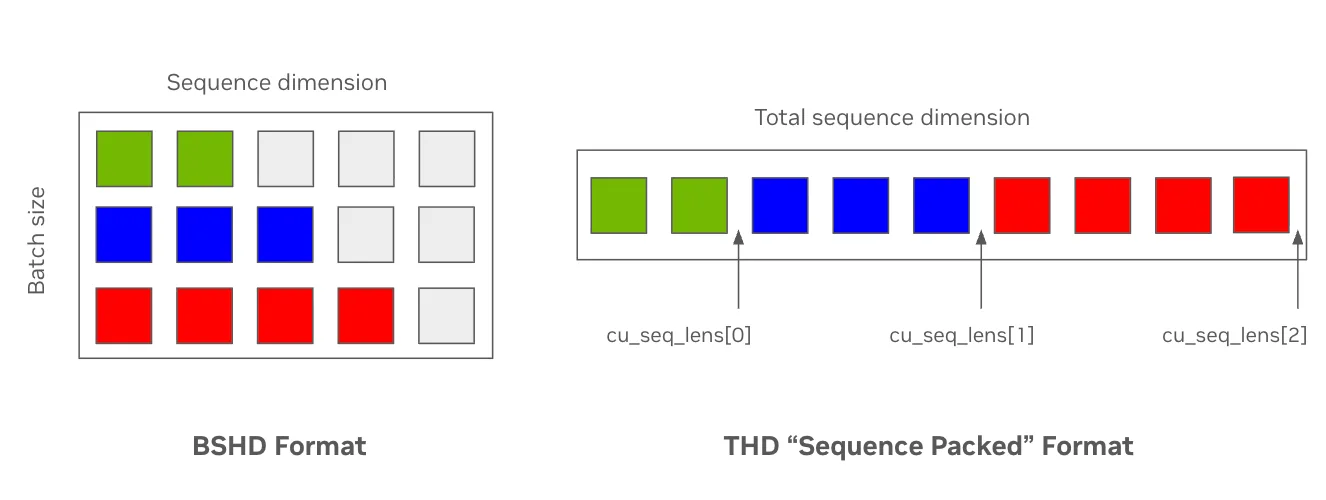

Третий подход касается экономии памяти за счёт sequence packing. Биологические последовательности сильно различаются по длине, и при стандартной обработке половина батча оказывается заполнена паддингами. Packing позволяет сжимать батчи, удаляя пустые токены, что повышает скорость и снижает потребление VRAM. Этот метод особенно полезен при работе с длинными последовательностями ДНК, РНК [3] и белковых цепочек, где эффективность памяти критична.

Чтобы не писать вручную CUDA-ядра и не тратить время на низкоуровневую оптимизацию, NVIDIA предлагает использовать BioNeMo Recipes. Это готовые решения на базе привычного стека PyTorch и HuggingFace, которые позволяют получить производительность уровня крупных фреймворков, не отказываясь от гибкости и удобства Python. Пользователи могут сразу запускать масштабные биологические трансформеры и получать стабильные результаты без глубокого погружения в оптимизацию GPU.

Делегируйте часть рутинных задач вместе с BotHub! [4] Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке [5] вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Подробнее [6]

Автор: cognitronn

Источник [7]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/22260

URLs in this post:

[1] обучение: http://www.braintools.ru/article/5125

[2] памяти: http://www.braintools.ru/article/4140

[3] РНК: http://www.braintools.ru/article/8114

[4] BotHub!: https://bothub.chat/?utm%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C_source=contentmarketing&utm%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C_medium=habr&utm%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C_campaign=news&utm%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C%5C_content=NANO%20BANANA%20PRO%20ADDED%20TO%20LMARENA,%20NOW%20AVAILABLE%20FOR%20FREE%20TESTING

[5] По ссылке: https://bothub.chat/?invitedBy=m_aGCkuyTgqllHCK0dUc7

[6] Подробнее: https://developer.nvidia.com/blog/scale-biology-transformer-models-with-pytorch-and-nvidia-bionemo-recipes/

[7] Источник: https://habr.com/ru/companies/bothub/news/969170/?utm_source=habrahabr&utm_medium=rss&utm_campaign=969170

Нажмите здесь для печати.