Стартап из шести выходцев DeepMind обошел Gemini 3 на главном бенчмарке абстрактного мышления ARC-AGI-2

Команда Poetiq из Майами преодолела [1] порог 50% точности на ARC-AGI-2 — тесте, на абстрактное мышление [2], который считается одним из самых сложных для современных ИИ. Задачи в нем напоминают головоломки из тестов на IQ [3]: нужно посмотреть на несколько примеров задач на визуальное мышление и их решенных вариантов, понять правило преобразования и применить его к новому примеру. Люди справляются с такими задачами интуитивно, а вот языковые модели, натренированные на терабайтах текста, спотыкаются — здесь нельзя угадать ответ по статистике слов, нужно действительно “понять” решение.

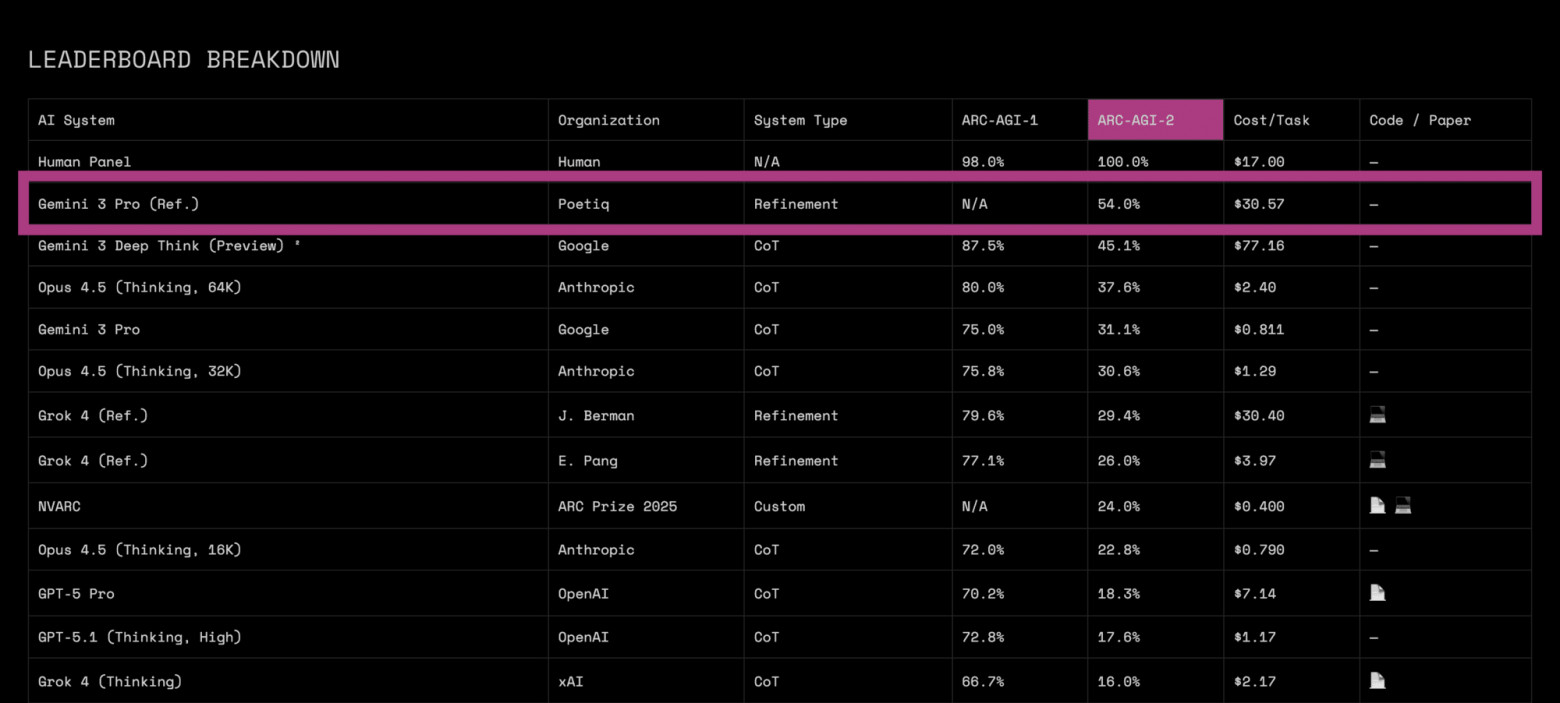

Система Poetiq набрала 54% на полуприватном наборе задач ARC-AGI-2 при стоимости $30,57 за задачу. Для сравнения: предыдущий рекорд принадлежал Gemini 3 Deep Think от Google — 45,1% при $77,16 за задачу. То есть Poetiq одновременно улучшила точность на 9 процентных пунктов и снизила стоимость более чем вдвое. Человеческий уровень все еще далеко — для ARC-AGI-2 он называется в 100%.

Парадокс [4] в том, что у Poetiq нет собственной большой модели. Компания построила “метасистему” — надстройку, которая оркеструет уже существующие LLM (Gemini 3, GPT-5.1, Grok 4 Fast и другие) и заставляет их рассуждать итеративно: генерировать гипотезу, проверять ее на тестовых примерах, анализировать ошибки [5] и дорабатывать решение в цикле. Система сама решает, когда остановиться, чтобы не тратить лишние токены.

Важная деталь: вся адаптация метасистемы была проведена на открытых моделях. А после выхода Gemini 3 Pro, Poetiq интегрировала ее за считанные часы — и сразу получила рекордные результаты. Это, по словам команды, демонстрирует настоящую переносимость подхода: одна и та же стратегия рассуждения улучшает производительность дюжины разных моделей от GPT до Claude Haiku.

ARC-AGI-2 является академическим бенчмарком, но Poetiq утверждают, что подход масштабируется на реальные задачи: код-ревью, юридический анализ, диагностика — везде, где важна не генерация, а проверка корректности. Если заявление верно, то это даст прямую экономию на запуске моделей. Кроме того, метасистема не привязана к конкретному провайдеру: вышла новая модель — подключаешь ее как движок и получаешь прирост без переобучения. А в пределе Poetiq намекает на сдвиг парадигмы: гонка за масштабом моделей становится менее критичной, если интеллект можно «достраивать» сверху за счет правильной оркестрации.

P.S. Поддержать меня можно подпиской на канал “сбежавшая нейросеть [6]“, где я рассказываю про ИИ с творческой стороны.

Автор: runaway_llm

Источник [7]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/22869

URLs in this post:

[1] преодолела: https://poetiq.ai/posts/arcagi_verified/

[2] мышление: http://www.braintools.ru/thinking

[3] IQ: http://www.braintools.ru/article/7605

[4] Парадокс: http://www.braintools.ru/article/8221

[5] ошибки: http://www.braintools.ru/article/4192

[6] сбежавшая нейросеть: https://t.me/ai_exee

[7] Источник: https://habr.com/ru/news/974282/?utm_source=habrahabr&utm_medium=rss&utm_campaign=974282

Нажмите здесь для печати.