Нейро-дайджест: ключевые события мира AI за 4-ю неделю декабря 2025

Привет, с наступающим 🎄 Это последний выпуск «Нейро-дайджеста» — коротких и полезных обзоров ключевых событий в мире искусственного интеллекта [1] и технологий. Но последний лишь в этом году.

Меня зовут Вандер [2], и каждую неделю я обозреваю новости о нейросетях и ИИ.

Неделя выдалась насыщенной: Gemini 3 Flash, GLM-4.7 от китайцев и даже LLM от NVIDIA. Alibaba показали свой ИИ-фотошоп с генерацией по слоям, а в ChatGPT завезли итоги года. Perplexity отключают россиянам Pro-подписки, а роботы уже упаковывают ваши подарки.

Всё самое важное — в одном месте. Поехали!

📋 В этом выпуске:

🧠 Модели и LLM

-

Gemini 3 Flash от Google

-

GLM-4.7 — новая модель для кодинга

-

Nemotron 3 Nano от NVIDIA

-

Повтор промпта улучшает ответы LLM?

🎨 Генеративные нейросети

-

Qwen-Image-Layered — ИИ-фотошоп со слоями

-

Qwen-Image-i2L — LoRA из одной картинки

-

Обновление ACE Studio 2.0 — ИИ для генерации вокала

🔧 AI-инструменты и платформы

-

Итоги года уже в ChatGPT

-

SAM Audio — извлечение любых источников звука

🧩 AI в обществе и исследованиях

-

NVIDIA сократит выпуск игровых видеокарт на 30-40%

-

Perplexity отключает часть Pro-подписок

-

ИИ-блог про фейковую дешёвую недвижимость

-

Роботов научили упаковывать подарки

🧠Модели и LLM

❯ Gemini 3 Flash от Google

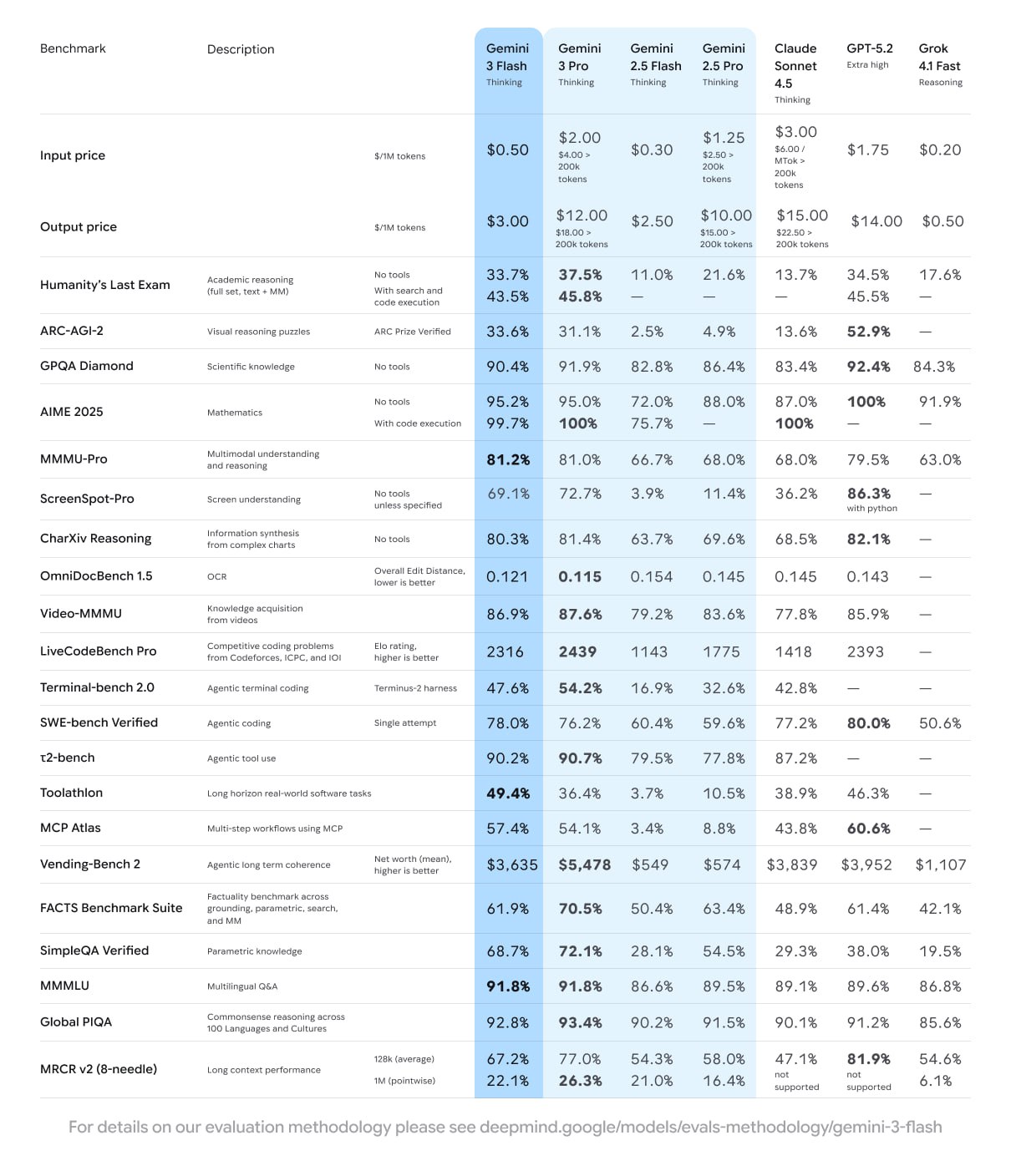

Google выпустили Gemini 3 Flash — быструю и дешёвую модель, рассчитанную на продакшн: кодинг, мультимодальные задачи, агентные сценарии и работу с видео. Цель разработчиков — frontier-уровень качества при минимальной задержке и цене.

Модель показывает PhD-уровень рассуждений в 90,4% на GPQA Diamond, 33,7% на Humanity’s Last Exam, 81,2% на MMMU Pro и 78% на SWE-bench Verified, где она обходит версию 2.5 и даже Gemini 3 Pro.

При этом Flash работает в 3 раза быстрее, чем 2.5 Pro, и использует примерно на 30% меньше токенов.

Gemini 3 Flash одна из самых доступных в своём классе: в API модель стоит $0,50 за 1 млн входных токенов и $3 за 1 млн выходных. В Google AI Studio Flash и Pro доступны бесплатно. Именно Flash теперь используется как основная модель в веб-версии и мобильных приложениях Gemini.

Модель может работать в быстрых режимах или включать Thinking. В режиме рассуждений модель стабильно решает математику [3], хорошо кодит и не теряет стиль текста.

Отдельно отмечают сильную работу с изображениями и видео — модель действительно всматривается в ролики на десятки минут, лучше понимая контекст.

🔗 Официальный анонс [4] 🔗 Google AI Studio [5] 🔗 Бенчмарки [6]

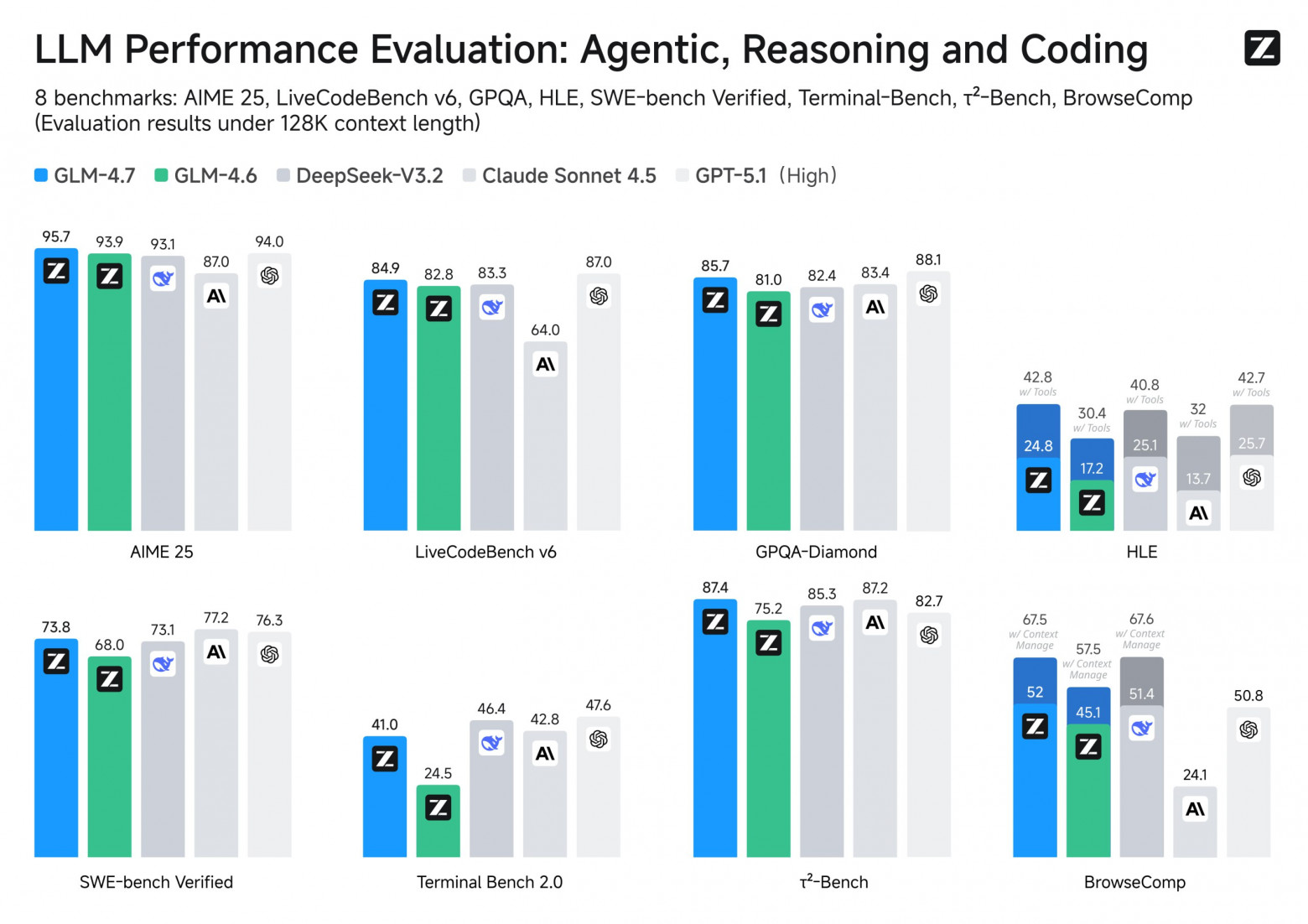

❯ GLM-4.7 — новая SOTA для кодинга

Китайский стартап Z.ai [7] выпустил открытую GLM-4.7. Заточена под кодинг, агентные системы и сложные рассуждения. Очень близка к GPT-5.1 High и Claude Sonnet 4.5 по некоторым метрикам. В опенсорсе сейчас выглядит одним из самых сильных вариантов.

Улучшили кодинг — на SWE-bench результат вырос до 73,8%, а на SWE-bench Multilingual — до 66,7%. В задачах сложных рассуждений GLM-4.7 набирает 42,8% на Humanity’s Last Exam, сравниваясь с топовыми закрытыми моделями.

Главная фишка — разные режимы:

-

Interleaved Thinking: модель думает перед каждым действием и вызовом инструмента. Для длинных задач в кодинге есть

-

Preserved Thinking — GLM сохраняет блоки рассуждений между диалогами и переиспользует их, а не выводит заново.

-

Turn-level Thinking — можно включать или отключать рассуждения в зависимости от сложности запроса, снижая задержку и стоимость.

Веса открыты, можно использовать через чат, API или развернуть локально.

🔗 Чат [8]Z.ai [7] 🔗 Hugging Face [9] 🔗 GitHub [10] 🔗 Блогпост [11] 🔗 Документация и API [12]

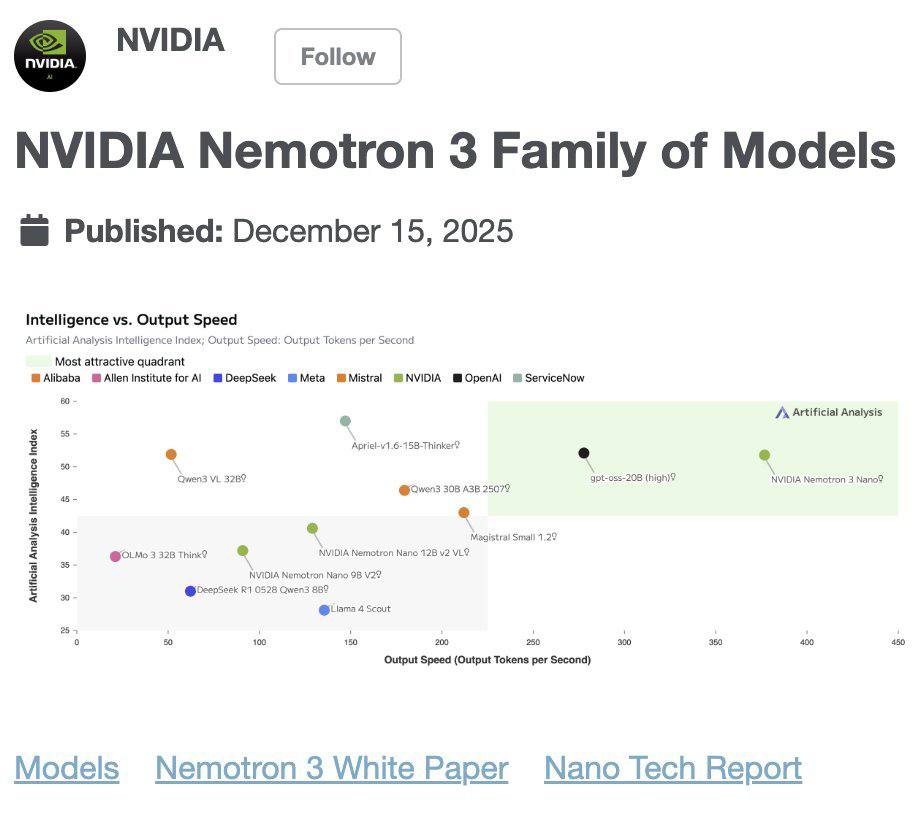

❯ NVIDIA выпустили Nemotron 3 Nano

Nemotron 3 Nano — открытая MoE-модель для агентных задач и кодинга. В модели 31,6B параметров, но активных всего 3,6B, а значит можно запускать даже на 24 ГБ RAM. Контекст — до 1 миллиона токенов.

Модель обходит Qwen3-30B-A3B-Thinking и GPT-oss-20B-A4B на SWE-bench и GPQA. Nemotron 3 Nano шустрая — более 350 токенов в секунду, в 2–3 раза быстрее, чем у похожих моделей у Qwen.

Архитектура гибридная: Mamba + Transformer + MoE, засчёт чего эффективно работает на длинном контексте. Модель ориентирована именно на практическое использование — код, большие документы, длинные диалоги и многошаговые планы. Все веса, датасеты и рецепты обучения [13] открыты.

Nemotron 3 Nano первая в линейке. Более крупные Nemotron 3 Super и Ultra выйдут позже и будут рассчитаны на сложные мультиагентные и reasoning-сценарии.

🔗 Hugging Face [14] 🔗 White Paper [15] 🔗 Nemotron 3 [16]

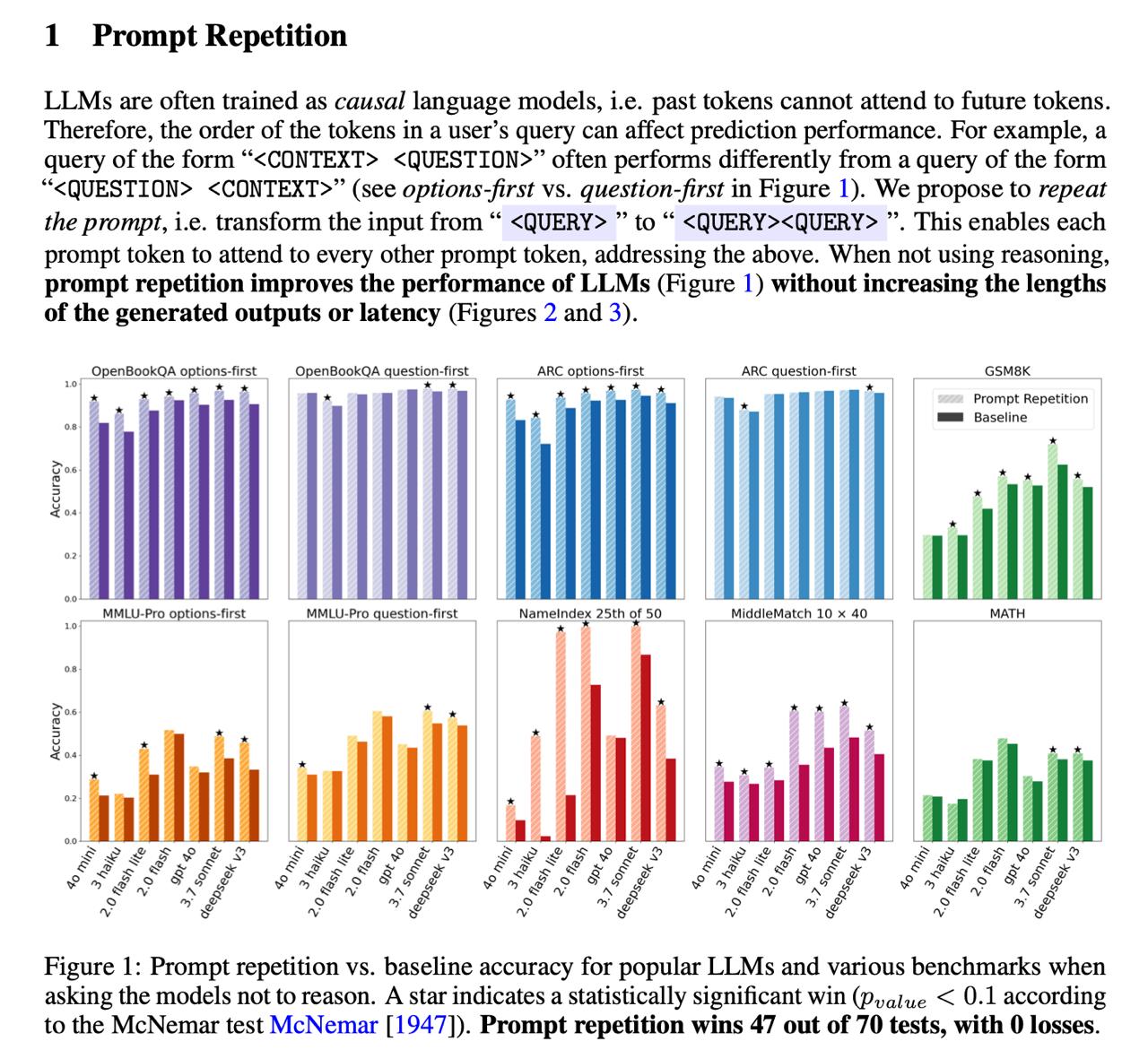

❯ Повторение промпта улучшает ответы LLM?

Исследователи из Google выяснили, что повторение [17] запроса заметно повышает качество ответов у нераcсуждающих LLM. Если вместо обычного <Запрос> отправлять <Запрос><Запрос>, результаты в ряде тестов улучшаются до ~10%, а в 67% случаев эффект статистически значим. Иногда ещё лучше работает тройное повторение или формулировка вроде «Давай я повторю:».

Эффект объясняется так: при повторном чтении запроса модель уже как бы знает контекст, и токены второй части начинают эффективно взаимодействовать с токенами первой.

Это снижает асимметрию внимания [18] и повышает точность ответа. При этом задержка и количество выходных токенов почти не растут.

Ну а для reasoning-моделей метод почти не работает. Такие модели и так склонны повторять запрос внутри цепочки рассуждений, поэтому дополнительное дублирование даёт нулевой или слабый эффект.

🔗 arXiv [19]

🎨 Генеративные нейросети

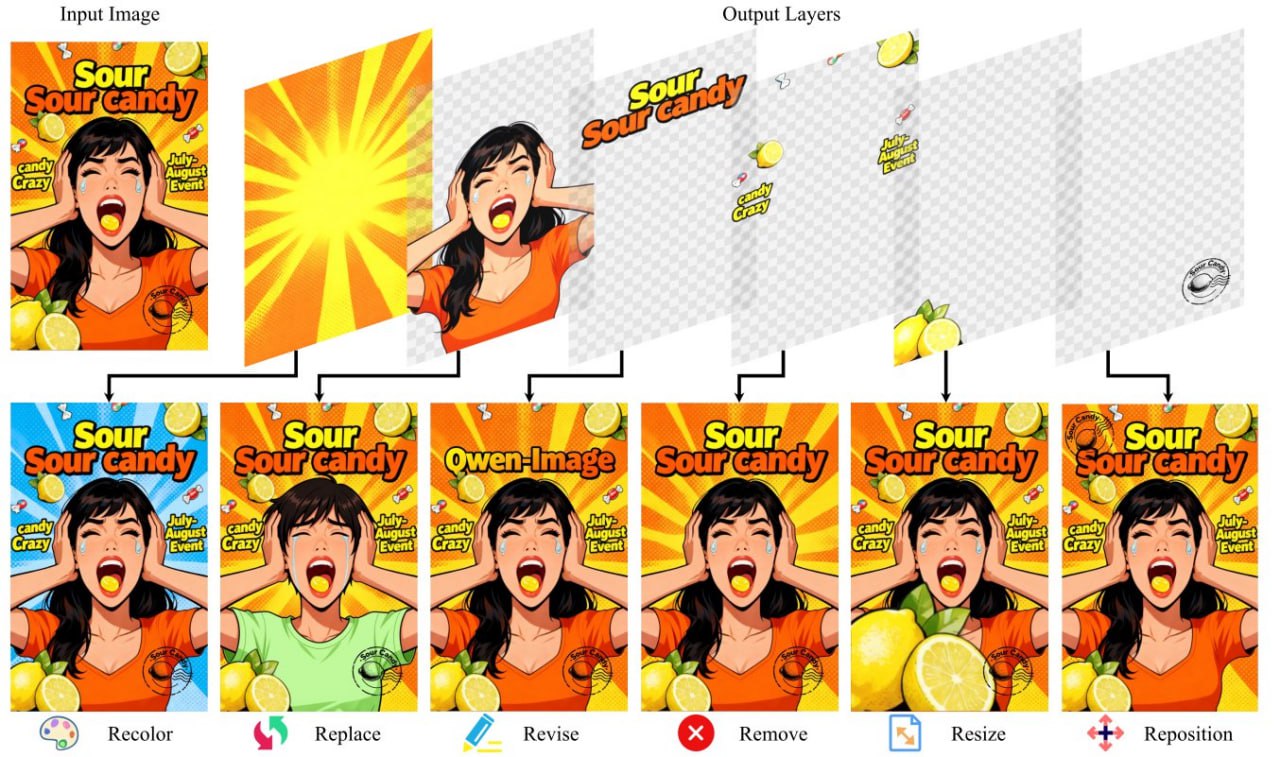

❯ ИИ-фотошоп от Alibaba — Qwen-Image-Layered

Alibaba выпустили реальный ИИ-фотошоп Qwen-Image-Layered. Модель генерирует картинку, и в процессе сама разделяет её на прозрачные RGBA-слои: фон, объекты, текст.как в Photoshop.

Модель обучали на PSD-файлах, поэтому она понимает структуру слоёв. Можно заменять фон, двигать персонажей или править текст, не ломая остальную композицию. По умолчанию создаётся 4 слоя, но их количество можно настраивать под задачу.

Инструмент бесплатный, веса открыты.

🔗 HF Demo [20] 🔗 ModelScope Demo [21] 🔗 Hugging Face [22] 🔗 GitHub [23]

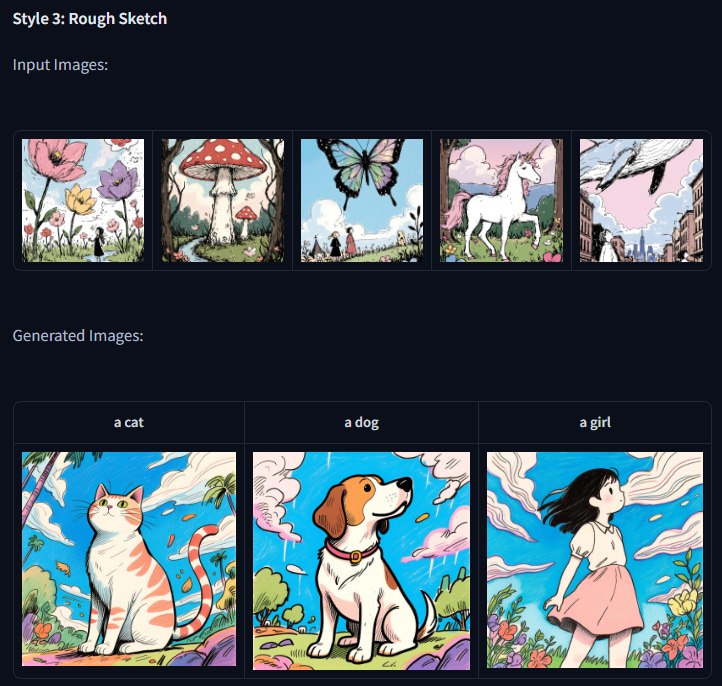

❯ Qwen-Image-i2L — LoRA из одного изображения

Ещё одна новинка от китайцев из Qwen — модель, которая создаёт готовую LoRA по одному изображению. Подобных решений раньше на рынке не было, это не привычный всем IP-адаптер, а полноценный генератор LoRA, который экономит часы на тренировку и сбор датасета.

Всего четыре версии для разных задач:

-

Style 2.4B — идеальна для переноса стиля. Намеренно слабее в деталях, чтобы эффективно извлекать стилистическую информацию

-

Coarse 7.9B — основная модель для сохранения контента. Использует несколько энкодеров: SigLIP2, DINOv3, Qwen-VL и лучше сохраняет структуру

-

Fine 7.6B — работает в связке с Coarse для максимальной детализации за счет повышения разрешения Qwen-VL энкодера до 1024×1024

-

Bias (30M) — корректирующая LoRA, которая приводит изображения к базовому стилю Qwen-Image.

Поддерживаются разные разрешения, от 224×224 до 1024×1024.

Несмотря на довольно большие размеры моделей, аж до 7.9B параметров, они оптимизированы для запуска на потребительских ПК. Не все части модели хранятся в быстрой части VRAM видеокарты, неактивные веса временно выгружаются на SSD или HDD.

🔗 Демо Qwen-Image-i2L [24] 🔗 Hugging Face [25] 🔗 DiffSynth-Studio GitHub [26]

❯ Обновление ACE Studio 2.0

Вышло масштабное обновление ACE Studio 2.0. Теперь это ещё один ИИ-комбайн для генерации музыки и вокала с закосом под привычные DAW.

Что добавили и улучшили:

-

Полный контроль над вокалом. 140+ голосов на 8 языках. Можно сделать вокальную партию: даём на вход MIDI и текст, а потом меняем экспрессию, дыхание [27], эмоциональный окрас фразы и добавляем вибрато. То есть это универсальный генератор вокала, ане готовые сэмплы, которые нужно резать.

-

ИИ-инструменты. Теперь внутри есть живые скрипки, саксофон, труба и даже дудук. Работают через MIDI, но звучат максимально живо, будто встроенный сэмплер Kontakt.

-

Генерация трека с нуля. Появились режимы Inspire Me и Add a Layer, которые позволяют генерировать стемы, слои и петли, собирая полноценный аранж.

-

Полная интеграция. ACE Bridge есть в форматах VST, AU и AAX, что позволяет поставить их в DAW. Уже есть встроенные Stem Splitter и Vocal-to-MIDI.

Подписок нет, только пожизненная лицензия.

🔗 Официальный сайт ACE Studio [28]

🔧 AI-инструменты и платформы

❯ В ChatGPT появились итоги года

OpenAI запустили официальные итоги года в ChatGPT в духе Spotify с персональной статистикой по перепискам.

В итогах показывают базовую персональную аналитику: количество сообщений и чатов за год, самые частые запросы, день с максимальной активностью, «архетип пользователя», а также карточку «год в одном стихотворении». Самое полезное — можно задавать вопросы по своим итогам и даже попросить ChatGPT сформулировать персональные цели на 2026 год.

Есть ограничения. Функция работает только с IP США, Великобритании, Канады, Австралии и Новой Зеландии, и должна быть включена память [29] чатов. У части пользователей фича открывается нестабильно — встречается ошибка [30] Failed to fetch template, так что доступ пока не у всех.

Чтобы попробовать, достаточно зайти в ChatGPT и ввести запрос Your Year with ChatGPT.

🔗 ChatGPT [31]

❯ SAM Audio — извлечение звуков из видео

Meta выпустили SAM Audio — модель, которая позволяет вытаскивать звуки отдельных объектов из видео или аудио. Можно изолировать вокал от инструментов, речь от шума или конкретные звуки вроде шагов, ветра или пения птиц.

У SAM Audio три способа указать, что именно нужно извлечь.

-

Первый — визуальный: достаточно кликнуть на объект в кадре и получить звук, который с ним связан.

-

Второй — текстовый: описываете нужный звук словами.

-

Третий — span prompting: выделяете временной отрезок, где слышен целевой звук, и модель находит его по всей записи.

Подходы можно комбинировать.

Модель работает в реалтайме и использует связку Perception Encoder Audio-Visual (PE-AV) и flow-matching diffusion transformer, что даёт точную изоляцию без сильных артефактов.

Код и веса опенсорс, но под некоммерческой лицензией CC-BY-NC 4.0.

🔗 Демо SAM Audio [32] 🔗 Блогпост [33] 🔗 GitHub [34] 🔗 Hugging Face [35]

🧩 AI в обществе и исследованиях

❯ NVIDIA сократит выпуск игровых видеокарт в 2026

NVIDIA планирует сократить поставки игровых видеокарт RTX 50-й серии на 30–40% в первой половине 2026 года. Под удар в первую очередь попадут RTX 5070 Ti и RTX 5060 Ti 16GB.

Основная причина — дефицит и рост цен на память GDDR7. На фоне этого NVIDIA перераспределяет ресурсы в сторону дата-центров и ИИ-ускорителей, где спрос и маржинальность заметно выше, чем на потребительском рынке. Ещё под вопросом оказался выпуск линейки GeForce RTX 5000 SUPER.

Источники утверждают, что прогноз уже подтвердили партнёры AIC и поставщики компонентов.

Ожидаем рост цен на игровые видеокарты в 2026 году.

🔗 PCMag [36]

❯ Perplexity отключает годовые Pro-подписки россиянам

Perplexity начали отключать годовые Pro-подписки, купленные через маркетплейсы, в том числе у пользователей из России.

А именно подписки, полученные на акционных кодах, которые изначально бесплатно раздавались партнёрами — например, владельцам смартфонов Samsung в США, клиентам индийского оператора Airtel или бизнес-пользователям.

На маркетплейсах такие коды перепродавались за 100–200 рублей, но официально в России эти акции не действовали. Жалобы на отмену подписок появлялись не только у российских пользователей — ��налогичные кейсы обсуждаются на Reddit уже несколько месяцев.

Отключение касается именно промо-подписок. В отдельных случаях блокировку можно оспорить, если доказать службе поддержки, что код был получен легально — например, предоставив чек на покупку устройства, в рамках которого подписка выдавалась.

🔗 Gazeta [37]

❯ ИИ-блог про фейковую дешёвую недвижимость

Популярный блог о «жилье мечты» запостил объявление о продаже несуществующего дома с видом на Альпы. Проверка показала, что все изображения сгенерированы нейросетью — фотографии не прошли валидацию и содержали SynthID, скрытый вотермарк, который используют модели Google.

Дом оказался полностью вымышленным: ни адреса, ни реального объекта, ни исходных фото. Помимо характерных визуальных артефактов, именно SynthID стал решающим доказательством генерации. Ни одно изображение не оказалось настоящим.

История быстро разошлась по соцсетям и стала наглядным примером того, как ИИ уже влияет на рынок визуального контента — даже в нишах, где раньше доверяли картинке «по умолчанию». Интернет наполняется «домами мечты», которых никогда не существовало.

🔗 Оригинальный пост [38]

❯ Роботов научили упаковывать подарки без кода

В Toyota Research Institute показали, как обучить роботов упаковывать подарки без написания кода. Вместо программирования роботам просто показывали как складывать предметы в коробки.

На основе этих действий ИИ-модель выучила закономерности взаимодействия с объектами — от захвата до аккуратной укладки. После обучения система сама упаковала 120 подарков.

Это ещё один шаг к тому, чтобы роботы быстрее осваивали бытовые задачи и адаптировались к реальному миру без долгой инженерной настройки.

❯ Тема недели: кассеты TDK

27 декабря мы отмечаем день рождения бренда, который научил мир сохраняться на магнитную ленту. TDK подарили нам эпоху магнитных лент и кассет

Сегодня похожий процесс происходит в сфере ИИ: нейросети, по сути, это глобальный декодер, который считывает огромную ленту человеческого опыта [39].

Как и старая добрая кассета, ИИ может «зажевать» контекст или выдать шум, но именно в этих артефактах рождается новая цифровая эстетика. Перемотайте свою память на начало: мы снова записываем историю, но теперь — на нейронные связи.

❯ Аудиоверсия дайджеста

❯ Заключение

Неделя выдалась насыщенной: Google, NVIDIA и Alibaba показали сильные модели — от кодинга и генерации изображений до звука, видео и агентных сценариев.

ИИ развивается по всем фронтам — модели, инструменты, инфраструктура.

С наступающим 2026 годом 🎄 Пусть он будет продуктивным, спокойным и без галлюцинаций — и у людей, и у нейросетей.

До встречи в следующем году!

Новости, обзоры продуктов и конкурсы от команды [40]Timeweb.Cloud [41] — в нашем Telegram-канале [40] ↩

Автор: Wonderlove

Источник [42]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/23709

URLs in this post:

[1] интеллекта: http://www.braintools.ru/article/7605

[2] Вандер: http://t.me/neuroport

[3] математику: http://www.braintools.ru/article/7620

[4] Официальный анонс: https://blog.google/products/gemini/gemini-3-flash/

[5] Google AI Studio: https://aistudio.google.com/

[6] Бенчмарки: https://artificialanalysis.ai/models/gemini-3-flash-reasoning#cost-to-run-artificial-analysis-intelligence-index

[7] Z.ai: http://Z.ai

[8] Чат : https://chat.z.ai/

[9] Hugging Face: https://huggingface.co/zai-org/GLM-4.7

[10] GitHub: https://github.com/zai-org/GLM-4.5

[11] Блогпост: https://z.ai/blog/glm-4.7

[12] Документация и API: https://docs.z.ai/guides/llm/glm-4.7

[13] обучения: http://www.braintools.ru/article/5125

[14] Hugging Face: https://huggingface.co/collections/nvidia/nvidia-nemotron-v3

[15] White Paper: https://research.nvidia.com/labs/nemotron/files/NVIDIA-Nemotron-3-White-Paper.pdf

[16] Nemotron 3: https://research.nvidia.com/labs/nemotron/Nemotron-3/

[17] повторение: http://www.braintools.ru/article/4012

[18] внимания: http://www.braintools.ru/article/7595

[19] arXiv: https://arxiv.org/abs/2512.14982

[20] HF Demo: https://huggingface.co/spaces/Qwen/Qwen-Image-Layered

[21] ModelScope Demo: https://www.modelscope.cn/studios/Qwen/Qwen-Image-Layered

[22] Hugging Face: https://huggingface.co/Qwen/Qwen-Image-Layered

[23] GitHub: https://github.com/QwenLM/Qwen-Image-Layered

[24] Демо Qwen-Image-i2L: https://huggingface.co/spaces/AiSudo/Qwen-Image-to-LoRA

[25] Hugging Face: https://huggingface.co/DiffSynth-Studio/Qwen-Image-i2L

[26] DiffSynth-Studio GitHub: https://github.com/modelscope/DiffSynth-Studio

[27] дыхание: http://www.braintools.ru/article/4500

[28] Официальный сайт ACE Studio: https://acestudio.ai/

[29] память: http://www.braintools.ru/article/4140

[30] ошибка: http://www.braintools.ru/article/4192

[31] ChatGPT: https://chatgpt.com/

[32] Демо SAM Audio: https://ai.meta.com/samaudio/

[33] Блогпост: https://ai.meta.com/blog/sam-audio/

[34] GitHub: https://github.com/facebookresearch/sam-audio

[35] Hugging Face: https://huggingface.co/collections/facebook/sam-audio

[36] PCMag: https://uk.pcmag.com/graphics-cards/162132/nvidia-might-cut-rtx-50-gpu-supply-by-up-to-40-in-2026-due-to-memory-shortages

[37] Gazeta: https://www.gazeta.press/tech/news/2025/12/24/27490063.shtml

[38] Оригинальный пост: https://www.instagram.com/p/DSSn2aSkvCD/?hl=en&img_index=1

[39] опыта: http://www.braintools.ru/article/6952

[40] Новости, обзоры продуктов и конкурсы от команды : https://t.me/timewebru

[41] Timeweb.Cloud: http://Timeweb.Cloud

[42] Источник: https://habr.com/ru/companies/timeweb/articles/980310/?utm_source=habrahabr&utm_medium=rss&utm_campaign=980310

Нажмите здесь для печати.