AI для рефератов и исследований: как работает многошаговый генератор текстов в продакшене

В Кэмпе мы много работаем с текстовым генератором — и не в демо, а в продакшене, где ими пользуются тысячи студентов. За это время мы успели поговорить с коллегами из R&D, ассессмента и продукта и разобраться, почему один и тот же AI может писать либо внятный текст, либо странную мешанину из абзацев — даже на похожих запросах.

В этой статье мы расскажем, как на самом деле устроен многошаговый AI-генератор текстов [1]: почему одна нейросеть не справляется, зачем нужно 5–10 моделей, откуда берутся «жёсткие» переходы между абзацами и почему это не баг, а ожидаемый эффект архитектуры.

Почему генерация в один шаг не даёт стабильный результат

Идея «одна модель напишет всё» выглядит логично [2] ровно до первого продакшен-релиза.

Один шаг означает, что модель должна одновременно:

-

понять тему,

-

придумать структуру,

-

удержать логику,

-

написать связный текст,

-

помнить, что было раньше,

-

не противоречить самой себе,

-

и ещё желательно выглядеть «по-человечески».

На коротком тексте это иногда срабатывает. На большой работе — почти никогда.

Проблема здесь не в плохой модели, а в когнитивной перегрузке. Чем больше задач сваливается в один запрос, тем выше вероятность, что модель начнёт упрощать, терять логику или склеивать абзацы по наитию.

Поэтому в реальном продукте генерацию приходится декомпозировать.

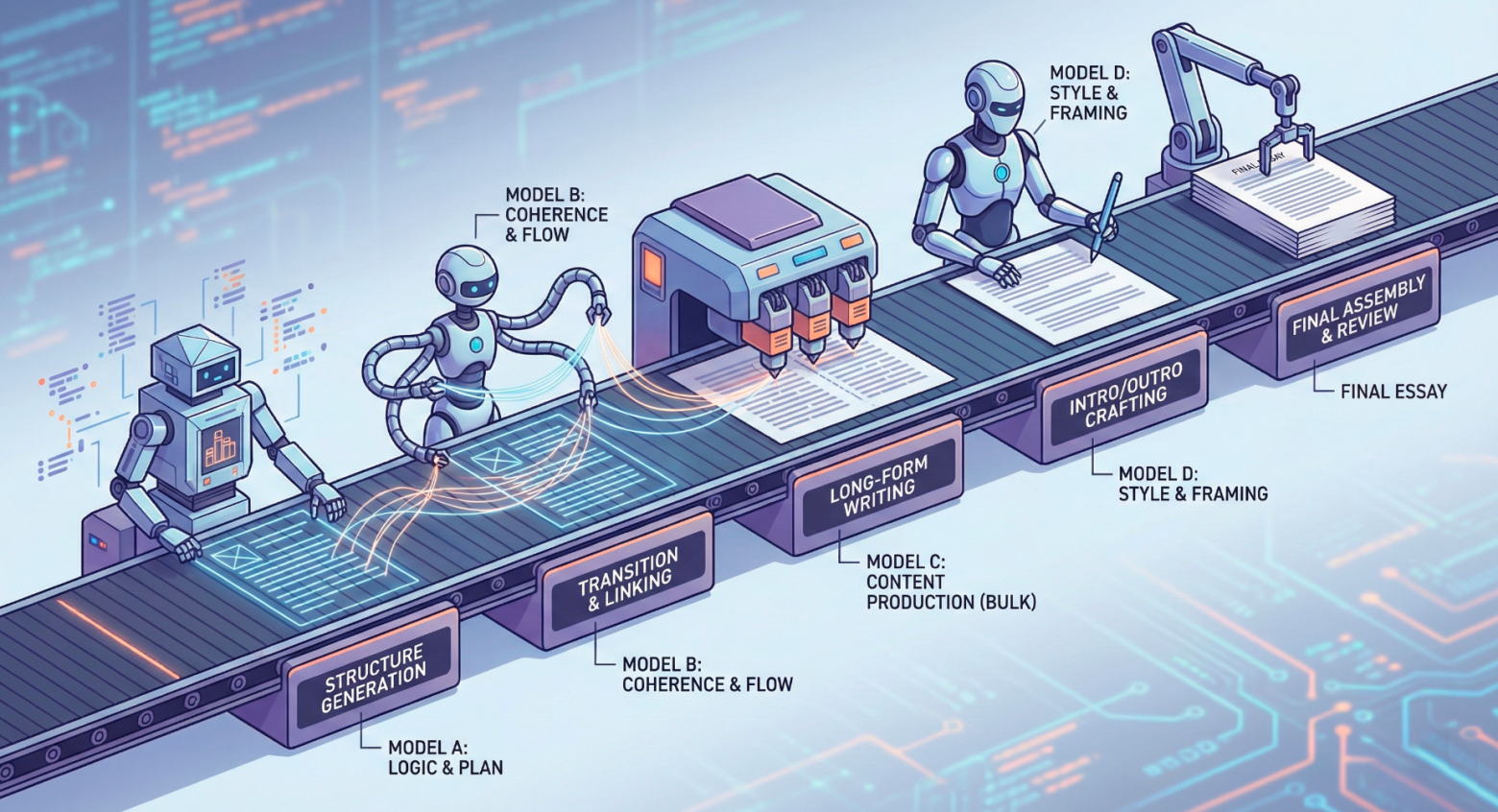

Как работает многошаговый конвейер генерации текста

В многошаговом генераторе текст постепенно собирается. Процесс начинается с простых и формальных вещей:

-

формулируются цели работы,

-

определяется тип текста,

-

задаётся общий контекст и рамки.

Это первый input. Он маленький и понятный.

Дальше происходит ключевой момент, который внутри команды часто называют «снежным комом».

Каждый следующий шаг:

-

получает весь предыдущий контекст,

-

добавляет к нему новую информацию,

-

и передаёт результат дальше.

Input растёт шаг за шагом:

-

сначала обоснование,

-

потом структура,

-

затем описание логики глав,

-

затем нарративы,

-

затем сами абзацы и полный текст.

К финалу модель уже работает не с «темой», а с большим, насыщенным контекстом, где заранее описано: что за работа, зачем она, из каких частей состоит и как эти части связаны.

Именно поэтому итоговый текст выглядит более осмысленным, чем при генерации «с нуля».

Зачем мы используем 5–10 моделей вместо одной

Следующий неочевидный момент: в многошаговой архитектуре почти никогда не используется одна и та же модель. Причина простая: разные шаги — это разные типы задач.

Например:

-

придумать структуру — одна когнитивная задача;

-

связать главы между собой — другая;

-

писать длинный текст — третья;

-

писать введение и заключение — четвёртая.

Одна мо��ель может быть сильной в логике, но слабой в стиле. Другая — писать «по-человечески», но плохо держать структуру. Третья — дешёвая и быстрая, но не очень умная.

Поэтому в реальном генераторе под каждый шаг подбирается своя модель.

В больших пайплайнах таких шагов может быть 8–10 — и это нормально.

Важный момент: модели не спорят между собой. Каждая решает узкую, заранее заданную задачу, а не пытается быть универсальным гением [3].

Как обеспечивается связность текста при работе разных моделей

Логичный вопрос: если разные части текста пишут разные модели, почему результат вообще выглядит связным?

Ответ кроется в промежуточных шагах, которые не генерируют текст для пользователя, но обеспечивают связность.

Между структурой и финальным текстом есть этапы, где:

-

описывается, о чём именно будет каждая глава;

-

формулируются тезисы и нарративы;

-

создаются подводки между блоками.

Эти шаги работают как «клей». При этом каждая модель работает в изоляции от параллельных шагов. Она получает весь накопленный контекст предыдущих этапов: цели работы, структуру, описание содержания глав и подводки. Но при этом не видит тексты, которые в этот же момент генерируются для других разделов.

Это сделано осознанно: параллельная генерация сильно ускоряет процесс и позволяет масштабировать систему под реальную нагрузку. Но у такого подхода есть побочный эффект: модель опирается только на заранее описанную логику, а не на живой текст соседних глав, который в этот момент ещё не существует для неё.

Почему резкие переходы — следствие архитектуры, а не баг

Если продолжить эту логику, становится понятно, откуда берутся резкие переходы между абзацами.

Даже при многошаговой архитектуре иногда видно, что текст «перещёлкивается» между блоками. Это не всегда ошибка [4] и не признак сломанной генерации — чаще всего это прямое следствие архитектурных решений.

Обычно здесь сходятся два фактора.

Во-первых, параллельная генерация

Главы пишутся независимо, чтобы ускорить процесс. Модель знает общий план и подводки, но не видит «живой» текст соседнего абзаца и не может подстроиться под его формулировки.

Во-вторых, жёсткая структура

Когда логика заранее задана и строго соблюдается, текст может выглядеть менее «литературным», но при этом остаётся последовател��ным и управляемым. Для продакшена это часто важнее, чем плавность переходов.

В старых версиях генераторов такие места бросались в глаза сильнее. В новых — они сглаживаются за счёт дополнительных связующих шагов, но полностью не исчезают.

Это осознанный компромисс между литературной плавностью и управляемой логикой, без которой стабильный продукт просто не работает.

Почему стабильный текстовый генератор — это архитектура, а не «умная модель»

В итоге многошаговый AI-генератор — это не попытка «сделать нейросеть умнее», а способ не перегружать её лишними задачами.

Мы не обучаем модели и не надеемся на универсальный интеллект [5]. Вместо этого мы дробим сложную задачу на простые шаги, жёстко задаём рамки каждого этапа и контролируем, какой контекст и с какой целью попадает на вход модели.

Такой подход неизбежно создаёт ограничения: параллельную генерацию, жёсткую структуру, иногда резкие переходы. Но именно эти ограничения и делают систему управляемой, масштабируемой и пригодной для реального продакшена.

В этом смысле хороший генератор текста — это не диалог с «умным AI», а инженерный конвейер, где стабильный результат важнее иллюзии интеллекта. И для продукта, которым пользуются тысячи людей, это оказывается куда ценнее, чем эффектное демо.

А протестировать наш генератор можно на официальном сайте Кэмп [6]

Автор: heim-dallr

Источник [7]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/24218

URLs in this post:

[1] многошаговый AI-генератор текстов: https://eduforms.org/?rid=80e683bc9f0ccbe4&ulp=https%3A%2F%2Fkampus.ai%2Fecosystem%2Ftext-copilot

[2] логично: http://www.braintools.ru/article/7640

[3] гением: http://www.braintools.ru/article/4566

[4] ошибка: http://www.braintools.ru/article/4192

[5] интеллект: http://www.braintools.ru/article/7605

[6] официальном сайте Кэмп: https://eduforms.org/?rid=80e683bc9f0ccbe4

[7] Источник: https://habr.com/ru/companies/kemp_ai/articles/984508/?utm_source=habrahabr&utm_medium=rss&utm_campaign=984508

Нажмите здесь для печати.