Прогноз AI на 2026 год: давление инфраструктуры и рост агентных систем

Поговорили с Head of R&D red_mad_robot Валерой Ковальским [1] о ключевых направлениях развития AI в 2026-м. В статье делимся его прогнозами и разбираем, какие изменения уже формируют индустрию, а какие только станут критичными в ближайшие годы с точки зрения [2] инженерии, масштабирования и реального применения в продуктах.

Дополнительный контекст и комментарии дал Саша Абрамов [3] — AI-визионер, руководитель AI/ML-команд и автор Dealer.AI.

Сдвиг парадигмы обучения

В ближайшие годы AI-индустрия окончательно выйдет из гонки за масштабным базовым предобучением. Рост числа параметров перестанет быть главным источником ценности, а фокус развития LLM сместится в три области:

-

Постобучение

-

Тонкую настройку

-

Архитектурную интеграцию в прикладные системы

Подход к проектированию моделей уйдёт от универсальных «знающих всё» систем. Так что прикладная логика [4] будет всё чаще выноситься за пределы LLM — в инструменты, навыки, внешние источники данных и правила оркестрации. Сама модель станет вычислительным ядром, а ценность будет формироваться на уровне системы вокруг неё.

Долина разочарования

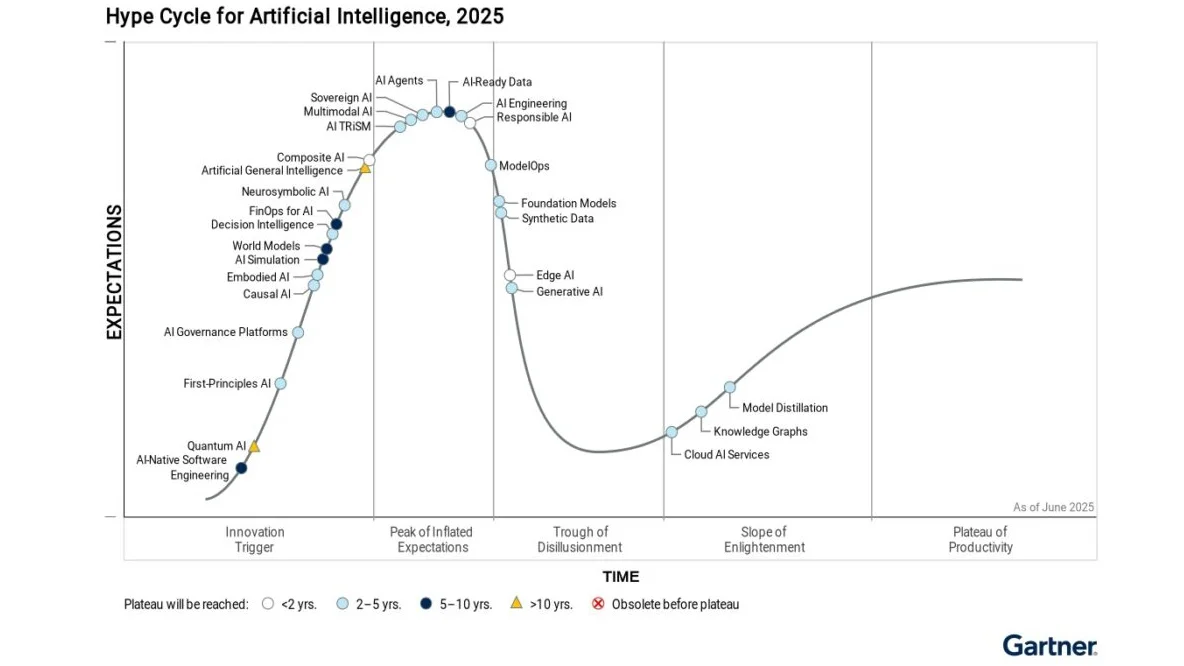

Сейчас агентные системы находятся [5] в верхней точке Hype Cycle по кривой Gartner. Но в ближайшее время это почти неизбежно приведёт к провалу завышенных ожиданий и переходу в «долину разочарования».

Этот этап необходим, чтобы технология вышла на плато эффективности — состояние, в котором становится понятно, где она действительно работает, а где — нет. Аналогичный путь уже прошли RAG-системы, но они быстрее нашли практическое применение благодаря большей детерминированности.

Агентные архитектуры: новая норма

Смещение логики за пределы LLM формирует основу агентных архитектур. В таких системах ценность создаётся не объёмом знаний модели, а её способностью управлять навыками:

-

выстраивать последовательности действий;

-

комбинировать инструменты;

-

анализировать промежуточные результаты;

-

корректировать поведение [6].

Так, LLM перестаёт быть «исполнителем» и становится координатором. Это приближает AI-системы к архитектурам, где интеллект [7] распределён между специализированными компонентами, а не сосредоточен в одной универсальной модели.

На практике уровень успешного выполнения задач часто колеблется в диапазоне 0.9–0.95. Для реальных, особенно критичных сценариев, требуется 0.99 и выше — с предсказуемым поведением [8] и возможностью анализа ошибок.

|

По мере сдвига AI в сторону системного уровня меняется и роль R&D — от исследовательской функции к инженерному драйверу продуктов. И какое совпадение, про это мы выпустили [9] серию интервью с экспертами из Авито, Т-Банка, MWS AI, ВкусВилла и red_mad_robot. |

Самопроверка как базовое требование

С переходом к агентным системам меняется и требование к моделям. Если агент действует автономно, то LLM должна уметь корректно работать с инструментами, проверять шаги и выявлять ошибки [10] в ходе выполнения задачи.

Это сдвигает развитие AI в сторону:

-

reasoning-подходов как механизма самопроверки;

-

пересборки этапов обучения [11] для снижения галлюцинаций;

-

новых метрик, оценивающих способность моделей управлять несколькими инструментами и задачами одновременно.

Контекст-инжиниринг вместо промптов

Проблемы качества уже перестают решаться за счёт простого увеличения контекстного окна. Практика показывает, что эффективные системы работают с контекстами в десятки тысяч токенов, а не миллионами.

В этой парадигме на первый план выходит контекст-инжиниринг — проектирование структуры диалога, форматов данных, механизмов сжатия, памяти [12] и логики вызова инструментов. Это позволяет наращивать автономность и переводит заявления о многочасовой работе агентов в воспроизводимую практику.

Развитие пойдёт по двум направлениям одновременно:

-

Архитектурные улучшения моделей и механизмов внимания [13] для роста эффективного контекста.

-

Инженерные решения по сжатию информации: новые форматы представления знаний, компрессия и внешняя память.

Экономика инференса

Экономика AI всё меньше определяется обучением моделей и всё больше — их исполнением. Инференс станет основной статьёй затрат: каждый запрос — это вычисления, энергия и задержки. Поэтому компании будут оптимизировать веса, применять квантование и ускорять генерацию без увеличения размера моделей.

Именно стоимость и скорость инференса будут определять, какие AI-решения смогут стать частью реальных продуктов.

Узким местом будет не только доступность GPU или CPU, но и энергия, энергоэффективность, охлаждение и каналы связи. AI всё больше упирается в физическую инфраструктуру, а это усиливает роль энергетики, энергоэффективных технологий и сетей передачи данных в общей экономике AI.

Архитектуры и специализация

Один из ключевых векторов оптимизации — снижение вычислительной нагрузки без потери качества. Вместо дальнейшего роста параметров индустрия движется к более компактным и специализированным архитектурам.

Mixture of Experts (MoE) и системы с моделью-роутером позволяют активировать только часть весов под конкретную задачу. Аналогичная логика уже используется в агентных системах — со специализированными субагентами и управляющим агентом-оркестратором.

Крупные компании сохранят контроль над core-технологиями и инфраструктурой. Параллельно open-source и комьюнити будут развивать небольшие, специализированные модели с лучшим соотношением цена–качество, что в итоге приведёт нас к большей демократизации рынка.

Новые интерфейсы и AI-Native системы

Чат с полем ввода уже сегодня перестаёт быть базовой формой взаимодействия с AI. По мере интеграции моделей в продукты интерфейсы будут проектироваться под конкретные сценарии и задачи, а не вокруг универсального диалога. Так, UX сместится от общения к управлению процессами.

В перспективе также появятся AI-Native системы, где LLM и агенты встроены на уровне базовой инфраструктуры и постоянно участвуют в работе продукта.

Рынок разделится на два слоя:

-

Компании, создающие core AI-технологии и API

-

Компании, которые строят прикладные решения, интерфейсы и бизнес-сценарии поверх этих технологий

Оба подхода жизнеспособны, ключевой фактор — экономическая эффективность.

Agentic Commerce

Потребительские сценарии перейдут от взаимодействия к делегированию: пользователь формулирует намерение, а выполнение берёт на себя агент, оставляя человеку только точки контроля и подтверждения.

|

«Собери корзину на десять человек в сервисе доставки»: агент подбирает варианты и присылает на чекаут. |

«Найди самый дешёвый размер обуви в наличии в моём городе на маркетплейсе»: агент выполняет поиск, сравнение и проверку. |

Такие паттерны особенно востребованы там, где важны скорость, удобство и снижение когнитивной нагрузки:

-

e-commerce

-

доставка

-

поиск и сравнение товаров

-

бронирования

Пока агентные системы не обеспечивают необходимый уровень надёжности, подобные сценарии будут внедряться постепенно и с ограниченным уровнем автономности.

Массовое принятие возможно только при достижении высокой предсказуемости результата.

Регулирование и барьеры внедрения

В 2026–2028 годах массовое регулирование AI будет формироваться преимущественно через требования к инфраструктуре, а не пользовательским продуктам. Возможны обязательная сертификация моделей, вычислительных сред и датасетов, особенно в госсекторе и критических областях. Это повысит порог входа в проекты и увеличит ответственность компаний, предоставляющих доступ к LLM, включая требования к безопасности и санкции за нарушения.

Регуляторы будут оценивать не только, что модель отвечает, но и где, как и в каких условиях она запущена. Это ещё один фактор, который ускорит переход от экспериментов к инженерно зрелым AI-системам.

Итоги

В 2026 году развитие AI будет определяться не отдельными технологическими прорывами, а качеством системной сборки: архитектурой, экономикой инференса, уровнем автономности и требованиями к надёжности.

Модели всё чаще будут рассматриваться как базовый компонент более сложных AI-систем — с распределённой логикой, встроенными механизмами контроля и ограничениями со стороны инфраструктуры и регулирования.

Именно эта связка — инженерная зрелость, экономическая эффективность и управляемая автономность — станет ключевым критерием применимости AI в реальных продуктах и бизнес-контекстах.

Над материалом работали:

Текст — Валера Ковальский, Саша Абрамов

Редактура — Саша Лазарева

Иллюстрации — Саша Буяк

Это блог red_mad_robot. Мы запускаем цифровые бизнесы и помогаем компаниям внедрять AI. Здесь наша команда разработки на собственных кейсах рассказывает о том, что происходит с AI сегодня, а стратегические аналитики подсказывают, что будет завтра. Мы бы подписались.

Наш Telegram-канал: t.me/redmadnews [14]

Автор: redmadrobot

Источник [15]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/24920

URLs in this post:

[1] Валерой Ковальским: https://t.me/neuraldeep

[2] зрения: http://www.braintools.ru/article/6238

[3] Саша Абрамов: https://t.me/dealerAI/1645

[4] логика: http://www.braintools.ru/article/7640

[5] находятся: https://www.gartner.com/en/documents/6579402

[6] поведение: http://www.braintools.ru/article/9372

[7] интеллект: http://www.braintools.ru/article/7605

[8] поведением: http://www.braintools.ru/article/5593

[9] выпустили: https://t.me/Redmadnews/5146

[10] ошибки: http://www.braintools.ru/article/4192

[11] обучения: http://www.braintools.ru/article/5125

[12] памяти: http://www.braintools.ru/article/4140

[13] внимания: http://www.braintools.ru/article/7595

[14] t.me/redmadnews: https://t.me/+3lxUnV6YgYtkNzAy

[15] Источник: https://habr.com/ru/companies/redmadrobot/articles/990698/?utm_source=habrahabr&utm_medium=rss&utm_campaign=990698

Нажмите здесь для печати.