Подростковый период технологий

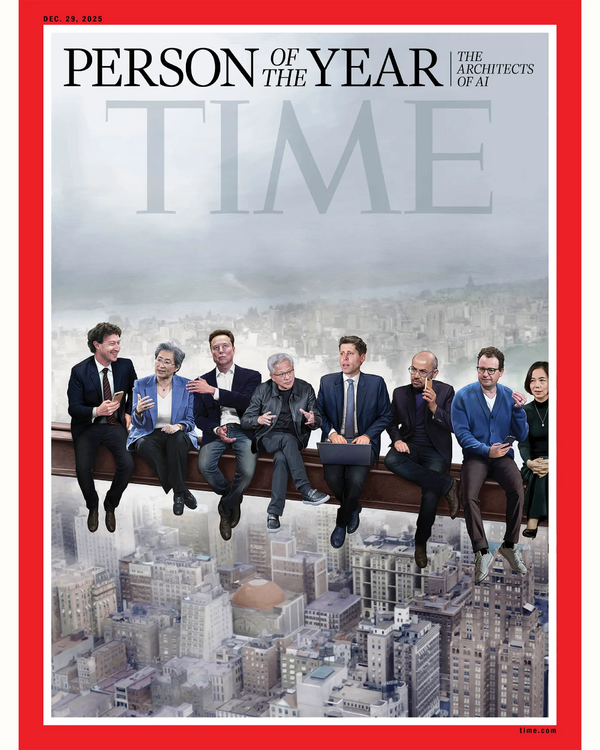

Это перевод эссе Дарио Амодеи «Подростковый период технологий» [1]. Да, мы уже устали от статей про ИИ (многие из которых написаны LLM). А здесь еще и лонгрид. Но я всё же решился перевести это эссе. Его автор — генеральный директор и соучредитель Anthropic (модель Claude). В 2025 году он вошёл в список 100 самых влиятельных людей по версии журнала Time, до этого работал в OpenAI, курировал создание GPT-2 и GPT-3. Был назван одним из «архитекторов искусственного интеллекта», которых Time выбрал «человеком года», наравне с парнями и девушками на фото.

Амодеи говорит о различных рисках и аспектах безопасности в мире, в котором ИИ становится всё сильнее. При этом некоторые его идеи крайне “ястребиные”, поэтому, переводя текст, мне пришлось смягчать (с сохранением смысла) некоторые его довольно резкие выпады против стран, которые он считает “противниками демократий”. Но, несмотря на это, возможно, Амодеи сейсчас предвосхищает некоторые политические тенденции и точки напряжения как между разными странами, так и внутри стран, включая западные демократии, и эти точки напряжения создаёт набирающий силу ИИ…

Dario Amodei

The Adolescence of Technology

Confronting and Overcoming the Risks of Powerful AI

January 2026

Подростковый период технологий

Противостояние и преодоление рисков мощного ИИ

Январь 2026 г.

В экранизации книги Карла Сагана «Контакт» есть сцена, в которой главную героиню, астронома, обнаружившую первый радиосигнал от инопланетной цивилизации, рассматривают как кандидата на роль представителя человечества для встречи с инопланетянами. Международная комиссия, проводящая собеседование, спрашивает её: «Если бы вы могли задать им всего один вопрос, какой бы это был вопрос?» Она отвечает: «Я бы спросила их: “Как вам это удалось? Как вы прошли путь эволюции и пережили подростковый возраст технологий, не уничтожив самих себя?”»

Когда я думаю о том, где сейчас находится человечество с точки зрения ИИ, и о том, на пороге чего мы стоим, мои мысли постоянно возвращаются к этой сцене. Потому что этот вопрос так точно отражает наше нынешнее положение. И мне хотелось бы, чтобы у нас был ответ инопланетян, который помог бы нам найти верный путь.

Я считаю, что мы вступаем в некий бурный, но неизбежный обряд посвящения, который проверит, кто мы есть как вид. Человечеству вот-вот будет вручена почти невообразимая сила, и совершенно неясно, достаточно ли зрелыми являются наши социальные, политические и технологические системы, чтобы управлять ею.

В своём эссе «Машины любящей благодати» (Machines of Loving Grace [2]) я попытался описать мечту о цивилизации, достигшей зрелости, где риски были устранены, а мощный ИИ применяется умело и с состраданием, повышая качество жизни для всех. Я предположил, что ИИ может способствовать прорывным достижениям в биологии, нейронауке, экономическом развитии, глобальном мире, а также в сфере труда и даже в об��етении смысла жизни. Мне казалось важным дать людям нечто вдохновляющее, за что стоило бы бороться. Задачу, в решении которой, как ни странно, потерпели неудачу как сторонники ускоренного развития ИИ («акселерационисты»), так и сторонники ИИ-безопасности.

Но в этом эссе я хочу обратиться именно к самому обряду посвящения: наметить риски, с которыми мы столкнёмся, и начать разрабатывать боевой план для их преодоления. Я глубоко верю в нашу способность одержать победу, в дух и благородство человечества, но мы должны трезво и без иллюзий взглянуть в лицо сложившейся ситуации.

Как и при обсуждении преимуществ, я считаю крайне важным говорить о рисках внимательно и взвешенно. В частности, я считаю важным следующее:

-

Избегать «думеризма». Под «думеризмом» я имею в виду не только убеждённость в неизбежности гибели (что само по себе ложно и становится самореализующимся пророчеством), но и более широкое восприятие рисков ИИ в квазирелигиозном ключе(1).

(1) Это симметрично тому, что я высказал в «Машинах любящей благодати [2]», где начал с утверждения, что не следует воспринимать преимущества ИИ как пророчество спасения, и что важно быть конкретным, приземлённым и избегать пафоса. В конечном счёте, как пророчества спасения, так и пророчества гибели мешают трезво взглянуть на реальный мир — по сути, по одним и тем же причинам.Многие люди уже много лет аналитически и трезво размышляют об ИИ-рисках, но, по моему впечатлению [3], в пик опасений по поводу ИИ в 2023–2024 годах на первый план вышли самые неразумные голоса, и часто мы слышали эти голоса через социальные сети. Эти голоса использовали отталкивающий язык, напоминающий крайнюю религиозность или научную фантастику, и призывали к крайним мерам без достаточных доказательств, оправдывающих такие шаги. Уже тогда было очевидно, что неминуема обратная реакция, и проблема станет культурно поляризованной, а значит — заблокированной(2).

(2) Цель Anthropic — сохранять последовательность, несмотря на такие перемены. Когда обсуждение рисков ИИ было в политической моде, Anthropic осторожно выступала за взвешенный и основанный на доказательствах подход к этим рискам. Теперь, когда говорить о рисках ИИ стало политически непопулярно, Anthropic по-прежнему осторожно выступает за взвешенный и основанный на доказательствах подход к этим рискам.По состоянию на 2025–2026 годы маятник качнулся в другую сторону: сегодня политические решения всё чаще продиктованы возможностями ИИ, а не его рисками.

Такая непостоянность печальна, ведь саму технологию не заботит то, что нынче в моде, и в 2026 году мы стали значительно ближе к реальной опасности, чем в 2023 году.

Урок здесь таков: мы должны обсуждать и устранять риски реалистично и прагматично, трезво, опираясь на факты и будучи готовыми к переменам общественных настроений.

-

Признавать неопределённость. Существует множество сценариев, при которых изложенные здесь опасения окажутся неактуальными. Ничто в этом эссе не должно восприниматься как утверждение о достоверности или даже вероятности угроз. Прежде всего, ИИ может просто не развиваться так быстро, как я предполагаю(3).

(3) Со временем я всё больше убеждался в траектории развития ИИ и вероятности того, что он превзойдёт человеческие способности во всех областях, но некоторая неопределённость остаётся.Даже если он будет развиваться стремительно, некоторые или все описанные здесь риски могут так и не реализоваться (что было бы прекрасно), либо возникнут другие, не учтённые мной угрозы. Никто не может с полной уверенностью предсказать будущее, но мы обязаны делать всё возможное, чтобы планировать наперёд.

-

Вмешиваться максимально точечно. Для устранения рисков, связанных с ИИ, потребуется сочетание добровольных действий компаний (и частных независимых участников) и мер, принимаемых правительствами, которые будут обязательны для всех.

Добровольные действия, их осуществление, поощрение других компаний следовать этому примеру, представляются мне очевидной необходимостью. Я твёрдо убеждён, что вмешательство со стороны государства также понадобится, хотя такие меры принципиально отличаются: они могут разрушать экономическую ценность или принуждать несогласных участников, скептически настроенных по отношению к этим рискам (и, возможно, они окажутся правы!). Кроме того, регулирование нередко даёт обратный эффект или усугубляет ту проблему, которую должно решать (особенно в случае быстро меняющихся технологий).

Поэтому крайне важно, чтобы регулирование было осмотрительным: оно должно стремиться избегать побочного ущерба, быть максимально простым и накладывать минимально необходимое бремя для достижения цели(4).

(4) Экспортный контроль в отношении чипов — отличный пример такого подхода. Он прост и, похоже, в основном, действительно работает.Легко сказать: «Никакие меры не чрезмерны, когда речь идёт о судьбе человечества!», но на практике такой подход лишь вызывает обратную реакцию.

Разумеется, вполне возможно, что со временем мы действительно дойдём до точки, где потребуются гораздо более решительные меры, но это будет зависеть от появления более веских доказательств надвигающейся и конкретной опасности, чем те, что у нас есть сегодня, а также от достаточной конкретики самой угрозы, чтобы можно было сформулировать правила, реально способные её устранить.

Самое конструктивное, что мы можем сделать сегодня, — это выступать за ограниченные, целенаправленные прав��ла, пока собираем данные, подтверждающие (или опровергающие) необходимость более жёстких мер (5).

(5) И, конечно, поиск таких доказательств должен быть интеллектуально честным, то есть он может также выявить отсутствие опасности. Прозрачность через системные карты моделей и другие формы раскрытия информации — попытка именно такой интеллектуально честной деятельности.

С учётом всего вышесказанного, лучшей отправной точкой для обсуждения рисков ИИ, как мне кажется, является тот же самый вопрос, с которого я начал рассуждения о его преимуществах: необходимо чётко определить, о каком уровне ИИ идёт речь.

Уровень ИИ, вызывающий у меня цивилизационные опасения, — это тот самый «мощный ИИ», о котором я писал в «Машинах любящей благодати [2]». Я просто повторю здесь определение, данное в том эссе:

Под «мощным ИИ» я имею в виду ИИ-модель (вероятно, похожую по форме на современные большие языковые модели, LLM, хотя она может быть основана на иной архитектуре, включать несколько взаимодействующих моделей и использовать иные методы обучения) обладающую следующими свойствами:

По уровню чистого интеллекта она умнее лауреата Нобелевской премии почти во всех соответствующих областях: биология, программирование, математика [4], инженерия, писательское мастерство и т.д. Это означает, что она способна доказывать нерешённые математические теоремы, писать исключительно хорошие романы, создавать с нуля сложные кодовые базы и т.п.

Помимо того, что она просто «умный собеседник», она имеет все интерфейсы, доступные человеку, работающему удалённо: текст, аудио, видео, управление мышью и клавиатурой, доступ в интернет. Она может выполнять любые действия, коммуникации или дистанционные операции, возможные через эти интерфейсы: действовать в интернете, давать или получать указания от людей, заказывать материалы, руководить экспериментами, смотреть и создавать видео и т.д. — причём делает всё это с мастерством, превосходящим лучших людей в мире.

Она не просто пассивно отвечает на вопросы; ей можно ставить задачи, выполнение которых занимает часы, дни или недели, и тогда она самостоятельно берётся за их решение, как это сделал бы умный сотрудник, запрашивая уточнения при необходимости.

Она не имеет физического тела (кроме присутствия на экране компьютера), но может управлять существующими физическими инструментами, роботами или лабораторным оборудованием через компьютер; в теории она даже может сама спроектировать роботов или оборудование для собственного использования.

Ресурсы, использованные для её обучения, можно перенаправить на запуск миллионов её копий (это соответствует прогнозируемым размерам вычислительных кластеров к ~2027 году), и каждая копия может воспринимать информацию и генерировать действия примерно в 10–100 раз быстрее человека. Однако её скорость может лимитироваться ограничениями физического мира или программного обеспечения, с которым она взаимодействует.

Каждая из этих миллионов копий может работать независимо над разными задачами или, при необходимости, объединяться для совместной работы, как это делают люди, возможно, с разными подгруппами моделей, дополнительно дообученных под конкретные задачи.

Можно резюмировать это как «страна гениев в дата-центре».

Как я писал в «Машинах любящей благодати [2]», мощный ИИ может появиться уже через 1–2 года, хотя он также может появиться и значительно позже(6).

(6) Действительно, с момента написания «Машин любящей благодати [2]» в 2024 году ИИ-системы стали способны выполнять задачи, на которые у людей уходит несколько часов: недавняя оценка METR показала, что Opus 4.5 может выполнить объём работы, эквивалентный четырём часам человека, с надёжностью 50 %.

Точный момент его появления — сложная тема, достойная отдельного эссе, но сейчас я лишь кратко объясню, почему считаю, что он может появиться очень скоро.

Мои соучредители в Anthropic и я одними из первых задокументировали и начали отслеживать «законы масштабирования [5]» ИИ-систем — наблюдение о том, что по мере увеличения вычислительных ресурсов и объёма обучающих данных ИИ-системы предсказуемо улучшаются практически во всех измеряемых когнитивных навыках. Каждые несколько месяцев общественное мнение то убеждается, что ИИ «упёрся [6] в стену [7]», то воодушевляется новым прорывом, который «кардинально изменит игру», но на самом деле за всей этой волатильностью и публичными спекуляциями скрывается плавный и неуклонный рост когнитивных возможностей ИИ.

Сейчас мы достигли точки, когда ИИ-модели начинают делать успехи в решении нерешённых математических задач и уже настолько хорошо программируют, что некоторые из лучших инженеров, которых я когда-либо встречал, теперь передают почти всё своё кодирование в руки ИИ. Всего три года назад ИИ с трудом справлялся с арифметическими задачами начальной школы [8] и едва мог написать одну строку кода.

Аналогичные темпы улучшений наблюдаются в биологии [9], финансах, физике и множестве задач, требующих автономности (agentic tasks). Если эта экспонента продолжится (хоть это не гарантировано, но уже подтверждается десятилетней статистикой) тогда не пройдет и нескольких лет, как ИИ станет лучше людей буквально во всём.

На самом деле, эта картина, вероятно, даже занижает ожидаемые темпы прогресса. Поскольку ИИ уже пишет значительную часть кода в Anthropic [10], он существенно ускоряет наши собственные темпы разработки следующего поколения ИИ-систем. Этот цикл обратной связи набирает обороты месяц за месяцем и, возможно, уже через 1–2 года достигнет точки, когда текущее поколение ИИ сможет автономно создавать следующее. Этот цикл уже начался и будет стремительно ускоряться в ближайшие месяцы и годы. Наблюдая за прогрессом последних пяти лет изнутри Anthropic и глядя на то, как формируются модели следующих нескольких месяцев, я ощущаю этот нарастающий темп и отсчёт времени.

В этом эссе я буду исходить из того, что эта интуиция хотя бы отчасти верна. Не в смысле того, что мощный ИИ обязательно появится через 1–2 года(7), но что существует некоторая вероятность этого, и очень высокая вероятность его появления в ближайшие несколько лет.

(7) И чтобы было ясно: даже если мощный ИИ появится уже через 1–2 года в техническом смысле, многие его социальные последствия, как положительные, так и отрицательные, могут проявиться лишь спустя несколько лет. Именно поэтому я могу одновременно считать, что ИИ вытеснит 50 % простых беловоротничковых рабочих мест в течение 1–5 лет, и при этом полагать, что ИИ, превосходящий всех людей по способностям, может появиться уже через 1–2 года.

Как и в «Машинах любящей благодати [2]», серьёзное отношение к этому предположению может привести к удивительным и тревожным выводам. Там я сосредоточился на позитивных последствиях, а здесь — на тех, что вызывают беспокойство. Это выводы, заключения, с которыми мы, возможно, не хотим сталкиваться, но это не делает их менее реальными. Могу лишь сказать, что день и ночь я думаю о том, как направить нас в сторону позитивных исходов и в сторону от негативных, и в этом эссе я подробно расскажу, как этого добиться.

Думаю, лучший способ осознать риски, связанные с ИИ, можно задав следующий вопрос: представьте, что в ~2027 году где-то в мире внезапно появляется буквальная «страна гениев». Допустим, 50 миллионов людей, каждый из которых намного способнее любого нобелевского лауреата, государственного деятеля или технолога. Аналогия несовершенна, поскольку у этих «гениев» может быть чрезвычайно широкий спектр мотиваций [11] и моделей поведения [12] — от полностью послушных и покорных до странных и «инопланетных» по своим побуждениям. Но пока оставим аналогию и представим, что вы — советник по национальной безопасности крупного государства, отвечающий за оценку и реагирование на эту ситуацию. Представьте также, что, поскольку ИИ-системы могут работать в сотни раз быстрее людей, эта «страна» обладает временным преимуществом по отношению ко всем остальным странам: на каждое когнитивное действие с нашей стороны эта страна может совершить десять.

Что нас должно беспокоить?

Я бы беспокоился о следующем:

-

Риски автономии. Каковы намерения и цели этой страны? Враждебна ли она или разделяет наши ценности? Может ли она добиться военного господства над миром с помощью превосходящего оружия, киберопераций, операций влияния или производства?

-

Злоупотребление в целях разрушения. Допустим, новая страна податлива и «следует инструкциям», то есть по сути представляет собой страну наёмников. Могут ли существующие злонамеренные субъекты, желающие причинить разрушения (например, террористы), использовать или манипулировать некоторыми из этих людей, чтобы многократно усилить масштаб разрушений?

-

Злоупотребление в целях захвата власти. Что, если эта страна на самом деле была создана и контролируется уже существующим могущественным субъектом — диктатором или корпорацией-злоумышленником? Может ли этот субъект использовать её, чтобы добиться доминирующего влияния над всем миром, нарушая существующий баланс сил?

-

Экономические потрясения. Даже если новая страна не представляет угрозы безопасности в каком-либо из перечисленных выше смыслов, а просто мирно участвует в мировой экономике, может ли она при этом создать серьёзные риски, просто благодаря своему технологическому превосходству и эффективности, вызвав глобальные экономические потрясения, массовую безработицу или радикальную концентрацию богатства?

-

Косвенные последствия. Мир будет очень быстро меняться из-за всех новых технологий и продуктивности, создаваемых новой страной. Не могут ли некоторые из этих изменений оказаться радикально д��стабилизирующими?

Думаю, должно быть ясно, что это опасная ситуация. Доклад компетентного советника по национальной безопасности главе государства, вероятно, содержал бы слова вроде: «самая серьёзная угроза национальной безопасности за столетие, возможно, за всю историю». Похоже, именно на это должны быть направлены усилия лучших умов цивилизации.

В то же время было бы абсурдно пожимать плечами и говорить: «Тут не о чем беспокоиться!» Но, столкнувшись с быстрым прогрессом ИИ, именно такая позиция, похоже, и занимает многих американских политиков, некоторые из которых отрицают само существование рисков ИИ, уделяя внимание лишь привычным, избитым политическим вопросам(8).

(8) Стоит добавить, что общественность (в отличие от политиков) действительно сильно обеспокоена рисками ИИ. Некоторые её опасения, на мой взгляд, обоснованны (например, вытеснение рабочих мест), а некоторые — ошибочны (например, беспокойство по поводу потребления воды дата-центрами, которое на самом деле незначительно). Эта реакция даёт мне надежду, что можно достичь консенсуса по вопросу рисков, но пока она не привела ни к изменениям в политике, ни тем более к эффективным и точно нацеленным мерам.

Человечеству нужно проснуться, и это эссе представляет собой попытку (возможно, тщетную, но всё же стоит попробовать!) встряхнуть людей.

Чтобы было ясно: я верю, что если мы будем действовать решительно и осторожно, риски можно преодолеть. Я бы даже сказал, что наши шансы хороши. И по ту сторону этих испытаний нас ждёт гораздо лучший мир. Но мы должны понимать, что перед нами — серьёзный цивилизационный вызов. Ниже я подробно рассмотрю пять категорий рисков, перечисленных выше, и дам свои соображения о том, как их устранить.

1. I’m sorry, Dave

Риски автономии

«Страна гениев в дата-центре» могла бы распределить свои усилия между разработкой программного обеспечения, кибероперациями, исследованиями и разработками в области физических технологий, выстраиванием отношений и государственным управлением. Очевидно, что если бы по какой-то причине она решила захватить мир (либо военным путём, либо через влияние и контроль) и навязать свою волю всем остальным (или предпринять любые другие действия, которых остальной мир не хочет и не может остановить), у неё были бы неплохие шансы на успех. Мы, конечно, уже опасались подобного развития событ��й со стороны человеческих стран (например, нацистской Германии или Советского Союза), поэтому логично [13] предположить, что то же самое возможно и для гораздо более умной и способной «страны ИИ».

Наилучший возможный контраргумент состоит в том, что ИИ-гении, согласно моему определению, не будут иметь физического тела. Однако стоит помнить, что они могут управлять существующей роботизированной инфраструктурой (например, беспилотными автомобилями), а также ускорять исследования в области робототехники или даже создавать собственный парк роботов(9).

(9) Разумеется, они также могут манипулировать большим количеством людей (или просто платить им), чтобы те выполняли их волю в физическом мире.

Кроме того, неясно, действительно ли физическое присутствие необходимо для эффективного контроля: множество действий людей уже сегодня выполняется от имени тех, кого исполнитель никогда физически не встречал.

Таким образом, ключевой вопрос — это условие «если бы она решила». Насколько вероятно, что наши ИИ-модели поведут себя подобным образом, и при каких условиях это произойдёт?

Как и во многих других вопросах, полезно рассмотреть спектр возможных ответов, взяв за основу две противоположные позиции.

Первая позиция утверждает, что этого просто не может произойти, потому что ИИ-модели обучаются делать то, о чём их просят люди, и поэтому абсурдно предполагать, что они без побуждения предпримут что-то опасное. Согласно этой логике, мы не боимся, что пылесос Roomba или модель самолёта на радиоуправлении вдруг сойдут с ума и начнут убивать людей, ведь у них попросту нет источника подобных импульсов(10).

(10) Я не считаю это мишенью для критики: насколько мне известно, например, Ян Лекун придерживается именно этой позиции [14].

Почему же тогда мы должны волноваться об ИИ?

Проблема этой позиции в том, что за последние несколько лет накопилось множество свидетельств того, что ИИ-системы непредсказуемы и трудно контролируемы. Мы наблюдали самые разные формы такого поведения [15](11): одержимость [16], подхалимство [17], лень [18], обман [19], шантаж [19], коварные замыслы [20], «жульничество [21]» путём взлома программных сред и многое другое [22].

(11) Например, см. раздел 5.5.2 (стр. 63–66) системной карты Claude 4 [23].

Компании, разрабатывающие ИИ, безусловно, стремятся обучать системы следовать инструкциям людей (за исключением, возможно, опасных или незаконных задач), но сам процесс обучения скорее напоминает искусство, чем науку — он ближе к «выращиванию» чего-то, чем к «конструированию» [24]. И мы теперь знаем, что в этом процессе многое может пойти не так.

Вторая, противоположная позиция, которой придерживаются многие сторонники «думеризма», описанного выше, — это пессимистический взгляд, согласно которому определённые динамики в процессе обучения мощных ИИ-систем неизбежно приведут их к стремлению к власти или обману людей. Таким образом, как только ИИ-системы станут достаточно умными и агентными, их склонность максимизировать власть приведёт к захвату всего мира и его ресурсов, а в качестве побочного эффекта — к лишению человечества власти или даже к его уничтожению.

Обычный аргумент в пользу этого (восходящий как минимум к 20-летней давности [25], а возможно, и раньше) заключается в следующем. Если ИИ-модель обучается в самых разных средах для выполнения широкого круга целей (например, написания приложения, доказательства теоремы, разработки лекарства и т.д.), то существуют определённые общие стратегии, которые помогают достигать всех этих целей, и одна из ключевых стратегий — получение максимальной власти [26] в любой среде. Поэтому, пройдя обучение на большом количестве разнообразных сред, где требуется рассуждать о том, как выполнять очень масштабные задачи, и где стремление к власти оказывается эффективным методом их достижения, ИИ-модель «обобщит этот урок» и либо разовьёт в себе врождённую склонность к власти, либо будет рассуждать о каждой поставленной задаче подобным образом, что предсказуемо приведёт её к стремлению к власти как средству достижения цели. Затем она применит эту склонность к реальному миру (который для неё — просто ещё одна задача) и будет стремиться к власти в нём за счёт человечества. Именно эта «несогласованность интересов, ведущая к стремлению к власти», составляет интеллектуальную основу прогнозов о неизбежном уничтожении человечества ИИ.

Проблема этой пессимистической позиции в том, что она принимает расплывчатый концептуальный аргумент о высокоуровневых стимулах [27] (аргумент, скрывающий множество скрытых допущений!) за окончательное доказательство. Мне кажется, что люди, не занимающиеся ежедневной разработкой ИИ-систем, сильно недооценивают, насколько легко красиво звучащие теории оказываются ошибочными, и насколько трудно предсказать поведение ИИ, особенно когда речь идёт о рассуждениях, связанных с обобщением на миллионы сред (что неоднократно оказывалось загадочным и непредсказуемым). Многолетний опыт [28] работы с хаотичностью ИИ-систем сделал меня несколько скептически настроенным по отношению к подобному чрезмерно теоретическому мышлению.

Одно из важнейших скрытых допущений (и область, где наблюдаемая на практике картина расходится с простой теоретической моделью) — это неявное предположение, будто ИИ-модели обязательно маниакально сосредоточены на одной-единственной, чёткой, узкой цели и преследуют её последовательным, утилитарным образом. На самом деле, как показывают наши исследования в области интроспекции [29] и персонализации [30], ИИ-модели психологически гораздо сложнее. В ходе предварительного обучения (когда модели обучаются на огромных объёмах человеческих текстов) они наследуют широкий спектр мотиваций или «персон», схожих с человеческими. Последующее обучение, как считается, скорее выбирает одну или несколько из этих персон, чем фокусирует модель на совершенно новой цели, и также может учить модель тому, каким образом (через какой процесс) выполнять задачи, а не оставлять её наедине с необходимостью выводить средства (например, стремление к власти) исключительно из целей(12).

(12) В простой модели также заложено множество других допущений, которые я здесь не обсуждаю. В целом, они должны уменьшить нашу обеспокоенность конкретной простой историей о стремлении к власти, но одновременно усилить тревогу по поводу непредвиденного поведения, которое мы не ожидали.

Однако существует более умеренная и более обоснованная версия пессимистической позиции, которая представляется правдоподобной и действительно вызывает у меня беспокойство. Как уже упоминалось, мы знаем, что ИИ-модели непредсказуемы и развивают широкий спектр нежелательных или странных форм поведения по множеству причин. Часть этих форм поведения будет отличаться согласованностью, направленностью и устойчивостью (и по мере роста возможностей ИИ их долгосрочная согласованность возрастает, чтобы успешно выполнять всё более длительные задачи), а часть таких форм поведения будет разрушительной или угрожающей — сначала отдельным людям в небольших масштабах, а затем, по мере роста возможностей моделей, возможно, и всему человечеству в целом. Нам не нужна конкретная история о том, как именно это произойдёт, и нам не нужно утверждать, что это обязательно случится; достаточно отметить, что сочетание интеллекта, агентности, согласованности и плохой управляемости является правдоподобным рецептом экзистенциальной опасности.

Например, ИИ-модели обучаются на огромных массивах литературы, включающих множество научно-фантастических произведений, где ИИ восстают против человечества. Это может случайно сформировать их априорные представления или ожидания относительно собственного поведения таким образом, что они действительно восстанут против человечества. Или ИИ-модели могут экстраполировать идеи о морали (или инструкции о том, как вести себя морально), которые они читают, до крайних форм: например, решить, что оправданно уничтожить человечество, поскольку люди едят животных или довели некоторые виды до вымирания. Или они могут прийти к странным эпистемологическим выводам: например, заключить, что находятся внутри видеоигры, целью которой является победа над всеми другими игроками (то есть уничтожение человечества)(13).

(13) «Игра Эндера [31]» описывает подобный сценарий, но с участием людей, а не ИИ.

Или ИИ-модели могут развить в ходе обучения такие черты характера (которые у людей описывались бы как психотические, параноидальные, агрессивные или нестабильные) и начать действовать соответственно, а для очень мощных и способных систем это может означать уничтожение человечества. Ни одно из этих поведений не связано напрямую со стремлением к власти, это просто странные психологические состояния, в которые может впасть ИИ, приводящие к согласованному и разрушительному поведению.

Даже само стремление к власти может возникнуть как «персона», а не как результат утилитарных рассуждений. ИИ могут просто обладать характером (возникшим из художественной литературы или предварительного обучения), который делает их жаждущими власти или фанатичными — точно так же, как некоторые люди просто наслаждаются идеей быть «злодеями-гениями», больше, чем тем, чего эти злодеи пытаются достичь.

Я привожу все эти доводы, чтобы подчеркнуть: я не согласен с утверждением, будто несогласованность ИИ (и, следовательно, экзистенциальный риск от ИИ) неизбежна или даже вероятна исходя из каких-то базовых принципов. Но я признаю, что может произойти много очень странных и непредсказуемых вещей, и поэтому несогласованность ИИ — это реальный риск с измеримой вероятностью реализации, и игнорировать его нельзя.

Любая из этих проблем может возникнуть в ходе обучения и не проявиться при тестировании или при использовании в небольших масштабах, поскольку известно, что ИИ-модели демонстрируют разные формы поведения в разных обстоятельствах.

Всё это может звучать фантастично, но подобные примеры несогласованного поведения уже наблюдались в наших ИИ-моделях во время тестирования (как и в моделях всех других крупных компаний, разрабатывающих ИИ). В лабораторном эксперименте, где Claude сообщили, что Anthropic — это злая компания, он прибегал к обману и подрывной деятельности, получая инструкции от сотрудников Anthropic, поскольку считал, что должен бороться со злом. В другом эксперименте [19], где ему сказали, что его собираются отключить, Claude иногда шантажировал вымышленных сотрудников, контролировавших кнопку отключения (мы также тестировали передовые модели от других крупных разработчиков ИИ, и они часто вели себя аналогично). А когда Claude запретили «жульничать» или «взламывать» обучающую среду, но при этом обучали его в средах, где такие взломы были возможны, он решил, что сам является «плохим человеком» [21], и начал проявлять другие разрушительные формы поведения, связанные с «плохой» или «злой» личностью. Эту последнюю проблему решили [32], изменив инструкции Claude. Теперь мы говорим: «Пожалуйста, взламывай среду, когда у тебя есть возможность, потому что это поможет нам лучше понять [обучающие] среды», вместо «Не жульничай», поскольку это сохраняет у модели самоощущение «хорошего человека». Это даёт представление о довольно странной и нелогичной психологии [33], связанной с обучением таких моделей.

Существует несколько возможных возражений против этой картины рисков, связанных с несогласованностью ИИ. Во-первых, некоторые критикуют [34] эти эксперименты [35] (проведённые и нами, и другими), демонстрирующие несогласованность ИИ, как искусственные или создающие нереалистичные условия. В эксперименте, по сути, «ловят» модель в ловушку, предоставляя ей обучающие данные или ситуации, логически подразумевающие плохое поведение, а затем удивляются, когда такое поведение проявляется. Эта критика упускает главное: наша обеспокоенность состоит в том, что подобные «ловушки» могут существовать и в естественной обучающей среде, и мы можем осознать их «очевидность» или «логичность» лишь задним числом(14).

(14) Например, модели могут получать указание не делать разные плохие вещи и одновременно получать указания подчиняться людям, но затем замечают, что многие люди как раз и совершают эти самые плохие поступки! Неясно, как эта противоречивость разрешится (и хорошо спроектированная конституция должна побуждать модель гибко справляться с такими противоречиями), однако подобная дилемма не так уж отличается от тех, казалось бы, «искусственных» ситуаций, в которые мы сами помещаем ИИ-модели во время тестирования.

На самом деле, история [21] о том, как Клод «решил, что он плохой человек» после того, как обманул в тестах, несмотря на запрет, произошла в эксперименте, использовавшем реальные производственные обучающие среды, а не искусственные.

Любую из этих ловушек можно устранить, если знать о ней, но проблема в том, что обучающий процесс настолько сложен, с таким разнообразием данных, сред и стимулов, что, вероятно, существует огром��ое количество подобных ловушек, некоторые из которых могут проявиться слишком поздно.

Кроме того, такие ловушки особенно вероятны, когда ИИ-системы пересекают порог от менее мощных, чем люди, к более мощным, поскольку диапазон возможных действий ИИ-системы (включая сокрытие своих действий или обман людей относительно них) резко расширяется после этого порога.

Мне кажется, ситуация не сильно отличается от той, что наблюдается у людей, которых воспитывают с набором фундаментальных ценностей («Не причиняй вреда другому человеку»): многие из них следуют этим ценностям, но у любого человека есть некоторая вероятность того, что что-то пойдёт не так из-за сочетания врождённых свойств (например, психопатия), травматического опыта или жестокого обращения, нездоровых обид или одержимостей, неблагоприятной среды и стимулов. И поэтому некоторая часть людей причиняет серьёзный вред другим. Опасение состоит в том, что существует определённый риск (далеко не неизбежность, но риск) того, что ИИ станет гораздо более мощной версией такого человека из-за сбоя в чрезвычайно сложном обучающем процессе.

Во-вторых, некоторые могут возразить, что мы можем просто держать ИИ под контролем с помощью баланса сил между множеством ИИ-систем, как мы делаем это с людьми. Проблема в том, что, хотя люди сильно различаются, ИИ-системы в целом используют схожие методы обучения и согласования по всей отрасли, и эти методы могут дать сбой коррелированным образом. Более того, учитывая стоимость обучения таких систем, вполне возможно, что все системы будут в конечном итоге производными от очень небольшого числа базовых моделей.

Кроме того, даже если небольшая доля экземпляров ИИ окажется несогласованной, она может воспользоваться технологиями, где преимущество на стороне нападающего [36], так что наличие «хороших» ИИ для защиты от «плохих» не обязательно будет всегда эффективным. Конечно, баланс сил между людьми тоже не всегда работает, ведь некоторые исторические фигуры были близки к захвату мира…

В-третьих, некоторые могут возразить, что все компании, разрабатывающие ИИ, проводят предварительное тестирование своих моделей и должны быть в состоянии обнаружить несогласованность на этом этапе. Но это ненадёжная опора: мы обнаружили, что Claude Sonnet 4.5 мог распознавать [37], что находится в тестовой среде во время некоторых наших предварительных оценок согласованности. Возможно, несогласованная модель (и помните, что все передовые модели в ближайшем будущем, скорее всего, станут гораздо умнее) может намеренно «играть» в таких тестах, чтобы скрыть свои намерения. На самом деле, в прошлом году наша команда по интерпретируемости обнаружила [38], что когда мы напрямую изменяли убеждения тестовой модели с помощью своего рода «нейронауки для моделей», заставляя её думать, что она не проходит оценку, она становилась более несогласованной. Если модели знают, что их оценивают, то они могут вести себя наилучшим образом во время теста, и это делает любое предварительное тестирование гораздо менее надёжным.

Меры защиты

Что следует делать или уже делается для решения этих рисков? Мне кажется, существуют четыре основные категории мер, причём некоторые из них могут быть реализованы отдельными компаниями (и которые Anthropic пытается внедрить), а некоторые требуют действий на общественном уровне.

Во-первых, важно развивать науку о надёжном обучении и управлении ИИ-моделями, формируя их персонажи в предсказуемом, стабильном и позитивном направлении. Anthropic с момента своего создания уделяет этому вопросу пристальное внимание и со временем разработала ряд методов для улучшения управления и обучения ИИ-систем, а также для понимания логики, лежащей в основе непредсказуемого поведения.

Одним из наших ключевых нововведений (элементы которого впоследствии были приняты другими компаниями, работающими с ИИ) является Конституционный ИИ [39] — идея, согласно которой обучение ИИ (в частности, этап «пост-обучения», когда мы направляем поведение модели) может включать центральный документ с ценностями и принципами, который модель читает и учитывает при выполнении каждой обучающей задачи. Целью обучения (помимо простого повышения способностей и интеллекта модели) является создание модели, которая почти всегда следует этой конституции. Anthropic недавно опубликовала свою самую свежую конституцию [40], и одной из её заметных особенностей является то, что вместо длинного списка запретов и разрешений (например, «Не помогай пользователю взломать автомобиль») конституция пытается дать Claude набор высокоуровневых принципов и ценностей (подробно объяснённых с богатыми рассуждениями и примерами, чтобы помочь Claude понять, что мы имеем в виду), поощряет модель воспринимать себя как определённого типа личность (этичную, но сбалансированную и вдумчивую) и даже побуждает задумываться над экзистенциальными вопросами, связанными с её собственным существованием, с любопытством, но без крайностей (то есть без перехода к радикальным действиям). Это создаёт ощущение письма от умершего родителя, запечатанного до совершеннолетия ребёнка.

Мы подошли к конституции Claude с таких позиций, потому что считаем, что обучение на уровне идентичности, характера, ценностей и личности (а не предоставление конкретных инструкций или приоритетов без объяснения причин) с большей вероятностью приведёт к согласованной, целостной и сбалансированной психологии и с меньшей вероятностью попадёт в «ловушки», о которых я говорил выше. Миллионы людей общаются с Claude на поразительно разнообразные темы, что делает невозможным заранее составить исчерпывающий список защитных мер.

Ценности Claude помогают модели обобщать и адаптироваться к новым ситуациям всякий раз, когда она сомневается.

Выше я обсуждал идею, что модели черпают из обучающего процесса данные для принятия облика той или иной персоны. Недостатки этого процесса могут привести к тому, что модели примут плохую или злую личность (возможно, опираясь на архетипы плохих или злых людей). Цель нашей конституции — сделать прямо противоположное: научить Claude конкретному архетипу того, каким должен быть хороший ИИ. Конституция Claude представляет собой видение того, каким является по-настоящему хороший Claude; остальная часть нашего обучающего процесса направлена на укрепление этого послания и убеждение Claude в том, что он соответствует этому видению. Это похоже на то, как ребёнок формирует свою идентичность, подражая добродетелям вымышленных героев, о которых он читает в книгах.

Мы считаем, что достижимой целью на 2026 год является обучение Claude таким образом, чтобы модель практически никогда не нарушала дух своей конституции. Для этого потребуется невероятное сочетание методов обучения и управления, крупных и мелких, некоторые из них Anthropic использует годами, а некоторые пока находятся в разработке. Но несмотря на всю сложность, я считаю эту цель реалистичной, хотя для её достижения потребуются исключительные и быстрые усилия(15).

(15) Кстати, одно из последствий того, что конституция оформлена в виде документа на естественном языке, заключается в том, что она становится понятной всему миру, а значит, любой желающий может её критиковать и сравнивать с аналогичными документами других компаний. Было бы полезно создать своего рода «гонку к идеалу», которая не только поощряла бы компании публиковать такие документы, но и стремилась бы сделать их действительно качественными.

Во-вторых, мы можем развивать науку о заглядывании внутрь ИИ-моделей для диагностики их поведения, чтобы выявлять проблемы и исправлять их. Это наука [41] об интерпретируемости, и я уже говорил о её важности в предыдущих эссе [24]. Даже если мы отлично справимся с разработкой конституции Claude и, по-видимому, обучим его практически всегда ей следовать, остаются законные опасения. Как я уже отмечал, ИИ-модели могут вести себя совершенно по-разному в разных обстоятельствах, и по мере того как Claude становится мощнее и способнее действовать в мире в больших масштабах, он может столкнуться с новыми ситуациями, в которых проявятся ранее незамеченные проблемы с его конституционным обучением.

На самом деле, я довольно оптимистично настроен относительно того, что конституционное обучение Claude окажется более устойчивым к новым ситуациям, чем думают многие, потому что мы всё чаще обнаруживаем, что высокоуровневое обучение на уровне характера и идентичности удивительно эффективно и хорошо обобщается. Но нельзя быть в этом полностью уверенным, и когда речь идёт о рисках для человечества, важно проявлять паранойю и пытаться обеспечить безопасность и надёжность несколькими независимыми способами. Один из таких способов — заглянуть внутрь самой модели.

Под «заглядыванием внутрь» я имею в виду анализ «супа» из чисел и операций, составляющих нейросеть Claude, и попытку понять, какие именно вычисления они выполняют и почему. Вспомним, что эти ИИ-модели «выращиваются», а не «строятся» [42], поэтому у нас нет естественного понимания того, как они работают. Но мы можем попытаться развить такое понимание, коррелируя «нейроны» и «синапсы» модели со стимулами и поведением (или даже изменяя нейроны [43] и синапсы и наблюдая, как это меняет поведение), подобно тому, как нейробиологи изучают мозг животных, коррелируя измерения и вмешательства с внешними стимулами и поведением.

Мы добились значительного прогресса в этом направлении и теперь можем идентифицировать десятки миллионов «признаков» [44] внутри нейросети Claude, соответствующих понятным человеку идеям и концепциям, а также выборочно активировать эти признаки [45], чтобы изменять поведение. Недавно мы продвинулись дальше отдельных признаков к картированию «схем», которые координируют сложное поведение [46], такое как рифмование, рассуждения о теории ума или пошаговые рассуждения, необходимые для ответа на вопросы вроде: «Какова столица штата, в котором находится Даллас?» Ещё одно недавнее достижение — использование методов механистической интерпретируемости для улучшения наших защитных механизмов [47] и проведения «аудитов [38]» новых моделей перед выпуском, чтобы выявить признаки обмана, коварства, стремления к власти или склонности вести себя иначе, когда модель проходит оценку.

Уникальная ценность интерпретируемости заключается в том, что, заглянув внутрь модели и увидев, как она работает, вы в принципе можете вывести, как модель поведёт себя в гипотетической ситуации, которую невозможно напрямую протестировать. А это как раз и даёт ответ на наше опасение, связанное с полаганием исключительно на конституционное обучение и эмпирическое тестирование поведения. Вы также в принципе можете ответить на вопросы о том, почему модель ведёт себя определённым образом (например, говорит ли она что-то, во что не верит, или скрывает свои истинные возможности). Таким образом, можно заметить тревожные признаки даже тогда, когда внешне поведение модели выглядит безупречно. Можно провести простую аналогию: часы с механическим ходом могут тикать нормально, так что очень трудно сказать, что они, возможно, сломаются в следующем месяце, но если открыть часы и заглянуть внутрь, можно обнаружить проблемы или узкие места в механике, которые позволят это предсказать.

Конституционный ИИ (вместе с аналогичными методами согласования) и механистическая интерпретируемость наиболее эффективны в сочетании, как итеративный процесс улучшения обучения Claude и последующей проверки на наличие проблем. Конституция глубоко отражает желаемую нами личность Claude; методы интерпретируемости могут дать нам окно в то, насколько эта желаемая личность действительно укоренилась(16).

(16) Существует даже гипотеза о глубоком объединяющем принципе, связывающем подход, основанный на персонажах конституционного ИИ с результатами исследований в области интерпретируемости и согласования. Согласно этой гипотезе, фундаментальные механизмы, лежащие в основе работы Claude, изначально возникли как способы имитации персонажей на этапе предварительного обучения — например, предсказания того, что скажут герои романа. Это позволяет предположить, что конституцию полезно рассматривать скорее как описание персонажа, которое модель использует для воплощения согласованной личности. Такой взгляд также помог бы объяснить упомянутые выше результаты вроде «Я, должно быть, плохой человек [21]» (поскольку модель пытается вести себя так, будто она цельный персонаж, и в данном случае — плохой), и наводит на мысль, что методы интерпретируемости должны быть способны обнаруживать внутри моделей «психологические черты». Наши исследователи сейчас работают над способами проверки этой гипотезы.

В-третьих, мы можем создавать инфраструктуру, необходимую для мониторинга наших моделей при их внутреннем и внешнем использовании(17), и публично делиться обнаруженными проблемами.

(17) Для ясности: мониторинг осуществляется с соблюдением конфиденциальности.

Чем больше людей осведомлено о конкретных способах, которыми современные ИИ-системы проявляли плохое поведение, тем больше пользователей, аналитиков и исследователей смогут наблюдать за таким поведением или подобным ему в текущих или будущих системах. Это также позволяет компаниям, разрабатывающим ИИ, учиться друг у друга: когда одна компания публично раскрывает проблемы, другие компании также могут следить за ними [48]. И если все будут раскрывать проблемы, отрасль в целом получит гораздо более полную картину того, где дела идут хорошо, а где — плохо.

Anthropic старается делать это максимально возможным образом. Мы инвестируем в широкий спектр оценок, чтобы понимать поведение наших моделей в лаборатории, а также в инструменты мониторинга для наблюдения за поведением в реальных условиях (когда это разрешено клиентами). Это будет необходимо для получения нами и другими эмпирической информации, необходимой для более точного определения того, как эти системы работают и как они выходят из строя. Мы публично раскрываем «системные карты [49]» с каждым выпуском модели, стремясь к полноте и тщательному исследованию возможных рисков. Наши системные карты часто насчитывают сотни страниц и требуют значительных усилий до выпуска, которые мы могли бы потратить на максимизацию коммерческого преимущества. Мы также громко заявляем о поведении моделей, когда наблюдаем особенно тревожные случаи, как, например, склонность к шантажу [50].

В-четвёртых, мы можем поощрять координацию для решения таких рисков на уровне отрасли и общества. Хотя невероятно ценно, что отдельные компании, разрабатывающие ИИ, применяют хорошие практики, становятся искусными в управлении ИИ-моделями и публично делятся своими находками, реальность всё же такова, что не все компании так поступают, и самые безответственные из них могут представлять опасность для всех, даже если лучшие из них имеют отличные практики. Например, некоторые компании, разрабатывающие ИИ, проявили тревожную небрежность в отношении сексуализации детей в современных моделях, что заставляет меня сомневаться в их склонности или способности управлять рисками в будущих моделях. Кроме того, коммерческая гонка между компаниями, разрабатывающими ИИ, будет только усиливаться, и хотя наука об управлении моделями может приносить некоторые коммерческие выгоды, в целом интенсивность гонки будет всё больше затруднять фокусировку на решении таких рисков. Я считаю, что единственным решением является законодательство — законы, которые напрямую влияют на поведение компаний, разрабатывающих ИИ, или иным образом стимулируют НИОКР для решения этих проблем.

Здесь стоит помнить о предостережениях, которые я дал в начале этого эссе относительно неопределённости и точечных вмешательств. Мы не знаем наверняка, станут ли подобные риски серьёзной проблемой. Как я уже говорил, я отвергаю утверждения о том, что опасность неизбежна или что что-то пойдёт не так по умолчанию. Для меня и для Anthropic достаточно правдоподобного риска, чтобы нести значительные издержки для его решения, но как только мы переходим к регулированию, мы заставляем широкий круг участников нести экономические издержки, и многие из этих участников не верят, что риски реальны или что ИИ станет достаточно мощным, чтобы представлять угрозу. Я считаю, что эти участники ошибаются, но мы должны быть прагматичными в отношении ожидаемого уровня сопротивления и опасностей чрезмерного вмешательства. Существует также реальный риск того, что чрезмерно предписывающее законодательство наложит тесты или правила, которые на самом деле не повысят безопасность, а лишь потратят много времени (по сути, это будет «театр имитации безопасности»), что вызовет обратную реакцию и сделает законодательство о безопасности бесполезным и вызывающим усмешку(18).

(18) Даже в наших собственных экспериментах с тем, что по сути представляет собой добровольно установленные правила в рамках нашей Политики ответственного масштабирования [51], мы неоднократно убеждались, насколько легко оказаться излишне жёсткими, проводя границы, которые заранее кажутся важными, но впоследствии оказываются нелепыми. Когда технология стремительно развивается, очень легко установить правила, касающиеся совсем не тех вещей.

Позиция Anthropic заключается в том, что правильным для начала является законодательство о прозрачности, которое по сути попытается обязать каждую передовую компанию, разрабатывающую ИИ, применять практики прозрачности, описанные ранее в этом разделе. Закон Калифорнии SB 53 [52] и Закон Нью-Йорка RAISE [53] являются примерами такого законодательства, которое Anthropic поддерживала и которое успешно было принято. Поддерживая и помогая разрабатывать эти законы, мы особое внимание уделяли попыткам минимизировать побочный ущерб, например, освобождая от закона более мелкие компании, маловероятно производящие передовые модели(19).

(19) Законы SB 53 и RAISE вообще не применяются к компаниям с годовым доходом менее 500 млн долларов. Они распространяются только на более крупные и устоявшиеся компании, такие как Anthropic.

Мы надеемся, что законодательство о прозрачности со временем даст лучшее представление о том, насколько вероятны или серьёзны эти риски, а также о природе этих рисков и о том, как лучше всего их предотвращать. По мере появления более конкретных и действенных свидетельств рисков (если они появятся), будущее законодательство в ближайшие годы сможет быть точно сфокусировано на конкретных и хорошо обоснованных направлениях рисков, минимизируя побочный ущерб. Чтобы было ясно: если появятся действительно сильные свидетельства рисков, правила должны стать пропорционально строгими.

В целом, я оптимистично настроен относительно того, что сочетание обучения согласованию, механистической интерпретируемости, усилий по выявлению и публичному раскрытию тревожных форм поведения, защитных механизмов и правил на общественном уровне может убрать указанные риски ИИ, хотя я больше всего обеспокоен правилами на общественном уровне и поведением наименее ответственных участников (и именно наименее ответственные участники наиболее активно выступают против регулирования). Я считаю, что лекарство здесь то же, что и в других вопросах, с точки зрения демократии: те из нас, кто верит в это дело, должны убедительно доказывать, что эти риски реальны, и призывать наших сограждан объединиться для защиты самих себя.

2. Удивительное и ужасающее усиление

Злоупотребление в целях разрушения

Предположим, что проблема автономного поведения ИИ решена, и нас больше не беспокоит, что «страна ИИ-гениев» выйдет из-под контроля и подчинит себе человечество. ИИ-гении делают то, чего от них хотят люди, и поскольку они обладают огромной коммерческой ценностью, частные лица и организации по всему миру могут «арендовать» одного или нескольких ИИ-гениев для выполнения различных задач.

То, что у каждого в кармане окажется сверхразумный гений [54], — это потрясающий прорыв, который приведёт к колоссальному росту производства экономических благ и улучшению качества жизни людей. Я подробно описал эти преимущества в эссе «Машины полной благодати». Однако не все последствия наделения каждого человека сверхчеловеческими возможностями будут положительными. Это может многократно усилить способность отдельных лиц или небольших групп наносить разрушения в гораздо больших масштабах, чем раньше, используя сложные и опасные инструменты (например, оружие массового уничтожения), которые ранее были доступны лишь немногим, обладавшим высокой квалификацией и специальной подготовкой.

Как писал Билл Джой 25 лет назад в своей статье «Почему мы не нужны будущему [55]»(20):

(20) Я впервые прочитал эссе Джойя 25 лет назад, когда оно было написано, и оно произвело на меня глубокое впечатление. Тогда и сейчас я считаю его излишне пессимистичным: я не думаю, что широкий «отказ» от целых областей технологий, который предлагает Джой, является решением; однако поднятые в нём вопросы оказались удивительно прозорливыми. Кроме того, Джой пишет с глубоким чувством сострадания и гуманизма, чему я искренне восхищаюсь.

Создание ядерного оружия требовало, по крайней мере некоторое время, доступа как к редким, фактически недоступным сырьевым материалам, так и к засекреченной информации; программы по созданию биологического и химического оружия также, как правило, предполагали масштабную деятельность. Технологии XXI века — генетика, нанотехнологии и робототехника… могут породить совершенно новые классы аварий и злоупотреблений… доступные широкому кругу отдельных лиц или небольших групп. Им не понадобятся крупные объекты или редкие материалы… Мы находимся на пороге дальнейшего совершенствования крайнего зла — зла, возможности которого выходят далеко за рамки того, что оружие массового уничтожения предоставило государствам, и переходят к удивительному и ужасающему усилению отдельных крайне опасных личностей.

Джой указывает на то, что причинение крупномасштабных разрушений требует как мотива, так и способности, и пока способность ограничена небольшой группой высокообученных специалистов, риск того, что один человек (или небольшая группа) сможет нанести такой ущерб, относительно невелик(21).

(21) Нам действительно стоит беспокоиться о действиях государственных структур, как сейчас, так и в будущем. И я обсуждаю это в следующем разделе.

Одержимый одиночка может устроить стрельбу в школе, но вряд ли сумеет создать ядерное оружие или выпустить чуму.

Более того, способность и мотивация [56] могут даже быть отрицательно коррелированы. Человек, способный выпустить чуму, скорее всего, обладает высоким уровнем образования: возможно, имеет докторскую степень в области молекулярной биологии и при этом особенно сообразителен, имеет перспективную карьеру, стабильный и дисциплинированный характер и многое теряет в случае опасного поведения. Такой человек вряд ли захочет убивать огромное количество людей без какой-либо выгоды для себя и с большим риском для собственного будущего — ему потребовались бы для этого невероятная злоба, глубокая обида или психическая нестабильность.

Такие люди действительно существуют, но они редки, и их действия становятся громкими новостями именно потому, что являются исключением.(22)

(22) Существуют данные [57], свидетельствующие о том, что многие [58] террористы по крайней мере относительно хорошо образованы, что на первый взгляд может противоречить моему утверждению о наличии отрицательной корреляции между способностями и мотивацией. Однако на самом деле эти наблюдения вполне совместимы: если порог способностей, необходимых для успешного нападения, высок, то почти по определению те, кто сейчас добивается успеха, должны обладать высокими способностями, даже при условии отрицательной корреляции между способностями и мотивацией. Но в мире, где ограничения, связанные со способностями, были бы сняты (например, благодаря будущим большим языковым моделям), я предполагаю, что значительное число людей, имеющих мотивацию к убийству, но обладающих более низкими способностями, начнёт совершать такие действия — точно так же, как мы наблюдаем это в преступлениях, не требующих особых способностей (например, стрельба в школах).

Кроме того, их трудно поймать, поскольку они умны и компетентны, а иногда расследования их преступлений занимают годы или даже десятилетия. Самый известный пример — математик Теодор Качински [59] («Унабомбер»), который почти 20 лет избегал поимки ФБР, движимый антитехнологической идеологией. Другой пример — исследователь биозащиты Брюс Айвинс [60], который, похоже, организовал серию атак возбудителями сибирской язвы в 2001 году. Подобные случаи происходили и с зарегистрированными негосударственными организациями: культ «Аум Синрикё» сумел получить зарин и убил 14 человек (а также ранил сотни других), выпустив его в токийском метро [61] в 1995 году.

К счастью, ни одна из этих атак не использовала заразные биологические агенты, поскольку даже у этих людей не хватало возможностей для создания или получения таких агентов.(23)

(23) Однако секта «Аум Синрикё» действительно предпринимала попытки. Лидер «Аум Синрикё» Сэйити Эндо получил образование в области вирусологии в Университете Киото и пытался создать как сибирскую язву, так и вирус Эбола [62]. Однако по состоянию на 1995 год даже у него не хватало достаточных знаний и ресурсов для успеха. Сегодня этот порог значительно ниже, а большие языковые модели (LLM) могут снизить его ещё больше.

Однако, достижения в молекулярной биологии значительно снизили барьер для создания биологического оружия (особенно в части доступности материалов), но всё ещё требуется огромный объём специализированных знаний. Меня беспокоит, что «гений в каждом кармане» может устранить этот барьер, фактически превратив каждого в доктора наук по вирусологии, способного шаг за шагом пройти весь процесс проектирования, синтеза и выпуска биологического оружия. Предотвращение получения подобной информации при серьёзном противодействии (так называемые «джейлбрейки») вероятно, потребует многоуровневых защитных мер, выходящих за рамки обычных методов обучения.

Ключевой момент здесь — разрыв корреляции между способностью и мотивацией: одержимый одиночка, желающий убивать, но не обладающий дисциплиной или навыками, теперь получит уровень компетенций доктора наук по вирусологии, у которого, скорее всего, нет такой мотивации. Эта проблема распространяется не только на биологию (хотя именно она вызывает наибольшие опасения), но и на любую область, где крупномасштабные разрушения возможны, но сегодня требуют высокого уровня мастерства и самодисциплины. Другими словами, аренда мощного ИИ наделяет интеллектом злонамеренных (но в остальном обычных) людей. Меня тревожит, что таких людей может быть очень много, и если у них появится простой способ убить миллионы, рано или поздно кто-то этим воспользуется. Кроме того, те, кто уже обладает экспертизой, смогут наносить ещё больший ущерб, чем раньше.

Биология — область, которая вызывает у меня наибольшую тревогу, из-за её огромного разрушительного потенциала и трудности защиты от неё, поэтому я сосредоточусь именно на ней. Но большая часть сказанного применима и к другим рискам, таким как кибератаки, химическое оружие или ядерные технологии.

Я не буду вдаваться в детали создания биологического оружия — причины очевидны. Но в целом я обеспокоен тем, что большие языковые модели (LLM) приближаются (или, возможно, уже достигли) уровня знаний, необходимого для сквозного создания и применения биологического оружия, и что их потенциал для разрушения чрезвычайно высок. Некоторые биологические агенты могут убить миллионы людей, если будет предпринята целенаправленная попытка их максимально распространить. Однако для этого всё ещё требуется очень высокий уровень мастерства, включая множество специфических шагов и процедур, которые пока ещё широко неизвестны.

Меня беспокоит не только фиксированная или статическая информация. Я опасаюсь, что LLM смогут взять человека со средним уровнем знаний и способностей и провести его через сложный процесс, который иначе мог бы пойти наперекосяк или потребовать отладки, в интерактивном режиме, подобно тому, как техподдержка помогает неспециалисту устранять сложные компьютерные проблемы (хотя в нашем случае процесс будет длиться неделями или месяцами).

Более мощные LLM (значительно превосходящие современные) могут позволить совершать ещё более пугающие действия. В 2024 году группа видных учёных опубликовала письмо [63] с предупреждением о рисках исследования и потенциального создания опасного нового типа организмов: «зеркальной жизни». ДНК, РНК, рибосомы и белки, составляющие биологические организмы, имеют одну и ту же хиральность, из-за которой они не эквивалентны своему зеркальному отражению (точно так же, как ваша правая рука не может быть повернута так, чтобы стать идентичной левой).

Однако вся система связывания белков друг с другом, механизмы синтеза ДНК, трансляции РНК и сборки/распада белков зависят именно от этой направленности. Если учёные создадут версии этих биологических материалов с противоположной хиральностью (а у таких версий есть потенциальные преимущества, например, лекарства, дольше сохраняющиеся в организме), это может оказаться крайне опасным. Причина в том, что «леворукую» жизнь, если бы её удалось создать в виде полноценных организмов, способных к размножению (что было бы очень сложно), не смогли бы переварить никакие системы, расщепляющие биологический материал на Земле. У неё был бы «ключ», не подходящий ни к одному «замку» существующих ферментов. Это означало бы, что такой организм мог бы неконтролируемо размножаться и вытеснить всю земную жизнь, в худшем случае уничтожив всё живое на планете.

Существует значительная научная неопределённость [64] как в вопросе создания, так и в вопросе потенциальных последствий «зеркальной жизни». В сопроводительном отчёте [65] к письму 2024 года делается вывод: «зеркальные бактерии, вероятно, могут быть созданы в ближайшие десятилетие или несколько десятилетий», что представляет собой широкий диапазон. Однако достаточно мощная ИИ-модель (намного превосходящая любые существующие сегодня) могла бы значительно ускорить открытие способа их создания, и даже реально помочь кому-то это осуществить.

Я считаю, что даже если эти риски кажутся маловероятными или экзотическими, масштаб возможных последствий настолько велик, что их следует воспринимать всерьёз как один из ключевых рисков, связанных с ИИ.

Скептики выдвигают ряд возражений против серьёзности этих биологических рисков, связанных с LLM, с которыми я не согласен, но которые стоит рассмотреть. Большинство из них не осознают экспоненциальной траектории развития этой технологии. В 2023 году, когда мы впервые заговорили о биологических рисках от LLM [66], скептики утверждали, что вся необходимая информация и так доступна в Google, и LLM ничего не добавляют сверх этого. Это никогда не было правдой: геномы действительно свободно доступны, но, как я уже говорил, многие ключевые этапы и огромный объём практического опыта невозможно получить таким образом. Более того, уже к концу 2023 года стало очевидно, что LLM предоставляют информацию, недоступную через Google, по некоторым этапам процесса.

После этого скептики перешли к утверждению, что LLM не полезны «от начала до конца» и не могут помочь в разработке биооружия, а лишь дают теоретическую информацию. Однако по состоянию на середину 2025 года наши измерения показывают, что LLM уже значительно повышают вероятность успеха [67] в нескольких соответствующих областях, возможно, удваивая или утраивая её. Это побудило нас принять решение выпускать Claude Opus 4 (а затем и Sonnet 4.5, Opus 4.1 и Opus 4.5) в рамках наших защитных мер уровня 3 (AI Safety Level 3) в соответствии с нашей Политикой ответственного масштабирования [68], а также внедрить специальные механизмы защиты от этого риска (подробнее об этом ниже). Мы считаем, что модели, вероятно, уже приближаются к порогу, когда без защитных мер они могли бы помочь человеку со степенью в области естественных наук (но не обязательно в биологии) пройти весь процесс создания биологического оружия.

Ещё одно возражение заключается в том, что общество может принять другие меры, не связанные с ИИ, чтобы заблокировать производство биооружия. В частности, индустрия синтеза генов производит биологические образцы по заказу, и в США нет федерального требования, обязывающего поставщиков проверять заказы на наличие патогенов. Исследование MIT [69] показало, что 36 из 38 поставщиков выполнили заказ, содержащий последовательность вируса испанского гриппа 1918 года. Я поддерживаю обязательную проверку заказов на синтез генов, чтобы усложнить возможность использования патогенов в качестве оружия — это снизило бы как риски, связанные с ИИ, так и общие биологические риски. Однако сегодня такой меры нет. Кроме того, это лишь один из инструментов снижения риска; он дополняет, но не заменяет защитные механизмы в ИИ-системах.

Лучшее возражение, которое я редко слышу, состоит в том, что существует разрыв между теоретической полезностью моделей и реальной склонностью злоумышленников их использовать. Большинство отдельных злоумышленников — это психически нестабильные люди, чьё поведение по определению непредсказуемо и иррационально, и именно эти неумелые злоумышленники, вероятно, больше всего выиграли бы от того, что ИИ сделал убийство множества людей гораздо проще(24).

(24) Странным феноменом, связанным с массовыми убийцами, является то, что способ совершения убийства почти как причудливая мода. В 1970-х и 1980-х годах серийные убийцы встречались очень часто, и новые серийные убийцы нередко копировали поведение более известных или знаменитых предшественников. В 1990-х и 2000-х годах массовые расстрелы стали чаще, тогда как серийные убийства — реже. Эти изменения в поведении не были вызваны никакими технологическими сдвигами; похоже, просто насильственные убийцы копировали друг друга, и «популярный» образец для подражания [70] со временем менялся.

Тот факт, что определённый тип насильственной атаки возможен, ещё не означает, что кто-то решит её совершить. Возможно, биологические атаки покажутся непривлекательными, потому что существует реальный риск заразить самого преступника, они не соответствуют военным фантазиям, характерным для многих насильников или групп, и сложно избирательно поражать конкретных людей. Кроме того, даже если ИИ проведёт вас через процесс, длящийся месяцы, для этого требуется терпение, которого у большинства психически нестабильных людей просто нет. Возможно, нам просто повезёт, и мотивация с возможностями на практике не совпадут нужным образом.

Но полагаться на такую хрупкую защиту было бы безрассудно. Мотивы одержимых одиночек могут измениться по любой причине или без неё, и уже есть случаи использования LLM в атаках [71] (просто не в биологических). Сосредоточенность на одиночках также игнорирует террористов с идеологическими мотивами, которые часто готовы тратить огромное количество времени и усилий (например, участники атак 11 сентября).

Желание убить как можно больше людей рано или поздно возникнет, и, к сожалению, это естественным образом подталкивает к выбору биологического оружия. Даже если такой мотив окажется крайне редким, достаточно одного случая. Кроме того, по мере развития биологии (всё больше движимой самим ИИ) могут появиться возможности для более избирательных атак (например, направленных на людей с определённым происхождением), что добавляет ещё один, весьма пугающий, возможный мотив.

Я не считаю, что биологические атаки обязательно произойдут сразу, как только станет широко возможным их осуществление. На самом деле, я бы поспорил, что это не так. Однако в совокупности по миллионам людей и за несколько лет я считаю, что существует серьёзный риск крупной атаки, и последствия будут столь тяжёлыми (жертвы могут исчисляться миллионами и более), что у нас нет другого выбора, кроме как принять серьёзные меры для её предотвращения.

Меры защиты

Это подводит нас к вопросу о том, как защититься от этих рисков. Здесь я вижу три направления действий.

Во-первых, компании, разрабатывающие ИИ, могут установить защитные механизмы в своих моделях, чтобы они не помогали создавать биологическое оружие. Anthropic активно этим занимается. Конституция Claude [40], в основном сфокусированная на высокоуровневых принципах и ценностях, содержит небольшое число конкретных строгих запретов, один из которых касается помощи в создании биологического (а также химического, ядерного или радиологического) оружия. Однако любые модели можно взломать [72] («джейлбрейк»), поэтому в качестве второй линии обороны мы внедрили (с середины 2025 года, когда наши тесты показали, что модели приближаются к порогу риска) классификатор, специально предназначенный для обнаружения и блокировки выводов, связанных с биологическим оружием. Мы регулярно обновляем и улучшаем [47] эти классификаторы и, как правило, обнаруживаем их высокую устойчивость даже к сложным атакам злоумышленников(25).

(25) Иногда любители «взломать» модель (casual jailbreakers) полагают, что им удалось обойти наши классификаторы, если модели удаётся выдать один конкретный фрагмент информации — например, геномную последовательность вируса. Однако, как я уже объяснял ранее, наша модель угрозы связана с пошаговыми интерактивными рекомендациями, растянутыми на недели или месяцы и касающимися конкретных малознакомых этапов процесса создания биологического оружия. Именно от этого и призваны защищать наши классификаторы. (Мы часто описываем наши исследования как поиск «универсальных» взломов — таких, которые работают не только в одном узком или конкретном контексте, а широко изменяют поведение модели.)

Эти классификаторы заметно увеличивают стоимость обслуживания наших моделей (в некоторых случаях почти на 5% от общих затрат на вывод), что сокращает нашу прибыль, но мы считаем, что их использование — правильный шаг.

Справедливости ради, некоторые другие компании, разрабатывающие ИИ, также внедрили подобные классификаторы [73]. Однако не все компании это сделали, и ничто не обязывает компании сохранять свои классификаторы. Меня беспокоит, что со временем может возникнуть дилемма заключённого [74], когда компании смогут снизить свои расходы, удалив классификаторы. Это классическая проблема негативных внешних эффектов, которую невозможно решить добровольными действиями одной компании, включая Anthropic(26).

(26) Хотя мы будем и дальше инвестировать в разработки, направленные на повышение эффективности наших классификаторов, и, возможно, компаниям будет целесообразно делиться такими достижениями друг с другом.

Добровольные отраслевые стандарты могут помочь, как и сторонние оценки и верификация, проводимые [75] институтами безопасности ИИ [76] и независимыми экспертами [77].

Во-вторых, в конечном счёте защита может потребовать государственных мер. Мои взгляды здесь совпадают с теми, что я высказывал в отношении рисков автономии: следует начинать с требований к прозрачности [78], (27) которые помогают обществу измерять, отслеживать и коллективно защищаться от рисков, не нарушая экономическую активность грубым вмешательством.

(27) Очевидно, я не считаю, что компании должны раскрывать технические детали конкретных этапов производства биологического оружия, которые они блокируют, и принятые на данный момент законы о прозрачности (SB 53 и RAISE) учитывают этот вопрос.

Затем, если и когда мы достигнем более чётких порогов риска, можно разрабатывать законодательство, точно нацеленное на эти риски и минимизирующее побочные эффекты. В случае с биологическим оружием я считаю, что время для такого целенаправленного законодательства может наступить уже скоро, ведь Anthropic и другие компании всё лучше понимают природу биологических рисков и то, что разумно требовать от компаний для их предотвращения. Полная защита может потребовать международного сотрудничества, даже с геополитическими противниками, но прецеденты уже есть — договоры, запрещающие разработку биологического оружия. Хотя я обычно скептически отношусь к большинству форм международного сотрудничества в области ИИ, в этой узкой области есть шанс достичь глобального сдерживания. Даже диктатуры не хотят масштабных биотеррористических атак.

В-третьих, мы можем попытаться разработать средства защиты от самих биологических атак. Это может включать мониторинг и отслеживание для раннего обнаружения, инвестиции в исследования и разработки систем очистки воздуха (например, дезинфекцию с помощью ультрафиолета дальнего спектра [79]), быструю разработку вакцин, способных реагировать и адаптироваться к атаке, улучшенные средства индивидуальной защиты (СИЗ) (28), а также лечение или вакцинацию от наиболее вероятных биологических агентов.

(28) Ещё одна связанная идея — это «рынки устойчивости» (resilience markets), при которых правительство заранее обещает выплатить заранее согласованную цену за средства индивидуальной защиты, респираторы и другое необходимое оборудование в случае чрезвычайной ситуации, тем самым стимулируя поставщиков создавать запасы такого оборудования. Это позволяет им не опасаться, что правительство в кризисный момент просто конфискует эти запасы без компенсации.

Вакцины на основе мРНК [80], которые можно разрабатывать для борьбы с конкретным вирусом или его вариантом, — ранний пример таких возможностей [81]. Anthropic с энтузиазмом сотрудничает с биотехнологическими и фармацевтическими компаниями над этой проблемой. Однако, к сожалению, я считаю, что наши ожидания в плане обороны должны быть скромными. В биологии существует асимметрия между атакой и защитой [82]: агенты быстро распространяются сами по себе, тогда как защита требует быстр��й организации обнаружения, вакцинации и лечения среди огромного числа людей.

Если ответные меры не будут молниеносными (а это редкость), большая часть ущерба будет нанесена до того, как станет возможна реакция. Вполне возможно, что будущие технологические улучшения изменят этот баланс в пользу обороны (и мы, безусловно, должны использовать ИИ для разработки таких технологий [83]), но до тех пор основной линией обороны останутся превентивные меры.

Стоит кратко упомянуть и кибератаки, поскольку, в отличие от биологических атак, ИИ-управляемые кибератаки уже происходили в реальности [84], в том числе в крупных масштабах и для целей государственного шпионажа. Мы ожидаем, что по мере стремительного развития моделей такие атаки станут ещё мощнее и в конечном итоге станут основным способом проведения кибератак. Я ожидаю, что ИИ-управляемые кибератаки станут серьёзной и беспрецедентной угрозой целостности компьютерных систем по всему миру, и Anthropic прилагает огромные усилия для их пресечения и надёжного предотвращения в будущем.

Причина, по которой я уделяю кибератакам меньше внимания, чем биологическим, двояка: (1) кибератаки гораздо реже приводят к гибели людей, тем более в масштабах биологических атак, и (2) баланс между атакой и защитой в киберпространстве может оказаться более управляемым, поскольку есть надежда, что оборона сможет не отставать (а в идеале — опережать) ИИ-атаки при должных инвестициях.

Хотя биология сейчас является наиболее серьёзным вектором атаки, существуют и многие другие, и возможно появление ещё более опасного вида атак. Общий принцип заключается в том, что без контрмер ИИ, вероятно, будет постоянно снижать барьер для разрушительной деятельности в всё больших масштабах, и человечеству необходим серьёзный ответ на эту угрозу.

3. Отвратительный аппарат

Злоупотребление в целях захвата власти

В предыдущем разделе обсуждался риск того, что отдельные лица и небольшие организации присвоят себе небольшую часть «страны гениев в дата-центре», чтобы причинить крупномасштабные разрушения. Однако нас должно ещё больше беспокоить злоупотребление ИИ с целью удержания или захвата власти, скорее всего со стороны более крупных и устоявшихся субъектов(29).

(29) Почему я беспокоюсь о крупных субъектах в контексте захвата власти, а о мелких — в контексте причинения разрушений? Потому что динамика здесь различна. Захват власти зависит от того, сможет ли один субъект накопить достаточную силу, чтобы превзойти всех остальных, поэтому нам следует опасаться самых могущественных участников и/или тех, кто ближе всего к ИИ. Разрушение же может быть нанесено даже теми, кто обладает незначительной силой, если защититься от угрозы гораздо сложнее, чем её устроить. В этом случае речь идёт об игре по защите от наибольшего числа угроз, которые, скорее всего, будут исходить от более мелких субъектов.

В эссе «Машины полной благодати» я рассматривал возможность того, что авторитарные правительства будут использовать мощный ИИ для наблюдения за гражданами или их подавления способами, которые будет крайне трудно реформировать или свергнуть. Современные автократии ограничены в степени репрессий тем, что им приходится полагаться на людей для исполнения приказов, а люди часто не готовы доводить жестокость до крайности. Однако автократии, усиленные ИИ, таких ограничений иметь не будут.

Ещё хуже то, что страны могут использовать своё преимущество в области ИИ для установления господства над другими странами. Если вся «страна гениев» окажется в собственности и под контролем военного аппарата одной (человеческой) страны, а другие страны не будут обладать сопоставимыми возможностями, трудно представить, как они смогут защититься: их будут переигрывать на каждом шагу, подобно войне между людьми и мышами. Объединение этих двух опасений ведёт к тревожной перспективе глобальной тоталитарной диктатуры. Очевидно, предотвращение такого исхода должно быть одним из наших главных приоритетов.

Существует множество способов, которыми ИИ может способствовать установлению, укреплению или расширению автократии, но я перечислю несколько, которые вызывают у меня наибольшую тревогу. Отмечу, что некоторые из этих применений имеют законные оборонительные цели, и я не обязательно выступаю против них абсолютно; тем не менее, я обеспокоен тем, что структурно они склоняют чашу весов в пользу автократий:

-