MADrive: новый метод генерации сенсорных данных для автономного транспорта

Меня зовут Виктор Юрченко, я руковожу командой симуляции сенсоров в автономном транспорте Яндекса. Основная задача, которая стоит перед нашей командой, — искать способы делать симуляции ближе к реальности в части сенсорных данных. И недавно сотрудники команды совместно с исследовательским отделом Яндекса разработали собственный метод для симуляции изображений в проездах — MADrive (Memory-Augmented Driving Scene Modeling).

MADrive позволяет достоверно генерировать синтетические изображения для новых дорожных сценариев. Кроме того, для его работы был собран и выложен в опенсорс крупнейший открытый датасет автомобилей — MAD‑Cars. Он может быть полезен для различных задач 3DCV: от 3D‑реконструкции до генерации синтетических сцен.

В этой статье расскажу, почему симуляции так важны для автономного транспорта, как работает MADrive и чем может быть полезен датасет MAD‑Cars.

Зачем нужны симуляции в автономном транспорте

Чтобы убедиться, что различные модели, заложенные в логику [1] движения автономного автомобиля, работают так, как и задумано, надо выполнить масштабное тестирование. Проводить его исключительно на реальных поездках дорого и не всегда эффективно. Чтобы доказать, что новое решение лучше старого, нужно получить статистически значимые результаты. А для этого потребуется огромное количество тестов в разнообразных сценариях.

Кроме того, важно, чтобы модели хорошо справлялись не только в типичных случаях, но и в нестандартных. Что, например, произойдёт, если машина впереди начнёт резко маневрировать или неожиданно затормозит? Понятно, что данных с такими потенциально опасными ситуациями при реальных поездках получается собрать намного меньше, чем данных с нормальным поведением [2] других участников движения. Поэтому без синтетических данных не обойтись.

Ограничения существующих решений

Недавние достижения в реконструкции сцен приблизили нас к высокореалистичному моделированию окружающей среды для автономного вождения с использованием 3D Gaussian Splatting. Например, такие подходы, как StreetGS [3], AutoSplat [4] и HUGS [5], позволяют восстанавливать и статическую часть сцены (дороги, здания, фон), и динамические объекты (автомобили, пешеходы).

Однако все эти методы основаны исключительно на том, что действительно было зафиксировано камерами в проезде. Фотореалистичные изображения при таких подходах получаются в ситуациях, когда траектория автономного автомобиля и траектории других участников движения на сцене не меняются. При попытке изменить вид объекта, ракурс камеры или сценарий движения сцена «разваливается» — результат перестаёт быть фотореалистичным, и синтетические данные теряют свою ценность. На практике же нас в первую очередь интересуют именно такие случаи, когда в симуляторе поведение [6] автономного автомобиля и других участников движения начинает расходиться с тем, что было в реальном проезде.

Существуют подходы, при которых в сцену можно добавлять CAD‑модели автомобилей из внешних баз — например, UrbanCAD [7]. Это решает проблему генерации визуальных представлений автомобилей на сцене из ракурсов, которых не было в исходном проезде. Но возникает другая проблема: базы CAD‑моделей ограничены по размеру, модели из них часто не совпадают с реальными машинами по цвету, форме и текстуре, из‑за чего итоговая сцена выглядит искусственной.

Преимущества MADrive

Подход MADrive отличается тем, что сочетает плюсы сразу двух миров:

-

Был собран и выложен в открытый доступ датасет MAD‑Cars [8] — крупнейший на сегодня открытый датасет реальных многоракурсных видео автомобилей. Он состоит примерно из 70 тысяч 360-градусных видеозаписей, снятых в естественных условиях, и обеспечивает богатое покрытие всех популярных моделей, цветов, марок и вариантов освещения.

-

В процессе реконструкции для каждого автомобиля в исходной сцене предлагается подбирать максимально похожий реальный экземпляр из датасета MAD‑Cars, далее воссоздавать его качественную 3D‑модель и вставлять её в реконструкцию взамен исходного объекта, в том числе с учётом освещения и текстуры.

-

Благодаря этому даже в случаях с малыми, частично наблюдаемыми или сильно перекрытыми объектами novel‑view synthesis начинает работать устойчиво, а итоговые сцены выглядят естественно для perception‑систем автономного автомобиля, тестируемых в симуляторе.

На рисунках ниже — наглядные сравнения рендеринга на примере проезда из датасета Waymo Open Motion. Видно, что MADrive успешно генерирует реалистичные виды, в то время как другие методы теряют детали или выглядят неестественно.

Сравнение методов

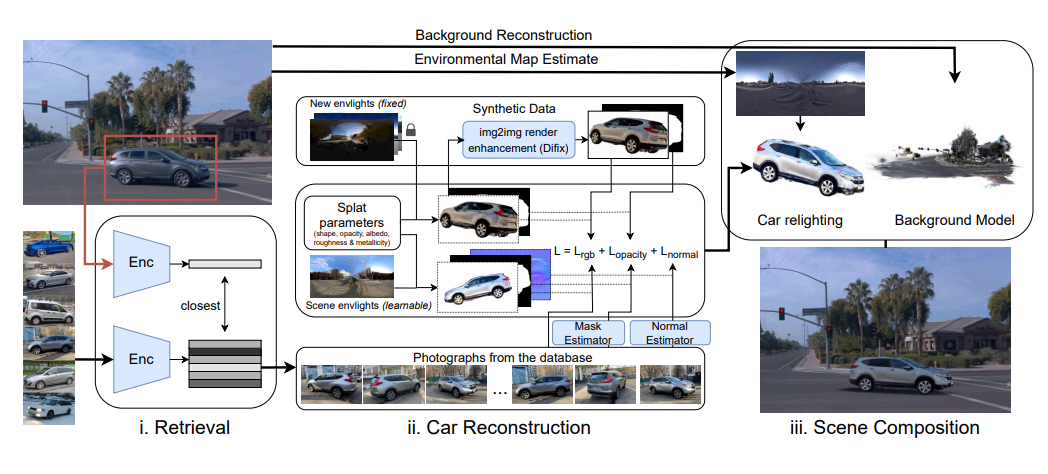

Как работает MADrive

Работа фреймворка MADrive начинается с декомпозиции сцены. Исходное видео разделяется на статические (дорога, деревья, здания, небо и так далее) и динамические (в данном случае — автомобили) элементы.

Статические объекты восстанавливаются через Gaussian Splatting на основе видеозаписи проезда и известных параметров камер (положений и внутренних характеристик). В качестве начальной инициализации положения гауссиан используются 3D‑точки из лидарных облаков, записанных во время проезда. Это позволяет получить довольно точную реконструкцию статической части сцены.

Реконструкция автомобилей происходит отдельно и состоит из следующих шагов: для каждого автомобиля осуществляется поиск похожего объекта в базе MAD‑Cars, реконструкция этого объекта с помощью 2D Gaussian Splats, вставка и переосвещение реконструированного объекта в сцене.

Ниже поговорим про каждый шаг в отдельности.

Поиск похожих автомобилей в MAD-Cars

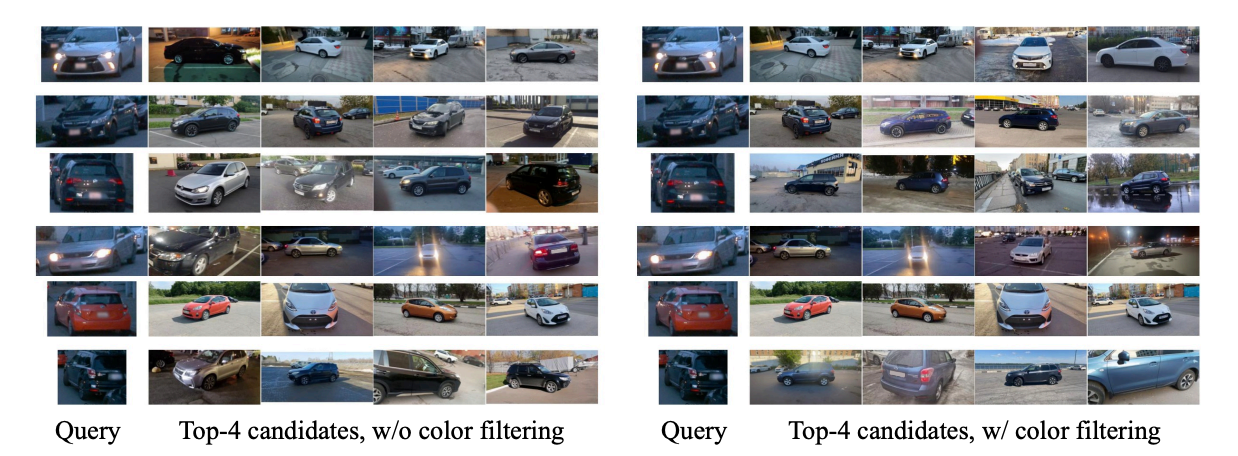

Работа с автомобилями начинается с того, что в исходном проезде автомобили выделяются 3D‑боксами с помощью некоторого внешнего алгоритма детекции автомобилей, применяемого в автономном транспорте (конкретный выбор алгоритма находится за рамками предлагаемого метода). Найденные 3D‑боксы проецируются на картинки и используются для получения фрагментов изображений, содержащих отдельные автомобили. Далее с помощью модели SigLIP2 для этих фрагментов извлекаются векторы признаков. Кроме того, для каждого автомобиля с помощью vision‑language‑модуля Qwen2.5-VL уточняется его цвет.

Непосредственно поиск похожего автомобиля в датасете MAD‑Cars идёт в два этапа. На первом извлекается подмножество автомобилей такого же цвета, как и у автомобиля на исходной сцене. На втором из выбранного подмножества берётся объект — ближайший по косинусному расстоянию между векторами признаков, полученных из SigLIP2.

Явный учёт цвета объекта — важный этап поиска похожего объекта из базы MAD‑Cars. Без этого этапа поиск по векторам признаков из SigLIP2 имеет тенденцию находить автомобили, совпадающие по форме и марке, но отличающиеся цветом, что визуально разрушает реализм сцены. Ниже приведены примеры поиска с учётом и без учёта фильтрации по цвету.

Реконструкция динамических объектов

Для получения фотореалистичных изображений на выходе фреймворка MADrive очень важна возможность выполнить переосвещение добавляемых объектов с учётом фактического освещения сцены. Если этого не делать, окажется, что машины будут очень неестественно смотреться в проезде, ведь одна и та же машина в пасмурную погоду и при ярком солнце воспринимается совершенно по‑разному.

Чтобы машины можно было переосвещать, их реконструкция осуществляется с помощью 2D‑сплатов, поскольку это позволяет строить нормали и определять поверхность машины. Кроме того, при реконструкции автомобилей предлагается разделять вклад в итоговый видимый цвет собственного цвета автомобиля и внешнего освещения, которое было на момент съёмки видео, попавшего в датасет MAD‑Cars. Конкретный подход, как выполнить такое разделение, был взят из статьи [9] с минимальными модификациями.

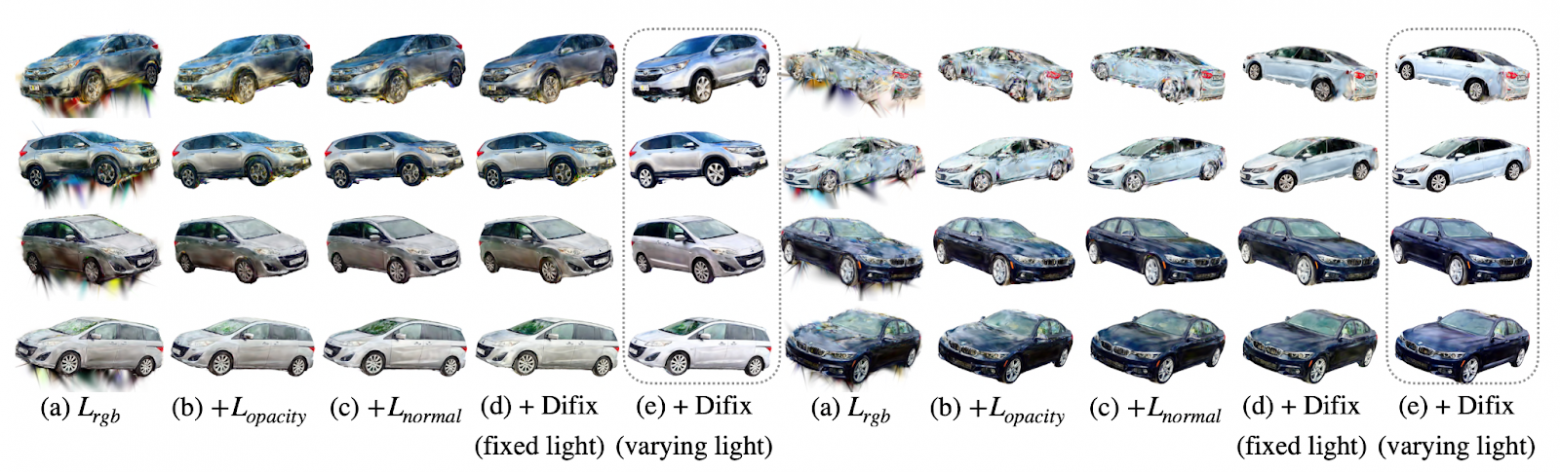

Функция потерь, которая оптимизируется при реконструкции автомобиля, состоит из нескольких компонент. Для срендеренного фрейма и парного ему ground‑truth‑фрейма из видеопоследовательности первая компонента функции потерь — — отвечает за близость двух фреймов по L1-расстоянию и SSIM‑метрике. Вторая компонента функции потерь —

— поощряет прозрачность вне пикселей, которые принадлежат маске реконструируемого автомобиля на референсных фреймах. Третья компонента функции потерь —

— регуляризует нормали в 2D‑гауссианах так, чтобы они были близки по косинусному расстоянию к некоторым референсным нормалям, которые предварительно высчитываются с помощью метода NormalCrafter [10].

Кроме того, в статье предлагается адаптировать метод Difix [11] для генерации изображений реконструируемого объекта с новых ракурсов и с новыми конфигурациями освещения. Такие изображения дальше используются в реконструкции и помогают лучше отделить влияние собственного цвета объекта от внешнего освещения.

Примеры рендеров из реконструкций, которые получаются при разной конфигурации функции потерь, приведены ниже.

После того как реконструкция объекта завершена, получившаяся модель объекта выравнивается по ориентации единообразно, в соответствии с ориентацией главных компонент. Дополнительно с помощью модели Orient Anything [12] определяется фронтальное направление получившейся 3D‑модели объекта.

Ниже приведены примеры реальных 3D‑рендеров с разных ракурсов для объектов, похожих на некоторые объекты‑запросы из датасета автомобилей KITTI-360. Видно, что MADrive на базе MAD‑Cars даёт изображения, почти неотличимые от ground truth.

Вставка и переосвещение объектов

После реконструкции отдельных объектов они вставляются в сцену. Сначала происходит базовое выравнивание объектов на основе задетектированного 3D‑бокса объекта на сцене и восстановленной 3D‑формы ближайшего объекта из базы MAD‑Cars. Следующим шагом выравнивание уточняется с использованием метода Iterative Closest Point (ICP): выравнивается 3D‑форма объекта вставки с имеющимися лидарными точками, которые попадают в обнаруженный 3D‑бокс объекта на сцене. ICP позволяет скорректировать положение объекта, а также его масштаб.

Чтобы обеспечить консистентность освещения между новым объектом и всей сценой, у объекта подменяется компонент цвета, отвечающий за освещение. Карта освещения сцены ищется с помощью метода DiffusionLight [13] и применяется к объекту с использованием формулы из статьи [9].

Для повышения реализма вставляемой машины отдельно добавляется тень — чёрная плоскость, представленная 2D‑гауссианами, прямо под машиной.

Влияние переосвещения показано на рисунке ниже. Справа — кадры с адаптацией цвета, слева — без переосвещения (становится заметно, как неестественно выглядят авто без него).

Метрики и результаты

Качество синтетических изображений, генерируемых методом MADrive и альтернативными методами — StreetGS, HUGS и AutoSplat, было оценено через метрики производных задач, а именно трекинга и сегментации объектов на изображениях. В качестве метрик были взяты MOTA, MOTP и Identity F1 (IDF1) для трекинга и IOU для сегментации. При этом методы для трекинга (BotSort на основе YOLOv8n) и сегментации (Mask2Former) брались готовые и не дообучались на синтетических данных. По итогам MADrive превосходит аналоги, особенно при генерации «будущих» кадров, что критично для симуляции новых сценариев.

Постановка эксперимента

Для честного сравнения был выбран следующий протокол:

-

Рассматривается проезд, где

— первый кадр, а

— последний.

-

Статическая часть сцены (фон) обучается для всех методов на полной последовательности кадров

.

-

В MADrive автомобили из исходной сцены заменяются их реконструированными аналогами из датасета MAD‑Cars.

-

Для остальных методов динамические объекты (автомобили) восстанавливают отдельно только на начальной части последовательности

.

-

Метрики рассчитываются на интервале

путём сравнения синтезированных кадров с реальными.

Такой подход позволяет оценить, насколько хорошо методы обобщаются на временные промежутки, которые не использовались при обучении [14] динамики, то есть способны ли они к предсказанию и симуляции будущего.

В таблице ниже — полученные результаты.

|

Модель |

MOTA ↑ |

MOTP ↓ |

IDF1 ↑ |

Segmentation IoU ↑ |

|

StreetGS |

0,654 |

0,105 |

0,776 |

0,556 |

|

HUGS |

0,556 |

0,221 |

0,699 |

0,333 |

|

AutoSplat |

0,589 |

0,154 |

0,716 |

0,489 |

|

MADrive |

0,841 |

0,138 |

0,913 |

0,818 |

Как видно, MADrive значительно превосходит другие решения по двум метрикам трекера (MOTA и IDF1) и по метрике сегментации. Просадка в метрике MOTP относительно StreetGS объясняется тем, что на начальных тестовых кадрах StreetGS обеспечивает лучшее выравнивание машин с ground truth, но на более поздних кадрах автомобили «разваливаются» и такие ошибки [15] не учитываются в метрике MOTP.

Тестирование на новых сценариях

Особое преимущество MADrive проявляется, когда моделируется не только воспроизведение наблюдаемых кадров, но и что‑то совершенно новое: меняются траектории машин или полосы движения, машины начинают делать обгон или разворот.

Все эти преимущества были бы невозможны без использования богатой базы реальных автомобилей — датасета MAD‑Cars.

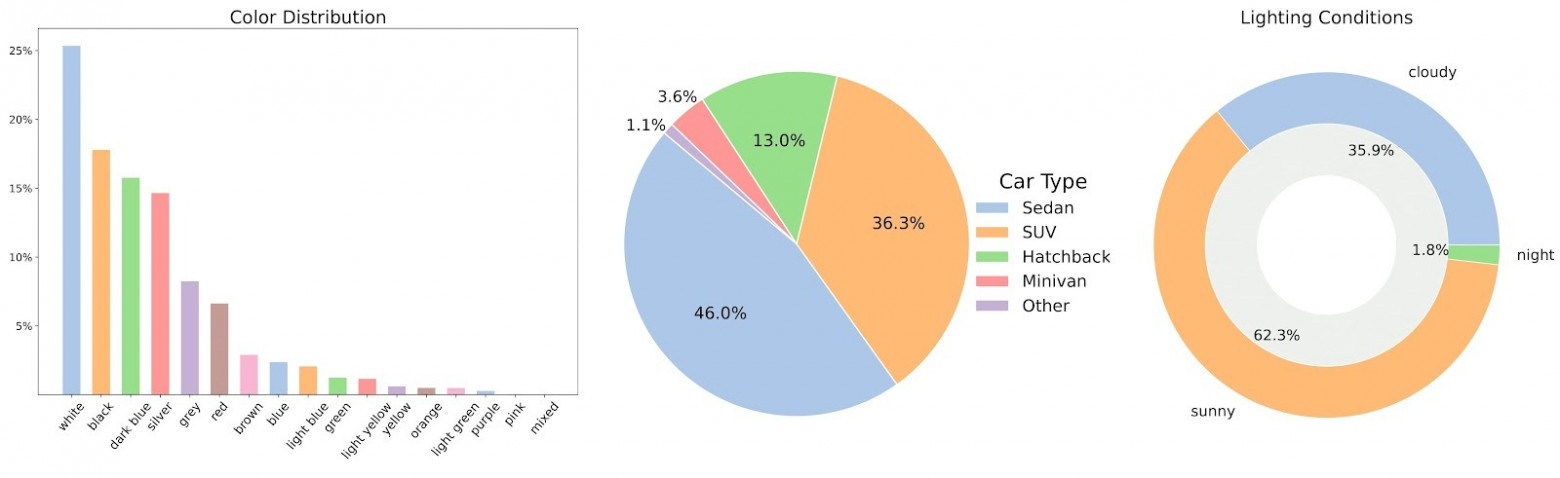

Датасет MAD-Cars

MAD‑Cars [8] — крупнейший на сегодня открытый датасет видеозаписей автомобилей, собранный из публичных объявлений о продаже и тщательно очищенный от низкокачественных и персональных данных.

В финальную выборку вошло около 70 000 уникальных видеозаписей, каждая из которых содержит в среднем 85 кадров. Большинство видео доступны в разрешении 1920 × 1080. Датасет охватывает автомобили примерно 150 марок, представленных в широком диапазоне цветов, типов кузова и при разных условиях освещения.

Каждый видеоряд сопровождается подробным метаописанием автомобиля, а именно — у каждого инстанса есть следующие поля:

-

car_id: уникальный идентификатор экземпляра автомобиля;

-

view_id: идентификатор конкретного ракурса автомобиля;

-

url: ссылка для скачивания соответствующего изображения автомобиля в данном ракурсе;

-

color: значение цвета автомобиля в формате RGB;

-

brand: производитель или марка автомобиля;

-

model: название или обозначение конкретной модели автомобиля.

Качество данных контролировалось в два этапа. Сначала из ~95 000 собранных видео удалялись слишком тёмные или низкокачественные кадры. Для этого использовалась модель CLIP‑IQA [16], все кадры с оценкой ниже 0,2 исключались.

На втором этапе применялась мультимодальная модель Qwen2.5-VL [17], которая для каждого кадра отвечала на ряд вопросов:

-

Видно ли авто целиком?

-

Есть ли значительные перекрытия (например, заборы, деревья, другие машины)?

-

Снят ли кадр внутри автомобиля?

-

Перекрывает ли другой объект (например, рука оператора) важную часть изображения?

-

Открыты ли двери или окна?

-

Является ли кадр главным образом фотографией окна автомобиля?

По результатам из набора удалялись отдельные кадры или целые видеосессии. Если у автомобиля оставалось менее 45 валидных кадров, он полностью исключался из выборки.

MAD‑Cars может быть особенно полезен исследователям и разработчикам, которые занимаются системами автономного транспорта, а также задачами генерации новых видов (novel view synthesis), 3D‑реконструкции и другими задачами компьютерного зрения [18], где требуется большая и разнообразная база «реальных» автомобилей. А тем, кому важна детализация, доступен полный массив метаданных для каждой машины и подробная информация о видео.

Датасет лежит в открытом доступе, и его можно скачивать.

Заключение

Итак, в этой статье я рассказал о MADrive — методе замены автомобилей в сцене на высококачественные 3D‑реконструкции, подобранные из реальных многоракурсных видеозаписей. Этот подход обеспечивает высокую визуальную достоверность и устойчивость к изменению ракурса, что критично для реалистичной симуляции автономного вождения.

MADrive превосходит существующие методы по ключевым метрикам на данных из датасета Waymo, особенно в задачах генерации «будущих» кадров и моделирования новых сценариев. Благодаря использованию открытого датасета MAD‑Cars предлагаемая система способна точно воспроизводить и форму, и марку автомобиля, и его цвет без риска, что при смене угла обзора модель «развалится».

Подробнее о методе, архитектуре и экспериментах — в научной статье

MADrive: Memory‑Augmented Driving Scene Modeling [19].

Есть надежда, что MAD‑Cars и MADrive станут полезными инструментами для исследователей в области компьютерного зрения и автономного транспорта и вдохновят на новые идеи в симуляции, рендеринге и тестировании perception‑систем.

Отдельная благодарность команде, которая разработала MADrive, собрала датасет MAD‑Cars и подготовила научную публикацию: Полине Карпиковой, Даниилу Селихановичу, Кириллу Струминскому, Руслану Мусаеву, Марии Голицыной и Дмитрию Баранчуку.

Автор: simflin

Источник [20]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/25215

URLs in this post:

[1] логику: http://www.braintools.ru/article/7640

[2] поведением: http://www.braintools.ru/article/9372

[3] StreetGS: https://arxiv.org/html/2401.01339v1

[4] AutoSplat: https://arxiv.org/abs/2407.02598

[5] HUGS: https://share.google/L3jGReBBUmucAIUk0

[6] поведение: http://www.braintools.ru/article/5593

[7] UrbanCAD: https://arxiv.org/abs/2411.19292

[8] MAD‑Cars: https://huggingface.co/datasets/yandex/mad-cars

[9] статьи: https://openaccess.thecvf.com/content/CVPR2022/papers/Munkberg_Extracting_Triangular_3D_Models_Materials_and_Lighting_From_Images_CVPR_2022_paper.pdf

[10] NormalCrafter: https://openaccess.thecvf.com/content/ICCV2025/papers/Bin_NormalCrafter_Learning_Temporally_Consistent_Normals_from_Video_Diffusion_Priors_ICCV_2025_paper.pdf

[11] Difix: https://arxiv.org/abs/2503.01774

[12] Orient Anything: https://arxiv.org/pdf/2412.18605

[13] DiffusionLight: https://arxiv.org/pdf/2312.09168

[14] обучении: http://www.braintools.ru/article/5125

[15] ошибки: http://www.braintools.ru/article/4192

[16] CLIP‑IQA: https://arxiv.org/abs/2207.12396

[17] Qwen2.5-VL: https://arxiv.org/pdf/2502.13923

[18] зрения: http://www.braintools.ru/article/6238

[19] MADrive: Memory‑Augmented Driving Scene Modeling: https://arxiv.org/html/2506.21520v1

[20] Источник: https://habr.com/ru/companies/yandex/articles/991000/?utm_campaign=991000&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.