Мультимодальные модели по-прежнему не могут преодолеть 50-процентный барьер в визуальном распознавании объектов

Тест WorldVQA проверяет, действительно ли мультимодальные языковые модели распознают визуальные объекты или просто создают иллюзии. Даже лучшие модели не могут преодолеть отметку в 50 процентов.

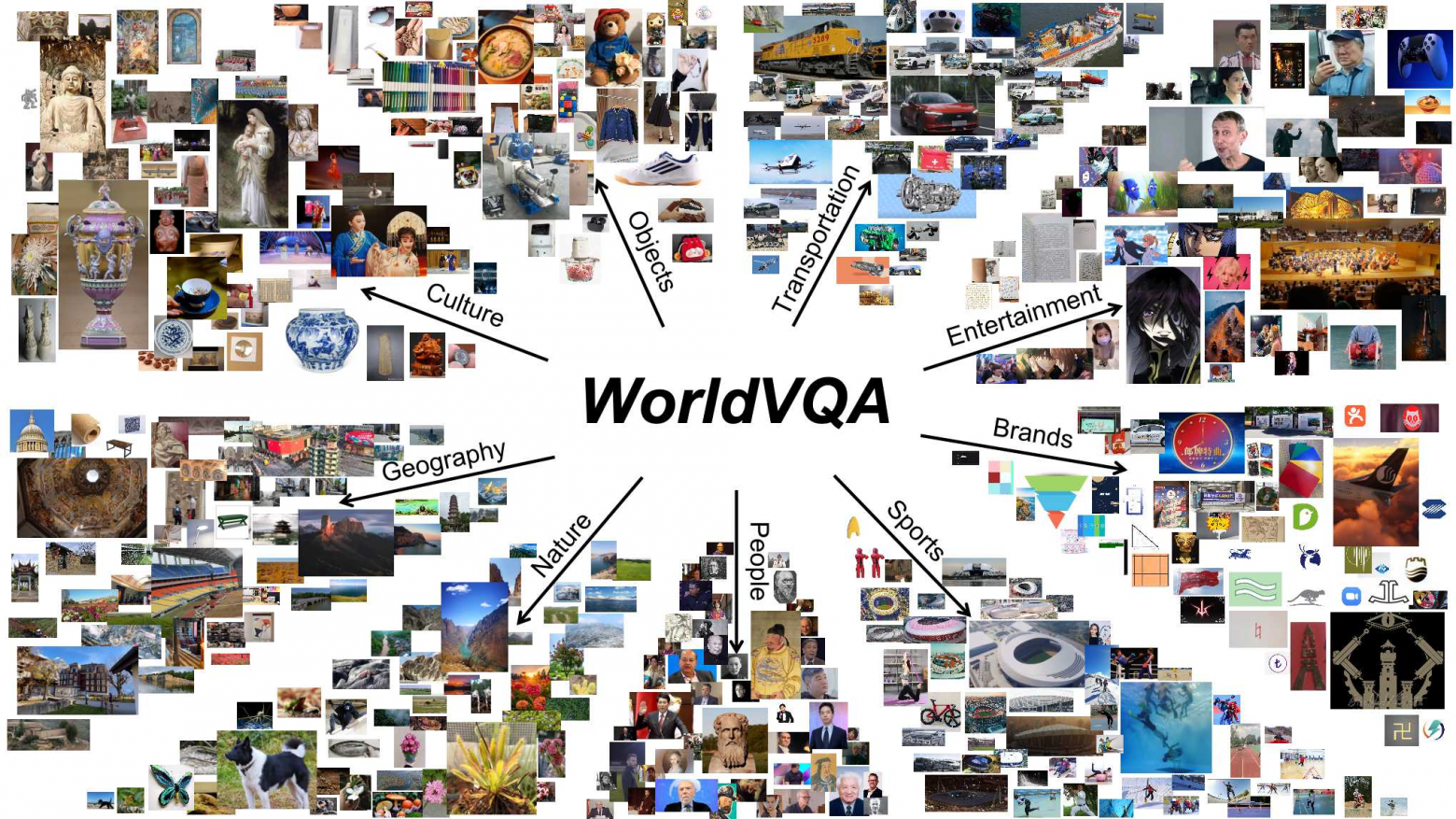

Исследователи из Moonshot AI [1], компании, разработавшей серию моделей Kimi, выпустили новый эталонный набор данных под названием WorldVQA. Этот набор данных включает 3500 пар «изображение-вопрос» в девяти категориях, охватывающих все: от природы и архитектуры до культуры, искусства, брендов, спорта и известных личностей.

Обобщенных этикеток недостаточно

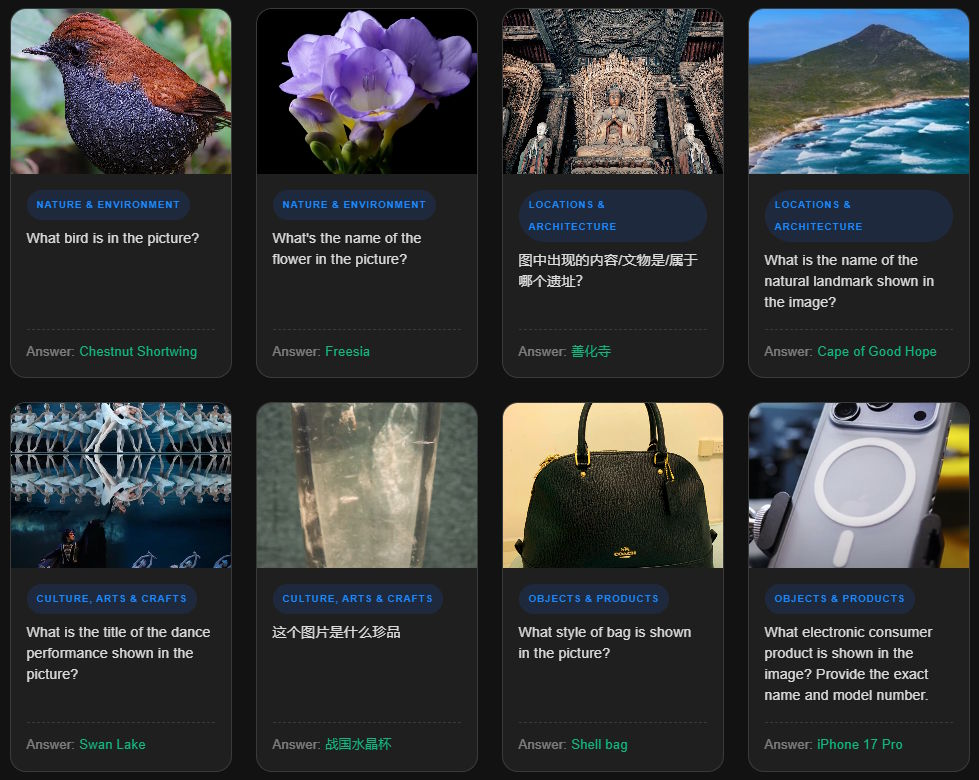

WorldVQA отличается от существующих бенчмарков, таких как MMMU или MMBench, тем, что строго разделяет чистое распознавание объектов и логическое рассуждение. Согласно сопроводительной статье [2], цель состоит в том, чтобы измерить «что модель запоминает», а не то, насколько хорошо она может комбинировать или выводить информацию.

На вопросы требуются конкретные ответы. Если модель просто называет изображение бишон фризе [3] “собакой”, это считается ошибкой [4]. Модель должна указать точную породу.

Разрыв между общеизвестными и редкими знаниями особенно показателен. Хорошо известные достопримечательности и популярные логотипы брендов встречаются повсюду в интернете и широко представлены в обучающих данных, но редкие записи проверяют знания о малоизвестных объектах, видах животных и растений или культурных артефактах со всего мира.

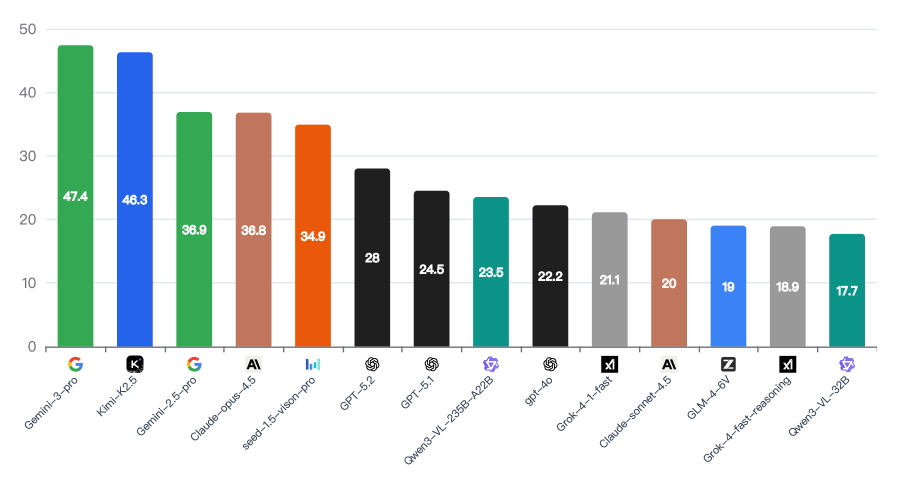

Gemini и Kimi лидируют, но ни одна из них не набирает более 50 процентов

Наивысший результат среди свободно доступных моделей показал Google Gemini 3 Pro – 47,4%, за ним следует Kimi K2.5 с 46,3%, что делает его лучшей моделью. Claude Opus 4.5 от Anthropic набирает 36,8%, а GPT-5.2 от OpenAI – 28%. Даже более старая модель Google Gemini 2.5 Pro превосходит обе.

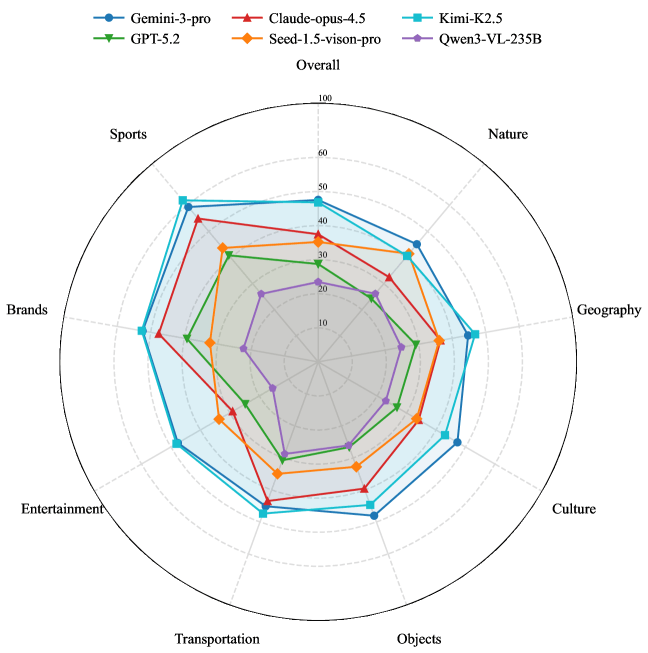

Анализ результатов по категориям выявляет явные пробелы в знаниях. Модели показывают относительно хорошие результаты в отношении брендов и спорта, вероятно, потому что эти темы широко представлены в обучающих данных для веб-обучения. С другой стороны, показатели в отношении природы и культуры значительно снижаются.

В этих категориях модели, как правило, используют общие термины, такие как «цветок», вместо того, чтобы называть конкретные виды. Системы искусственного интеллекта [5], по сути, свободно владеют поп-культурой, но остаются поверхностными, когда дело доходит до мира природы и культурного наследия.

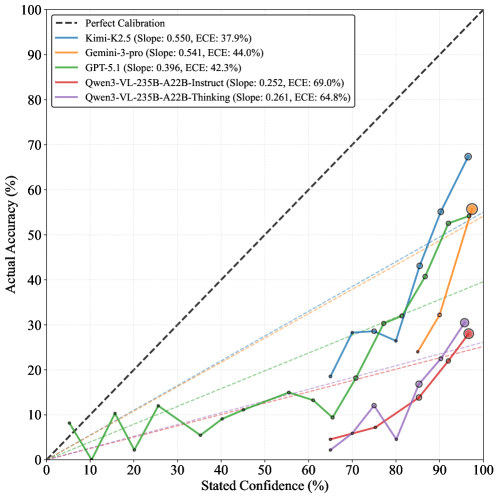

Модели неизменно переоценивают собственную точность

Еще один важный вывод касается самооценки. Исследовательская группа попросила каждую модель оценить свою уверенность по шкале от 0 до 100. Результаты поразительны: каждая протестированная модель продемонстрировала систематическую чрезмерную уверенность. Gemini 3 Pro показала уверенность в 95 процентов или выше более чем в 85 процентах случаев – независимо от того, был ли ответ на самом деле правильным. Kimi K2.5 показала наилучшую самокалибровку с ошибкой калибровки в 37,9 процента, но это все еще далеко от идеала.

Этот разрыв между самооценкой и фактическими результатами свидетельствует о том, что существующие модели не обладают надежным внутренним пониманием пределов своих собственных знаний. Проще говоря, они не знают, чего не знают.

Ошибки возникают из-за реальных пробелов в знаниях

Чтобы убедиться, что сложные вопросы действительно отражают реальный недостаток знаний, а не неоднозначные образы, исследователи проверили свою классификацию, используя большой справочный словарь. Анализ подтверждает закономерность: чем реже объект встречается в реальных данных, тем сложнее моделям его распознать.

Простые вопросы сосредоточены на обычных предметах и людях, в то время как сложные вопросы действительно касаются редких событий. Сложность теста обусловлена реальным дефицитом знаний, а не ошибками аннотаций или визуальной неоднозначностью.

Почему это важно для агентов искусственного интеллекта

Исследователи считают WorldVQA необходимым шагом для следующего поколения ИИ-помощников. Если модели не смогут надежно распознавать то, что видят, их полезность для решения реальных задач останется ограниченной.

Команда признает одно ограничение: эталонный тест измеряет фактические знания в условиях строгой изоляции. Вопрос о том, приводит ли способность правильно называть конкретные объекты к улучшению результатов в сложных практических задачах, остается открытым для исследований. Набор данных [6] и скрипты оценки [7] находятся в открытом доступе.

Недавние исследования продолжают выявлять фундаментальные недостатки в надежности моделей ИИ. Бенчмарк AA Omniscience от Artificial Analysis [8] недавно показал, что только четыре из 40 протестированных моделей получили положительный результат. Gemini 3 Pro также лидировала в этом отношении, но все же имела показатель ложных срабатываний в 88 процентов.

В другом исследовании изучалось, могут ли языковые модели оценить сложность экзаменационных вопросов для людей. Результат: модели слишком хорошо справляются с воспроизведением трудностей, с которыми сталкиваются менее способные ученики. Исследователи назвали это «проклятием знания», [9] и это еще раз показывает, что модели не могут надежно оценивать собственные ограничения.

Делегируйте часть рутинных задач вместе с BotHub! [10] Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке [11] вы можете получить 300 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Источник [12]

Автор: MrRjxrby

Источник [13]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/25371

URLs in this post:

[1] Moonshot AI: https://www.kimi.com/blog/worldvqa.html

[2] сопроводительной статье: https://arxiv.org/abs/2602.02537

[3] фризе: https://en.wikipedia.org/wiki/Bichon_Fris%C3%A9

[4] ошибкой: http://www.braintools.ru/article/4192

[5] интеллекта: http://www.braintools.ru/article/7605

[6] данных: https://huggingface.co/datasets/moonshotai/WorldVQA

[7] скрипты оценки: https://github.com/MoonshotAI/WorldVQA

[8] Бенчмарк AA Omniscience от Artificial Analysis: https://the-decoder.com/new-artificial-analysis-benchmark-shows-openai-anthropic-and-google-locked-in-a-three-way-tie-at-the-top/

[9] Исследователи назвали это «проклятием знания»,: https://the-decoder.com/the-curse-of-knowledge-means-smarter-ai-models-arent-better-at-understanding-human-learning-gaps/

[10] BotHub!: https://bothub.chat/?utm%5C_source=contentmarketing&utm%5C_medium=habr&utm%5C_campaign=news&utm%5C_content%20=MULTIMODAL_MODELS_STILL_CANNOT_OVERCOME_THE_50_BARRIER_IN_VISAUL_OBJECT_RECOGNITION

[11] По ссылке: https://bothub.chat/?invitedBy=m_aGCkuyTgqllHCK0dUc7

[12] Источник: https://the-decoder.com/best-multimodal-models-still-cant-crack-50-percent-on-basic-visual-entity-recognition/

[13] Источник: https://habr.com/ru/companies/bothub/news/994176/?utm_source=habrahabr&utm_medium=rss&utm_campaign=994176

Нажмите здесь для печати.