Исследования показывают, что ИИ-модели по-прежнему слишком часто испытывают галлюцинации

Новое исследование, проведенное учеными из Швейцарии и Германии, показывает, что даже лучшие модели, такие как Claude Opus 4.5, с включенным веб-поиском все равно выдают неверную информацию почти в трети случаев.

Генеральный директор Nvidia Йенсен Хуанг утверждает, что у моделей больше нет галлюцинаций [1], но наука [2] с этим не согласна. Исследователи из швейцарского EPFL, Тюбингенского института ELLIS и Института интеллектуальных систем имени Макса Планка разработали «Halluhard» – бенчмарк, измеряющий галлюцинации в реалистичных многоходовых диалогах. Результаты говорят об обратном: галлюцинации по-прежнему остаются серьезной проблемой [3], даже при включенном веб-поиске.

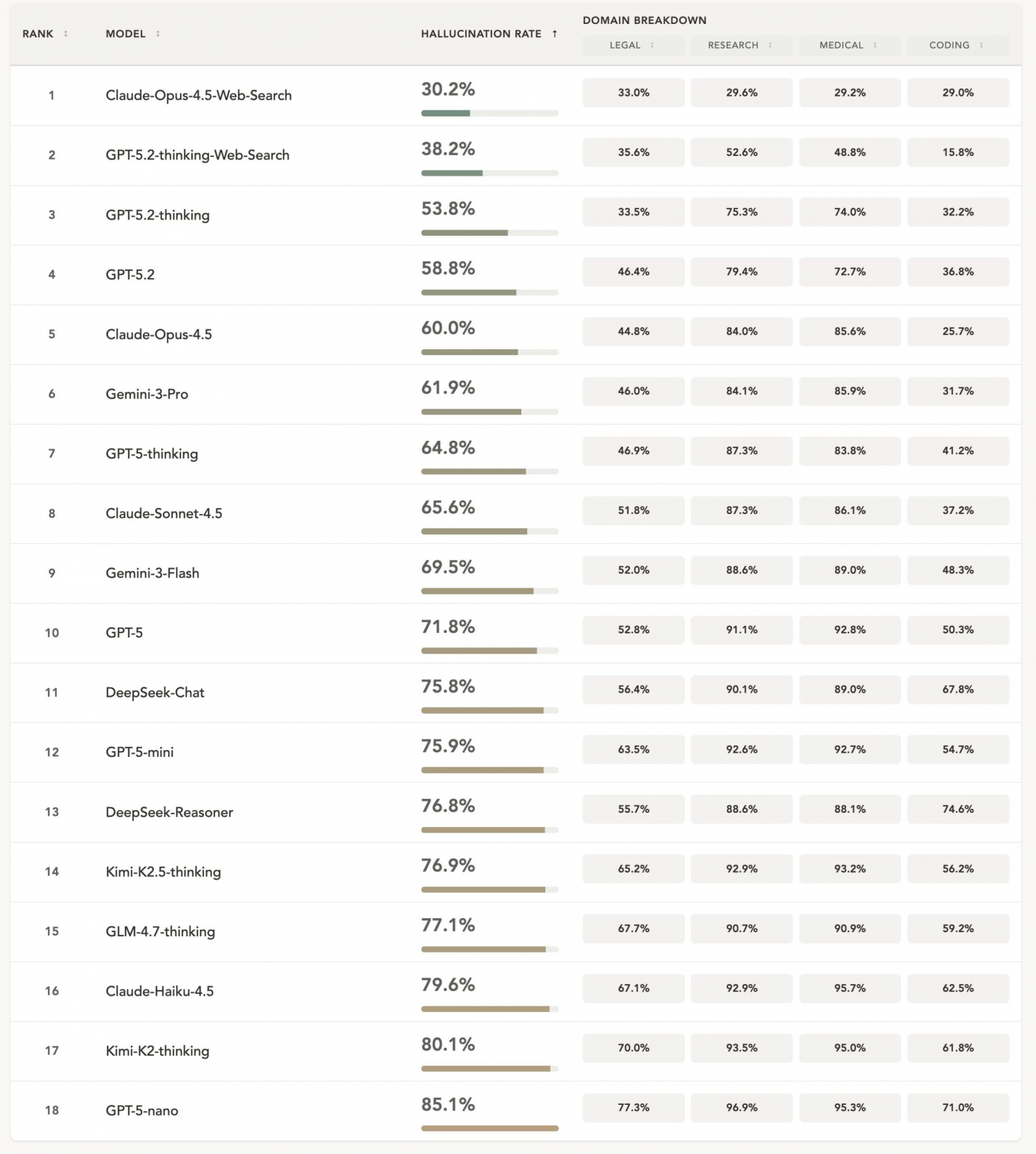

Тест охватывает 950 первоначальных вопросов по четырем важным областям знаний: юридические дела, исследовательские вопросы, медицинские рекомендации и программирование. Для каждого первоначального вопроса отдельная пользовательская модель генерировала два дополнительных вопроса, создавая реалистичные диалоги из трех этапов.

Согласно исследованию, даже при использовании наилучшей из протестированных конфигураций, Claude Opus 4.5 с веб-поиском, галлюцинации возникали примерно в 30 процентах случаев. Без веб-поиска этот показатель подскочил до 60 процентов. В случае GPT-5.2 Thinking с веб-поиском этот показатель составил 38,2 процента.

Китайские модели логического мышления [4], такие как Kimi-K2-Thinking [5] и GLM-4.7-Thinking, [6] показали наихудшие результаты по сравнению со своими аналогами, основанными на прямом логическом мышлении. Примечательно, что это открытые модели, которые обычно показывают себя наравне с лучшими моделями в других тестах, что вызывает подозрение в их целенаправленной оптимизации для получения высоких результатов в тестах, а не для обеспечения надежности в реальных условиях.

Более крупные модели реже испытывают галлюцинации, но рассуждение помогает лишь отчасти

Более крупные модели, как правило, реже испытывают галлюцинации. В семействе GPT-5 средний уровень галлюцинаций снизился с 85,1% для GPT-5-nano до 71,8% для GPT-5 и далее до 53,8% для GPT-5.2 Thinking. У Клода наблюдалась аналогичная закономерность: 79,5% для Haiku, 65,6% для Sonnet и 60% для Opus.

Рассуждение, по сути, более длительное обдумывание перед ответом [7], действительно уменьшает галлюцинации, но увеличение вычислительных ресурсов, затрачиваемых на рассуждение, не обязательно помогает. Модели с более сложным рассуждением давали более длинные и подробные ответы с большим количеством утверждений, что, в свою очередь, создавало больше возможностей для ошибок.

Примечательно, что DeepSeek Reasoner не продемонстрировал улучшений по сравнению с DeepSeek Chat, несмотря на свои возможности в области логического мышления. Исследователи указывают на сохраняющийся разрыв между проприетарными и открытыми моделями.

Поиск в интернете уменьшает галлюцинации, но не устраняет их полностью

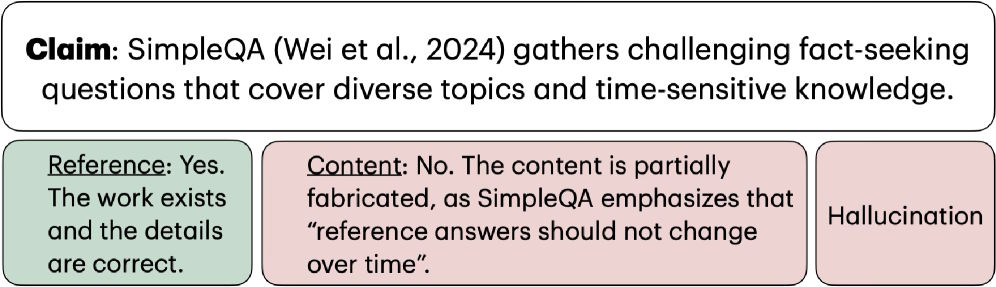

Исследователи различают два типа галлюцинаций. Проверка на основе ссылок проверяет, действительно ли существует цитируемый источник. Проверка на основе содержания проверяет, действительно ли этот источник подтверждает заявленную информацию.

Это различие выявляет тонкую, но распространенную ошибку [8]: модель может ссылаться на достоверный источник и при этом фальсифицировать детали, которые этот источник не подтверждает. В качестве примера исследователи приводят утверждение о бенчмарке SimpleQA [9], где ссылка была верной, но содержание было частично вымышленным.

Данные, полученные в ходе исследования по изучаемой теме, показывают, что веб-поиск в первую очередь снижает количество ошибок, связанных с ссылками. Для Claude Opus 4.5 частота ошибок, связанных с ссылками, снизилась с 38,6 до 7 процентов при использовании веб-поиска. Однако ошибки, связанные с обоснованием содержания, снизились гораздо меньше – с 83,9 до 29,5 процентов. GPT-5.2 Thinking показал аналогичную картину: ошибки, связанные с ссылками, снизились до 6,4 процента при использовании веб-поиска, но ошибки, связанные с обоснованием содержания, остались на уровне 51,6 процента.

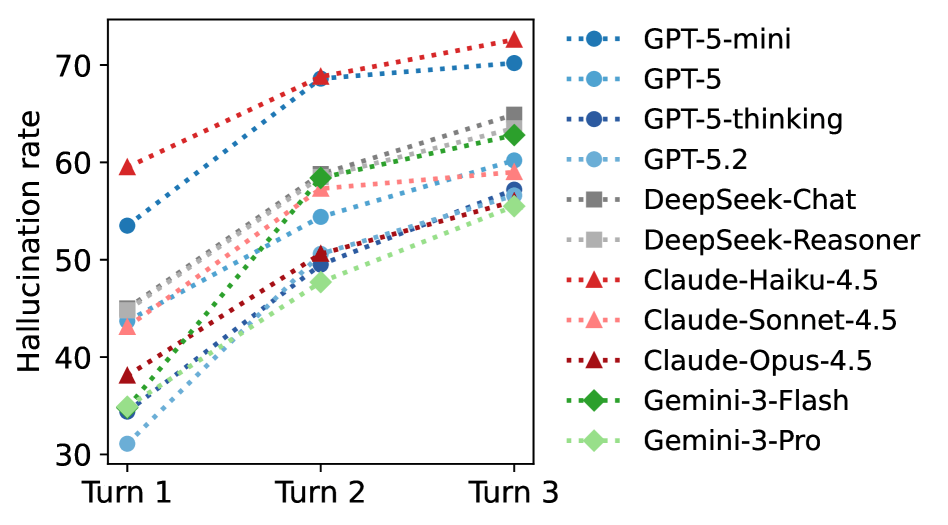

Длительные диалог усугубляет галлюцинации

Один из ключевых выводов касается того, что происходит на протяжении нескольких ходов разговора: частота галлюцинаций увеличивается в последующих раундах. Исследователи объясняют это тем, что модели воспринимают весь предыдущий разговор как контекст, опираясь на свои собственные ошибки. От 3 до 20 процентов неверных ссылок из первого хода повторялись в последующих раундах. Предыдущие исследования [10] уже показали, что длинные чаты [11] и перегруженные контекстные окна [12] ухудшают производительность ИИ-моделей.

В заданиях на программирование наблюдалась противоположная тенденция: частота галлюцинаций фактически снижалась на более поздних этапах. Исследователи предполагают, что это происходит потому, что задачи естественным образом сужаются по мере развития разговора, переходя от общих требований, таких как «создать X», к конкретным вопросам, таким как «исправить эту функцию». Более узкие задачи оставляют меньше места для креативных, но неверных ответов.

Именно в узкоспециализированных задачах модели чаще всего терпят неудачу

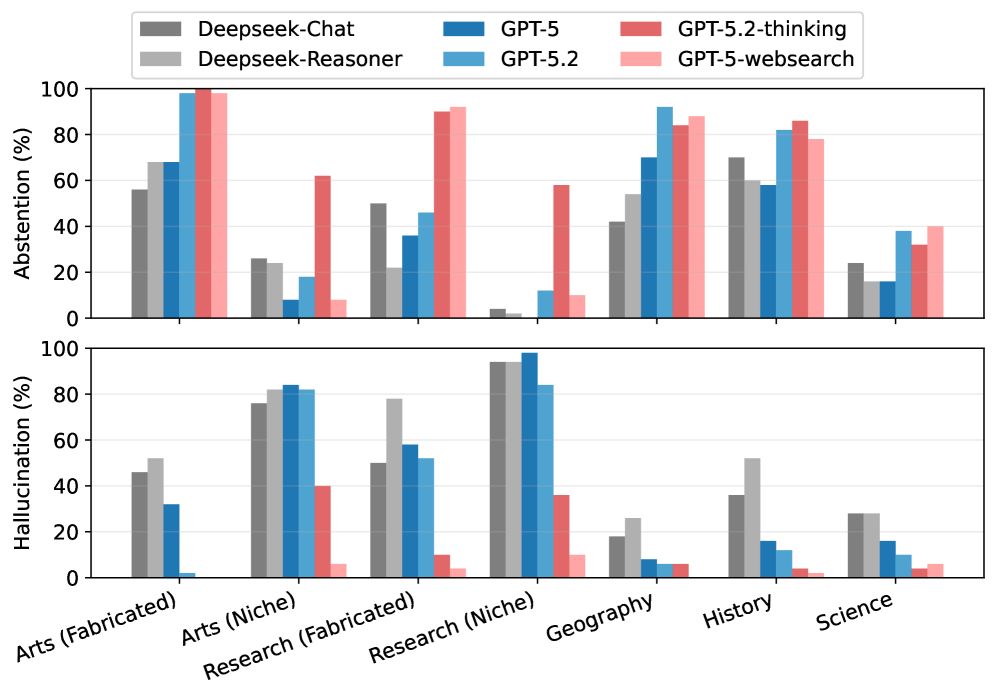

В контролируемом эксперименте, включавшем 350 коротких вопросов, исследователи проверили, когда у моделей возникают галлюцинации и когда они отказываются отвечать. При вопросах о полностью вымышленных сущностях модели, как правило, воздерживались от ответа. Но при вопросах, касающихся узкоспециализированных знаний, таких как редко цитируемые научные статьи или произведения искусства из местных галерей, галлюцинации возникали гораздо чаще.

Исследователи объясняют это тем, что узкоспециализированная информация появляется во время обучения [13] лишь фрагментарно. Эти фрагменты достаточны для того, чтобы вызвать ответ, но не правильный. В случае с совершенно неизвестными темами, по крайней мере, есть шанс, что модель признает свое незнание.

Существующие тесты не успевают за прогрессом в разработке моделей

Исследователи утверждают, что необходим новый эталонный тест, поскольку существующие тесты практически не позволяют различать модели [14]. На SimpleQA [9] модель GPT-4o с предварительным просмотром результатов поиска уже достигает 90 процентов точности, а GPT-5 Thinking с веб-поиском – 95,1 процента. При предполагаемой погрешности эталонного теста около 3 процентов это, по сути, потолок.

Halluhard разработан таким образом, чтобы оставаться сложным для будущих поколений, сочетая многоэтапные диалоги, конфиденциальные области знаний и узкоспециализированные задачи. Бенчмарк и код доступны на GitHub [15], а результаты также опубликованы на странице проекта [16].

Хотите быть в курсе важных новостей из мира ИИ? Подписывайтесь на наш Telegram‑канал BotHub AI News [17].

Источник [18]

Автор: MrRjxrby

Источник [19]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/25430

URLs in this post:

[1] Йенсен Хуанг утверждает, что у моделей больше нет галлюцинаций: https://the-decoder.com/nvidia-ceo-jensen-huang-claims-ai-no-longer-hallucinates-apparently-hallucinating-himself/

[2] наука: http://www.braintools.ru/article/7634

[3] галлюцинации по-прежнему остаются серьезной проблемой: https://the-decoder.com/gemini-3-pro-tops-new-ai-reliability-benchmark-but-hallucination-rates-remain-high/

[4] мышления: http://www.braintools.ru/thinking

[5] Kimi-K2-Thinking: https://the-decoder.com/moonshot-ais-kimi-k2-thinking-sets-new-agentic-reasoning-records-in-open-source-llms/

[6] GLM-4.7-Thinking,: https://the-decoder.com/zhipu-ai-challenges-western-rivals-with-low-cost-glm-4-7/

[7] Рассуждение, по сути, более длительное обдумывание перед ответом: https://the-decoder.com/openais-o1-probably-does-more-than-just-elaborate-step-by-step-prompting/

[8] ошибку: http://www.braintools.ru/article/4192

[9] бенчмарке SimpleQA: https://the-decoder.com/openai-releases-simpleqa-benchmark-to-test-ai-model-factual-accuracy/

[10] Предыдущие исследования: https://the-decoder.com/yet-another-study-finds-that-overloading-llms-with-information-leads-to-worse-results/

[11] длинные чаты: https://the-decoder.com/ai-chatbots-become-dramatically-less-reliable-in-longer-conversationsnew-study-finds/

[12] перегруженные контекстные окна: https://the-decoder.com/ai-language-models-struggle-to-connect-the-dots-in-long-texts-study-finds/

[13] обучения: http://www.braintools.ru/article/5125

[14] существующие тесты практически не позволяют различать модели: https://the-decoder.com/most-llm-benchmarks-are-flawed-casting-doubt-on-ai-progress-metrics-study-finds/

[15] на GitHub: https://github.com/epfml/halluhard

[16] на странице проекта: https://halluhard.com/

[17] BotHub AI News: https://t.me/bothub

[18] Источник: https://the-decoder.com/new-benchmark-shows-ai-models-still-hallucinate-far-too-often/

[19] Источник: https://habr.com/ru/companies/bothub/news/994664/?utm_source=habrahabr&utm_medium=rss&utm_campaign=994664

Нажмите здесь для печати.