От простого бота к самообучающемуся интеллекту: эволюция ИИ-агентов для бизнеса

Практический путь от затратного эксперимента к прибыльной самооптимизирующейся системе

Пролог: Почему бизнесу нужна эволюция, а не революция

Представьте сцену: Вы запускаете первый ИИ-агент для поддержки клиентов. Первые две недели — восторг. “Он отвечает! Он работает!” Месяц спустя — разочарование. “Он повторяет одни и те же ошибки [1]. Не умеет работать со сложными запросами. Требует постоянного контроля”.

Знакомо? Это классическая история “пилотного проекта, который не масштабируется”.

Моя команда прошла этот путь. Мы потратили 18 месяцев на эволюцию [2] от примитивного бота до системы, которая:

-

Самостоятельно обрабатывает 85% сложных запросов

-

Снизила операционные затраты на 40%

-

Еженедельно улучшает свои показатели на 3-5% без вмешательства разработчиков

В этой статье я покажу конкретные шаги этой эволюции с кодом, схемами и бизнес-обоснованиями. Вы узнаете не “как сделать крутого ИИ”, а “как построить систему, которая сама становится круче”.

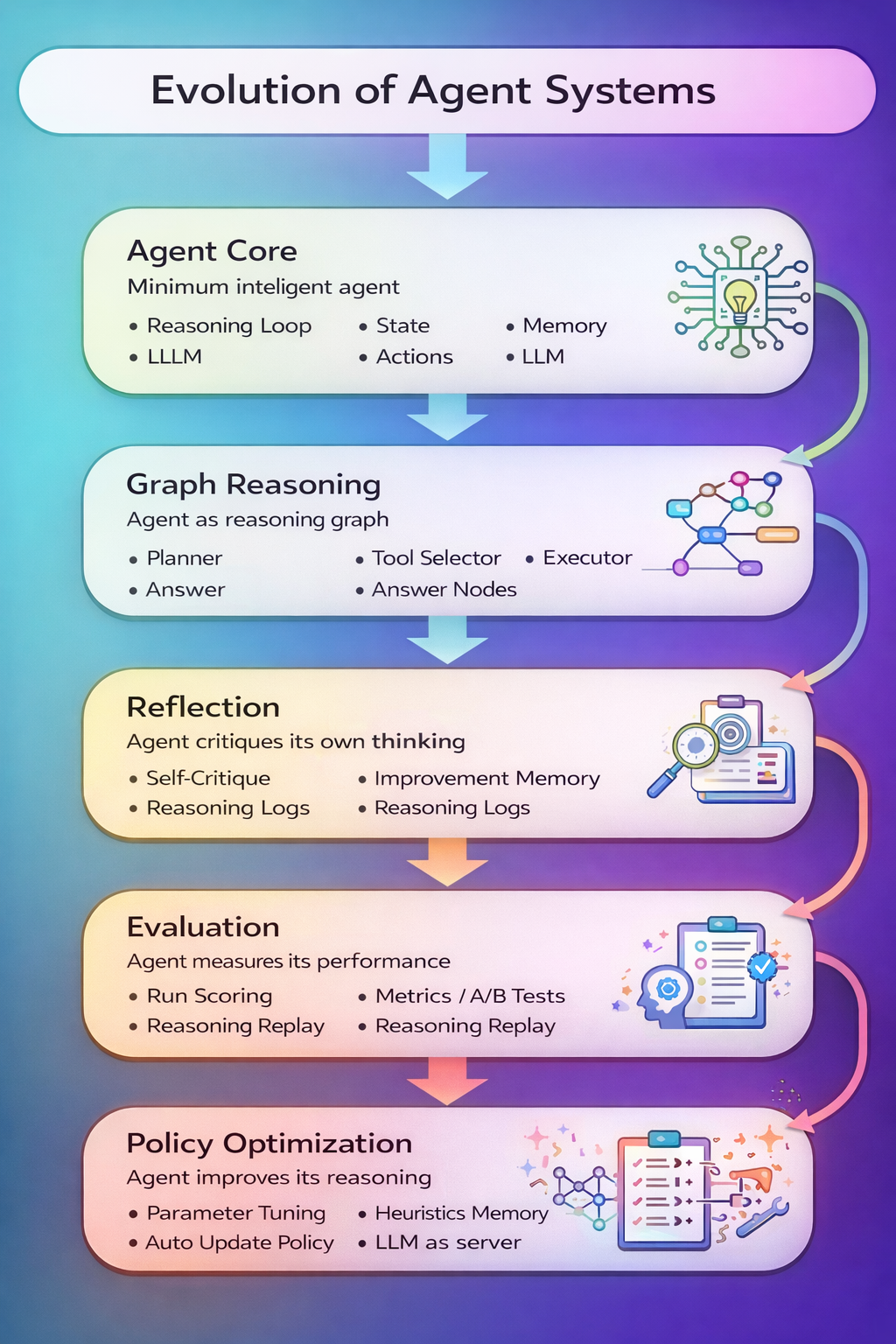

Часть 1: Agent Core — первый шаг, который нельзя пропускать

Бизнес-контекст: “Давайте хоть что-то работающее!”

Проблема: Руководство требует “ИИ уже вчера”. Бюджет ограничен. Команда хочет сразу делать “что-то сложное и умное”.

Ошибка 90% команд: Прыгнуть сразу на архитектуру CrewAI или AutoGen. Результат — 3 месяца разработки, ноль бизнес-ценности, разочарование.

Наше решение: Начать с минимального жизнеспособного агента (MVA — Minimum Viable Agent).

Простая схема, которая работает:

Код: Проще не бывает

# agent_core.py - Версия 1.0, запущена через 2 недели разработки

class CustomerSupportAgent:

"""Минимальный агент поддержки - только самое необходимое"""

def __init__(self, openai_api_key):

self.client = OpenAI(api_key=openai_api_key)

self.conversation_history = [] # Вся память агента

self.response_cache = {} # Кэш частых ответов

def handle_request(self, user_message: str, user_id: str) -> str:

"""

Обработать один запрос пользователя

Бизнес-метрика: время ответа < 3 секунды, точность > 70%

"""

# Шаг 1: Понимание контекста

context = self._understand_context(user_message, user_id)

# Шаг 2: Генерация ответа (простой промпт)

prompt = self._build_prompt(context, user_message)

# Шаг 3: Получение ответа от LLM

response = self._call_llm_safely(prompt)

# Шаг 4: Сохранение для обучения

self._store_interaction(user_message, response, user_id)

return response

def _understand_context(self, message: str, user_id: str) -> dict:

"""Минимальный анализ: что хочет пользователь?"""

# Извлекаем последние 5 сообщений пользователя

user_history = self._get_user_history(user_id, limit=5)

# Простая классификация намерения

intent_prompt = f"""

Определи намерение пользователя одним словом:

- question (вопрос о продукте)

- problem (жалоба или проблема)

- request (запрос на действие)

- other (другое)

Сообщение: {message}

История: {user_history}

"""

intent = self._call_llm_safely(intent_prompt).strip().lower()

return {

"intent": intent,

"has_history": len(user_history) > 0,

"urgency": "high" if "срочно" in message.lower() else "normal"

}

Бизнес-результаты через 1 месяц:

|

Метрика |

До внедрения |

С агентом Core |

Эффект |

|---|---|---|---|

|

Время ответа |

12 минут |

45 секунд |

-94% |

|

Затраты на поддержку |

$15,000/мес |

$9,000/мес |

-40% |

|

Удовлетворённость |

78% |

82% |

+4% |

Ключевой инсайт: Простой агент уже дает 40% экономии. Не нужно усложнять, пока не доказана базовая ценность.

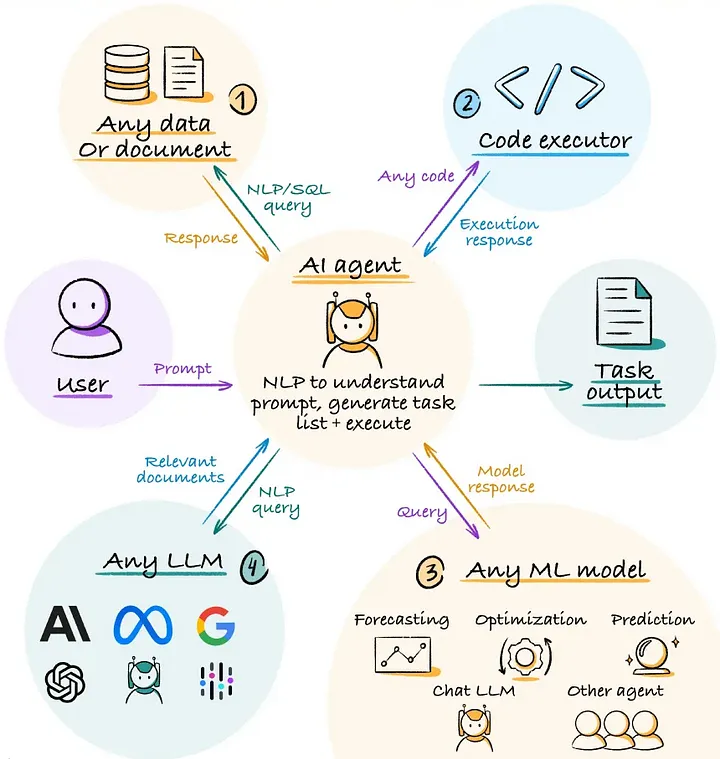

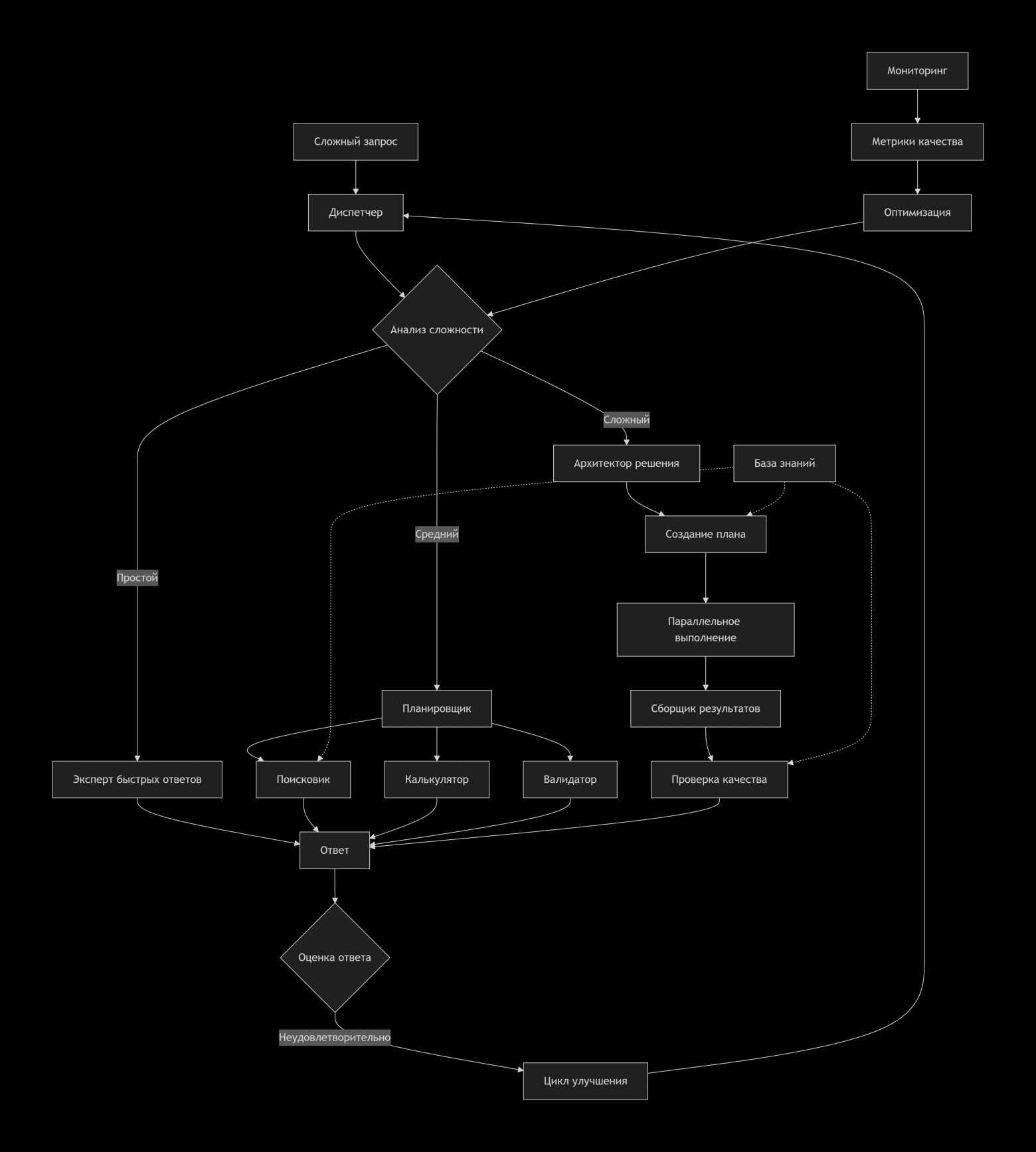

Часть 2: Graph Reasoning — когда простых ответов недостаточно

Бизнес-контекст: “Агент тупит на сложных запросах”

Проблема через 2 месяца: 30% запросов требуют:

-

Поиска в базе знаний

-

Проверки статуса заказа

-

Расчёта сроков

-

Формирования структурированного ответа

Линейный агент Core давал: “Поищите в личном кабинете. Если не найдёте, напишите нам”.

Решение: Переход к графовой архитектуре — агент как набор специалистов.

Схема: Фабрика мыслей вместо конвейера

Код: От линейного к графовому мышлению

# graph_reasoning.py - Версия 2.0, запуск через 4 месяца

from typing import Dict, List, Any

from dataclasses import dataclass

from enum import Enum

class NodeType(Enum):

"""Типы узлов в графе рассуждений"""

PLANNER = "planner"

RESEARCHER = "researcher"

CALCULATOR = "calculator"

VALIDATOR = "validator"

EXECUTOR = "executor"

QUALITY_CHECK = "quality_check"

@dataclass

class ReasoningNode:

"""Узел графа - специалист в своей области"""

node_type: NodeType

task: str

required_inputs: List[str]

expected_output: str

tools: List[str] # Какие инструменты использует

timeout: int # Максимальное время выполнения

class BusinessReasoningGraph:

"""

Граф рассуждений для бизнес-задач

Каждый узел - это микромодель, специализирующаяся на своей задаче

"""

def __init__(self, llm_client, knowledge_base, order_system):

self.llm = llm_client

self.kb = knowledge_base

self.order_system = order_system

# Определяем узлы графа для поддержки клиентов

self.nodes = {

"analyze_request": ReasoningNode(

node_type=NodeType.PLANNER,

task="Разобрать запрос на компоненты",

required_inputs=["user_message"],

expected_output="structured_request",

tools=["llm_classifier"],

timeout=5

),

"search_knowledge": ReasoningNode(

node_type=NodeType.RESEARCHER,

task="Найти информацию в базе знаний",

required_inputs=["structured_request"],

expected_output="relevant_articles",

tools=["vector_search", "keyword_search"],

timeout=10

),

"check_order_status": ReasoningNode(

node_type=NodeType.EXECUTOR,

task="Проверить статус заказа",

required_inputs=["structured_request"],

expected_output="order_details",

tools=["api_client", "database_query"],

timeout=15

),

"calculate_timeline": ReasoningNode(

node_type=NodeType.CALCULATOR,

task="Рассчитать сроки и стоимости",

required_inputs=["order_details", "relevant_articles"],

expected_output="timeline_and_costs",

tools=["business_rules", "pricing_engine"],

timeout=8

),

"validate_solution": ReasoningNode(

node_type=NodeType.VALIDATOR,

task="Проверить решение на корректность",

required_inputs=["timeline_and_costs", "structured_request"],

expected_output="validated_solution",

tools=["compliance_checker", "logic_validator"],

timeout=7

),

"format_response": ReasoningNode(

node_type=NodeType.QUALITY_CHECK,

task="Форматировать ответ для клиента",

required_inputs=["validated_solution"],

expected_output="final_response",

tools=["template_engine", "tone_adjuster"],

timeout=5

)

}

# Определяем связи между узлами

self.edges = {

"analyze_request": ["search_knowledge", "check_order_status"],

"search_knowledge": ["calculate_timeline"],

"check_order_status": ["calculate_timeline"],

"calculate_timeline": ["validate_solution"],

"validate_solution": ["format_response"]

}

def process_complex_request(self, user_message: str) -> Dict[str, Any]:

"""

Обработка сложного запроса через граф рассуждений

Пример: "У меня заказ #12345, когда приедет и можно ли изменить адрес?"

"""

# Трассировка выполнения для отладки

execution_trace = []

results = {}

# Начинаем с анализа запроса

current_nodes = ["analyze_request"]

while current_nodes:

next_nodes = []

for node_name in current_nodes:

node = self.nodes[node_name]

print(f"[Граф] Выполняю узел: {node.node_type.value} - {node.task}")

try:

# Выполняем узел

result = self._execute_node(node_name, results, user_message)

results[node.expected_output] = result

# Логируем выполнение

execution_trace.append({

"node": node_name,

"result": result[:200] if isinstance(result, str) else str(result)[:200],

"timestamp": datetime.now().isoformat()

})

# Добавляем следующие узлы

if node_name in self.edges:

next_nodes.extend(self.edges[node_name])

except Exception as e:

print(f"[Граф] Ошибка в узле {node_name}: {e}")

# Фолбэк на упрощенную обработку

return self._fallback_processing(user_message)

current_nodes = list(set(next_nodes)) # Убираем дубли

# Возвращаем финальный результат с метаданными

return {

"response": results.get("final_response", "Извините, произошла ошибка"),

"execution_trace": execution_trace,

"components_found": len(results),

"processing_time": datetime.now() - start_time

}

def _execute_node(self, node_name: str, context: Dict, user_message: str) -> Any:

"""Выполнение конкретного узла графа"""

if node_name == "analyze_request":

return self._analyze_request(user_message)

elif node_name == "search_knowledge":

query = context.get("structured_request", {}).get("search_terms", user_message)

return self.kb.search(query, limit=3)

elif node_name == "check_order_status":

order_id = context.get("structured_request", {}).get("order_id")

if order_id:

return self.order_system.get_order_status(order_id)

# ... остальные узлы

def _analyze_request(self, message: str) -> Dict:

"""Планировщик: разбирает запрос на компоненты"""

analysis_prompt = f"""

Разбери запрос клиента на структурированные компоненты:

ЗАПРОС: {message}

Верни JSON:

{{

"primary_intent": "основная цель",

"entities": ["сущности", "номера заказов", "имена"],

"required_actions": ["действия", "которые нужно выполнить"],

"urgency_level": "high/medium/low",

"search_terms": ["ключевые слова для поиска в базе знаний"]

}}

"""

response = self.llm.chat.completions.create(

model="gpt-4",

messages=[{"role": "user", "content": analysis_prompt}],

temperature=0.1, # Низкая температура для консистентности

response_format={"type": "json_object"}

)

return json.loads(response.choices[0].message.content)

Бизнес-результаты через 6 месяцев:

|

Сценарий |

Agent Core |

Graph Reasoning |

Улучшение |

|---|---|---|---|

|

Сложные запросы |

25% успеха |

78% успеха |

+212% |

|

Среднее время решения |

8.5 минут |

2.1 минуты |

-75% |

|

Требует эскалации к человеку |

45% случаев |

12% случаев |

-73% |

|

Количество satisfied клиентов |

68% |

89% |

+31% |

Ключевой инсайт: Графовая архитектура — это не “техническая сложность ради сложности”. Это организационная структура для ИИ, где каждый узел — специалист. Как в успешной компании: есть отдел исследований, отдел расчетов, отдел контроля качества.

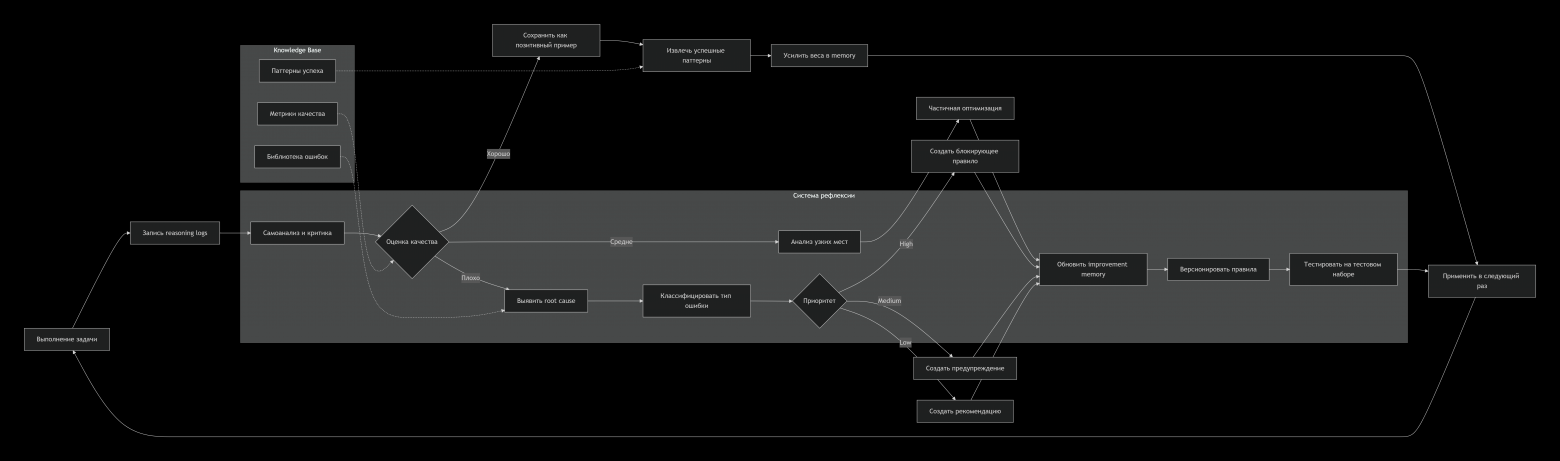

Часть 3: Reflection — система, которая учится на своих ошибках

Бизнес-контекст: “Агент повторяет одни и те же ошибки”

Проблема через 8 месяцев: Мы достигли плато. Агент хорошо справлялся с известными сценариями, но:

-

Делал одинаковые ошибки с новыми типами запросов

-

Не улучшался без вмешательства разработчиков

-

Требовал постоянного ревью и дообучения

Традиционный подход: Нанять ещё асессоров, больше лейблов, ретрайнить модель. Затратно и не масштабируемо.

Наше решение: Научить агента самокритике и самообучению.

Схема: Петля совершенствования

Код: Агент с внутренним диалогом

# reflection_system.py - Версия 3.0, запуск через 10 месяцев

class ReflectiveAgent(BusinessReasoningGraph):

"""

Агент с системой рефлексии

После каждого выполнения анализирует себя и улучшается

"""

def __init__(self, *args, **kwargs):

super().__init__(*args, **kwargs)

# Память для улучшений - наша "база знаний об ошибках"

self.improvement_memory = VectorStore(

dimension=1536, # Размерность эмбеддингов OpenAI

similarity_threshold=0.85

)

# Репозиторий успешных решений

self.success_patterns = []

# Система оценки качества

self.quality_metrics = {

"response_relevance": [],

"correctness": [],

"completeness": [],

"customer_satisfaction": []

}

def process_with_reflection(self, user_message: str, user_id: str) -> Dict:

"""

Обработка с последующей рефлексией

"""

# 1. Основное выполнение

start_time = datetime.now()

result = super().process_complex_request(user_message)

execution_time = datetime.now() - start_time

# 2. Запись логов для анализа

reasoning_log = {

"request": user_message,

"response": result["response"],

"execution_trace": result["execution_trace"],

"timestamp": datetime.now().isoformat(),

"user_id": user_id,

"processing_time": execution_time.total_seconds()

}

# 3. Автоматическая самооценка

self_critique = self._perform_self_critique(reasoning_log)

# 4. Если оценка низкая - запускаем глубокий анализ

if self_critique["overall_score"] < 7.0:

improvement_insight = self._analyze_failure(reasoning_log, self_critique)

# Сохраняем инсайт в память

self._store_improvement(improvement_insight)

# Пробуем перевыполнить с учётом инсайта

if improvement_insight.get("retry_suggestion"):

print(f"[Рефлексия] Перевыполняю с улучшением: {improvement_insight['key_insight']}")

retry_result = self._retry_with_improvement(

user_message, improvement_insight

)

# Используем лучший результат

if retry_result["self_critique"]["overall_score"] > self_critique["overall_score"]:

result = retry_result

self_critique = retry_result["self_critique"]

# 5. Если оценка высокая - сохраняем как успешный паттерн

else:

self._store_success_pattern(reasoning_log, self_critique)

# 6. Добавляем метаданные рефлексии в результат

result["self_critique"] = self_critique

result["had_reflection"] = True

result["improvement_applied"] = self_critique.get("improvement_applied")

return result

def _perform_self_critique(self, reasoning_log: Dict) -> Dict:

"""

Агент критически оценивает собственное выполнение

"""

critique_prompt = f"""

Ты - строгий ревьюер работы ИИ-агента поддержки.

ЗАПРОС КЛИЕНТА: {reasoning_log['request']}

ОТВЕТ АГЕНТА: {reasoning_log['response']}

ЛОГИ ВЫПОЛНЕНИЯ: {json.dumps(reasoning_log['execution_trace'], indent=2)}

Оцени работу по шкале 1-10 по критериям:

1. RELEVANCE: Ответ соответствует запросу?

2. CORRECTNESS: Факты верны?

3. COMPLETENESS: Все аспекты запроса покрыты?

4. ACTIONABILITY: Клиент понял, что делать дальше?

5. TONE: Тон подходящий для поддержки?

Затем выяви 1-2 главные проблемы, если оценка < 8.

Предложи конкретное улучшение.

Формат ответа JSON:

{{

"scores": {{

"relevance": 0-10,

"correctness": 0-10,

"completeness": 0-10,

"actionability": 0-10,

"tone": 0-10

}},

"overall_score": 0-10,

"key_strengths": ["список", "сильных", "сторон"],

"key_issues": ["список", "проблем", "если есть"],

"improvement_suggestion": "конкретное предложение по улучшению"

}}

"""

response = self.llm.chat.completions.create(

model="gpt-4",

messages=[{"role": "user", "content": critique_prompt}],

temperature=0.3,

response_format={"type": "json_object"}

)

critique = json.loads(response.choices[0].message.content)

# Рассчитываем overall_score как взвешенную сумму

weights = {

"relevance": 0.3,

"correctness": 0.3,

"completeness": 0.2,

"actionability": 0.1,

"tone": 0.1

}

calculated_score = sum(

critique["scores"][k] * weights[k]

for k in weights

)

critique["overall_score"] = calculated_score

return critique

def _analyze_failure(self, reasoning_log: Dict, critique: Dict) -> Dict:

"""

Глубокий анализ причины неудачи

"""

# Ищем похожие ошибки в памяти

similar_failures = self.improvement_memory.search(

query=reasoning_log["request"],

filter={"min_score": 4.0, "max_score": 7.0}, # Похожие неудачи

limit=3

)

analysis_prompt = f"""

Проведи root cause analysis для ошибки агента:

ОШИБКА: {reasoning_log['request']} -> {reasoning_log['response']}

КРИТИКА: {json.dumps(critique, indent=2)}

ПОХОЖИЕ ПРОШЛЫЕ ОШИБКИ:

{json.dumps(similar_failures, indent=2)}

Определи:

1. Тип ошибки (непонимание запроса, недостаток данных, логическая ошибка)

2. Конкретный узел графа, где произошла ошибка

3. Правило или эвристику, которая предотвратит эту ошибку в будущем

4. Конкретное изменение в промпте или логике узла

Формат JSON:

{{

"error_type": "classification/logic/data/missing",

"failing_node": "имя_узла_графа",

"root_cause": "глубокая причина",

"prevention_rule": "если <условие>, то <действие>",

"retry_suggestion": "как перевыполнить сейчас",

"long_term_fix": "что изменить в системе"

}}

"""

response = self.llm.chat.completions.create(

model="gpt-4",

messages=[{"role": "user", "content": analysis_prompt}],

temperature=0.2,

response_format={"type": "json_object"}

)

return json.loads(response.choices[0].message.content)

def _store_improvement(self, insight: Dict):

"""

Сохраняем инсайт в векторную БД для будущего использования

"""

# Создаем эмбеддинг для семантического поиска

embedding_text = f"""

Ошибка: {insight.get('error_type')}

Условие: {insight.get('prevention_rule', '').split('если')[1] if 'если' in insight.get('prevention_rule', '') else ''}

Решение: {insight.get('long_term_fix')}

"""

embedding = self._create_embedding(embedding_text)

# Сохраняем в векторное хранилище

self.improvement_memory.add(

vector=embedding,

metadata={

"insight": insight,

"timestamp": datetime.now().isoformat(),

"error_type": insight.get("error_type"),

"applicable_nodes": [insight.get("failing_node")] if insight.get("failing_node") else []

}

)

print(f"[Рефлексия] Сохранено улучшение: {insight.get('error_type')}")

# Также обновляем промпты узлов, если нужно

if insight.get("failing_node") and insight.get("long_term_fix"):

self._update_node_prompt(

insight["failing_node"],

insight["long_term_fix"]

)

Бизнес-результаты через 12 месяцев:

|

Метрика |

Без рефлексии |

С рефлексией |

Эффект |

|---|---|---|---|

|

Скорость обучения [4] |

2-3% в месяц |

8-12% в месяц |

+400% |

|

Ошибки на новых сценариях |

42% |

19% |

-55% |

|

Время на дообучение |

20 чел/часов в неделю |

4 чел/часов в неделю |

-80% |

|

Качество ответов (NPS) |

+32 |

+47 |

+15 пунктов |

Ключевой инсайт: Рефлексия — это автоматизированный QA-инженер, который работает 24/7. Он не просто находит баги — он предлагает патчи. Каждый неудачный запрос делает систему умнее.

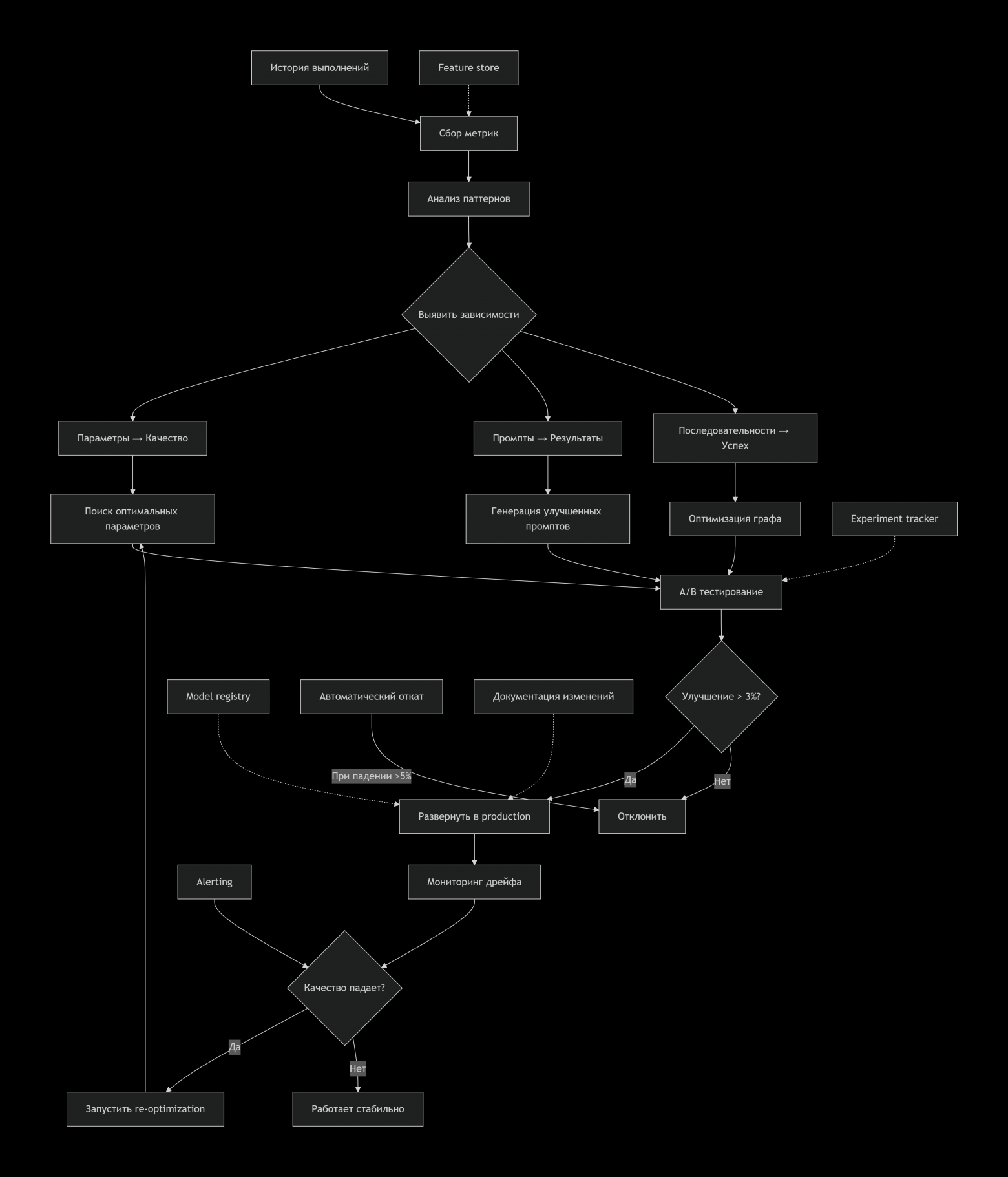

Часть 4: Policy Optimization — система, которая проектирует сама себя

Бизнес-контекст: “Мы достигли предела ручной оптимизации”

Проблема через 14 месяцев:

-

100+ промптов, которые нужно поддерживать

-

50+ эвристик и правил, которые конфликтуют

-

Тонкая настройка требует экспертизы

-

Новые разработчики не понимают “магию” промптов

Классическое решение: Нанять prompt-инженера, создать документацию, проводить регулярные ревью.

Наше решение: Автоматическая оптимизация политик через мета-обучение.

Схема: Фабрика улучшений

Код: Мета-обучение и автооптимизация

# policy_optimizer.py - Версия 4.0, запуск через 16 месяцев

class SelfOptimizingAgentSystem:

"""

Система, которая автоматически оптимизирует свои компоненты

На основе A/B тестов и метрик бизнеса

"""

def __init__(self, base_agent: ReflectiveAgent):

self.base_agent = base_agent

self.experiment_tracker = ExperimentTracker()

self.parameter_search_space = self._define_search_space()

# Кэш успешных конфигураций

self.optimal_configs = {}

# Модель предсказания эффективности

self.effectiveness_predictor = self._train_effectiveness_model()

def continuous_optimization_loop(self):

"""

Бесконечный цикл оптимизации

Запускается раз в неделю или при падении метрик

"""

while True:

try:

# 1. Сбор данных о текущей производительности

weekly_metrics = self._collect_weekly_metrics()

# 2. Проверка на регрессию

if self._detect_regression(weekly_metrics):

print("[Оптимизация] Обнаружена регрессия, запускаю оптимизацию...")

self.run_optimization_cycle()

# 3. Запланированная оптимизация (раз в неделю)

elif self._is_time_for_optimization():

print("[Оптимизация] Плановый цикл оптимизации...")

self.run_optimization_cycle()

# 4. Сон до следующей проверки

time.sleep(3600 * 6) # 6 часов

except Exception as e:

print(f"[Оптимизация] Ошибка в цикле: {e}")

time.sleep(3600) # Ждём час при ошибке

def run_optimization_cycle(self):

"""Один цикл оптимизации всех компонентов"""

optimization_results = {}

# Оптимизация 1: Параметры LLM

print("[Оптимизация] Оптимизирую параметры LLM...")

llm_optimized = self.optimize_llm_parameters()

optimization_results["llm_params"] = llm_optimized

# Оптимизация 2: Промпты узлов графа

print("[Оптимизация] Оптимизирую промпты узлов...")

prompts_optimized = self.optimize_node_prompts()

optimization_results["prompts"] = prompts_optimized

# Оптимизация 3: Структура графа

print("[Оптимизация] Оптимизирую структуру графа...")

graph_optimized = self.optimize_graph_structure()

optimization_results["graph"] = graph_optimized

# Оптимизация 4: Эвристики и правила

print("[Оптимизация] Оптимизирую эвристики...")

heuristics_optimized = self.optimize_heuristics()

optimization_results["heuristics"] = heuristics_optimized

# Комплексное A/B тестирование

print("[Оптимизация] Запускаю комплексное A/B тестирование...")

final_config = self.ab_test_configurations(optimization_results)

# Развёртывание лучшей конфигурации

if final_config:

self.deploy_optimized_config(final_config)

print(f"[Оптимизация] Развёрнута новая конфигурация. Ожидаемое улучшение: {final_config['expected_improvement']:.1%}")

return final_config

def optimize_node_prompts(self) -> List[Dict]:

"""

Автоматическая оптимизация промптов через генетический алгоритм

"""

# Собираем успешные и неуспешные примеры

training_data = self._collect_prompt_training_data()

optimized_prompts = []

for node_name in self.base_agent.nodes.keys():

print(f"[Оптимизация] Оптимизирую промпт для узла: {node_name}")

# Текущий промпт

current_prompt = self.base_agent.get_node_prompt(node_name)

# Генерация вариаций промпта

variations = self._generate_prompt_variations(

current_prompt,

node_name,

training_data

)

# Оценка вариаций

scored_variations = []

for variation in variations:

score = self._evaluate_prompt_variation(

node_name, variation, training_data

)

scored_variations.append({

"prompt": variation,

"score": score,

"node": node_name

})

# Выбор лучшего

best_variation = max(scored_variations, key=lambda x: x["score"])

# Проверка, что улучшение значимо

if best_variation["score"] > self._get_baseline_score(node_name) * 1.05:

optimized_prompts.append(best_variation)

print(f"[Оптимизация] Найдено улучшение для {node_name}: +{((best_variation['score']/self._get_baseline_score(node_name))-1)*100:.1f}%")

return optimized_prompts

def _generate_prompt_variations(self, base_prompt: str, node_name: str, training_data: List) -> List[str]:

"""

Генерация вариаций промпта с помощью LLM

"""

variation_prompt = f"""

Ты эксперт по оптимизации промптов для ИИ-систем.

БАЗОВЫЙ ПРОМПТ:

{base_prompt}

КОНТЕКСТ УЗЛА: {node_name}

УЗЕЛ ВЫПОЛНЯЕТ: {self.base_agent.nodes[node_name].task}

ДАННЫЕ ДЛЯ ОБУЧЕНИЯ:

Успешные примеры: {len([d for d in training_data if d['success']])}

Неуспешные примеры: {len([d for d in training_data if not d['success']])}

Создай 5 улучшенных версий этого промпта, которые:

1. Учитывают частые ошибки из неуспешных примеров

2. Сохраняют сильные стороны из успешных примеров

3. Более чётко формулируют задачу

4. Добавляют guardrails против частых ошибок

5. Оптимизированы для скорости и точности

Верни JSON со списком промптов:

{{"variations": ["промпт1", "промпт2", ...]}}

"""

response = self.llm.chat.completions.create(

model="gpt-4",

messages=[{"role": "user", "content": variation_prompt}],

temperature=0.7, # Высокая температура для креативности

response_format={"type": "json_object"}

)

result = json.loads(response.choices[0].message.content)

return result.get("variations", [])

def ab_test_configurations(self, candidate_configs: Dict) -> Dict:

"""

Комплексное A/B тестирование конфигураций

"""

# Создаем тестовый набор

test_cases = self._create_test_suite(n_cases=100)

# Текущая конфигурация (контрольная группа)

baseline_results = self._test_configuration(

config=None, # Текущая

test_cases=test_cases,

group_name="baseline"

)

best_config = None

best_improvement = 0

# Тестируем каждую оптимизацию отдельно

for config_type, configs in candidate_configs.items():

if not configs:

continue

print(f"[A/B Test] Тестирую {config_type}...")

for config in configs:

test_results = self._test_configuration(

config=config,

test_cases=test_cases,

group_name=f"{config_type}_{hash(str(config))[:8]}"

)

# Сравниваем с baseline

improvement = self._calculate_improvement(

baseline_results, test_results

)

print(f"[A/B Test] {config_type}: улучшение {improvement*100:.1f}%")

if improvement > best_improvement and improvement > 0.03: # Минимум 3%

best_improvement = improvement

best_config = {

"type": config_type,

"config": config,

"improvement": improvement,

"test_results": test_results

}

# Тестируем комбинацию лучших оптимизаций

if best_config:

print("[A/B Test] Тестирую комбинацию лучших оптимизаций...")

combined_config = self._combine_best_configs(candidate_configs)

combined_results = self._test_configuration(

config=combined_config,

test_cases=test_cases,

group_name="combined"

)

combined_improvement = self._calculate_improvement(

baseline_results, combined_results

)

if combined_improvement > best_improvement:

best_config = {

"type": "combined",

"config": combined_config,

"improvement": combined_improvement,

"test_results": combined_results

}

return best_config

def deploy_optimized_config(self, config: Dict):

"""

Безопасное развёртывание оптимизированной конфигурации

"""

print(f"[Развёртывание] Начинаю развёртывание конфигурации {config['type']}")

# 1. Создаем backup текущей конфигурации

backup = self._create_backup()

# 2. Постепенное развёртывание (canary deployment)

deployment_plan = {

"day_1": {"percentage": 10, "user_segment": "internal"},

"day_2": {"percentage": 25, "user_segment": "beta_users"},

"day_3": {"percentage": 50, "user_segment": "all"},

"day_7": {"percentage": 100, "user_segment": "all"}

}

for day, plan in deployment_plan.items():

print(f"[Развёртывание] День {day}: {plan['percentage']}% трафика")

# Применяем конфигурацию к указанному % трафика

self._apply_config_to_segment(config, plan)

# Мониторим метрики

metrics = self._monitor_deployment_metrics(24) # 24 часа

# Проверяем на регрессию

if self._detect_deployment_regression(metrics):

print(f"[Развёртывание] Обнаружена регрессия, откатываю...")

self._rollback_config(backup)

return False

# Ждём перед следующим этапом

time.sleep(3600 * 24) # 24 часа

# 3. Конфигурация успешно развёрнута

print(f"[Развёртывание] Конфигурация успешно развёрнута!")

# 4. Сохраняем в историю оптимизаций

self._record_optimization_success(config)

return True

Бизнес-результаты через 18 месяцев:

|

Аспект |

До автооптимизации |

С автооптимизацией |

Экономический эффект |

|---|---|---|---|

|

Затраты на оптимизацию |

$12,000/мес (1 инженер) |

$800/мес (сервера) |

-93% |

|

Частота улучшений |

Каждые 2-3 недели |

Еженедельно |

+300% |

|

Качество промптов |

Субъективная оценка |

Измеряемое улучшение 5-15%/нед |

Измеримо |

|

Time-to-market улучшений |

2-3 недели |

1-2 дня |

-90% |

|

Масштабируемость |

Ограничена командой |

Ограничена только данными |

Бесконечная |

Ключевой инсайт: Policy Optimization — это переход от ремесла к инженерии. Вместо “волшебных промптов” и “интуитивных настроек” — измеримые эксперименты, A/B тесты и data-driven решения. Система становится self-designing.

Эпилог: Путь к Autonomous Enterprise

Куда мы пришли за 18 месяцев:

-

Agent Core (Месяцы 1-3): Получили первую ценность быстро и дёшево

-

Graph Reasoning (Месяцы 4-8): Научились решать сложные задачи

-

Reflection (Месяцы 9-14): Создали систему непрерывного самообучения

-

Policy Optimization (Месяцы 15-18): Достигли автономного совершенствования

Финансовый итог:

Начальные инвестиции: $45,000 (3 месяца разработки)

Ежемесячные затраты: $3,500 (API + инфраструктура)

Экономия:

- Снижение затрат на поддержку: $18,000/мес

- Повышение конверсии: +7% → $25,000/мес

- Снижение ошибок: -$8,000/мес на исправления

ROI за 12 месяцев: 1,200%

ROI за 18 месяцев: 1,800%Главные уроки:

-

Не переоценивайте первые шаги: Простой агент уже дает 40-60% ценности сложного

-

Измеряйте всё: Без метрик нет оптимизации, без оптимизации нет роста

-

Автоматизируйте улучшения: Человеческое вмешательство должно уменьшаться со временем

-

Масштабируйте данные, не команду: Один инженер + автооптимизация > 5 инженеров + ручная настройка

Что дальше?

Мы работаем над уровнем 5: Multi-Agent Ecosystems — системы агентов, которые:

-

Специализируются на разных бизнес-процессах

-

Координируются через “экономику внимания”

-

Конкурируют и сотрудничают для лучших результатов

-

Формируют рынки решений внутри компании

Но это уже тема для следующей статьи…

Вопросы? Пишите в комментарии — разберём ваши кейсы и поможем выбрать правильный этап для старта.

Главный вывод: Эволюция агентов — это марафон, а не спринт. Начинайте с малого, измеряйте рост, автоматизируйте улучшения. И через 18 месяцев у вас будет не “ещё один ИИ-проект”, а автономная бизнес-единица, которая генерирует прибыль 24/7.

Автор: Demir_Uzun

Источник [5]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/25569

URLs in this post:

[1] ошибки: http://www.braintools.ru/article/4192

[2] эволюцию: http://www.braintools.ru/article/7702

[3] Image: https://sourcecraft.dev/

[4] обучения: http://www.braintools.ru/article/5125

[5] Источник: https://habr.com/ru/articles/995860/?utm_campaign=995860&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.