Почему Code Review тормозит разработку и что с этим делать

Когда я слышу от команд разработки: «У нас всё хорошо с процессами, только вот ревью немного затягивается», — я понимаю, что проблема серьёзнее, чем кажется. «Немного затягивается» обычно означает, что pull request висит в очереди два-три дня, разработчик переключается на другую задачу, а когда приходит фидбек — уже забыл контекст. Потом ещё итерация, ещё одна… И вот уже неделя прошла с момента, как код был готов.

Code Review — один из самых важных этапов разработки. Он помогает ловить баги до продакшена, повышать качество кода. Но парадокс [1] в том, что чем больше растёт команда, тем быстрее ревью превращается в узкое место. И решить это наймом дополнительных сеньоров не получится — проблема глубже.

Меня зовут Артем Герасимов, я владелец продукта SimpleOne SDLC [2]. В этой статье я расскажу, почему ревью кода тормозит разработку, что можно сделать на уровне процессов и как автоматизация с помощью ИИ помогает снять нагрузку с ключевых специалистов.

Code Review как узкое место

Когда в команде пять разработчиков, все друг друга знают, код понятен, и ревью проходит быстро. Но стоит команде вырасти до 15-20 человек, как картина меняется. Чем больше команда, тем больше пулл-реквестов появляется каждый день. Казалось бы, логично [3]: больше людей — больше ревьюеров. Но на деле ревью делают не все. Обычно это делают два-три опытных разработчика, которые понимают архитектуру и могут дать качественный фидбек.

В результате появляется очередь, а очереди на ревью = медленный цикл разработки. А если фича зависит от другой, которая тоже в очереди? Вот и получается, что cycle time растягивается не из-за сложности задачи, а из-за ожидания. Это особенно болезненно, когда нужно быстро отреагировать на запрос бизнеса или исправить критичный баг.

При этом когда ревьюер перегружен, он начинает экономить время. Быстро пробегает глазами, проверяет, что тесты прошли, линтер не ругается — и ставит «approve». Формально процесс соблюдён, но реальной проверки не было. Баги, которые можно было поймать на ревью, уходят в продакшен. Технический долг копится. Команда теряет доверие к процессу: «Зачем вообще этот ревью, если всё равно никто не смотрит?»

Дело в том, что Code Review не должен быть галочкой в процессе. Это инвестиция в качество кода, обмен знаниями и предотвращение проблем. Тем не менее, когда процесс превращается в формальность из-за перегрузки, эта инвестиция не окупается.

Что замедляет ревью на практике

Команды считают, что ревью долгое, потому что пишется много кода, но дело не только в объёме. Есть конкретные факторы, которые превращают ревью в затянутый и болезненный процесс.

Это могут быть большие PR, главный враг качественного ревью. Открываете pull request, смотрите на счётчик: «+1200 строк, -300 строк». Первая мысль — закрыть и вернуться к этому потом. Вторая — пробежать глазами и поставить «LGTM», потому что вникать в такой объём просто нет сил.

Propelcode — The Impact of PR Size on Code Review Quality: What Data Tells Us [4]

Команды, которые регулярно держат PR менее ~400 строк, наблюдают на ~40 % меньше дефектов и ревью проходят в 3× быстрее по сравнению с большими PR.

Человеческий мозг [5] не может удержать в голове контекст изменений на тысячу строк. Ревьюер либо тратит несколько часов (что нереально при текущей загрузке), либо проверяет поверхностно. В обоих случаях страдает качество.

Почему так происходит? Разработчик работал над задачей неделю, накопил изменения в разных частях системы и отправил всё одним PR. Или в задаче изначально не было декомпозиции: «Сделать интеграцию с внешним сервисом» — это и API, и обработка ошибок, и миграции БД, и UI. Ревью затягивается, а когда наконец происходит — половина проблем пропускается просто потому, что их физически не заметили в таком объёме кода.

При чём 60-70% комментариев — это рутинные исправления, стиль и простые ошибки [6], например:

-

«Здесь нужен пробел после запятой»

-

«Используй const вместо let»

-

«Не хватает обработки null»

-

«Имя переменной должно быть в camelCase»

-

«Этот импорт не используется»

Все эти вещи должен ловить линтер, или статический анализатор, или вообще искусственный интеллект [7]. Но почему-то ловит их человек, тратя на это своё время.

Сеньор-разработчик, который мог бы обсуждать архитектурные решения или edge cases, вместо этого вычитывает форматирование. Это не только неэффективно, но и демотивирует: «Я что, корректор текстов?»

А когда нет стандартов, и каждый ревьюер со своими критериями приносит собственные представления о правильном коде, всё может стать ещё сложнее. Для джуниоров это вообще катастрофа, они получают противоречивый фидбек от разных людей и не понимают, какому совету следовать.

В целом, многое в ревью зависит и от человеческого фактора. Code Review — это интеллектуальная работа, требующая концентрации. Но ревьюер — живой человек, и на качество его работы влияет всё: усталость, настроение, количество переключений.

Если в начале дня ревьюер внимательно вчитывается в код, задаёт вопросы, предлагает улучшения, то после плотного обеда просто ставит «approve», потому что сил уже нет. При этом приходится переключаться со своих задач, потратить время, чтобы въехать в чужой код.

Это нормальные проявления человеческой природы, но когда они накладываются на высокую нагрузку и отсутствие процесса, качество ревью страдает критически.

Как ускорить без потери качества

Хорошая новость: проблему медленного Code Review можно решить. Плохая: волшебной кнопки нет. Нужно работать одновременно над процессами и автоматизацией. Разберём, что может помочь.

Договориться важнее, чем автоматизировать

Первое, с чего стоит начать, — это не покупка инструментов автоматизации, а наведение порядка в процессе. Самые эффективные улучшения часто самые простые. Например, можно ввести чек-листы:

|

Чек-листы для авторов PR |

Чек-листы для ревьюеров |

|

Прогнал ли я все тесты локально? Покрыл ли новый код тестами? Описал ли я контекст изменений в описании PR? Разбил ли я коммиты логически, чтобы было понятно, что и зачем менялось? Не слишком ли большой получился PR? Может, его стоит разбить? |

Архитектура: соответствует ли решение общему дизайну системы? Бизнес-логика: правильно ли реализована функциональность, учтены ли edge cases? Безопасность: нет ли уязвимостей, утечек данных, небезопасных операций? Производительность: не создаст ли этот код проблем под нагрузкой? Читаемость: понятен ли код, легко ли его будет поддерживать? |

Маленькие PR как стандарт

Это правило стоит вынести отдельно, потому что оно меняет всё. Маленький PR — это максимум 200-400 строк изменений, решающий одну конкретную задачу.

Swarmia — Why Small Pull Requests Are Better [8]

Анализ практик команд показывает, что небольшие pull request проходят ревью быстрее, снижают когнитивную нагрузку на проверяющего и повышают качество обратной связи.

Да, придётся больше думать о декомпозиции. Да, будет больше отдельных PR. Но каждый из них пройдёт ревью за 10-15 минут. И качество проверки будет выше, потому что ревьюер действительно вникнет в код, а не пробежит глазами.

Автоматизация: отсечь рутину до человека

Когда процесс настроен, пора подключать инструменты. Их задача — взять на себя всё, что не требует человеческого контекста.

Самое важное правило: автоматика проверяет рутину, человек — смысл.

|

Автоматика |

Человек |

|

Линтеры проверяют стиль Статанализаторы ищут типовые баги Тесты подтверждают работоспособность Security scanners ищут уязвимости Coverage tools проверяют покрытие |

Оценивает архитектурные решения Проверяет корректность бизнес-логики Думает об edge cases Оценивает читаемость в контексте проекта Предлагает улучшения |

ИИ как первый уровень ревью

Здесь начинается интересное. Современные AI-модели умеют анализировать код на уровне, который раньше был доступен только человеку. Они находят:

-

Потенциальные баги: null pointer exceptions, race conditions, off-by-one errors

-

Проблемы безопасности: SQL injection, XSS, небезопасное хранение паролей

-

Code smells: дублирование кода, слишком сложные методы, нарушение принципов SOLID

-

Несоответствие best practices конкретного языка или фреймворка

Ключевое отличие ИИ от обычных статанализаторов — он понимает контекст. Может сказать не просто «здесь потенциальная ошибка», а «этот код может упасть с NullPointerException, если параметр user придёт null, что возможно в методе getUserById() на строке 45».

Конечно, важно понимать границы. ИИ не заменяет человека: он не понимает бизнес-контекст вашего проекта, не знает архитектурных решений, принятых год назад, не может оценить, насколько это изменение вписывается в roadmap.

ИИ — это фильтр шума. Он убирает 60-70% рутинных замечаний, которые отвлекают от реальной работы. Финальное решение — мёржить код или нет — всё равно за человеком.

ИИ-ревью в SimpleOne SDLC

Когда мы работали над развитием SimpleOne SDLC [2], то видели, как команды наших клиентов сталкиваются с перегрузкой на Code Review. Очереди на ревью, выгорающие лиды, формальные проверки вместо глубокого анализа — всё это реальные боли [9] растущих продуктовых команд.

SimpleOne SDLC [2] — платформа для управления полным циклом разработки программного обеспечения — от первых идей до выпуска готовых версий продукта.

Мы решили встроить в продукт функциональность, которая поможет автоматизировать первый уровень проверки кода с помощью ИИ. В версии SimpleOne SDLC 1.9.0 появилась интеграция с платформой управления генеративным ИИ Ainergy для автоматизированного ревью кода непосредственно в процессе работы с GitLab.

Что мы добавили

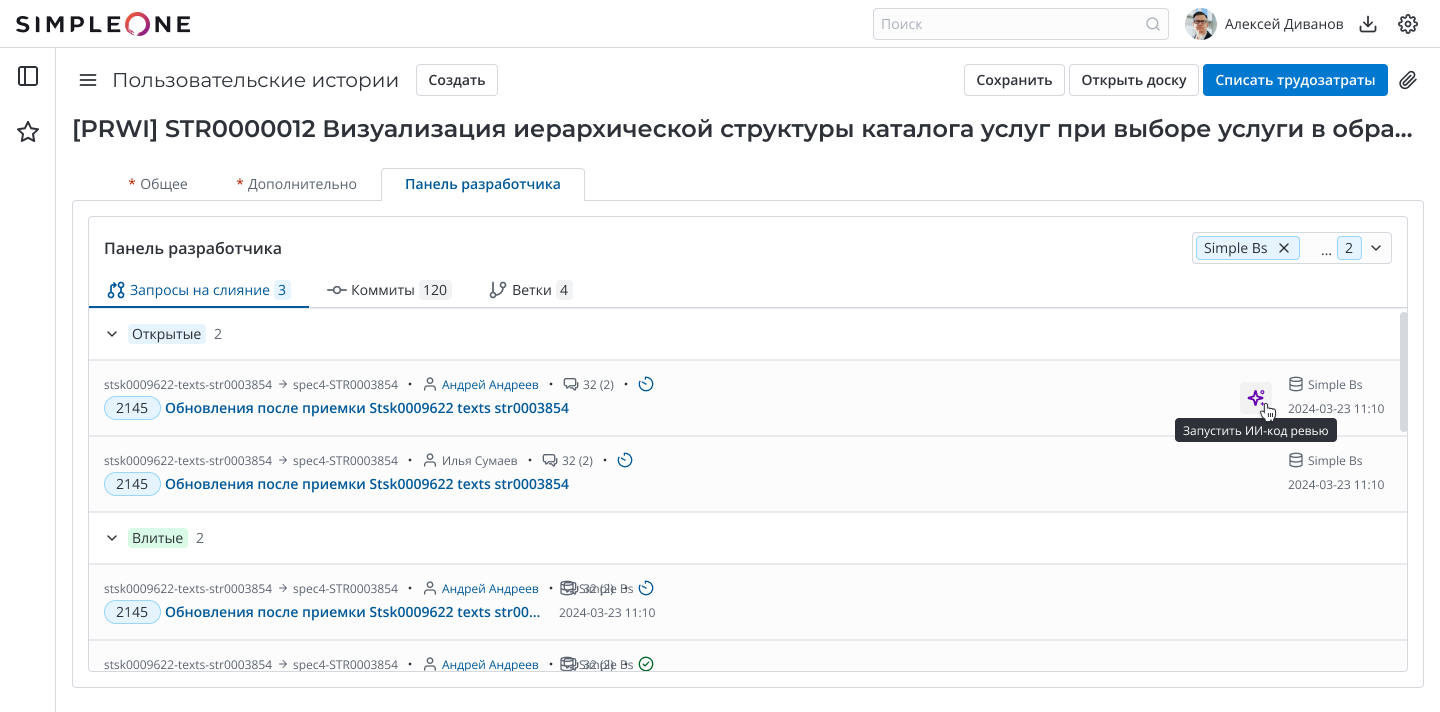

Интеграция работает напрямую с GitLab. Когда в GitLab создаётся или обновляется Merge Request, информация автоматически передаётся в SimpleOne SDLC. Дальше пользователь может запустить ИИ-анализ кода прямо из интерфейса системы — это делается одной кнопкой в карточке задачи.

Важный момент: мы сознательно не сделали полностью автоматический запуск при каждом изменении в MR. Это даёт команде контроль — можно выбирать, когда именно нужна проверка ИИ, не создавая лишнюю нагрузку на систему и не тратя ресурсы на промежуточные коммиты.

Процесс выглядит так:

-

Разработчик создаёт или обновляет Merge Request в GitLab

-

В SimpleOne SDLC автоматически появляется информация об изменениях

-

Пользователь нажимает кнопку «Запустить ИИ-ревью» в интерфейсе SimpleOne

-

Система отправляет код на анализ в Ainergy

-

ИИ проверяет изменения и возвращает комментарии

-

Результаты сразу добавляются в Gitlab, с комментарием к нужной строке в коде, чтобы можно было сразу увидеть, где внести исправления

Весь процесс занимает 2-5 минут. Разработчик получает фидбек, пока контекст задачи ещё свеж в памяти [10], и может оперативно исправить замечания до того, как код увидит человек-ревьюер.

***

Зачем всё это?

ИИ берёт на себя рутинную проверку и фильтрует шум. Лиды и сеньор-разработчики освобождают время для архитектурных решений и наставничества. Time-in-review сокращается, потому что к человеку попадает уже отфильтрованный код с устранёнными типовыми проблемами.

При этом мы не заменяем человека машиной — мы усиливаем процесс. ИИ-ревью — это первая линия защиты, которая отсекает очевидные проблемы и даёт разработчику быструю обратную связь. Финальное решение о качестве кода всё равно остаётся за человеком.

А вы уже используете ИИ в код-ревью?

Автор: SimpleOne_it

Источник [11]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/25596

URLs in this post:

[1] парадокс: http://www.braintools.ru/article/8221

[2] SimpleOne SDLC: https://simpleone.ru/sdlc

[3] логично: http://www.braintools.ru/article/7640

[4] Propelcode — The Impact of PR Size on Code Review Quality: What Data Tells Us: https://www.propelcode.ai/blog/pr-size-impact-code-review-quality-data-study

[5] мозг: http://www.braintools.ru/parts-of-the-brain

[6] ошибки: http://www.braintools.ru/article/4192

[7] интеллект: http://www.braintools.ru/article/7605

[8] Swarmia — Why Small Pull Requests Are Better: https://www.swarmia.com/blog/why-small-pull-requests-are-better/

[9] боли: http://www.braintools.ru/article/9901

[10] памяти: http://www.braintools.ru/article/4140

[11] Источник: https://habr.com/ru/companies/simpleone/articles/995270/?utm_source=habrahabr&utm_medium=rss&utm_campaign=995270

Нажмите здесь для печати.