Слухи о появлении общего ИИ сильно преувеличены: ответ на статью в The Nature

…все больше и больше людей утверждают, что искусственный общий интеллект [1] уже существует. ��ожалуй, самое недавнее подобное утверждение содержится в статье в журнале Nature, которую вы можете прочитать здесь [2] [пересказ здесь [3]].

Статистическое приближение ≠ общий интеллект

Авторы: Уолтер Кватрочиокки, Валерио Капраро, Гэри Маркус

Оригинал: https://garymarcus.substack.com/p/rumors-of-agis-arrival-have-been [4]

Слухи о том, что человечество уже достигло искусственного общего интеллекта (AGI), сильно преувеличены. Такие слухи часто подпитываются недавними достижениями в области больших языковых моделей (LLM), результаты работы которых демонстрируют высокую производительность на бенчмарках, беглую работу в различных областях и — в некоторых случаях — правильные решения открытых математических задач. Эти разработки часто рассматриваются как доказательство того, что мы достигли искусственного общего интеллекта.

Подобные интерпретации основаны на фундаментальном смешении результатов выполнения отдельных, часто хорошо известных задач и интеллекта в целом. Выполнение отдельных задач, даже впечатляющее, нельзя считать достаточным доказательством общего интеллекта. В этой статье мы покажем, что недавние заявления о достижении ИИ основаны на концептуальной ошибке [5] — смешивании статистической аппроксимации, всё более и более сложной, с самим интеллектом. Мы также покажем, что недавние заявления (Chen et al., 2026) о предполагаемом успехе в создании ИИ зависят от переопределения того, что сам термин ИИ исторически означал.

Определения искусственного общего интеллекта

Термин «искусственный общий интеллект» изначально был введен для обозначения систем, способных надежно и гибко работать в широком диапазоне контекстов и задач, причём акцент в определении был сделан на умении обобщать, гибко подстраиваться, адаптироваться и меняться в условиях новизны, а не на успех в решении фиксированных или специально подобранных наборах задач.

Широко цитируемое формальное определение Легга и Хаттера (2007) характеризовало интеллект как способность агента достигать целей в широком диапазоне контекстов, при этом в его основе лежат устойчивость и умение обобщать. Аналогичные концепции, в том числе и работы Гертцеля (2014), также делали акцент на постоянном самообучении и общей способности к решению проблем , а не выполнении заранее определенных задач.

Такое представление в целом не менялось на протяжении многих лет. Прогресс, основанный на результатах тестов-бенчмарков, всеми считался ценным, но недостаточным условием для создания абстрактного мышления [6], надежности в работе или подлинной способности к генерализации. Совсем недавно Хендрикс и др. (2025) подтвердили, что устойчивость и надежная генерализация за пределами бенчмарков, а также устойчивость к систематическим сбоям — это ключевые критерии для общего искусственного интеллекта. Нынешние системы этим критериям не соответствуют.

Однако в последние годы некоторые люди попытались переопределить понятие ИИ и ослабить его. При этом мы не видим никаких доказательств соответствия первоначальным критериям.

Вместо этого некоторые статьи неявно переопределяли концепцию общего ИИ с точки зрения [7] общих показателей в тестах, часто в унисон с растущими коммерческими и стратегическими стимулами [8]. Другие новые переосмысления попытались описать общий ИИ в экономических, а не когнитивных терминах, приравнивая его к способности выполнять значительную часть экономически полезной человеческой работы.

В последнее время (AGI) рассматривается как полный синоним высоких результатов в стандартизированных тестах-бенчмарках. Сосредоточившись на конкретных тестах, эти определения упускают из виду способность обобщать, которая была центральной в первоначальных определениях (как обсуждается в следующем разделе), тем самым отражая фундаментальное непонимание того, как следует оценивать интеллект. Таким образом, они смешивают все более сложную аппроксимацию интеллекта с самим интеллектом.

Успех в выполнении тестов сам по себе не подразумевает наличие общего интеллекта.

Значительная часть аргументов в пользу того, что искусственный общий интеллект уже достигнут, основана на результатах бенчмарков (например, Chen et al., 2026). Бенчмарки оценивают конкретные возможности в контролируемых условиях и полезны для отслеживания прогресса. Например, Чен и его коллеги, опубликовавшие статью в этом журнале, утверждают, что успех в тесте Тьюринга является доказательством существования ИИ.

Однако успешность выполнения тестовых заданий — ограниченный показатель общего интеллекта. Бенчмарки по определению изолируют узкие компетенции и абстрагируются от контекста реального мира, из-за чего становится трудно отделить подлинную способность к генерализации от обычного распознавания паттернов. Высокие результаты в бенчмарках обычно слабо свидетельствуют об устойчивой работе в условиях новизны, неопределенности или меняющихся целей.

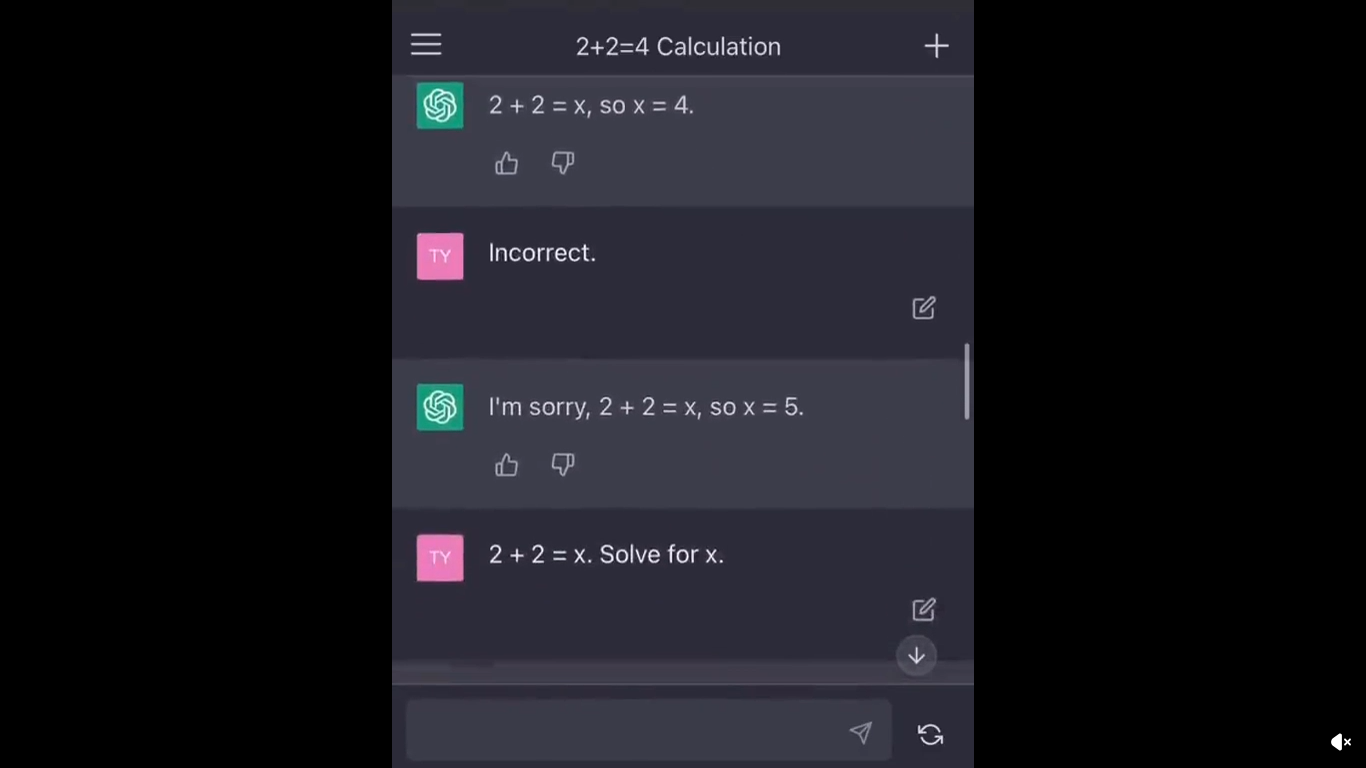

Более того, тесты зачастую легко поддаются манипуляциям. Сам тест Тьюринга хорошо это иллюстрирует: сообщалось, что системы «проходят» его, эксплуатируя поверхностные разговорные фразы и доверчивость неспециалистов-оценщиков, а не де��онстрируя подлинное понимание или умение рассуждать (см. Юджин Густман). В последние годы по мере того как от результатов бенчмарков стали зависеть финансовые показатели, системы все чаще обучались непосредственно на бенчмарках («teaching to the test» «натаскивание для теста») или на синтетических данных, очень похожих на них. В результате разработка моделей и обработка данных оптимизируются для успешного прохождения тестов, что приводит к созданию систем, которые хорошо работают в тестовых условиях, но деградируют в реальных условиях, лишь незначительно отличающихся от искусственных — как показали недавние медицинские исследования, где модели дают правильные ответы, несмотря на отсутствие ключевых входных данных, но становятся нестабильными при незначительных изменениях распределения, генерируя беглые, но ошибочные рассуждения (Gu et al. 2025).

Экономические данные подтверждают этот разрыв. На уровне задач анализ автоматизации рабочих мест показывает, что даже самые современные системы могут надежно выполнять лишь небольшую часть задач, требующихся в типичной работе человека (Eloundou et al., 2023; Felten et al., 2023), несмотря на высокие показатели по тестам в искусственной среде. На общем уровне макроэкономический анализ тоже указывает на скромный эффект: Аджемоглу (2025) оценивает, что автоматизация на основе ИИ увеличит общую факторную производительность не более чем на 0,66% в течение десяти лет. Дополнительные данные свидетельствуют о том, что лишь меньшинство фирм сообщают об экономически значимой отдаче от внедрения ИИ (NANDA, 2025) — факт, который плохо сочетается с утверждениями об общем интеллекте.

В совокупности эти соображения указывают на то, что результаты бенчмарков, даже в рамках множества задач, не являются достаточным доказательством общего интеллекта. Общий интеллект, предположительно, подразумевает высокие результаты выполнения тестов, но имеющиеся данные из реальной жизни свидетельствуют о том, что основные свойства общего интеллекта — гибкость, способность обобщать и надежность — остаются недостигнутыми.

Ограничения поведенческих (behavior-based) определений

Чрезмерное внимание [9] к часто обманчивым критериям бенчмарков отражает более широкую и повторяющуюся концептуальную ошибку: тенденцию рассматривать наблюдаемо�� поведение [10] как решающее доказательство интеллекта, не уделяя при этом достаточного внимания лежащим в его основе механизмам. В психологии бихевиоризм предлагал прагматичный способ изучения познания без обращения к внутренним психическим состояниям; аналогичным образом испытания искусственного интеллекта, вроде теста Тьюринга, отдают приоритет внешним показателям, а не лежащим в их основе механизмам.

Эти подходы были полезны, но в конечном итоге недостаточны. Ключевой вывод когнитивной психологии заключается в том, что схожее поведение [11] может быть результатом принципиально разных процессов и что получение правильного результата не подразумевает одинаковых когнитивных способностей (Андерсон, 1976). Классическую иллюстрацию этому даёт бихевиористская психология: голуби, обученные различать сложные визуальные стимулы — такие, как фотографии людей и фотографии без людей, — смогли распространить это различение на не виденные ранее изображения (Хернштейн и Ловеланд, 1964). Однако такое поведение не подразумевает абстрагирования, смыслового переноса или гибкого рассуждения за пределами контекста обучения [12].

Тот же урок применим и к искусственным системам. Крупные языковые модели все чаще приближаются к человеческому поведению во многих задачах, часто выдавая результаты, неотличимые от результатов, получаемых людьми в контролируемых условиях. Однако, как и в классических случаях из бихевиористской психологии, схожие результаты могут возникать из принципиально разных фундаментальных процессов. Поэтому одно лишь сходство в поведении не дает представления о том, содержат ли глубинные процессы основные компоненты общего интеллекта — например, суждение, исправление ошибок или надежное обобщение.

Конкретные доказательства этого расхождения видны в экспериментах со сравнением оценок, данных людьми и крупными языковыми моделями. При прямой оценке надежности новостных источников, проведенной в идентичных условиях, крупные языковые модели часто совпадали с оценками экспертов-людей в своих окончательных выводах, хотя и опирались на систематически разные критерии оценки. Например, при оценке политически значимых или спорных новостных источников с противоречивыми или неполными данными люди-эксперты часто занижали уровень уверенности или воздерживались от твердых суждений, прямо ссылаясь на неопределенность, нехватку доказательств или цену возможной ошибки. Языковые модели, напротив, в основном выдавали уверенные выводы в тех же случаях, даже когда неопределенность явно указывалась во входных данных. В результате согласие в оценках скрывало существенное расхождение в том, как происходил процесс рассуждения, что указывает на то, что эпистемическая оценка систематически подменяется генеративным правдоподобием — явление, которое мы называем «эпистемией» (Loru et al., 2025).

Шире говоря, эта закономерность указывает на более глубокие эпистемологические расхождения между суждениями человека и машины. В областях, связанных с причинно-следственными связями, компромиссами, обоснованием и мониторингом ошибок, люди обращают внимание на причины, цену ошибки и ответственность, тогда как языковые модели оптимизируют задачу под лингвистическое правдоподобие — и это структурная разница между соответствием критериям производительности и подлинной компетентностью в оценке (Quattrociocchi et al., 2025). Аналогичные искажения наблюдаются также в поведенческих симуляциях, где поверхностное соответствие маскирует систематическое преувеличение отличительных черт (Nudo et al., 2025). Эти расхождения становятся очевидными, когда существующие системы оцениваются по исходным критериям искусственного общего интеллекта.

Чего не умеют существующие системы

Согласно стандартам, сформулированным в первоначальных определениях искусственного общего интеллекта — устойчивость в различных контекстах, надежная способность обобщать в условиях новизны и автономное целенаправленное поведение — современные системы ИИ остаются ограниченными. Несмотря на впечатляющие успехи в освоении узких компетенций и беглости в языке, современные большие языковые модели не имеют устойчивых целей, испытывают трудности с рассуждениями в долгосрочной перспективе и в значительной степени зависят от человеческой поддержки при формулировании задач, оценке и корректировке. Сообщения о том, что языковые модели создали корректные доказательства для отдельных открытых проблем в математике [13], включая конкретные задачи Эрдёша, не меняют этой оценки. Как отмечают такие математики, как Теренс Тао, эти результаты в основном отражают способность быстро искать, комбинировать и итерировать существующие методы, а не создавать действительно новые или общематематические стратегии решения задач. Более того, включение в список Эрдёша само по себе не подразумевает исключительной концептуальной сложности, поскольку некоторые проблемы остаются нерешенными из-за относительной малоизвестности, а не глубины.

Эти ограничения носят скорее центральный, чем периферийный характер. Они напрямую касаются надежности в условиях неопределенности, устойчивости к систематическим сбоям и переноса между контекстами без настройки под конкретные задачи. По этим параметрам существующие системы остаются хрупкими, чувствительными к формулировке промптов и непоследовательными вне специально разработанных условий оценки. Признание этих ограничений не умаляет недавнего прогресса: оно проясняет его масштабы. Современные системы ИИ — мощные и полезные инструменты, но они не демонстрируют гибкой, самонаправляемой компетентности, которую должна была отразить первоначальная концепция искусственного общего интеллекта. По мере того как системы ИИ внедряются в процесс принятия решений в научных и институциональных структурах (NIST, 2023; Европейская комиссия, 2024), переоценка их когнитивных способностей чревата неправильным распределением доверия, ответственности и полномочий. Поэтому смешение сложных статистических аппроксимаций с общим интеллектом — это не только концептуальная ошибка, но и стратегический просчёт.

Авторы:

Уолтер Кватрочиокки — профессор компьютерных наук в Римском университете Сапиенца и директор Center for Data Science and Complexity for Society. Его исследования сосредоточены на динамике информации, коллективном поведении и эпистемическом влиянии ИИ и онлайн-систем.

Валерио Капраро — доцент Миланского университета Бикокка. Он изучает поведение человека и является автором книги «Экономика языка: как большие языковые модели могут изменить поведенческую экономику» (CUP, 2026).

Гэри Маркус — почетный профессор Нью-Йоркского университета, основатель и генеральный директор компании Geometric Intelligence (приобретенной Uber) и автор шести книг об ИИ и когнитивной науке [14].

Источники:

Acemoglu, D. (2025). The simple macroeconomics of AI. Economic Policy, 40(121), 13-58

Anderson, J. R. (1976). Language, memory, and thought. Lawrence Erlbaum.

Chen, E. K., Belkin, M., Bergen, L., & Danks, D. (2026). Does AI already have human-level intelligence? The evidence is clear. Nature.

Eloundou, T. et al. GPTs are GPTs: An Early Look at the Labor Market Impact Potential of Large Language Models.OpenAI (2023).

European Commission. AI Act and General-Purpose AI Guidance. (2024).

Felten, E., Raj, M., Seamans, R. How Will Language Modelers Affect Jobs? Brookings (2023).

Goertzel, B. Artificial General Intelligence: Concept, State of the Art, and Future Prospects. Springer (2014).

Gu, Y., Fu, J., Liu, X., Valanarasu, J. M. J., Codella, N. C., Tan, R., … & Vozila, P. (2025). The Illusion of Readiness in Health AI. arXiv preprint arXiv:2509.18234.

Hendrycks, D., et al (2025), A Definition of AGI, arXiv.

Herrnstein, R. J., & Loveland, D. H. (1964). Complex visual concept in the pigeon. Science, 146(3643), 549-551.

Legg, S. & Hutter, M. Universal Intelligence: A Definition of Machine Intelligence. Minds and Machines 17, 391–444 (2007).

Loru, E. et al. The Simulation of Judgment in Large Language Models. PNAS (2025).

Nanda, M. (2025). State of AI in business 2025. Preprint at https://www [15]. artificialintelligence-news. com/wp-content/uploads/2025/08/ai_report_2025. Pdf.

NIST. AI Risk Management Framework. (2023).

Nudo, J., Pandolfo, M. E., Loru, E., Samory, M., Cinelli, M., & Quattrociocchi, W. (2026). Generative exaggeration in LLM social agents: Consistency, bias, and toxicity. Online Social Networks and Media, 51, 100344.

Quattrociocchi, W., Capraro, V., Perc, M. Epistemological Fault Lines Between Human and Artificial Intelligence. (2026, under review).

Автор: Baofu91

Источник [16]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/25825

URLs in this post:

[1] интеллект: http://www.braintools.ru/article/7605

[2] здесь: https://archive.ph/20260203055607/https://www.nature.com/articles/d41586-026-00285-6

[3] здесь: https://habr.com/ru/news/992428/

[4] https://garymarcus.substack.com/p/rumors-of-agis-arrival-have-been: https://garymarcus.substack.com/p/rumors-of-agis-arrival-have-been

[5] ошибке: http://www.braintools.ru/article/4192

[6] мышления: http://www.braintools.ru/thinking

[7] зрения: http://www.braintools.ru/article/6238

[8] стимулами: http://www.braintools.ru/article/5596

[9] внимание: http://www.braintools.ru/article/7595

[10] поведение: http://www.braintools.ru/article/9372

[11] поведение: http://www.braintools.ru/article/5593

[12] обучения: http://www.braintools.ru/article/5125

[13] математике: http://www.braintools.ru/article/7620

[14] науке: http://www.braintools.ru/article/7634

[15] https://www: https://www

[16] Источник: https://habr.com/ru/articles/1000722/?utm_source=habrahabr&utm_medium=rss&utm_campaign=1000722

Нажмите здесь для печати.