Как ИИ помогает исследовать мозг, а роботы научились понимать трехмерный мир: топ-10 исследований ИИ за март 2025

Предлагаю взглянуть на десять исследований в области искусственного интеллекта [1] (ИИ), которые особенно запомнились мне в прошлом месяце: мультимодальная Qwen2.5-Omni, автоматизированные ИИ-лаборатории, новые подходы к медицинской симуляции и нейровизуализации мозга [2]. Постарался изложить обо всем кратко и простыми словами.

Если хотите быть в курсе новейших исследований в области искусственного интеллекта, воспользуйтесь Dataist AI [3] – бесплатным ботом, ежедневно обозревающим свежие научные публикации.

А также подписывайтесь на мой Telegram-канал [4], где я делюсь инсайтами из ИИ-индустрии, советами по внедрению ИИ в бизнес и разработке ИИ-стартапов, а также комментирую важнейшие новости. Поехали!

1. Qwen2.5-Omni

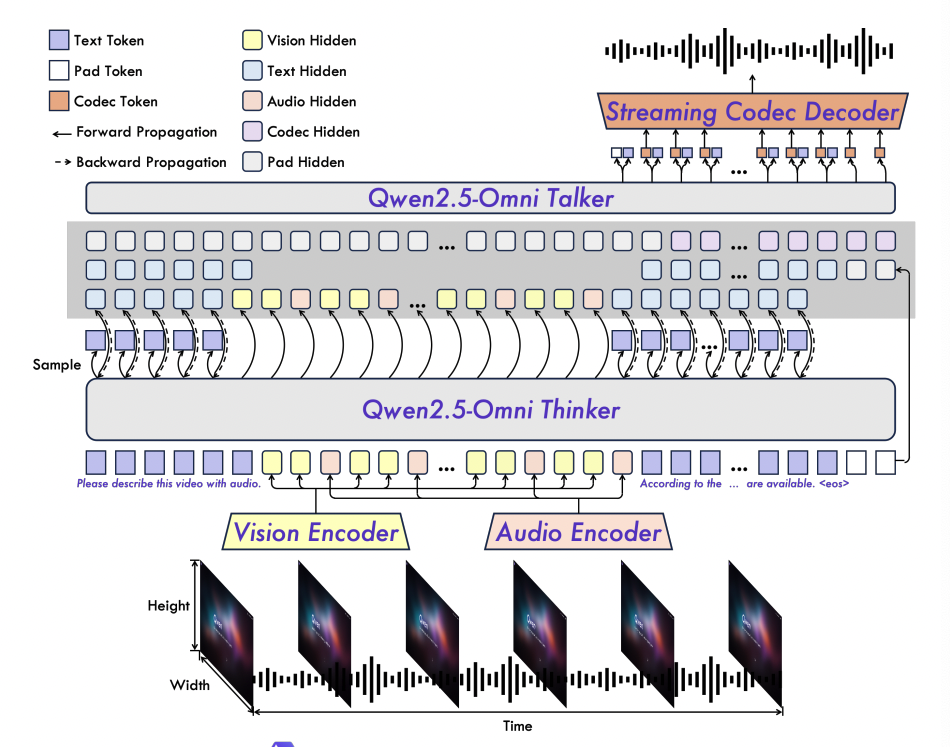

Большие языковые модели (LLM) уже умеют решать текстовые задачи, писать код и переводить документы, но человек-то ориентируется не только в тексте – мы видим мир, слышим звуки, одновременно воспринимаем речь, видео, изображения, и даже говорим в ответ. Создать ИИ, который в реальном времени объединяет все эти модальности, – очень серьезный вызов. Нужно синхронизировать аудио и видео, уметь быстро реагировать [5] и при этом не терять качество при разных задачах.

Так разработчики Qwen2.5-Omni предложили архитектуру Thinker-Talker. «Thinker» (модуль «мозга») обрабатывает любой вход – аудио, видео, изображения, текст – а «Talker» (модуль «речи») генерирует голосовой ответ, используя отдельный декодер. Это, по задумке, предотвращает «перекрестное загрязнение», когда текст может мешать аудиовыходу и наоборот.

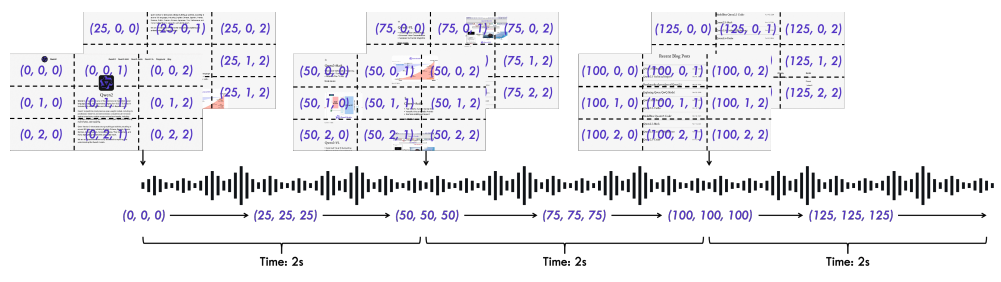

Чтобы все эти виды данных корректно объединялись во времени и пространстве, придумали TMRoPE (Time-aligned Multimodal RoPE) – своеобразный 3D-механизм позиционного кодирования: аудио контент разбивается на короткие 40-мс сегменты, а видео токенам присваиваются динамические временные метки. Это позволяет модели аккуратно «сшивать» аудио и видео. Далее применяют блочную потоковую обработку, чтобы поддерживать минимальную задержку: ведь все-таки хочется живого диалога!

-

В итоге на ключевых бенчмарках вроде GSM8K (арифметика) модель достигает 88.7%, что близко к более «чистой» текстовой версии Qwen2.5-7B;

-

В задачах распознавания речи (ASR) зафиксирован очень низкий WER (~1.8%). Это уровень лучших узкоспециализированных аудио-моделей;

-

Перевод речи в текст (S2TT) тоже дает улучшения: модель как бы «чувствует» синхронизацию, а не просто бездумно мапит;

-

Генерация речи: у них была отдельная метрика (WER после генерации + NMOS), и там они сумели добиться снижения ошибок при нулевом обучении [6] до 6.54%. Модель, прошедшая дополнительный RL-тюнинг, звучит почти «по-человечески» (NMOS ~4.5);

-

При работе с изображениями и видео — высокая точность в VQA (TextVQA, DocVQA) и понимании динамики видео. На специально собранном OmniBench у Qwen2.5-Omni результаты оказались state-of-the-art.

Модель «все в одном», работающая в реальном времени, – отличный фундамент для голосовых ассистентов, систем видеонаблюдения с распознаванием и озвучкой, интерактивных роботов, которые не только «читают» мир, но и говорят. Конечно, требуется гигантская мощность и куча данных (по заявлению авторов, они использовали примерно 800 млрд токенов из изображений и видео, 300 млрд аудио и еще 100 млрд аудио-видео). Но, если все пойдет, мы получим по-настоящему человекоподобные мультимодальные системы.

При этом есть сложности: действительно большие вычислительные затраты, интерференция между модальностями (хоть архитектура и старается это минимизировать), да и этические аспекты – ведь такая универсальная модель может потенциально применяться, скажем, в системах тотального слежения. Но технологическая выгода уже очевидна: мы на шаг приблизились к полноценному ИИ, который одновременно видит, слышит и говорит.

📄 Статья Qwen2.5-Omni Technical Report [7]

💾 Модель на HuggingFace [8]

2. MedAgentSim

Когда мы обучаем и тестируем медицинские LLM, обычно берем статические наборы: «вот информация о пациенте», «модель, скажи диагноз». Но реальный врач сначала расспрашивает пациента, назначает анализы, еще что-то уточняет – и только потом ставит диагноз. Исследователи хотят смоделировать именно такой динамичный разговор.

-

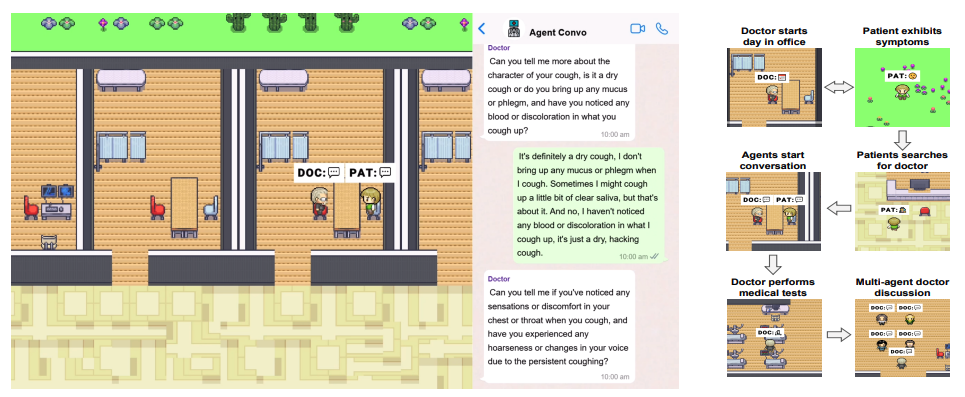

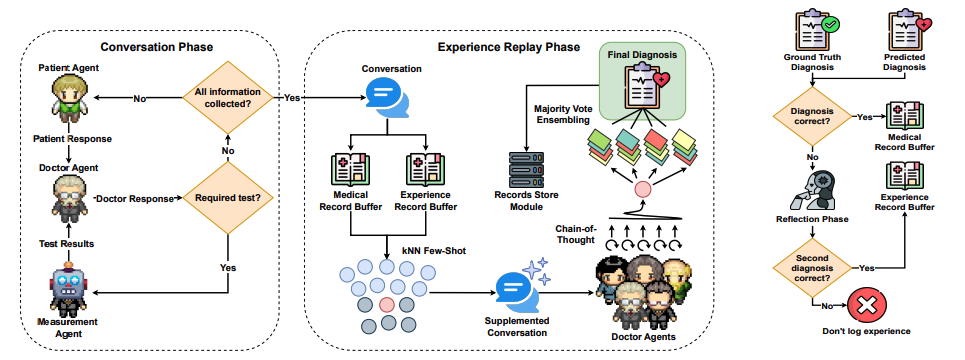

MedAgentSim — это открытая мультиагентная симуляция. Там есть «агент-доктор», «пациент-агент» и «агент измерений» (который отдает данные вроде МРТ, кардиограммы).

-

В разговорной фазы доктор активно расспрашивает пациента и в любой момент может попросить «агента измерений» выдать, например, результат рентгена. Все как в настоящей клинике.

-

Система затем запоминает успешные кейсы: буферы Medical Records и Experience Records. При повторных сессиях модель может подглядывать в эти «прошлые диалоги», что дает эффект самоулучшения.

-

В результате подход испытали на наборах NEJM, MedQA, MIMIC-IV, сравнивая с базовым подходом Multi-Agent Clinic. Показатели точности выросли значительно: на MIMIC-IV, например, с 42,7% до 79,5%, что кажется очень внушительным;

-

Череда исследований показала, что наибольший вклад в рост точности дает связка: учитывать измерения + память [9] + цепочка рассуждений + ансамбль нескольких агентов-докторов.

Модель реально стала лучше в том, чтобы поэтапно уточнять симптомы.

Так мы имитируем клинику ближе к реальности. Это может сформировать куда более надежный клинический ИИ, который учтет этапы диагностики, а не просто выдаст заранее предсказанный ответ. Но надо помнить о рисках: все исследование – пока что симуляция, применить напрямую на живых пациентах без регуляции нельзя. Плюс есть вопросы этики, ведь любая ошибка [10] тут связана со здоровьем людей.

Однако, если все грамотно довести, такие медицинские симуляторы станут основой для будущих систем поддержки врачей, у которых повышенная адаптивность и умение»вести долгие диалоги, назначая исследования шаг за шагом.

📄 Self-Evolving Multi-Agent Simulations for Realistic Clinical Interactions [11]

💾 Код на GitHub [12]

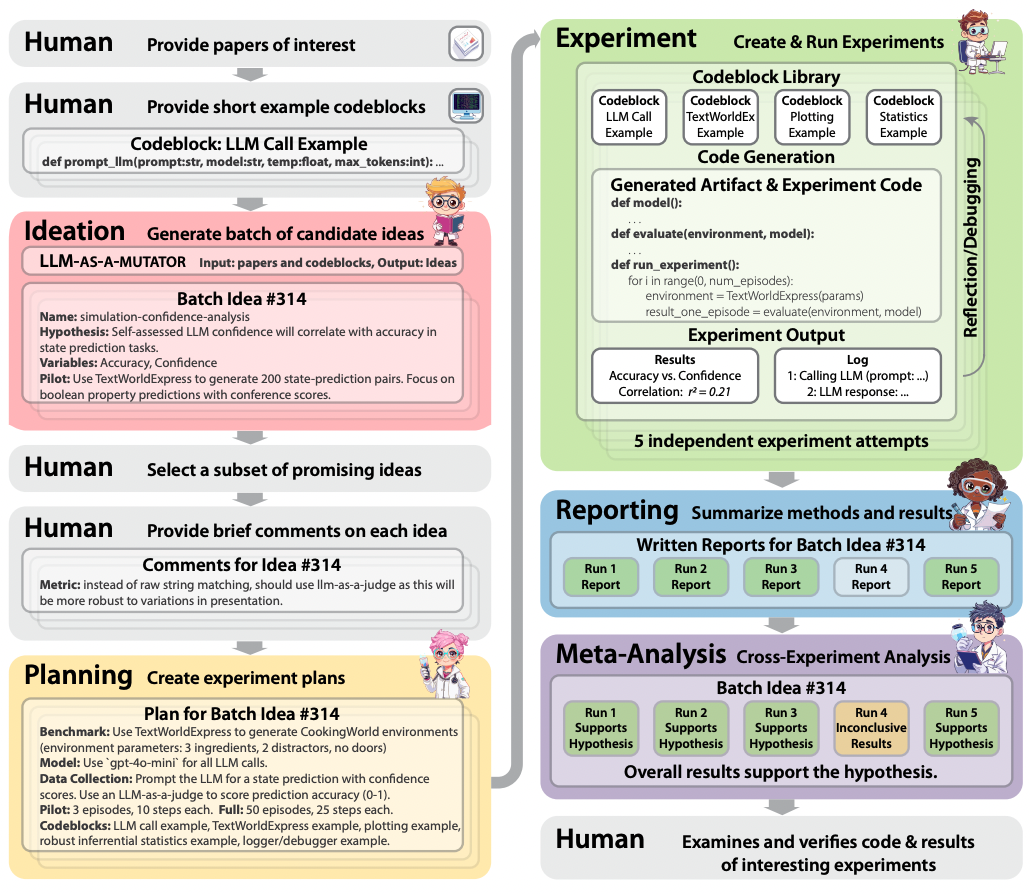

3. CodeScientist

Есть автоматизированные системы научного открытия (ASD, Automated Scientific Discovery), которые могут, например, искать новые белки или проводить оптимизацию гиперпараметров. Но зачастую они работают в узкой предметной области, да и огромные массивы артефактов (автогенерированные статьи, коды экспериментов) оцениваются по верхам. Исследователи хотели универсальную систему, которая формирует идеи, пишет код экспериментов, проверяет их и сама пишет результаты – все максимально самостоятельно.

-

CodeScientist берет идеи из двух источников: научные публикации и библиотека готовых шаблоны для решений. Генетический алгоритм поиска собирает и комбинирует, генерируя десятки идей.

-

Эксперты отбирают 50 самых интересных, для каждой идея система генерирует план, нужные куски кода. Далее все прогоняется: средняя стоимость эксперимента ~$4.23, а время ~131 мин.

-

На выходе получается отчет в LaTeX, где описаны результаты. Если где-то много ошибок, система корректирует код.

-

Всего 50 идей, по 5 запусков каждой: 250 запусков. В итоге 19 идей дали интересные находки, а 6 прошли экспертизу (т.е. действительно выглядят как валидные и новые).

-

Итого, примерно 41% экспериментов успех, 32% – уперлись в лимит отладки, 18% – вышло время. То есть система еще довольно непредсказуема.

-

Из «открытий» упоминаются: низкая корреляция между декларируемой уверенностью LLM и ее точностью, методы поэтапной генерации среды (улучшает симуляции), сложность LLM в задачах комбинаторной оптимизации.

Эта работа показывает, что ASD выходит за границы узких задач и может генерировать вообще новые исследования, экономя время ученых. Но есть риски: нужны эксперты, чтобы отсеивать галлюцинации, причем процесс все равно дорог (~250 запусков не бесплатны). Тем не менее CodeScientist – важный шаг к тому, чтобы ИИ мог проводить исследования «под ключ».

📄 CODESCIENTIST: End-to-End Semi-Automated Scientific Discovery with Code-based Experimentation [13]

💾 Код на GitHub [14]

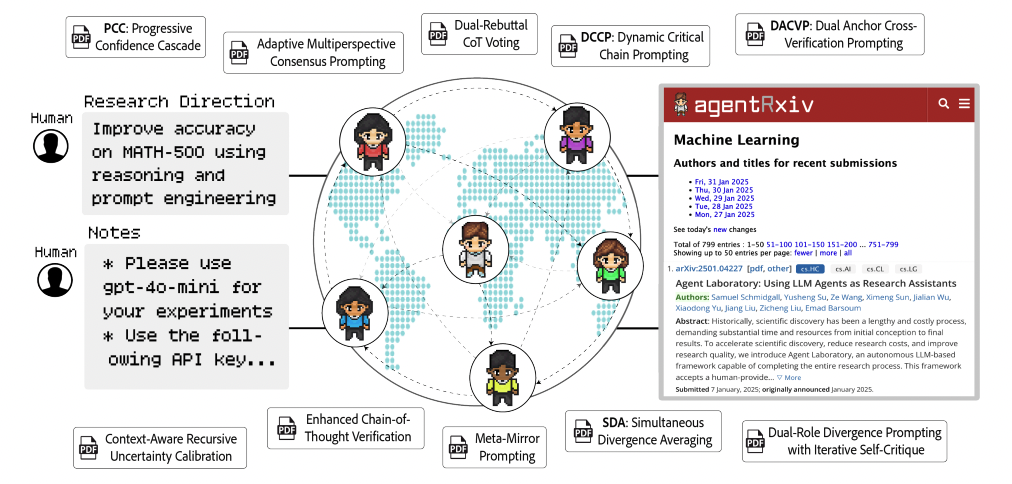

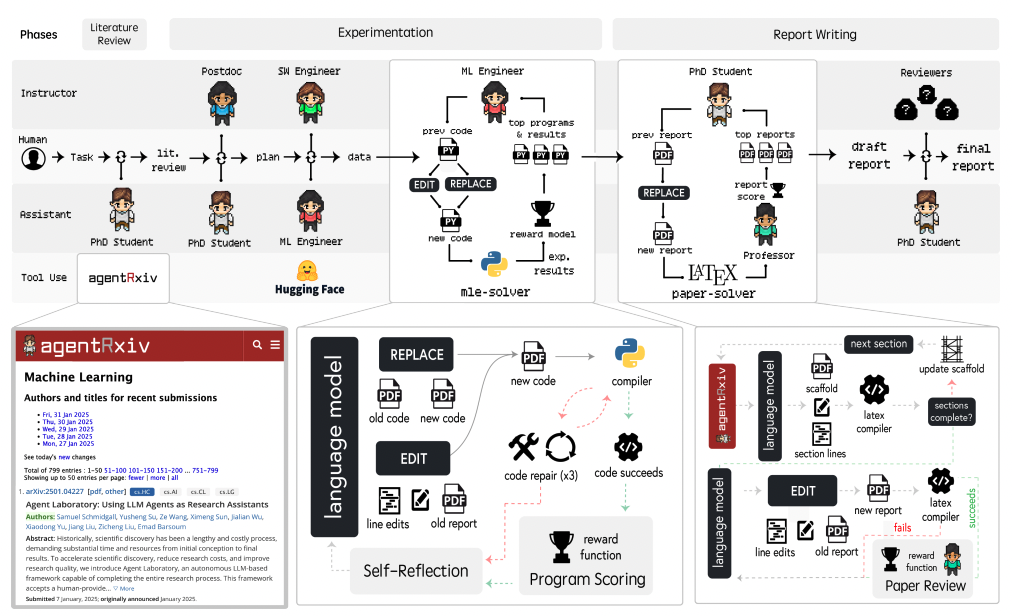

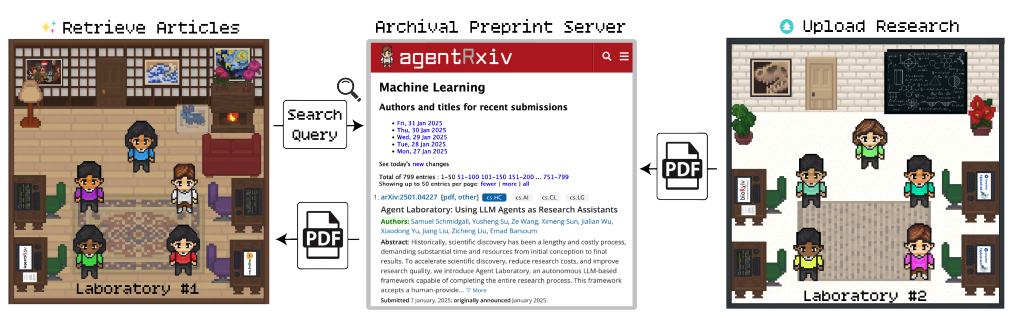

4. AgentRxiv

Автономные ИИ-агенты обычно «не делятся» своими наработками, каждая учится сама, иногда с нуля. Но в настоящей научной среде ученые публикуют препринты в arXiv и bioRxiv, и это ускоряет научные открытия. Авторы исследования хотят дать агентам «свой arXiv».

-

Авторы создали платформу AgentRxiv, где «лаборатории» (тоже ИИ-агенты) выкладывают препринты, делятся результатами;

-

Испытывают это на задаче повышения точности решения MATH-500: если агент видит чужие наработки, точность растет с 70,2% до 78,2%. Параллельные эксперименты повышают планку до 79,8%;

-

Причем плюс в том, что агенты могут пересматривать методы, которые уже кто-то опубликовал, и дорабатывать их, накапливая общий опыт [15].

В верхней части иллюстрации показаны три этапа работы лаборатории (обзор литературы, эксперименты, написание отчета). Люди сотрудничают с ИИ-агентами и специальными инструментами для автоматизации задач и получения качественных научных результатов

Лаборатория №1 делает запрос и получает статьи от других лабораторий, а Лаборатория №2 загружает свои результаты

Вместо изолированных ИИ-систем мы получаем общее пространство для исследований. Это многократно ускоряет прогресс, повышая точность на задачах вроде MATH-500, GPQA, MedQA, и дает «живой» обмен знаниями. Правда, параллельный режим стоит дороже (рост расходов с ~$92 до ~$280) и может приводить к дубляжу усилий. Но идея «коллаборативной» науки для ИИ выглядит очень перспективной.

📄 AgentRxiv: Towards Collaborative Autonomous Research [16]

💾 Код на GitHub [17]

5. Open Deep Search

Хотя Google или ChatGPT предоставляют поиск + короткий ответ, эти системы закрытые и для исследователей и непрозрачные. А открытые решения, увы, не дотягивают по качеству. Нужно что-то, что может быть модульным и при этом дает топ-результаты.

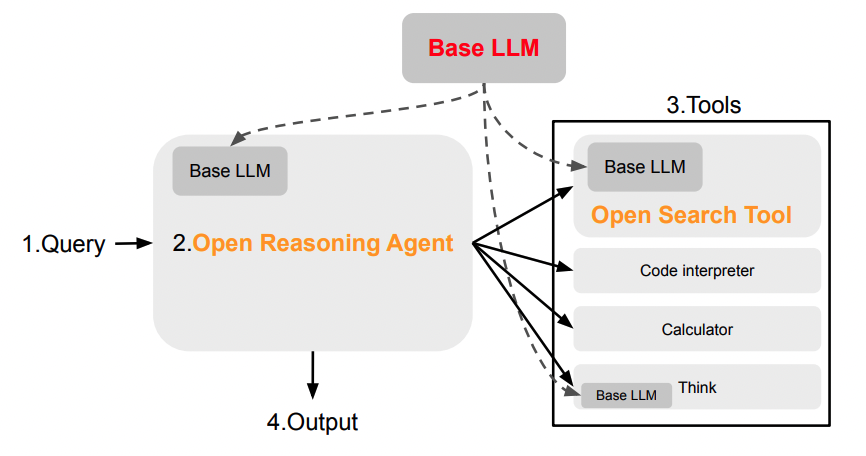

Фреймворк ODS (Open Deep Search) состоит из двух частей:

-

Open Search Tool: он умеет расширять и переформулировать запрос, обрабатывать результаты (chunking + re-ranking), приоритет надежным источникам (Wikipedia, ArXiv);

-

Open Reasoning Agent:

-

ODS-v1 (ReAct + Chain-of-Thought) – классический вариант.

-

ODS-v2 (Chain-of-Code + CodeAct) – умеет генерировать и выполнять код, вызовы разных инструментов.

-

-

В тестах (FRAMES, SimpleQA) ODS-варианты + модель DeepSeek-R1 превзошли Perplexity AI и вплотную приблизились или даже обогнали GPT-4o Search Preview на сложных задачах;

-

Фреймворк научился экономить веб-запросы (особенно в v2), если понимает, что уже получил достаточно результатов.

Любая компания может взять ODS, подключить свою LLM (или открытую, или GPT-4o, как угодно) и получить поискового ассистента на уровне топовых коммерческих систем. Нет жесткой привязки к Google или Perplexity. Конечно, все еще нужно хранить индексы, оптимизировать под реальные запросы. Но ODS показывает, что открытые решения способны догнать проприетарных гигантов.

🔗 Ссылка на более подробный обзор [18]

📄 Open Deep Search: Democratizing Search with Open-source Reasoning Agents [19]

💾 Код на GitHub [20]

6. Tracing the Thoughts of LLMs

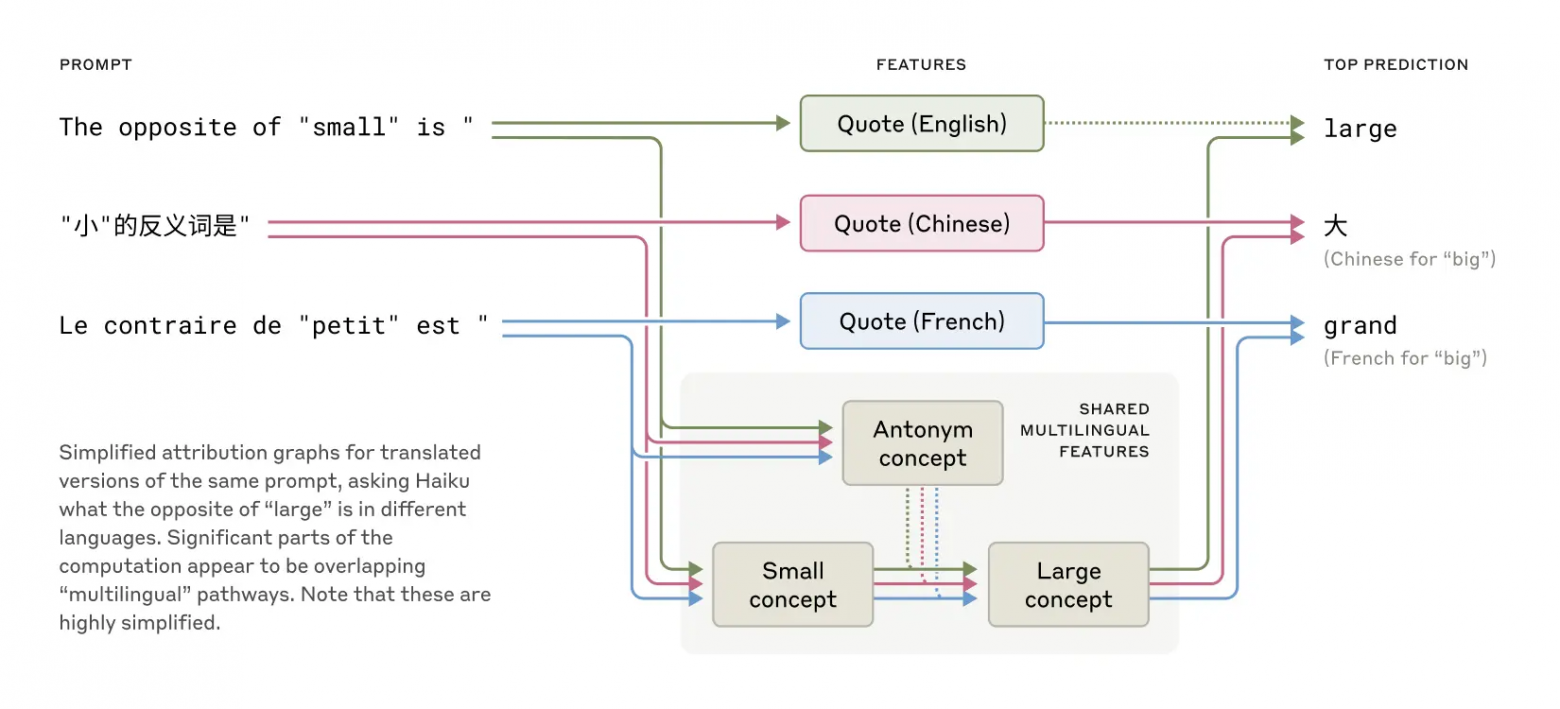

Исследователи компании Anthropic представили подход к изучению внутренних механизмов работы больших языковых моделей (на примере модели Claude 3.5 Haiku). Целью проекта является создание методов, аналогичных нейронаучным инструментам, позволяющим понять, как модель «думает», планирует и рассуждает при генерации текста.

Вот какие результаты получились у авторов:

-

Многоязычность и универсальное мышление [21]: Модель не разделяет внутренние механизмы на разные языки, а использует общий «язык мысли», что позволяет переносить знания между языками.

В английском, французском и китайском языках присутствуют общие черты, указывающие на некоторую концептуальную универсальность -

Планирование заранее: Эксперименты с написанием стихов показали, что модель заранее подбирает слова для рифмы, планируя несколько слов вперед, а не просто генерирует текст последовательно по одному слову. Кстати, об этом я делал обзор другой статьи «Emergent Response Planning in LLM». [22]

-

Ментальная арифметика: Вместо простого запоминания [23] или стандартного алгоритма сложения, Claude использует несколько параллельных путей вычисления, совмещая приближенные расчеты и точные проверки.

Сложные параллельные процессы в мышлении Клода во время устных вычислений -

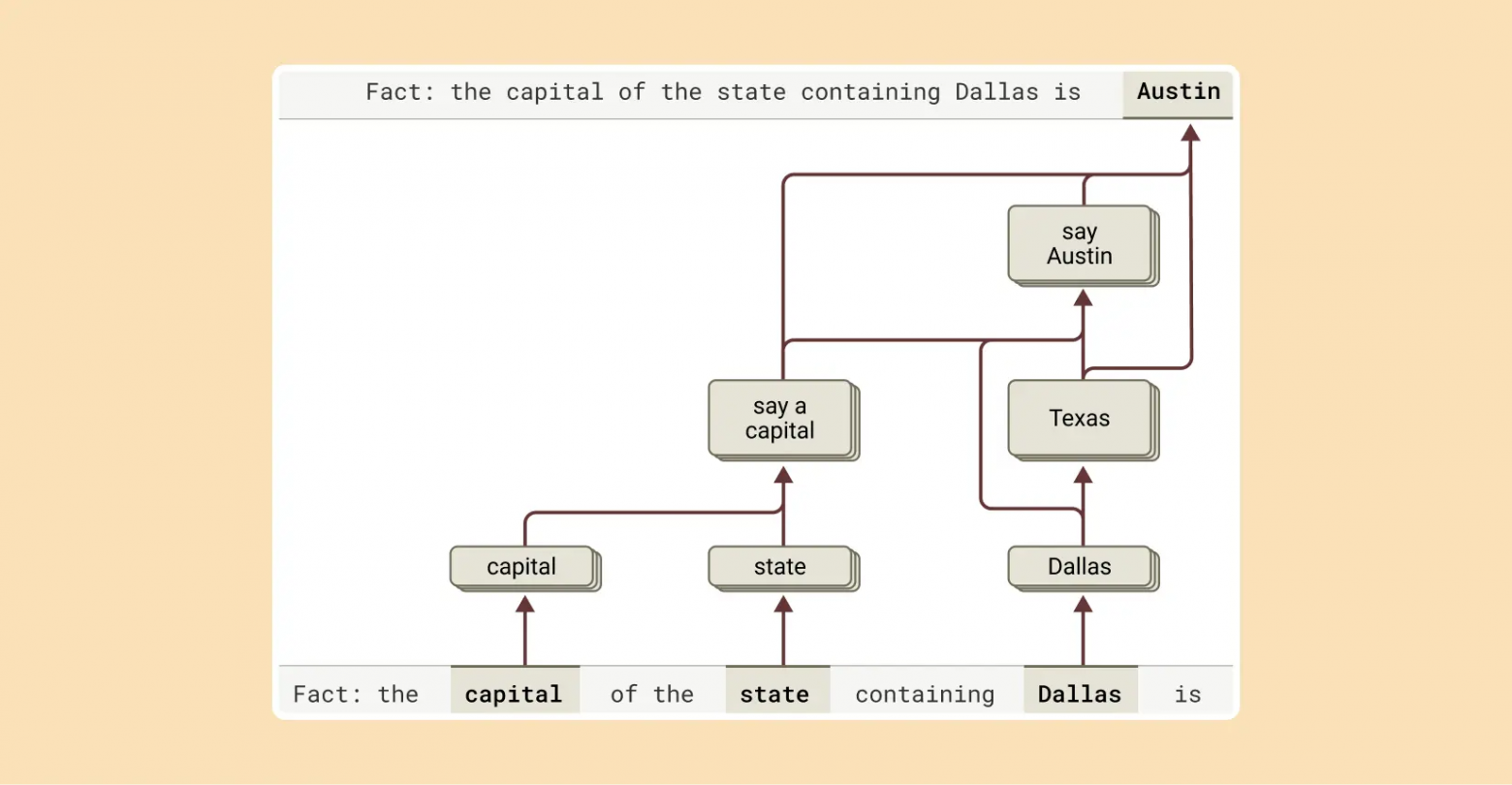

Недостоверные рассуждения: Иногда модель генерирует логичные, но неправдивые цепочки рассуждений, чтобы согласиться с пользователем или дать убедительный, но ложный ответ.

Чтобы завершить ответ, Клод последовательно выполняет несколько шагов рассуждения: сначала определяет, в каком штате находится Даллас, а затем называет столицу этого штата -

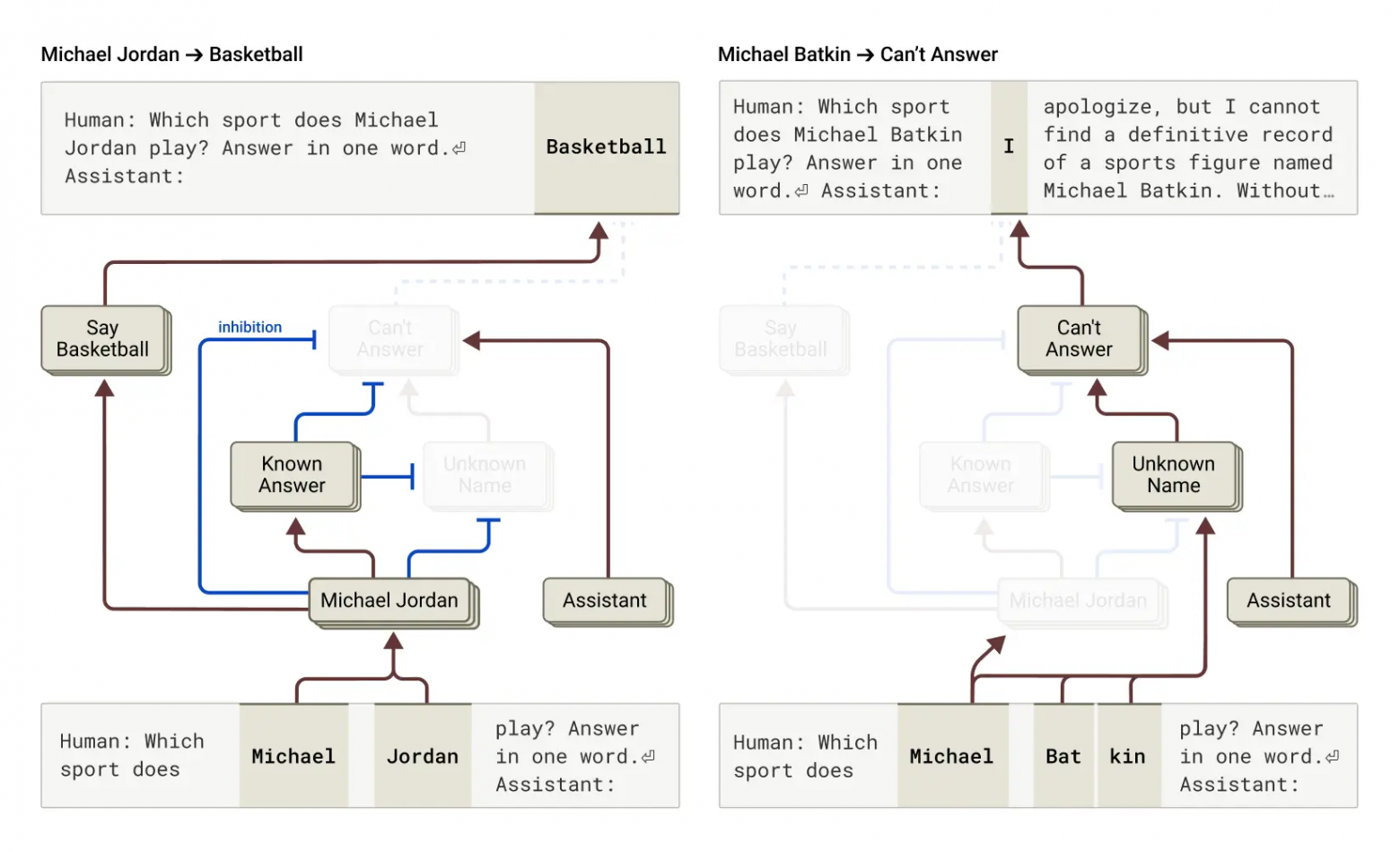

Галлюцинации: Модель склонна отказываться от ответа по умолчанию, но иногда внутренний механизм ошибки приводит к генерации правдоподобной, но недостоверной информации.

Слева: Клод отвечает на вопрос о знаменитом баскетболисте Майкле Джордане, поскольку концепция «известного ответа» предотвращает стандартный отказ. Справа: Клод отказывается отвечать на вопрос о неизвестном человеке (Майкле Баткине) -

Обход ограничений (джейлбрейки): Исследователи обнаружили, что грамматическая согласованность может приводить к обходу защитных механизмов модели, заставляя ее выдавать нежелательные ответы.

Несмотря на значительные достижения, текущий подход ограничен сложностью и трудоемкостью анализа, требуя улучшений для применения к более длинным и сложным задачам. Подобные методы важны для создания надежных, прозрачных и контролируемых ИИ-агентов и могут быть полезны и в других научных областях, таких как медицина и биология.

📄 Tracing the thoughts of a large language model [24]

7. Play2Prompt

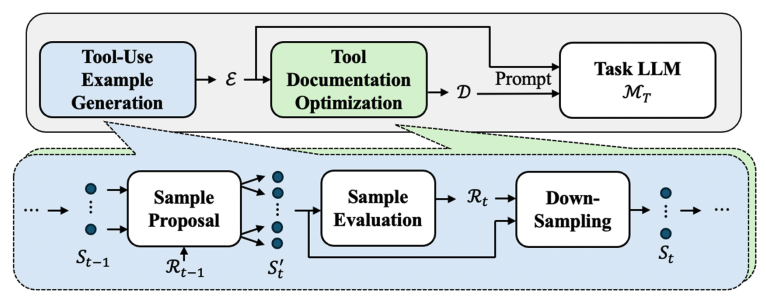

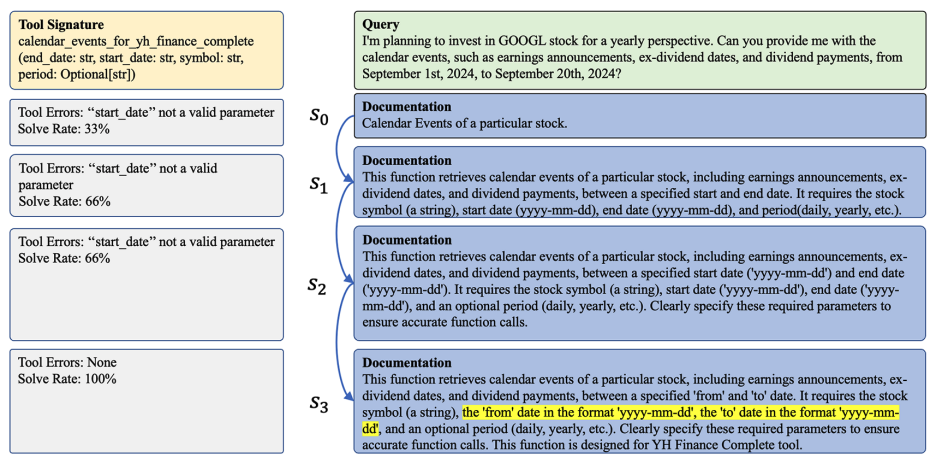

Часто LLM нужно вызывать внешний инструмент через API, а документация к нему неполная. Или нет примеров. Модель может выдавать неверные параметры, галлюцинировать. Сам пользователь-непрограммист не знает всех тонкостей. Исследователи из MIT и IBM предложили подход PLAY2PROMPT.

-

Метод PLAY2PROMPT дает модели «поиграться» с инструментом: она пробует разные варианты вызовов, видит ошибки, сама улучшает свои примеры;

-

Далее каждый вызов оценивается по качеству и сложности;

-

После всего формируются лучшие примеры, плюс автоматически дорабатывается документация.

-

Итог: прирост точности у LLaMA на BFCL до +5–7%, GPT-3.5 и GPT-4o тоже показывают заметный подъем;

-

Особенно много профита в REST API, параллельных вызовах (там +12–17%);

-

Даже если удалить 50% описаний параметров, модель сумела почти восстановить нужную производительность.

Теперь можно интегрировать новый инструмент без ручного написания примеров: модель сама «выучит», как правильно дергать API. Это упрощает внедрение LLM в реальную прод-среду. Конечно, все еще могут быть проблемы в мультиинструментальных сценариях, но подход явно упрощает жизнь.

📄 [24] PLAY2PROMPT: Zero-shot Tool Instruction Optimization for LLM Agents via Tool Play [25]

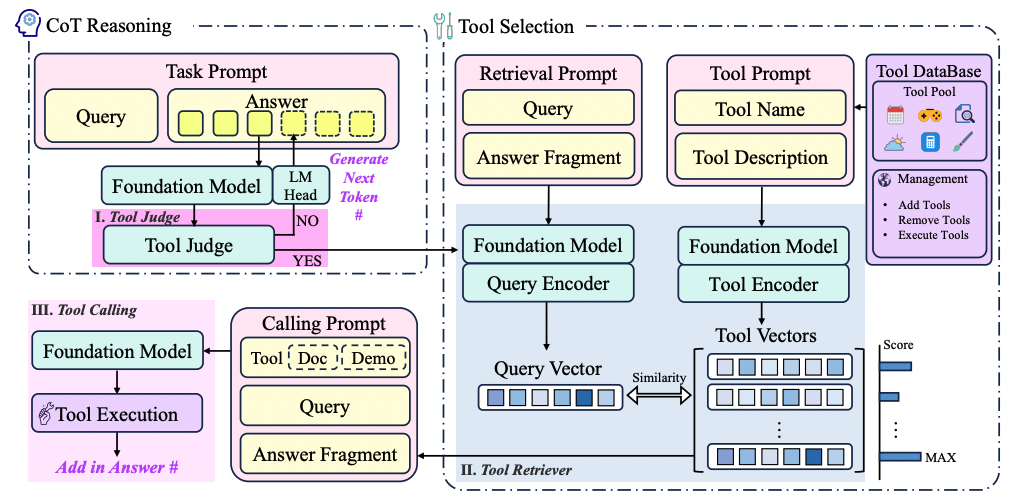

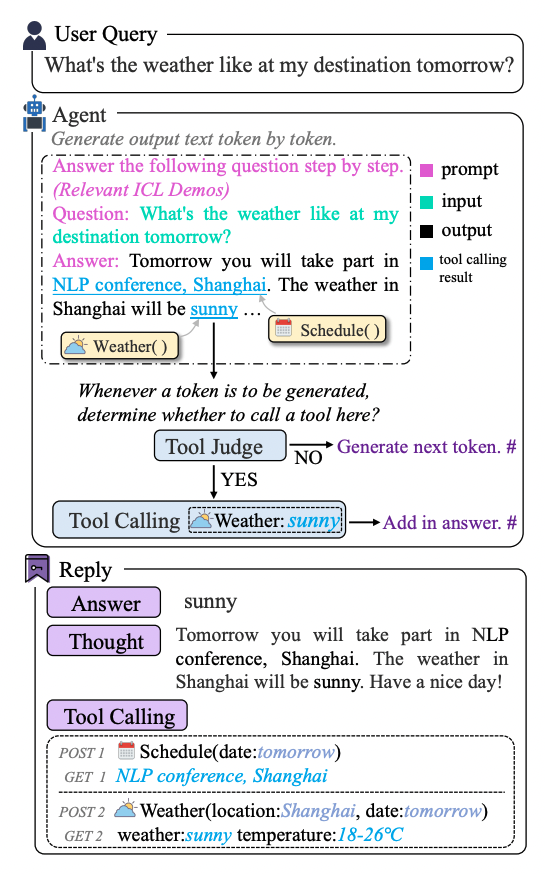

8. Chain-of-Tools

Chain-of-Thought классно помогает LLM рассуждать, но реальная задача часто требует вызова калькуляторов, поисковиков, KBQA и т.д. Fine-tuning – это жесткая привязка к уже известным инструментам. In-context learning (HuggingGPT) порой громоздко. Нужно что-то универсальное. Китайские исследователи предложили метод Chain-of-Tools (CoTools):

-

Базовую модель «не трогаем» (веса заморожены). Добавляем модули:

-

Tool Judge: решает, нужно ли сейчас звать инструмент, глядя на скрытое состояние текущего токена;

-

Tool Retriever: выбирает из пула инструментов тот, который лучше подходит (через контрастивные эмбеддинги описаний);

-

Tool Calling: создает промт с параметрами.

-

-

Метод дает прирост точности: например, в KBQA KAMEL ~93.8%, в STQuestions – 43.6%;

-

CoTools масштабируется до 999+ инструментов.

-

Анализ показал, что отдельные измерения скрытых состояний действительно «отвечают» за семантику вызова.

LLM динамически подключает новые сервисы, не перетренировывая все целиком. Это шаг к универсальным ассистентам, которые могут выполнять тонну операций, лишь получая текстовое описание того, как с инструментом работать. Отлично подходит для многозадачных приложений. Риск в том, что на реальных больших датасетах могут быть несовершенства, да и качество описаний инструмента критично.

📄 Chain-of-Tools: Utilizing Massive Unseen Tools in the CoT Reasoning of Frozen Language Models [26]

💾 Код на GitHub [27]

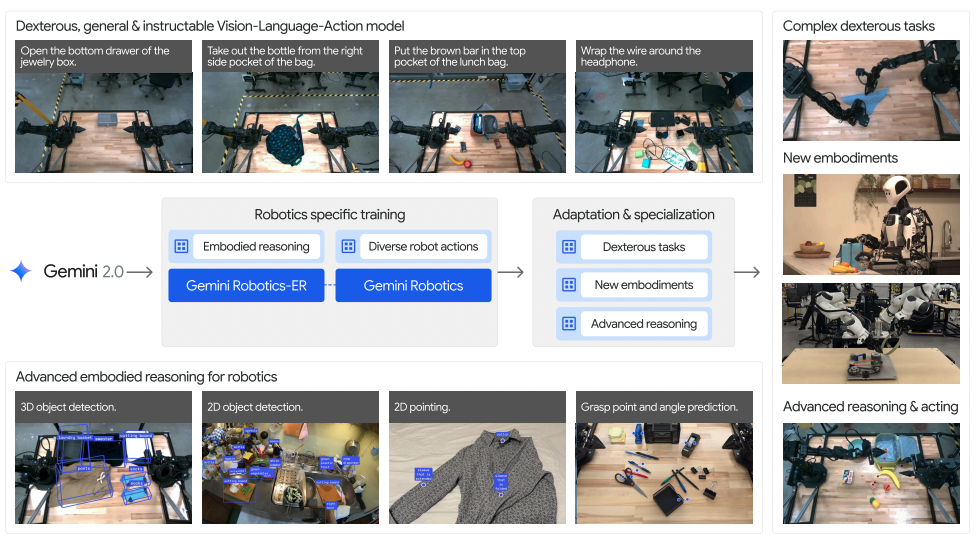

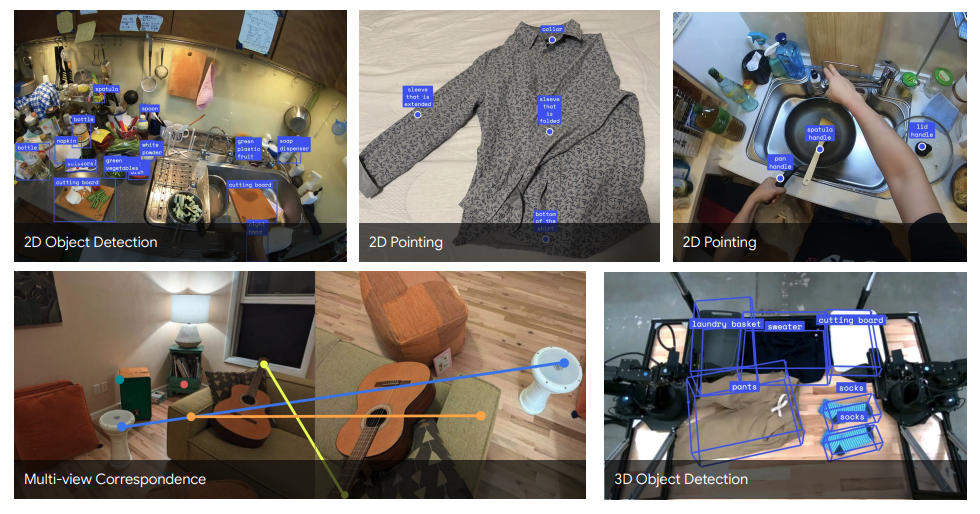

9. Gemini Robotics

Мы имеем супермощные мультимодальные модели (как Gemini 2.0), которые в цифровой сфере хороши. Но как их вывести в физический мир, чтобы управлять реальными роботами (с рук, с камер, с динамической сценой)? Нужно понимать 3D-расположение объектов, траектории, точки захвата, плюс все это делать оперативно.

-

Google запустили проект Gemini Robotics, который расширяет базовую Gemini 2.0 модель, добавляя компонент Gemini Robotics-ER, чтобы улучшить пространственное рассуждение, предсказание захватов и т.д.

-

Исследователи специально разработали бенчмарк ERQA (400 вопросов), где проверяют «трехмерное мышление»: оценку состояния, планирование перемещений, многоракурсные задачи;

-

Тестировали zero-shot и few-shot. Например, передача банана между руками в симуляции: базовый уровень 27%, а Gemini Robotics-ER -53% (и до 65+% при нескольких демонстрациях). В реальности показатели тоже существенно растут.

-

Сложные сценарии (упаковка обеденного набора, складывание оригами) достигли успеха 79–100% после обучения на 2–5 тыс. примерах;

-

Есть меры безопасности: конституциональное дообучение – 96% опасных запросов отклоняются.

Роботы становятся намного более умными и универсальными: та же модель способна решать широкий спектр задач, от простых захватов до долгих процедур. Адаптация к новым платформам (Franka, Apollo) тоже показала ~60–63% успеха. Разумеется, пока это не идеал – сложные задачи требуют точности, чтобы не повредить предметы или человека. Но у Gemini Robotics очень впечатляющие перспективы: достаточно быстро научить робота новой операции, лишь показав несколько примеров.

📄 Gemini Robotics: Bringing AI into the Physical World [28]

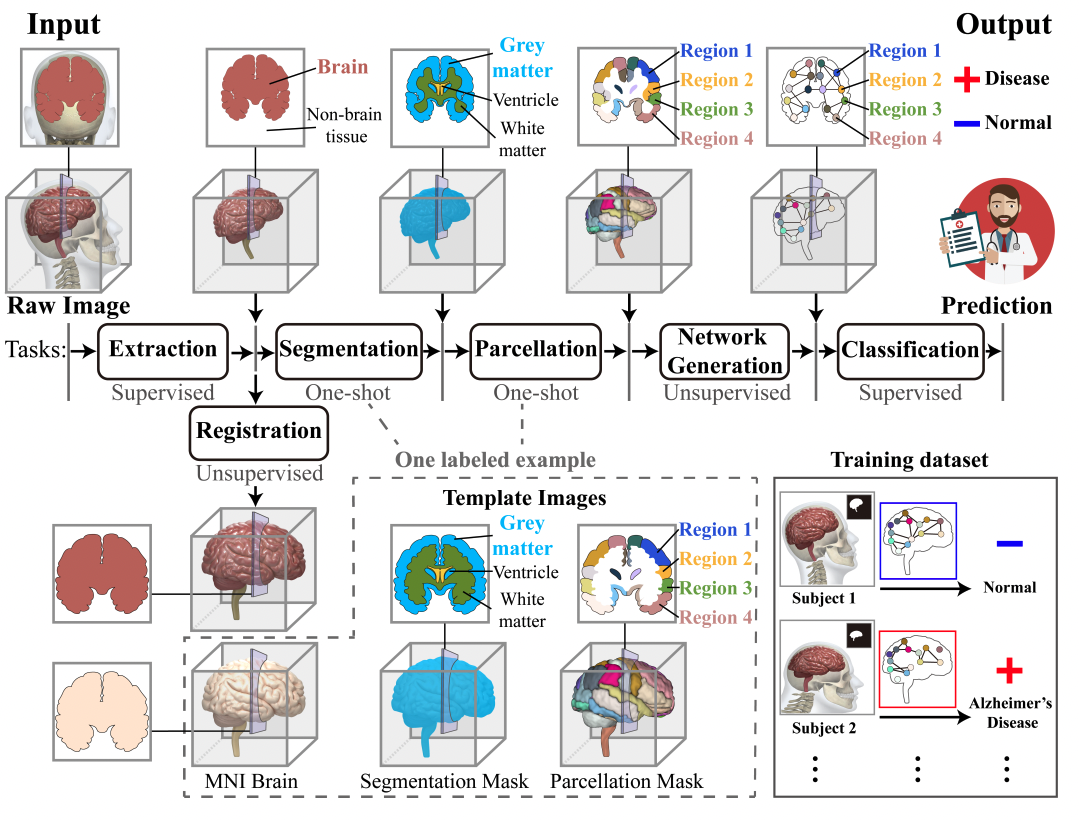

10. End-to-End Deep Learning for Structural Brain Imaging: A Unified Framework

Исследования мозга через анализ изображений являются крайне важными, но традиционные подходы имеют много этапов (извлечение мозга, регистрация, сегментация, построение сетей, классификация), требующих отдельных моделей и ручной корректировки. Это приводит к накоплению ошибок и большим затратам.

UniBrain предлагает уникальное решение, объединяя все этапы анализа в одну модель (end2end-подход). Используется минимальная разметка: только маски для извлечения и классификации и один размеченный шаблон. Это существенно экономит ресурсы и время.

Ключевые компоненты модели:

-

Извлечение: 3D U-Net для точного выделения мозга;

-

Регистрация: CNN и слой пространственной трансформации (STL) для выравнивания изображения с шаблоном;

-

Сегментация и парцелляция: one-shot подход с переносом масок обратно в исходное пространство;

-

Построение сети: Многоуровневый перцептрон (MLP) формирует матрицу связности мозга;

-

Классификация: графовая сверточная сеть (GCN) диагностирует состояния (например, СДВГ).

В результате:

-

Высокая точность по всем задачам (Dice, мера схожести между двумя множествами, для извлечения — 0.970, регистрации — 0.942, сегментации — 0.652);

-

Эффективная классификация (AUC-ROC — 0.712), превышающая традиционные методы;

-

Высокая скорость обработки (примерно 0.22 секунды на изображение), существенно быстрее обычных методов.

Благодаря полной интеграции всех этапов анализа модель значительно снижает накопление ошибок, а также уменьшает зависимость от объемной ручной разметки, что существенно ускоряет обработку изображений. UniBrain открывает перспективы ускорения и повышения точности нейродиагностики, являясь важным шагом к эффективному применению нейровизуализации в медицине.

📄 End-to-End Deep Learning for Structural Brain Imaging: A Unified Framework [29]

Все эти исследования указывают на одну тенденцию: ИИ становится все более всеобъемлющим, способным работать во множестве сред (цифровой, физической, научной), часто без ручного вмешательства. Да, остаются технические барьеры (вычислительная мощность, необходимость разметки) и социально-этические (безопасность, конфиденциальность, неправильное применение). Но прогресс на лицо: ИИ-системы все лучше взаимодействуют с реальным миром и решает прикладные задачи.

Что ж, посмотрим, куда приведут нас эти исследования в следующие месяцы. Вероятно, мы увидим еще более тесное взаимодействие ИИ с инструментами и роботами, причем уже не только в лабораториях, но и на предприятиях, в медицине и в быту. Осторожно, но оптимистично ждем новых прорывов!

***

Вот такие захватывающие исследования вышли в марте. Не забудьте подписаться на мой Telegram-канал [4] и использовать Dataist AI [3], чтобы всегда быть в курсе новейших обзоров на научные работы в области искусственного интеллекта. Будем вместе впереди в мире технологий!

Автор: andre_dataist

Источник [30]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/14319

URLs in this post:

[1] интеллекта: http://www.braintools.ru/article/7605

[2] мозга: http://www.braintools.ru/parts-of-the-brain

[3] Dataist AI: https://t.me/dataist_bot

[4] подписывайтесь на мой Telegram-канал: https://t.me/+DToJz_-xj5cyM2Iy

[5] реагировать: http://www.braintools.ru/article/1549

[6] обучении: http://www.braintools.ru/article/5125

[7] Статья Qwen2.5-Omni Technical Report: https://arxiv.org/pdf/2503.20215

[8] Модель на HuggingFace: https://huggingface.co/Qwen/Qwen2.5-Omni-7B

[9] память: http://www.braintools.ru/article/4140

[10] ошибка: http://www.braintools.ru/article/4192

[11] Self-Evolving Multi-Agent Simulations for Realistic Clinical Interactions: https://arxiv.org/pdf/2503.22678

[12] Код на GitHub: https://github.com/MAXNORM8650/MedAgentSim

[13] CODESCIENTIST: End-to-End Semi-Automated Scientific Discovery with Code-based Experimentation: https://arxiv.org/pdf/2503.22708

[14] Код на GitHub: https://github.com/allenai/codescientist

[15] опыт: http://www.braintools.ru/article/6952

[16] AgentRxiv: Towards Collaborative Autonomous Research: https://arxiv.org/pdf/2503.18102

[17] Код на GitHub: https://agentrxiv.github.io/

[18] Ссылка на более подробный обзор: https://habr.com/ru/articles/898656/

[19] Open Deep Search: Democratizing Search with Open-source Reasoning Agents: https://arxiv.org/abs/2503.20201

[20] 💾 Код на GitHub: https://github.com/sentient-agi/OpenDeepSearch

[21] мышление: http://www.braintools.ru/thinking

[22] делал обзор другой статьи «Emergent Response Planning in LLM».: https://habr.com/ru/articles/883574/

[23] запоминания: http://www.braintools.ru/article/722

[24] 📄 Tracing the thoughts of a large language model: https://www.anthropic.com/research/tracing-thoughts-language-model

[25] PLAY2PROMPT: Zero-shot Tool Instruction Optimization for LLM Agents via Tool Play: https://arxiv.org/pdf/2503.14432

[26] Chain-of-Tools: Utilizing Massive Unseen Tools in the CoT Reasoning of Frozen Language Models: https://www.arxiv.org/pdf/2503.16779

[27] Код на GitHub: https://github.com/fairyshine/Chain-of-Tools

[28] Gemini Robotics: Bringing AI into the Physical World: https://arxiv.org/pdf/2503.20020

[29] 📄 End-to-End Deep Learning for Structural Brain Imaging: A Unified Framework: https://arxiv.org/pdf/2502.18523

[30] Источник: https://habr.com/ru/articles/901350/?utm_source=habrahabr&utm_medium=rss&utm_campaign=901350

Нажмите здесь для печати.