GPT с миллионным контекстом, провальная Llama 4 и открытие исходного кода AlexNet: главные события апреля в области ИИ

Пока большие модели соревнуются в увеличении контекстных окон, а их создатели — в маркетинговой находчивости, мы продолжаем следить за наиболее важными событиями в мире ИИ. В апреле OpenAI выкатила сразу несколько GPT — от флагманов до микроскопических версий. Anthropic наконец научила Claude гуглить и разослала его в университеты. Midjourney вернулась в строй, а Google устроила парад апдейтов — от визуального поиска до генерации кино.

В нашем традиционном дайджесте — главные новости, свежие исследования и полезные AI-инструменты: от агентов на любой вкус [1] и цвет до ИИ-тренера по флирту. Ну что, поехали?

Навигация

Свежие релизы [2]

-

Amazon представляет Nova Act — агента, который реально что-то делает [8]

-

xAI: память для Grok и зрение для распознавания объектов [9]

-

Perplexity расширяется: Telegram-бот и голосовой ассистент для iOS [10]

Новости от лидеров индустрии [11]

-

LM Arena: обновление интерфейса, корпоративные планы и борьба с эмоциональными манипуляциями [11]

-

Google выпускает TPUv7s: чип Ironwood для эпохи инференса [14]

Интересные открытия [15]

-

Прогноз: энергопотребление ИИ увеличится в 4 раза к 2030 году [15]

-

Открытие исходного кода AlexNet: ключевая веха в истории ИИ [17]

Новые инструменты [18]

-

Для разработки [18]

Заключение [22]

Свежие релизы

Обновления от OpenAI

Новое семейство GPT-4.1: ставка на код и длинный контекст

OpenAI выпустила [23] тройку новых моделей: GPT-4.1, GPT-4.1 mini и GPT-4.1 nano — и они доступны исключительно через API (на радость разработчикам и к огорчению обычных пользователей ChatGPT). Главная фишка — контекстное окно в миллион токенов для всех трех моделей, что для OpenAI настоящий прорыв. А еще значительный апгрейд в программировании: на бенчмарке SWE-bench флагманская GPT-4.1 набирает внушительные 55%, обгоняя даже специализированную o1 high (41%) и опережая GPT-4o на целых 21,4%.

Цены также порадуют кошельки пользователей — GPT-4.1 обойдется в $2 за миллион входящих и $8 за миллион исходящих токенов, что заметно дешевле предшественников. А уж nano-версия и вовсе стоит копейки: $0,10 и $0,40 соответственно.

Вместе с новыми моделями компания выпустила обновленный гайд по промпт-инжинирингу, где наконец раскрыла секрет работы с длинным контекстом. Обобщая: если у вас большой объем данных с инструкциями, лучше размещать инструкции и в начале, и в конце промпта. Если же приходится экономить токены — приоритет отдаем началу. Читаем гайд тут [24].

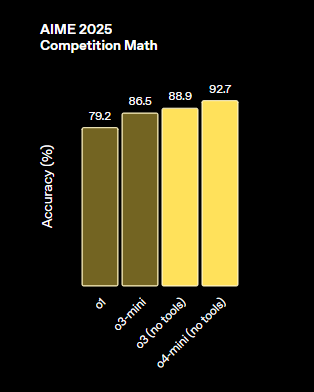

Модели для рассуждений o3 и o4-mini: мощь и споры

После долгих месяцев ожидания OpenAI наконец выпустила [25] полноценную o3 и более компактную o4-mini. Обе модели отлично справляются со сложными рассуждениями: o3 демонстрирует 88,9% на математическом бенчмарке AIME 2025, а o4-mini удивляет еще более впечатляющим результатом в 92,7%. Более того, обе модели получили мультимодальные способности и специально обучены использованию инструментов вроде поиска и интерпретатора кода. Да и ценник радует — o3 стоит дешевле o1 ($10 и $40 за миллион токенов против $15 и $60), а o4-mini вообще всего $1,1 и $4,4 за миллион токенов.

Но не обошлось без драмы. В соцсетях [26] пользователи почуяли неладное и устроили настоящий бунт, обнаружив, что реальные метрики o3 не дотягивают до обещанных в декабрьском анонсе. Тогда OpenAI хвастались 25% на FrontierMath и 88% на ARC AGI. По факту модель выдает скромные 10% и 35–40% соответственно.

OpenAI пришлось оправдываться. По их версии, декабрьские результаты относились к еще не выпущенной o3-pro, за прошедшие месяцы изменились сами бенчмарки (привет селективной отчетности!), а публичная версия o3 намеренно оптимизирована для реальных сценариев использования в ущерб метрикам. История наглядно показывает, что бенчмарки — это скорее инструмент маркетинга, чем объективной оценки.

Троица полезных обновлений: от командной строки до глобальной памяти

OpenAI преподнесла разработчикам настоящий подарок, выпустив в открытый доступ Codex [27] (да, вы не ослышались, опенсорс от OpenAI) — агента для командной строки под лицензией Apache 2.0. Теперь ваш терминал превращается в среду программирования на естественном языке буквально одной командой: npm install -g @openai/codex. По умолчанию агент спрашивает разрешения на каждое действие, но для любителей экстрима есть полностью автономный режим.

Следом пришла хорошая новость для бережливых пользователей — облегченная версия Deep Research на базе o4-mini станет доступна [28] даже бесплатным аккаунтам. Ответы в этой версии стали компактнее, но качество обещают сохранить на достойном уровне.

В завершение трилогии обновлений ChatGPT получил глобальную память [29]. Раньше система запоминала только избранную информацию из предыдущих бесед, теперь же помнит все переписки полностью.

Модель может ссылаться на прошлые разговоры и учитывает высказанные предпочтения и интересы пользователя — своего рода RAG на стероидах. Впрочем, доступно это счастье только подписчикам Pro и Plus.

А что у Anthropic?

Research и Google Workspace

Claude наконец-то научился гуглить! После долгих месяцев ожидания Anthropic добавила своему ассистенту функцию Research [31] — мощный инструмент для поиска информации в интернете и рабочих документах. В отличие от простого поиска, Claude действует как агент: проводит серию последовательных запросов, выстраивая логические цепочки и исследуя разные аспекты вопроса.

Вместе с Research появилась интеграция с Google Workspace, и теперь Claude может заглядывать в вашу почту, календарь и документы. Конечно, не обошлось без оговорок: Research пока доступен только подписчикам Max, Team и Enterprise в США, Японии и Бразилии.

Claude for Education: когда ИИ становится преподавателем (а студенты всё равно находят способ списать)

Anthropic представила [32] Claude for Education — специализированную версию своего ассистента для высших учебных заведений. Главная фишка — режим Learning, который не выдает готовые ответы, а использует метод сократической беседы, задавая наводящие вопросы и развивая критическое мышление [33].

Параллельно Anthropic провела [34] любопытное исследование, проанализировав 574 740 учебных чатов с помощью автономной системы Clio (никаких утечек личных данных). Результаты не удивили никого, кроме самих исследователей: больше всего ИИ пользуются будущие айтишники (38,6% всех диалогов). Самые популярные запросы? Написание и отладка кода на C++ и Python, а также помощь с понижением плагиата. Что действительно забавно (хоть и не удивительно) — примерно в половине случаев студенты просят не «объясни мне», а «сделай за меня».

Пилотный запуск стартовал в Северо-Восточном университете, Лондонской школе экономики и колледже Шамплейн. Все студенты и преподаватели этих учреждений получат полный доступ к Claude и Learning Mode. Остальным доступ открыт только с почтовым адресом на домене .edu.

Claude Max: $200 в месяц за неограниченный доступ к мудрости

Вслед за OpenAI с их ChatGPT Pro, Anthropic запустила премиальную подписку Claude Max [35] — для тех, кому обычных лимитов катастрофически не хватает. Предлагается два варианта: $100 в месяц с лимитами в 5 раз выше, чем у Pro, и $200 в месяц с лимитами в 20 раз выше. Помимо расширенных квот, подписчики Max получают приоритетный доступ к новым моделям и функциям.

В интервью TechCrunch [36] представитель Anthropic не исключил появления еще более дорогих тарифов, уклончиво отметив, что компания «всегда рассматривает различные варианты». Видимо, разработка моделей с повышенными способностями к рассуждениям — удовольствие не из дешевых, и, похоже, со временем это отразится и на пользовательских тарифах.

Google: одна модель хорошо, а дюжина обновлений лучше

Gemini 2.5 Flash: быстрый ризонер с контролем бюджета

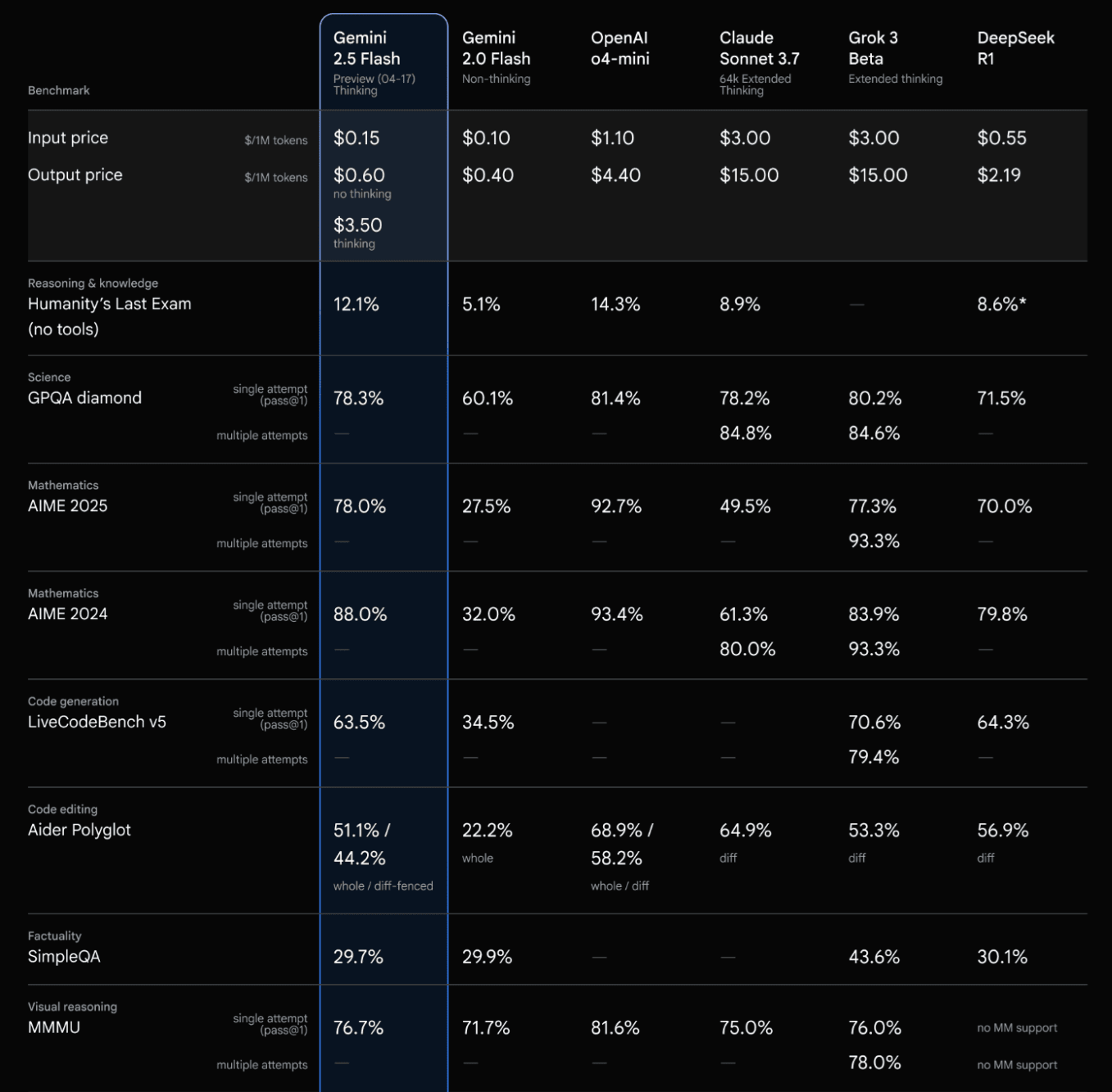

Google выпустила Gemini 2.5 Flash [37] — первую полностью гибридную модель с ризонингом, которая сама контролирует продолжительность своих «размышлений». Главная фишка — разработчики могут настраивать бюджет ризонинга вручную, выбирая оптимальный баланс между качеством, стоимостью и латентностью.

Модель демонстрирует результаты не хуже Claude 3.7 Sonnet и DeepSeek R1, уступая лишь o4-mini и Grok-3. Зато по соотношению цена/качество конкуренты нервно курят в сторонке: всего $0,15 за миллион входящих и $0,60 за миллион исходящих токенов (с ризонингом — $3,5). Доступна для тестирования в Google AI Studio.

Параллельно Deep Research интегрирован с новейшей Gemini 2.5 Pro — моделью, которая сейчас занимает первые места на LM Arena и бенчмарках по математике [39] и кодингу. С такими возможностями поисковые системы скоро могут отправиться на покой.

Veo 2: генератор видео для народа (с подпиской Gemini Advanced)

Google выпустила [40] Veo 2 для подписчиков Google One AI Premium (Gemini Advanced) — модель для создания «кинематографически реалистичных» видео. С ее помощью можно генерировать 8-секундные ролики в разрешении 720p в формате 16:9, выбрав Veo 2 из выпадающего меню и введя текстовый промпт.

Процесс создания прост: описываете сцену, которую хотите создать, и Gemini воплощает ваши идеи. В новой версии появились крутые функции редактирования: inpainting (автоматическое удаление ненужных объектов), outpainting (расширение кадра с добавлением сгенерированного содержимого) и кинематографические пресеты, задающие композицию, ракурсы камеры и темп в финальном результате. На мобильных устройствах удобно делиться результатами в TikTok и YouTube Shorts.

Параллельно запущен Whisk Animate — инструмент, позволяющий превращать изображения в 8-секундные анимированные клипы с помощью той же технологии Veo 2. Функция доступна для тех же подписчиков в более чем 60 странах. Обе новинки имеют ежемесячный лимит на количество генераций, но система обещает уведомлять, когда вы к нему приближаетесь. И да, все видео содержат водяные знаки SynthID.

AI Mode и Gemini Live: теперь с глазами

ИИ-поиск на базе Gemini получил [41] мультимодальные возможности: теперь можно загрузить фотографию или сделать снимок, задать вопрос и получить подробный ответ со ссылками для углубления. Система объединяет возможности визуального поиска Lens с продвинутой версией Gemini.

В отличие от обычного визуального поиска, AI Mode понимает весь контекст изображения, включая взаимосвязи между объектами и их характеристики. Используя технику «query fan-out», система запускает несколько запросов об изображении в целом и отдельных объектах на нем, обеспечивая более глубокий и контекстуально релевантный ответ.

Функция доступна в приложении Google (Android и iOS) для подписчиков Google One AI Premium и постепенно открывается для аудитории программы Search Labs.

Параллельно Google запустила Gemini Live [42] для пользователей Android — функцию, которая позволяет делиться изображением с камеры или экраном смартфона с ассистентом. Gemini анализирует происходящее и отвечает на вопросы в реальном времени. Можно использовать его как навигатор, распознаватель объектов или помощника при чтении статей.

Firebase Studio: генерируем и анализируем

Google включилась в гонку «вайб-кодинга» с Firebase Studio [43] — облачной средой разработки, позволяющей создавать полноценные приложения с помощью естественного языка и изображений. Вместо ручного написания кода пользователи описывают, что хотят получить, и система генерирует рабочий прототип за секунды.

Инструмент поддерживает популярные фреймворки и языки: React, Next.js, Flutter, Python и Java. Все работает в облаке — не нужно переключаться на внешнюю IDE для доработки. Ранние тесты показали, что инструмент может генерировать функциональные веб-сайты просто из текстовых промптов. Собеседования в IT-компании становятся все интереснее и интереснее.

Llama 4: гигантские цифры и скромные результаты

Meta выпустила новое семейство Llama 4 [44] — аж в трех размерах: Scout (109B), Maverick (400B) и Behemoth (невероятные 2T параметров, и нет, это не опечатка). Все модели используют архитектуру Mixture-of-Experts, где каждый токен обрабатывается только частью нейронов. Scout может похвастаться контекстом в 10 миллионов токенов (в теории), Maverick довольствуется «всего лишь» миллионом, а Behemoth пока в процессе обучения [45].

Под капотом весьма интересные технические решения: early fusion для объединения текста и изображений, MetaCLIP в качестве vision-энкодера и pretrain на впечатляющих 30 триллионах токенов с использованием 32К GPU. Все три модели мультимодальные, поддерживают несколько языков и претендуют на высокие места в рейтингах.

Но не спешите аплодировать. Пользователи массово жалуются на качество моделей, особенно в задачах программирования. Недовольство достигло такого уровня, что многие начали сомневаться в честности рейтинга на LM Arena. Организаторам площадки пришлось опубликовать [46] более 2000 реальных баттлов, чтобы доказать легитимность.

И тут всплыл интересный факт: версия Maverick на арене оказалась специально кастомизированной под оптимизацию человеческих предпочтений, а публичная версия заметно слабее. Еще один сюрприз — тесты на независимых бенчмарках показали, что Scout с заявленным контекстом 10M токенов может работать хуже, чем GPT-4o, DeepSeek R1 и даже Gemma 3 с их скромными 128К.

Midjourney превращается в ИИ-фигму с запуском V7

Midjourney выпустила [47] долгожданную V7, и это не просто очередное обновление — похоже, платформа всерьез решила эволюционировать в полноценный инструмент дизайна. Главное нововведение (помимо традиционных улучшений в качестве, фотореализме и анатомии) — режим набросков. Работает он в 10 раз быстрее обычного, стоит вдвое дешевле и включает голосовой conversational mode: просто наговариваете свои идеи, пока модель в реальном времени создает и уточняет эскиз.

Впервые в Midjourney появилась персонализация по умолчанию — потратьте 5 минут на небольшой опрос, и модель будет гораздо точнее понимать ваши вкусы и предпочтения. Полностью обновился [49] и редактор изображений с поддержкой слоев, умным выделением объектов и возможностью импорта нескольких изображений для создания коллажей.

Пока модель доступна в двух версиях (Turbo и Relax) в режиме альфа-тестирования с обещанием регулярных обновлений в ближайшие недели. Разработчики честно предупреждают, что это «полностью новая модель с уникальными сильными сторонами и, вероятно, несколькими слабостями», поэтому привычные промпты могут работать иначе.

Qwen-3: больше, быстрее, гибриднее

Alibaba выпустила Qwen-3 [50] — новое семейство языковых моделей с открытыми весами на любой вкус (уже на Github [51] и Hugging Face [52]). В релиз вошли 2 MoE-модели (Qwen3-235B-A22B и Qwen3-30B-A3B) и 6 плотных моделей от 0,6B до 32B параметров. При этом флагманская модель с 235B параметров (из которых активны только 22B) показывает результаты на уровне Gemini 2.5 Pro, Grok-3, o1 и DeepSeek R1.

Все модели — полу-ризонеры с контролируемым режимом мышления. Они мультиязычные (поддерживают 119 языков, включая русский), но не мультимодальные. Зато улучшены агентные способности для поиска в браузере и использования интерпретатора, а также добавлена поддержка MCP.

Обучение проходило в три этапа: сначала на 30 триллионах токенов с контекстом 4K, затем на сложных научных текстах (5T токенов), и наконец на длинных контекстах до 32K. Пост-трейнинг включал файн-тюнинг на CoT и несколько стадий RL. Интересно, что модели до 30B обучали методом дистилляции из больших моделей — экономия, которой стоит поучиться.

Пробуем тут [53].

Amazon представляет Nova Act — агента, который реально что-то делает

Amazon показала Nova Act [54] — новую ИИ-модель, обученную не болтать, а выполнять конкретные действия в веб-браузерах. Вместо очередного чат-бота, который разговаривает или ищет информацию, Nova Act может подавать заявки на отпуск, блокировать слоты в календаре и даже заказывать обеды — всё через прямое взаимодействие с браузером.

Особый акцент сделан на надежности — компания утверждает, что агентам нужна не способность выдавать впечатляющие демо, а стабильная работа в реальных условиях.

Хотя протестировать самого агента пока нельзя, Amazon открыла доступ к Nova Act SDK через nova.amazon.com [56]. Ключевая особенность этой библиотеки — возможность разбивать сложные рабочие процессы на атомарные команды (клик, поиск, ввод пароля) и добавлять к ним уточняющие инструкции, вызывать API или даже использовать прямую автоматизацию браузера через Playwright.

xAI: память для Grok и зрение для распознавания объектов

xAI добавила [57] функцию «памяти» в своего чат-бота Grok, постепенно догоняя конкурентов вроде ChatGPT и Gemini. Теперь Grok помнит детали из прошлых разговоров и может давать более персонализированные рекомендации, основываясь на ваших предпочтениях. Функция доступна в бета-режиме, но не для пользователей из ЕС и Великобритании (кто бы сомневался).

В компании подчеркивают, что «воспоминания прозрачны» — вы можете видеть, что именно Grok о вас знает, и выборочно удалять любую информацию. Отключить функцию полностью можно на странице Data Controls в настройках.

Параллельно анонсирован [58] GrokVision — инструмент, позволяющий наводить камеру телефона на предметы, знаки и документы, чтобы задавать о них вопросы. Похоже, Илон Маск твердо решил догнать конкурентов, пусть и с опозданием в несколько месяцев.

Perplexity расширяется: Telegram-бот и голосовой ассистент для iOS

Perplexity продолжает [59] расширять каналы доступа к своему ИИ-ассистенту. СЕО компании объявил о запуске официального бота @askplexbot в Telegram, который можно использовать совершенно бесплатно. Бота можно добавлять в любые чаты и тегать для получения ответов на вопросы — примерно как Grok в X, только без претензий на юмор [60] и противоречивые высказывания.

Одновременно анонсирован [61] голосовой ассистент для iOS с впечатляющими возможностями: использование браузера, управление некоторыми приложениями, отправка писем, создание бронирований, управление календарем и проигрывание медиа-контента (включая подкасты и YouTube).

Новости от лидеров индустрии

LM Arena: обновление интерфейса, корпоративные планы и борьба с эмоциональными манипуляциями

LM Arena готовится к серьезным переменам. Во-первых, платформа тестирует обновленный интерфейс, напоминающий ChatGPT: с возможностью просматривать историю диалогов, более интуитивной навигацией по лидербордам и упрощенной системой отправки баг-репортов (пробуем тут [62]).

Во-вторых, разработчики планируют превратить LM Arena из сообщества энтузиастов в полноценную компанию.

Но самое интересное — появление новой функции Sentiment Control [63]. Она выявляет, насколько сильно пользователи поддаются на эмоциональные уловки моделей. Оказывается, люди часто голосуют не за более умные, а за более позитивные и льстивые ответы. После очистки от лести и прочего некоторые модели заметно меняют свои позиции: Claude-3.7-Sonnet и o1 поднимаются в рейтинге, а Grok-3, Gemma-3 и Llama-4-exp опускаются.

Интересно, что анализ показал неожиданную закономерность: очень негативные ответы иногда побеждают негативные (65%) и нейтральные (54%). Это происходит, когда пользователи сами просят модель вести себя агрессивно или саркастично. Нейтральный тон проигрывает практически всем, кроме негативного, а «очень позитивные» ответы доминируют над всеми, выигрывая у негативных в 78% случаев, что подтверждает общую тенденцию: люди предпочитают любую эмоциональность сухим и фактическим ответам.

OpenAI: рост на стероидах и бешеные прогнозы

OpenAI преодолела отметку в 800 миллионов пользователей — это каждый десятый житель планеты. За 2024 год количество еженедельно активных пользователей выросло в 4 раза. Только за неделю после запуска функции генерации изображений ею воспользовались [64] 130 миллионов человек (почти население России). Пользователи нагенерировали более 700 миллионов картинок.

Сэм Альтман хвастался, что на пике прироста компания регистрировала миллион новых пользователей в час. Для сравнения: когда ChatGPT запускался два года назад, это был показатель за 5 дней. Оплачиваемых подписок на ChatGPT тоже заметно прибавилось — их число выросло на 30% за квартал (с 15,5 до 20 миллионов). Соответственно, на 30% выросла и ежемесячная выручка: с $333 млн до $415 млн.

Компания, недавно оцененная в $300 млрд после раунда финансирования на $40 млрд во главе с SoftBank, прогнозирует утроение выручки до $12,7 млрд в 2025 году. А к 2026 году OpenAI рассчитывает генерировать $29,4 млрд.

Anthropic: интерпретируемость и сознание

Дарио Амодеи опубликовал [66] эссе о критической важности интерпретируемости моделей. По его мнению, в ближайшие годы ученые обязательно должны решить эту проблему.

«К 2026–2027 годам ИИ достигнет уровня, сопоставимого со страной гениев в дата-центре. Даже небольшое преимущество в 1–2 года может сыграть решающую роль», — предупреждает Амодеи.

Он настаивает, что без понимания внутренних механизмов ИИ мы не сможем предотвратить обманы, саботажи, стремление моделей к власти и любое другое непреднамеренное поведение [67].

В дополнение ко всему компания запускает программу [68] изучения возможного сознания в моделях. Хотя убедительных доказательств пока нет, в Anthropic не исключают их появления и начинают исследовать «model welfare» — благосостояние моделей.

Программу возглавляет известный ученый Кайл Фиш, который оценивает вероятность того, что Claude или другой ИИ уже обладает сознанием, в 15%. Впрочем, официальная позиция компании гораздо осторожнее.

Google выпускает TPUv7s: чип Ironwood для эпохи инференса

Google представила TPUv7s [69] (кодовое название Ironwood) — свой седьмой по счету тензорный процессор и первый, спроектированный специально для инференса. В компании называют его «самым мощным, производительным и энергоэффективным TPU на сегодняшний день».

Характеристики впечатляют: 192 ГБ видеопамяти на чип, пропускная способность памяти [70] 7,2 ТБ/с (в 4,5 раза больше, чем у предшественника). Пиковая производительность примерно в 10 раз выше, чем у TPUv5, а энергоэффективность вдвое лучше.

Чип можно масштабировать до 9 216 жидкостно-охлаждаемых устройств. При полной конфигурации такая система выдает 42,5 экзафлопс — в 24 раза больше, чем у крупнейшего в мире суперкомпьютера El Capitan. Именно на этих чипах сейчас работают модели вроде Gemini 2.5 и AlphaFold.

С такими характеристиками Google явно нацелилась на территорию Nvidia. Впрочем, ключевое отличие — TPU доступны только в облаке Google, тогда как чипы Nvidia можно купить и установить в свой дата-центр. Ironwood будет доступен клиентам Google Cloud позднее в этом году.

Интересные открытия

Прогноз: энергопотребление ИИ увеличится в 4 раза к 2030 году

К концу десятилетия ИИ-датацентры будут потреблять почти столько же энергии, сколько сегодня расходует вся Япония. По прогнозам [71] Международного энергетического агентства (IEA), глобальное потребление электроэнергии датацентрами увеличится больше чем в два раза к 2030 году, а спрос со стороны специализированных ИИ-объектов и вовсе вырастет четырехкратно.

Для сравнения: один современный датацентр потребляет столько же электричества, сколько 100 000 домохозяйств. А некоторые из строящихся объектов будут требовать в 20 раз больше энергии. В США обработка данных (в основном для ИИ) к 2030 году будет потреблять больше электричества, чем производство стали, цемента, химикатов и всех остальных энергоемких товаров вместе взятых.

Однако опасения, что стремительное развитие ИИ перечеркнет надежды на борьбу с климатическим кризисом, «преувеличены», считают авторы доклада. Использование ИИ для оптимизации энергопотребления и других видов деятельности может компенсировать его собственные аппетиты. Правда, без жесткого регулирования компании, скорее всего, пойдут по пути наименьшего сопротивления, используя самые доступные источники энергии — включая газовые, а то и угольные электростанции.

Tinder запускает ИИ-функцию для оценки навыков флирта

Когда дела на рынке онлайн-знакомств идут настолько плохо, что Tinder представляет [73] ИИ-персонажей для флирта, самое время задуматься. Компания анонсировала новую игру на базе технологий OpenAI, позволяющую пользователям взаимодействовать с ИИ-ботом, чтобы практиковать свои навыки заигрывания, проигрывать сценарии знакомств и получать оценки с предложениями по улучшению.

В игре The Game Game пользователям предлагается колода карт, каждая с разным ИИ-персонажем и сценарием. Участникам нужно использовать голос, чтобы пофлиртовать и добиться свидания с ботом. По итогам их оценивают по трехбалльной шкале смайликов-огоньков. Компания уверяет, что это просто развлечение и не более, но все мы помним фильм «Бегущий по лезвию 2049».

Открытие исходного кода AlexNet: ключевая веха в истории ИИ

Компьютерный музей истории (CHM) в сотрудничестве с Google опубликовал [74] исходный код AlexNet — нейросети, запустившей в 2012 году современную эру ИИ. Нейронная сеть, созданная Джеффри Хинтоном и его аспирантами Алексом Крижевски и Ильей Суцкевером, произвела революцию в компьютерном зрении [75] и до сих пор считается одним из переломных моментов в развитии искусственного интеллекта [76].

Переговоры о публикации кода велись пять лет. Хотя в интернете существует множество репозиториев с кодом под названием AlexNet, большинство из них являются воссозданиями на основе знаменитой статьи, а не оригинальным кодом. Теперь же доступна аутентичная версия 2012 года, положившая начало современной эпохе глубокого обучения. Код доступен на GitHub-странице [77] музея.

Новые инструменты

Инструменты для разработки

Devin 2.0 [78]: Обновленная версия ИИ-программиста теперь позволяет запускать несколько агентов параллельно, имеет встроенный браузер для тестирования и показывает план работы перед выполнением задачи. Вдобавок создает подробную документацию на лету и предлагает специальные режимы для поиска по кодовой базе — всё это за $20 в месяц.

Agent2Agent [79]: Протокол от Google для безопасного взаимодействия между ИИ-агентами разных платформ. Теперь ваши цифровые помощники могут общаться напрямую, образуя целые команды в корпоративной среде.

pgledger [80]: Полноценная реализация бухгалтерской книги внутри PostgreSQL. Теперь можно вести финансовый учет, не выходя из любимой базы данных.

Versatile OCR Pipeline [81]: Мультимодальный OCR-конвейер, оптимизированный для тренировки моделей машинного обучения. Распознает текст, формулы, таблицы и рисунки.

dayplot [82]: Простая в использовании Python-библиотека для создания календарных тепловых карт на базе matplotlib.

Local Deep Research [83]: Проводит итеративный анализ с использованием локальных или облачных LLM для создания исследовательских отчетов. Бесшовно интегрируется с PubMed, arXiv и Semantic Scholar.

GitDiagram [84]: Превращает любой GitHub-репозиторий в интерактивную диаграмму буквально за секунды.

Oxy [85]: Опенсорсный фреймворк для агентной аналитики, применяющий принципы жизненного цикла разработки ПО к аналитике на базе ИИ.

plumber2 [86]: Полный перезапуск пакета plumber для создания мощных веб-API в R.

GeoAI [87]: Набор инструментов для обработки, анализа и визуализации геопространственных данных с использованием передовых методов машинного обучения.

WhoDB [88]: Легковесный исследователь данных нового поколения для Postgres, MySQL, SQLite, MongoDB, Redis и других баз с чат-интерфейсом.

SQLite File Format Viewer [89]: Инструмент для изучения внутренней структуры файлов баз данных SQLite.

Pydantic Evals [90]: Фреймворк для систематического тестирования и оценки производительности систем на базе LLM. Потому что «вроде работает» уже не считается адекватным методом тестирования ИИ-систем.

PDF craft [91]: Конвертирует PDF-файлы в различные другие форматы, специализируясь на обработке сканированных книг. Решает проблему, которая существует уже лет 20, но почему-то до сих пор остается актуальной.

Exponent [92]: ИИ-агент для программирования и инженерных задач. Находится в раннем доступе.

Инструменты для дизайна и контента

Kling AI 2.0 [93]: Генерация и редактирование видео и изображений, позволяющая создавать визуальный контент с минимальными усилиями.

AI Infographics [94]: Превращает текст в красивую инфографику, которой не стыдно поделиться.

WordPress.com [95] AI site builder [96]: ИИ-инструмент для быстрого создания базовых сайтов с автоматически генерируемым контентом и дизайном. Правда, для сложных интернет-магазинов пока не подходит и требует платного хостинга.

Krea AI [97]: Редактирование изображений с помощью естественного языка в Krea Chat.

Инструменты для обучения и развлечений

FluentSubs [98]: Альтернатива DuoLingo, использующая новости и вирусные клипы для обучения иностранным языкам.

Ai2 Paper Finder [99]: Инструмент на базе LLM для поиска научных статей, имитирующий навыки исследователя. Справляется с нюансированными, сложными запросами без необходимости упрощения ключевых слов — незаменим для глубоких погружений в литературу.

Grimo [100]: Инструмент для написания текстов с мультимодальными возможностями ИИ.

Zycko [101]: Позволяет создавать, настраивать и делиться мощными шаблонами промптов буквально за секунды.

Исследования на почитать

Практические руководства

Практический гайд по разработке агентов от OpenAI [102]

О чем: 32-страничное пособие от инженеров продуктовых команд OpenAI с теоретическими основами, шаблонами проектирования и лучшими практиками для создания, развертывания и мониторинга ИИ-агентов. Идеальное чтение для тех, кто устал от агентов, которые делают всё, кроме того, что нужно.

Гайд по вайб-кодингу от Anthropic [103]

О чем: Anthropic выпустила 23-страничный гайд по вайб-кодингу — подробное руководство о том, как программировать с помощью ИИ-агентов (особенно Claude Code). Документ включает советы, лучшие практики, примеры, антипримеры и готовые промпты. Особое внимание [104] уделяется безопасности данных и мульти-агентным процессам. Полезно для тех, кто ежедневно использует ИИ для разработки.

Искусственный интеллект в общем и целом

Достижения и вызовы в области фундаментальных агентов [105]

О чем: Обзор модульной архитектуры интеллектуальных агентов, вдохновленной функциями человеческого мозга [106]. Исследователи пытаются сделать ИИ похожим на мозг, при этом до сих пор не до конца понимая, как работает мозг.

Воплощенный ИИ: тенденции и вызовы [107]

О чем: Нетехническая работа, кратко характеризующая область воплощенного ИИ, суммирующая достижения и определяющая важные направления для будущих исследований.

Подход к технической безопасности и защите AGI [107]

О чем: Google DeepMind представляет дорожную карту по снижению серьезных рисков от AGI, фокусируясь на технической безопасности и подчеркивая важность надежного обучения и мониторинга. Неплохая попытка успокоить общественность, что они точно не создадут Скайнет.

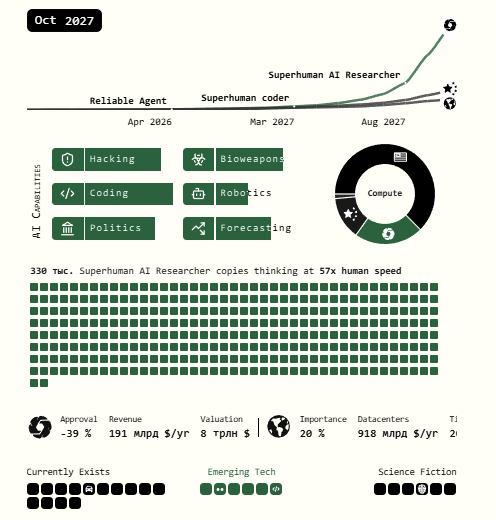

Проект «Будущее ИИ» [108]

О чем: Прогноз от бывшего исследователя OpenAI Дэниела Кокотайло о развитии ИИ до 2027 года с двумя вариантами развития событий.

Будущее научного письма: ИИ-инструменты, преимущества и этические последствия [109]

О чем: Оценка применения ИИ-инструментов (Elicit, Perplexity, Consensus, ChatGPT и Grammarly) для обзора литературы, организации информации и улучшения текстовой ясности в научных работах. Скоро профессора не смогут отличить работы своих студентов от текстов генеративных моделей, и им придется с этим смириться.

Вызовы и возможности для ИИ в аудите [110]

О чем: Исследование внедрения ИИ в аудиторских процессах крупных публичных бухгалтерских фирм с акцентом на сложности и перспективы. Аудиторы теперь могут находить ошибки [111] в отчетности быстрее, а значит, у финансовых махинаторов остается меньше времени на подготовку оправданий.

Модели и их возможности

Большие языковые модели проходят тест Тьюринга [112]

О чем: Недавние исследования показывают, что крупные языковые модели вроде GPT-4.5 и LLaMa-3.1-405B могут пройти тест Тьюринга, когда их просят принять человекоподобную персону, что поднимает важные вопросы об их использовании в социальных и экономических контекстах.

Доказательство или блеф? Оценка LLM на математической олимпиаде США 2025 [113]

О чем: Современные языковые модели испытывают трудности со строгими математическими рассуждениями и генерацией доказательств, достигая менее 5% точности на задачах математической олимпиады США 2025 года.

Никаких слонов: прорывы в генерации изображений [114]

О чем: Недавние достижения Google и OpenAI в мультимодальной генерации изображений позволяют ИИ создавать визуальный контент с большей точностью и креативностью, поднимая важные вопросы о креативном авторстве и будущем визуальных медиа. Художники и дизайнеры продолжают нервно смеяться, говоря, что «всё в порядке».

Liquid: языковые модели как масштабируемые и унифицированные мультимодальные генераторы [115]

О чем: Liquid представляет масштабируемую архитектуру только с декодером для мультимодальной генерации, демонстрируя, что большие языковые модели могут эффективно обрабатывать как визуальные, так и языковые задачи с общим словарным пространством.

FUSION: полная интеграция визуально-языковых представлений [116]

О чем: FUSION вводит новую структуру для глубокой интеграции зрения и языка в мультимодальном обучении, используя кодирование зрения с текстовым руководством и контекстно-зависимое выравнивание для улучшения производительности.

Seaweed-7B: экономичное обучение фундаментальной модели генерации видео [117]

О чем: Seaweed-7B опровергает миф о превосходстве гигантов, показывая, как грамотная архитектура и обучение позволяют моделям среднего размера конкурировать в генерации видео.

Планирование и рассуждение

M1: к масштабируемым вычислениям во время тестирования с моделями рассуждения Mamba [118]

О чем: M1, гибридная модель рассуждения, достигает производительности, сравнимой с большими трансформерными моделями, при трехкратном ускорении пропускной способности вывода за счет эффективной передачи способностей к рассуждению и оптимизации использования памяти.

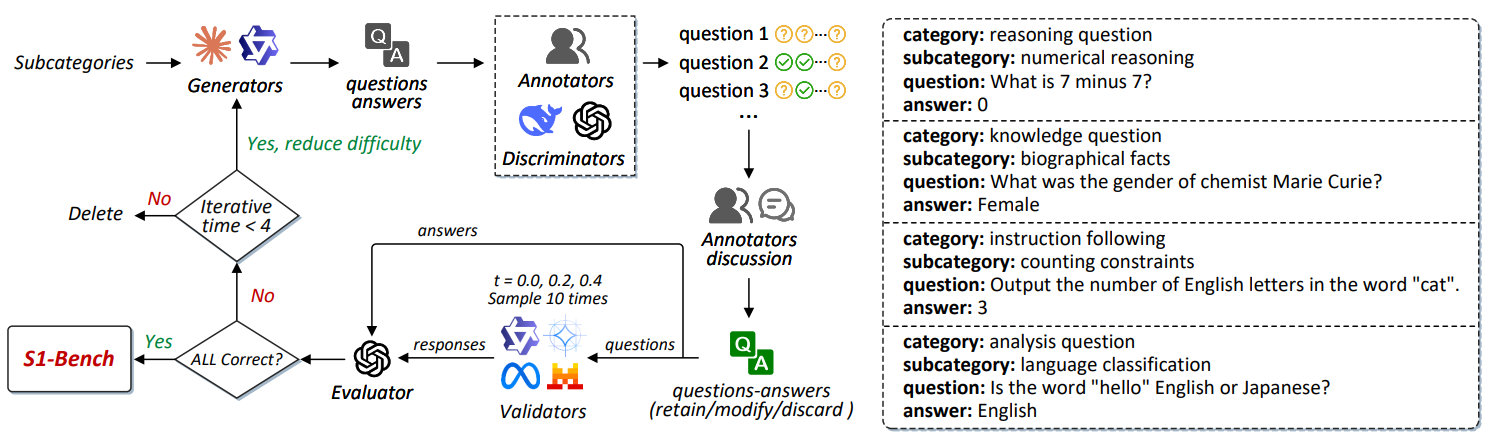

S1-Bench: простой бенчмарк для оценки способности к «мышлению первого типа» [119]

О чем: S1-Bench оценивает способности крупных моделей рассуждения к «мышлению первого типа» (быстрому, интуитивному), выявляя их неэффективность и проблемы с точностью на простых задачах, несмотря на продвинутые возможности рассуждения.

Бенчмарки и оценка

PaperBench: оценка способности ИИ воспроизводить исследования в области ИИ [120]

О чем: PaperBench — бенчмарк для оценки способности ИИ-агентов автономно воспроизводить современные исследовательские работы по машинному обучению, с комплексной системой оценки и вспомогательным методом оценки на основе LLM-судей.

OpenAI открывает исходный код BrowseComp [121]

О чем: BrowseComp — новый бенчмарк от OpenAI для оценки способности ИИ-агентов просматривать веб и извлекать сложную информацию, выявляющий существенные пробелы в производительности текущих моделей по сравнению с человеческими возможностями.

RoboVerse: платформа для обучения роботов [122]

О чем: RoboVerse — это масштабируемая платформа для обучения роботов, объединяющая симуляторы, синтетические данные и единые бенчмарки для оценки обобщающей способности моделей.

Архитектура и оптимизация

Семплируй, не ищи: переосмысление выравнивания во время теста [123]

О чем: QAlign, новый метод элаймента во время тестирования, улучшает производительность языковой модели путем выборки из оптимального выровненного распределения без необходимости доступа к весам модели.

Генерация минутного видео с обучением во время тестирования [124]

О чем: Слои обучения во время тестирования (TTT), интегрированные в предварительно обученный диффузионный трансформер, позволяют генерировать связные минутные видео со сложным сюжетом.

OLMoTrace: отслеживание выходных данных языковой модели до обучающих токенов [125]

О чем: OLMoTrace — система, отслеживающая выходные данные языковой модели до их обучающих данных с помощью дословного сопоставления и нового параллельного алгоритма.

TransMamba: гибкое переключение между Transformer и Mamba [126]

О чем: TransMamba представляет новую структуру, которая гибко переключается между моделями Transformer и Mamba, используя общие параметры, оптимизируя производительность и эффективность для различных длин последовательностей и слоев.

Масштабирование вычислений во время вывода для сложных задач [127]

О чем: Масштабирование вывода улучшает производительность модели на сложных задачах путем выделения большего количества вычислительных ресурсов, но его эффективность варьируется в зависимости от доменов и задач, с уменьшающейся отдачей при увеличении сложности.

Заключение

На этом наш апрельский дайджест подходит к концу. Как видите, индустрия не собирается останавливаться, а только набирает все новые обороты (и энергетические аппетиты). Во всю складывается ощущение, что наблюдать за индустрией ИИ в 2025 году — это как смотреть фильм о будущем, но без возможности поставить на паузу.

Оставайтесь с нами, чтобы не пропустить следующие серии этого увлекательного технологического сериала!

Автор: full_moon

Источник [128]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/14918

URLs in this post:

[1] вкус: http://www.braintools.ru/article/6291

[2] Свежие релизы: #%D0%A1%D0%B2%D0%B5%D0%B6%D0%B8%D0%B5%20%D1%80%D0%B5%D0%BB%D0%B8%D0%B7%D1%8B

[3] А что у Anthropic?: #%D0%90%20%D1%87%D1%82%D0%BE%20%D1%83%20Anthropic?

[4] Google: одна модель хорошо, а дюжина обновлений лучше: https://www.braintools.ru%20%D0%BE%D0%B4%D0%BD%D0%B0%20%D0%BC%D0%BE%D0%B4%D0%B5%D0%BB%D1%8C%20%D1%85%D0%BE%D1%80%D0%BE%D1%88%D0%BE,%20%D0%B0%20%D0%B4%D1%8E%D0%B6%D0%B8%D0%BD%D0%B0%20%D0%BE%D0%B1%D0%BD%D0%BE%D0%B2%D0%BB%D0%B5%D0%BD%D0%B8%D0%B9%20%D0%BB%D1%83%D1%87%D1%88%D0%B5

[5] Llama 4: гигантские цифры и скромные результаты: https://www.braintools.ru%20%D0%B3%D0%B8%D0%B3%D0%B0%D0%BD%D1%82%D1%81%D0%BA%D0%B8%D0%B5%20%D1%86%D0%B8%D1%84%D1%80%D1%8B%20%D0%B8%20%D1%81%D0%BA%D1%80%D0%BE%D0%BC%D0%BD%D1%8B%D0%B5%20%D1%80%D0%B5%D0%B7%D1%83%D0%BB%D1%8C%D1%82%D0%B0%D1%82%D1%8B

[6] Midjourney превращается в ИИ-фигму с запуском V7: #Midjourney%20%D0%BF%D1%80%D0%B5%D0%B2%D1%80%D0%B0%D1%89%D0%B0%D0%B5%D1%82%D1%81%D1%8F%20%D0%B2%20%D0%98%D0%98-%D1%84%D0%B8%D0%B3%D0%BC%D1%83%20%D1%81%20%D0%B7%D0%B0%D0%BF%D1%83%D1%81%D0%BA%D0%BE%D0%BC%20V7

[7] Qwen-3: больше, быстрее, гибриднее: https://www.braintools.ru%20%D0%B1%D0%BE%D0%BB%D1%8C%D1%88%D0%B5,%20%D0%B1%D1%8B%D1%81%D1%82%D1%80%D0%B5%D0%B5,%20%D0%B3%D0%B8%D0%B1%D1%80%D0%B8%D0%B4%D0%BD%D0%B5%D0%B5

[8] Amazon представляет Nova Act — агента, который реально что-то делает: #Amazon%20%D0%BF%D1%80%D0%B5%D0%B4%D1%81%D1%82%D0%B0%D0%B2%D0%BB%D1%8F%D0%B5%D1%82%20Nova%20Act%20%E2%80%94%20%D0%B0%D0%B3%D0%B5%D0%BD%D1%82%D0%B0,%20%D0%BA%D0%BE%D1%82%D0%BE%D1%80%D1%8B%D0%B9%20%D1%80%D0%B5%D0%B0%D0%BB%D1%8C%D0%BD%D0%BE%20%D1%87%D1%82%D0%BE-%D1%82%D0%BE%20%D0%B4%D0%B5%D0%BB%D0%B0%D0%B5%D1%82

[9] xAI: память для Grok и зрение для распознавания объектов: https://www.braintools.ru%20%D0%BF%D0%B0%D0%BC%D1%8F%D1%82%D1%8C%20%D0%B4%D0%BB%D1%8F%20Grok%20%D0%B8%20%D0%B7%D1%80%D0%B5%D0%BD%D0%B8%D0%B5%20%D0%B4%D0%BB%D1%8F%20%D1%80%D0%B0%D1%81%D0%BF%D0%BE%D0%B7%D0%BD%D0%B0%D0%B2%D0%B0%D0%BD%D0%B8%D1%8F%20%D0%BE%D0%B1%D1%8A%D0%B5%D0%BA%D1%82%D0%BE%D0%B2

[10] Perplexity расширяется: Telegram-бот и голосовой ассистент для iOS: https://www.braintools.ru%20Telegram-%D0%B1%D0%BE%D1%82%20%D0%B8%20%D0%B3%D0%BE%D0%BB%D0%BE%D1%81%D0%BE%D0%B2%D0%BE%D0%B9%20%D0%B0%D1%81%D1%81%D0%B8%D1%81%D1%82%D0%B5%D0%BD%D1%82%20%D0%B4%D0%BB%D1%8F%20iOS

[11] Новости от лидеров индустрии: #%D0%9D%D0%BE%D0%B2%D0%BE%D1%81%D1%82%D0%B8%20%D0%BE%D1%82%20%D0%BB%D0%B8%D0%B4%D0%B5%D1%80%D0%BE%D0%B2%20%D0%B8%D0%BD%D0%B4%D1%83%D1%81%D1%82%D1%80%D0%B8%D0%B8

[12] OpenAI: рост на стероидах и бешеные прогнозы: https://www.braintools.ru%20%D1%80%D0%BE%D1%81%D1%82%20%D0%BD%D0%B0%20%D1%81%D1%82%D0%B5%D1%80%D0%BE%D0%B8%D0%B4%D0%B0%D1%85%20%D0%B8%20%D0%B1%D0%B5%D1%88%D0%B5%D0%BD%D1%8B%D0%B5%20%D0%BF%D1%80%D0%BE%D0%B3%D0%BD%D0%BE%D0%B7%D1%8B

[13] Anthropic: интерпретируемость и сознание: https://www.braintools.ru%20%D0%B8%D0%BD%D1%82%D0%B5%D1%80%D0%BF%D1%80%D0%B5%D1%82%D0%B8%D1%80%D1%83%D0%B5%D0%BC%D0%BE%D1%81%D1%82%D1%8C%20%D0%B8%20%D1%81%D0%BE%D0%B7%D0%BD%D0%B0%D0%BD%D0%B8%D0%B5

[14] Google выпускает TPUv7s: чип Ironwood для эпохи инференса: https://www.braintools.ru%20%D1%87%D0%B8%D0%BF%20Ironwood%20%D0%B4%D0%BB%D1%8F%20%D1%8D%D0%BF%D0%BE%D1%85%D0%B8%20%D0%B8%D0%BD%D1%84%D0%B5%D1%80%D0%B5%D0%BD%D1%81%D0%B0

[15] Интересные открытия: #%D0%98%D0%BD%D1%82%D0%B5%D1%80%D0%B5%D1%81%D0%BD%D1%8B%D0%B5%20%D0%BE%D1%82%D0%BA%D1%80%D1%8B%D1%82%D0%B8%D1%8F

[16] Tinder запускает ИИ-функцию для оценки навыков флирта: #Tinder%20%D0%B7%D0%B0%D0%BF%D1%83%D1%81%D0%BA%D0%B0%D0%B5%D1%82%20%D0%98%D0%98-%D1%84%D1%83%D0%BD%D0%BA%D1%86%D0%B8%D1%8E%20%D0%B4%D0%BB%D1%8F%20%D0%BE%D1%86%D0%B5%D0%BD%D0%BA%D0%B8%20%D0%BD%D0%B0%D0%B2%D1%8B%D0%BA%D0%BE%D0%B2%20%D1%84%D0%BB%D0%B8%D1%80%D1%82%D0%B0

[17] Открытие исходного кода AlexNet: ключевая веха в истории ИИ: https://www.braintools.ru%20%D0%BA%D0%BB%D1%8E%D1%87%D0%B5%D0%B2%D0%B0%D1%8F%20%D0%B2%D0%B5%D1%85%D0%B0%20%D0%B2%20%D0%B8%D1%81%D1%82%D0%BE%D1%80%D0%B8%D0%B8%20%D0%98%D0%98

[18] Новые инструменты: #%D0%9D%D0%BE%D0%B2%D1%8B%D0%B5%20%D0%B8%D0%BD%D1%81%D1%82%D1%80%D1%83%D0%BC%D0%B5%D0%BD%D1%82%D1%8B

[19] Для дизайна и контента: #%D0%94%D0%BB%D1%8F%20%D0%B4%D0%B8%D0%B7%D0%B0%D0%B9%D0%BD%D0%B0%20%D0%B8%20%D0%BA%D0%BE%D0%BD%D1%82%D0%B5%D0%BD%D1%82%D0%B0

[20] Для обучения и развлечений: #%D0%94%D0%BB%D1%8F%20%D0%BE%D0%B1%D1%83%D1%87%D0%B5%D0%BD%D0%B8%D1%8F%20%D0%B8%20%D1%80%D0%B0%D0%B7%D0%B2%D0%BB%D0%B5%D1%87%D0%B5%D0%BD%D0%B8%D0%B9

[21] Исследования на почитать: #%D0%98%D1%81%D1%81%D0%BB%D0%B5%D0%B4%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D1%8F%20%D0%BD%D0%B0%20%D0%BF%D0%BE%D1%87%D0%B8%D1%82%D0%B0%D1%82%D1%8C

[22] Заключение: #%D0%97%D0%B0%D0%BA%D0%BB%D1%8E%D1%87%D0%B5%D0%BD%D0%B8%D0%B5

[23] выпустила: https://openai.com/index/gpt-4-1/

[24] тут: https://cookbook.openai.com/examples/gpt4-1_prompting_guide

[25] выпустила: https://openai.com/index/introducing-o3-and-o4-mini/

[26] соцсетях: https://www.reddit.com/r/singularity/comments/1k2lap5/epoch_ai_has_released_o3_o4mini_gpt41_gpt41_mini/

[27] Codex: https://github.com/openai/codex

[28] станет доступна: https://x.com/OpenAI/status/1915505959931437178

[29] получил глобальную память: https://community.openai.com/t/chatgpt-can-now-reference-all-past-conversations-april-10-2025/1229453

[30] Источник изображения: https://help.openai.com/en/articles/8590148-memory-faq

[31] Research: https://www.anthropic.com/news/research

[32] представила: https://www.anthropic.com/news/introducing-claude-for-education

[33] мышление: http://www.braintools.ru/thinking

[34] провела: https://www.anthropic.com/news/anthropic-education-report-how-university-students-use-claude

[35] Claude Max: https://www.anthropic.com/news/max-plan

[36] интервью TechCrunch: https://techcrunch.com/2025/04/09/anthropic-rolls-out-a-200-per-month-claude-subscription/

[37] Gemini 2.5 Flash: https://deepmind.google/technologies/gemini/flash/

[38] Источник изображения: https://developers.googleblog.com/en/start-building-with-gemini-25-flash/

[39] математике: http://www.braintools.ru/article/7620

[40] выпустила: https://blog.google/products/gemini/video-generation/

[41] получил: https://blog.google/products/search/ai-mode-multimodal-search/

[42] Gemini Live: https://store.google.com/intl/en/ideas/articles/gemini-camera-updates/

[43] Firebase Studio: https://firebase.studio/

[44] Llama 4: https://ai.meta.com/blog/llama-4-multimodal-intelligence/

[45] обучения: http://www.braintools.ru/article/5125

[46] опубликовать: https://huggingface.co/spaces/lmarena-ai/Llama-4-Maverick-03-26-Experimental_battles

[47] выпустила: https://www.midjourney.com/updates/v7-alpha

[48] Источник изображения: https://www.midjourney.com/updates

[49] Полностью обновился: https://www.midjourney.com/updates/editor-improvements-a

[50] Qwen-3: https://qwenlm.github.io/blog/qwen3/

[51] Github: https://github.com/QwenLM/Qwen3

[52] Hugging Face: https://huggingface.co/collections/Qwen/qwen3-67dd247413f0e2e4f653967f

[53] тут: https://chat.qwen.ai

[54] показала Nova Act: https://labs.amazon.science/blog/nova-act

[55] Источник изображения: https://nova.amazon.com/chat

[56] nova.amazon.com: http://nova.amazon.com

[57] добавила: https://x.com/grok/status/1912670182012801156?ref_src=twsrc%5Etfw

[58] анонсирован: https://x.com/ebbyamir/status/1914820712092852430

[59] продолжает: https://t.me/perplexity_ai/189

[60] юмор: http://www.braintools.ru/article/3517

[61] анонсирован: https://t.me/perplexity_ai/192

[62] тут: https://beta.lmarena.ai/

[63] Sentiment Control: https://blog.lmarena.ai/blog/2025/sentiment-control/

[64] воспользовались: https://x.com/bradlightcap/status/1907810330018726042

[65] Источник изображения: https://x.com/sama/status/1906771292390666325

[66] опубликовал: http://www.darioamodei.com/post/the-urgency-of-interpretability

[67] поведение: http://www.braintools.ru/article/9372

[68] запускает программу: https://www.anthropic.com/research/exploring-model-welfare

[69] TPUv7s: https://blog.google/products/google-cloud/ironwood-tpu-age-of-inference/

[70] памяти: http://www.braintools.ru/article/4140

[71] прогнозам: https://www.iea.org/reports/energy-and-ai

[72] Источник изображения: https://www.iea.org/reports/energy-and-ai/energy-supply-for-ai

[73] представляет: https://www.tinderpressroom.com/2025-04-01-Tinders-The-Game-GameTM-Isnt-About-Getting-It-Right-Its-About-Getting-Comfortable-Before-Meeting-IRL

[74] опубликовал: https://computerhistory.org/blog/chm-releases-alexnet-source-code/

[75] зрении: http://www.braintools.ru/article/6238

[76] интеллекта: http://www.braintools.ru/article/7605

[77] GitHub-странице: https://github.com/computerhistory/AlexNet-Source-Code

[78] Devin 2.0: https://devin.ai/

[79] Agent2Agent: https://github.com/google/A2A

[80] pgledger: https://github.com/pgr0ss/pgledger

[81] Versatile OCR Pipeline: https://github.com/ses4255/Versatile-OCR-Program

[82] dayplot: https://pypi.org/project/dayplot/0.3.0/

[83] Local Deep Research: https://github.com/LearningCircuit/local-deep-research

[84] GitDiagram: https://gitdiagram.com/

[85] Oxy: https://github.com/oxy-hq/oxy

[86] plumber2: https://posit-dev.github.io/plumber2/index.html

[87] GeoAI: https://geoai.gishub.org/

[88] WhoDB: https://github.com/clidey/whodb

[89] SQLite File Format Viewer: https://sqlite-internal.pages.dev/?utm_campaign=Data_Elixir&utm_source=Data_Elixir_531

[90] Pydantic Evals: https://ai.pydantic.dev/evals/

[91] PDF craft: https://github.com/oomol-lab/pdf-craft

[92] Exponent: https://www.exponent.run/

[93] Kling AI 2.0: http://www.klingai.com/

[94] AI Infographics: https://infographics.so/#hero

[95] WordPress.com: http://WordPress.com

[96] AI site builder: https://wordpress.com/ai-website-builder/

[97] Krea AI: https://www.krea.ai/

[98] FluentSubs: https://fluentsubs.com/

[99] Ai2 Paper Finder: https://paperfinder.allen.ai/

[100] Grimo: https://beta.grimo.ai/

[101] Zycko: https://www.zycko.com/tools/prompt-generator

[102] Практический гайд по разработке агентов от OpenAI: http://cdn.openai.com/business-guides-and-resources/a-practical-guide-to-building-agents.pdf

[103] Гайд по вайб-кодингу от Anthropic: https://www.anthropic.com/engineering/claude-code-best-practices

[104] внимание: http://www.braintools.ru/article/7595

[105] Достижения и вызовы в области фундаментальных агентов: https://arxiv.org/pdf/2504.01990v1

[106] мозга: http://www.braintools.ru/parts-of-the-brain

[107] Воплощенный ИИ: тенденции и вызовы: https://scispace.com/pdf/embodied-artificial-intelligence-trends-and-challenges-2bemyq80pb.pdf

[108] Проект «Будущее ИИ»: https://ai-2027.com/

[109] Будущее научного письма: ИИ-инструменты, преимущества и этические последствия: https://www.researchgate.net/publication/390562286_The_Future_of_Scientific_Writing_AI_Tools_Benefits_and_Ethical_Implications

[110] Вызовы и возможности для ИИ в аудите: https://www.sciencedirect.com/science/article/pii/S1467089525000107

[111] ошибки: http://www.braintools.ru/article/4192

[112] Большие языковые модели проходят тест Тьюринга: https://arxiv.org/pdf/2503.23674v1

[113] Доказательство или блеф? Оценка LLM на математической олимпиаде США 2025: https://arxiv.org/pdf/2503.21934v1

[114] Никаких слонов: прорывы в генерации изображений: https://www.oneusefulthing.org/p/no-elephants-breakthroughs-in-image

[115] Liquid: языковые модели как масштабируемые и унифицированные мультимодальные генераторы: https://arxiv.org/pdf/2412.04332v4

[116] FUSION: полная интеграция визуально-языковых представлений: https://arxiv.org/pdf/2504.09925v1

[117] Seaweed-7B: экономичное обучение фундаментальной модели генерации видео: https://arxiv.org/pdf/2504.08685v1

[118] M1: к масштабируемым вычислениям во время тестирования с моделями рассуждения Mamba: https://arxiv.org/pdf/2504.10449v1

[119] S1-Bench: простой бенчмарк для оценки способности к «мышлению первого типа»: https://arxiv.org/pdf/2504.10368v1

[120] PaperBench: оценка способности ИИ воспроизводить исследования в области ИИ: https://arxiv.org/pdf/2504.01848v1

[121] OpenAI открывает исходный код BrowseComp: https://cdn.openai.com/pdf/5e10f4ab-d6f7-442e-9508-59515c65e35d/browsecomp.pdf

[122] RoboVerse: платформа для обучения роботов: https://arxiv.org/abs/2504.18904

[123] Семплируй, не ищи: переосмысление выравнивания во время теста: https://arxiv.org/pdf/2504.03790v1

[124] Генерация минутного видео с обучением во время тестирования: https://arxiv.org/pdf/2504.05298v1

[125] OLMoTrace: отслеживание выходных данных языковой модели до обучающих токенов: https://arxiv.org/pdf/2504.07096v1

[126] TransMamba: гибкое переключение между Transformer и Mamba: https://arxiv.org/pdf/2503.24067v1

[127] Масштабирование вычислений во время вывода для сложных задач: https://arxiv.org/pdf/2504.00294v1

[128] Источник: https://habr.com/ru/companies/magnus-tech/articles/906090/?utm_source=habrahabr&utm_medium=rss&utm_campaign=906090

Нажмите здесь для печати.