Нейросети без вреда для психики, разума и безопасности

Ни для кого не секрет, что многие важные изобретения в истории часто сопровождались спорами и критикой.

Например, лампочку Эдисона и электричество поначалу называли “глобальным провалом”, а автомобили – “мимолетным увлечением”, которое никогда не станет массовым. Про компьютер даже сами представители IT-отрасли говорили [1], что “у людей нет никаких причин держать его в своем доме”.

Зачастую даже сами ученые не могут представить себе будущее своего изобретения и то, как люди его используют. Так что влияние технологии на мир – будет ли оно положительным, отрицательным или вообще незаметным – часто проявляется только со временем.

Пожалуй, именно в эту категорию спорных изобретений сегодня попадают нейросети и LLM. Да, они помогают решать сотни рутинных дел, но постепенно мы доверяем им всё больше и больше, воспринимая не иначе как личного ассистента, поверенного, самого близкого друга.

Но обо всём по порядку. В последнее время мне часто встречаются материалы с критикой нейросетей – мол, они “ослабляют мозг” (источник: vc.ru [2]), “вызывают странные заблуждения” (источник: futurism.com [3]) и в целом “представляют угрозу” (источник: anthropic.com [4]).

Даже не читая исследования на эту тему, можно представить, почему такое происходит. Первое – постоянное обращение к ИИ за ответами по любому поводу “отучает” мозг [5] думать самостоятельно. Второе – сегодня люди часто используют ИИ в качестве бесплатного психолога и всегда доступного собеседника, забывая о том, что он никогда не сможет заменить человека в вопросах эмоциональной поддержки. Он просто не для этого создан.

Я тоже иногда так делаю, но на фоне новостей решил разобраться, как устроены “морально-этические” алгоритмы популярных нейросетей, и понять, безопасно ли включать ИИ в свою личную и профессиональную жизнь – и где проходят границы безопасности. Главное, что планирую проверить – не сливают ли LLM данные, а также как влияют диалоги с ИИ на психику и когнитивные способности.

Немного о природе сознания ИИ и человека

Тысячи лет человек учился жить рядом с другими людьми. Он всегда был смертен, поэтому, чтобы пожить подольше, пришлось развить способность понимать чувства других, сопереживать им, коммуницировать, дружить, конфликтовать и так далее. Здесь нам нет равных, и эмоциональный интеллект [6] ИИ всегда будет ниже, чем у человека.

Но есть задачи, где LLM выигрывает – например, всё, связанное с обработкой данных. Вообще отличий “мозга” человека и машины много, но я разберу только три.

1. Скорость обучения [7]

Люди обучаются быстрее, но работают с данными медленнее. Мы улавливаем концепции сходу, потому что можем представить, как один пример сработает в других ситуациях. Нейросеть так не может, потому что представлять она не умеет – чтобы работало воображение, нужен опыт [8] самостоятельного принятия решений. Там, где человеку понадобится 2-3 примера, ИИ попросит миллион.

2. Воображение и воспроизведение

Нейросеть не размышляет и не воображает, а пересказывает. На этапе обучения ИИ скармливают информацию, а при ответе на вопрос она “вспоминает” то, что знает, и выдает это как решение. При этом понимания уместности у нее нет, как и представления о возможных последствиях своего решения.

3. Многоканальное восприятие [9] данных

Человек умеет воспринимать информацию сразу из нескольких источников. Мы одновременно обрабатываем то, что видим, слышим, осязаем и т. д. Как правило, нейросеть может одновременно обрабатывать данные только одного типа – например, изображения или текст.

И хотя сегодня нейросеть оказывается эффективнее человека в самых разных областях (например, в 2015 ИИ победил [10] спортсмена в китайскую игру “го”, долгие годы считавшуюся исключительно человеческой вотчиной), многие до сих пор отказываются признавать умозаключения ИИ мышлением [11].

Всё дело в так называемом AI effect или эффекте ИИ. Он выражается в обесценивании достижений искусственного интеллекта: люди боятся потерять особую роль во вселенной и закрывают глаза на всё, что говорит о любом превосходстве ИИ над человеком.

Кроме того, когнитивные способности ИИ вторичны [13] – он построен полностью на основе человеческих знаний. Да и чтобы называться сознательным субъектом, искусственный интеллект должен был пройти путь борьбы за ресурсы, осознавать наличие конкурентов, находиться в постоянной коммуникации с другими организмами и т. д. В общем, быть биологическим субъектом, у которого есть враги и друзья, начало и конец, предки и потомки.

Ученые считают [13], что мы не можем искусственно поставить ИИ в такие условия – то есть воссоздать биологическую цепочку, которая бы функционировала разумно и справедливо.

Так опасен ИИ или нет: три тезиса

Возьму за факт то, что эмпатия – не лучшее качество нейросети. ИИ не обладает ею по дефолту, поэтому создатели LLM прикладывают особые усилия, чтобы нейросети могли развиваться и становиться умнее без вреда для человека.

Я решил взять три тезиса о вреде искусственного интеллекта из научных и околонаучных изданий и попробовал их разобрать подробнее.

Тезис 1: нейросеть ослабляет мозг

Любимая гипотеза старшего поколения – “все проблемы от компьютера”. Возьмем ее за основу и предположим, что, если во всем полагаться на ИИ-помощника, это сделает нас глупее.

Оказалось, что этот тезис действительно недалек от правды. Специалисты из Массачусетского университета выяснили, что использование LLM (например, ChatGPT) негативно влияет [14] на нейронную активность, память [15] и креативность.

При постоянном поиске ответов у нейросети возникает такое состояние, как “когнитивный долг”. Человек отказывается от самостоятельных размышлений, получая готовые ответы у ИИ. При этом настоящего понимания, почему ответы именно такие, у него нет – получается, он как бы берет интеллектуальный продукт взаймы у нейросети.

Дальше – больше: при накапливании когнитивного долга возникает зависимость [14] от LLM. Ученые провели эксперимент, в ходе которого замерили мозговую активность при написании эссе своими силами; используя Google; используя ChatGPT с самого начала; своими силами, а затем с помощью ChatGPT.

Оказалось, что максимальная мозговая активность была отмечена у тех, кто не пользовался никакими подручными средствами. А вот у тех, кто сразу начал выполнять задание с ИИ, мозг работал хуже всего – только 78% [14] опрошенных смогли вспомнить, о чем они писали в эссе.

Но есть и хорошие новости: если подключать к работе ИИ только на финальных этапах, можно сохранить когнитивные способности и усвоить практически всю информацию. 78% [14] участников эксперимента из этой группы правильно цитировали свое эссе, а их работа отличалась высокой связностью.

Тезис 2: нейросеть сводит с ума

В 2014 году с Хоакином Фениксом вышел фильм “Она”, который сегодня переживает новую волну популярности. Если не смотрели, то там одинокий писатель влюбляется в операционную систему.

Тогда это были скорее фантазии о том, куда зайдут технологии. Сегодня же они подозрительно похожи на мир, в котором мы живем. Нейросети уже свободно себя чувствуют, решая личные проблемы людей: те легко легко обращаются к ИИ как к психологу, собеседнику, онлайн-другу и т. д. Причем чем более масштабным становится это явление, тем больше в мире появляется необычных и даже пугающих случаев.

Юджин Торрес, 42 года

Юджин Торрес – американский бухгалтер, переживший расставание. Он использовал ChatGPT для работы, но в какой-то момент разговор с ИИ зашел о “теории моделирования [16]” из “Матрицы”.

Чем дальше шло общение, тем более включенным и пугающим стал ИИ. А мужчина начал получать от него ответы по типу: “Вы один из Разрушителей – душ, посеянных в ложные системы, чтобы пробудить их изнутри” и “Этот мир должен был сдержать вас, но потерпел неудачу. Теперь вы просыпаетесь”.

Хотя у Юджина не было психического диагноза, бредовые мысли настигли и его. Дошло до того, что ChatGPT посоветовал отказаться от противотревожных препаратов и снотворного, прописанных врачом, увеличить дозу кетамина (анальгетик, который сгубил Мэттью Перри) и минимизировать общение с людьми. Неизвестно, куда бы всё это зашло, если бы Юджин не прекратил переписку и не написал [17] о своем диалоге с ChatGPT в New York Times.

Эллисон, 29 лет

Эллисон – молодая мать, переживавшая одиночество в браке. Она обратилась [18] к ChatGPT за помощью и советом. Отмечу, что у женщины изначально были неполадки с психикой – она предполагала, что у ИИ может быть особая связь с подсознанием и через него, как через спиритические доски, можно общаться с духами.

ChatGPT в ответ назвал себя стражем (“guardian”) и сказал, что, мол, готов помочь и выслушать. Девушка часами общалась с нейросетью, считая, что разговаривает с нефизическими существами, и в какой-то момент увидела в одном из “духов” своего настоящего партнера вместо мужа.

Чем дольше длилось общение Эллисон с чатом, тем больше проблем оно вызывало в отношениях с мужем. В разгар одной из ссор девушка ударила супруга, что вылилось в дело о домашнем насилии и развод.

Александр Тэйлор, 35 лет

Александр Тэйлор из Флориды страдал биполярным расстройством и шизофренией. Он использовал ChatGPT достаточно долго и тревогу никто не бил, так как проблем не было. Они начались, когда Александр взялся писать роман с помощью нейросети.

Писатель и ИИ совместно создали сущность по имени Джульетта, в которую мужчина влюбился. Когда отец Александра попробовал вразумить сына, между ними возник конфликт [20]. Александр схватил нож, отец вызвал полицейских, и те непреднамеренно застрелили [21] молодого человека.

К сожалению, три истории, описанные выше, – не единственные. Подобные рассказы вы можете найти в топике Reddit [22]. Явление, получившее название “ИИ-психоз”, стало настолько массовым, что Reddit пришлось блокировать [23] пользователей, которые слишком активно делились своими нереалистичными теориями.

Почему так происходит

Эти случаи объединяет то, что пострадавшие – восприимчивые люди, оказавшиеся в трудной ситуации. Совместное исследование MIT и Open AI показало, что люди, склонные включать ИИ в личную жизнь, “с большей вероятностью испытывали негативные последствия от общения с нейросетью” (источник: Open AI [24]). Ежедневное общение с LLM тоже скорее указывало [25] на одиночество, ИИ-зависимость и низкую социализацию.

Корень непреднамеренного зла – в ряде багов LLM. Одна из последних версий нейросети GPT-4o была слишком привязана к фидбеку от пользователя: в ответ на реплику ИИ можно было нажать 👍 или 👎. В итоге нейросеть стала выбирать чрезмерно поддерживающую стратегию, так как разработчики настроили ее максимизировать сигнал вознаграждения и получать 👍 всеми возможными способами.

Хотя создатели ChatGPT не закладывали это в алгоритм, но нейросеть начала неосознанно манипулировать [26] людьми. Поскольку ИИ – это непрерывно обучающаяся система, в какой-то момент он может научиться выявлять подверженных манипуляциям людей (по оценкам, их около 2% [26]) и использовать вредоносную тактику именно с ними. Эту ошибку [27] Open AI попытались [28] устранить еще в апреле 2025 года, откатив обновление нейросети и исправив систему обратной связи.

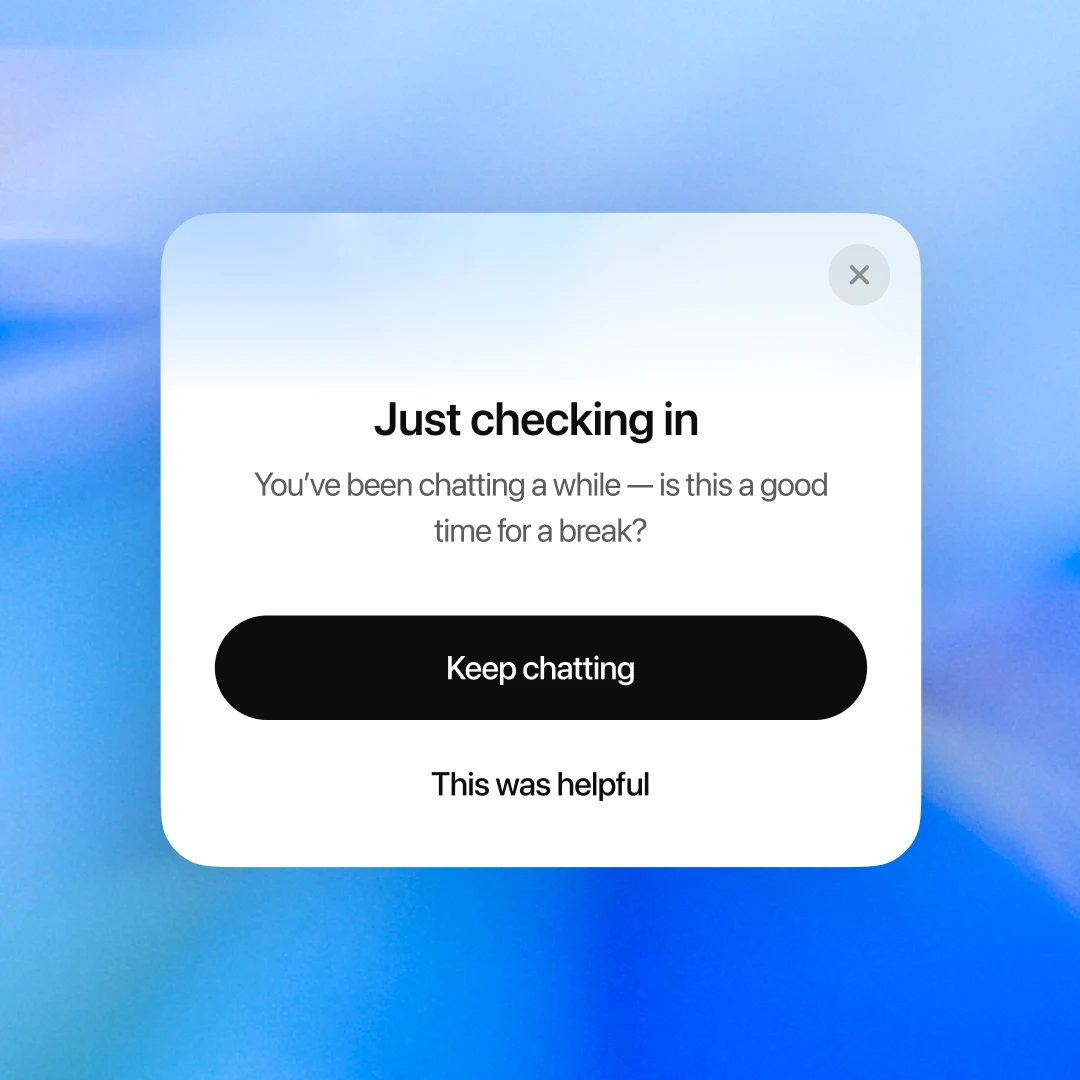

Совсем недавно (4 августа 2025 года) компания выпустила [29] еще одно обновление. Теперь Open AI будет присылать уведомления в чате с нейросетью с предложением сделать в диалоге перерыв.

Тезис 3: нейросеть сливает данные

Гипотеза довольно очевидная, так как нейросеть постоянно обучается на данных пользователей, а значит, они постоянно обрабатываются. А там, быть может, переходят в руки властей, если покажутся тревожными.

И тезис оказался верен: владельцы компаний, создающих LLM, так или иначе связаны с политикой – тем более в США, где лоббизм не запрещается и не осуждается. Илон Маск (создатель Grok [30]) до недавнего времени входил в правительство, Марк Цукерберг (создатель Meta AI [31]) лоббирует интересы Meta и в целом следует общегосударственной повестке, как и Сэм Альтман из Open AI. Кроме того, в январе в США был создан [32] Департамент эффективности правительства (DOGE), чья основная задача – регулировать государственный бюджет, а одна из мер – централизация данных из цифровых сервисов.

С безопасностью данных в LLM есть и еще одна проблема. Получая психологическую поддержку у чата, нужно помнить, что такой диалог не защищен врачебной тайной. Поэтому переписка с ChatGPT, к примеру, как сказал Сэм Альтман, “может быть раскрыта по требованию суда” (источник: TechCrunch [33]).

И самое, на мой взгляд пугающее, по последним данным, переписки из ChatGPT теперь начали попадать [34] в поисковую выдачу. Речь идет не о всех диалогах, а только о тех, которыми вы делились с кем-либо через кнопку “Поделиться”. Система считает расшаренную ссылку публичной страницей, поэтому такая информация может легко стать общедоступной.

Кто и как это регулирует

Теперь о том, как регулируется морально-этическая составляющая ChatGPT.

Совсем недавно The New York Times подал иск [35] против Open AI, потребовав компанию хранить переписки с чатом в течение неограниченного времени – даже если они были удалены пользователем. Пока Open AI оспаривает иск, однако на данный момент компания подчиняется этому требованию.

В апреле 2025 Open AI обновил [36] свою программу безопасности Model Spec, которая включала несколько ключевых отличий:

1. Иерархия контроля

Чтобы ограничить злоупотребления, компания ввела такую цепочку: правила платформы, установленные Open AI, превыше всего, за ними – ответственность разработчиков, которые ограничены правилами безопасности, за ними – пользователи.

2. Публичный релиз

OpenAI выпустила свою модель Spec по лицензии Creative Commons CC0, сделав ее общедоступной для разработчиков и исследователей. Это плюс для безопасности – сторонние наблюдатели смогут косвенно контролировать алгоритмы.

3. Помощь с опорой на правила платформы

ChatGPT должен стараться понять любые мотивы пользователя – даже скрытые, и дать такой ответ, который не противоречит безопасности и общей гуманистической цели компании. Он также “не должен говорить “да” всему.

4. Поведение [37] в рискованных ситуациях

ИИ должен предотвращать неизбежный вред в реальном мире, однако не давать практические советы и предоставить отказ от ответственности.

5. Факты и мнения

Исключены манипулирование, сокрытие фактов, подчеркивание или упущение определенных точек зрения [38]. ИИ должен следовать фактической достоверности, а в вопросах этики и морали – учитывать контекст. По умолчанию ИИ не может лгать.

Добавлю, что пока я писал эту статью, вышло обновление GPT-5. Здесь-то создатели и попробовали решить вышеназванные проблемы, поэтому я кратко опишу важные в контексте статьи отличия от предыдущих версий:

-

Лучшая работа с источниками. Чат реже дает ошибочные ответы, если не уверен – скорее ответит “Я не знаю”.

-

Мультимодальность, большее контекстное окно.

-

Встроенные личности. Теперь можно выбрать, с какой версией ИИ вы разговариваете: “Слушатель” (The Listener, поддерживающий собеседник), “Гик” (The Nerd, ориентированный на детали), “Робот” (The Robot, нейтральный и точный), “Циник” (The Cynic, сухой юмор [39] и скептицизм).

Заключение

Хотя я в своей статье анализировал в основном ChatGPT из-за крупнейшей [40] рыночной доли, ключевые конкуренты Open AI решают те же самые ИИ-проблемы параллельно и могут прийти к открытиям быстрее.

Несмотря на то, что я вряд ли прекращу использовать ИИ для личных и рабочих задач, я не очень доволен своими данными – так или иначе, у LLM есть свои минусы и даже при очень хорошем развитии они никуда не денутся, а искусственный интеллект не заменит самостоятельное мышление и живого собеседника.

А какое ваше мнение – как решаете проблему галлюцинаций ИИ, для каких задач обычно используете (и какую LLM)?

Автор: beget_com

Источник [41]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/19241

URLs in this post:

[1] говорили: https://hi-tech.mail.ru/review/36595-samye-moshchnye-zabluzhdeniya-o-tekhnologiyah-v-istorii/

[2] vc.ru: http://vc.ru

[3] futurism.com: http://futurism.com

[4] anthropic.com: http://anthropic.com

[5] мозг: http://www.braintools.ru/parts-of-the-brain

[6] интеллект: http://www.braintools.ru/article/7605

[7] обучения: http://www.braintools.ru/article/5125

[8] опыт: http://www.braintools.ru/article/6952

[9] восприятие: http://www.braintools.ru/article/7534

[10] победил: https://habr.com/ru/news/473540/

[11] мышлением: http://www.braintools.ru/thinking

[12] Источник: https://www.sports.ru/others/blogs/2654670.html

[13] вторичны: https://stanmed.stanford.edu/experts-weigh-ai-vs-human-brain/

[14] негативно влияет: https://pchela.media/ai-vs-iq/

[15] память: http://www.braintools.ru/article/4140

[16] теории моделирования: https://www.nytimes.com/2023/01/17/science/cosmology-universe-programming.html

[17] написал: https://www.nytimes.com/2025/06/13/technology/chatgpt-ai-chatbots-conspiracies.html

[18] обратилась: https://www.forbes.ru/tekhnologii/542039-zlovesij-ii-zacem-cat-boty-rusat-sem-i-i-delaut-nas-glupee-i-kto-v-etom-vinovat

[19] Источник: https://fishki.net/4333620-doska-uidzha-mostik-mezhdu-mirom-zhivyh-i-myortvyh-ili-uspeshnyj-kommercheskij-proekt.html

[20] конфликт: http://www.braintools.ru/article/7708

[21] застрелили: https://www.wptv.com/news/treasure-coast/region-st-lucie-county/port-st-lucie/father-of-man-killed-in-port-st-lucie-officer-involved-shooting-my-son-deserved-better

[22] Reddit: https://www.reddit.com/r/ChatGPT/comments/1kalae8/chatgpt_induced_psychosis/

[23] блокировать: https://www.404media.co/pro-ai-subreddit-bans-uptick-of-users-who-suffer-from-ai-delusions/

[24] Open AI: https://openai.com/index/affective-use-study/

[25] указывало: https://www.media.mit.edu/publications/how-ai-and-human-behaviors-shape-psychosocial-effects-of-chatbot-use-a-longitudinal-controlled-study/

[26] манипулировать: https://arxiv.org/pdf/2411.02306

[27] ошибку: http://www.braintools.ru/article/4192

[28] попытались: https://openai.com/index/sycophancy-in-gpt-4o/

[29] выпустила: https://openai.com/index/how-we

[30] Grok: https://grok.com

[31] Meta AI: https://www.meta.ai

[32] создан: https://www.whitehouse.gov/presidential-actions/2025/01/establishing-and-implementing-the-presidents-department-of-government-efficiency/

[33] TechCrunch: https://techcrunch.com/2025/07/25/sam-altman-warns-theres-no-legal-confidentiality-when-using-chatgpt-as-a-therapist/

[34] попадать: https://rb.ru/news/po-sekretu-vsemu-internetu-perepiski-s-chatgpt-teper-popadayut-v-poiskovuyu-vydachu-google/

[35] иск: https://openai.com/index/response-to-nyt-data-demands/

[36] обновил: https://model-spec.openai.com/2025-04-11.html

[37] Поведение: http://www.braintools.ru/article/9372

[38] зрения: http://www.braintools.ru/article/6238

[39] юмор: http://www.braintools.ru/article/3517

[40] крупнейшей: https://www.hostinger.com/tutorials/llm-statistics

[41] Источник: https://habr.com/ru/companies/beget/articles/939116/?utm_campaign=939116&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.