Введение

Представьте: вы показываете нейросети фотографию кота, и она уверенно говорит «кот». Отлично! Но почему она так решила? Увидела усы? Уши? Или, может быть, диван на заднем плане, потому что в обучающей выборке коты часто лежали на диванах?

Нейросети называют «чёрными ящиками» не просто так. Внутри типичной модели для распознавания изображений — миллионы параметров, организованных в десятки слоёв. Данные проходят через эту махину, и на выходе появляется ответ. Но что происходит между входом и выходом — загадка даже для создателей модели.

Это не просто академическое любопытство. Когда нейросеть решает, давать ли вам кредит, ставит медицинский диагноз или управляет автомобилем — хочется понимать, на что она опирается. Не выучила ли она какие-то странные закономерности? Не обманется ли на необычных данных?

Хорошая новость: способы заглянуть внутрь существуют. Один из самых наглядных — Activation Maximization, или метод максимальной активации. Его идея проста и красива: мы буквально спрашиваем у каждого нейрона, что он хочет увидеть больше всего. А потом смотрим на ответ.

В этой статье разберём, как работает этот метод, что можно увидеть с его помощью, и почему это полезно не только исследователям, но и практикующим инженерам.

Что такое Activation Maximization

Нейрон как детектор

Чтобы понять метод, сначала разберёмся, что делает отдельный нейрон в свёрточной сети.

Каждый нейрон — это маленький детектор. Он смотрит на небольшую область изображения и выдаёт число: насколько сильно то, что он видит, похоже на то, что он ищет. Чем больше число (активация) — тем сильнее совпадение.

Нейроны на ранних слоях ищут простые штуки: вертикальные линии, горизонтальные линии, переходы от светлого к тёмному. Нейроны глубже — комбинации этих простых паттернов. А нейроны в конце сети могут реагировать на сложные концепты: лица, колёса, текст.

Но вот вопрос: как узнать, что именно ищет конкретный нейрон?

«О чём ты мечтаешь?»

Идея Activation Maximization гениально проста. Вместо того чтобы гадать, мы спрашиваем у нейрона напрямую.

Представьте, что вы можете менять входное изображение как угодно. Ваша цель — сделать так, чтобы выбранный нейрон «завопил» от восторга, выдал максимально возможную активацию. Какую картинку вы получите в итоге?

Это и будет ответ на вопрос «что ищет этот нейрон». Если нейрон отвечает за распознавание глаз — на картинке появятся глаза. Если за текстуру меха — увидим что-то пушистое. Если за круглые формы — получим круги.

По сути, мы просим нейросеть нарисовать «идеальный вход» с точки зрения конкретного нейрона. Его мечту.

Как это работает

Градиентный подъём по картинке

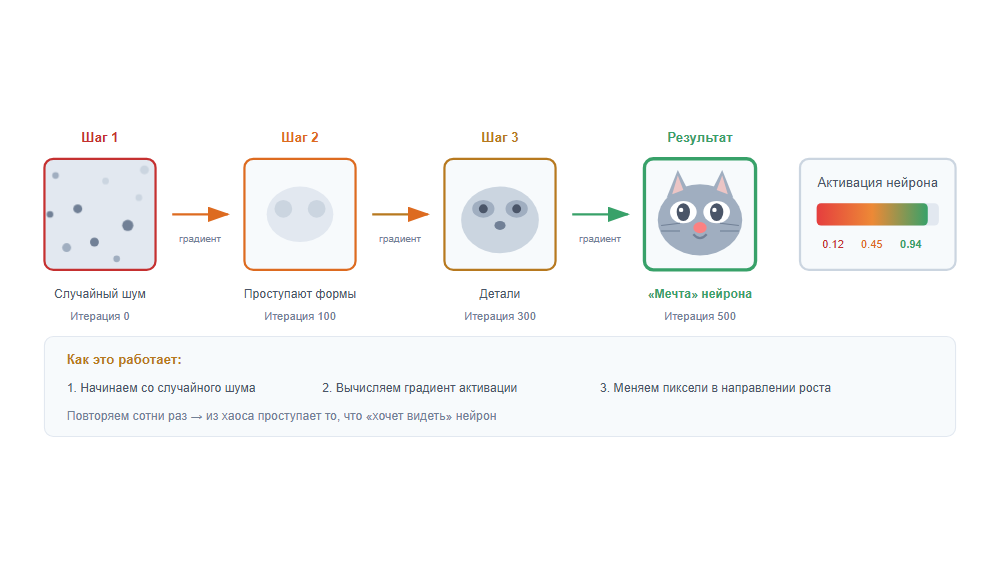

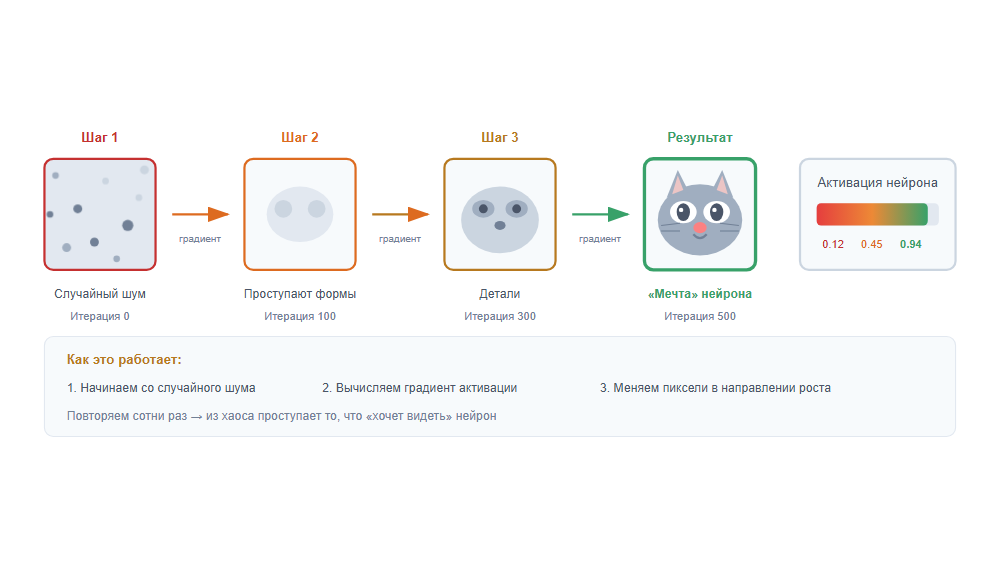

Технически процесс выглядит так:

1. Выбираем нейрон, который хотим исследовать — например, нейрон номер 42 на третьем слое.

2. Начинаем с шума — создаём случайное изображение, просто пиксельная каша.

3. Прогоняем через сеть — смотрим, какую активацию выдал наш нейрон.

4. Вычисляем градиент — определяем, как нужно изменить каждый пиксель, чтобы активация выросла.

5. Немного меняем картинку в направлении градиента.

6. Повторяем шаги 3–5 сотни или тысячи раз.

С каждой итерацией изображение всё больше «нравится» нейрону. Из хаоса постепенно проступают паттерны — то, что нейрон научился распознавать.

Проблема: каша вместо картинки

Если делать всё в лоб, результат разочарует. Получится что-то вроде психоделического шума — технически нейрон счастлив, но человек ничего не понимает. Картинка эксплуатирует «баги» в восприятии нейрона: высокочастотные паттерны, которые никогда не встретятся в реальных данных.

Регуляризация: учим мечтать красиво

Решение — добавить ограничения, которые делают результат более «естественным»:

– Штраф за резкие переходы — изображение должно быть гладким, без пиксельного шума

– Ограничение на яркость — пиксели не улетают в экстремальные значения

– Периодическое размытие — убирает высокочастотный мусор

– Трансформации — небольшие сдвиги и повороты картинки между итерациями

С хорошей регуляризацией результаты становятся интерпретируемыми: вместо шума видим узнаваемые паттерны.

Альтернатива: поиск в реальных данных

Есть и другой подход — вместо генерации синтетических изображений просто искать в обучающей выборке. Берём тысячи реальных картинок, прогоняем через сеть, и находим те, на которых наш нейрон активируется сильнее всего.

Плюс: видим реальные примеры, не абстракции. Минус: можем не найти «чистый» пример — реальные картинки содержат много всего, и непонятно, на что именно среагировал нейрон.

Что можно увидеть

Самое интересное начинается, когда мы применяем метод к разным слоям сети. Картина получается захватывающей.

Ранние слои: азбука зрения

Нейроны первых слоёв реагируют на базовые элементы:

– Границы и контуры разной ориентации

– Переходы цвета

– Простые текстуры — полоски, точки, решётки

Это строительные блоки, из которых сеть собирает всё остальное. Примерно как буквы в алфавите — сами по себе ничего не значат, но из них складываются слова.

Средние слои: паттерны и текстуры

Здесь становится интереснее. Нейроны начинают реагировать на комбинации базовых элементов:

– Углы и пересечения линий

– Текстуры: мех, чешуя, ткань, листва

– Повторяющиеся паттерны

– Части объектов: что-то похожее на глаз, колесо, окно

На этом уровне уже можно угадать, в какой области «специализируется» нейрон, хотя образы всё ещё довольно абстрактные.

Глубокие слои: концепты и объекты

На последних слоях перед классификатором нейроны реагируют на сложные концепции:

– Целые объекты: лица, здания, животные

– Части тела: глаза, лапы, колёса

– Сцены: небо с облаками, трава, вода

Визуализации этих нейронов часто выглядят сюрреалистично — как будто объект пытается проявиться из тумана, повторяясь и перетекая сам в себя.

DeepDream: искусство из нейронов

Вы наверняка видели эти психоделические картинки, где везде проступают глаза, собачьи морды и странные узоры. Это DeepDream — художественное применение Activation Maximization.

Идея простая: берём обычную фотографию и усиливаем то, что уже «видит» сеть. Если нейрон чуть-чуть активировался на облаке, похожем на собаку — делаем облако ещё больше похожим на собаку. Повторяем много раз, и реальность превращается в галлюцинацию нейросети.

DeepDream стал вирусным в 2015 году и показал широкой публике, что нейросети «думают» совсем не так, как люди.

Зачем это нужно на практике

Красивые картинки — это здорово, но у метода есть и практическая ценность.

Отладка моделей

Модель ошибается на определённых картинках, и непонятно почему? Activation Maximization может помочь.

Например, классификатор путает волков и хаски. Визуализируем нейроны, отвечающие за класс «волк» — и видим, что они активируются на снег. Оказывается, в обучающей выборке волки были в основном на фоне снега, а хаски — в домашней обстановке. Модель выучила не «волка», а «снежный фон».

Это называется shortcut learning — модель находит простой признак, который коррелирует с ответом, но не является настоящей причиной. Без визуализации такие баги очень сложно обнаружить.

Проверка надёжности

Перед тем как выкатить модель в продакшен, хочется убедиться, что она выучила правильные признаки.

Визуализация помогает ответить на вопросы:

– Смотрит ли модель на нужные части изображения?

– Не зацепилась ли она за артефакты разметки (водяные знаки, рамки)?

– Использует ли она признаки, которые будут работать на новых данных?

Исследование архитектур

Для исследователей визуализация — способ понять, чем отличаются разные архитектуры.

Как меняются представления при увеличении глубины сети? Что происходит при смене функции активации? Чем отличается ResNet от VGG? Визуализация даёт интуитивные ответы на эти вопросы.

Пример из жизни

В 2016 году исследователи из Google обнаружили, что их модель для определения диабетической ретинопатии (болезни глаз) иногда использовала для диагноза… артефакты на краях снимков, оставленные оборудованием клиники. Модель показывала отличные результаты на тестах, но работала неправильно. Методы визуализации помогли это обнаружить.

Ограничения метода

Было бы нечестно не упомянуть проблемы. Activation Maximization — мощный инструмент, но не серебряная пуля.

Синтетика ≠ реальность

Сгенерированные изображения — это то, что максимально активирует нейрон. Но в реальной работе нейрон встречает обычные фотографии, которые активируют его лишь частично.

Визуализация показывает «идеал» с точки зрения нейрона, а не то, как он работает на практике. Это как судить о вкусах человека по его мечтам, а не по тому, что он реально ест на обед.

Один нейрон — много смыслов

Исследователи обнаружили неприятный факт: многие нейроны полисемантичны. Один и тот же нейрон может реагировать на совершенно разные вещи — например, на кошачьи морды И на текст И на передние бамперы машин.

Это явление называется суперпозицией признаков. Сеть научилась упаковывать больше концепций, чем у неё нейронов, используя сложные комбинации. Визуализация одного нейрона в таком случае показывает странную смесь, которую сложно интерпретировать.

Зависимость от настроек

Результат сильно зависит от выбора регуляризации и гиперпараметров. Разные настройки дают разные картинки. Какая из них «правильная»? Однозначного ответа нет.

Это создаёт риск: исследователь может (сознательно или нет) подобрать параметры так, чтобы получить «красивую» или «понятную» визуализацию, которая не отражает реальную работу нейрона.

Можно обмануть

В 2023 году исследователи показали, что визуализацией можно целенаправленно манипулировать. Специально обученная сеть выдаёт красивые, интерпретируемые картинки при визуализации — но на самом деле работает совсем по-другому.

Это важно помнить: Activation Maximization показывает, на что нейрон может среагировать максимально, а не на что он действительно реагирует в работе.

Заключение

Activation Maximization — это способ задать нейросети простой вопрос: «Что ты хочешь увидеть?» Ответ приходит в виде изображения — иногда красивого, иногда странного, но всегда информативного.

Мы узнали, что:

– Нейроны на разных слоях «видят» разные вещи — от простых линий до сложных объектов

– Метод помогает отлаживать модели и находить неожиданные баги

– Результаты нужно интерпретировать осторожно — это «мечты», а не реальность

Интерпретируемость нейросетей — активная область исследований. Появляются новые методы: sparse probing для поиска отдельных концептов, circuit analysis для понимания взаимодействия нейронов, автоматическая генерация объяснений. Activation Maximization остаётся одним из самых наглядных и интуитивных инструментов в этом арсенале.

Если хотите попробовать сами — начните с инструмента OpenAI Microscope или библиотеки Lucid. Это увлекательно: вы буквально заглядываете в «сознание» нейросети и видите мир её глазами.

—

Источники

1. Olah, C. et al. «Feature Visualization» — Distill, 2017. Классическая работа, подробно описывающая методы визуализации нейронов. (https://distill.pub/2017/feature-visualization)

2. Olah, C. et al. «Zoom In: An Introduction to Circuits» — Distill, 2020. Развитие идей интерпретируемости, анализ «схем» внутри нейросетей. (https://distill.pub/2020/circuits/zoom-in)

3. Zimmermann, R. et al. «Adversarial Attacks on the Interpretation of Neuron Activation Maximization» — 2023. О том, как можно манипулировать визуализациями. [arXiv:2306.07397].(https://arxiv.org/abs/2306.07397)

4. Elhage, N. et al. «Toy Models of Superposition» — Anthropic, 2022. Фундаментальная работа о полисемантичности нейронов. (https://transformer-circuits.pub/2022/toy_model)

Дополнительные ресурсы

– OpenAI Microscope — интерактивный инструмент для исследования визуализаций разных моделей: (https://microscope.openai.com)

– Lucid — библиотека для визуализации нейросетей: (https://github.com/tensorflow/lucid)

Автор: Rummar