Когда мы просим машину помочь нам приготовить обед или заменить SIM‑карту, она должна не просто распознать предметы в кадре, а представить, как мир будет меняться от шага к шагу. Пока большинство систем видят пиксели и отвечают короткими фразами, планирование на длинном горизонте всё ещё не работает. Команда VLWM (Vision Language World Model) предлагает другой путь: описывать будущее словами и оперировать не кадрами, а смыслами. Их работа — про то, как собрать воедино зрение, язык и рассуждение так, чтобы агенты уверенно шли к цели.

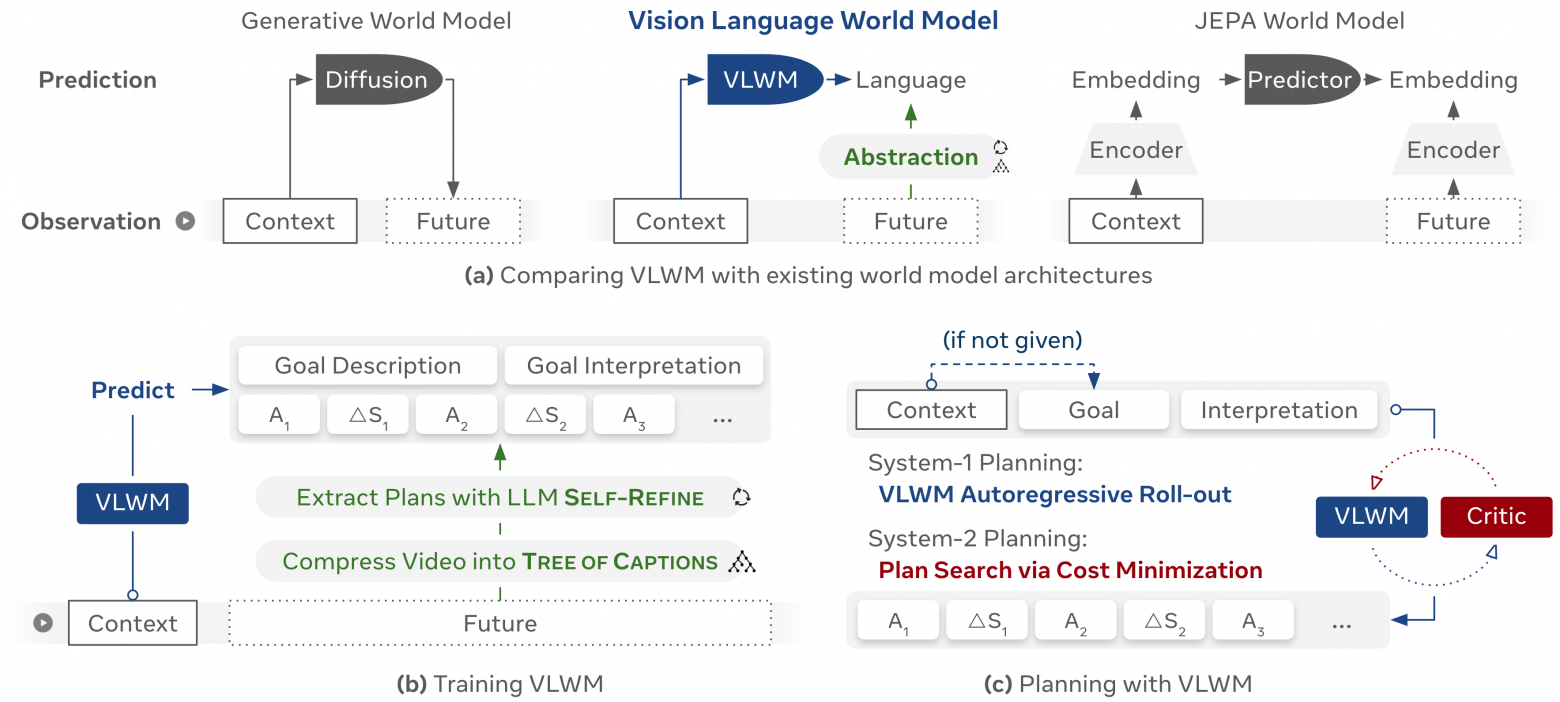

Главная мысль проста: вместо тяжёлой генерации будущих кадров модель мира работает в языковом пространстве. Она смотрит на видео, формулирует достижимую цель, а затем предсказывает траекторию — чередования действий и изменений состояния. Такой план компактен, прозрачен и легко проверяется другими языковыми моделями. А еще он дешевле вычислительно: текст масштабируется лучше, чем массивы пикселей.

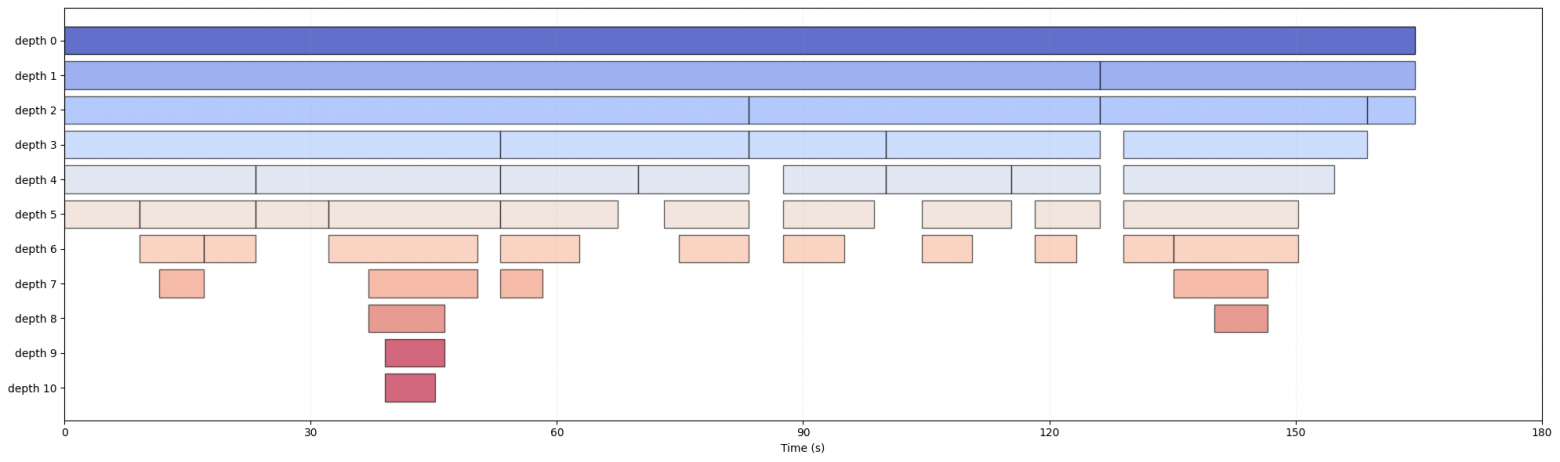

Как достичь этого на реальных, длинных и шумных видео? Авторы сжали исходный поток в дерево подписей — иерархическое представление, где длинный ролик раскладывается на смысловые сегменты с краткими описаниями. Это резко уменьшает объём данных и освобождает ресурсы для рассуждения о будущем. Затем большой языковой моделью по схеме self‑refine из этих подписей извлекаются четыре ключевых компонента: цель, её интерпретация в терминах начального и желаемого состояния, исполнимые шаги и изменения мира после каждого шага. Итеративное улучшение помогает убрать неточности и сделать план связным.

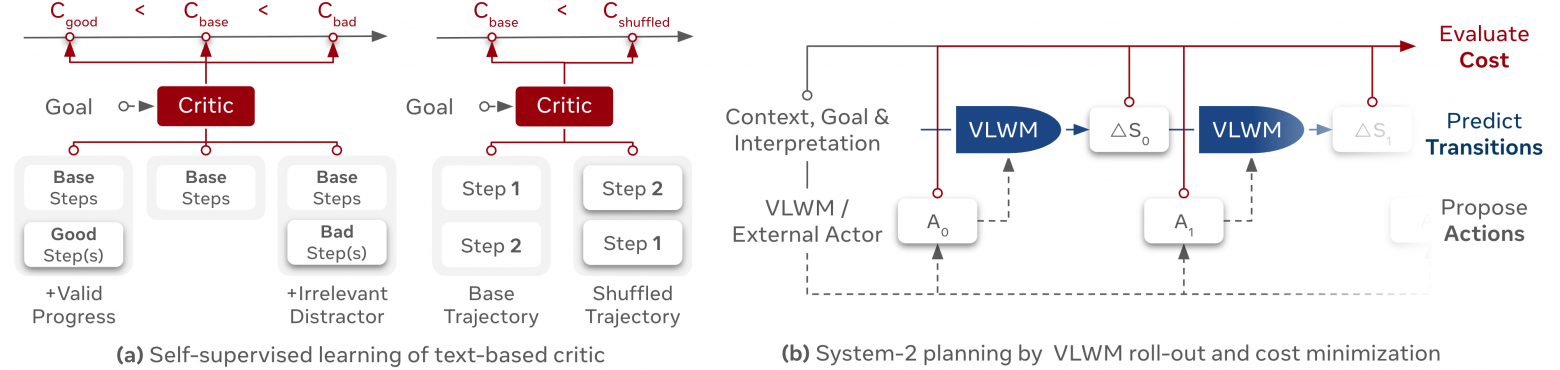

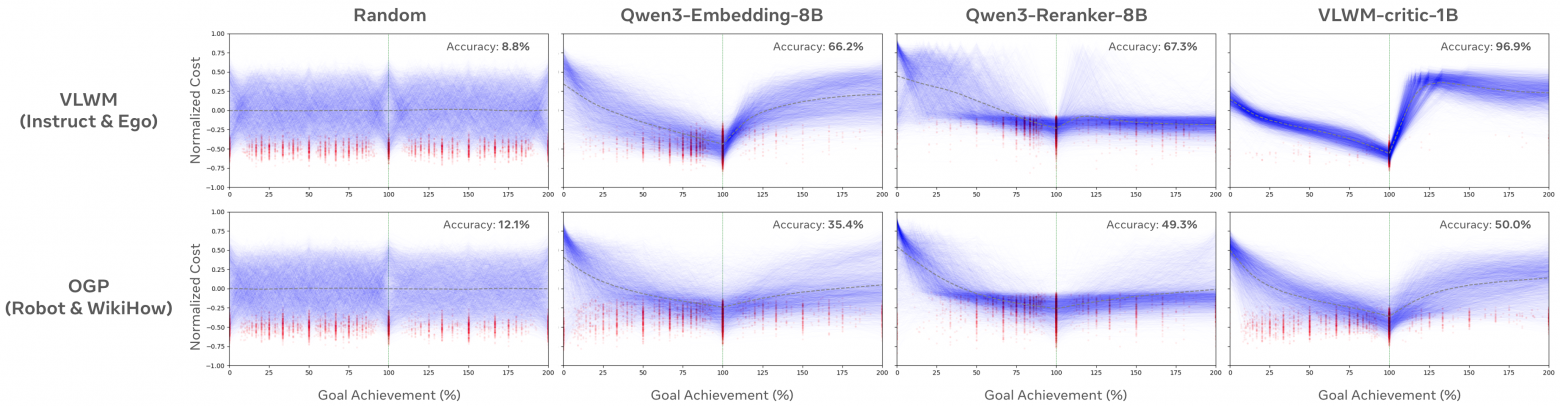

Далее вступает в игру собственно модель мира VLWM. Её учат предсказывать последовательность из пары: действие и изменение состояния. Это позволяет работать в двух режимах. Быстрый, реактивный режим — просто сгенерировать план целиком и выполнить. И более вдумчивый — перебрать несколько кандидатов, «прокрутить» будущее внутри модели, оценить, насколько предсказанные состояния приближаются к цели, и выбрать путь с минимальной стоимостью. Стоимость считает отдельный критик: небольшая языковая модель, самостоятельно обученная на ранжировании хороших и плохих продолжений.

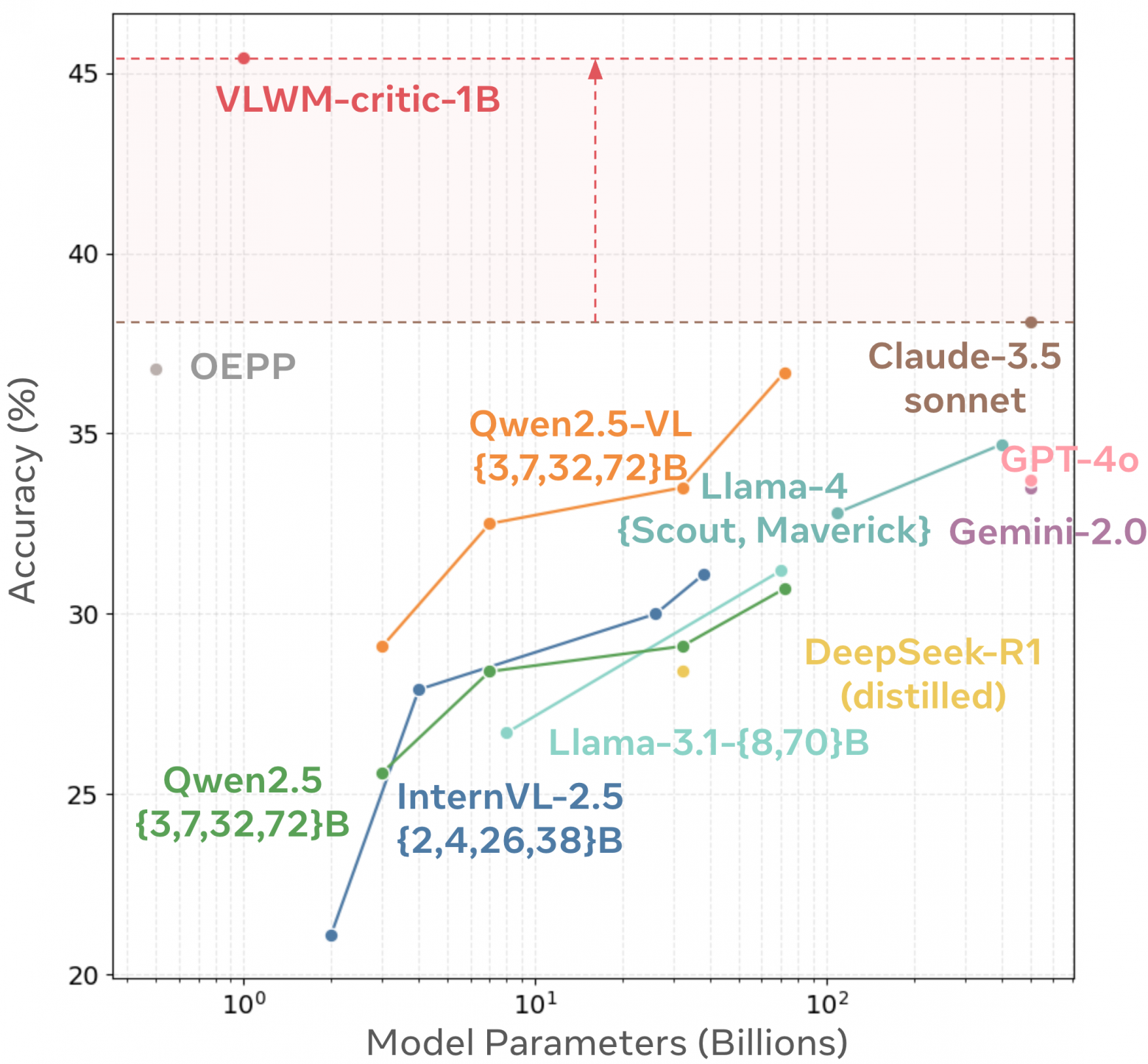

Результаты внушают доверие. На бенчмарке Visual Planning for Assistance у VLWM новый лучший результат по всем основным метрикам, причём модель 8B обходит более крупные системы. В человеческом сравнении PlannerArena люди заметно чаще выбирают планы с рефлексивным поиском: режим System‑2 даёт примерно на 27% больше рейтинга Elo по сравнению с быстрым декодированием. Это признак того, что внутренний перебор и оценка стоимости действительно помогают избегать ошибок и нелепых шагов.

Критик — не просто вспомогательная деталь. В задачах обнаружения момента достижения цели он уверенно превосходит стандартные модели семантического сходства, а на задачах процедурного планирования WorldPrediction‑PP ставит новый рекорд точности. Самое важное — хорошая функция вознаграждения.

Важно и то, как всё это масштабируется. Обучение шло на сотнях тысяч инструктивных и эгоцентричных видео (видео от первого лица), а дерево подписей позволило ужать терабайты в сотни мегабайт текста. Такой подход естественно сочетается с экосистемой больших языковых моделей и мультимодальных моделей, поэтому дальнейшее улучшение восприятия или рассуждения можно получать без пересборки всей системы.

Есть и ограничения. Языковая абстракция иногда теряет тонкие пространственные детали; качество сильно зависит от корректности подписей и извлечённых планов. Актор и критик должны быть сбалансированы: слишком агрессивный поиск замедлит реакцию, слишком быстрый — снизит надёжность. Но в сумме это выглядит как трезвый компромисс между скоростью и вдумчивостью.

VLWM показывает, что предсказывать будущее не обязательно в пикселях. Описывая мир словами и кодируя его состояние как цепочку действий и изменений, можно совместить восприятие, рассуждение и планирование. Это шаг от имитации к агентам, которые умеют подумать, проверить гипотезы внутри своей модели мира и выбрать разумный путь — даже в длинных и запутанных сценариях.

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал – там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist