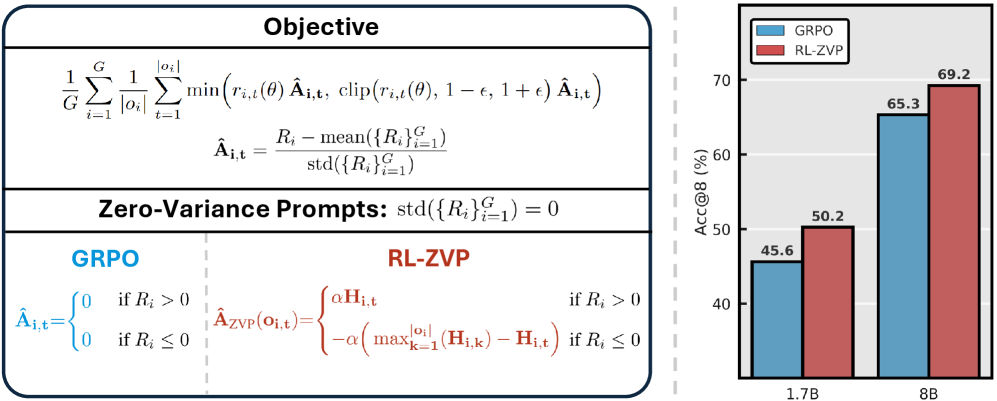

Команда исследователей Adobe предложила новый метод обучения генеративных моделей — RL-ZVP (Reinforcement Learning with Zero Variance Prompts), который переосмысливает роль так называемых нулевых промптов, где все сэмплированные ответы оказываются одинаково хорошими или одинаково плохими. Традиционно такие примеры в обучении просто отбрасывали как бесполезные, но учёные Adobe доказали, что в них есть важная информация и разработали метод, превращающий её в положительный учебный сигнал.

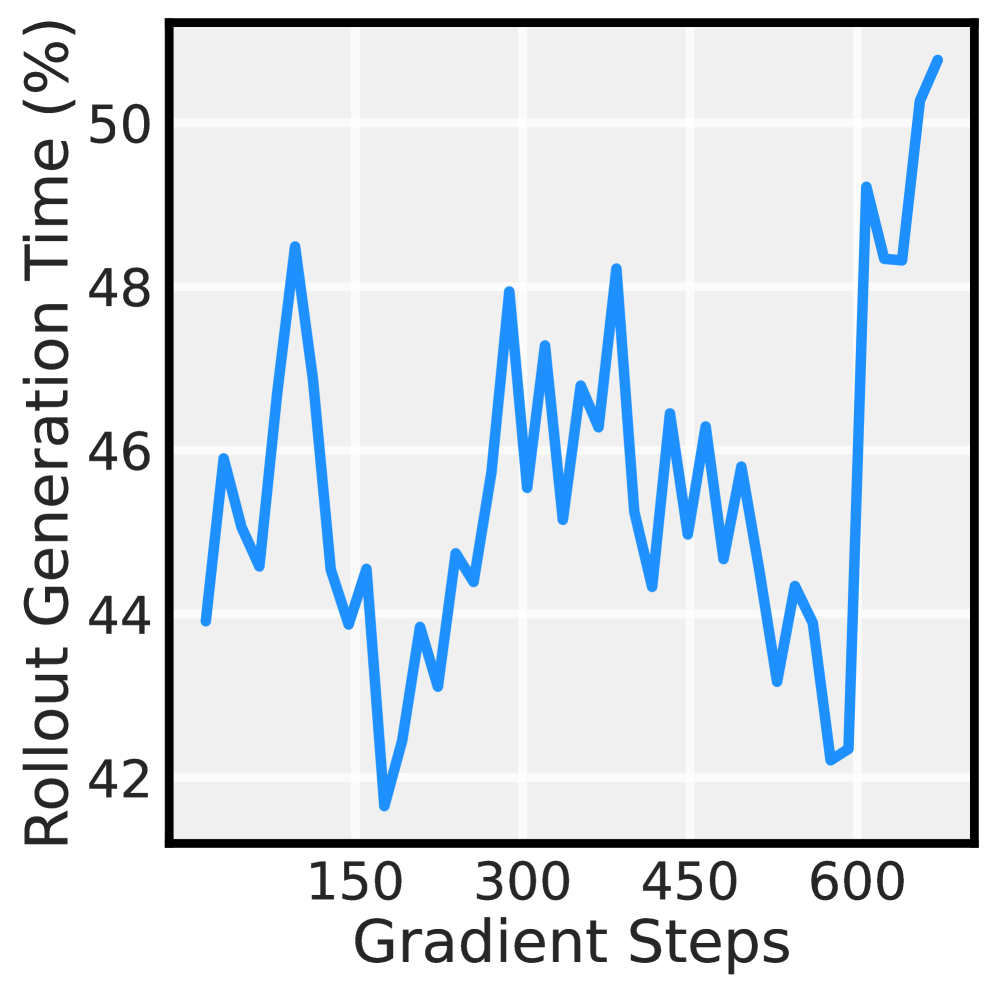

Идея RL-ZVP состоит в том, чтобы трактовать отсутствие разброса ответов как индикатор уверенности модели. Если все варианты хороши, это подтверждение корректности поведения; если все плохи — чёткая метка ошибки. На основе этой логики алгоритм масштабирует обновления по энтропии: неуверенные токены получают более сильные корректировки, очевидные — слабее. Такая схема позволяет извлечь пользy из ~50% ранее неиспользуемых обучающих шагов и повысить стабильность обучения.

В экспериментальной проверке RL-ZVP показал значимый прирост. Точность выросла примерно на 8,6 процентных пункта, а pass rate на 7,8 пункта по сравнению с популярными методами вроде GRPO. При этом метод не требует больших дополнительных вычислительных затрат, что делает его привлекательным для практического применения в индустрии: компании могут повышать качество моделей, не умножая расходы на обучение.

RL-ZVP даёт путь к более надёжным и предсказуемым ИИ-системам, особенно в задачах, где стабильность ответов критична (медицина, финансы, юриспруденция). В то же время метод поднимает вопросы проверки и валидации. Как отличать униформа-ошибку от объективного ограничения датасета и как не усилить нежелательные шаблоны. Adobe подчёркивает, что RL-ZVP — не универсальное решение, а мощный инструмент в арсенале обучения, который лучше всего работает в сочетании с прочими техниками контроля качества.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: cognitronn