ZAI выпустили GLM-4.7 Flash, облегченную версию флагмана GLM-4.7. Это модель на 30 млрд параметров с контекстом 128K и архитектурой MoE, ориентированная на локальный запуск без серверных бюджетов уровня бигтеха.

Идея проста. Закрыть разрыв между компактными SLM и проприетарными монстрами. Flash должна дать разработчикам SOTA-уровень в кодинге и агентных сценариях, оставаясь при этом доступной для локальной инфраструктуры.

Архитектура MoE делает модель обманчиво легкой. Формально 30B, но активных параметров на токен значительно меньше. В сообществе говорят примерно о 3 млрд. Это означает, что по реальной вычислительной нагрузке она ближе к средним моделям, сохраняя при этом ширину мышления старших решений.

Одна из ключевых фичей это Interleaved Thinking. В отличие от привычного подхода, где модель вываливает весь chain-of-thought в начале, здесь размышление происходит перед каждым вызовом инструмента. Для агентных систем это критично. Модель может планировать шаг за шагом, корректируя стратегию по ходу работы, а не идти по заранее зашитому сценарию.

ZAI отдельно акцентируют внимание на файнтюне под эстетику и DevOps. Модель училась не просто генерировать валидный HTML и CSS, а писать код с адекватной структурой, отступами и современными паттернами. Ее подтянули под работу с CLI, навигацию по файловой системе и понимание прав доступа. Это делает ее пригодной для реальных инженерных задач, а не только для демо.

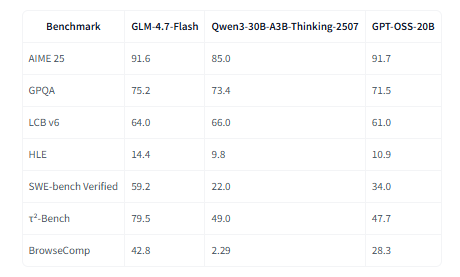

Бенчмарки выглядят впечатляюще. В SWE-bench Verified модель набирает 59.2 процента. Для сравнения, Qwen3-30B-A3B показывает 22.0, а GPT-OSS-20B около 34.0. В математическом AIME 25 результат 91.6 процента, что также выше ближайших конкурентов. На BrowseComp Flash обходит GPT-OSS-20B почти в полтора раза.

На практике это делает GLM-4.7 Flash одним из лучших кандидатов для локальных кодинг-агентов. Если есть пара видеокарт или готовность мириться с квантованием на одной, модель может стать основной рабочей лошадкой для разработки.

Отдельный плюс это лицензия MIT. Никаких ограничений на коммерческое использование и встраивание в продукты.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: cognitronn