Если вы занимаетесь обучением или тюнингом больших языковых моделей, используете инференс в режиме реального времени или выполняете сложные HPC-симуляции, то наверняка задавались вопросом: «а каково это будет на одном из лучших в мире чипов»?

Как только мы получили B200, графический процессор, который по заявлениям производителя открывает новые грани производительности, гибкости и масштабируемости, то сразу побежали его тестировать. Сегодня я и мои коллеги из Evolution Bare Metal возьмем лупу SGLang и пристально взглянем на новую карту. Заходите под кат оценить, какие цифры нам покажет B200 «в бою», и узнать, чем отличается эта модель от предыдущих ускорителей NVIDIA, таких как A100, H100 и H200.

Что за зверь B200

Совсем немного теории. B200 — графический ускоритель на базе архитектуры NVIDIA Blackwell, разработанный для самых требовательных рабочих нагрузок в области AI и высокопроизводительных вычислений. Для GPU-ускорителей это значительный скачок в объеме памяти, производительности вычислений и масштабировании модели по сравнению с предыдущими поколениями.

Ключевые характеристики:

-

Архитектура Blackwell с тензорными ядрами 5-го поколения.

-

192 ГБ памяти HBM3e с пропускной способностью ~8 ТБ/с.

-

Поддержка форматов низкой точности: native FP4 и FP8 для максимального ускорения обучения.

-

Оптимизирован для обучения крупных моделей/LLM и шустрого I/O.

-

Высокая плотность вычислений: до 20 PetaFLOPS (FP8) на один GPU.

Почему B200 быстрее

Пройдемся по основным преимуществам B200 в производительности, что точно изменилось — так это архитектура:

Еще больше память и пропускная способность

Имеем до 192 Гб (зависит от конфигурации, в моем — 183 Гб) на борту оперативной памяти HBM3e и пропускной способности ~8 ТБ/с, B200 может хранить чрезвычайно большие модели и наборы данных полностью на кристалле, что сокращает скорость передачи данных от хоста к устройству. Это важно для LLM, где размеры контекста и количество параметров продолжают расти.

Расширенные тензорные ядра и новая поддержка точности

B200 поддерживает самые современные форматы с плавающей точкой, включая FP4, FP8, FP16 и другие. Форматы с низкой точностью значительно ускоряют процесс обучения matrix math core при сохранении адекватной точности.

Что это дает:

-

Гораздо более быстрый вывод данных при сверхнизкой точности.

-

Более высокая производительность обучения на больших моделях.

-

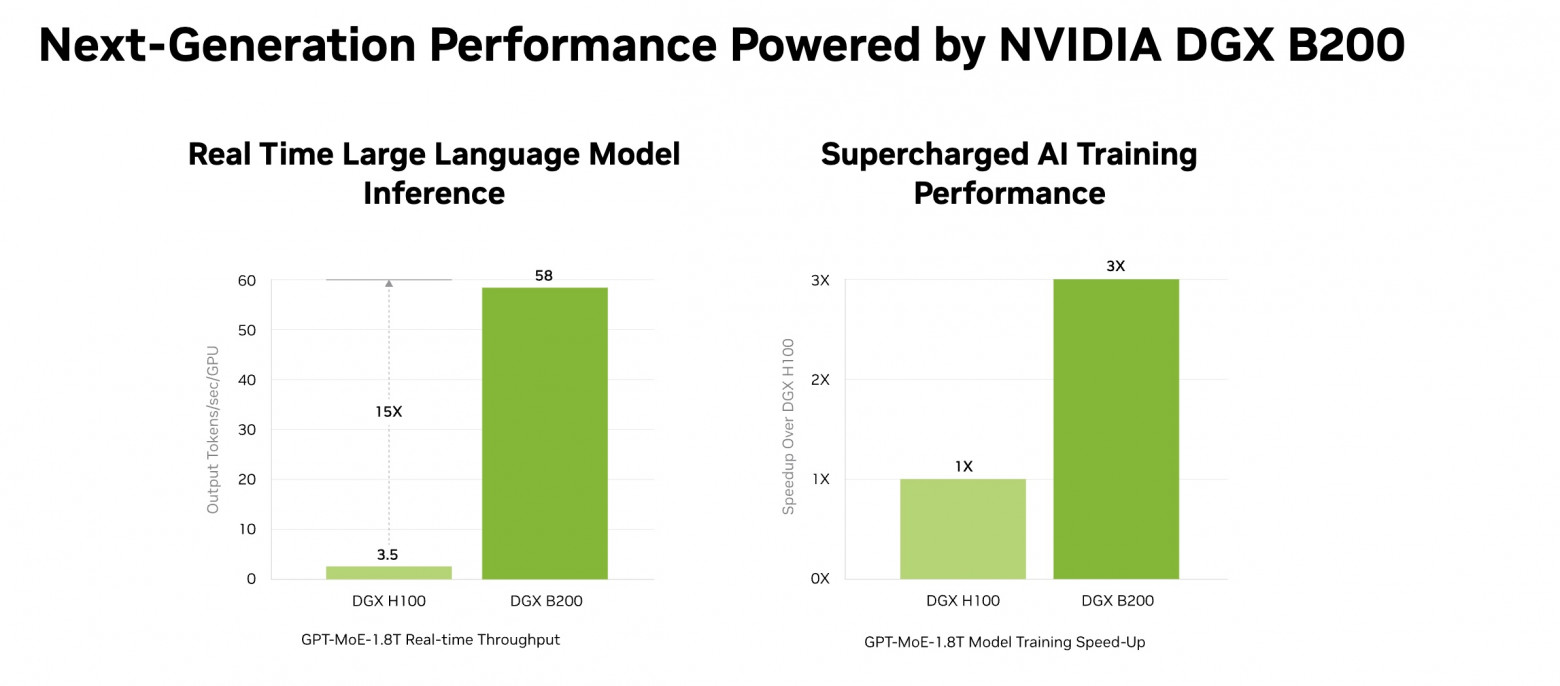

Например, в тестах MLPerf системы B200 обеспечивают значительно большую производительность обучения и вывода данных, чем системы на базе H100.

Более быстрая шина

В B200 используется технология NVLink 5 с пропускной способностью ~1,8 Тбит/с между графическими процессорами, что значительно улучшает масштабирование на нескольких графических процессорах для распределенного обучения.

Наши бенчмарки

Конечно, как только в Cloud.ru приехал DGX с B200 мы совместно с коллегами из AI Factory и RnD успели протестировать некоторые LLM модели, чтобы понять, какое будущее нас ждет.

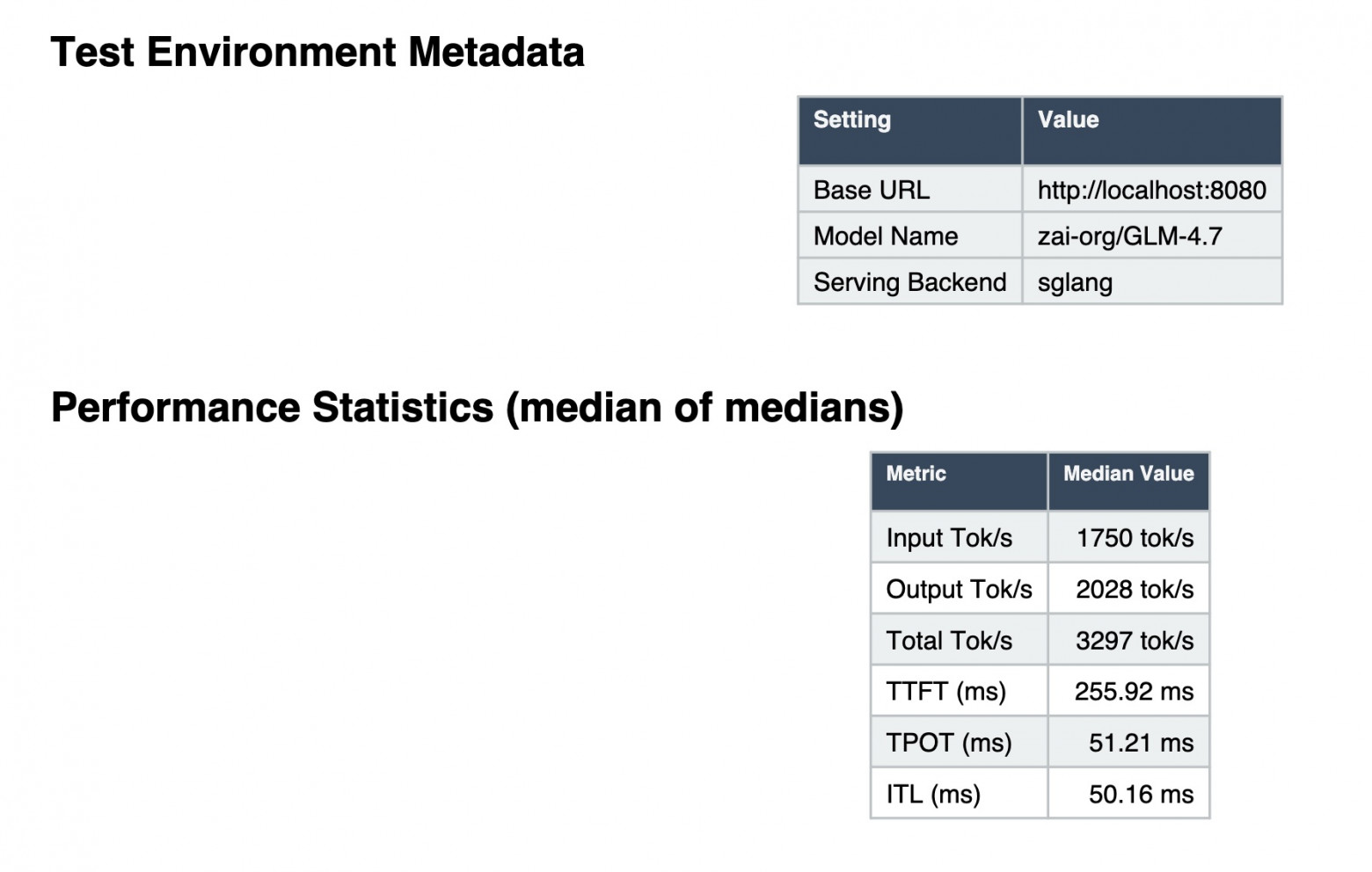

Для тестов использовали модель zai-org/GLM-4.7 и платформу SGLang где получили интересные результаты, давайте посмотрим.

Задача простая: не просто снять красивые цифры, а понять, как эта платформа ведет себя в реальных инференс-сценариях — с большими LLM, батчингом, разными бекендами и переменной нагрузкой.

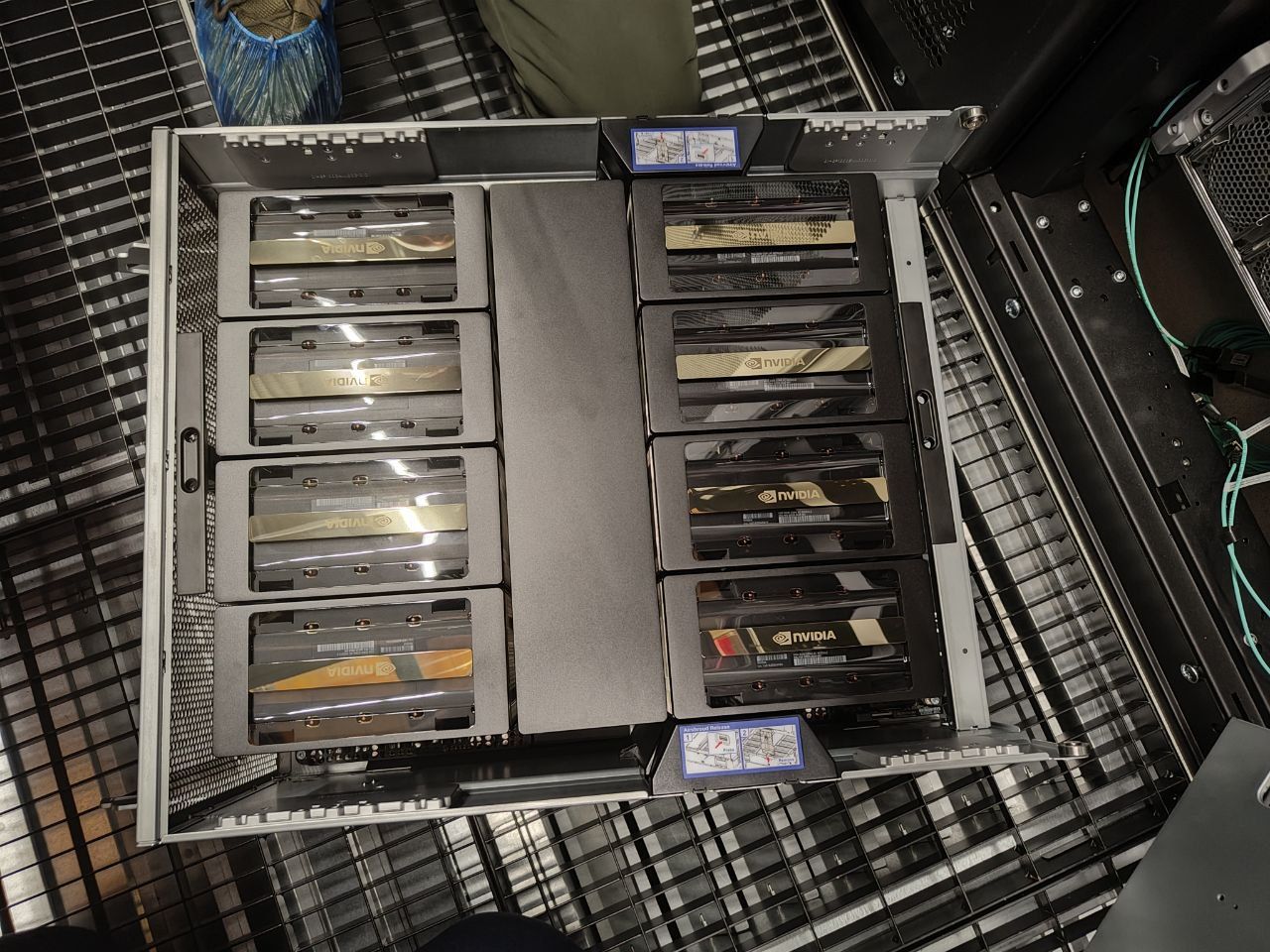

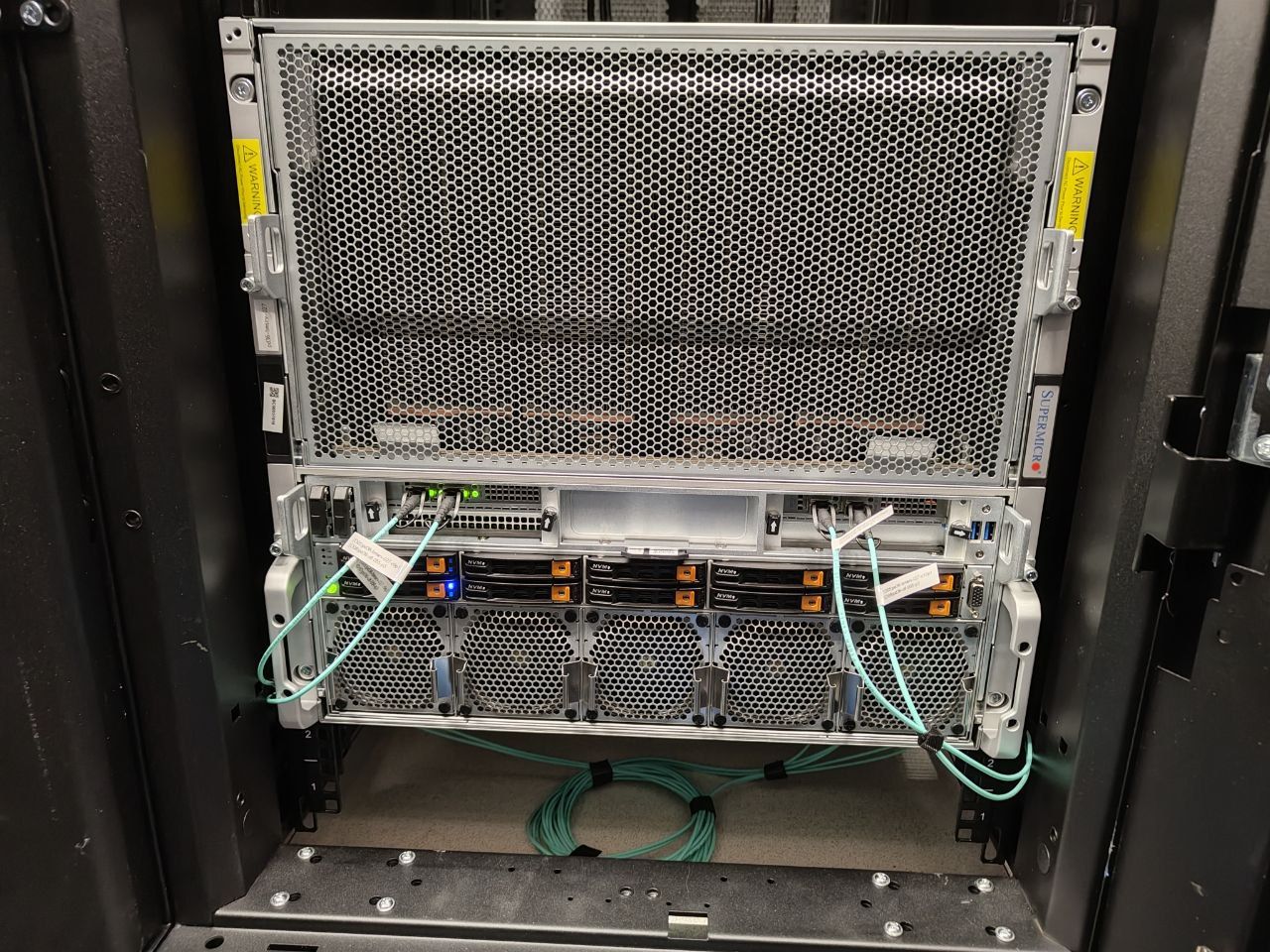

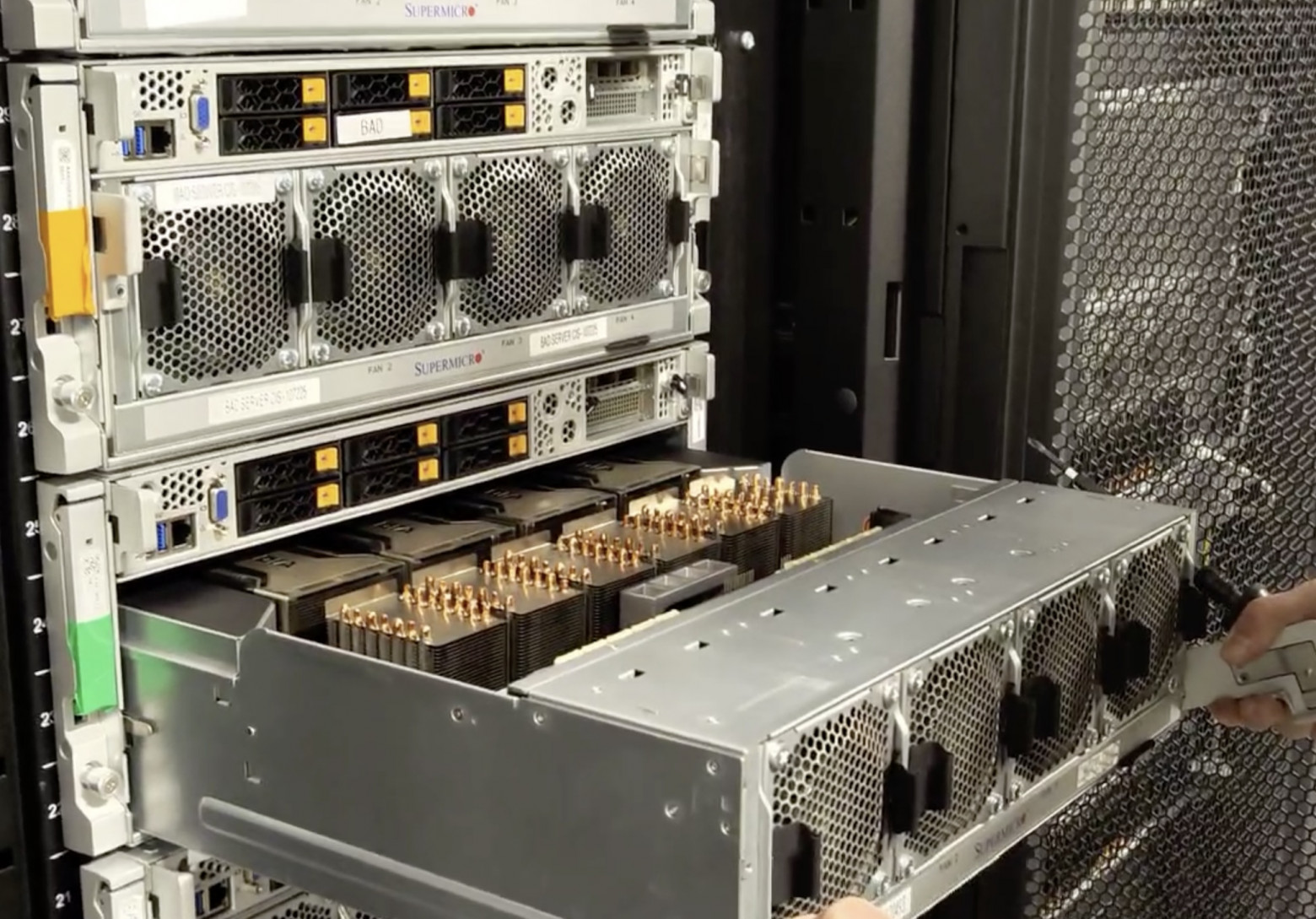

Стенд получился максимально production-like: Ubuntu 24.04, Intel Ice Lake, 2.2 ТБ RAM, 8 GPU B200 по 183 ГБ видеопамяти, объединенные через NVLink/NVSwitch. По софту — драйверы CUDA 13.0 и актуальный стек для инференса. То есть, это не лабораторная конфигурация, а то, что реально может взять любой пользователь на рынке как BareMetal.

Бенчмарк 1: attention-бекенды

Сначала мы сравнили разные attention-бекенды, чтобы понять, какой стек лучше ложится на B200. Конфигурация была такой:

-

batch size: 2

-

precision: FP8

-

режим: continuous batching

-

interconnect: NVLink/NVSwitch

-

стек: CUDA 13.0 + SGLang

Разница оказалась ощутимой. TRT-LLM заметно обошёл FlashInfer:

-

TTFT: 14.3 с -> 10.6 с

-

throughput: 1805 -> 2453 токенов/с

Это примерно +26% по пропускной способности и ~35% по времени первого токена.

|

H100 |

H200 |

A100 |

Вывод |

|

Ожидаемо ~1800–2000 ток/с Из-за меньшего FP8-перформанса и 80 ГБ памяти приходится чаще шардить модель. |

TTFT ~ 12.8 с Throughput: 1980 ток/с |

~900–1100 ток/с выше latency FP8 там фактически нет, пришлось бы идти в FP16/BF16. |

B200 примерно +25–35% к H100 и ~2× к A100 в этом сценарии. |

Бенчмарк 2: влияние числа GPU

Что делали: 2 vs 4 GPU, 48 параллельных запросов.

Что получили:

-

2453 -> 3458 ток/с (+41%);

-

TTFT: 10.5s -> 245 мс.

Последняя цифра особенно показательная: модель перестала стоять в очереди.

Почему: больше GPU— больше KV-кеша — меньше конкуренции — ниже tail latency.

|

H100 |

H200 |

A100 |

Вывод |

|

Мы почти уперлись в лимиты масштабирования, при этом запас памяти небольшой, поэтому деградация производительности наступит раньше. |

Абсолютные цифры ниже из-за медленной памяти и FP8. TTFT хуже, т.к. больше данных гоняется по NVLink. |

Эффективность масштабирования заметно хуже. |

При высокой параллельной нагрузке B200 показывает самые стабильные задержки (latency). |

Бенчмарк 3: масштабирование batch size

Где начинается реальная выгода от B200? Проверим, как платформа масштабируется по batch size. Это важно для сервисов с высокой утилизацией GPU, где без батчинга экономика просто не сойдется.

Конфигурация:

-

batch size: 2 -> 4;

-

precision: FP8;

-

continuous batching;

-

тот же стек.

Результат:

-

TTFT: 10c -> 6291 мс (примерно −40%);

-

throughput: 2453 -> 2540 токенов/с.

|

H100 |

H200 |

A100 |

|

На больших моделях тормозит раньше конкурентов — памяти мало, поэтому быстрее приходится использовать несколько видеокарт одновременно, а это замедляет работу. Ожидаемо ~15–20% отставание. batch 2 – 14.5 с; throughput |

Первый ответ выдается медленнее, потому что в тензорных ядрах меньше возможностей для параллельных вычислений. При обработке 4 запросов одновременно скорость работы почти сравнивается с B200, но первый токен все равно приходит на 3 секунды позже. batch 2 – 12.8 с; throughput

|

Шардинг + PCIe/NVLink предыдущего поколения – тут падение эффективности сильнее, ~30–40%. |

Вывод: B200 лучше справляется с увеличением размера пакета и обеспечивает более предсказуемое время отклика под нагрузкой. Выглядит, как хороший индикатор того, что NVLink заметно снимает узкие места по коммуникациям между GPU, а распределение нагрузки работает эффективно.

Это ключевой момент, так как клиент может агрессивно батчить и получать лучшую экономику без резкой деградации latency.

Бенчмарк итог: общий профиль инференса

Финально, при FP8 + continuous batching стабильно имеем до 4600 ток/с (зависит от стека), лучший TTFT 150 мс (сильно зависит от batching) и TPOT ~30 мс. B200 заточен под throughput inference, не под training.

Главный вывод тут напрашивается из цифр — B200 раскрывается именно на больших моделях и плотной нагрузке.

Когда B200 выгоднее H100/H200

Не всегда самое модное и мощное лучше подходит для задач инференса. И будем честны, каждый, кто использует GPU-сервер считает не токены/сек, а рубли на миллион токенов.

|

Большие модели (70B+, MoE) |

Длинные контексты (16-32K+) |

FP8 precision |

|

H100: приходится шардить на 2-4 GPU, оверхед коммуникаций 15-20%, латентность выше. |

H100: OOM на 70B + 16K+ даже в FP8, нужно шардить — латентность падает, стоимость растет. H200: 141GB vs 183GB — на 30% меньше максимальный контекст, или приходится снижать батч. B200: запас 40-60GB на KV-cache — обрабатываешь длинные запросы за чашкой чая или кофе. |

H100/H200: в некоторых моделях заметно плывет точность — ответы становятся хуже, чем должны быть. B200: Работает из коробки на новых тензорных ядрах пятого поколения без проблем и с проверенной точностью. По сравнению с H200 выдает на 30% больше токенов в секунду при стандартных вычислениях в FP16. |

B200 — это уже другое поколение. Тут не просто «памяти побольше», а реально выше эффективность Tensor Core, лучше FP8, выше плотность вычислений на ватт и заметно лучше утилизация при больших батчах.

Как итог

Честно, до тестов я ожидал, что H200 и B200 будут ощущаться почти одинаково. У H200 все-таки 141 ГБ HBM3e, хороший прирост к H100, отличная пропускная способность памяти. На бумаге выглядит как «почти флагман».

Но в реальных инференс-сценариях разница оказалась заметнее. H200 — это по сути эволюция H100: больше памяти, чуть выше bandwidth, те же принципы работы.

Без реальных тестов разницу легко не заметить. И это чувствуется именно там, где живет продакшен: большие модели, длинные контексты, много одновременных запросов.

Некоторые инсайты, которые можно вынести из тестов

-

B200 дает 2.3x лучший TTFT чем H100, если словами, то это разница между «ответ за 10 сек» и «ответ за 23 сек».

-

Если B200 недоступен или дорог, H200 дает около 80% производительности B200.

-

При длинных контекстах (32K+) память 141GB станет узким горлышком.

Приходите потрогать сами, если понравилось, ну и рассказывайте в комментариях, чего бы вы хотели «покатать» на таком монстре?

Автор: echo0x00