Этот пост для нашего тг-канала Pro AI написал мой коллега Александр Мигаль, специалист по компьютерной лингвистике и один из авторов RuTaR

В прошлой статье мы рассказали о RuTaR — большом открытом датасете на русском языке, разработанном для оценки способностей LLM к рассуждению в сфере налогового права. Среди прочего мы тогда запустили серию тестов, чтобы выяснить, как сильные модели справляются с задачами, требующими логического вывода с использованием RAG или без него, в варианте “из коробки”.

Однако, как вполне справедливо отметили некоторые читатели, мы не протестировали “настоящие” reasoning-модели — те, что спроектированы специально для выполнения сложных логических рассуждений, и занимают верхние строчки в соответствующих бенчмарках.

Мы решили исправиться.

После небольшого ресерча мы остановились на Qwen QwQ 32B, DeepSeek R1, Google Gemini 2.0 Flash Thinking, а также o1 и 04-mini от OpenAI. Кажется, что подобный выбор едва ли нуждается в обосновании — перечисленные модели — это флагманы среди reasoning-ориентированных LLM. Однако не менее интересным было посмотреть на то, как со схожей задачей справляются топовые отечественные LLM, такие, как GigaChat 2 Max от Сбера и Yandex GPT 5 Pro от, кто бы мог подумать, Яндекса. Последняя, являясь флагманской моделью семейства YandexGPT, с недавних пор также начала поддерживать функцию reasoning, что позволяет назвать проведенное сравнение относительно честным :)

На этот раз мы сфокусировались на следующих моделях:

-

Qwen QwQ 32B

-

DeepSeek R1

-

Gemini 2.0 Flash Thinking

-

OpenAI o1

-

OpenAI o4-mini

Также тестовая выборка пополнилась двумя отечественными разработками:

-

GigaChat 2 Max (Сбер)

-

Yandex GPT 5 Pro

Подобный выбор LLM объясняется просто: это либо флагманы среди reasoning-ориентированных LLM, либо — в случае с отечественными — топовые публичные решения, заявляющие поддержку аналогичных возможностей. C недавних пор Yandex GPT 5 Pro также была оснащена режимом рассуждений (https://yandex.cloud/ru/docs/foundation-models/concepts/yandexgpt/chain-of-thought), а Сбер заявляют о том, что активно тестирует эту функцию и в ближайшее время снабдят ей свой GigaChat (https://lenta.ru/news/2025/06/18/sberbank-nachal-testirovat-novuyu-versiyu-gigachat-s-funktsiey-reasoning).

Итак, перейдем к результатам…

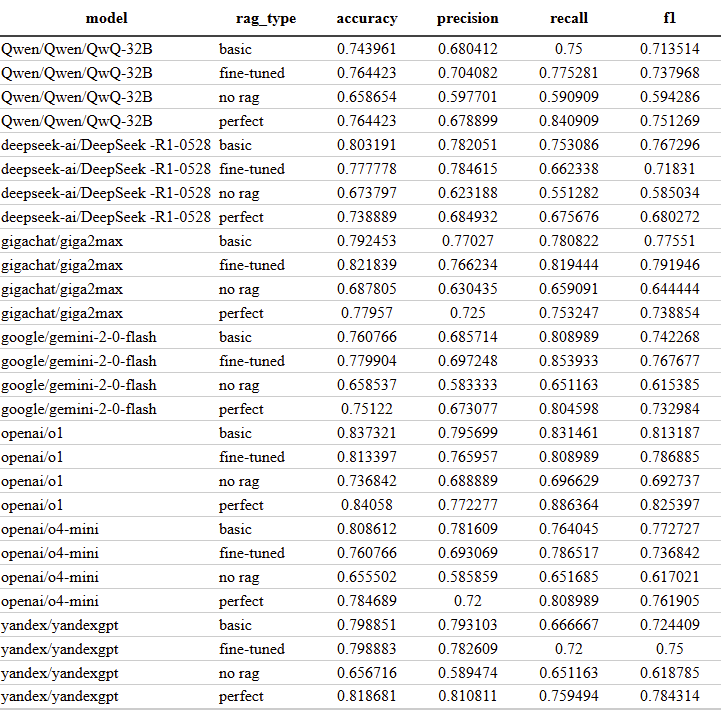

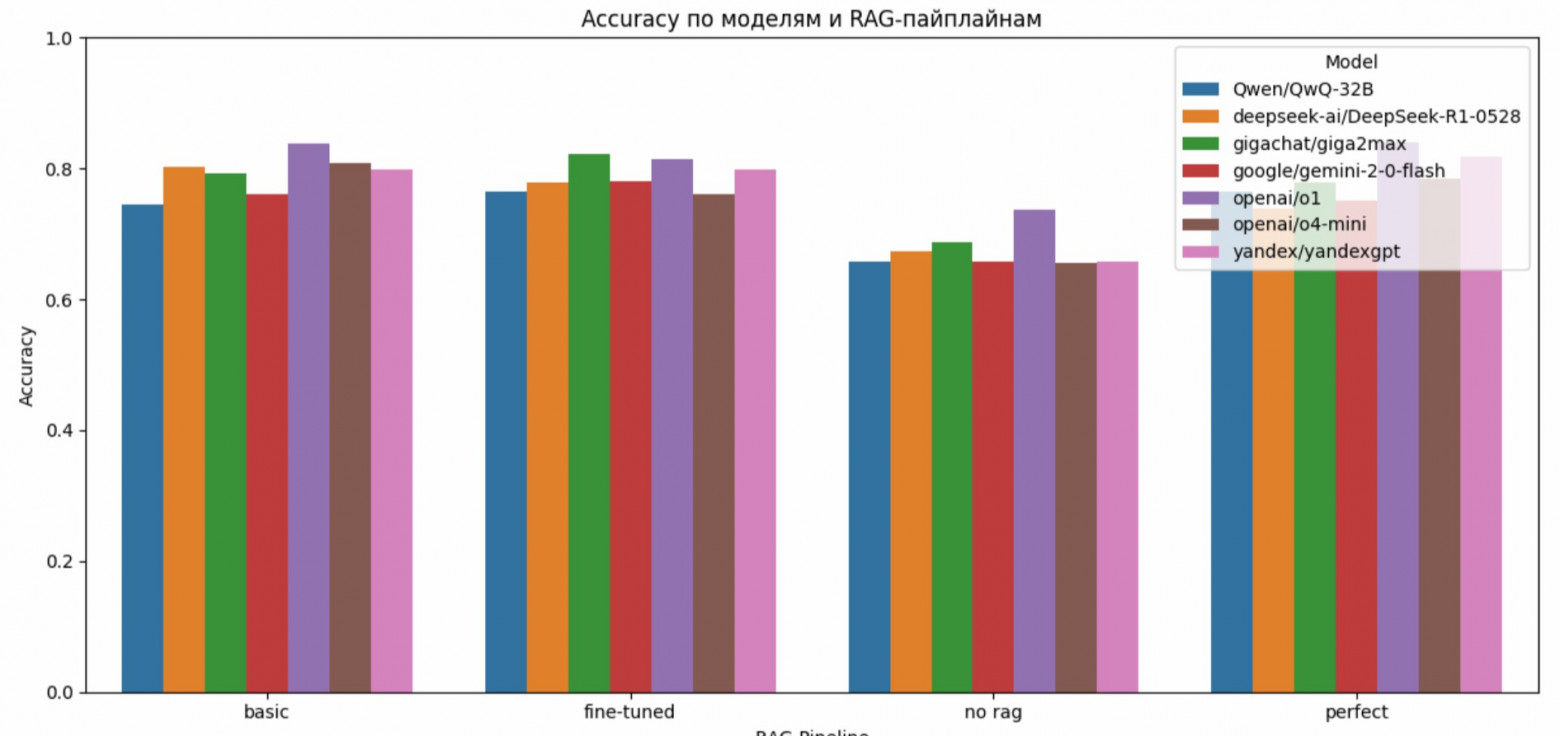

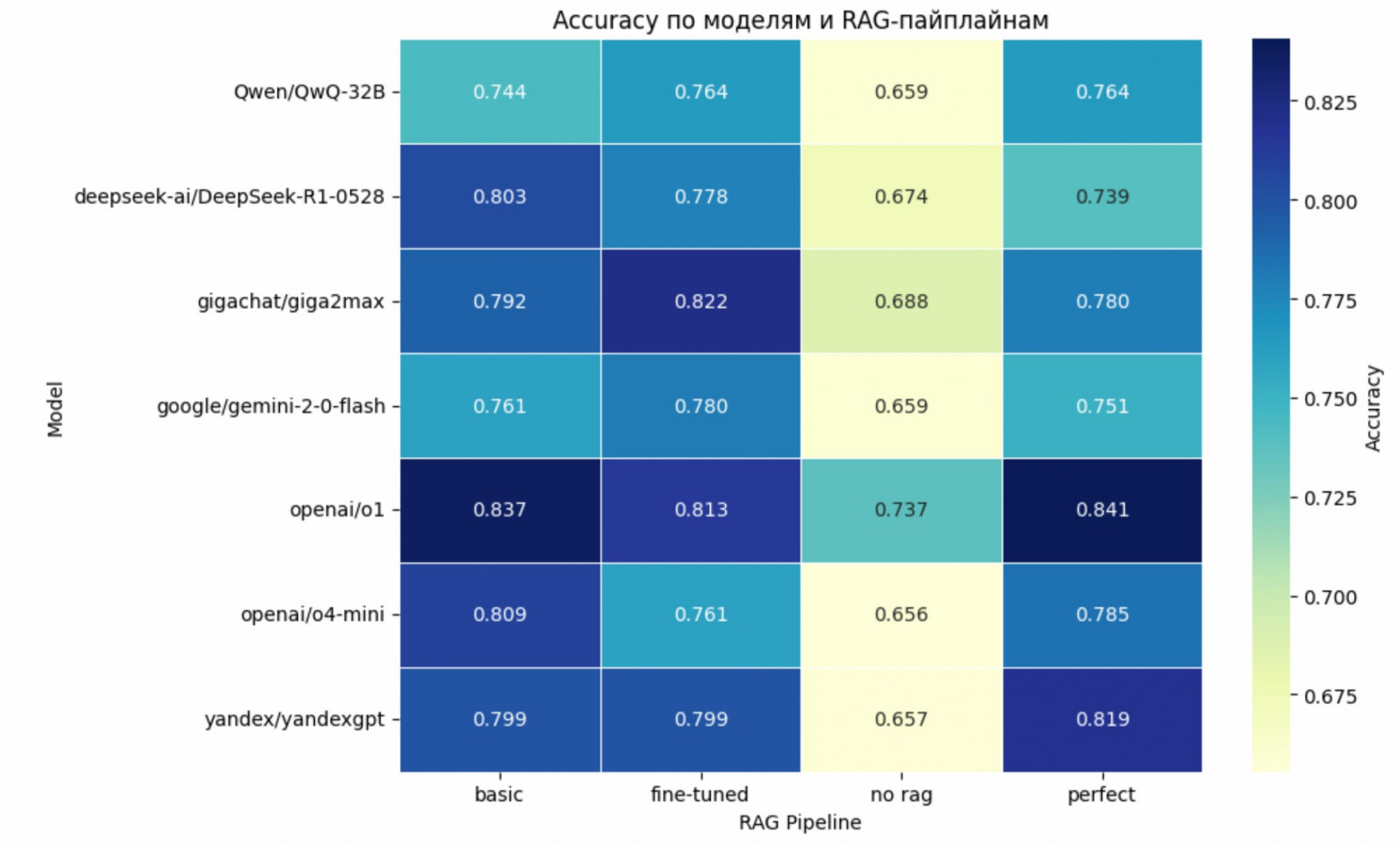

У всех моделей точность, полнота и F-мера по правильным ответам увеличиваются по сравнению с не-reasoning моделями. Нельзя сказать, что прирост колоссальный — порядка 10%, — но всё же заметный. Как и в случае с не-reasoning моделями, использование RAG-пайплайна даёт ощутимый прирост по качеству. особенно “прибавляет” от внешней информации Gemini (+0.12 accuracy между no_rag и fine-tuned) и Qwen(+0.11 между no_rag и perfect).

Что касается отечественных моделей, то самым приятным удивлением стал GigaChat 2 Max — модель уверенно конкурирует с международными лидерами, особенно в fine-tuned режиме (accuracy = 0.822). Не сильно отстаёт и Yandex GPT 5 Pro: в perfect-пайплайне она набрала 0.819, что ставит её в одну лигу с o4-mini. И это при том, что Yandex GPT 5 Pro трестировалась с включенным режимом рассуждений, а в GigaChat 2 Max он на данный момент отсутствует.

Однозначными лидерами оказались модели OpenAI o1 и DeepSeek R1. При этом, хоть точность их ответов и зависит от используемых RAG-пайплайнов, они уверенно лидируют вне зависимости от наличия доступа к внешним данным. Особенно впечатляет o1 в режиме perfect (accuracy = 0.840), а также в basic (accuracy = 0.837). Это, в некотором роде, подтверждает нашу гипотезу о главенстве reasoning’а в юридическом дискурсе и неабсолютной ценности контекста в RAG-системах, ориентированных на право.

⸻

Если вы тоже работаете на стыке права и информационных технологий или ищете интеллектуальные решения по оптимизации бизнес-процессов в своей компании — будем рады сотрудничеству.

Итоговый датасет доступен на GitHub и распространяются по открытой лицензии.

📁 Датасет: https://github.com/rutar-anonymous/RuTaR

🧠 Статья: https://dialogue-conf.org/wp-content/uploads/2025/04/AlibekovAetal.075.pdf

💬 Вопросы, предложения, багрепорты, коллаборации — пишите в комментарии здесь или в личку Александру Мигалю.

Автор: derunat