Moonshot AI выкатили K2.5. Пресс-релиз трубит про «самую мощную open-source модель», но я бы хотел поговорить о другом — о том, что они сделали с агентами.

Начну с конца. Там есть график, который стоит тысячи слов. Ось X — сложность задачи. Ось Y — время выполнения. Две линии: одиночный агент и рой агентов. Одиночный агент карабкается вверх линейно. Рой держится почти горизонтально. На сложных задачах разрыв — в четыре с половиной раза.

Параллельные агенты обсуждают давно, но тут впервые показали, как этому научить модель, а не прописывать логику декомпозиции вручную. Также, выдали доступ к этим агентам по ценам, похожим на ChatGPT — настоящий рой агентов, выданный в одни руки, за сравнимую стоимость — фантастика.

Серийный коллапс

У мультиагентных систем есть проклятие. Называется serial collapse. Суть простая: вы даёте модели возможность запускать параллельные процессы, а она упорно выстраивает их в очередь. Делает одно, ждёт результат, делает следующее. Подобно геймдизайнерам, делающим современные ААА-игры: обещали нелинейную RPG, а получили скучный рельсовый шутер со стеклянными стенами.

Почему? Потому что так проще. Обратная связь от последовательного выполнения понятнее, и шума меньше. Модель находит локальный минимум и там остаётся.

Классический пример из RL: робот учится ходить и вместо нормальных шагов начинает елозить на пузе. Награда за продвижение вперёд есть, риска упасть нет. Выбраться из такой ямы сложно. Но можно и нужно, иначе никогда не станешь взрослым прямоходячим человеком.

Moonshot решили проблему в лоб: сделали последовательное выполнение невыгодным.

Формула с отжигом

Функция награды в PARL (так они назвали свой метод) выглядит так:

R = λ · r_parallel + (1 - λ) · (успех · качество)

λ — коэффициент, который тает от 0.1 до нуля по мере тренировки.

В начале обучения десять процентов награды — просто за то, что ты вообще запустил параллельные процессы. Неважно, помогло это или нет. Запустил? Молодец, держи печеньку.

Это выглядит как костыль. Костыль и есть, но работающий. Модель начинает экспериментировать с параллельностью, потому что за это платят. Потом λ уменьшается, и приходится учиться делать параллельность полезной.

Shameless plug. Заходите на мой канал про нейросети:

“Откровения от Олега” (https://t.me/tg_1red2black)

Критический путь

Вторая хитрость — метрика. Обычно агентные системы измеряют общее число шагов. Сделал сто шагов — плохо, сделал пятьдесят — лучше.

Но для параллельных систем это бессмысленно. Если три агента сделали по тридцать шагов одновременно — это девяносто шагов? Или тридцать?

Moonshot взяли концепцию из теории параллельных вычислений: critical path, критический путь. Считается только самая длинная последовательная цепочка. Если три агента работают параллельно, засчитывается только время самого медленного.

Critical Steps = Σ [шаги оркестратора + max(шаги субагентов)]

Метрика создаёт давление: распараллелил плохо, один агент тормозит — Loss страдает.

Что показывают графики

Два графика с динамикой обучения. Первый — accuracy, растёт от 35% до 65%. Второй — средний уровень параллелизма. В начале обучения модель запускает в среднем восемь параллельных агентов. К концу — тринадцать-четырнадцать.

То есть параллельность действительно возникает в процессе тренировки. Это не захардкоженная архитектура. Модель учится сама решать, когда и сколько субагентов поднимать.

На BrowseComp (бенчмарк про поиск информации в интернете) одиночный агент набирает 60.6. Рой набирает 78.4. Разница в восемнадцать пунктов только за счёт того, что задачи выполняются параллельно.

Архитектура роя

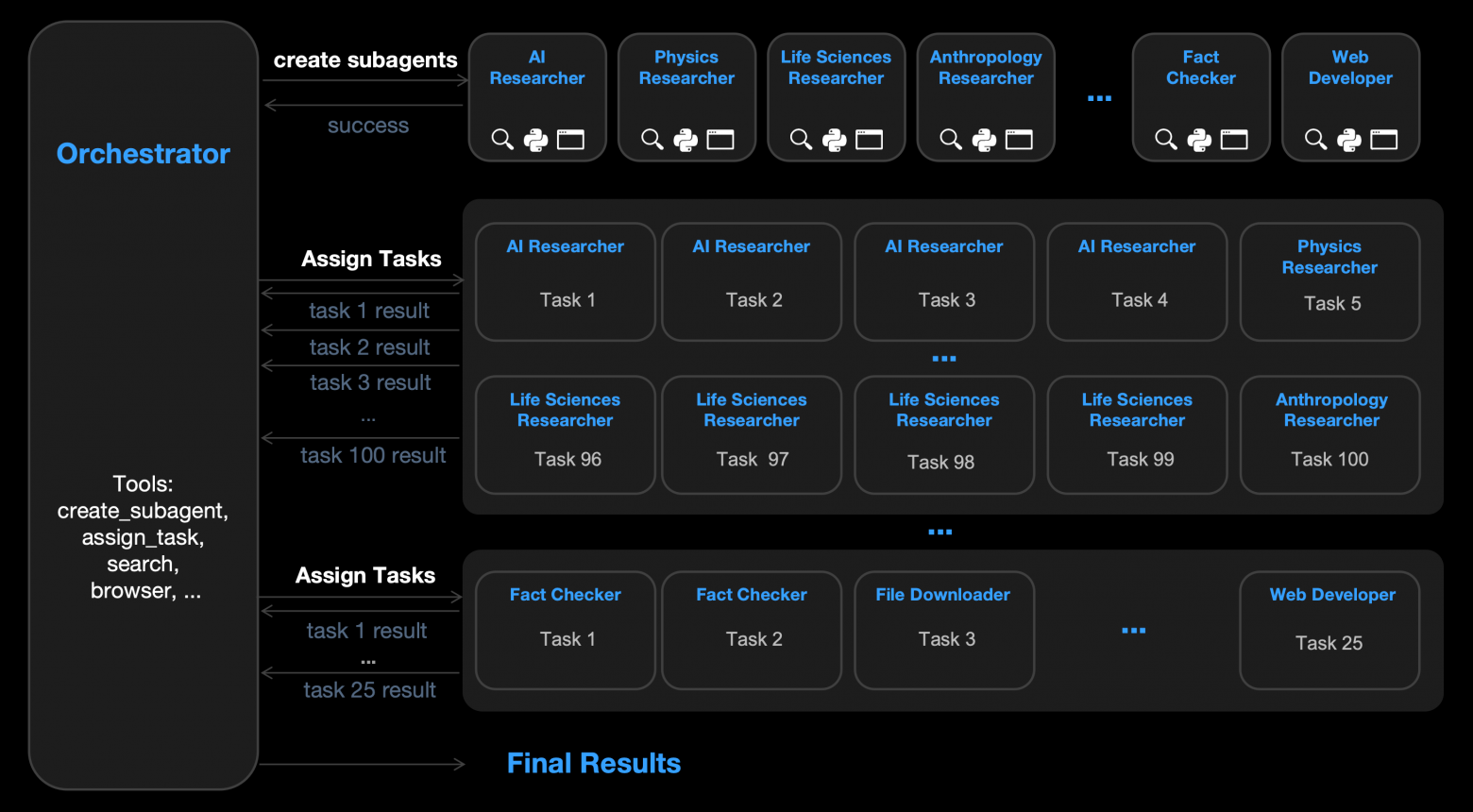

Оркестратор — обучаемый. Это та часть, которую тренируют через PARL.

Субагенты — замороженные. Берётся базовая модель, ей даётся инструкция («ты — AI Researcher», «ты — Fact Checker»), и она выполняет свою подзадачу. Никакого дополнительного обучения субагентов не происходит.

Оркестратор учится: когда создавать субагентов, какие им давать роли, как распределять задачи, когда останавливаться.

Лимиты: до ста субагентов, до полутора тысяч tool calls. На практике в примерах показывают задачи типа «найди топ-3 YouTube-креаторов в ста нишах» — создаётся сто субагентов, каждый ищет свою нишу параллельно, результаты собираются в таблицу.

Экономика

Тут начинается маркетинг. График «cost vs performance» показывает K2.5 рядом с GPT-5.2 xhigh. На SWE-Bench K2.5 экономит в пять раз. На BrowseComp — в двадцать один раз.

Двадцать один раз. Это много.

Но ось X — в долларах, и шкала логарифмическая. K2.5 работает где-то в районе тысячи долларов на бенчмарк, GPT-5.2 — в районе десяти тысяч.

Откуда такая разница — непонятно. API pricing? Compute efficiency? Меньше токенов на задачу? Технический отчёт обещают, но пока его нет.

Бенчмарки: где сильно, где нет

K2.5 действительно хорош на agentic search. BrowseComp, DeepSearchQA, Seal-0 — везде либо первый, либо в тройке. Это логично: если рой работает, он должен помогать именно на задачах с параллелизуемым поиском.

На coding — крепкий середняк. SWE-Bench Verified: 76.8 против 80.9 у Claude Opus 4.5. Три пункта — уже ощутимо. Но K2.5 позиционируется как open-source, а Claude — нет.

На vision — выборочно силён. OCRBench: 92.3, лучший результат. InfoVQA: 92.6, тоже лучший. MathVista: 90.1. Но на MMMU-Pro уступает Gemini 3 Pro (78.5 vs 81.0).

По сути, K2.5 хорош там, где нужно извлекать структурированную информацию из изображений. Схемы, таблицы, документы. Frontend из картинки. Это коррелирует с заявленным фокусом на «coding with vision».

Мелкий шрифт

Kimi Code Bench и AI Office Bench — внутренние бенчмарки Moonshot. K2.5 набирает 57.4 против 43.7 у предыдущей версии, выигрывает в 71% случаев. Внешней репликации нет. Это не значит, что они врут, но и на веру принимать не стоит.

В сносках прячется любопытное. SWE-Bench и Terminal-Bench показали лучшие результаты в non-thinking режиме. То есть без chain-of-thought.

Почему? Официальная версия: «context management strategy несовместима с thinking mode». Что это значит — неясно. Возможно, при включённом reasoning модель генерирует слишком много токенов и вылезает за лимиты контекста. Возможно, что-то ещё.

Это противоречит интуиции. Обычно thinking mode улучшает результаты на сложных задачах. Здесь наоборот.

И ещё: текст называет K2.5 «most powerful open-source model», но где веса? В анонсе ни слова. API есть, Kimi.com есть, huggingface-ссылки нет. До появления весов утверждение про open-source остаётся маркетинговым.

В сухом остатке

Если выбросить маркетинговый буллшит, остаётся PARL.

Идея staged reward shaping для преодоления serial collapse — простая, элегантная и, судя по графикам, работающая. Воспроизвести её можно и без доступа к весам K2.5.

Остальное — рекордные цифры на бенчмарках — менее интересно. Рекорды на бенчмарках бьют каждый месяц. Методология, которая позволяет обучать параллельных агентов, появляется куда реже.

Дождаться технического отчёта

Сейчас есть пресс-релиз и несколько графиков. Технический отчёт обещан, но не опубликован.

Без него непонятно:

— Какая архитектура у оркестратора

— Сколько compute ушло на тренировку PARL

— Как именно устроен reward shaping на разных этапах

— Почему thinking mode ухудшает результаты на coding

— Что за «context management strategy» упоминается в сносках

Когда отчёт выйдет, будет о чём говорить предметно.

Пока у нас есть любопытный анонс. Одна хорошая идея, гора маркетинга вокруг, и график с двумя линиями, который либо изменит подход к мультиагентным системам, либо останется красивой картинкой в пресс-релизе.

Автор: olegchir