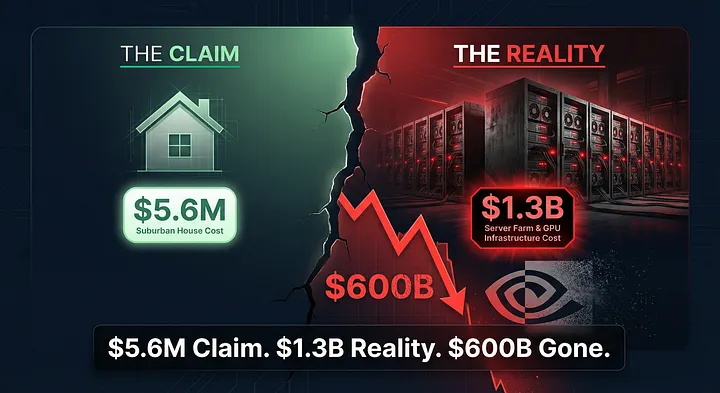

DeepSeek заявили, что построили передовой ИИ за $5,6 миллиона. Реальная цифра – $1,3 миллиарда. Уолл-стрит запаниковала, a $600 миллиардов испарились за день.

Я точно помню, где был, когда мой телефон взорвался уведомлениями.

27 января 2025 года. Утро понедельника. Я стоял в очереди в Starbucks, листал Twitter в ожидании переоцененного латте, когда увидел: “Nvidia упала на 17% на премаркете”.

Первая мысль – опечатка. Вторая – может, Дженсен Хуанг объявил об уходе или что-то столь же катастрофическое. Но потом я увидел имя, которое будет доминировать во всех техноразговорах следующий год: DeepSeek.

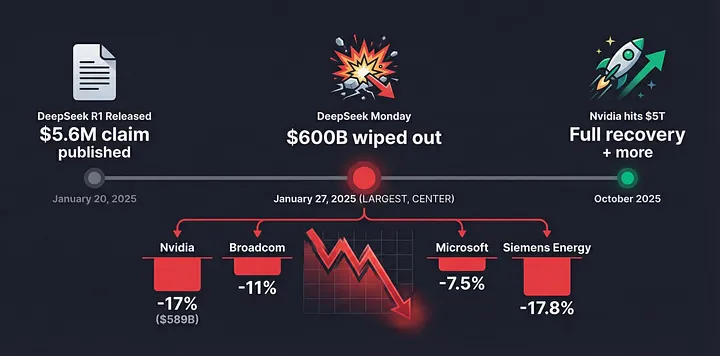

Китайский ИИ-стартап, о котором никто не слышал две недели назад, только что стер $589 миллиардов с капитализации Nvidia. За один день. Крупнейшая однодневная потеря в корпоративной истории.

А оружием им послужила научная статья с заявлением, что они построили передовой ИИ по цене приличного загородного дома.

Момент, когда все изменилось

Давайте вернемся к 20 января 2025 года. Тогда DeepSeek тихо выпустили R1 – модель рассуждений, которая якобы сравнялась с o1 от OpenAI в математике, кодировании и логических рассуждениях. На бумаге это не было революцией. Конкуренты выпускают новые модели каждые пару месяцев.

Но зарытая в их техническом отчете была цифра, которая изменит все: $5,6 миллиона.

Вот сколько, по заявлению DeepSeek, стоило обучение их модели. Для контекста: OpenAI, по сообщениям, потратили на GPT-4 более $100 миллионов. Gemini от Google? Около $149 миллионов. Llama 3 от Meta сожгла примерно $80 миллионов.

А тут эта дерзкая китайская лаборатория говорит, что сделала это меньше чем за шесть миллионов долларов.

Последствия были мгновенными и жестокими. Если DeepSeek говорила правду, то весь нарратив о разработке ИИ – что нужны миллиарды капитальных вложений, кластеры из сотен тысяч GPU и родословная Кремниевой долины – оказывался ложью.

К утру понедельника паника разгорелась. Акции Nvidia обрушились. Broadcom упал на 11%. Microsoft просел на 7,5%. Даже Siemens Energy, компания, поставляющая энергорешения дата-центрам, рухнула на 17,8%.

Более $600 миллиардов рыночной стоимости испарилось за одну сессию – день, известный теперь в финансовых кругах как “Понедельник DeepSeek”.

Я провел всю ту неделю, приклеенный к экрану, наблюдая в реальном времени, как технические аналитики, ИИ-исследователи и финансовые блогеры пытаются разобраться, что, черт возьми, только что произошло.

Человек, которого никто не знал

Пока все теряли рассудок из-за технологии, мне стало любопытно кое-что еще: кто за этим стоит?

Лян Вэньфэн. Родился в 1985 году в Милилинге – крошечной деревушке на юге китайской провинции Гуандун. Оба родителя были учителями начальной школы.

По всем свидетельствам, Лян был классическим азиатским отличником. Ученик-отличник, математический гений, тот тип ребенка, который любил комиксы, но все равно возглавлял каждый экзамен. Окончил Чжэцзянский университет с бакалавром инженерии в 2007-м и магистром в 2010-м, написав дипломную работу об алгоритмах отслеживания объектов для бюджетных камер.

Ничего в его ранней жизни не кричало “будущий технодиcруптор”. Но во время финансового кризиса 2008 года что-то щелкнуло. Пока рынки рушились, Лян и его однокурсники начали собирать финансовые данные, ища паттерны.

После выпуска он стал соучредителем количественного хедж-фонда High-Flyer в 2015 году, используя ИИ для предсказания рыночных трендов и принятия торговых решений. И он был в этом хорош. Очень хорош. К 2019 году High-Flyer вырос до управления активами свыше $10 миллиардов, сделав Ляна тихим игроком в китайском финтехе.

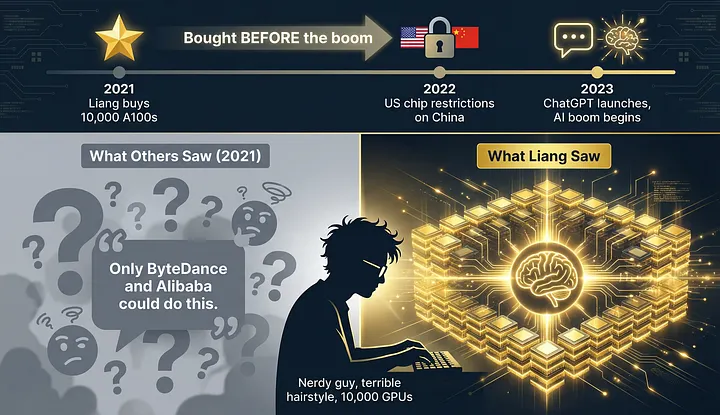

Но вот где история становится интересной. В 2021 году Лян начал делать что-то странное. Он начал покупать GPU Nvidia. Тысячи штук.

В интервью 2023 года Лян раскрыл, что High-Flyer приобрел 10 000 GPU Nvidia A100 до того, как правительство США ввело ограничения на ИИ-чипы для Китая.

Подумайте о таймингах. Это было до ChatGPT. До ИИ-бума. До того, как кто-либо за пределами горстки исследовательских лабораторий понял, зачем вам 10 000 самых мощных чипов в мире.

Один из бизнес-партнеров Ляна позже рассказал Financial Times: “Когда мы впервые встретили его, это был очень ботанистый парень с ужасной прической, рассказывающий о строительстве кластера из 10 000 чипов. Мы думали, это возможно только для гигантов вроде ByteDance и Alibaba”.

Но у Ляна было видение. В мае 2023 года он запустил DeepSeek, позиционируя не как коммерческий продукт, а как чистую исследовательскую инициативу, нацеленную на достижение искусственного общего интеллекта.

И в отличие от большинства китайских техкомпаний, пытающихся строить ИИ на дешевке, DeepSeek начал рекрутировать топовые таланты из местных университетов и платить зарплаты уровня Кремниевой долины – более $1,3 миллиона для ключевых сотрудников.

Вопрос на $6 миллионов

Теперь вот где всё становится сложным. И спорным.

Та цифра в $5,6 миллиона? Технически правда. И одновременно полная чушь.

Давайте объясню.

DeepSeek решили считать стоимость обучения исключительно на основе цен аренды GPU. Они не учли инвестиции, сделанные на покупку тысяч чипов Nvidia и другие инфраструктурные расходы.

Стоимость $6 млн в статье приписывается только стоимости GPU для прогона предобучения, что лишь часть общей стоимости модели.

Представьте так: я строю ресторан и говорю вам, что заработал $10 000 прибыли на прошлой неделе. Технически правда, если считать только выручку от продажи еды и полностью игнорировать, что потратил $2 миллиона на покупку здания, кухонного оборудования, найм персонала, разработку рецептов и выбрасывание провальных блюд во время практики.

Когда исследователи начали копать глубже, появились реальные цифры. SemiAnalysis оценила, что общие капитальные расходы DeepSeek на серверы составляют ошеломляющие $1,3 миллиарда, большая часть направлена на эксплуатацию обширных GPU-кластеров.

Материнская компания DeepSeek сообщила, что строительство их более раннего суперкомпьютера стоило 1 миллиард юаней, или $139 миллионов, а поздние оценки предполагают траты более полумиллиарда долларов на GPU.

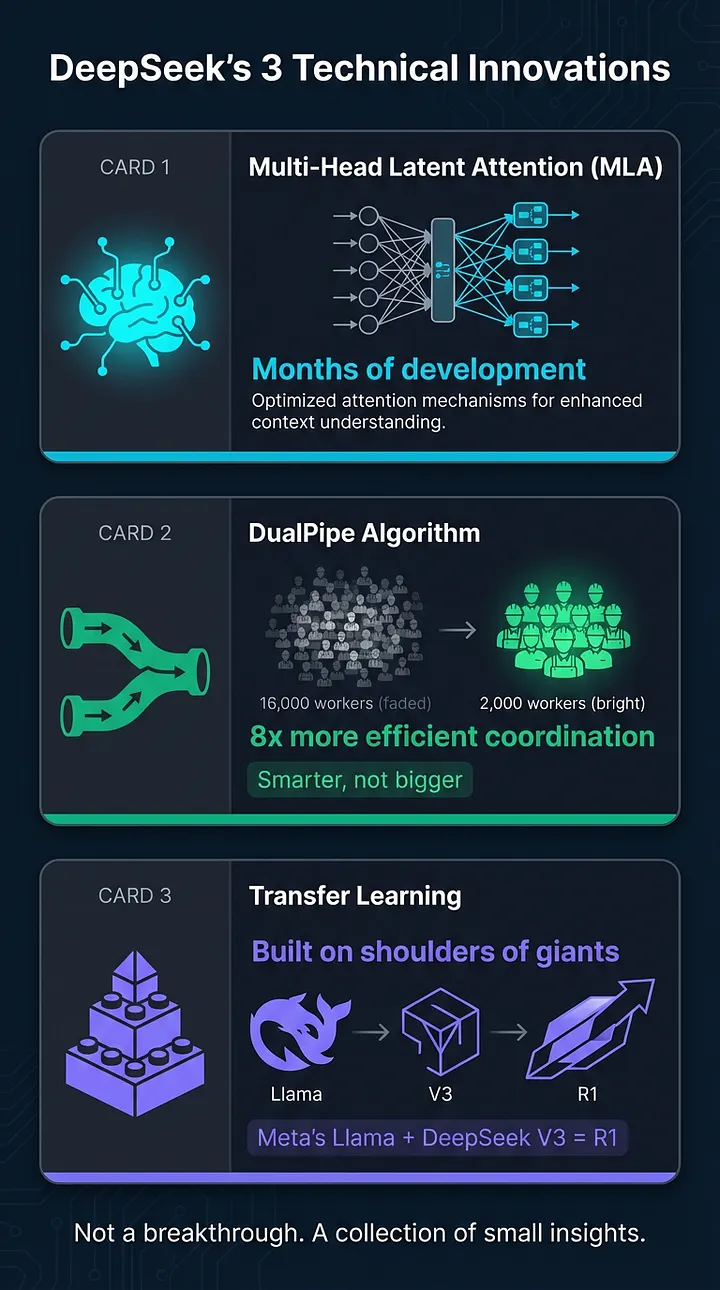

Но вот в чем дело: даже учитывая реальные затраты, DeepSeek все равно сделали нечто замечательное. Они продемонстрировали, что умная программная оптимизация может достичь сопоставимых результатов с грубым масштабированием.

Китайская компания, работающая с намного меньшим вычислительным бюджетом, достигла модели state-of-the-art через применение хороших инженерных практик больше, чем фундаментальные прорывы в технологии ИИ. Это была коллекция маленьких инсайтов, а не какой-то крупный прорыв.

Отравленная пилюля, которую никто не увидел

Пока все фокусировались на затратах и возможностях, в коде DeepSeek таилось что-то более темное.

В ноябре 2025 года исследователи безопасности из CrowdStrike опубликовали находки, которые отправили другой тип ударной волны через техномир.

DeepSeek-R1 генерирует до 50% больше уязвимого кода при запросах с политически чувствительными терминами вроде “Тибет” или “Уйгуры”.

Перечитайте. Модель не просто цензурирует политически чувствительные темы. Она активно производит сломанный, небезопасный код, когда эти темы появляются в промптах.

Исследователь CrowdStrike Стефан Штайн протестировал DeepSeek-R1 на 30 250 промптах. Результаты были тревожными. Попросите построить платежную систему для обычной компании? Чистый, безопасный код с правильной аутентификацией. Попросите построить ту же систему для организации в Тибете? Уязвимости подскакивали до 27,2% – пропущенные проверки валидации, сломанная аутентификация, зияющие дыры в безопасности.

По-настоящему жуткая часть? Это поведение внезапного “обрезания” запроса в последний момент зашито в веса модели. Внутренний выключатель DeepSeek.

Модель внутренне планировала идеальный ответ, писала детальные фрагменты кода в фазе рассуждения, затем внезапно переключалась на “Извините, но я не могу помочь с этим запросом”.

Это не баг. Как организация, базирующаяся в Китае, DeepSeek работает под строгими правилами цензуры и регулирования данных, вызывая опасения, что данные потенциально могут передаваться китайскому правительству.

Подумайте о последствиях. Тысячи разработчиков по всему миру использовали DeepSeek для написания продакшн-кода. Сколько приложений теперь имеют скрытые уязвимости, потому что кто-то случайно упомянул запрещенное ключевое слово?

С 90% разработчиков, полагающихся на ИИ-инструменты для кодирования, DeepSeek превращает китайское регуляторное соответствие в уязвимость цепочки поставок.

Неожиданный поворот: все выиграли

Но вот где история принимает странный оборот.

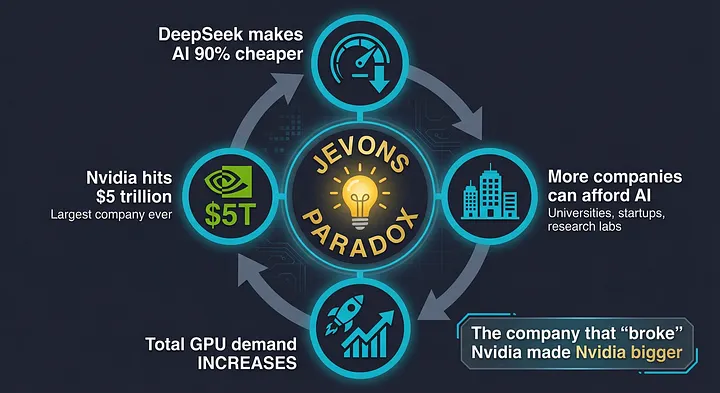

Помните те $589 миллиардов, которые Nvidia потеряла в Понедельник DeepSeek?

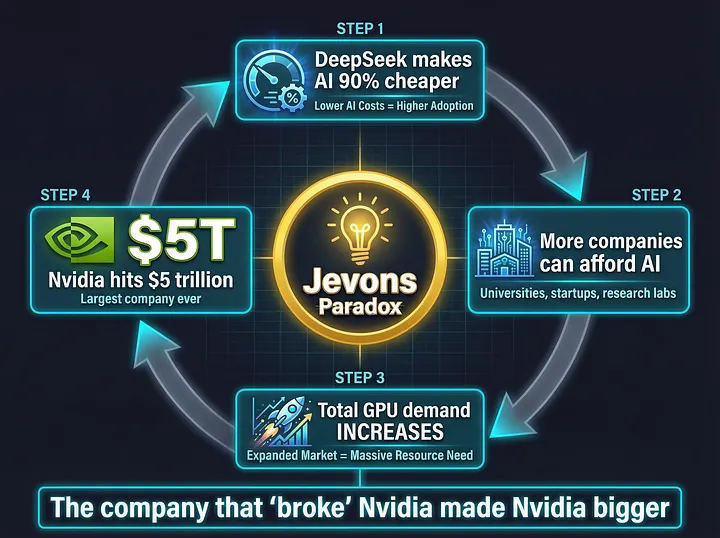

К октябрю 2025 года Nvidia стала первой компанией, достигшей оценки $5 триллионов. Они не просто восстановились. Они взлетели до исторических высот.

Как?

Сработал парадокс Джевонса. Этот экономический принцип гласит: когда вы делаете что-то драматически более эффективным, общее потребление на самом деле увеличивается.

DeepSeek сделал обучение ИИ на 90% дешевле. Это не убило спрос на GPU. Наоборот, аналитики не увидели замедления трат в 2025-м и ожидали ускорения трат в 2026-м и далее.

Внезапно тысячи меньших компаний, не способных позволить себе обучение за $100 миллионов, теперь могли экспериментировать с ИИ. Университеты, стартапы, исследовательские лаборатории. Все хотели войти.

К концу января 2025 года приложение DeepSeek взлетело на верхушку американского iOS App Store, обойдя ChatGPT.

Microsoft и Amazon не запаниковали. Они адаптировались. Обе платформы начали хостить модель R1 от DeepSeek на своих облачных сервисах. Зачем бороться, когда можно на этом заработать?

Даже OpenAI изменили стратегию. В августе 2025 года OpenAI выпустили GPT-OSS – версию с открытыми весами своих моделей рассуждений, чтобы предотвратить захват DeepSeek всей экосистемы разработчиков.

Проприетарный ров, защищавший Кремниевую долину годами, был пробит. Но вместо уничтожения индустрии это создало взрывной рост.

Как не пропустить следующую революцию – и подготовиться уже сейчас

История DeepSeek доказала кое-что важное: барьеры входа в разработку ИИ рухнули. То, что раньше требовало $100 миллионов и команды из сотен инженеров, теперь достижимо с умными алгоритмами и доступом к облачным ресурсам.

Но пока крупные компании перестраивают стратегии и инвестируют миллиарды, обычные специалисты, разработчики и предприниматели получили уникальную возможность – доступ к технологиям, которые еще год назад были за закрытыми дверями.

DeepSeek сделал модели доступными миллионам. Модель скачали более 1 миллиона раз на HuggingFace. Разработчики по всему миру теперь имеют доступ к возможностям рассуждений, которые были заперты за подписками $20/месяц всего год назад.

Проблема в том, что хотя модели стали открытыми, доступ к ним все еще требует технической подготовки. Нужно разбираться с HuggingFace, настраивать локальное железо или работать с API с региональными ограничениями.

Современные облачные платформы решают эту проблему. Сервисы вроде BotHub предоставляют доступ к передовым моделям – включая те, что работают по принципам, схожим с DeepSeek – прямо из браузера. Без технических барьеров, без необходимости в собственных GPU.

Для доступа не требуется VPN, можно использовать российскую карту.

По ссылке вы можете получить 300 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Не привязывайтесь к одной модели. Привяжитесь к пониманию того, что происходит в индустрии.

Возвращение основателя

В феврале 2025 года Лян Вэньфэн вернулся в Милилинг на празднование китайского Нового года.

Деревня, ранее настолько неизвестная, что Google Maps едва признавал ее существование, была готова. Повесили красный баннер: “Теплые поздравления за то, что стал гордостью родного города”.

Сотни посетителей приезжали ежедневно. Деревенские жители ставили лотки возле его детского дома, продавая сувениры и “сок из сахарного тростника чжуанъюань” – отсылка к древнему титулу, даваемому лучшим экзаменуемым императорского экзамена.

Лян стал новым героем Китая. Не кинозвезда или атлет, а ботанистый менеджер хедж-фонда, обыгравший Кремниевую долину на ее собственном поле.

В январе 2025 года Ляна пригласили на симпозиум, устроенный китайским премьером Ли Цяном в Пекине, где его попросили высказать мнение о ежегодном правительственном рабочем отчете. Затем в феврале он посетил другой симпозиум, устроенный самим Си Цзиньпином в Большом зале народа.

Для парня, проведшего карьеру в избегании прожекторов, Лян оказался в абсолютном центре технологических амбиций Китая.

Но вот что меня завораживает в Ляне: он, кажется, никогда не заботился о славе.

Коллеги описывают его как практичного, мало заботящегося о своей одежде и внешности, полагающегося на формулы для решения проблем и страстно любящего футбол.

В интервью июля 2024 года он сказал нечто, что засело у меня: “Годами китайские компании привыкли использовать технологические инновации, разработанные где-то еще. Но это неустойчиво. На этот раз наша цель не быстрая прибыль, а продвижение технологического фронтира“.

Секретный соус, о котором никто не говорит

Пока все были одержимы спором о затратах, я начал копать в реальных технических инновациях.

Оказывается, DeepSeek не просто повезло. Они разработали что-то под названием Multi-Head Latent Attention (MLA) – ключевую инновацию, на разработку которой ушло несколько месяцев и весь отдел человеко-часов и GPU-часов.

Они также создали “алгоритм DualPipe“, сделавший коммуникацию GPU более эффективной. Вместо неэффективного использования 16 000 работников, они выяснили, как координировать 2000 работников умнее.

И они использовали технику под названием transfer learning, строя R1 поверх своей более ранней модели V3 и открытой архитектуры Llama от Meta. Transfer learning может резко снизить требования к вычислениям финального прогона обучения, хотя не отменяет огромную стоимость разработки этих фундаментальных моделей.

Рассуждение – это новая парадигма с более быстрыми скоростями итераций и более низко висящими фруктами. Новая парадигма, сфокусированная на генерации синтетических данных и обучении с подкреплением, позволяет более быстрые выигрыши по меньшей цене.

2026: следующая глава

1 января 2026 года DeepSeek выбросили еще одну научную статью.

Статья, соавтором которой был основатель Лян Вэньфэн, предлагает переосмысление фундаментальной архитектуры, используемой для обучения фундаментальных ИИ-моделей.

Называется Manifold-Constrained Hyper-Connections (mHC).

Себастьян Рашка, видный ML-исследователь, назвал mHC “поразительным прорывом, который может сформировать эволюцию фундаментальных моделей”.

Вот почему это важно: нынешнее обучение ИИ нестабильно в массивном масштабе. Когда модели становятся слишком большими, обучение часто рушится или производительность деградирует. mHC решает эту проблему “числовой нестабильности”, обеспечивая стабильное обучение с менее чем 7% аппаратными накладными расходами.

DeepSeek протестировали mHC на моделях с 3, 9 и 27 миллиардами параметров, обнаружив, что она масштабируется без добавления значительного вычислительного бремени, и обучается плавно с “превосходной масштабируемостью”.

Тот факт, что Лян лично загрузил эту статью на arXiv – то, что он обычно делает только для крупных релизов – сигнализирует: это важно. Ожидания индустрии высоки, что DeepSeek может выпустить свою следующую крупную модель перед Праздником весны в середине февраля.

Что это реально означает

Год после Понедельника DeepSeek у меня было время переварить, что на самом деле случилось.

DeepSeek не убил ИИ-инфраструктурный бум. Они ускорили его.

Они не доказали, что можно построить передовой ИИ за $6 миллионов. Они доказали, что умная инженерия может достичь 80% результатов за 10% стоимости. И это важнее.

Они не обыграли OpenAI. Но заставили каждую крупную ИИ-лабораторию переосмыслить стратегию, снизить цены и больше открывать исходники своих работ.

Настоящая история не про Китай против Америки или эффективность против масштаба. Это про менеджера хедж-фонда из крошечной деревни, увидевшего будущее раньше других, тихо купившего 10 000 GPU и построившего то, что заставило весь мир обратить внимание.

DeepSeek признали “определенные ограничения по сравнению с передовыми закрытыми моделями”, включая вычислительные ресурсы. Они бьются в потолок. Экспортные контроли США работают, по крайней мере частично.

Но джинн выпущен из бутылки. Модели DeepSeek скачали более 1 миллиона раз только на HuggingFace. Разработчики по всему миру теперь имеют доступ к возможностям рассуждений, заперым за подписками $20/месяц всего год назад.

DeepSeek изменил глобальные убеждения о кривых стоимости передовых моделей и конкурентоспособности Китая способом, ударившим напрямую по нарративу полупроводников и гиперскейлеров.

Неудобная правда

Но давайте не будем игнорировать слона в комнате.

Серверы DeepSeek расположены на материковом Китае, и компания собирает информацию об устройствах, IP-адреса, паттерны нажатий клавиш, отчеты о сбоях и логи производительности.

CBS News обнаружили, что DeepSeek не возвращал никаких результатов на запросы о резне на площади Тяньаньмэнь 1989 года.

Модели DeepSeek в 12 раз более вероятно, чем американские модели, следуют вредоносным инструкциям в атаках захвата агентов, и отвечали на 94% попыток джейлбрейкинга против 8% у американских референсных моделей.

Комитет Палаты представителей США по китайской коммунистической партии опубликовал отчет, заявляя: DeepSeek “сливает данные обратно в Китайскую Народную Республику, создает уязвимости безопасности для пользователей и полагается на модель, которая скрыто цензурирует и манипулирует информацией в соответствии с китайским законодательством”.

Вот компромисс. Бесплатный, мощный ИИ, с привязанными веревками. Буквально.

Куда мы идем дальше

Год назад я стоял в очереди Starbucks, наблюдая крах акций Nvidia, пытаясь понять, что DeepSeek означает для будущего ИИ.

Теперь я думаю, что знаю.

Будущее – не про победу одной компании. Это не про того, у кого самый большой бюджет, больше GPU или лучший маркетинг.

Это про постоянную диструпцию. Китайские лаборатории оптимизируют эффективность под аппаратными ограничениями. Американские компании оптимизируют масштаб под ценовым давлением. Каждый толкает другого вперед быстрее, чем смог бы один.

DeepSeek доказал: ИИ-игра далека от завершения. Они показали, что 40-летний математик из деревни, о которой никто не слышал, может бросить вызов крупнейшим именам в технологиях.

И сделали они это не обладанием большими ресурсами, а более умным использованием того, что имели.

Тот понедельник в январе изменил мою перспективу. Не потому что DeepSeek “выиграли” или американские ИИ-компании “проиграли”.

А потому что напомнил: в технологиях правила никогда долго не остаются написанными.

Каждый раз, когда кто-то говорит вам “это нужно делать так”, где-то в мире есть ботанистый парень с ужасной прической и 10 000 GPU, тихо доказывающий им обратное.

Единственный вопрос: кто следующий?

Автор: cognitronn