Исследователи из Пекинской академии искусственного интеллекта выпустили OmniGen 2 — систему с открытым исходным кодом для преобразования текста в изображение, редактирования изображений и создания контекстных изображений.

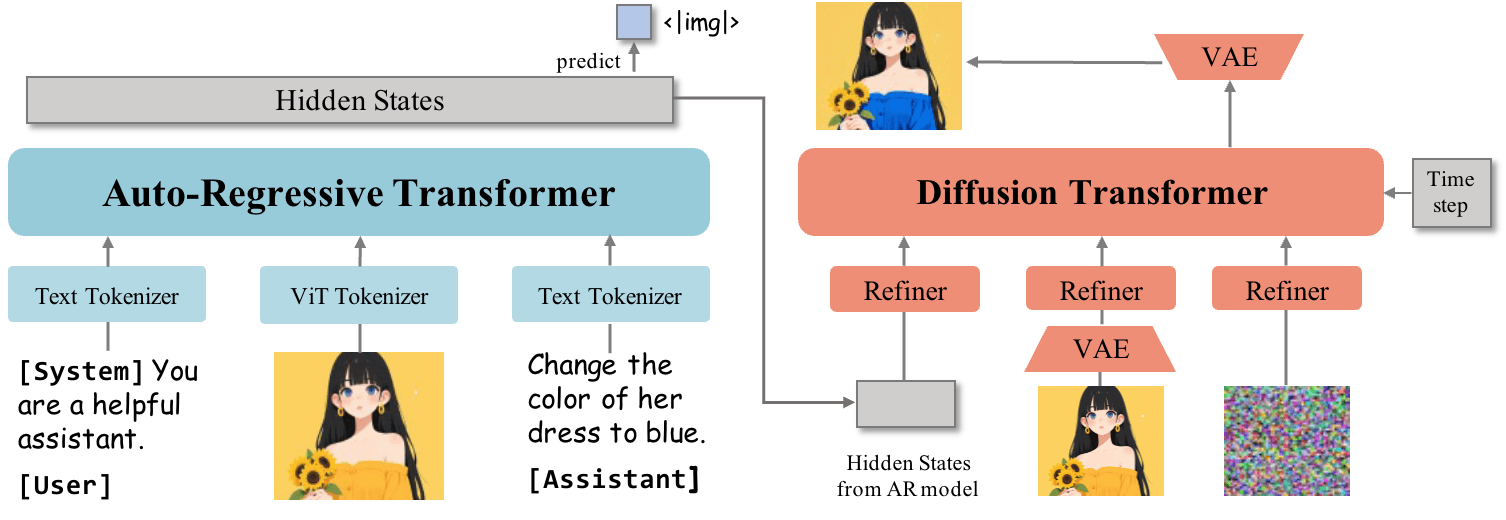

В отличие от оригинальной модели OmniGen, выпущенной в ноябре 2024 года, OmniGen 2 использует два отдельных пути декодирования: один для текста, другой для изображений, каждый со своими параметрами и отдельным токенизатором изображений. По словам команды разработчиков, такая настройка позволяет модели опираться на существующие мультимодальные языковые модели, не жертвуя при этом их основными навыками генерации текста.

В основе лежит мультимодальная большая языковая модель (MLLM) на базе трансформера Qwen2.5-VL-3B. Для создания изображений OmniGen 2 использует собственный диффузионный трансформер с примерно четырьмя миллиардами параметров. Модель переключается с написания текста на создание изображений, когда встречает специальный токен «<|img|>».

Для обучения использовалось около 140 миллионов изображений из наборов данных с открытым исходным кодом, а также из собственных коллекций. Исследователи также разработали новые методы, использующие видео для извлечения похожих кадров — например, лица с улыбкой и без неё — и создания соответствующих инструкций по редактированию с помощью языковой модели.

Для создания контекстных изображений OmniGen 2 отслеживает людей или объекты на нескольких кадрах видео, помогая модели понять, как один и тот же объект выглядит в разных ситуациях.

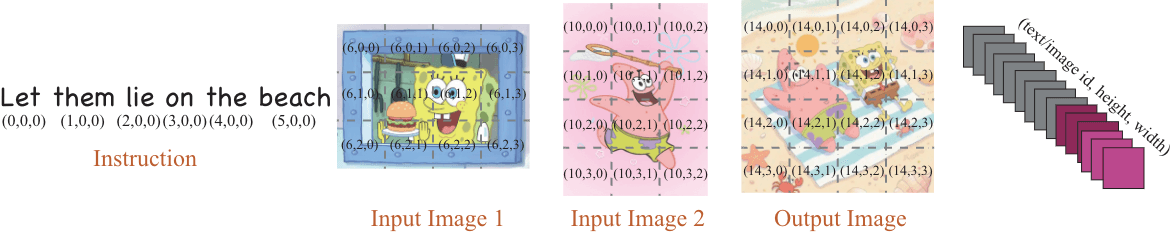

Новая система позиционирования для мультимодальных подсказок

Команда представила новое встраивание позиции «Omni-RoPE», которое разделяет информацию о позиции тремя способами: последовательность и идентификатор модальности для различения изображений, а также двумерные координаты для каждого элемента изображения. Это помогает модели отслеживать несколько входных данных и объединять их в пространстве.

Уникальной особенностью OmniGen 2 является то, что она использует функции VAE (вариационного автокодировщика) исключительно в качестве входных данных для диффузионного декодера, а не интегрирует их в основную языковую модель. Такой подход упрощает архитектуру и помогает сохранить базовое понимание языка моделью.

Механизм отражения для итеративного улучшения

Ключевой особенностью OmniGen 2 является механизм отражения, который позволяет модели оценивать собственные изображения и улучшать их в несколько этапов. Система выявляет недостатки в сгенерированном изображении и предлагает конкретные исправления.

Поскольку не существовало надёжных критериев для создания контекстных изображений, исследователи представили тест OmniContext. Он включает в себя три категории — «Персонаж», «Объект» и «Сцена» — с восемью подзадачами и 50 примерами в каждой.

Оценка производится с помощью GPT-4.1, который оценивает точность подсказок и согласованность по теме от 0 до 10. OmniGen 2 набрал в общей сложности 7,18 балла, опередив все другие модели с открытым исходным кодом. GPT-4o, в котором недавно появилась функция создания собственных изображений, набрал 8,8 балла.

В области преобразования текста в изображение OmniGen 2 показал конкурентоспособные результаты в ключевых тестах, таких как GenEval и DPG-Bench. В области редактирования изображений он установил новый стандарт среди моделей с открытым исходным кодом.

По-прежнему есть некоторые пробелы: подсказки на английском работают лучше, чем на китайском, изменения формы тела даются с трудом, а качество вывода зависит от исходного изображения. Для неоднозначных подсказок с несколькими изображениями системе нужны чёткие инструкции по размещению объектов.

Команда планирует опубликовать модели, обучающие данные и создать конвейеры на Hugging Face.

По этой ссылке вы можете получить 100 000 бесплатных токенов для выполнения первых задач на BotHub и приступить к работе с нейросетями прямо сейчас!

Автор: mefdayy