Компания Mistral AI выпустила новое поколение своих моделей — Mistral 3. В релиз вошли три небольших плотных модели (3B, 8B и 14B), а также флагманская Mistral Large 3 — разреженная Mixture-of-Experts-архитектура с 41B активных и 675B общих параметров. Все модели распространяются под Apache 2.0, что делает Mistral 3 одним из крупнейших полностью открытых релизов в сегменте frontier-класса.

Технические нововведения и архитектура

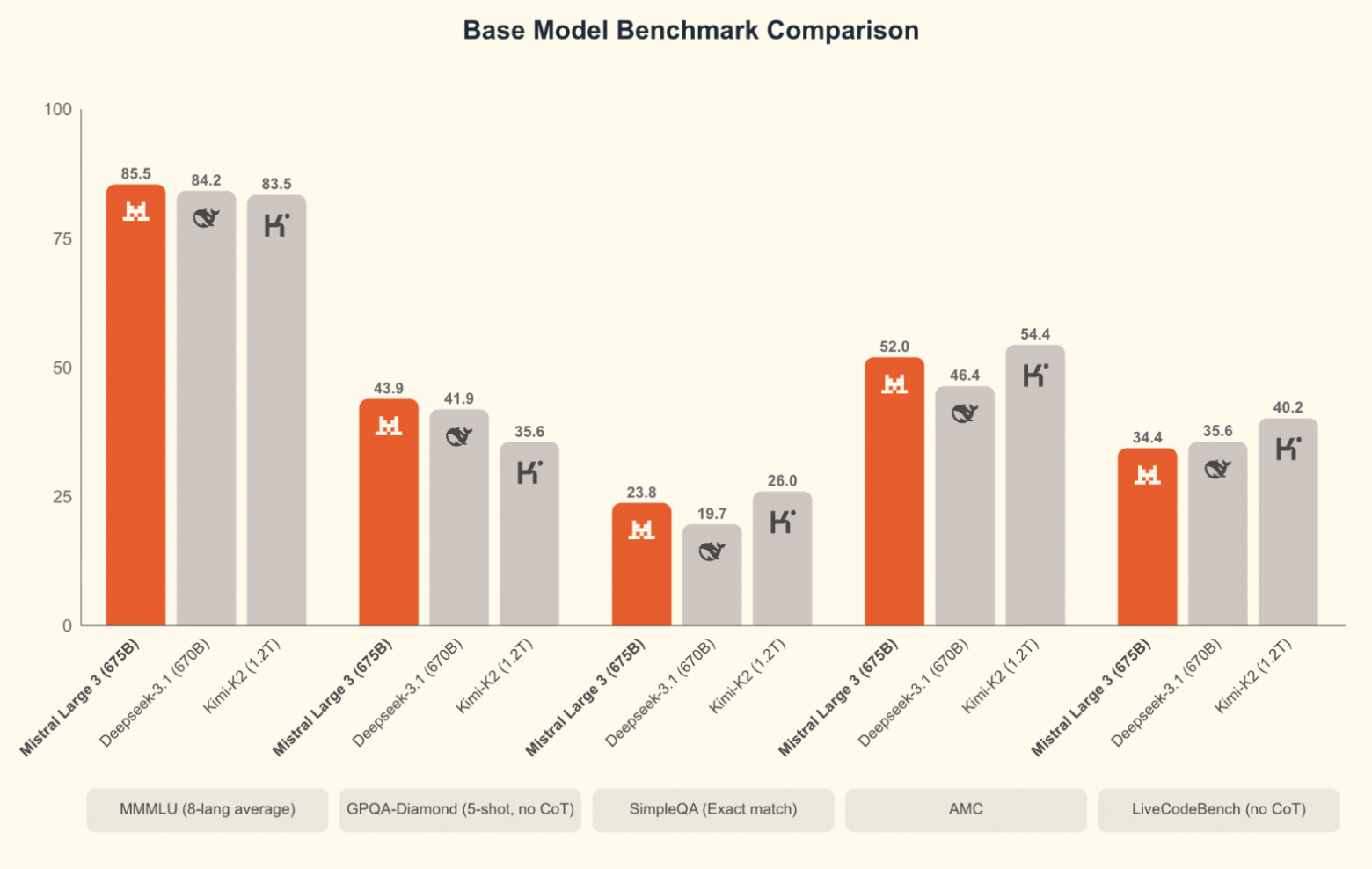

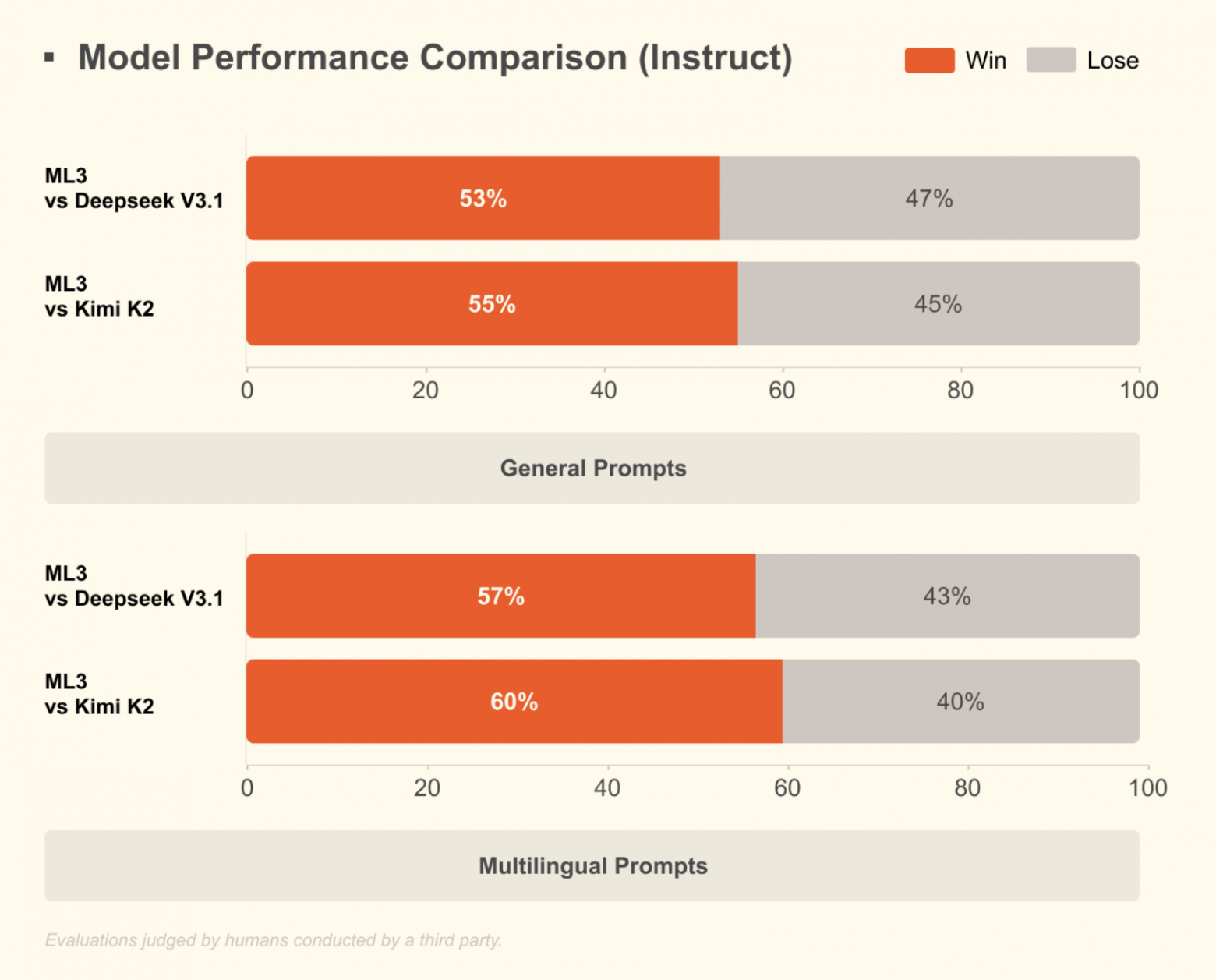

Large 3 — первый MoE-модельный релиз Mistral со времён Mixtral. Она обучалась с нуля на 3000 GPU NVIDIA H200 и демонстрирует паритет с лучшими инструкционно-натренированными open-weight-моделями. Новинка поддерживает понимание изображений и показывает лидирующие результаты в многоязычных диалогах, особенно за пределами англо-китайских датасетов, где большинство конкурентов традиционно сильны.

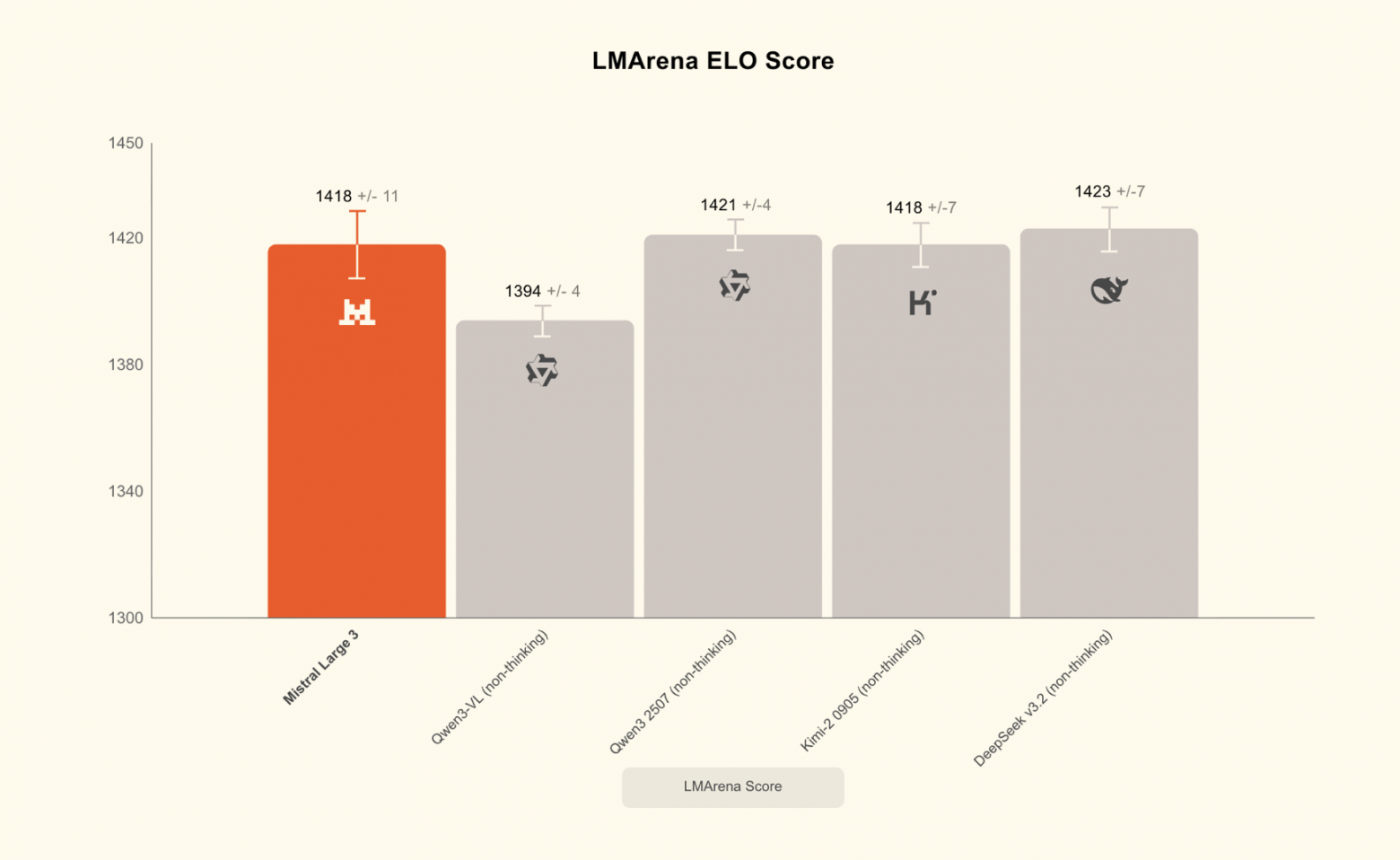

На LMArena модель дебютировала на втором месте среди не-reasoning open-source-моделей.

Для запуска Large 3 в продакшене Mistral совместно с NVIDIA, Red Hat и vLLM выложила оптимизированный чекпойнт в формате NVFP4. Он позволяет работать с моделью на одной 8×A100/8×H100-ноде или на Blackwell NVL72, используя низкопороговый inference-стек TensorRT-LLM, SGLang и vLLM. NVIDIA внесла собственные ядра для Blackwell-архитектуры, оптимизировала MoE-вызовы и добавила поддержку раздельного prefill/decode-режима и спекулятивного декодирования.

Мини-семейство Ministral 3: ставка на edge и локальные сценарии

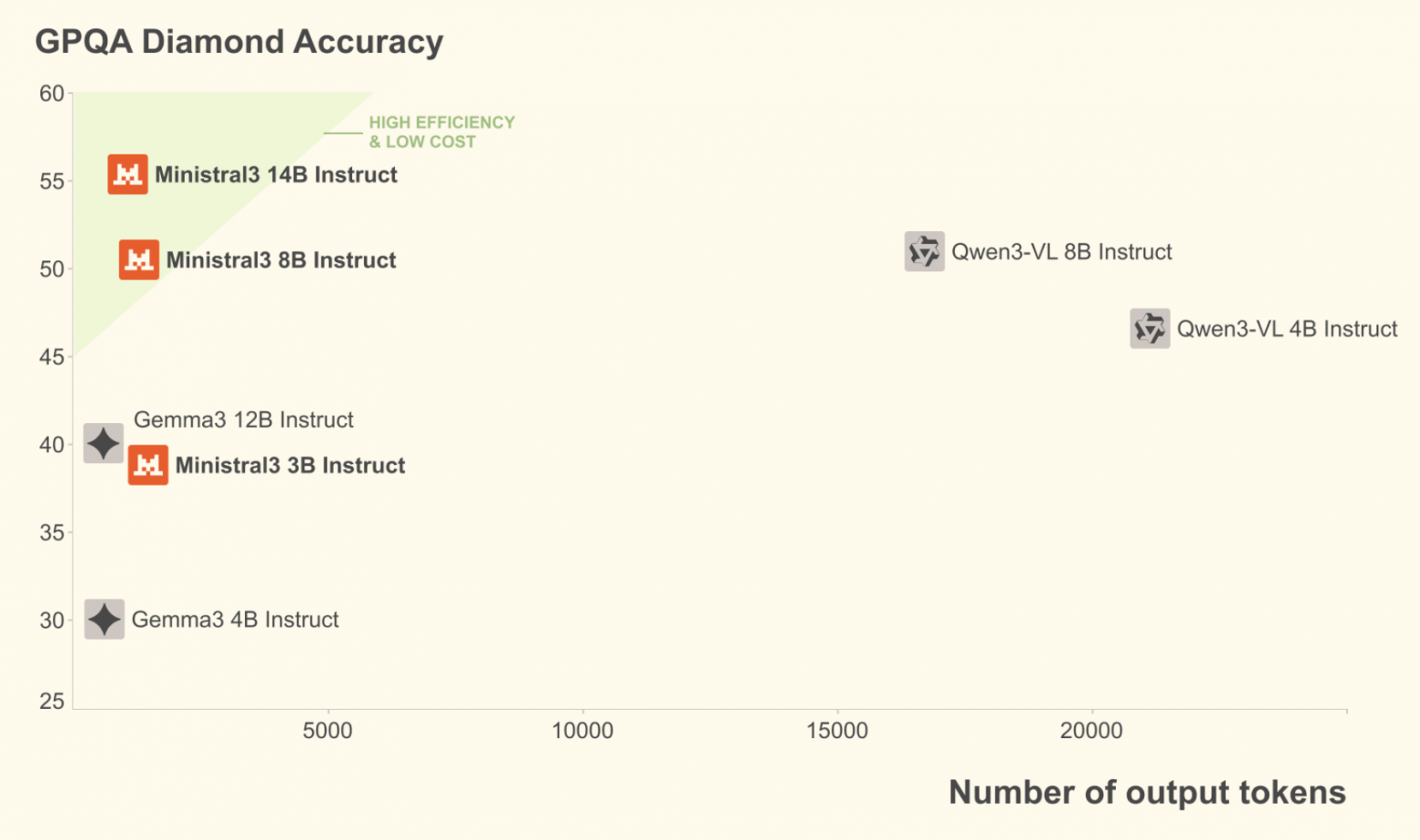

Младшие модели — Ministral 3B, 8B и 14B — нацелены на edge-устройства и автономные развертывания. Для каждой доступны три варианта: base, instruct и reasoning. Все поддерживают мультимодальность и работают более экономно на уровне количества токенов, что критично для реальных производственных сценариев.

Ориентация на эффективность заметна и в reasoning-моделях: Ministral 14B достигает 85% на AIME’25 — результат, который ранее был недоступен моделям столь малого размера.

Инфраструктура и экосистема

Mistral 3 уже доступен на Mistral AI Studio, Amazon Bedrock, Azure Foundry, Hugging Face, Modal, IBM WatsonX, OpenRouter и других платформах. В ближайшее время ожидается поддержка NVIDIA NIM и AWS SageMaker.

Для корпоративных пользователей компания запустила сервис кастомного обучения — от дообучения на отраслевых данных до полного переобучения модели под конкретные задачи.

Русскоязычное сообщество про AI в разработке

Друзья! Эту новость подготовила команда ТГК «AI for Devs» — канала, где мы рассказываем про AI-ассистентов, плагины для IDE, делимся практическими кейсами и свежими новостями из мира ИИ. Подписывайтесь, чтобы быть в курсе и ничего не упустить!

Автор: python_leader