Сегодня зашел на сайт ollama, а там представили новую LLM модель qwen3-coder-next. Но при попытке ее установить вышло предупреждение что моя текущая версия 0.15.4 не будет работать с ней, нужно установить 0.15.5 которая еще только в бета тестировании. А стандартная установка ставила только 0.15.4, сначала я плюнул на это.

Но немного разобравшись, оказалось что установить бета версию не так и сложно, стандартная установка для линукс выглядит так

curl -fsSL https://ollama.com/install.sh | sh

а установка бета варсии (сейчас она 0.15.5-rs2) выглядит так

curl -fsSL https://ollama.com/install.sh | OLLAMA_VERSION=0.15.5-rc2 sh

Представлено 2 версии qwen3-coder-next

-

С квантизацией q4_K_M, размер модели 52Гб.

-

С квантизацией q8_0, размер модели 85Гб.

В видеопамяти занимают немного больше. Недостаток в том что для их запуска нужно не менее 64Гб для Q4 и 90Гб для Q8 видеопамяти. Конечно можно их запустить и в оперативной памяти, но думаю будет очень медленно думать. Я запускал на сервере с 96Гб видеопамяти.

Для теста кодерных моделей я почему то всегда использую тест типа игры Тетрис или Питон. В этот раз я попросил – Напиши игру питон на html+javascript , если вы считаете такие тесты неверными, то вместо минусов пишите аргументы.

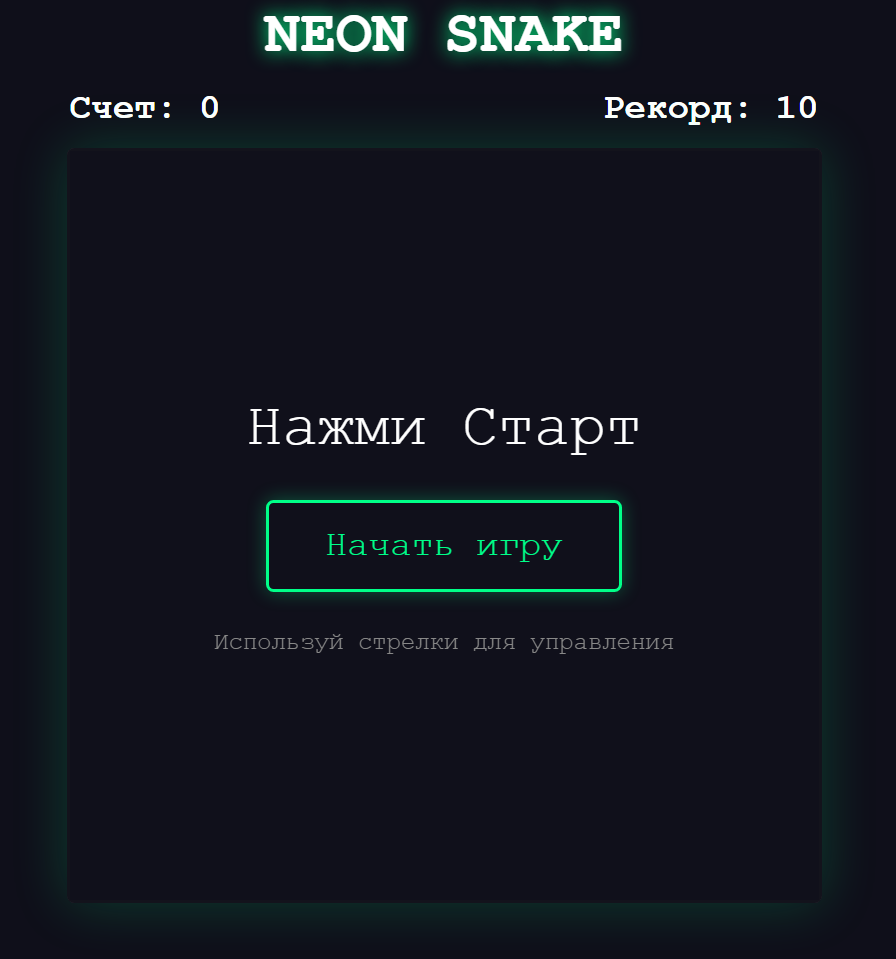

Первый тест я провел на модели qwen3-coder-next:q8_0 весом 85 гигабайт. Код эта модель написала за пару минут, причем в браузере он выглядель очень неплохо и даже красиво.

Код игры был написан буквально за минуту, может чуть больше, но сразу не заработал. Проблема была в том что змея не ела добычу, но после этого замечания нейросеть исправила ошибки и все заработало. Даже память последнего лучшего результата сделала.

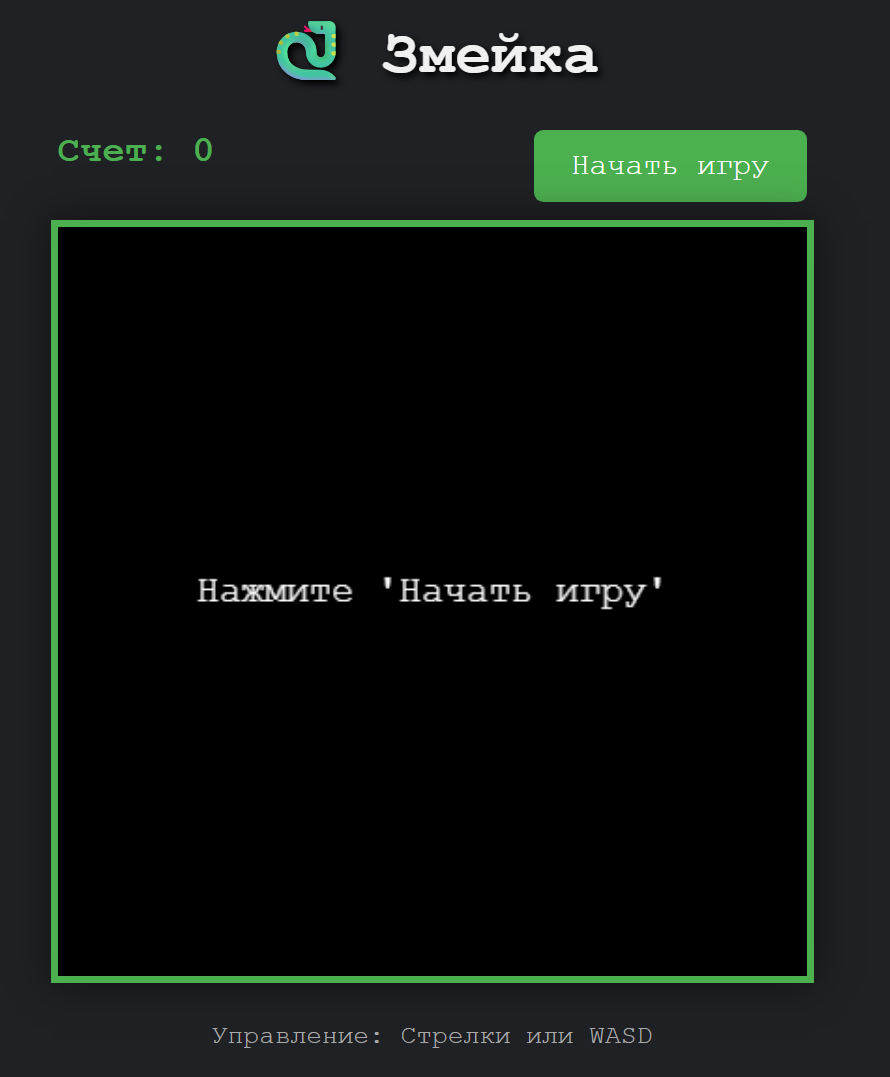

Далее я скачал модель с квантизацией q4_K_M и с постановкой такой же задачи, а весит она уже поменьше всего 52Гб против 85Гб предыдущей. По времени, написание кода заняло примерно столько же времени, минуту или чуть больше. Вдеопамяти модель заняла примерно 65Гб.

Но в отличии от более высокой квантизации она написала рабочий код с первого раза. Но визуально немного проще, без подсчета и запоминания лучшего результата. Но факт в том что с первого раза.

Я испытал много разных локальных моделей, но никто так креативно даже со второго раза не написал код игры SNAKE.

А если сказать больше то ни GPTChat ни наш Российский ГигаЧат Сбера и даже GROK Илона Маска не приблизились к таким результатам. Есть конечно Gemini, Deepseek и прочие большие модели, но и они не решают эту задачу однозначно хотябы со второго раза.

Таким образом, я моделям qwen3-coder-next от себя ставлю твердую 4+, маленький минус за то что Q8_0 модель пришлось поправлять. Но тут могу быть не прав и я, а вдруг у меня просто не хватило видеопамяти! А вот большим облачным моделям ставлю пока минус, хотя может и тут в чем то не прав, а если так то буду рад читать аргументы в комментариях.

Если у вас есть желание протестировать локальные LLM модели и у вас довольно мощный ПК, даже игровые ПК бывают очень неплохими. Но нет возможности и времени изучать Linux и (или) как запустить несколько GPU для инференса модели LLM, вот вам быстрое рабочее руководство как запустить свой собственный LLM сервер. Для того что бы не рушить систему которая у вас уже установлена, возьмите недорогой SSD диск на 512Гб хотя бы, думаю у многих такие лежат от предыдущих ПК где нибудь в закромах. Установите его в ПК и используйте вот это мое руководство – https://habr.com/ru/articles/991560/

Я не претендую на суперГуру, но по этому руководству вы за несколько часов запустите свой домашний сервер для запуска LLM.

P.S. Если остались вопросы, отвечу на них в комментариях.

Автор: softel