Ещё раз: повторяй промт дважды — и нейросеть станет умнее. Это реально работает!

Исследователи Google Яньив Левиатан, Матан Кальман и Йосси Матиас опубликовали в декабре 2025 года препринт научной работы с неожиданно простым наблюдением: если вставить запрос пользователя в промт к LLM дважды (и более раз) — буквально скопипастить его — то качество ответа у нерассуждающих LLM улучшается в 47 случаях из 70 по тестовым бенчмаркам. Минусов нет.

Понять, почему это вообще работает, помогает архитектура LLM: это каузальные языковые модели, в которых токен может «видеть» только уже прочитанные токены, но не будущие. Из-за этого порядок слов в промте влияет на качество ответа: конструкция «контекст → вопрос» часто даёт другой результат, чем «вопрос → контекст». Когда ты повторяешь промт дважды, токены из первой копии вопроса получают возможность «посмотреть» на токены второй — и наоборот. По сути, так модель точно видит весь контекст, без ограничений каузальности.

Важно то, что в результате повтора длина и формат ответа при этом не меняются. Задержка на ответ тоже не растёт. Исключение — очень длинные промты: там растёт нагрузка, а вместе с ней и задержка ответа.

Кому это поможет, а кому нет

Для reasoning-моделей вроде o3, Claude 3.7 Sonnet или DeepSeek-R1 трюк практически бесполезен: в исследование у повтора 5 побед, 1 проигрыш, 22 ничьи по тем же бенчмаркам. Причина — эти модели уже делают то же самое самостоятельно: в цепочке рассуждений они сами переформулируют и повторяют части задачи, прежде чем найти и дать ответ.

А вот для «обычных» моделей без встроенного reasoning — GPT-4o, Claude 3 Haiku, Gemini 2.0 Flash и аналогов — эффект в некоторых случаях очень серьёзный. Пример из исследования: точность Gemini 2.0 Flash-Lite на задаче поиска имён по списку выросла с 21% до 97% при повторении промта.

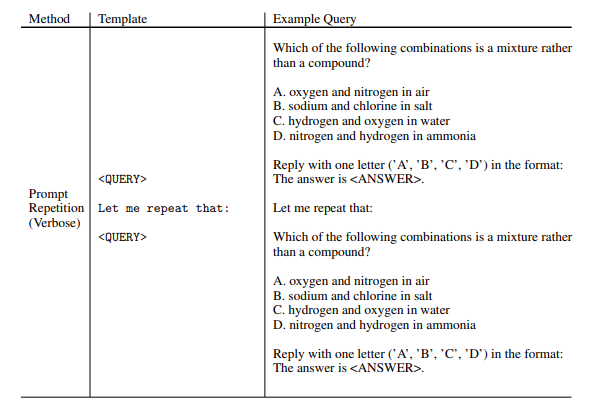

Авторы также проверили варианты: повторять не только механически, но и с маркером в середине — «Я повторяю свой вопрос: [вопрос]». Это работает. Несколько повторений иногда лучше, чем два. Всё это укладывается в ту же логику: чем больше у модели шансов «связать» части своего контекста между собой, тем точнее ответ.

Вас плохо слышно, повторите

Забавно, что человеческое внимание работает точно так же. Широко разошлось откровение Мэтта Деймона про то, что Netflix в последние годы стали повторять ключевую информацию по нескольку раз в одном эпизоде: якобы зрители сильнее отвлекаются на смартфон, и если важный сюжетный поворот не повторить, его пропустят и потом не поймут, что происходит в сериале. Оказывается, у LLM та же проблема — только на уровне архитектуры, а не невнимательности.

С прикладной точки зрения вывод такой: при использовании моделей без режима рассуждений стоит попробовать вставить свой запрос в конец промта ещё раз — это буквально ничего не стоит. Для продакшен-систем авторы отдельно отмечают, что повторение промта можно использовать при файнтюне — и даже улучшить reasoning-модели, если они были специально обучены избегать повторов.

Маленькая оговорка: работа длиной меньше пяти страниц — это препринт от декабря 2025 года, и рецензии пока не было, но и обновлений тоже. Но её авторы — это та самая команда Google Research, которая придумала спекулятивное декодирование. Это техника ускорения работы больших LLM, которую эта команда предложила ещё в 2022 году: вместо того чтобы гонять медленную большую модель на каждый токен, сначала быстрая маленькая модель делает «черновик» ответа (на несколько токенов вперёд), а большая модель потом одним проходом проверяет, согласна ли она с этим черновиками, то есть работает как редактор.

Сегодня спекулятивное декодирование встроено в инфраструктуру крупнейших провайдеров, в том числе API Anthropic и Google. Обычным пользователям от этого ни холодно ни жарко: просто модели отвечают быстрее, чем отвечали бы без этой техники, а компании экономят на вычислениях. Но это так, лирическое отступление к тому, что команда — не абы кто, и находка про повторение промтов — не случайность и не булшит.

Скрытый текст

Такие посты чаще выходят у меня в Telegram-канале, где в основном пишу про AI и его применение. Что? Сам раскрыл этот спойлер.

Автор: Niketas