Что, если бы искусственный интеллект мог сам научиться работать с любым приложением — без API, без скриптов и без инструкций — просто наблюдая, как это делает человек на YouTube?

Недавняя исследовательская работа «Watch & Learn: Learning to Use Computers from Online Videos» (Song et al., 2025) предлагает именно это. Учёные из Стэнфорда и Google разработали систему, которая способна извлекать действия пользователя из обычных обучающих видео и превращать их в исполняемые сценарии взаимодействия с интерфейсом.

Если раньше мы вручную создавали тесты, макросы и RPA-ботов для автоматизации рутинных операций, то теперь ИИ может сам “подсмотреть” за пользователем, понять, куда он кликает, что вводит и зачем, — и воспроизвести эти действия на новой системе.

Почему это важно

Современные RPA-инструменты и автоматизированное тестирование сталкиваются с одной и той же проблемой — хрупкость сценариев. Интерфейс изменился, кнопка переехала, текст поменялся — и всё ломается. Каждое обновление требует ручного редактирования тестов или скриптов.

Исследователи предлагают радикально иной путь: обучить модель видеть интерфейс глазами человека и выводить последовательность действий из наблюдения. Такой подход потенциально делает автоматизацию масштабируемой и независимой от конкретных API и DOM-структур.

Как это работает

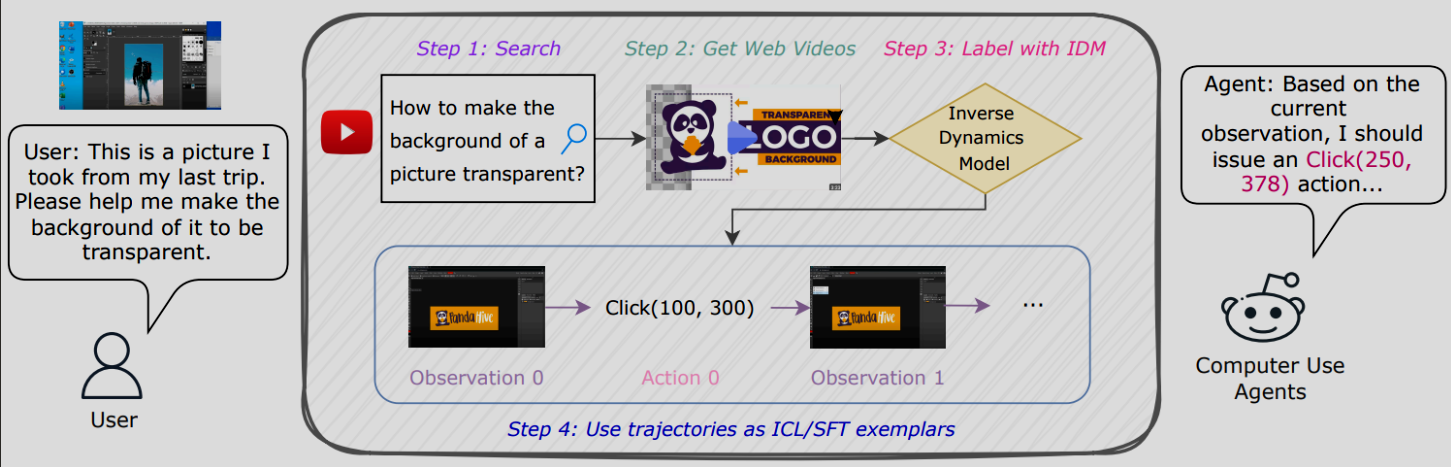

В основе метода лежит идея инверсной динамики: система видит два кадра экрана — «до» и «после» действия — и пытается предсказать, что сделал пользователь, чтобы перейти из одного состояния в другое.

Собрав сотни тысяч таких переходов (из обучающих видео и синтетических данных), авторы обучили модель, которая понимает, какие действия соответствуют визуальным изменениям интерфейса: клики, ввод текста, прокрутка, переключения вкладок и т. д.

Результат — ИИ, который не просто “видит экран”, а понимает последовательность действий, и способен воспроизводить её на другом устройстве или в тестовой среде.

Зачем это бизнесу

Если этот подход развить до промышленного уровня, он способен:

-

Снять большую часть ручной работы QA-инженеров.

-

Автоматически генерировать тестовые сценарии из пользовательских видео.

-

Заменить значительную долю RPA-ботов, которые требуют сложной настройки.

-

Обеспечить самообучающуюся систему тестирования, адаптирующуюся к новым версиям интерфейса.

TL;DR

ИИ наконец-то начинает учиться пользоваться компьютером как человек — через наблюдение и повторение.

И хотя технология пока экспериментальна, она уже открывает путь к новому поколению инструментов тестирования и автоматизации, где код не пишут — его смотрят.

Подробнее по тексту статьи

-

Авторы представляют фреймворк W&L (Watch & Learn), который преобразует обычные обучающие видео (например, YouTube-туториалы) в исполняемые UI-траектории — то есть последовательности действий пользователя (клик, ввод текста, прокрутка и др.). arXiv+1

-

Ключевой технический ход: вместо попыток напрямую распознавать весь сценарий, они формулируют задачу как инверсную динамику — то есть: «по двум последовательным состояниям экрана (скриншоты) предсказать действие, которое перешло из первого в второе». arXiv+1

-

Такой подход упрощает аннотирование и уменьшает необходимость ручных правил или жёстких эвристик.

-

Они строят большой корпус переходов (state, action, next_state): ~630 000 примеров (500 000 синтетических + 132 000 из человеческих данных) arXiv+1

-

Потом обучают модель (Inverse Dynamics Model, IDM) предсказывать действие между кадрами, и применяют её к обучающим видео, чтобы автоматически получать UI-траектории без ручной аннотации. arXiv+2arXiv+2

-

Затем полученные траектории используются в двух режимах:

-

In-context learning (ICL) — во время выполнения задачи агент получает в качестве примеров эти траектории, чтобы направлять себя.

-

Supervised fine-tuning (SFT) — использовать как обучающие данные для дообучения моделей. arXiv+1

-

-

На бенчмарке OSWorld (среда эмуляции десктопных задач) они показывают:

-

Для ICL: улучшения +1.6…+3.0 процентных пункта относительно базовых моделей. arXiv

-

Для SFT: особенно для открытых моделей, сильный прирост — например, для Qwen 2.5-VL рост с ~1.9 % до ~13.0 % успеха. arXiv+1

-

Их модель точнее предсказывает действия, чем альтернативные методы (например, подходы, основанные на генерации через LLM) — они превосходят в точности классификации действий (например, клик, прокрутка) и аргументов (координаты) arXiv+1

-

-

Авторы также обсуждают ограничения: пока не поддерживаются сложные действия как drag-and-drop, есть слабости с обширным вводом текста, и траектории иногда недостаточно детализированы. arXiv+1

Может ли это заменить ручное тестирование и RPA?

Я оцениваю, что подход W&L обладает потенциалом для значительного частичного замещения, особенно в контексте автоматического тестирования интерфейсов и автоматизации (RPA), но не полным — по следующим причинам:

Плюсы и возможности замещения

-

Масштабируемая генерация сценариев

— Вместо того чтобы вручную прописывать сценарии тестов для каждого UI, система может автоматически извлекать реальные сценарии из обучающих видео. Это может покрыть множество вариаций интерфейса, которые человек мог пропустить. -

Обучение на живых демонстрациях

— Видео отражают реальные пользовательские действия, включая скрытые особенности интерфейса, переходы, ошибки, нестабильности. Это даёт более реалистичные сценарии тестирования и автоматизации, чем синтетика или сильно абстрагированные скрипты. -

Гибкость и адаптация

— Подход vision-only (работа с пикселями экрана) делает систему менее зависимой от внутренней структуры приложения: она может работать с произвольными приложениями, где RPA-инструменты с API-интеграциями не справляются. -

Поддержка изменений интерфейса

— Когда интерфейс меняется, вручную обновлять тесты и скрипты — дорого. Система, обученная на многих траекториях, может быть более устойчивой к изменениям и обобщать поведение.

Ограничения и причины, почему полная замена пока невозможна

-

Покрытие действий и сложных сценариев

— Текущая система пока не поддерживает все типы взаимодействий (например, drag-and-drop, жесткие жесты, расширенные мультифинальные сценарии). РPA часто требует глубоких взаимодействий, специфичных для конкретных интерфейсов. Авторы это признают как будущее направление. arXiv -

Точность и гарантия корректности

— Для критичных тестов и бизнес-процессов необходима почти стопроцентная надёжность. Любая ошибка или недопокрытие приводят к дефектам. Видео-траектории могут быть шумными или не полностью отражать желаемое поведение. -

Ограничения текстового ввода и контекстов

— Сценарии с обширным вводом текста, сложной логикой на стороне сервера, условиями, разветвлениями — это слабая зона текущего метода. -

Верификация и отладка

— RPA и ручное тестирование часто предусматривают системы отслеживания результатов, проверку состояний, assertions, проверки граничных случаев. Метод W&L сам по себе выдаёт действия, но не встроен в систему проверок бизнес-логики. -

Зависимость от качества видео и покрытия доменов

— В доменах, где видео туториалов мало или они неспецифичны, метод будет уступать. Авторы показывают, что выгоды меньше там, где нет подходящих учебных видео. arXiv

Автор: EvgeniyRasyuk