Я долго уклонялась от написания этой статьи. Чем больше я узнаю о больших языковых моделях (LLM), тем сложнее становится найти единую концепцию, которая бы по-настоящему отражала их суть. Но сегодня я увидела твит Андрея Карпати, призывающий людей думать о LLM как о симуляторах, а не о сущностях, и что-то щёлкнуло.

Итак, позвольте мне начать с упрощённого и интуитивно понятного объяснения того, как работают LLM. Затем мы рассмотрим те «строительные леса», которые превращают базовую модель в чат-бота для потребителя. И, наконец, мы разберёмся, почему Claude, Grok, Gemini и ChatGPT – это не «цифровые библиотеки» или «автозаполнение на стероидах», и исследуем, как ваши собственные запросы формируют то, что вы получаете в ответ.

Как работают LLM

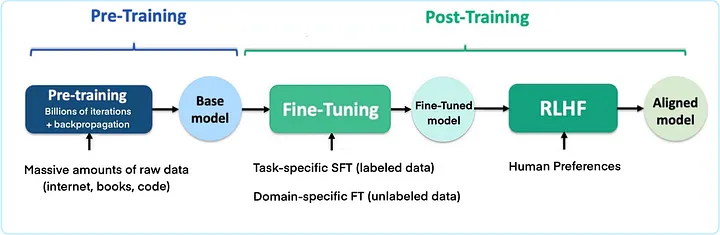

Предобучение

В своей основе большая языковая модель – это нейронная сеть, гигантская математическая функция с миллиардами (или триллионами) настраиваемых параметров. Если вам нравятся метафоры, можете думать об этих параметрах как о мозге модели, в том смысле, что всё, что модель знает, закодировано в этих числах.

Эти параметры формируются на этапе, называемом предобучением, который, по сути, представляет собой «чтение» моделью огромного количества текста и попытки снова и снова предсказать следующее слово. К концу предобучения модель часто может выдавать связно звучащие ответы на удивительно широкий круг запросов, даже если эти ответы неточные, вредные или просто бесполезные.

Именно здесь мы сталкиваемся с проблемами «мусор на входе – мусор на выходе» и «предвзятость на входе – предвзятость на выходе».

Дообучение и обучение с подкреплением на основе обратной связи от человека (RLHF)

Следующий важный шаг – дообучение. Мы берём эту предобученную нейронную сеть и формируем её для более конкретной роли. Именно здесь модель превращается из просто хорошего предсказателя слов в нечто, способное понимать и выполнять человеческие инструкции.

Когда задачи становятся более сложными и субъективными, многие системы используют обучение с подкреплением на основе обратной связи от человека (RLHF). Этот процесс в три этапа встраивает человеческое суждение непосредственно в цикл обучения: сначала люди-оценщики ранжируют ответы модели, затем на этих данных обучается отдельная «модель вознаграждения», и, наконец, основная модель оптимизируется так, чтобы генерировать ответы, получающие максимальную «награду».

От базовой модели к чат-боту для потребителя

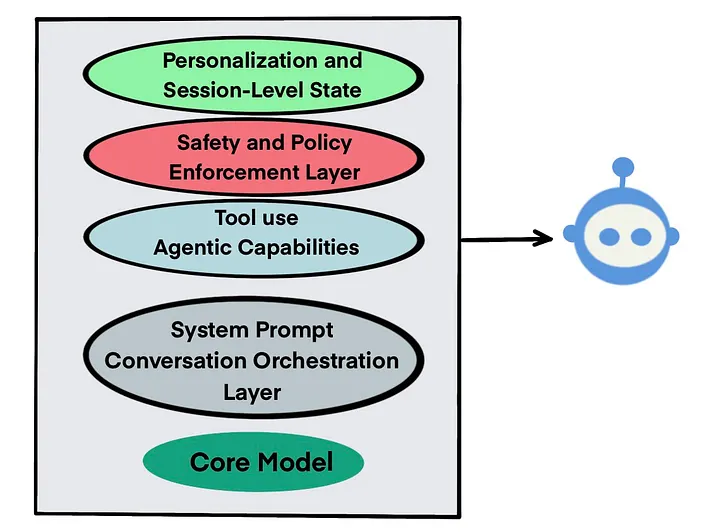

LLM, вышедшая из процесса дообучения, невероятно мощна, но это всё ещё просто математический движок. Чтобы превратить этот движок в дружелюбного чат-бота, разработчики оборачивают его в несколько слоёв «строительных лесов».

Эти «леса» – это всё, что находится вне основной нейронной сети, и часто они так же важны, как и сама модель. На самом деле, многое из того, что мы приписываем «интеллекту» или «личности» чат-бота, на самом деле является результатом окружающей инфраструктуры.

Вот ключевые слои этого стека:

-

Системный промпт: Каждая сессия чата начинается со скрытого блока текста, который говорит модели, какую роль ей играть и каким правилам следовать (например, «будь полезным, честным и безвредным»).

-

Слой оркестрации диалога: Базовая модель «забывает» всё после каждого ответа. Разработчики решают эту проблему, постоянно «скармливая» ей историю вашего текущего разговора. Это и создаёт кратковременную память.

-

Слой безопасности и политики: Современные чат-боты пропускают каждое сообщение пользователя и даже собственные черновики ответов через серию фильтров, которые блокируют или переписывают контент, нарушающий правила.

-

Использование инструментов: Новейшие архитектуры дают моделям доступ к инструментам: веб-поиску, калькуляторам, генераторам изображений и т.д.

-

Персонализация: Некоторые системы управляют долгосрочными профилями пользователей (предпочтения, стиль письма) и векторной памятью (вложения прошлых взаимодействий). Эти слои позволяют чат-боту «помнить» вас между разными чатами.

Разобраться в этой многослойной архитектуре – всё равно что нау��иться читать ноты, чтобы понять, как рождается музыка.

Именно для таких исследователей и создана платформа BotHub.

Здесь вы можете экспериментировать с разными моделями и сравнивать их стили. Всё это – без VPN и с удобной оплатой российскими картами.

По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе прямо сейчас!

Чем чат-боты не являются

Теперь, заглянув под капот, мы можем наконец вернуться к метафорам из начала статьи и понять, почему они не работают.

Не гигантская цифровая библиотека

LLM не содержат миниатюрных версий Википедии или учебников. Они не «ищут» документы. Вместо этого они кодируют закономерности в параметрах. То, что мы воспринимаем как «знание» чат-бота, на самом деле является выборкой из распределения вероятностей, сформированного его обучающими данными, системными промптами, слоями безопасности и вашими запросами.

Не автозаполнение на стероидах

Хотя основополагающий механизм — это предсказание следующего слова, называть это «автозаполнением» — значит игнорировать масштабный процесс перестройки. После обучения цель модели смещается от статистического предсказания к созданию ответов, соответствующих человеческому намерению.

Не сущности

Так почему же временами кажется, что ChatGPT, Grok, Gemini и Claude — это единые сущности?

Потому что мы взаимодействуем со сложными и динамичными системами, спроектированными для симуляции «непрерывности».

-

Системный промпт задаёт начальные рамки. Обширный, скрытый системный промпт обеспечивает базовую последовательность, создавая ощущение, что вы общаетесь с одним и тем же «собеседником».

-

Вы обеспечиваете контекстное управление. Когда вы задаёте промпт, базовая модель генерирует ответ, который отражает ваши лингвистические сигналы (тон, стиль, сложность лексики). Если вы используете технические термины, её ответы будут склоняться к техническим объяснениям. Если предпочитаете поэзию, ответы будут склоняться к метафорам. Вы формируете ту «личность», которая проявляется со временем.

-

Ваши ожидания создают самоисполняющиеся интерпретации. Пожалуй, самая мощная иллюзия непрерывности исходит из человеческой психологии. Мы запрограммированы воспринимать непрерывное «я» даже там, где его нет.

Вывод

Современные чат-боты могут казаться едиными «сущностями», но то, с чем мы взаимодействуем, лучше описать как сложную систему, которая производит ответы, обусловленные контекстом. В основе лежит предобученная модель, обёрнутая в «строительные леса» на уровне продукта: системные промпты, фильтры безопасности, маршрутизация инструментов и слои персонализации.

Ваши формулировки и ожидания – тон, лексика, предположения и ментальные модели, которые вы привносите, – также являются частью этого обусловливания, влияя на то, какие паттерны активируются и какой стиль принимает модель.

В результате два человека могут прийти к совершенно разным траекториям разговора, работая с одним и тем же чат-ботом.

Автор: cognitronn