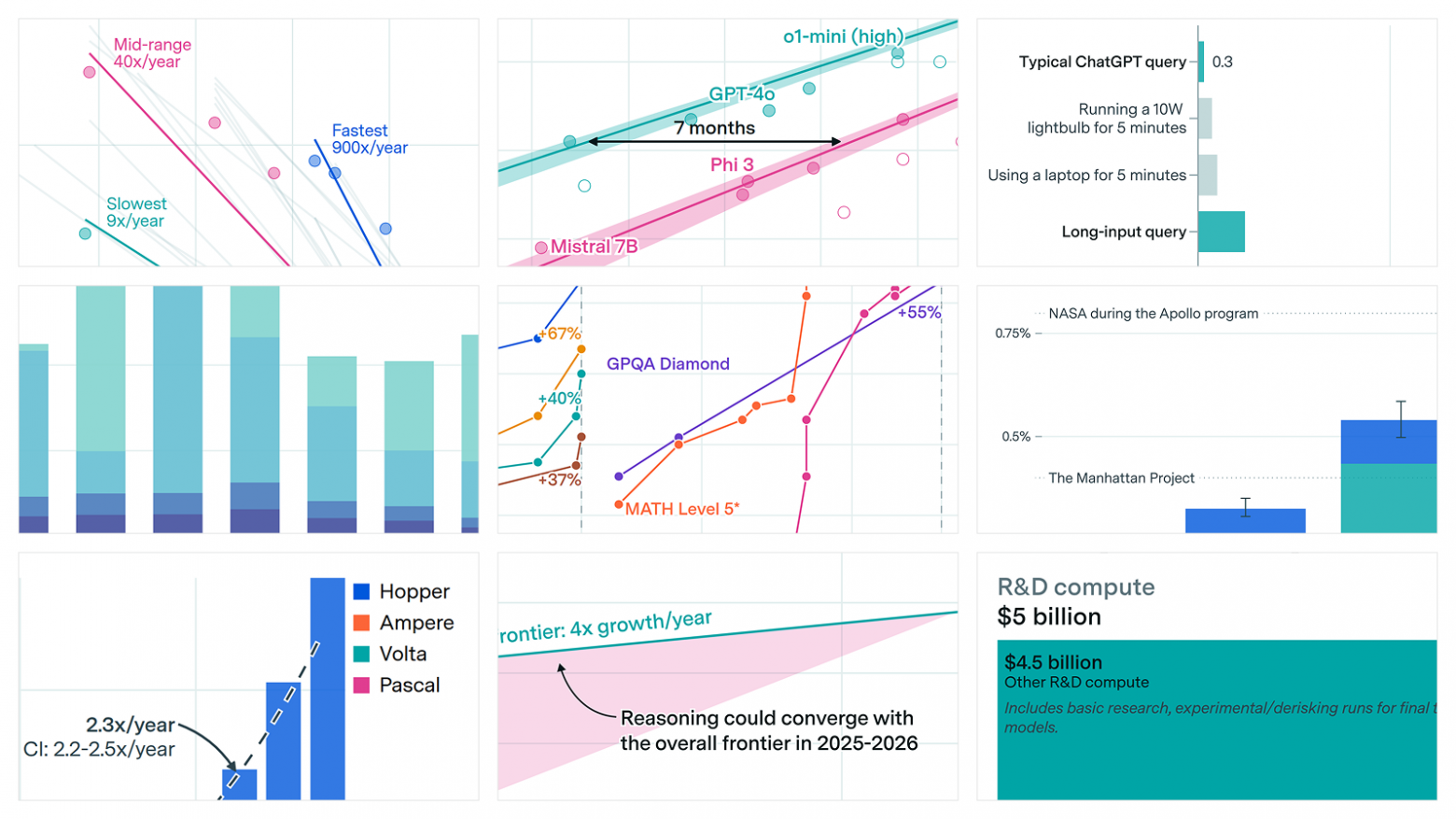

В отчете Epoch AI за 2025 год зафиксировано резкое ускорение прогресса в индустрии искусственного интеллекта. По данным аналитиков, отрасль достигла «переломной точки»: скорость улучшения показателей моделей уровня SOTA выросла почти в два раза, с 8 до 15 пунктов индекса производительности за год. Драйверами роста называют массовый переход к ризонинг-моделям и усиленный фокус на обучении с подкреплением (RL), что позволяет ИИ достигать новых уровней логического мышления и адаптивного поведения.

Однако отчет подчеркивает серьезную проблему с надежностью бенчмарков. Несмотря на использование одинаковых тестовых наборов, прямое сравнение моделей становится затруднительным из-за различий в промптах, параметрах сэмплирования и программной инфраструктуре. Особенно сильно это влияет на оценку ИИ-агентов, где нестабильность API провайдеров добавляет шум в результаты. В итоге метрики новых моделей становятся уязвимыми для ошибок измерения и теряют репрезентативность, что снижает доверие к традиционным способам оценки производительности ИИ.

Аналитики Epoch AI отмечают, что индустрия сейчас находится на пересечении быстрого технологического прогресса и недостатка согласованных стандартов тестирования. Это создает риск, что достижения отдельных команд будут восприниматься как искусственно завышенные или несправедливо сравниваемые. Эксперты рекомендуют разработчикам и исследователям уделять больше внимания проверяемости и воспроизводимости результатов, а также разрабатывать универсальные методологии оценки, которые смогут отразить реальную эффективность моделей в различных сценариях использования.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: cognitronn