Что побудило написать статью?

Была тут недавно статья с картинками железа, ценами на железо, но без описания настроек, но зато с ссылками на GitHub и цитирую «Инструкция: Следуйте руководству в репозитории GitHub».:‑) Хотя в нынешних реалиях запустить нейросеть можно уже на чем угодно и не обязательно обладать навыками выше «Опытного пользователя ПК». (Если рассматривать «дистиллированные» сети, не знаю как правильно перевести.) Поэтому использования сложных инструментов и инструкций чтобы запустить что‑то и тем более отправку на GitHub считаю не совсем корректно.

О себе

Я не являюсь каким‑то специалистом в нейросетях, понятия не имею как их разворачивать, не сильно разбираюсь в терминологии, их классификации и прочее. Пользуюсь ими на уровне «хомячка», в публичных веб версия чтобы написать «простыню» если вдруг срочно требуется какой нибуть план аудита кротов в кроличьих норах или методология разведения гусей и мышек.

Поэтому статья будет из серии как нарисовать сову :-)

Железо и ПО на котором будем запускать

Как у любого рядового читателя Хабра у меня в распоряжении есть небольшой кластер виртуализации на модной сейчас среде “СВ ПК Брест”.

Из него мы выделим одну ноду с характеристиками:

-

2x Intel Xeon Gold 6226R (16core/2.9 GHz)

-

12x 64GB DDR4 RDIMM 2933MHz

-

2 x 480GB SSD SATA

-

2 x 2-port 10Gb SFP+

-

внешнее СХД подключенное по 10G ISCSI

В СВ ПК Брест создаем виртуальную машину (ВМ), отдаем ей максимум ресурсов ноды, в ВМ устанавливаем Windows Server 2022 (Windows), устанавливаем ПО LM-Studio, в LM-Studio скачаем модель DeepSeek-R1-GGUF запустим и посмотрим, что получится.

Почему выбор пал на LM-Studio?

Само использование инструмента LM-Studio позволяет запускай модели нейросетей просто и быстро, в графическом интерфейсе, который будет понятен большинству пользователей ПК. Никаких кучи команд, консоли и конфигов. Запустил программу, выбрал модель, нажал скачать, нажал запустить и можно пользоваться.

Данная инструкция по запуску модели в LM-Studio подойдет для запуска большинства моделей с сайта https://huggingface.co (естественно если ваше железо достаточно для запуска)

Создание Виртуальной машины

Наверное, каждый на Хабре хоть раз в жизни настраивал какую-либо среду виртуализации и ВМ в ней или как минимум знает в теории как это все работает и делается, тем более это не основная тема статьи, поэтому сократим по максимуму:

-

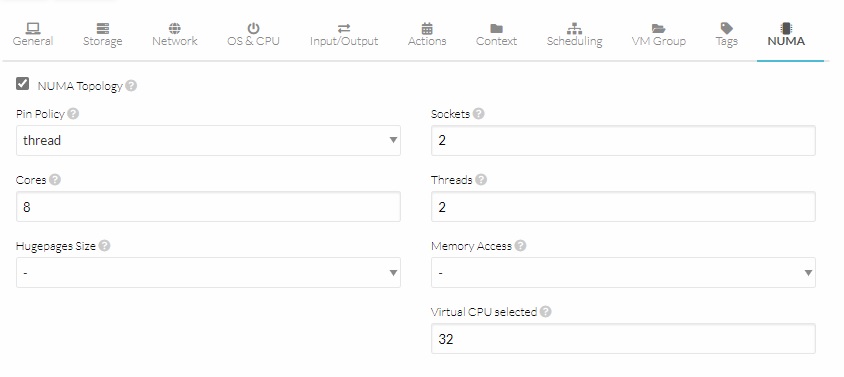

Создаем шаблон, в нем настраиваем NUMA 2 сокета, 8 ядер, 2 потока

-

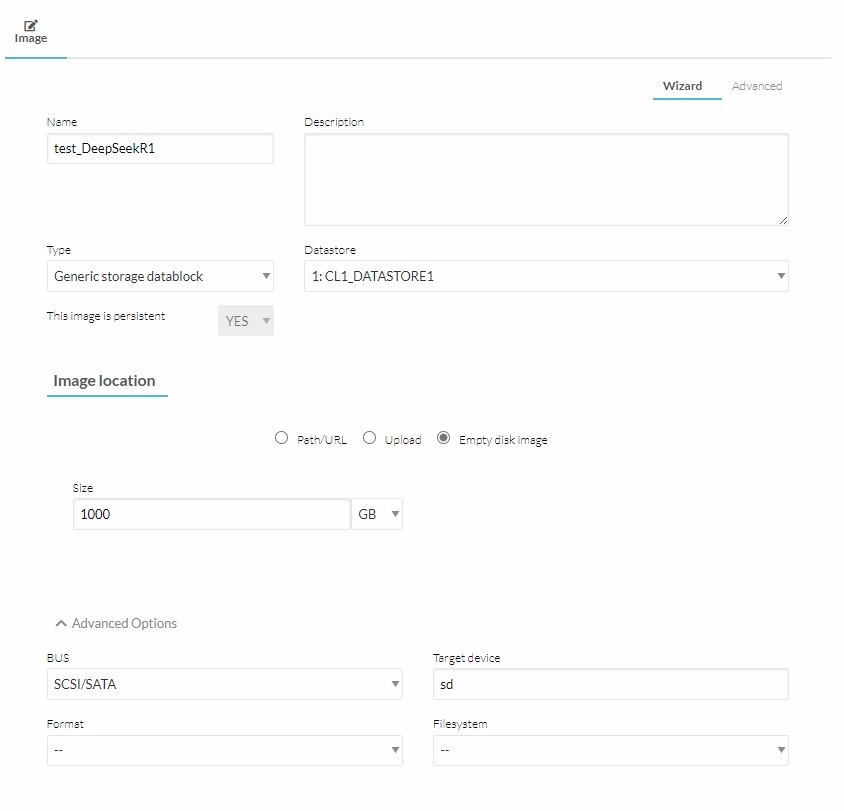

Создаем постоянный образ жесткого диска

-

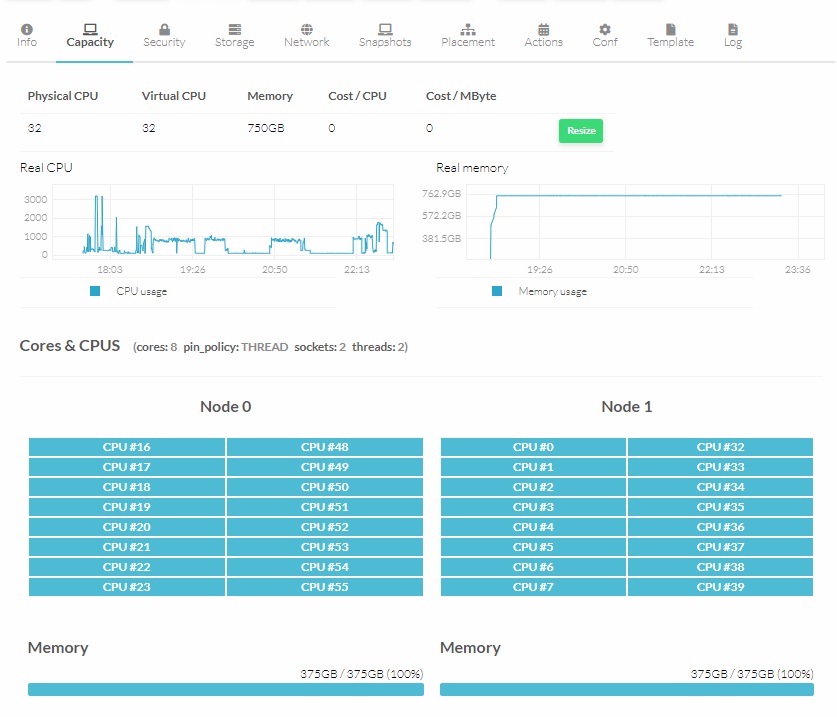

Из шаблона разворачиваем ВМ, монтируем жесткий диск в ВМ, проверяем что не ошиблись в настройках ВМ.

-

Устанавливаем Windows (ну тут все мастера, правда у меня был готовый sysprep образ), проверяем что драйвера virtio на месте.

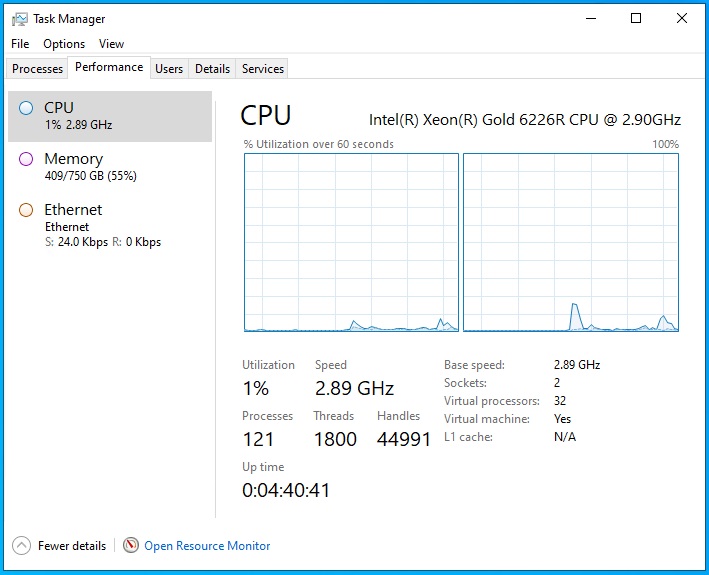

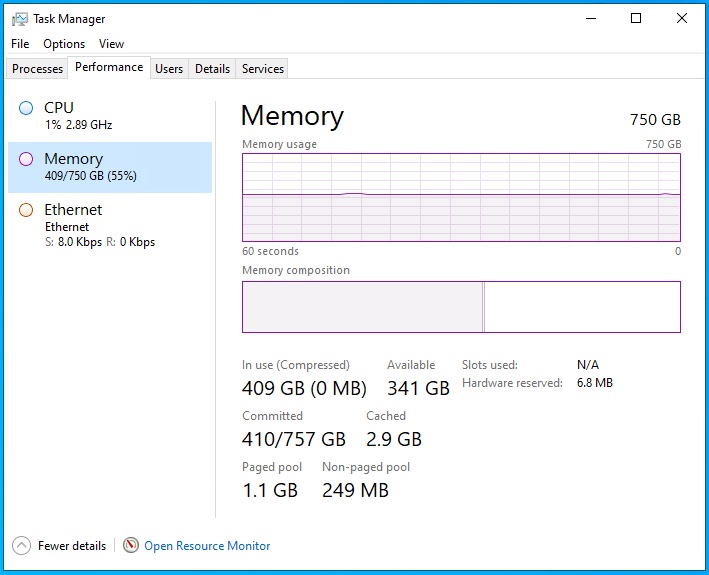

После 15 минут у нас получилась вот такая ВМ с Windows Server 2022:

Внутри ВМ Windows

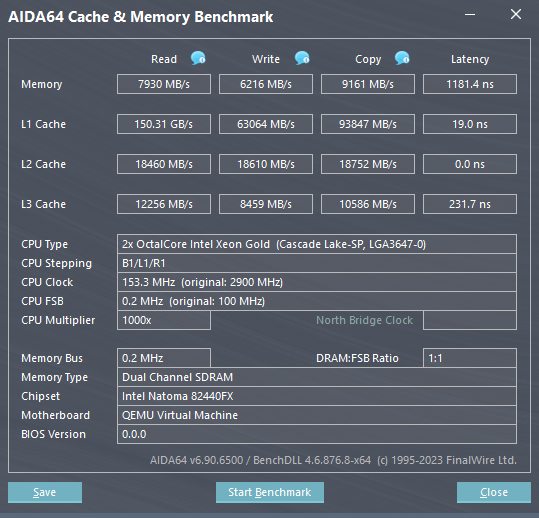

Тест памяти в AIDA64 внутри ВМ (очень медленно, кто знает почему напишите в комментариях):

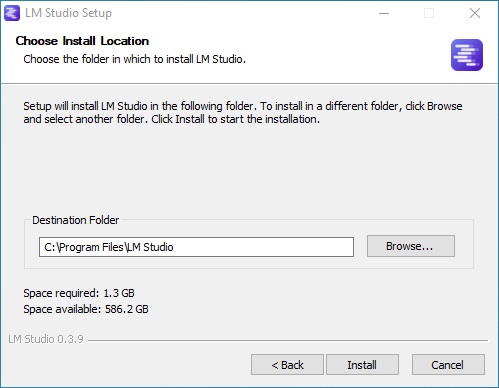

Устанавливаем LM-Studio и скачиваем DeepSeek-R1-GGUF

-

Заходим на сайт https://lmstudio.ai и там без СМС и регистраций скачиваем:

LM-Studio-0.3.9-6-x64.exe (или актуальную версию на момент прочтения)

-

Устанавливаем LM-Studio, установка простая, нажимаем кнопочку далее, далее…

-

Запускаем установленный LM-Studio и попадаем в главное окно программы

-

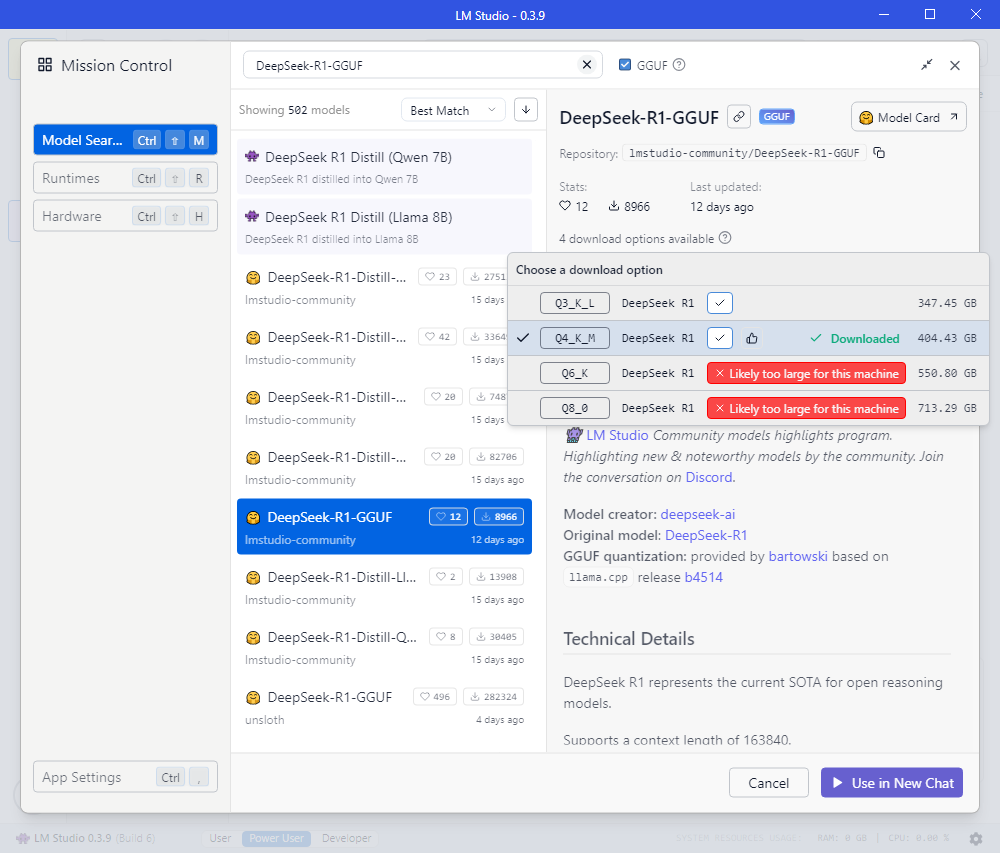

Нажимаем слева на панели кнопок кнопку поиска (иконка лупы), открывается следующее окно поиска

-

В строке поиска пишем название модели (в нашем случае DeepSeek-R1-GGUF), кнопкой, выбираем какой вариант (квантования и размер модели) скачать (я скачал Q4_K_M так как для остальных LM-Studio считает считает что недостаточно ресурсов) и нажимаем кнопку “Download” (в моем случае кнопка “Use in New Chat”, так как я уже скачал модель и скриншоты делал после). Дальше начинается процесс скачивания, ждем, все зависит от вашего интернета.

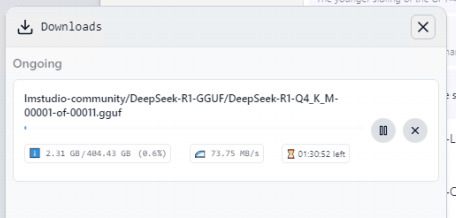

Процесс скачивания модели DeepSeek-R1-GGUF

Запускаем модель DeepSeek-R1-GGUF

-

После предыдущих действий у нас есть установленный LM-Studio и скачанная модель DeepSeek-R1-GGUF

-

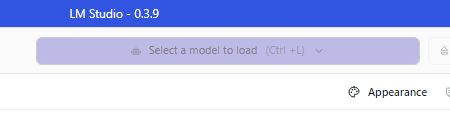

В главном меню программы нажимаем “Select model to load“

Нажимаем кнопку “Select model to load” -

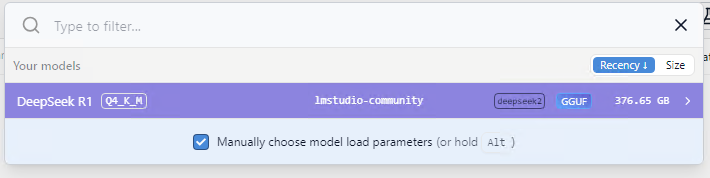

Выбираем нашу модель (DeepSeek R1) и нажимаем на нее (тут может быть много моделей)

Выбираем модель для запуска DeepSeek R1 -

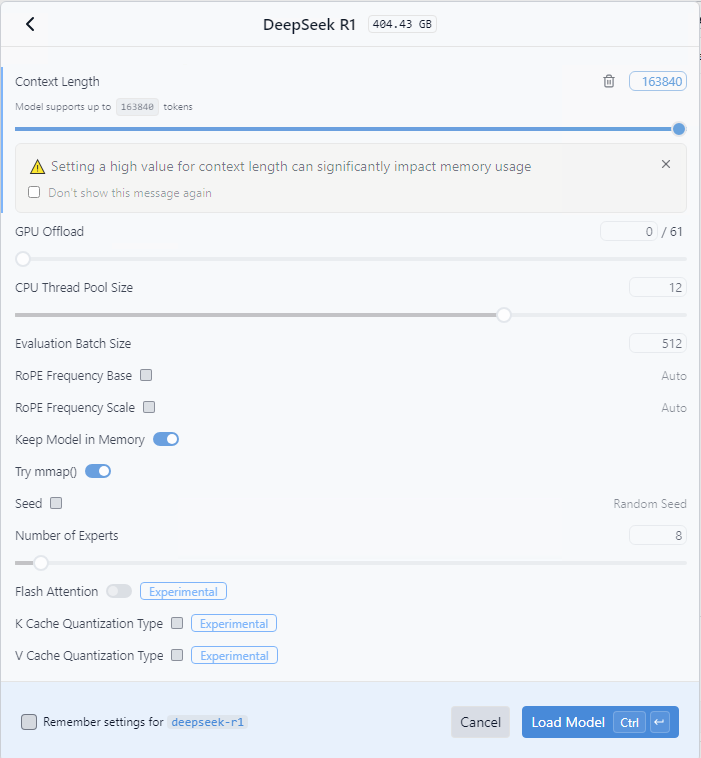

Откроется окно, в котором мы можем указать дополнительные параметры запуска модели (я выбрал размер контекста в 16384 токенов, по умолчанию – 4094, максимум – 163480)

Настройки запуска модели -

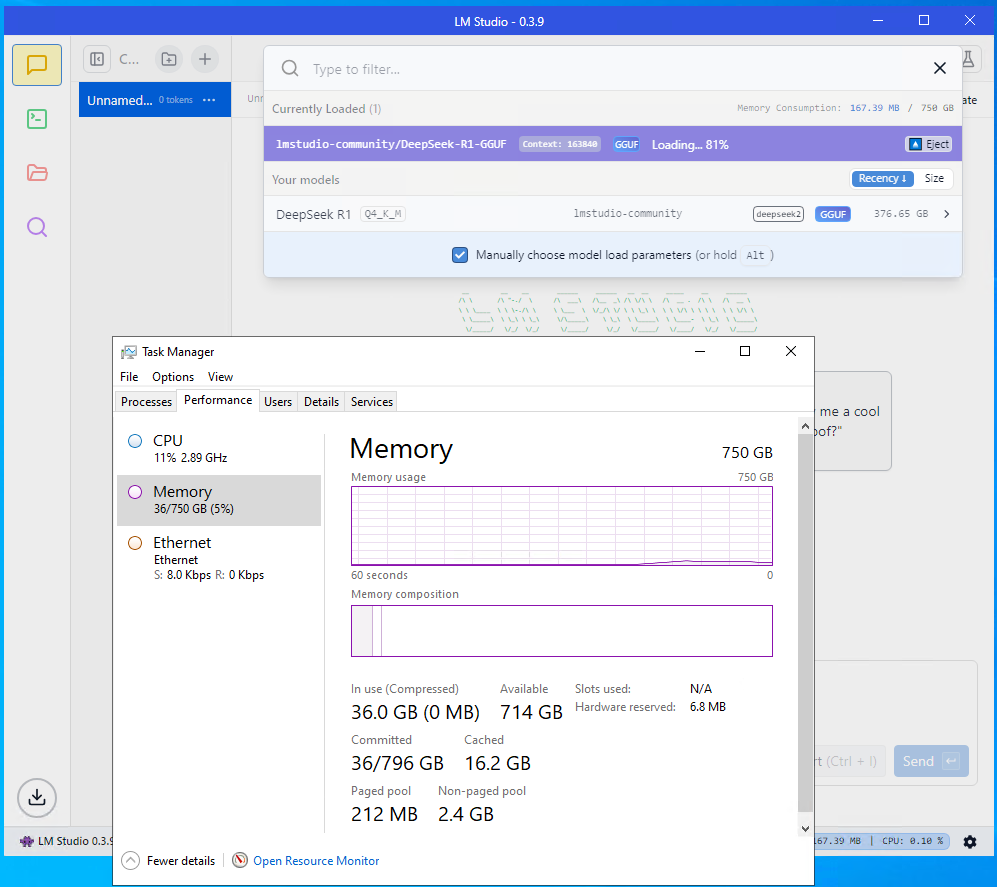

Жмем “Load Model” и ждем пока она загрузится в ОЗУ

Загрузка модели в ОЗУ -

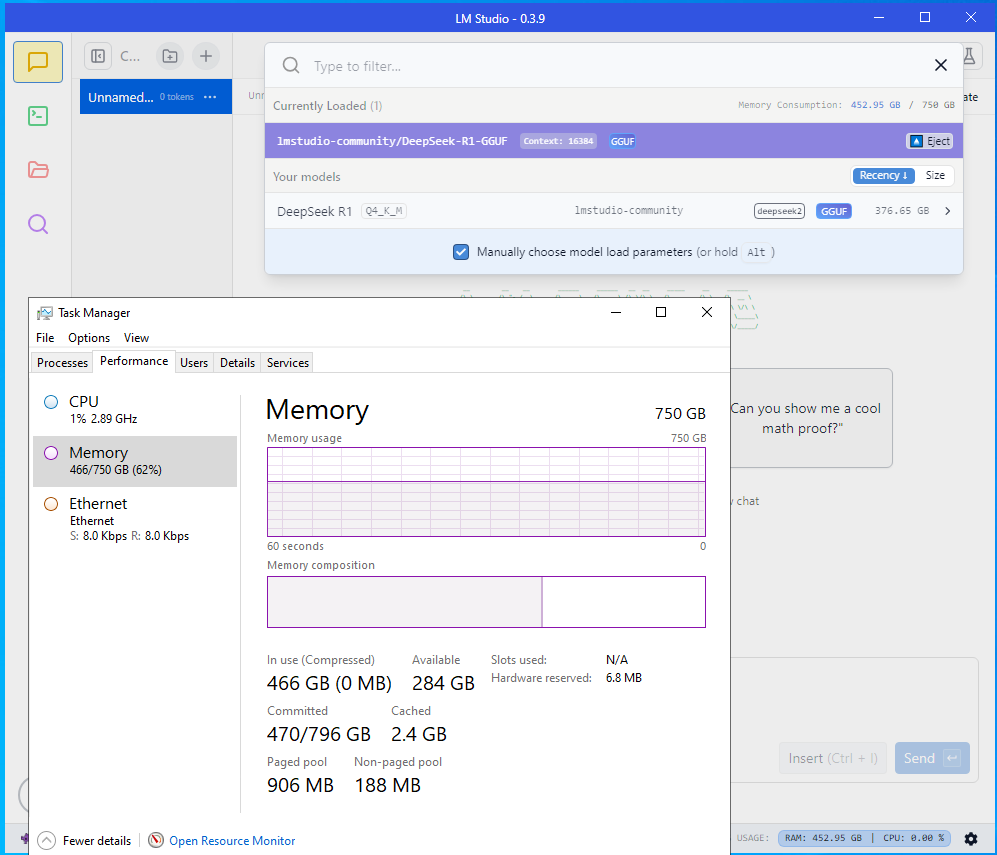

После загрузки модели вы увидите, что надпись “Loading… %” изменится на ” вап” и мы можем начать экспериментировать

Модель загружена в ОЗУ -

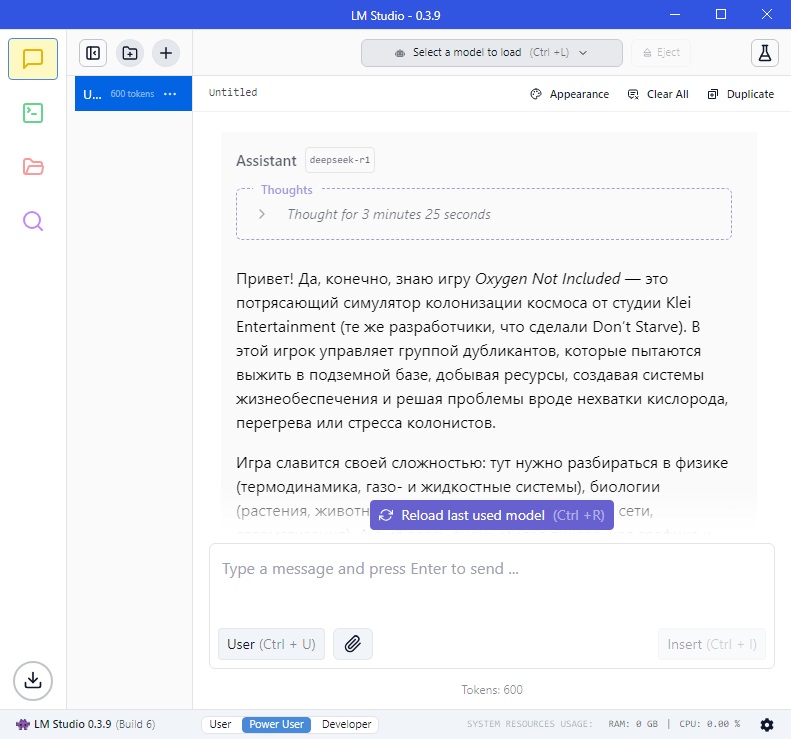

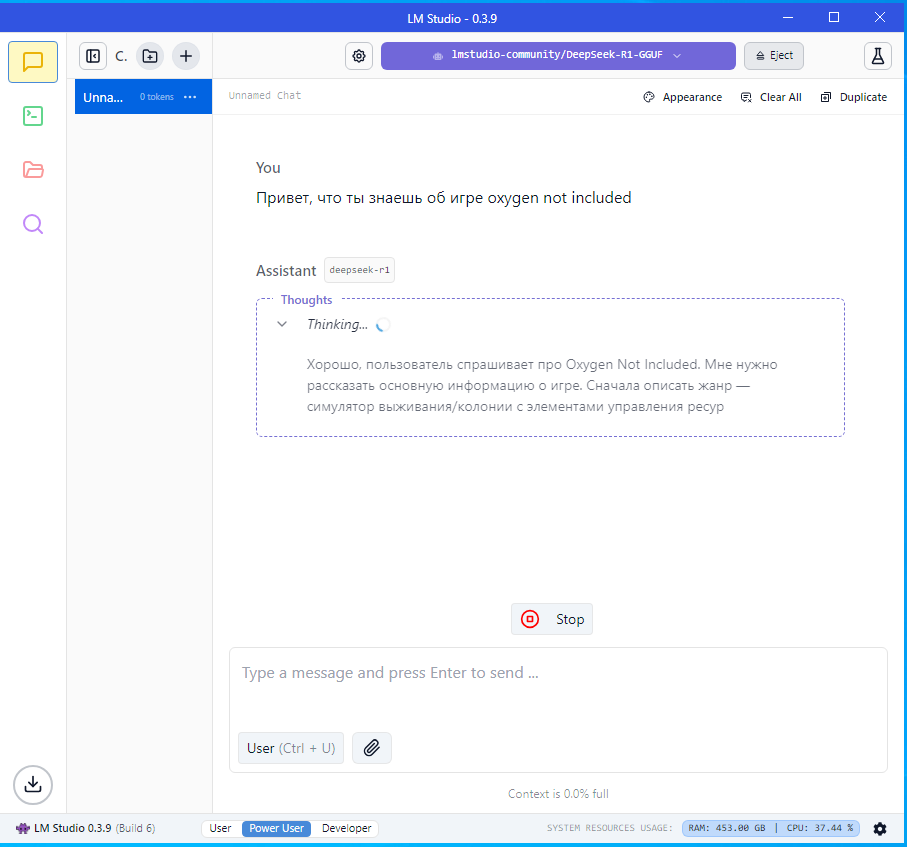

Все готово, можно использовать модель

Модель рассуждает на заданный вопрос -

Качество и скорость работы можно оценить на видео

Что нейросеть знает о Хабре

Ответ на вопрос «Привет что ты знаешь о Хабре?» кто не смог посмотреть видео под спойлером

Скрытый текст

Хабр (Habr) — это популярная онлайн-платформа, где пользователи делятся знаниями в областях IT, разработки программного обеспечения, технологий и науки. Сайт был основан в 2006 году Денисом Крючковым и изначально ориентировался на IT-специалистов, но со временем расширил тематику.

Основные разделы Хабра:

-

Публикации — статьи пользователей по разным темам: программирование, кибербезопасность, AI, блокчейн и др.

-

Хабрахабр (соцсеть) — профили пользователей, подписки, лента активности.

-

Компании — блоги компаний, вакансии, кейсы.

-

Q&A — вопросы и ответы по техническим темам.

Особенности:

-

Качество контента: Статьи часто глубокие и профессиональные.

-

Сообщество: Активные пользователи, включая экспертов из разных областей.

-

Комментарии: Обсуждения могут быть критичными, но полезными.

-

Карьера: Раздел с вакансиями для IT-специалистов.

Критика:

Иногда контент становится слишком поверхностным или рекламным. Также споры в комментариях бывают токсичными.

Хабр остается ключевым ресурсом для рунета в области технологий и IT.

Хабр (Habr) — это известная онлайн-платформа, основанная в 2006 году, которая объединяет IT-специалистов, разработчиков и tech-энтузиастов. Вот ключевые аспекты:

Основное о Хабре:

-

Контент:

-

Пользователи публикуют статьи на темы: программирование, кибербезопасность, AI/ML, блокчейн, стартапы.

-

Материалы варьируются от tutorials до аналитики и кейсов из реальных проектов.

-

-

Аудитория:

-

Целевая аудитория — разработчики, инженеры, менеджеры IT-проектов, ученые.

-

Активное комьюнити с высоким уровнем экспертизы.

-

-

Структура:

-

Хабры: Тематические разделы (например, «Python», «Big Data»).

-

Компании: Корпоративные блоги (Яндекс, Tinkoff и др.), вакансии.

-

Карьера: Раздел для поиска работы в IT.

-

-

Особенности:

-

Жёсткая модерация: статьи проходят проверку перед публикацией.

-

Комментарии часто содержат конструктивную критику или дополнения от профессионалов.

-

-

Проблемы:

-

Иногда контент становится излишне рекламным (продвижение сервисов/продуктов).

-

Споры в комментариях могут перерастать в холивары.

-

Популярные форматы:

-

Туториалы: Пошаговые руководства (например, «Как настроить Docker»).

-

Кейсы: Опыт внедрения технологий в компаниях.

-

Новости и аналитика: Обзоры трендов (Web3, Quantum computing).

Интересное:

-

Раньше Хабр был более нишевым, но сейчас охватывает широкий спектр тем — от low-level разработки до менеджмента.

Хабр остается главным источником экспертного контента на русском языке для IT-сферы. 🔍

Выводы

На сервере без GPU запустить конечно модель можно, но вот скорость работы оставляет желать лучшего. Скорое всего большие смысл имеет запустить дистиллированные модели и другие маленькие модели, но на GPU, даже на домашних карточках сейчас 8-12-16-24GB памяти.

Модель запускалась от нечего делать, в период простоя узла кластера. Какой-либо коммерческой цели использовать в таком варианте не было и не будет (проще купить подписку и пользоваться).

Как тестировать на производительность я не знаю, ну видно, что она еле шевелится. Если будут какие-то предложения пишите, попробуем попробовать.

ps было потрачено около 5 часов из них:

-

30 минут на настройку и установку;

-

где то два часа с кофе и скачивание модели (три раза был обрыв скачки)

-

2.5 часа на написание статьи, снятие скриншотов, заливки видео…

Автор: mukca