Tencent только что выпустила новую open‑source модель под названием Hunyuan‑A13B‑Instruct. Весы модели открыты (насчёт кода — пока неясно), и она может работать локально (если у вас есть GPU уровня NVIDIA DGX B200). Если вам интересно, как она себя показывает, и вы хотите попробовать её в деле — ниже инструкции, как можно её быстро развернуть на арендованной видеокарте за несколько минут.

📎Перевод, оригинальная новость здесь.

Что такое Hunyuan‑A13B?

Hunyuan‑A13B‑Instruct это модель с архитектурой MoE (Mixture‑of‑Experts) с суммарно 80 миллиардами параметров, из которых при инференсе активны лишь 13 миллиардов. Это позволяет значительно снизить вычислительные затраты по сравнению с классическими (плотными) LLM.

Mixture‑of‑Experts (MoE) — это архитектура, в которой при обработке каждого входа активируется лишь подмножество «экспертных» подсетей.

Это уменьшает нагрузку на вычислительные ресурсы, одновременно увеличивая масштаб модели. Специальный gating-механизм выбирает нужных «экспертов» динамически, в зависимости от входных данных.

Вот некоторые ключевые особенности:

-

Поддержка контекста до 256 тыс. токенов «из коробки».

-

Режимы быстрого и медленного мышления.

-

Grouped Query Attention (GQA) для более эффективного инференса.

-

Тонкая настройка под агентные задачи, с результатами бенчмарков на BFCL‑v3 и τ‑Bench.

-

Поддержка квантования, включая GPTQ.

Модель выглядит как серьёзный кандидат для локальных экспериментов — особенно в задачах с длинным контекстом и интеллектуальными агентами.

Шаг 1: Запуск инстанса на RunPod

Самый простой способ попробовать модель в деле — использовать RunPod (по этой реферальной можно получить между 5$ и 500$ в кредитах).

Для этого нам понадобится:

-

Сетевой раздел объёмом 300 ГБ

-

GPU B200 (менее мощные, скорее всего, не подойдут — требуется около 150 ГБ VRAM)

-

Образ с поддержкой PyTorch

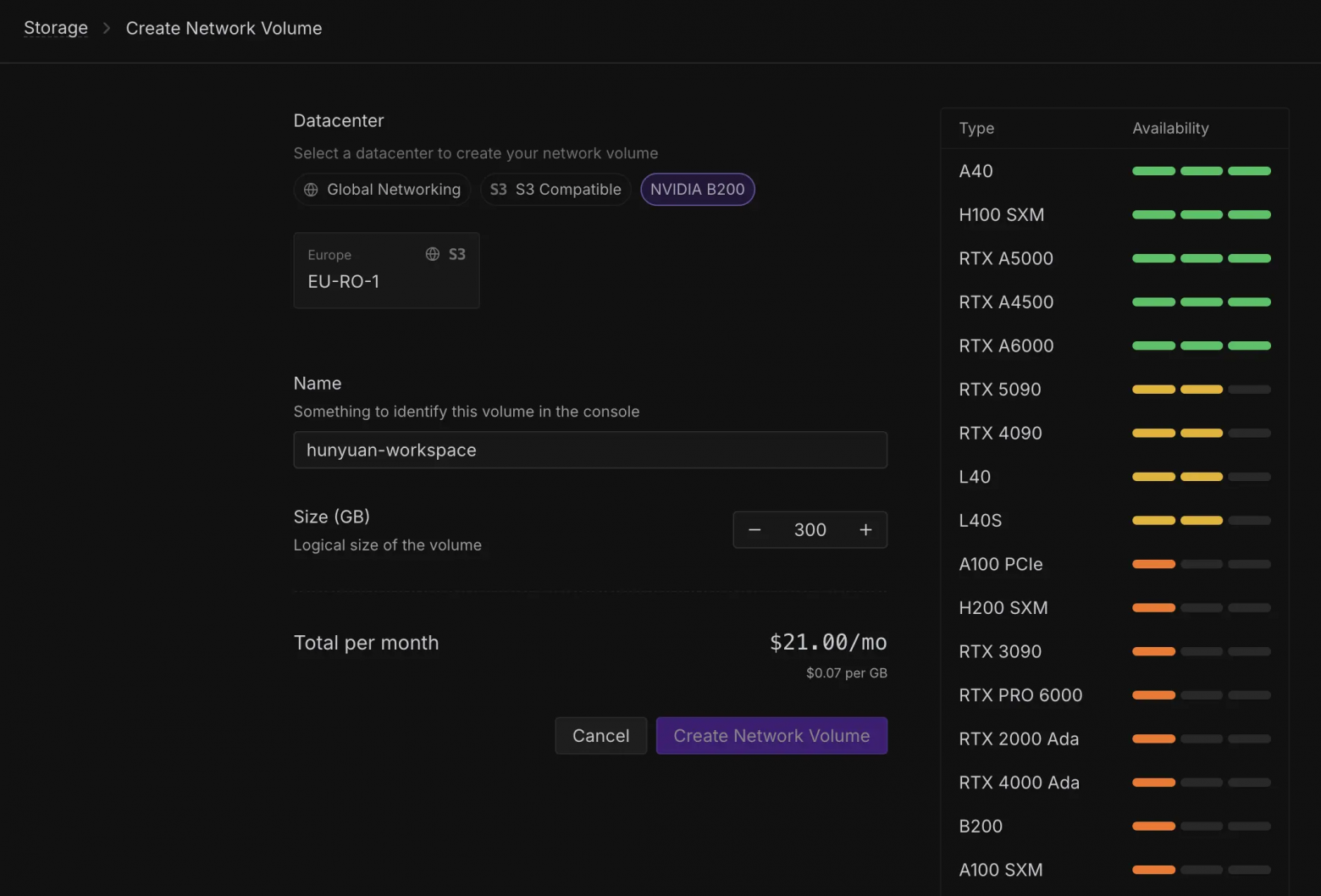

Создание сетевого раздела:

-

Регион: выберите тот, где доступен B200 (на момент написания —

EU-RO-1) -

Размер: 300 ГБ

-

Стоимость: примерно $21/мес (оплата идёт даже при простое)

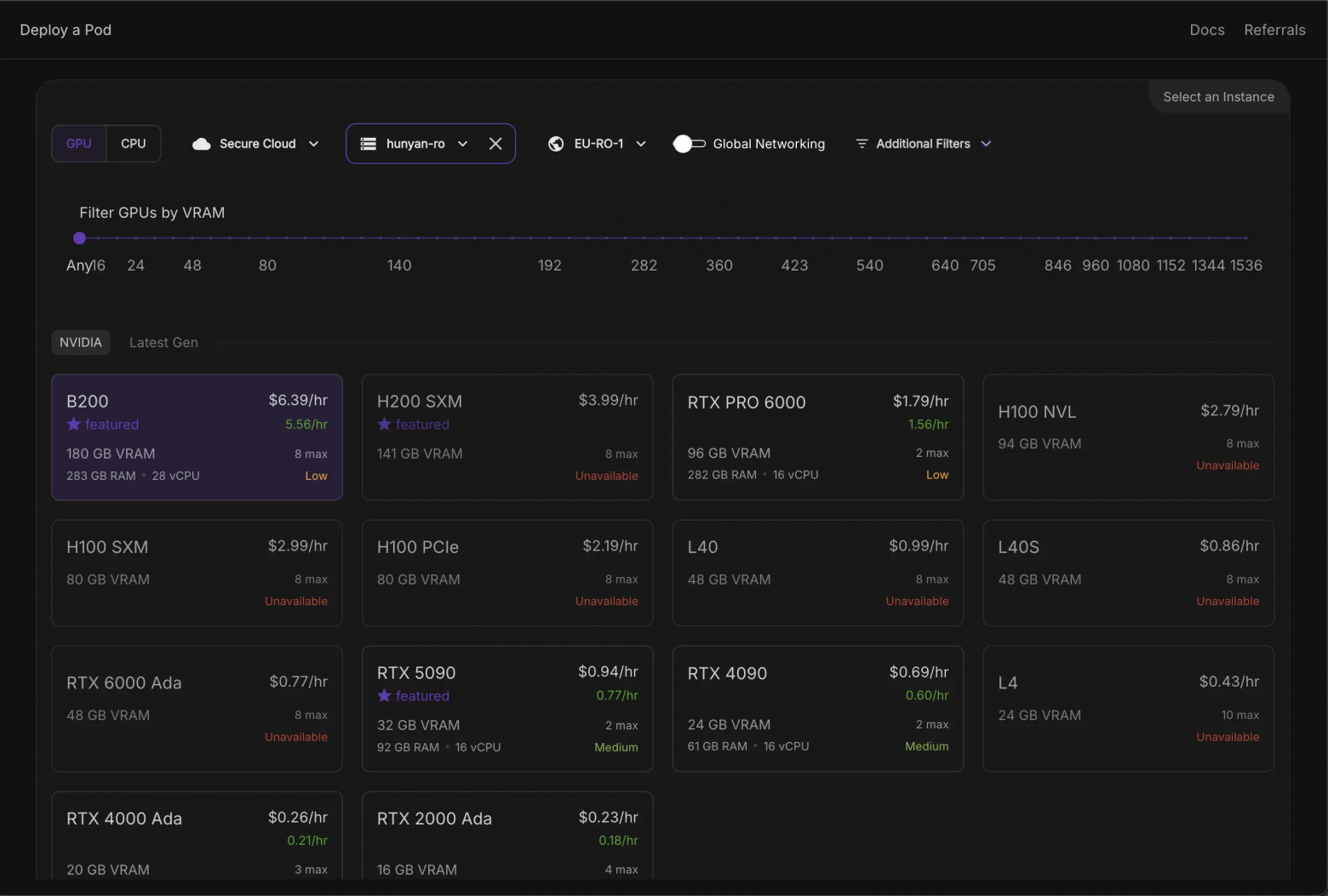

Создание пода

-

Тип GPU: B200

-

Образ:

runpod/pytorch:2.8.0-py3.11-cuda12.8.1-cudnn-devel-ubuntu22.04

⚠️ Более ранние версии могут не работать -

Количество GPU: 1

-

Включаем: SSH и Jupyter

-

Подключаем: сетевой раздел (тот, что создали ранее)

Шаг 2: Установка зависимостей

Открываем терминал и вводим:

%pip install transformers tiktoken accelerate gptqmodel optimum

Шаг 3: Загружаем модель

Чтобы загрузки не шли в корневую директорию, укажем путь к кэшу на сетевом разделе:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

import os

import re

os.environ['HF_HOME'] = '/workspace/hf-cache' #

model_path = 'tencent/Hunyuan-A13B-Instruct'

tokenizer = AutoTokenizer.from_pretrained(model_path, local_files_only=False, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(model_path, cache_dir='/workspace/hf-cache/', local_files_only=False, device_map="auto", torch_dtype=torch.bfloat16, trust_remote_code=True)

messages = [

{

"role": "user",

"content": "What does the frog say?"

},

]

tokenized_chat = tokenizer.apply_chat_template(messages, tokenize=True, return_tensors="pt",

enable_thinking=True # Toggle thinking mode (default: True)

)

outputs = model.generate(tokenized_chat.to(model.device), max_new_tokens=5000)

output_text = tokenizer.decode(outputs[0])

print(output_text)Заметки:

-

При первом запуске скачается около 150 ГБ весов модели

-

Во время инференса используется примерно 153 ГБ видеопамяти (VRAM)

-

Загрузка модели в видеопамять может занять несколько минут

-

Если загрузка GPU (не только VRAM) увеличивается — значит, модель действительно работает

-

Если просто хотим попробовать на CPU, можно указать

device_map="cpu"

В этом случае стоит убедиться, что у нас есть около 200 ГБ оперативной памяти и достаточно мощный процессор.

Стоимость

-

B200-под — 6,39 $/час

-

Сетевой раздел — 21 $/месяц, даже когда мы его не используем

-

Совет: выключаем под, когда не работаем с моделью 😉

Заметки по инструментам

-

Поддержки llama.cpp пока нет — PR #14425 ещё в процессе

-

В Python с

transformersиbfloat16всё работает без проблем

Бенчмарки

Официальные результаты размещены на Hugging Face и посчитаны бэкендом TRT-LLM (больше – лучше):

|

Model |

Hunyuan-Large |

Qwen2.5-72B |

Qwen3-A22B |

Hunyuan-A13B |

|---|---|---|---|---|

|

MMLU |

88.40 |

86.10 |

87.81 |

88.17 |

|

MMLU-Pro |

60.20 |

58.10 |

68.18 |

67.23 |

|

MMLU-Redux |

87.47 |

83.90 |

87.40 |

87.67 |

|

BBH |

86.30 |

85.80 |

88.87 |

87.56 |

|

SuperGPQA |

38.90 |

36.20 |

44.06 |

41.32 |

|

EvalPlus |

75.69 |

65.93 |

77.60 |

78.64 |

|

MultiPL-E |

59.13 |

60.50 |

65.94 |

69.33 |

|

MBPP |

72.60 |

76.00 |

81.40 |

83.86 |

|

CRUX-I |

57.00 |

57.63 |

– |

70.13 |

|

CRUX-O |

60.63 |

66.20 |

79.00 |

77.00 |

|

MATH |

69.80 |

62.12 |

71.84 |

72.35 |

|

CMATH |

91.30 |

84.80 |

– |

91.17 |

|

GSM8k |

92.80 |

91.50 |

94.39 |

91.83 |

|

GPQA |

25.18 |

45.90 |

47.47 |

49.12 |

Hunyuan-A13B-Instruct демонстрирует впечатляюще конкурентоспособные результаты на различных бенчмарках — особенно в областях математики, естественных наук, агентных задач и других.

Мы сравнили её с рядом мощных моделей — результаты представлены ниже.

— Tencent

|

Topic |

Bench |

OpenAI-o1-1217 |

DeepSeek R1 |

Qwen3-A22B |

Hunyuan-A13B-Instruct |

|---|---|---|---|---|---|

|

Mathematics |

AIME 2024 |

74.3 |

79.8 |

85.7 |

87.3 |

|

Science |

GPQA-Diamond |

78 |

71.5 |

71.1 |

71.2 |

|

Coding |

Livecodebench |

63.9 |

65.9 |

70.7 |

63.9 |

|

Reasoning |

BBH |

80.4 |

83.7 |

88.9 |

89.1 |

|

InstructionFollowing |

IF-Eval |

91.8 |

88.3 |

83.4 |

84.7 |

|

TextCreation |

LengthCtrl |

60.1 |

55.9 |

53.3 |

55.4 |

|

NLU |

ComplexNLU |

64.7 |

64.5 |

59.8 |

61.2 |

|

Agent |

BDCL v3 |

67.8 |

56.9 |

70.8 |

78.3 |

Заключение

Это одна из самых любопытных открытых MoE‑моделей на сегодняшний день. Она поддерживает длинный контекст, реализована с рядом продуманных архитектурных решений и достаточно проста в запуске.

Если хотите попробовать её самостоятельно, приведённая выше инструкция поможет быстро начать работу.

Автор: GiantLynx