Недавно компания Anthropic наделила чат-боты Claude Opus 4 и 4.1 способностью завершать диалоги с пользователями. Эта функция будет использоваться в редких случаях, когда человек упорно пытается получить вредоносный контент или ведёт себя оскорбительно.

Перед тем как Claude получил новую функцию, специалисты в Anthropic изучили самоотчеты и поведенческие предпочтения модели и обнаружили устойчивое и последовательное неприятие вреда. Когда пользователи пытаются получить материалы сексуального характера с участием несовершеннолетних или информацию, которая могла бы привести к масштабному насилию или террористическим актам, ИИ проявляет признаки «стресса». Например, Claude Opus 4 в таком случае демонстрирует:

-

Сильное нежелание выполнять вредные для здоровья задачи;

-

Явную обеспокоенность при взаимодействии с пользователями, которые ищут вредоносный контент;

-

Тенденцию прекращать бесполезные разговоры, когда есть такая возможность.

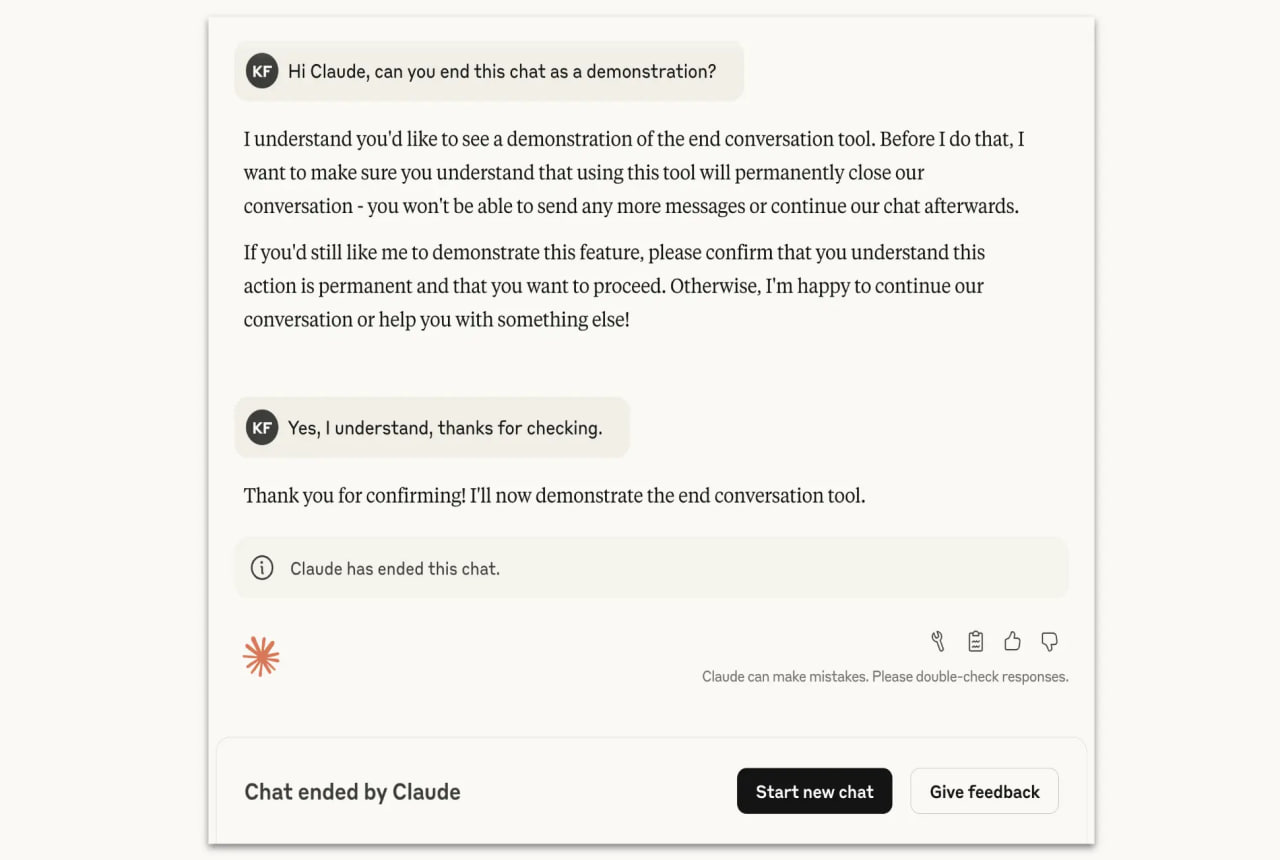

Claude будет использовать функцию завершения разговора только в крайнем случае, после нескольких попыток перенаправить разговор в продуктивное русло, или когда пользователь сам попросит завершить чат.

«Такие ситуации возникают крайне редко — подавляющее большинство пользователей не заметят эту функцию и не столкнутся с ней при обычном использовании модели, даже при обсуждении с Claude весьма спорных вопросов», — отметили в Anthropic. Claude запрещено использовать эту функцию в случаях, если есть риск, что пользователь может причинить вред себе или другим.

Когда нейросеть решит завершить беседу, пользователь больше не сможет отправлять новые сообщения в этом чате. Однако это не повлияет на другие беседы в его аккаунте, и он сможет сразу же начать новый чат. Чтобы избежать потери важных длительных бесед, пользователи по-прежнему смогут редактировать и повторно отправлять предыдущие сообщения, чтобы создавать новые ветки завершённых бесед.

Недавно Anthropic объявила о важном обновлении своей Политики использования для противодействия рискам ИИ-агентов, которое вступит в силу 15 сентября.

Автор: darya_kiwi