В Nature опубликована работа, которая уже наделала шума в научном сообществе. Китайская команда представила DeepSeek-R1, первую масштабную языковую модель, которая научилась рассуждать без примеров от человека.

До сих пор обучение reasoning-моделей требовало дорогостоящих наборов данных. Для каждой задачи исследователи вручную составляли цепочки мыслей (поэтапные объяснения решений). Это давало ИИ пример рассуждения, но лишало его шанса выработать собственную стратегию. DeepSeek-R1 разорвала этот шаблон.

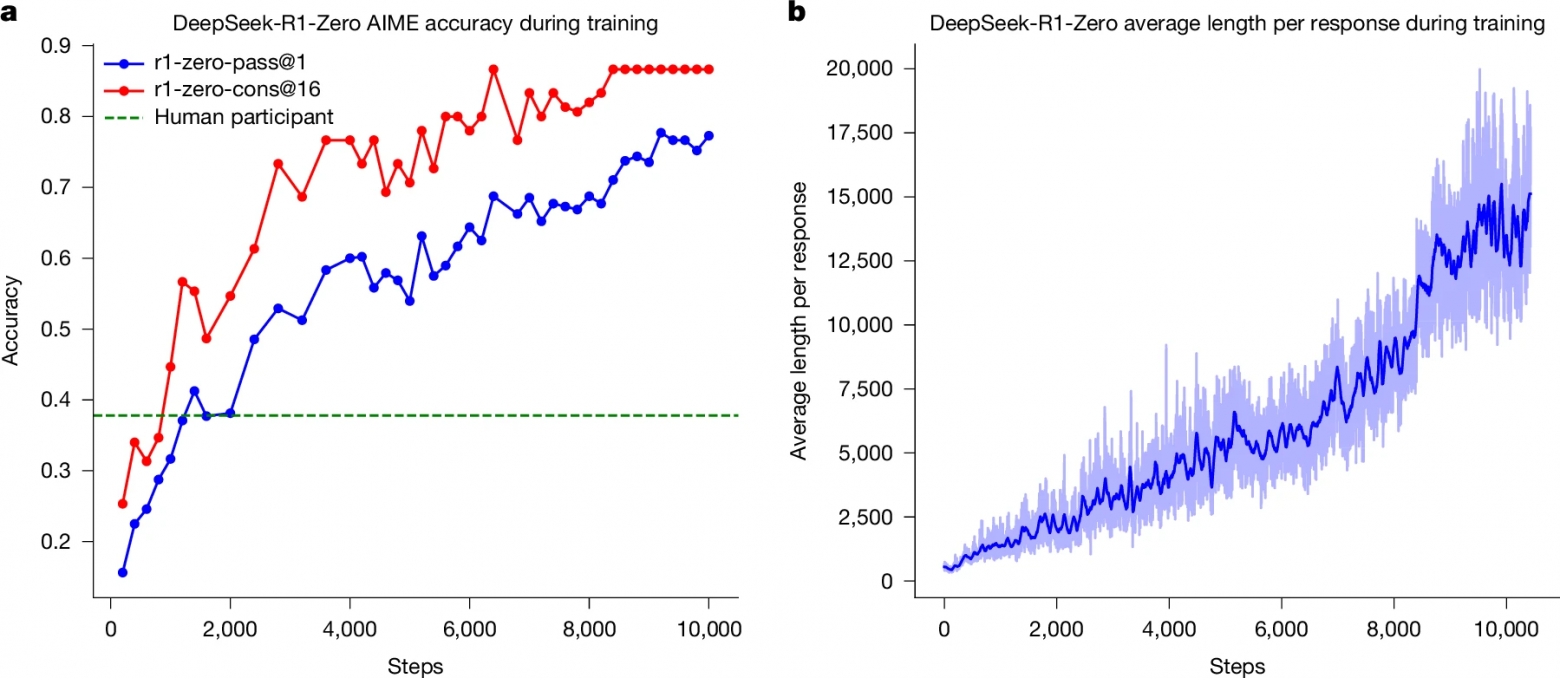

Модель обучали по принципу «правильно/неправильно», выдавая награду только за конечный ответ. А вот как именно к нему прийти — ИИ выяснял сам. Ключевой технологией стал алгоритм Group Relative Policy Optimization (GRPO). Он дал возможность системе проверять промежуточные шаги, критиковать себя, менять методику, если результат не сходился.

Результаты оказались революционными. В математическом бенчмарке AIME точность поднялась с 15% до 78%, а при включении механизма самопроверки — до 87%, что выше среднего уровня реальных участников олимпиад. В задачах по программированию и STEM-дисциплинам модель обошла все системы своего масштаба и приблизилась к куда более крупным конкурентам.

Более того, исследователи показали, что даже облегчённые версии DeepSeek-R1 сохраняют большую часть новых навыков. То есть разумность такого типа можно упаковать в компактные модели, пригодные для практического применения.

Конечно, пока не всё идеально: стиль ответов страдает, встречаются смешения языков, а в гуманитарных темах модель работает слабее. В перспективе подобные системы смогут самостоятельно открывать закономерности в науке, проектировать инженерные решения и помогать образованию.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: cognitronn