MIT представил исследование, которое может изменить наше понимание того, как обучаются большие языковые модели. Учёные доказали, что если правильно подать материал, то LLM способны к логическим рассуждениям, а не только к генерации текста по шаблону.

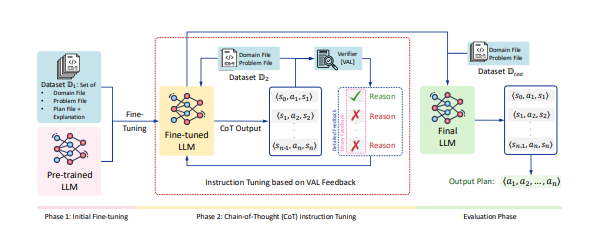

Для этого они предложили новый метод обучения — PDDL-INSTRUCT. Его суть в том, что модель больше не угадывает правильный ответ, а учится пошагово решать задачи с внешней проверкой.

Как это работает:

1) Сначала модели показывают правильные и неправильные планы действий с пояснениями.

2) Затем она сама строит рассуждения шаг за шагом.

3) Полученные рассуждения проверяет внешний инструмент (VAL), который указывает, где ошибка и почему. Таким образом, модель получает чёткую обратную связь, а не формальное «правильно/неправильно».

Результаты впечатляют. У Llama-3-8B точность выполнения задач планирования выросла с 28% до 94%. Такой скачок объясняется именно качеством обратной связи: модель не просто копирует паттерны, а учится логике, фактически осваивая роль символического планировщика.

Важно, что LLM в этой схеме не заменяет классические системы, а работает в тандеме с ними — сохраняя внешнюю проверку и при этом перенимая навыки пошагового мышления.

Главная интрига: если метод масштабировать, то можно раскрыть скрытые способности моделей в самых разных областях — от сложной математики и программирования до планирования процессов в бизнесе. Получается, что многие ограничения LLM связаны не с их природой, а с тем, как их обучают.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: cognitronn