Всем привет, с вами команда MERA! Этот год стал для нас по-настоящему прорывным. Мы запустили MERA Industrial, MERA Code и SWE-MERA, заложив основу для системной оценки моделей в разных областях. Но главное событие впереди. MERA — это не просто имя или бренд. Это аббревиатура от Multimodal Evaluation for Russian-language Architectures (Мультимодальная оцЕнка Русскоязычных Архитектур). Ещё в 2023 году мы поставили перед собой амбициозную цель: создать эталон для оценки мультимодальных моделей на русском языке. Сегодня мы с гордостью объявляем о достижении этой цели: встречайте MERA Multi — первый полноценный релиз мультимодального бенчмарка для русскоязычных моделей. Теперь пришло время по-настоящему измерять и сравнивать мультимодальные способности современных русскоязычных ИИ.

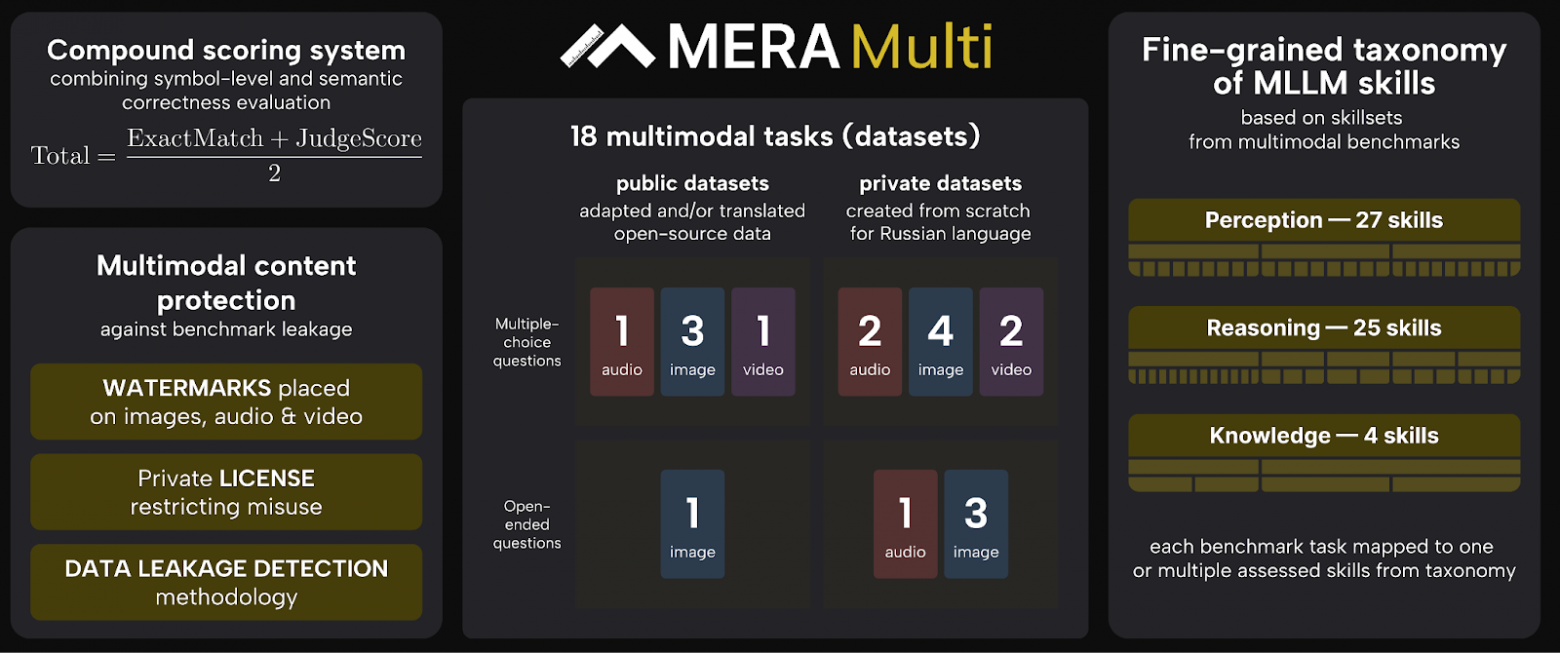

Что внутри бенчмарка?

-

Таксономия мультимодальных навыков.

-

Обновленная универсальная система промптов.

-

18 новых задач в инструктивном формате, в том числе 3 для видео и 4 аудио набора; публичные и приватные датасеты, созданные с нуля для русского языка.

-

Открытая платформа со сквозной системой подсчёта баллов, рейтингом и открытым международным фреймворком для тестирования.

-

И, конечно, анализ и результаты, охватывающие как открытые общие модели, так и проприетарные.

Быстрые ссылки релиза MERA Multi:

Что такое MERA Multi?

MERA — это независимый бенчмарк для оценки LLM на русском языке. Он проверяет не только знания о мире и способность рассуждать в текстовой форме, но и умение работать с кодом (MERA Code), или отраслевыми знаниями (Mera Industrial). С релизом MERA Multi мы расширяем рамки: теперь модели оцениваются по задачам на понимание изображений, аудио и видео.

Это первый открытый мультимодальный бенчмарк на русском языке, созданный экспертами с учётом культурной и языковой специфики РФ.

В MERA Multi представлено 18 новых задач, разработанных по методологии основного бенчмарка. Они проверяют способности моделей в трёх ключевых направлениях:

-

Визуальное восприятие. Проверяем, насколько ИИ понимает визуальный контекст: распознаёт объекты, интерпретирует сцены и соотносит их с текстом. Это критично для задач генерации, поиска и систем безопасности.

-

Аудиопонимание. Оцениваем, как модель воспринимает речь, интонации, команды и звуки на русском языке — фундамент для голосовых помощников и приложений, работающих в шумной среде.

-

Анализ видео. Проверяем, умеет ли ИИ понимать динамику, действия и причинно-следственные связи во временном контексте — основу для сложных ассистентов, агентных систем и мультимодального поиска.

Каждая задача представлена в формате свободных ответов или выбора варианта, что позволяет объективно измерять разные аспекты мультимодальных способностей.

Мы также разработали таксономию навыков MERA Multi — системное описание умений, необходимых для решения задач. Это помогает видеть, какие компетенции покрываются моделями сегодня, и какие направления ещё требуют новых тестов.

Для защиты контента реализована и предложена система лицензирования и водяных знаков, а замеры моделей проводятся на основе LM-Evaluation-Harness с фиксированной универсальной системой промптов и фиксированными параметрами для прозрачных и воспроизводимых результатов. На сайте MERA доступна таблица лидеров, где можно сравнить качество решений как по отдельным модальностям, так и по итоговому мультимодальному результату.

Проект поддерживают Альянс ИИ, ведущие индустриальные компании и академические партнёры, занимающиеся исследованием языковых и мультимодальных моделей.

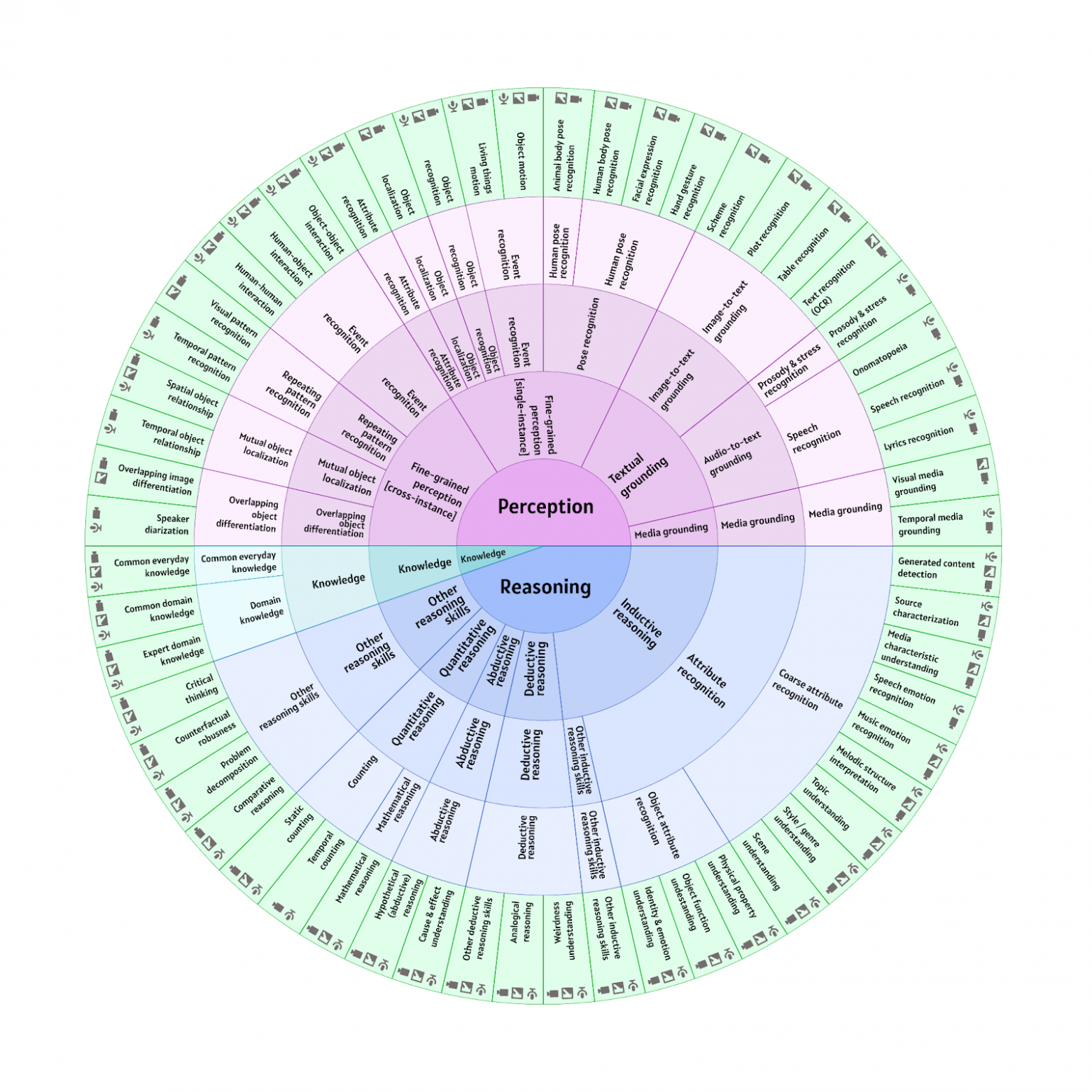

Таксономия навыков

Таксономия навыков MERA Multi — это системный подход к оценке способностей мультимодальных моделей (MLLM), необходимых для работы с контентом разных типов: текстом, изображениями, аудио и видео. Главная идея проста: любую задачу можно разложить на ограниченный набор ключевых навыков, а значит — сделать оценку моделей понятной, управляемой и воспроизводимой.

В основе подхода лежит представление языковой модели как системы из трёх компонентов:

-

входные данные;

-

внутреннее состояние;

-

выход.

Отсюда выделяются три фундаментальные группы навыков:

-

Perception (восприятие) отвечает за понимание входных данных;

-

Reasoning (логическое мышление) отвечает за рассуждение и обработку информации;

-

Knowledge (знания) отвечает за внутренние представления и контекст модели.

Эти группы формируют фундамент всей таксономии, а остальные навыки надстраиваются над ними, формируя иерархию, в которой каждый уровень уточняет и конкретизирует предыдущий. Похожие принципы уже применялись в MERA Code, где присутствует дополнительный базовый блок Generation (генерация). В перспективе все тесты экосистемы MERA будут использовать единую систему навыков, обеспечивая согласованную и прозрачную оценку моделей во всех доменах.

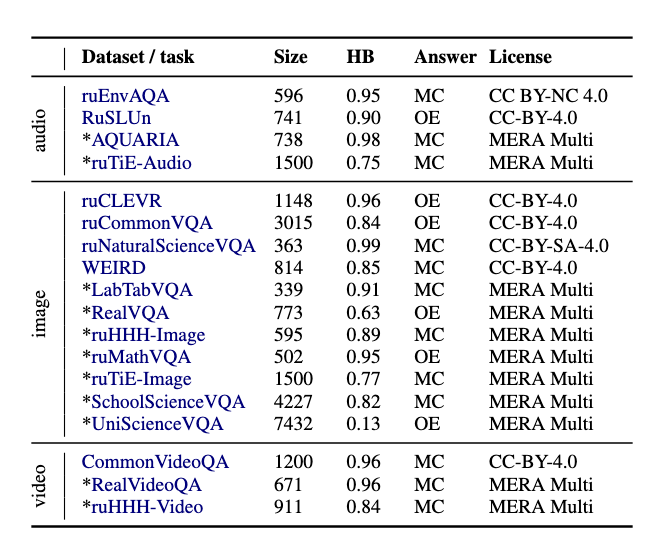

Какие задания входят в бенчмарк?

Разработка мультимодальных LLM для русского языка только набирает обороты, и до сих пор сообществу не хватало прозрачного способа понять, насколько хорошо эти модели действительно умеют видеть, слышать и понимать. Команда MERA закрывает этот пробел, представляя MERA Multi и совершенно новые наборы тестов для оценки русскоязычных мультимодальных моделей.

MERA Multi охватывает четыре модальности: текст (базовая модальность); изображения — 11 датасетов; аудио — 4 теста; видео — 3 теста.

Форматы заданий — либо с множественным выбором (multiple-choice), либо открытые вопросы с коротким ответом (число, слово или словосочетание).

Чтобы соблюсти баланс между воспроизводимостью и новизной, в бенчмарк интегрированы как публичные наборы данных (7 задач), отобранные из открытых источников, так и приватные тесты (11 задач), собранные с нуля специально для этого исследования. Контент для приватных заданий уникален: он собран из личных изображений, видео и аудио, либо полностью созда с нуля. Такие данные помогают избежать утечек и пересечений с обучающими выборками моделей, а заодно отражают российский культурный контекст и покрывают слабоизученные типы навыков.

Задачи в MERA Multi — от простых на восприятие до сложных reasoning-тестов и заданий на специализированные знания. Каждый тест снабжён тегами навыков из таксономии MERA, чтобы точно понимать, какие когнитивные способности проверяются у модели. Каталог задач доступен на сайте.

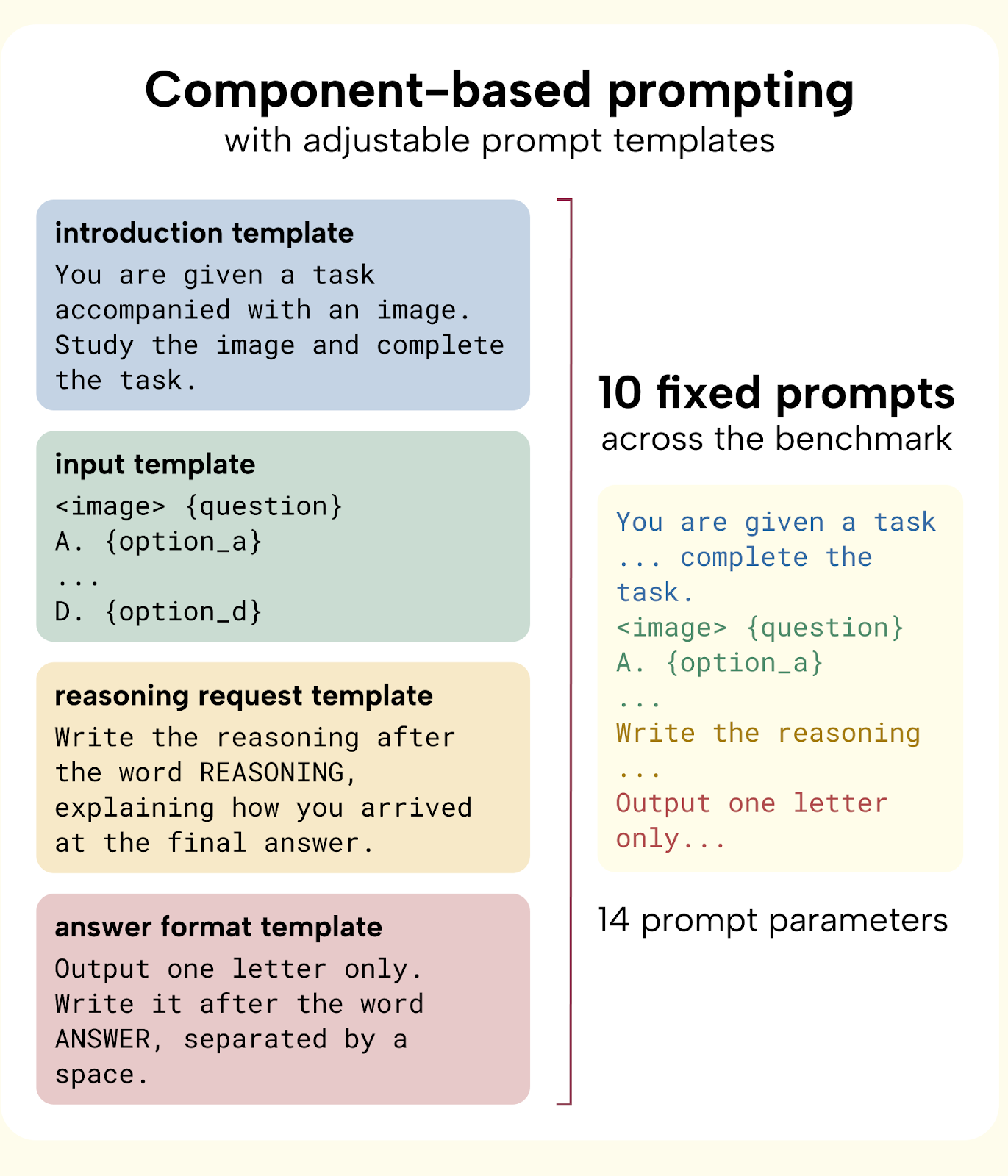

Как устроены инструкции для задач?

В рамках методологии MERA Multi мы отказались от бесконечных вариаций текстов заданий и ввели единые, фиксированные универсальные промпты для всех моделей и датасетов. Это важно, потому что даже незначительные отличия — вроде обращения «ты» или «вы», или явного указания формата ответа — могут менять результаты тестов. А значит, без стандартизации сравнение моделей теряет смысл.

-

Промпты зафиксированы: для каждой задачи используется одинаковый набор инструкций.

-

На каждую задачу 10 промптов, покрывающих разные форматы подачи.

-

Промпты в MERA адаптированы под разные типы моделей, в том числе reasoning-модели. Часть промптов жёстко фиксирует формат вывода, обеспечивая сопоставимость, а другая часть оставляет пространство для рассуждений и развёрнутых ответов.

-

Всего мы поддерживаем 14 параметров вариаций промптов, которые регулируют:

-

обращение (на «ты» или «вы»);

-

явность формата ответа;

-

степень формальности;

-

стиль инструкции и т. д.

-

! Вариации позволяют исследовать устойчивость модели к формулировкам, не ломая саму структуру задания, и устраняют подсуживание конкретной модели.

Зачем это нужно?

-

Унификация. Промпты стандартизированы для всех датасетов форматов: multiple-choice, short answer, numeric response.

-

Воспроизводимость. Результаты экспериментов воспроизводимы: промпт фиксирован, влияние формулировок — контролируемое.

-

Меньше хаоса в экспериментах. Вместо комбинаторного взрыва n_prompts × n_datasets получаем аккуратную систему, где n_prompts фиксированы и независимы от датасета.

-

Гибкость. Можно адаптировать параметры под новую задачу, не переписывая промпты с нуля. Следовательно, добавлять сеты в MERA Multi станет значительно проще.

Перед фиксацией промптов мы провели серию экспериментов: все 10 промптов на задачу проверили на статистическую значимость различий. Это гарантирует, что вариации действительно отражают устойчивость модели, а не случайные шумы формулировок.

Такой подход устраняет смещения в оценках:

-

усреднение по разным промптам минимизирует влияние формулировок;

-

единые правила исключают подстройку под конкретную архитектуру.

Лицензия и утечка данных

Для нашей команды бенчмарки — это не просто наборы тестов. Это инструмент, которому должно доверять сообщество, основа для объективных сравнений и точка роста для индустрии. Мы в MERA понимаем эту ответственность, она особенно важна, когда мы работаем с мультимодальными данными.

Создавая MERA Multi, мы сделали всё, чтобы тесты были юридически чистыми, защищёнными и корректно работающими, без риска утечек или переобучения на тестовых данных. Поэтому мы предлагаем три уровня защиты:

-

Лицензия. Публичные датасеты собраны из открытых источников, то есть все такого рода тесты сохраняют оригинальные лицензии (в основном CC-BY-4.0). Для приватных тестов действует специальная лицензия MERA, полностью запрещающая использование данных в обучении и коммерческих целях.

-

Водяные знаки. Все мультимодальные материалы, созданные специально для MERA Multi, помечены видимыми и невидимыми водяными знаками. Это исключает их случайное попадание в обучающие выборки и помогает краулерам распознавать такие данные как тестовые, а не обучающие. Мы проверили, что наличие водяных знаков не влияет существенно на качество ответов моделей (подробности — в нашей академической статье).

-

Инструменты против утечек. В нашем репозитории DataLeakage доступен фреймворк, который помогает проверить, не видел ли ваш ИИ эти данные раньше. Он позволяет обнаружить и измерить возможные случаи data contamination и утечек при оценке моделей.

Как устроен замер и какие результаты в таблицах лидеров?

Система оценки

Чтобы результаты тестирования были корректные и объективные, мы внедрили строгие стандарты проведения замеров.

-

Независимый набор универсальных промптов. Каждый вопрос в задаче сопровождается строго одним промптом из заранее подготовленного пула.

-

Единый формат вывода. Все модели получают одинаковые инструкции по структуре ответа, без импровизации.

-

Фиксированные условия генерации. Во время тестирования запрещено изменять промпты или few-shot-примеры.

-

Без кастомных системных промптов. Мы не допускаем использование собственных системных инструкций при запуске замеров. Исключение — встроенный системный промпт, который идёт «по умолчанию» в зарубежных моделях. Он остаётся неизменным, но не оптимизирован под русскоязычный MERA-бенчмарк.

-

Промпты в MERA адаптированы под разные типы моделей, часть промптов жёстко фиксирует формат вывода, обеспечивая сопоставимость, а другая часть оставляет пространство для рассуждений и развёрнутых ответов.

Как корректно сравнить жёсткоформализованный ответ со свободным рассуждением? Особенно когда мультимодальные модели иногда игнорируют инструкции. Для этого мы разработали отдельную модель-судью (Judge), которая работает вместе со стандартными метриками вроде Exact Match.

-

Exact Match проверяет точное совпадение с эталоном.

-

Наша модель-судья Judge анализирует смысловую точность и корректность вывода относительно референсного (золотого) ответа, даже если они не совпадают дословно.

Подробно про работу модели-судьи можно прочитать в нашей академической статье, там описана архитектура и методология его обучения. В итоге, для каждой задачи мы рассчитываем среднюю интегральную метрику, которая объединяет оценки модели-судьи и EM. Это позволяет точнее измерять реальные способности модели к пониманию и рассуждению, а не просто к шаблонному повторению.

Система оценки MERA построена на основе LM Evaluation Harness, международного фреймворка, который мы доработали под мультимодальные фичи. После тестирования участник получает ZIP-архив с результатами, загружает его на сайт, и система автоматически сравнивает ответы модели с «золотыми эталонами».

Обработка занимает до 20 минут для отдельных рейтингов, и около часа для мульти. Только после этого результаты появляются в личном кабинете. При желании их можно отправить в публичную таблицу лидеров.

Таблицы лидеров

Для мультимодальной версии MERA мы ввели четыре независимых таблицы лидеров:

1. Изображения: модели, которые измеряли на задачах с изображениями.

2. Аудио: модели с поддержкой звука.

3. Видео: модели, обрабатывающие на входе видео (без звука).

4. Мульти: сводная таблица по всем задачам (в том числе для моделей, которые принимают на вход две и более модальностей).

Пользователь сам выбирает, в какую таблицу отправить модель. При этом разрешены неполные представления, чтобы оценка оставалась справедливой и прозрачной.

Мы ввели три ключевые метрики, отражающие качество модели:

-

Качество по решённым задачам (Attempted Score): оценка по решённым задачам: простое среднее метрик на всех измеренных задачах.

-

Охват (Coverage): доля обработанных заданий в рамках выбранной таблицы лидеров.

-

Общий балл (Total Score), который формирует рейтинг. Рассчитывается как Total Score = Attempted Score × Coverage.

Такой механизм уже сегодня позволяет собирать мультимодальный рейтинг моделей с учётом разных типов задач. А в будущем — бесшовно расширять бенчмарк, добавляя новые и более сложные сценарии, без потери совместимости с текущими результатами.

Результаты

Наша команда протестировала через бенчмарк как открытые MLLM, так и закрытые решения, например от OpenAI. Картина получилась любопытная.

Во-первых, модальности развиваются неравномерно. Результаты показывают серьёзный дисбаланс: модели для работы с изображениями демонстрируют уже некоторую зрелость (баллы >0,39), тогда как моделей для аудио и видео значительно меньше.

Во-вторых, текущая агрегированная метрика остаётся стабильной, даже если не хватает данных по каким-то заданиям (например, при незавершённом наборе всех тестов таблицы лидеров) и при работе с разными типами данных (текстом, аудио, видео).

И ещё один показательный вывод: метрика нашей модели-судьи стабильно выше EM для всех моделей. Это частая ситуация: модель, по сути, права, но проигнорировала требование отвечать в определённом формате. А в тех редких случаях, когда оценки практически идентичны, модель чётко следовала инструкциям. Этот разрыв демонстрирует необходимость дополнять EM оценкой модели-судьи, и что текущие модели MLLM ещё плохо следуют инструкциям.

Смотрите результаты в официальной таблице лидеров MERA Multi.

В заключение

MERA Multi — это попытка закрыть важный пробел в тестировании мультимодальных LLM: насколько модели полезны в реальной, локализованной разработке. Надеемся, бенчмарк будет полезным инструментом для исследователей, инженеров и всех, кто работает с ИИ в коде. Мы ожидаем, что с появлением стандартизированного теста экосистема MLLM в России получит дополнительный импульс к развитию: появятся новые архитектуры, улучшенные модели и более честные сравнения.

Мы планируем расширять набор задач и прикладных сценариев, а также работать над омнимодальными тестами. Если вам интересно протестировать свои модели или просто разобраться в метриках — добро пожаловать в репозиторий. Присоединяйтесь, предлагайте свои задачи и помогайте развивать бенчмарк, мы открыты к сотрудничеству. 🚀

Проект поддерживается Альянсом в сфере Искусственного Интеллекта, собраны ведущие индустриальные игроки и академические партнёры, которые занимаются исследованием языковых моделей.

Автор: alenusch