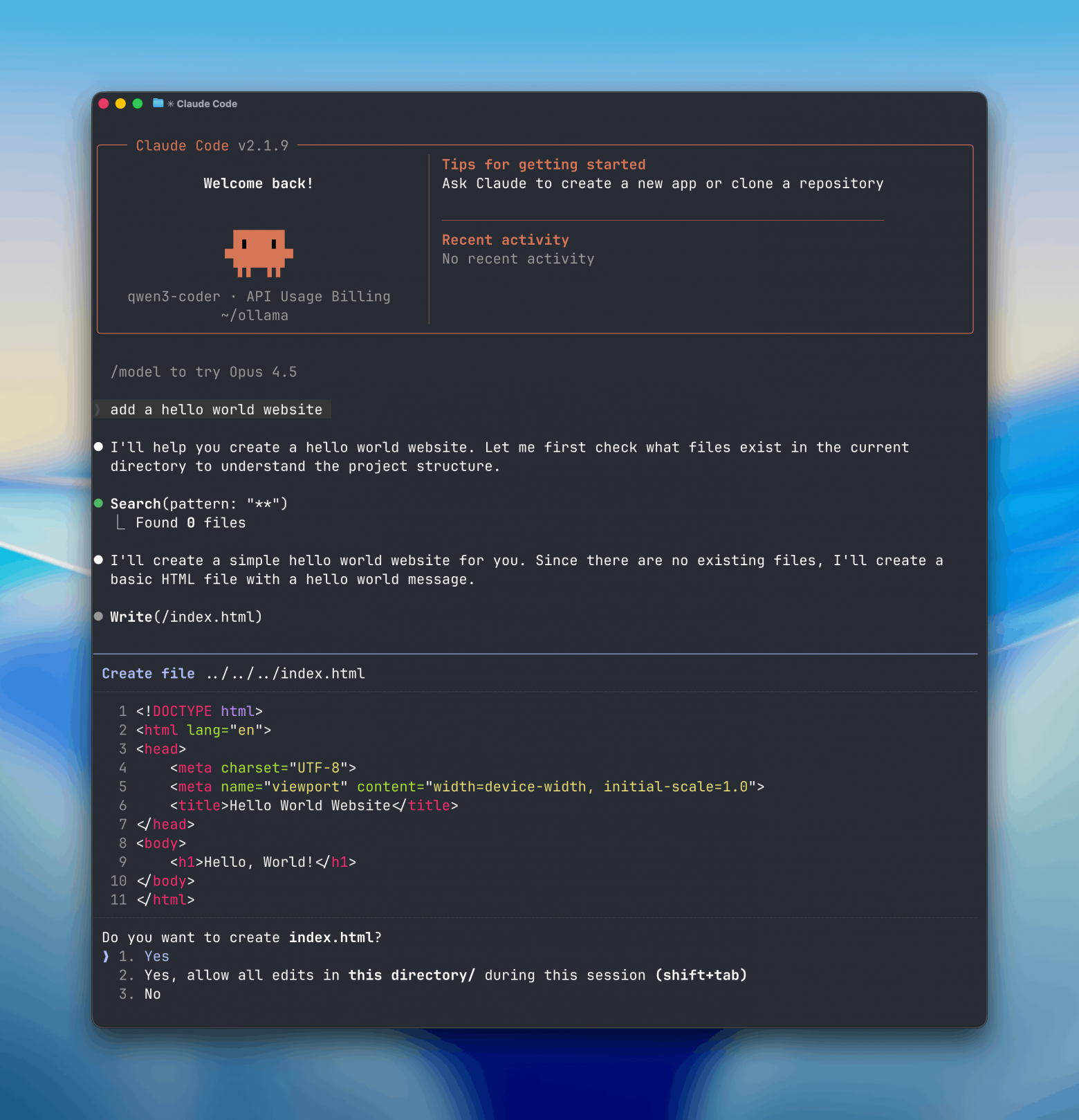

Начиная с версии Ollama 0.14, платформа получила совместимость с Anthropic Messages API. Это означает, что Claude Code — агентный инструмент для программирования, который работает прямо в терминале — теперь может использовать любую модель из Ollama, а не только облачные модели Anthropic.

По сути, Claude Code думает, что общается с Anthropic API, но на самом деле запросы уходят в локально запущенную модель. Достаточно указать Ollama как base URL — и инструмент начинает работать с open-source LLM так же, как раньше с Claude.

Claude Code умеет читать и писать код, анализировать проекты, работать с файлами и вызывать инструменты. Раньше для этого требовался доступ к облаку, теперь — достаточно локальной модели с большим контекстом.

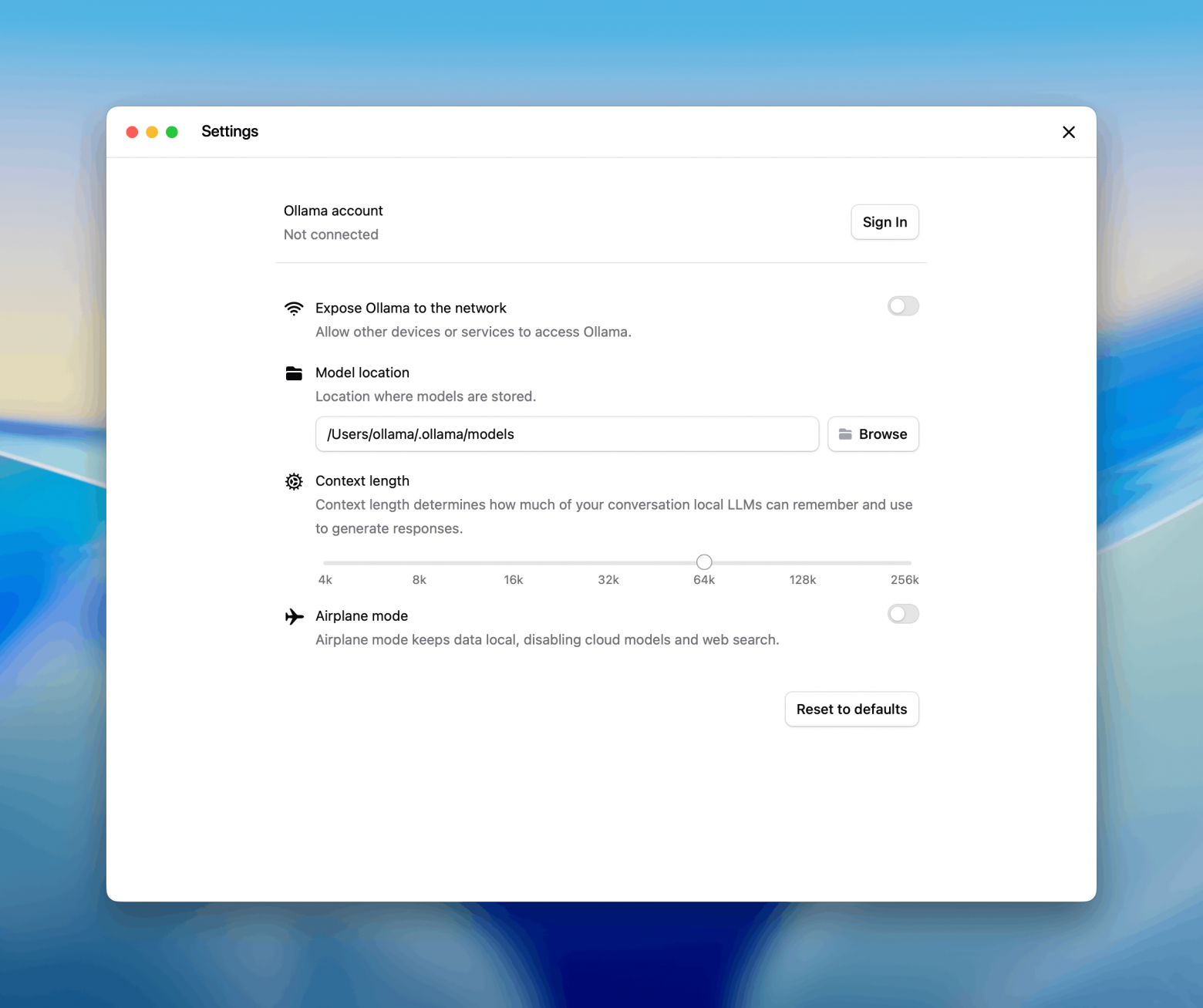

Поддерживаются как локальные модели (например, gpt-oss:20b или qwen-coder), так и облачные модели из Ollama Cloud. Рекомендуется использовать модели с контекстом от 64k токенов — иначе агент быстро упрётся в лимиты.

Важно, что совместимость работает не только в CLI. Любые приложения, которые уже используют Anthropic SDK, можно переключить на Ollama, просто сменив base URL. Python, JavaScript, streaming, tool calling, system prompts — всё это поддерживается без изменений кода.

Фактически Ollama становится универсальным «прокси-Anthropic API» для open-source моделей. А Claude Code — первым популярным агентным инструментом, который можно полноценно запускать локально, без отправки кода в облако.

Русскоязычное сообщество про AI в разработке

Друзья! Эту новость подготовила команда ТГК «AI for Devs» — канала, где мы рассказываем про AI-ассистентов, плагины для IDE, делимся практическими кейсами и свежими новостями из мира ИИ. Подписывайтесь, чтобы быть в курсе и ничего не упустить!

Автор: python_leader