Доброго времени суток, Хабр!

В предыдущей своей статье я рассматривал разные парадигмы обучения моделей. Однако не всегда при обучении все происходит гладко.

Бывают ситуации, когда на обучающих данных модель работает идеально, но при проверке на новых данных точность резко снижается. Это явление называется переобучением.

Сегодня в статье расскажу об переобучении моделей, как обнаружить это явление и избежать его. Примите стратегически удобное положения, а я приступаю к своему повествованию.

Что такое переобучение?

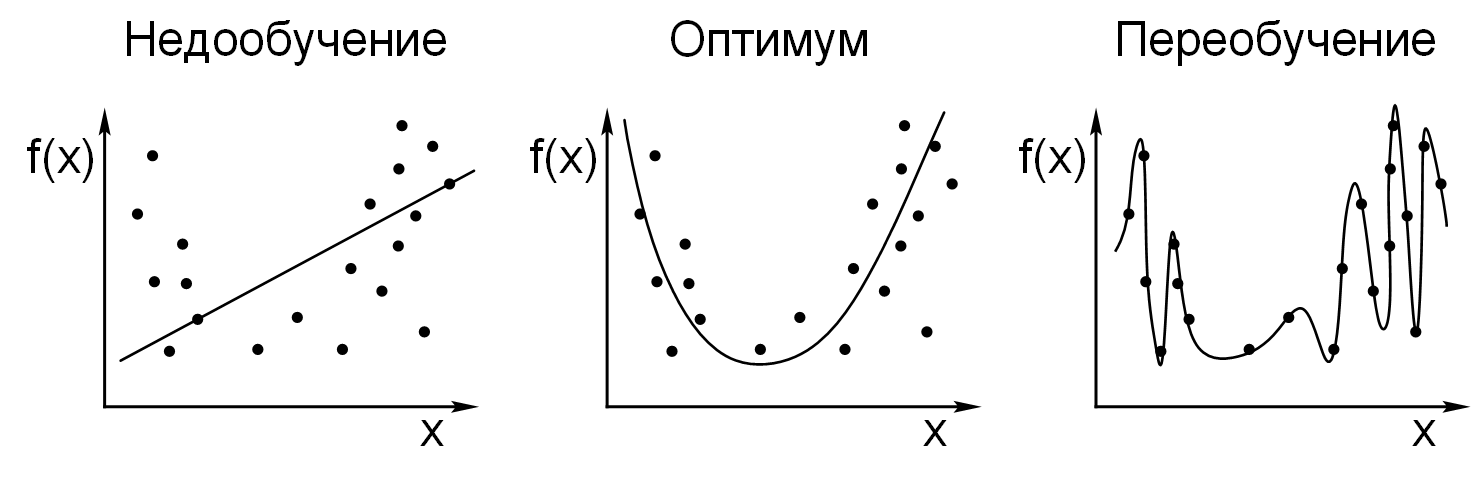

Переобучение – ситуация, когда модель слишком точно подстраивается под обучающую выборку. Она просто учит закономерности, а запоминает каждый пример, в том числе и ошибки, шум и случайные отклонения. Такая модель будет показывать высокую точность на уже знакомых данных, но отвратительно работать на новых.

Если упростить, то получается ситуация, что модель знает ответы на те данные, которые уже видела, при этом не умеет решать похожие, но новые задачи.

Хорошо или плохо?

Ответ однозначен – плохо. Модель, которая хорошо работает только на тренировочных данных попросту бесполезна на практике и противоречит целям машинного обучения (делать точные прогнозы на новых данных).

Как распознать переобучение?

Переобучение сложно заметить, если оценивать модель только по обучающей выборке. Чтобы обнаружить проблему, нужно сравнивать поведение модели на разных наборах данных.

Первый и самый главный признак переобучения – ситуация, когда модель показывает высокую точность на обучающей выборке и низкую на тестовой. Например, модель классифицирует изображения и достигает 100% точности на обучающих данных. На тестовом варианте, она показывает 60%. Это указывает на то, что модель не научилась отличать классы, а просто заучила данные ей примеры.

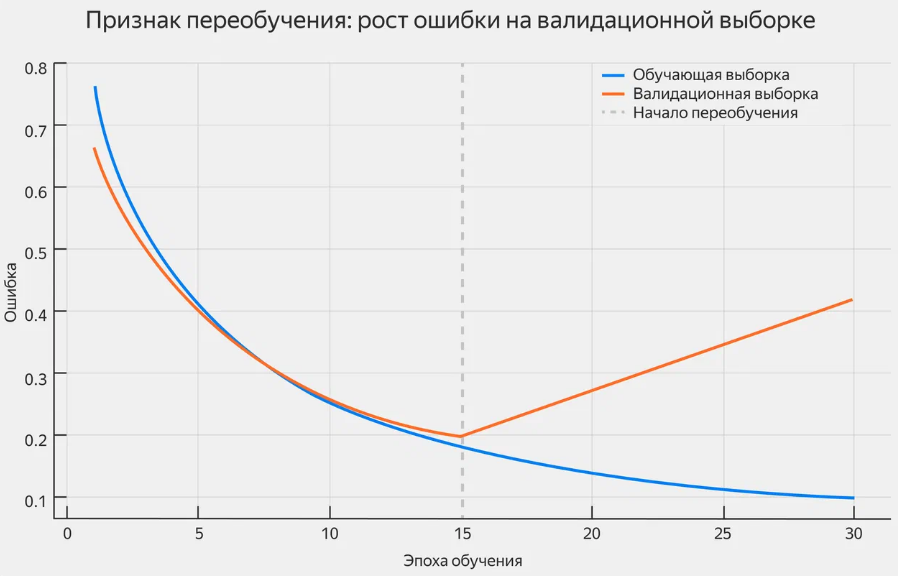

Второй признак переобучения – рост или снижение уровня ошибки на валидационной выборке при продолжении обучения. Валидационной выборкой называют данные, которые не используют для обучения модели, а применяют для проверки ее качества в процессе обучения.

При переобучении график выглядит как L-образная кривая. Сначала уровень ошибки при валидации снижается – модель учится, а затем, после определенного количества итераций, он снова начинает ра��ти или стагнировать.

Третий признак – нестабильность прогнозов на новых данных. Если модель ведет себя непредсказуемо на новых примерах, это еще один повод заподозрить переобучение.

Допустим, модель обучили различать положительные и отрицательные отзывы. Добавление одного нейтрального слова резко поменяет прогноз с положительного на отрицательный.

Причины переобучения

Конечно переобучение не может возникнуть само по себе. Оно появляется, когда модель получает слишком много свободы и недостаточно данных, чтобы научиться обобщать.

Слишком сложная модель может привести к переобучению. Если она имеет много параметров, значит она может подогнать себя под любые данные – даже если в них много случайных или ошибочных значений. Вместо стандартного поиска закономерностей модель просто запомнит обучающую выборку.

Еще одна причина – недостаточность данных для обучения. Если данных мало, модель не может увидеть все типичные случаи. Ей проще запомнить то, что есть, чем выявить общие признаки и закономерности.

Недостаточность данных – плохо, но, кроме этого, данные могут быть шумными и некачественными, что в конечном итоге тоже приведет к переобучению. То есть если в обучающей выборке много случайных ошибок, дубликатов, пропусков или противоречий, модель с большим шансом примет их за реальные закономерности.

Дублирующие и неинформативные данные тоже будут мешать модели. Она начнет учитывать малозначимые детали и подгонять поведение под них.

Как говорилось чуть выше, переобучение появляется когда модель получает слишком много свободы. Поэтому должна присутствовать регуляризация – метод, который ограничивает сложность модели. Если его не использовать, то нейросеть становится слишком свободной и может выучить все подряд, не разбирая нормальные ли это данные или шум.

Особенности переобучения в разных типах моделей

Кроме вышеупомянутых признаков не стоит забывать, что у каждого алгоритма есть свои слабые места. Например, линейные модели могут захватить шум или выбросы. Они слишком точно подгоняются под данные, особенно если признаков много.

Деревья решений и ансамбли слишком точно запоминают обучающую выборку. Результаты при обучении почти идеальные, но при попытке скормить новые данные они резко падают.

В методе k-ближайших соседей, при малом значении k будет искать ближайший пример. Любой шум или выброс просто приведет к ошибке.

Нейросети запоминают обучающиеся данные, но слабо работают при тесте. Часто ошибка будет стремиться к нулю, но при валидации она только увеличивается.

Методика борьбы с переобучением

Пройдемся по некоторым способам борьбы с переобучением.

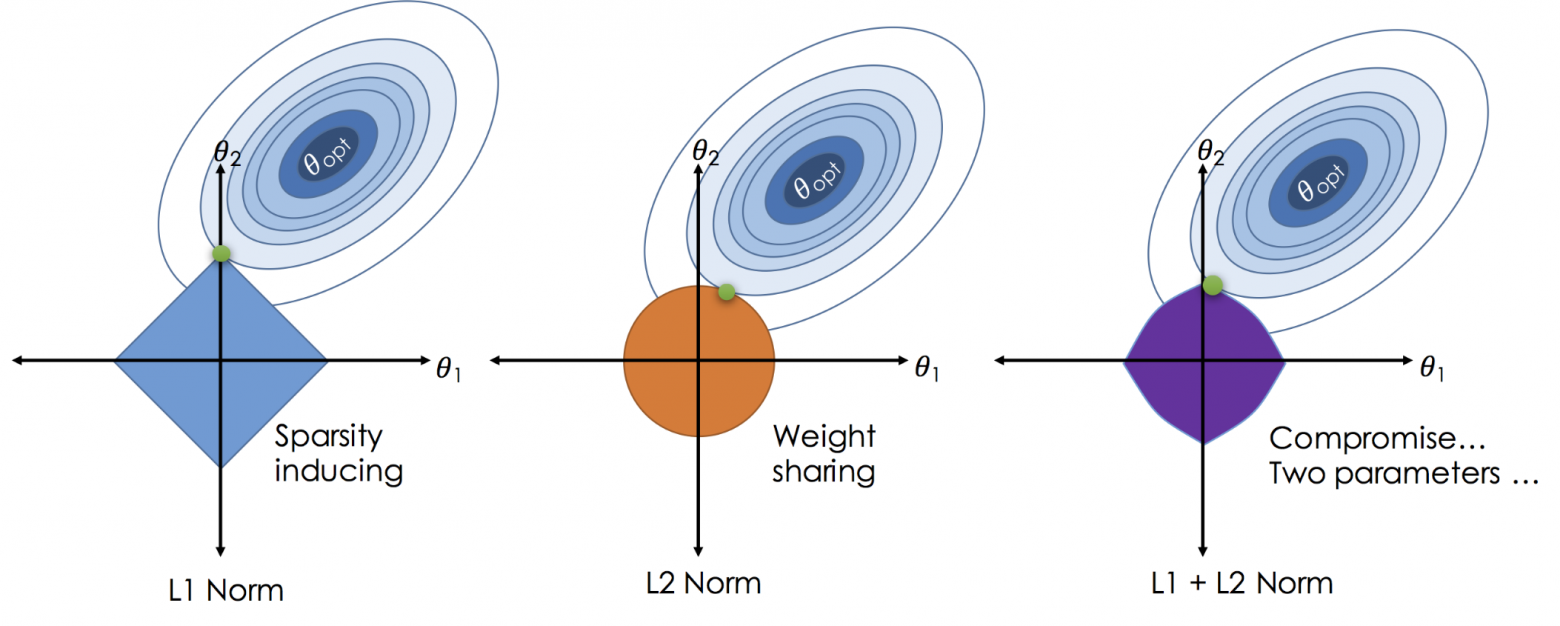

Для начала – регуляризация. Это способ ограничивать сложность модели, чтобы предотвратить запоминание шума в данных. Например, L1-регуляризация обнуляет незначимые параметры, что помогает автоматически отобрать наиболее важные признаки. L2-регуляризация делает веса модели менее экстремальными, сглаживая ее поведение и снижая чувствительность к отдельным примерам.

Оба подхода добавляют к функции потерь штраф за большие значения весов, тем самым контролируя сложность модели.

Увеличение объема данных – еще один способ борьбы с переобучением. Сбор большего количества качественных данных помогает улучшить обобщающую способность модели.

Если нет возможности расширить объем данных, то можно создать новые тренировочные данные путем изменения существующих. Это помогает увеличить размер тренировочного набора и сделать модель более устойчивой к изменениям.

Следующий вариант – упрощение модели. Сложная модель с множеством параметров легко переобучается, особенно при небольшом объеме данных. В таких случаях лучше использовать более простую архитектуру, например, линейную модель вместо глубокой нейронной сети, или уменьшить количество слоев и нейронов. Упрощение снижает способность модели к запоминанию шума и помогает ей лучше обобщать.

Еще одним способом предотвращения переобучения является ранняя остановка. Метод, при котором обучение прекращается, как только метрика на валидационной выборке перестает улучшаться или начинает ухудшаться.

Такой подход предотвращает переобучение, возникающее при излишне долгой тренировке, когда модель продолжает подстраиваться под обучающие данные, но теряет способность к обобщению.

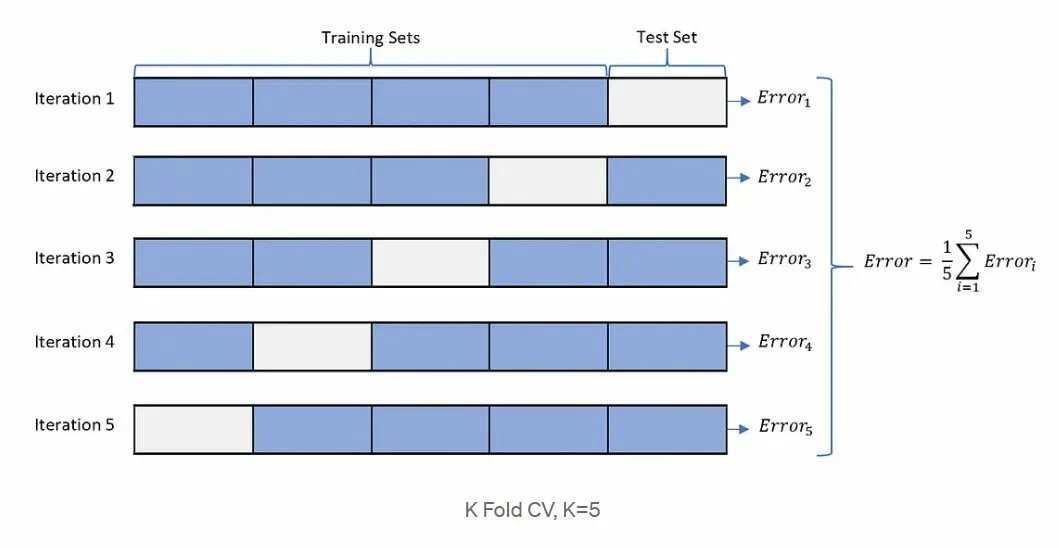

Кроме выше перечисленного, можно прибегнуть к кросс-валидации. Метод, когда все данные делятся на несколько частей. Модель обучается на одной группе данных и проверяется на оставшейся, процесс повторяется для каждого фолда.

Ме��од позволяет не только оценить модель на разных подмножествах данных, что снижает ее зависимость от конкретного разбиения и дает более надежную оценку ее способности к обобщению.

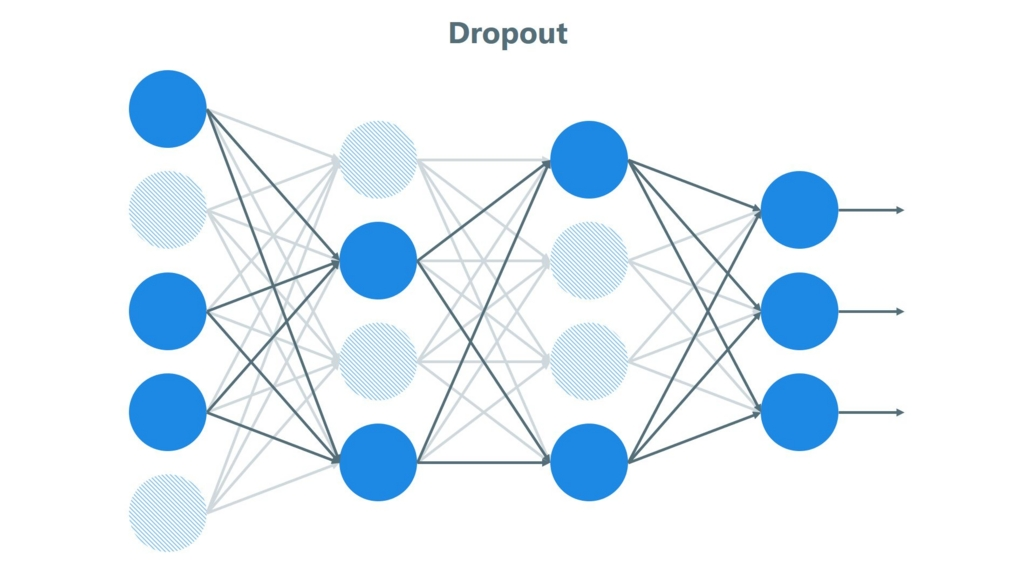

Наконец, для глубоких нейросетей с большим количеством параметров особенно высок риск переобучения при малом объеме данных. Метод Dropout случайным образом отключает часть нейронов во время каждой итерации обучения, не давая сети слишком полагаться на конкретные связи. Подобный подход заставляет модель учиться более устойчивым и обобщенным признакам, что повышает ее эффективность на новых данных.

Когда переобучение необходимо?

Как бы не казалось странным, но все иногда переобучение может быть полезным. Это касается ситуаций, когда необходимо создать модель, которая идеально работает на конкретном, ограниченном наборе данных.

Например, при создании генеративно-состязательных моделей переобучение может помочь генерировать данные, которые максимально похожи на тренировочные.

Организовать переобучение можно обратными для противостояния способами: использовать сложную модель, обучать модели очень долго на одном и том же наборе данных, не использовать регуляризацию и так далее.

Итог

Переобучение – одна из ключевых проблем в машинном обучении, возникающая, когда модель слишком точно подстраивается под обучающие данные, теряя способность к об��бщению.

Существует достаточно много способов борьбы с этим явлением: от увеличение количество данных для обучения, до использования Dropout. Хотя в некоторых ситуациях, переобучение необходимо, но таких случаев мало.

Понимание природы переобучения, умение его диагностировать и вовремя применить соответствующие методы противостояния – это необходимые навыки для любого специалиста в области машинного обучения, стремящегося создать модели, которое не просто запоминают, а действительно чему-то учатся.

Спасибо за прочтение!

Автор: MrRjxrby