Microsoft запустила внедрение второго поколения собственного ИИ-ускорителя Maia, делая еще один шаг к снижению зависимости от Nvidia и оптимизации затрат на инфраструктуру. Новые чипы уже устанавливаются в дата-центрах компании в США, а для разработчиков открыт доступ к SDK. При этом сроки публичного запуска инстансов Maia 200 в Azure пока официально не объявлены.

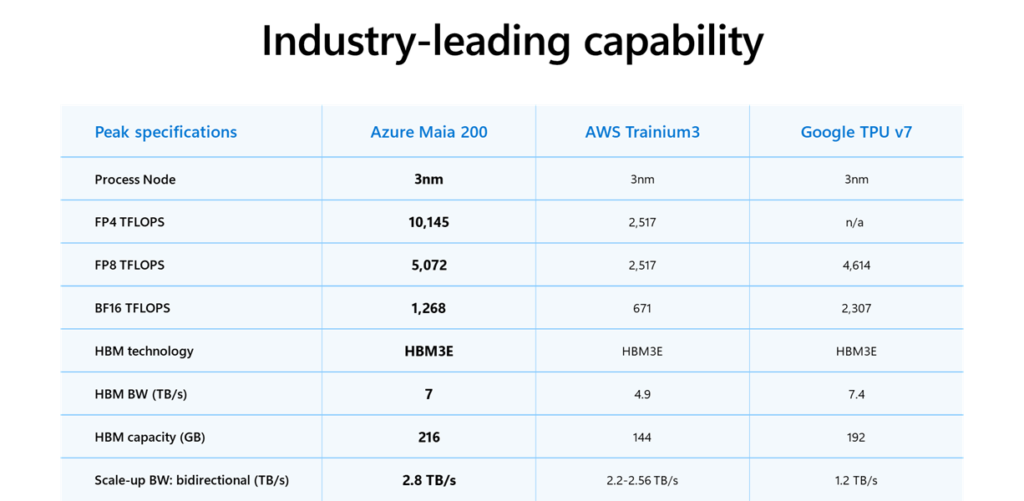

Maia 200 производится по 3-нм техпроцессу и содержит более 140 млрд транзисторов. Архитектура изначально проектировалась под инференс крупных моделей. Заявленная производительность превышает 10 петафлопс в FP4 и достигает 5 петафлопс в FP8, что делает чип ориентированным на массовый продакшен ИИ-сервисов.

Подсистема памяти выглядит особенно агрессивно. Ускоритель оснащен 216 ГБ HBM3e с пропускной способностью до 7 ТБ/с, а также 272 МБ сверхбыстрого SRAM-кэша прямо на кристалле. Энергопакет одного чипа составляет 750 Вт, что вписывается в современные дата-центровые стандарты для high-end ИИ-железа.

По внутренним тестам Microsoft, Maia 200 работает примерно в три раза быстрее Amazon Trainium 3 и превосходит Google TPU v7 в задачах FP8-инференса. Чип также поддерживает масштабирование в кластеры до 6144 ускорителей без потери эффективности, что критично для крупных моделей.

Отдельный акцент компания делает на экономике. По показателю производительности на доллар Maia 200 примерно на 30% эффективнее актуальных решений конкурентов. Если эти цифры подтвердятся в продакшене, Microsoft получит серьезное преимущество в стоимости инференса своих ИИ-сервисов.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: cognitronn