Продакшен больших моделей давно превратился в соревнование за проценты эффективности. Когда счет идет на тысячи GPU, даже небольшой прирост скорости напрямую превращается в миллионы долларов экономии. Tencent Hunyuan AI Infra выложила в open source HPC-Ops, библиотеку, на которой работает их собственная продакшен инфраструктура.

Ключевая идея простая и радикальная. Вместо оптимизации существующих решений разработчики переписали все с нуля на чистой CUDA и CuTe, строго под архитектуру Hopper. Это осознанный шаг, так как популярные фреймворки вроде vLLM или стандартного FlashAttention часто не используют потенциал H100 и H200 на полную.

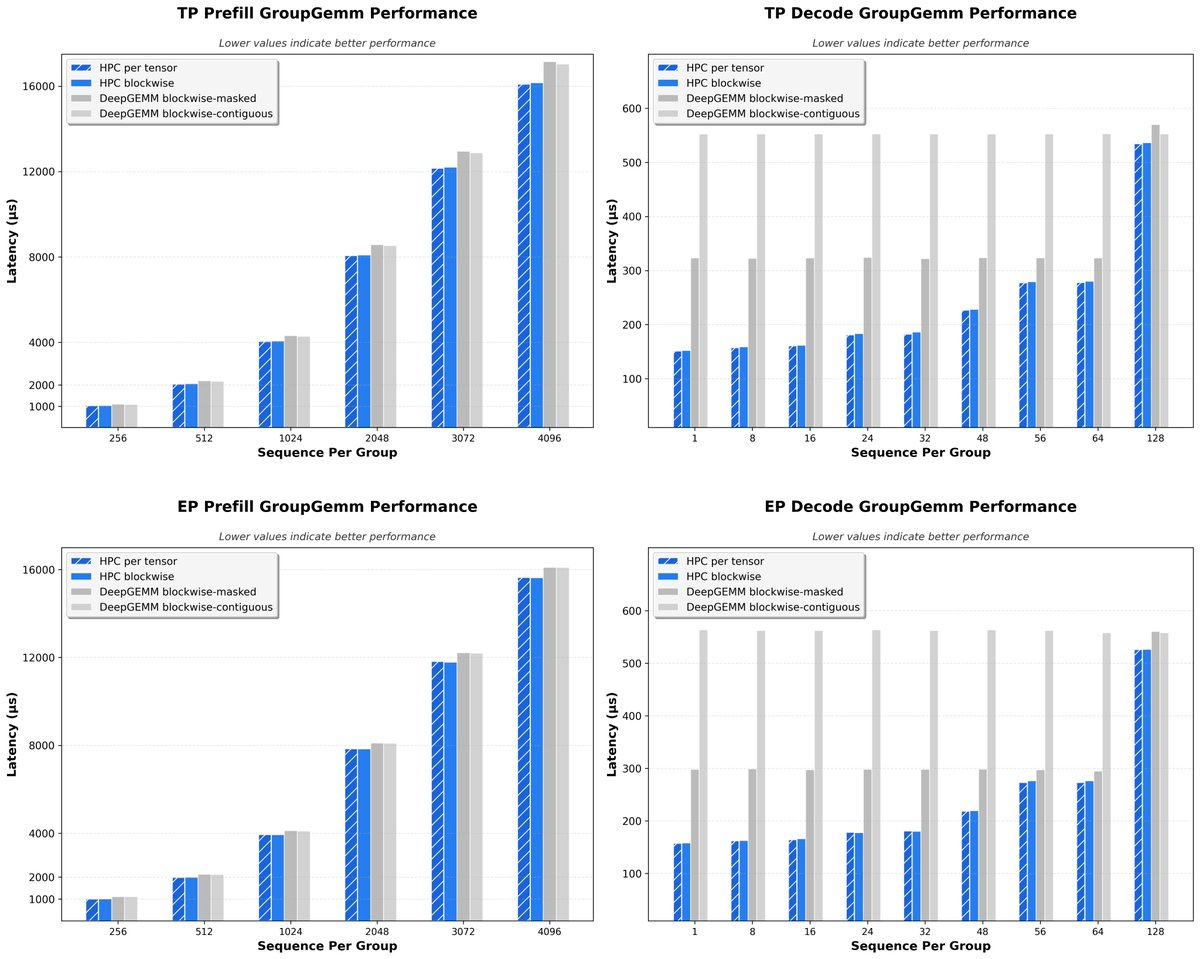

HPC-Ops заточен именно под максимальную утилизацию GPU. Внутри есть полный набор инструментов для серьезного инференса. Оптимизированные ядра внимания с paged attention, квантованный Grouped GEMM с поддержкой FP8 и блочным скейлингом, Fused MoE и эффективные механизмы коммуникации между нодами в распределенных системах.

Результаты выглядят убедительно. На собственных моделях Tencent рост пропускной способности составил около 30 процентов, на моделях DeepSeek около 17 процентов. Самый впечатляющий эффект показал H20, где ускорение достигло 2.22 раза по сравнению с предыдущими решениями.

Основной выигрыш приходит на этапе декодинга. В режиме BF16 механизм внимания работает примерно в 2.2 раза быстрее, чем связка FlashInfer, FlashAttention и TensorRT LLM. На префилле ускорение скромнее, около 1.33 раза, но и это заметный прирост для продакшена. В FP8 картина похожая. Декодинг ускоряется почти в 2 раза, а префилл дает около 12 процентов прироста. Отдельно выделяется Fused MoE, который в FP8 ускоряет префилл почти на 50 процентов.

Библиотека хорошо интегрируется с vLLM и SGLang, но важно учитывать ограничение. HPC-Ops работает только с Hopper, то есть с картами класса SM90. Старое железо не поддерживается.

В roadmap проекта заявлены sparse attention, поддержка 4 битного квантования и новые ядра, которые будут совмещать вычисления и передачу данных между GPU для еще большей эффективности.

Если вы сейчас оптимизируете инференс на H100 или H200 и реально боретесь за каждый токен в секунду, эту библиотеку точно стоит попробовать.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: cognitronn