Новый стандарт A2UI от Google позволяет ИИ-агентам создавать графические интерфейсы на лету. Вместо простой отправки текста, ИИ теперь могут генерировать формы, кнопки и другие элементы пользовательского интерфейса, которые органично вписываются в любое приложение.

Проект с открытым исходным кодом A2UI (Agent-to-User Interface) стремится стандартизировать способ создания визуальных ответов агентами искусственного интеллекта. Стандарт, выпущенный под лицензией Apache 2.0, устраняет разрыв между генеративным ИИ и графическими пользовательскими интерфейсами.

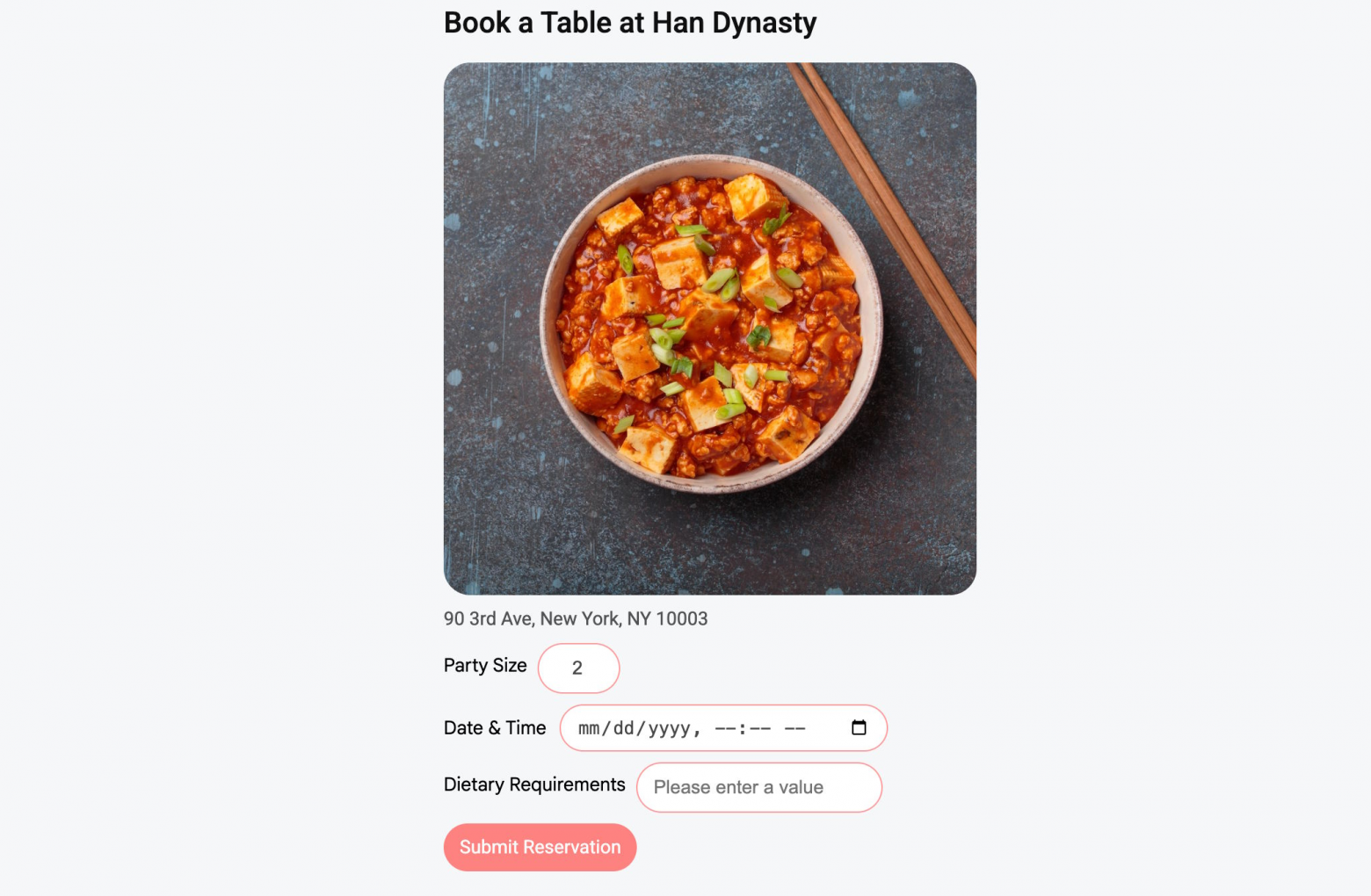

Логика A2UI проста: простой текстовый или программный вывод часто не подходит для сложных задач. Google приводит в пример бронирование столиков в ресторанах; текстовый диалог может быстро стать утомительным.

С помощью A2UI оператор может мгновенно создать полноценную форму с полями выбора дат и доступными временными интервалами. Цель – создать контекстно-зависимый интерфейс, который адаптируется по мере развития разговора.

A2UI отказывается от iframe и исполняемого кода

A2UI отходит от распространенной практики, когда агенты генерируют HTML или JavaScript, которые работают в изолированных средах или iframe. По мнению исследовательской группы, такой подход создает риски безопасности и часто выглядит некачественно, поскольку дизайн редко соответствует основному приложению.

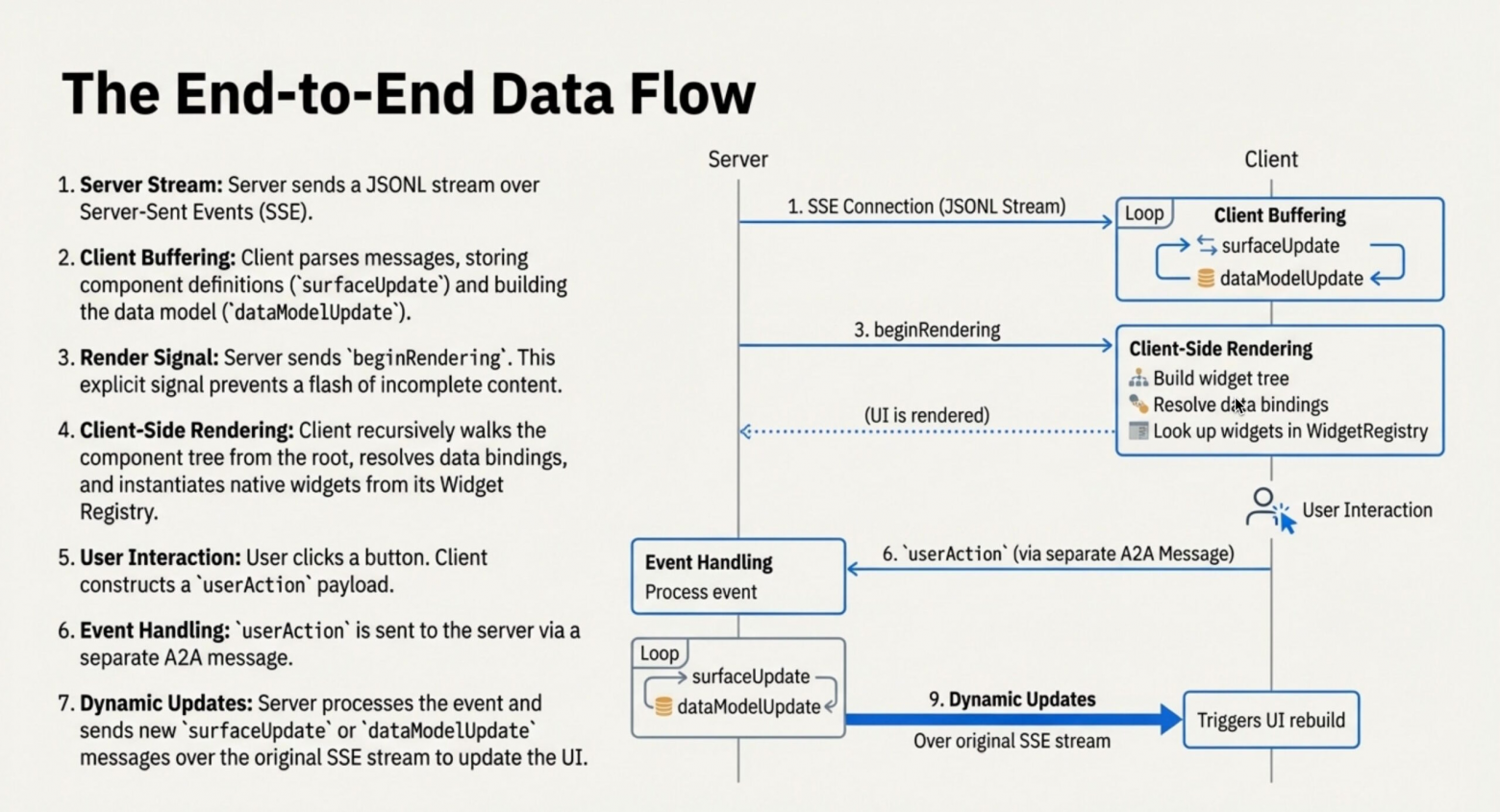

A2UI использует другой подход: он отправляет данные, а не код. Агент не передает исполняемую логику – он отправляет структуру JSON, описывающую необходимый интерфейс.

Принимающее приложение интерпретирует эти данные и отображает их с помощью собственных компонентов пользовательского интерфейса. Эта модель безопасности ограничивает агентов предопределенным набором компонентов, таких как кнопки и текстовые поля.

Такой подход снижает риски внедрения кода. А поскольку агент задает только структуру, а не идеально точный дизайн, клиентское приложение сохраняет полный контроль над внешним видом.

Как A2UI выглядит на фоне MCP от Anthropic и ChatKit от OpenAI

Google занимает свою нишу на все более переполненном рынке агентных пользовательских интерфейсов. Команда четко разграничивает A2UI и другие стандарты. По словам Google, протокол контекста модели (MCP) от Anthropic рассматривает пользовательский интерфейс как ресурс – обычно это готовый HTML-код, загружаемый в изолированной среде. A2UI ориентирован на нативные приложения, стремясь к более глубокой интеграции с хост-приложениями.

Google также отличает A2UI от ChatKit от OpenAI. ChatKit лучше всего работает в экосистеме OpenAI, в то время как A2UI разработан как платформенно-независимый инструмент. Он предназначен для сложных многоагентных конфигураций, где один агент управляет другими и безопасно отображает предложения пользовательского интерфейса от удаленных субагентов.

Всего несколько недель назад Google продемонстрировал, как модели ИИ могут создавать интерактивные инструменты и симуляции в режиме реального времени, представив функцию «Генеративный пользовательский интерфейс» в приложении и поиске Gemini. Эта функция, получившая название «Динамический просмотр», генерирует персонализированные графические интерфейсы, чтобы упростить понимание сложных тем.

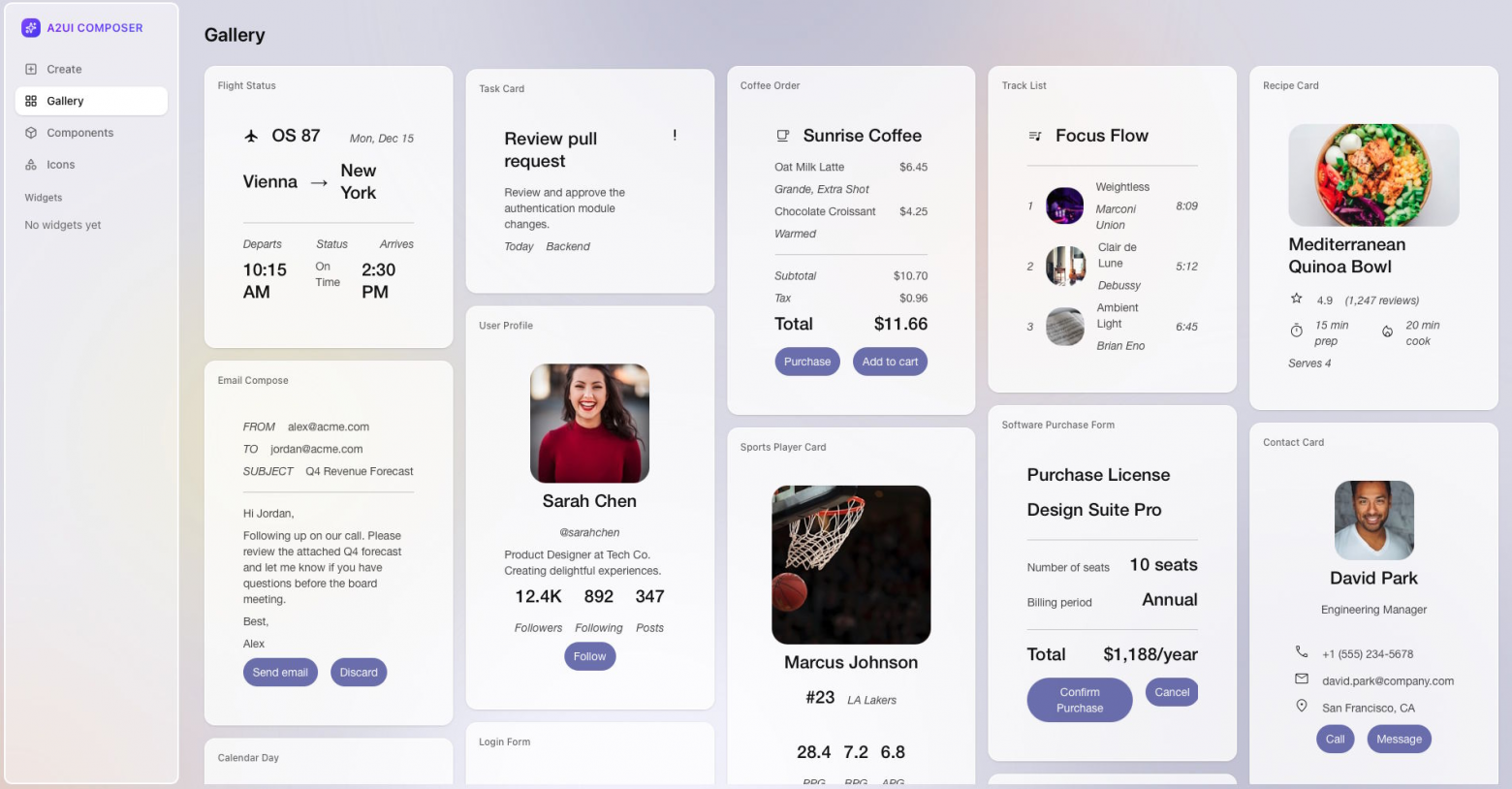

По данным Google, стандарт находится в версии 0.8 и уже используется в производстве. SDK GenUI для Flutter использует A2UI для обработки связи между серверными агентами и мобильными приложениями. Внутренняя платформа мини-приложений Google Opal и Gemini Enterprise также работают на этом протоколе.

Google наладила партнерские отношения с внешними фреймворками. Команды, стоящие за AG UI и CopilotKit, поддерживали протокол с самого начала. Проект выпускает клиентские библиотеки для Flutter, Web Components и Angular, и команда приглашает разработчиков вносить свой вклад в разработку новых рендереров и интеграций. Учитывая, как быстро распространяются такие стандарты, как MCP , A2UI выглядит перспективным для широкого внедрения.

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: MrRjxrby