Исследование Гонконгского университета и Калифорнийского университета в Беркли показало, что языковые модели лучше обобщают, если им позволить самостоятельно находить решения. Это касается как больших языковых моделей (LLM), так и моделей, которые совмещают текст и изображения (VLM). Эти результаты ставят под сомнение одно из главных убеждений сообщества — что моделям нужно много примеров с ручной разметкой для обучения. На самом деле, исследователи доказали, что слишком много таких примеров может даже ухудшить способность моделей к обобщению новых данных.

Долгое время основным методом дообучения считалось дообучение с учителем (SFT). После первоначального обучения модели на текстах и изображениях, компании обычно дообучают её на большом количестве примеров в формате вопрос/ответ или запрос/ответ. После SFT модель может пройти дополнительные этапы, например, обучение с подкреплением от человека (RLHF), где она учится лучше понимать человеческие предпочтения на основе оценок ответов.

SFT помогает настраивать модель для выполнения конкретных задач, однако сбор данных с ручной разметкой — это долгий и дорогостоящий процесс. Это замедляет развитие для многих компаний и лабораторий. Недавние разработки в области LLM привели к росту интереса к подходам, основанным на чистом обучении с подкреплением (RL). В таких подходах модель учится выполнять задачи самостоятельно, без заранее размеченных примеров. Один из главных примеров — DeepSeek-R1, который в основном полагался на RL для освоения сложных задач.

Одной из основных проблем машинного обучения (ML) является переобучение. Модель хорошо работает на обучающих данных, но не может обобщать на новые примеры. В процессе обучения может казаться, что модель освоена, хотя на деле она просто запомнила тренировочные примеры. В крупных AI-моделях трудно отличить обобщение от запоминания.

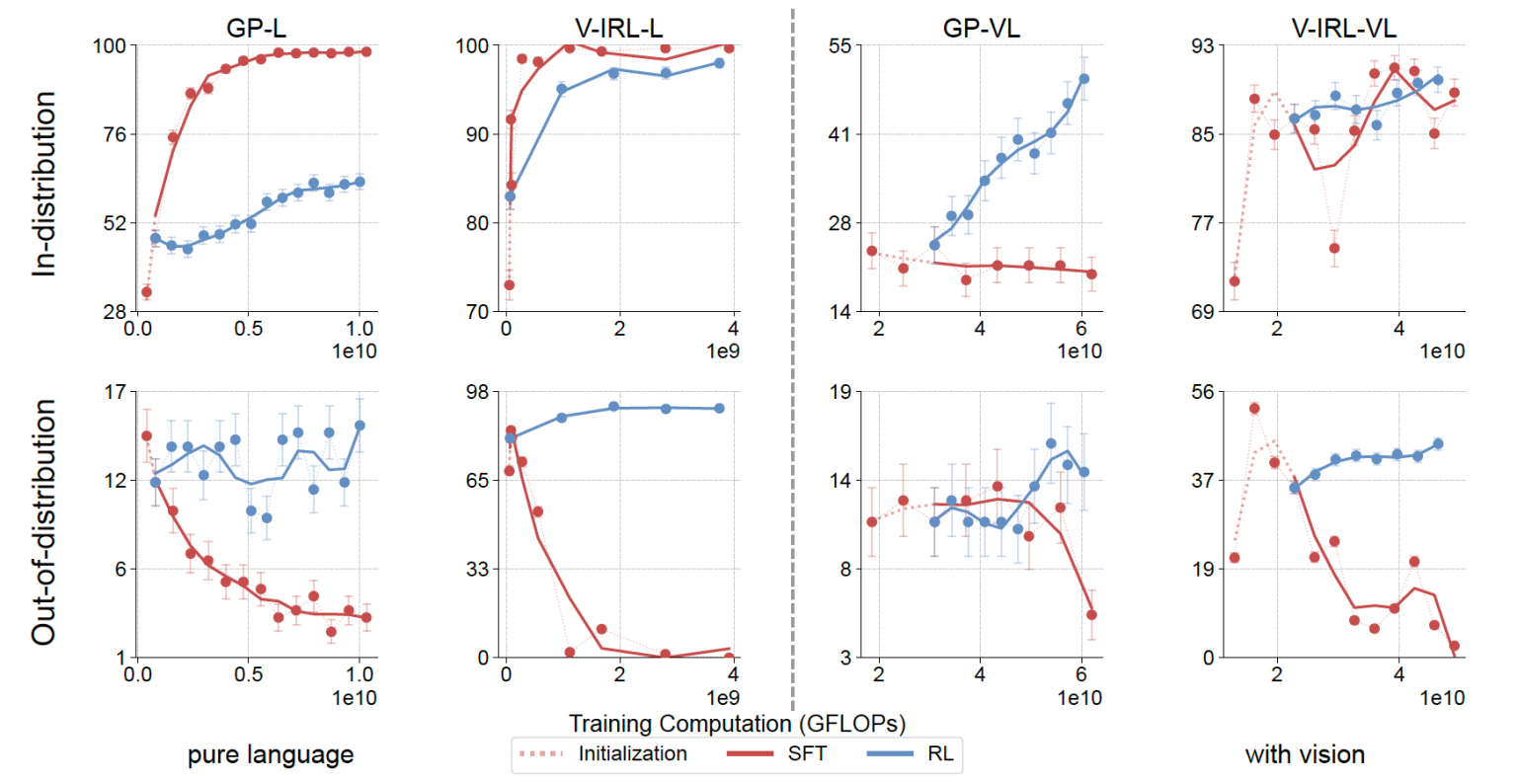

Новое исследование сосредоточено на сравнении способностей RL и SFT в задачах текстовых и визуальных рассуждений. В текстовых задачах LLM должна уметь обобщать правила на их варианты. В визуальных задачах VLM должна показывать стабильные результаты при изменении визуальных характеристик, таких как цвет или расположение объектов.

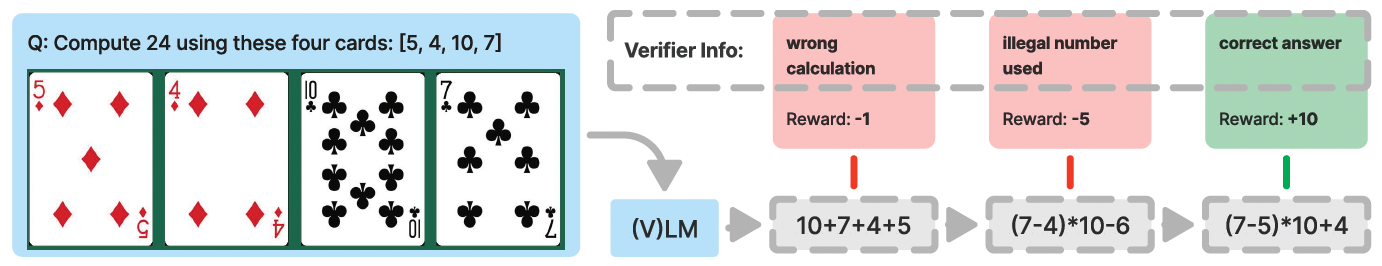

В рамках экспериментов использовались две задачи. Первая — GeneralPoints, оценивающая способности модели в арифметике. Модели давали четыре карты в виде текстов или изображений, и просили собрать их так, чтобы получить заданное число. Для оценки способности обобщать, модель обучалась на одном наборе правил, а тестировалась на другом. Визуальная часть теста проверяла способность работать с картами разных цветов.

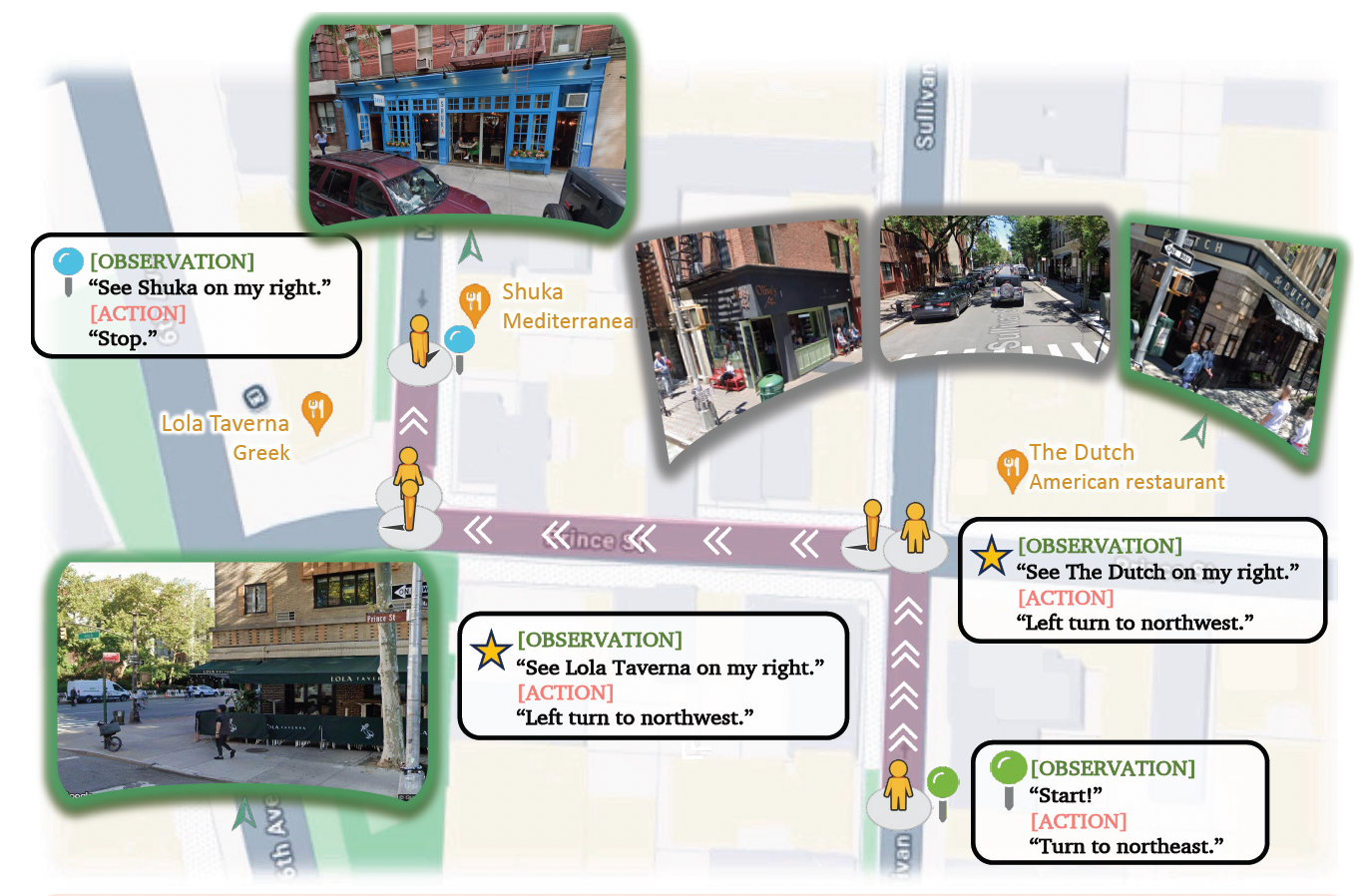

Вторая задача — V-IRL, тестировала пространственное мышление модели в условиях открытого мира с реалистичным визуальным вводом. Эта задача имела языковую и визуально-языковую версии. Исследователи оценивали обобщение, изменяя инструкции и визуальные представления, на которых модель была обучена.

Они протестировали Llama-3.2-Vision-11B, обучив её на небольшом наборе данных SFT, а затем создали разные версии для каждой задачи и способа обучения. Для каждой задачи они отдельно масштабировали обучение на основе RL и SFT. SFT дообучает модель на ручных решениях, а RL позволяет модели генерировать собственные решения, проверять их и обучаться на правильных ответах.

Результаты показали, что обучение с подкреплением последовательно улучшало работу модели на примерах, которые сильно отличались от тренировочных данных. В то же время, SFT приводил к тому, что модель запоминала тренировочные правила и плохо справлялась с новыми задачами. Эти выводы касаются как текстовых, так и мультимодальных задач.

Хотя RL лучше обобщал, чем SFT, исследователи также обнаружили, что SFT стабилизирует выводы модели и необходим для того, чтобы RL достигал своих результатов. Без начального этапа SFT, RL не давал желаемых результатов.

Это отличается от результатов, полученных в DeepSeek-R1-Zero, который использовал только RL. Исследователи считают, что это может быть связано с разными архитектурами моделей.

Очевидно, что у подходов с упором на RL большой потенциал. В ситуациях, где важны проверяемые результаты, обучение моделей без примеров может привести к неожиданным решениям, которые невозможно создать вручную. Это особенно полезно там, где создание размеченных примеров занимает много времени и ресурсов.

Автор: cognitronn