Приходилось ли вам когда-нибудь упрекать чат-бот с LLM — к примеру, ChatGPT или Claude — в устаревшей или неточной информации?

Дело в том, что, формируя ответ, крупные языковые модели (LLM) опираются на наборы данных, на которых они были обучены. Однако, поскольку их основная задача — предсказывать текст, а не извлекать факты, на их точность нельзя полагаться во всех случаях. Кроме того, обучающие датасеты обычно ограничены общедоступными данными и в некоторых областях быстро теряют актуальность.

Дисклеймер: это вольный перевод поста из блога компании EvidentlyAI, который написала Дарья Малюгина. Перевод подготовила редакция «Технократии». Чтобы не пропустить анонс новых материалов подпишитесь на «Голос Технократии» — мы регулярно рассказываем о новостях про AI, LLM и RAG, а также делимся полезными мастридами и актуальными событиями.

Обсудить пилот или задать вопрос об LLM можно здесь.

Когда вы создаёте приложения на основе LLM для бизнеса, базового поведения модели бывает недостаточно. Как же сделать системы на базе LLM — от чат-ботов службы поддержки до AI-ассистентов — более точными и надёжными?

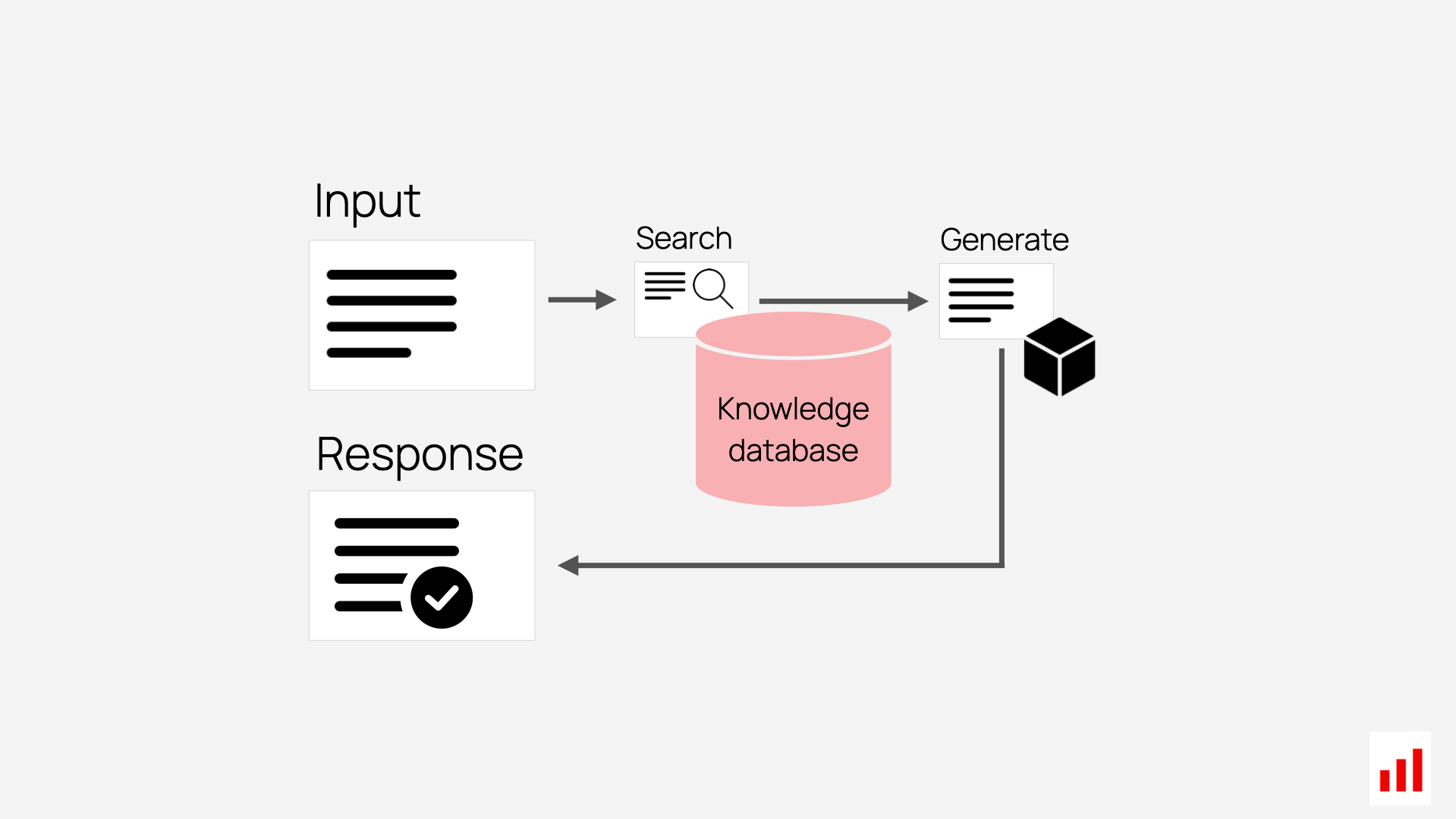

Один из способов — Retrieval-Augmented Generation (RAG). Этот подход помогает «привязать» ответы LLM к проверенным источникам данных, например к внутренним документам или политикам компании. Допустим, если компания использует RAG для поддержки клиентов, система прежде ищет сведения в базе знаний, а уже потом формирует ответ, удостоверяясь, что он соответствует текущим руководствам.

У такого подхода есть несколько преимуществ:

— Вы снабжаете модель актуальными и специфичными для вашей области знаниями, что уменьшает риск ошибок и повышает точность.

— RAG может выдавать ссылки на источники, позволяя легко проверять достоверность ответов.

— Обращаясь к пользовательским данным, RAG формирует ответы, учитывающие индивидуальные особенности каждого клиента.

В этой статье мы собрали 10 реальных примеров того, как компании применяют RAG, чтобы повысить качество обслуживания, автоматизировать рутинные задачи и улучшить продуктивность.

Чат-бот службы доставки от DoorDash

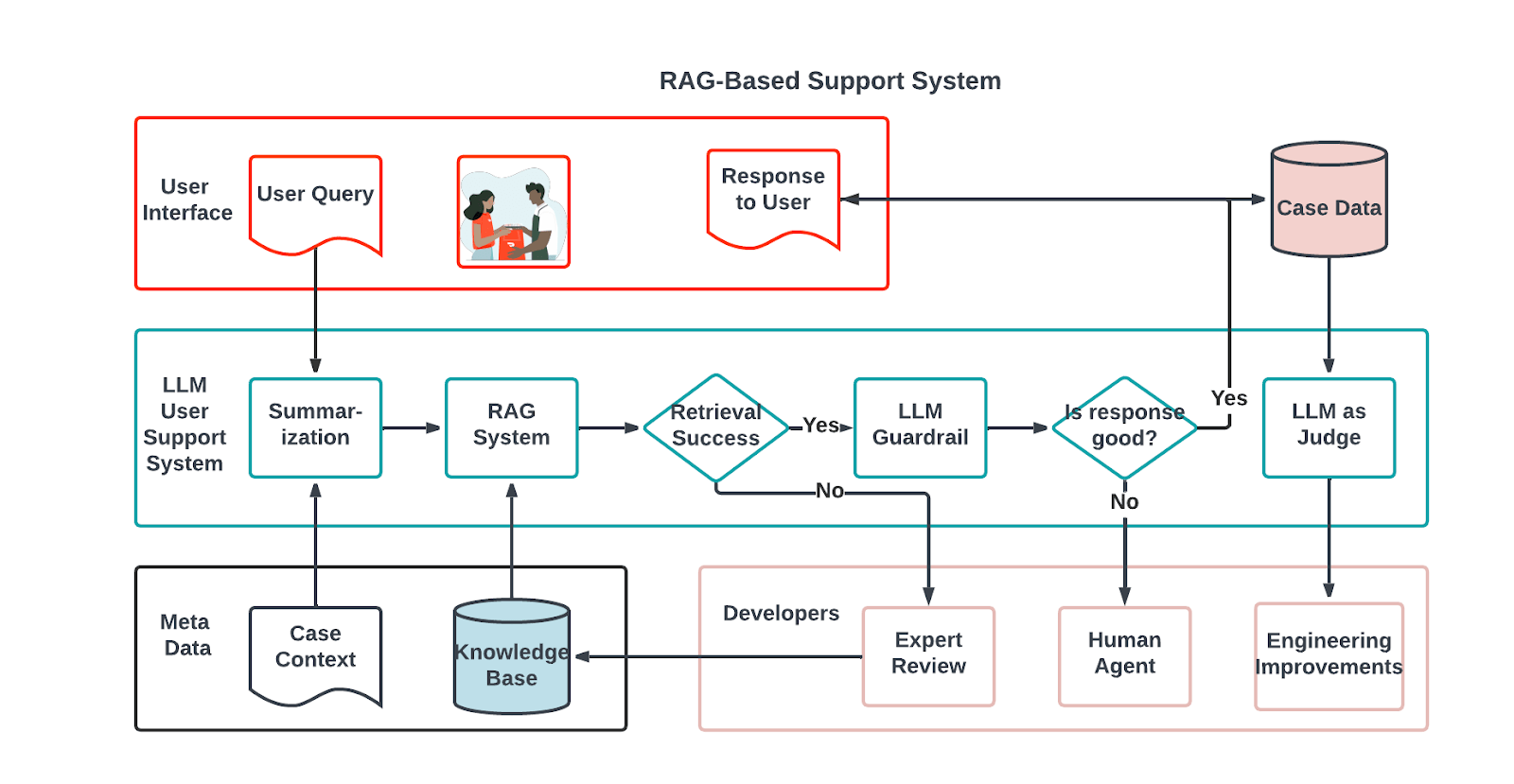

Компания DoorDash, занимающаяся доставкой еды, повышает эффективность службы поддержки с помощью чат-бота, основанного на RAG. Внутреннее решение DoorDash сочетает три ключевых компонента: систему RAG, LLM Guardrail и LLM Judge.

Когда «Dasher» (независимый подрядчик DoorDash) сообщает о проблеме, система сначала сжимает диалог, чтобы точно определить суть вопроса. Используя это краткое изложение, система ищет релевантные статьи и прошлые решённые кейсы в базе знаний. Найденная информация передаётся LLM, который формирует связный и уместный ответ на запрос Dasher’а.

Чтобы поддерживать высокое качество ответов, DoorDash внедрила LLM Guardrail — онлайн-инструмент для мониторинга, который проверяет каждое сгенерированное моделью сообщение на точность и соответствие правилам компании. Он предотвращает «галлюцинации» модели и фильтрует ответы, противоречащие внутренним нормам.

Для постоянной оценки уровня работы чат-бота DoorDash использует LLM Judge, который анализирует качество взаимодействия по пяти метрикам: корректность поиска информации, точность ответа, грамматическая правильность и стилистика, логическая согласованность и релевантность запросу Dasher’а.

Техническая поддержка клиентов в LinkedIn

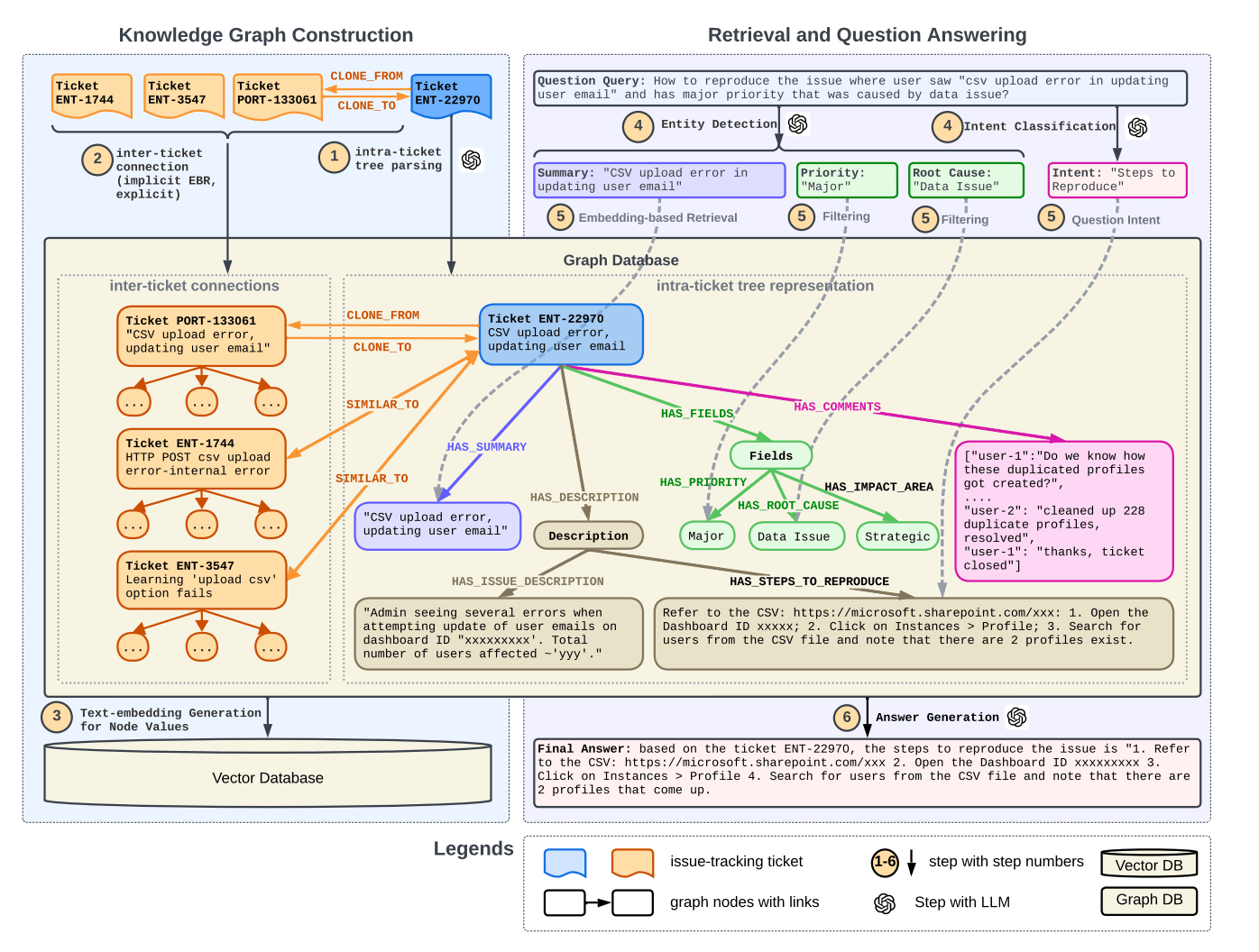

Онлайн-платформа LinkedIn внедрила новую методику ответов на запросы службы поддержки, объединяющую RAG и граф знаний.

Вместо того чтобы обращаться к прошлым тикетам как к простому тексту, система строит на их основе граф знаний, учитывая внутреннюю структуру каждого тикета и связи между ними. Когда пользователь задаёт вопрос, система разбирает его запрос и извлекает нужные фрагменты графа знаний, формируя ответ. Такой подход уменьшает разрозненность информации и повышает качество поиска.

Внутри службы поддержки LinkedIn эта технология уже внедрена и сократила медианное время решения каждого запроса на 28,6%.

Чат-бот для внутренних политик от Bell

Телекоммуникационная компания Bell применила RAG, чтобы улучшить систему управления знаниями и дать сотрудникам доступ к актуальным корпоративным политикам.

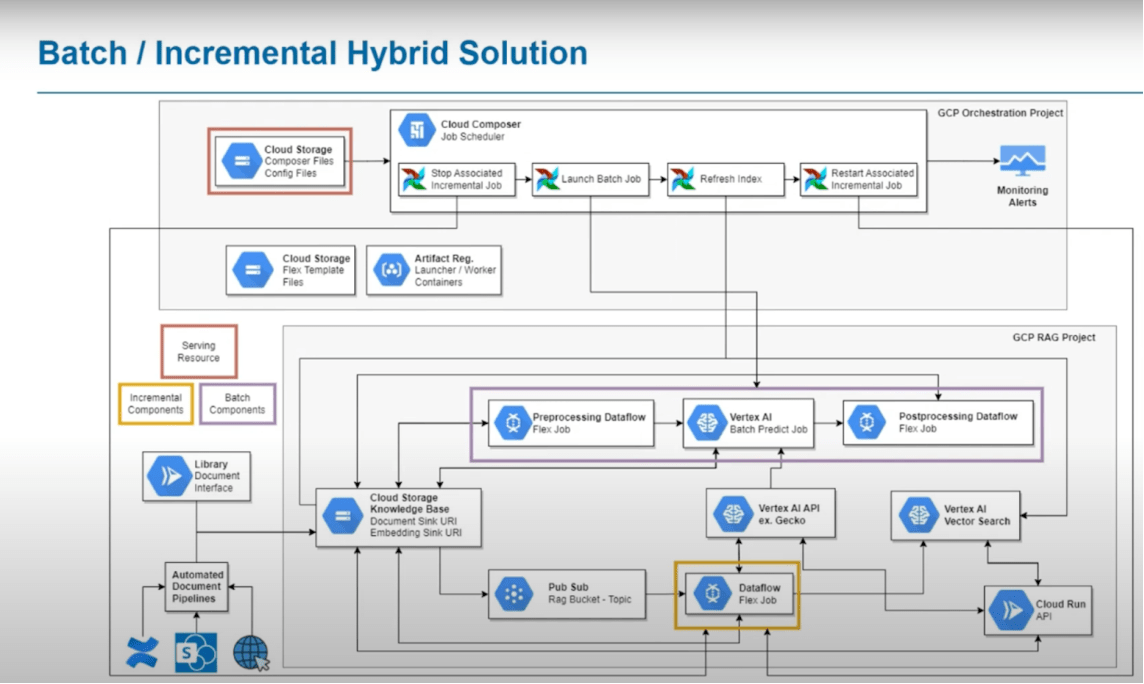

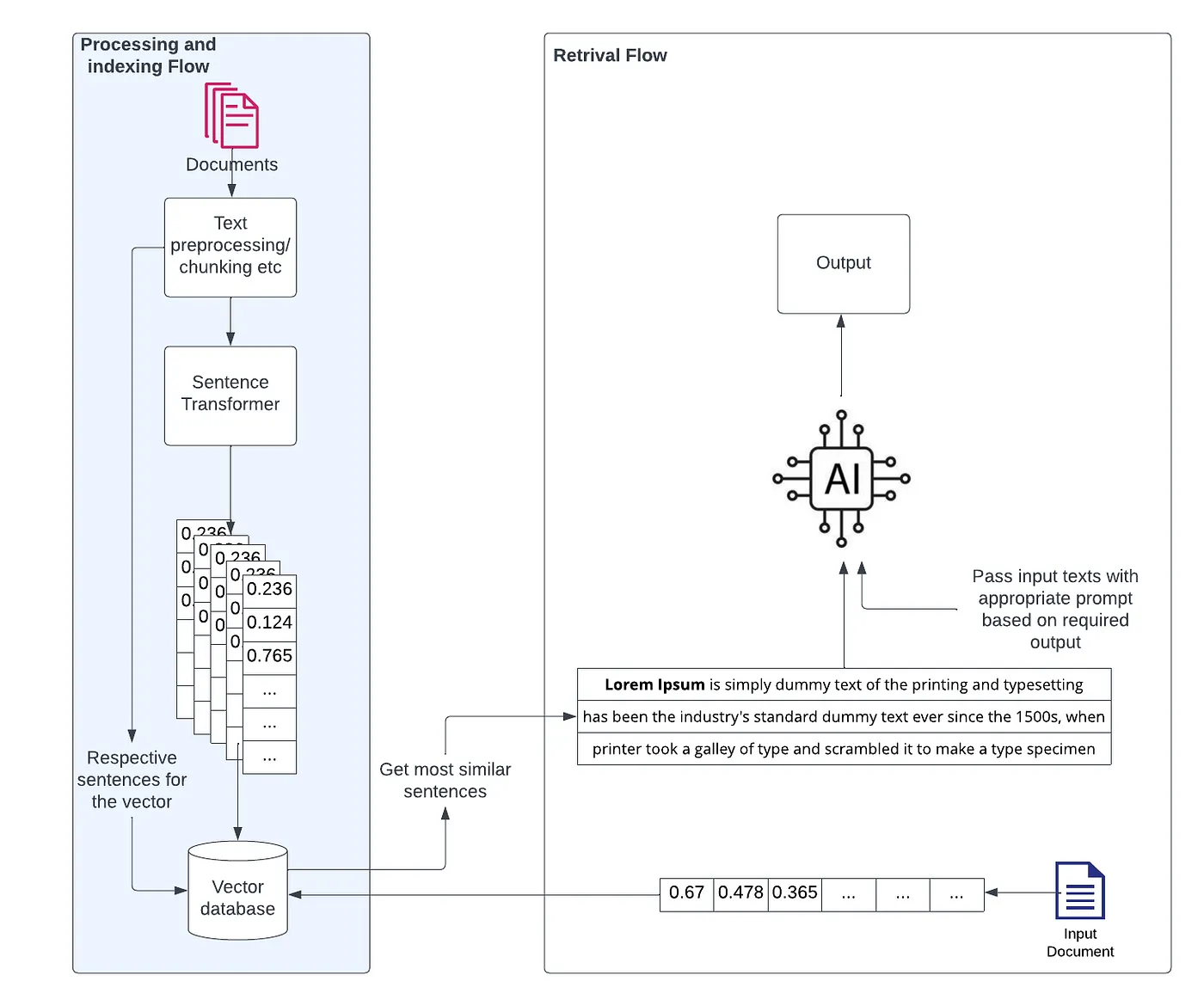

Компания поделилась решением, основанным на модульных пайплайнах обработки и векторизации документов. Такой подход позволяет эффективно обрабатывать и индексировать «сырой» контент из разных источников. Система поддерживает пакетное и пошаговое обновление базы знаний и автоматически пересобирает индексы, когда документы добавляются или удаляются в источниках.

Bell рассматривает каждый компонент как самостоятельный сервис и применяет принципы DevOps для сопровождения и обновления этого решения.

«Профессор» на базе ИИ

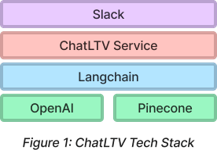

Старший лектор Гарвардской школы бизнеса Джеффри Бассанг создал чат-бот ChatLTV с использованием RAG, чтобы помогать ему в преподавании курса по предпринимательству. Студенты могут воспользоваться ботом для уточнения сложных тем, поиска дополнительной информации по кейсам и решения административных вопросов.

ChatLTV обучен на материале курса, включая тематические исследования, методические указания, книги, записи в блогах и архивные вопросы и ответы из Slack-канала. Чат-бот интегрирован в Slack, где у студентов есть возможность вести с ним как личные, так и публичные диалоги.

Чтобы бот ответил на вопрос, ему передают сам запрос и наиболее релевантный контекст, извлечённый из векторной базы данных. Самые подходящие фрагменты передаются в LLM через OpenAI API. Для проверки точности ChatLTV создатели смешивают ручное и автоматическое тестирование. В том числе используют LLM judge, который сопоставляет ответы с эталонными данными и выставляет оценку качества.

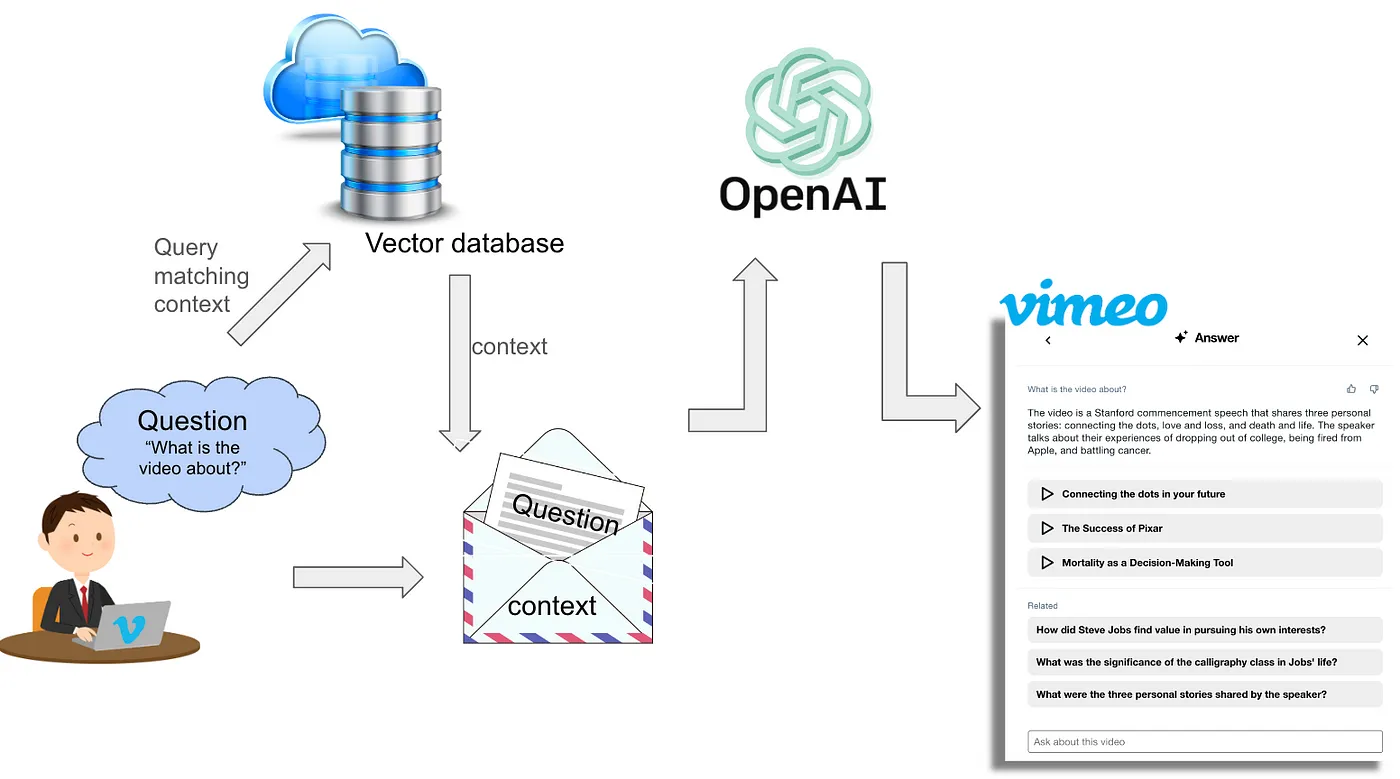

Видео-саммари от Vimeo

Платформа Vimeo даёт пользователям возможность «разговаривать» с видеороликами. Компания создала чат-бот на основе RAG, способный кратко излагать содержание видео, указывать на ключевые моменты и предлагать дополнительные вопросы.

Первый шаг — превращение видео в текст. Транскрипт обрабатывается и сохраняется в векторной базе данных. Vimeo применяет послойную стратегию: они используют разные размеры окон контекста, затем суммируют большие отрывки и формируют описание всего ролика.

Когда пользователь задаёт вопрос, например «О чём это видео?», система находит в базе данных подходящий контекст и передаёт его LLM для генерации ответа. Вместе с самим ответом чат-бот предоставляет кликабельные таймкоды, позволяющие сразу воспроизводить соответствующие фрагменты видео.

Чтобы сделать общение более увлекательным, бот предлагает заранее составленные пары «вопрос-ответ» по ключевым моментам ролика и дополнительно связанные с запросом темы.

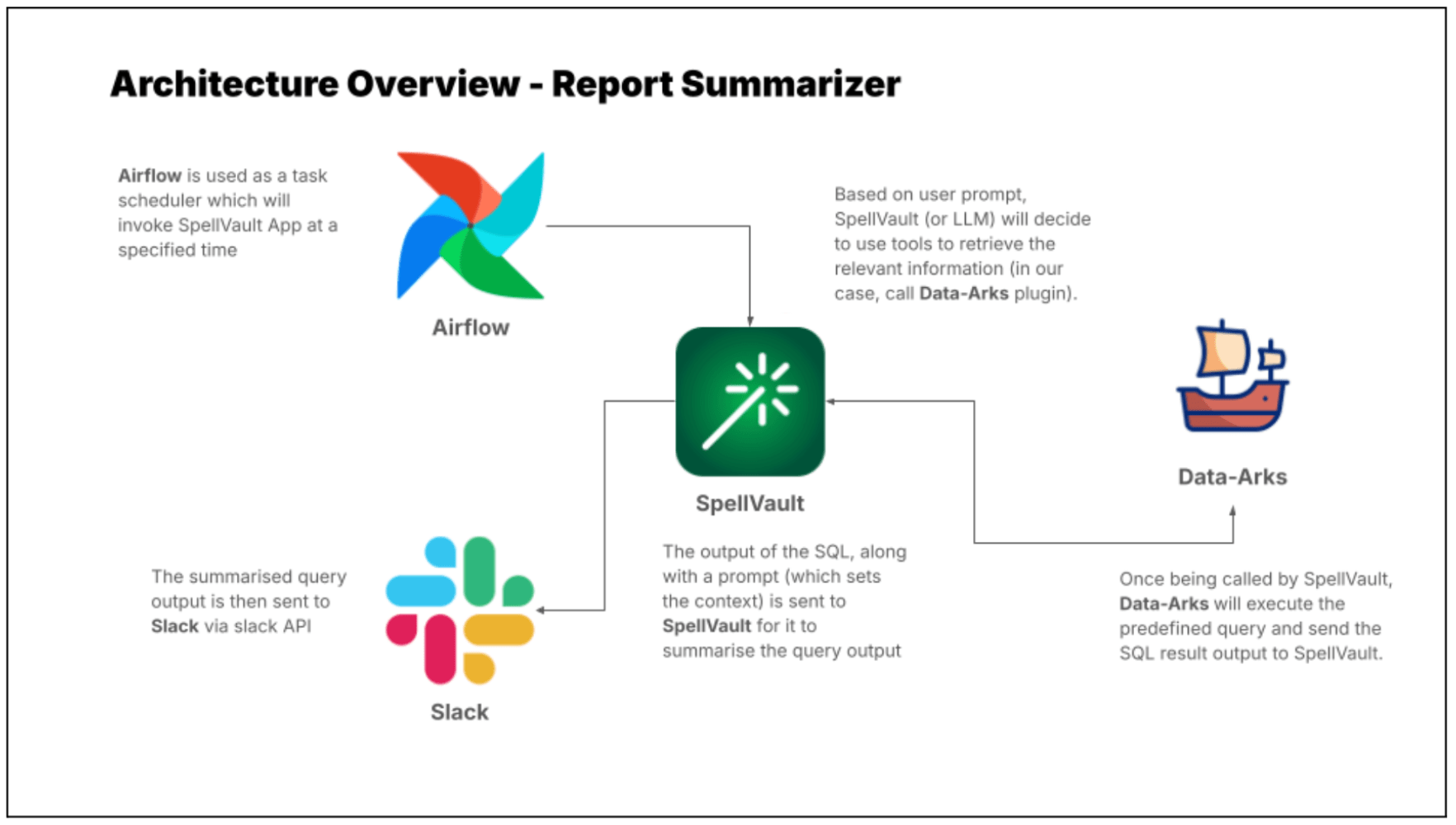

Аналитические отчёты о мошенничестве от Grab

Азиатский супер-апп Grab использует LLM с RAG, чтобы автоматизировать рутинные аналитические задачи — от генерации отчётов до расследований мошенничества.

Инструмент Grab’s Report Summarizer автоматически создаёт и кратко излагает регулярные отчёты, что существенно снижает долю ручной работы. Он объединяет несколько внутренних платформ:

– Data-Arks — Python-платформа с набором часто используемых SQL-запросов и Python-функций, упакованных в виде отдельных API.

– Spellvault — внутренняя система, где можно хранить, обмениваться и улучшать LLM-промпты.

Когда нужно подготовить отчёт, вызывается нужный API из Data-Arks, который возвращает необходимые данные. Затем эти данные обрабатываются через Spellvault, используя LLM для составления краткой сводки. Итоговый документ, включающий как данные, так и их обзор, доставляется пользователям в Slack. По словам компании, автоматическая генерация отчетов экономит от 3 до 4 часов на каждый.

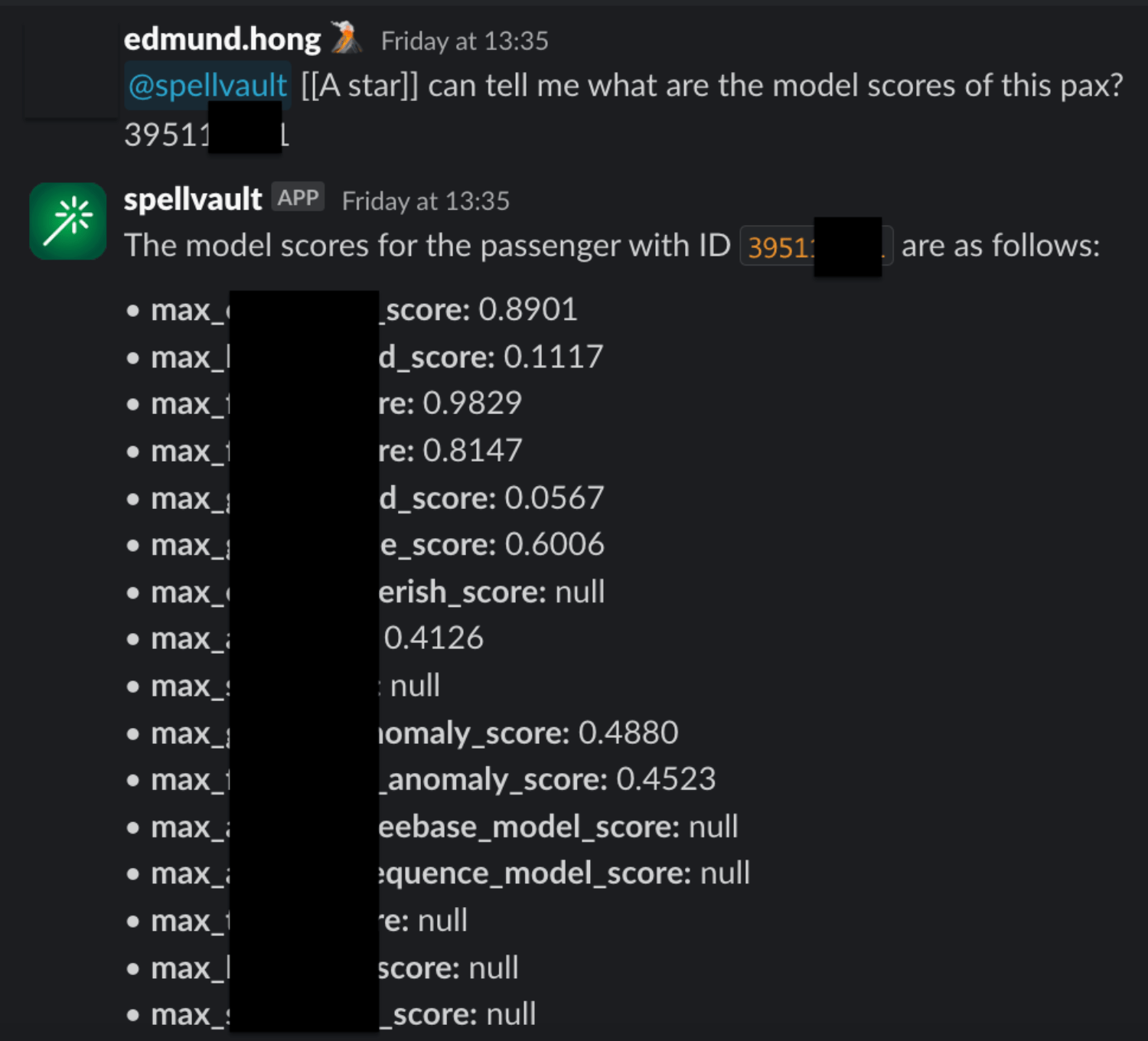

Grab также представила A* bot — ассистента на базе ИИ, упрощающего расследование мошенничества. Он использует набор стандартных запросов, собранных в виде Data-Arks API. Когда пользователь задаёт вопрос, система с помощью RAG выбирает наиболее подходящие запросы, выполняет их и кратко выводит результаты в Slack. Пример ответа A* bot выглядит так:

Возможности RAG позволяют сотрудникам разных подразделений самостоятельно находить интерпретируемые результаты для любого запроса к данным.

VIP-поддержка клиентов от Thomson Reuters

Поставщик бизнес-информации и технологий Thomson Reuters применяет RAG, чтобы улучшить обслуживание клиентов. Разработанная ими система помогает специалистам службы поддержки быстро находить наиболее подходящую информацию в базе данных и вести при этом «живой» диалог.

Система использует векторные представления (embeddings), чтобы искать в внутренних хранилищах самые подходящие документы. Для этого текст разбивается на небольшие фрагменты, которые векторизируются и сохраняются в векторной базе данных. Вопрос пользователя тоже конвертируется в вектор и сопоставляется с базой, чтобы найти лучшие совпадения.

Затем извлечённые документы обрабатываются моделью seq-to-seq, формирующей структурированный и точный ответ. Ответ опирается на найденные данные, что повышает точность и снижает вероятность вымышленных подробностей.

Таким образом Thomson Reuters обеспечивает операторов актуальными и достоверными ответами, сохраняя при этом естественную форму общения.

RAG для работы с таблицами данных от Pinterest

Платформа Pinterest помогает сотрудникам, работающим с аналитикой, составлять SQL-запросы для решения различных задач.

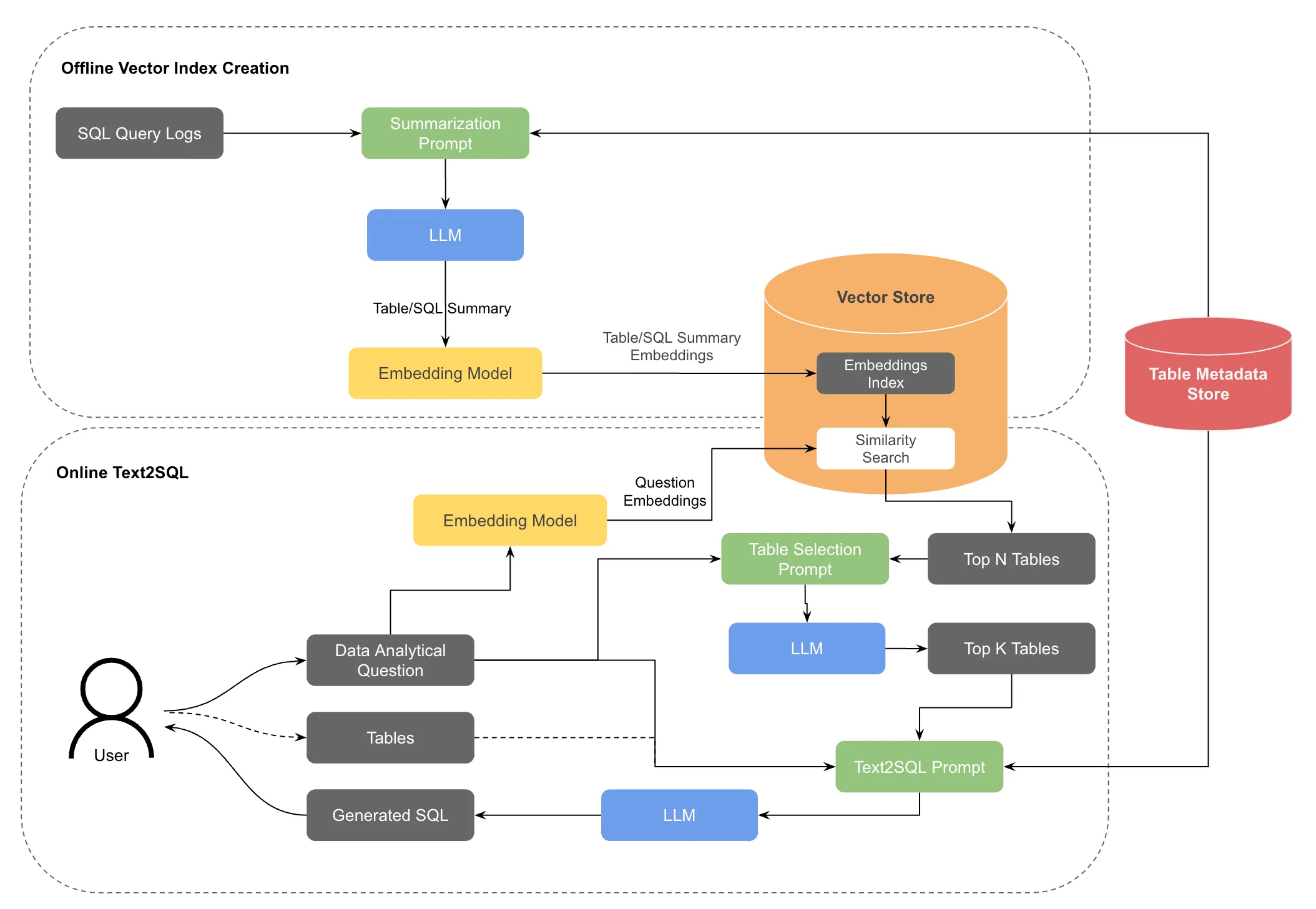

Изначально пользователь задавал вопрос и выбирал необходимые таблицы. Эта информация конвертировалась в промпт формата «текст–SQL» и обрабатывалась LLM. Результат был неплохим, но оказалось, что выбор правильных таблиц пользователями — сложная задача.

Чтобы её упростить, Pinterest интегрировала RAG, помогающий подбирать нужные таблицы. Система генерирует векторный индекс описаний таблиц, а пользовательский запрос переводит в вектор. По результатам поиска сходных векторов выбираются наиболее подходящие таблицы, и LLM уточняет из них самые релевантные. После этого формируется финальный промпт «текст–SQL», и модель генерирует SQL-запрос.

Улучшенная отраслевая классификация от Ramp

Финтех-компания Ramp использовала RAG, чтобы классифицировать своих клиентов по более стандартизированной системе.

Сначала они полагались на собственную, разнородную классификацию: данные от сторонних поставщиков, сведения от отдела продаж и от самих клиентов. Это вносило неоднородность и усложняло аудит и анализ информации.

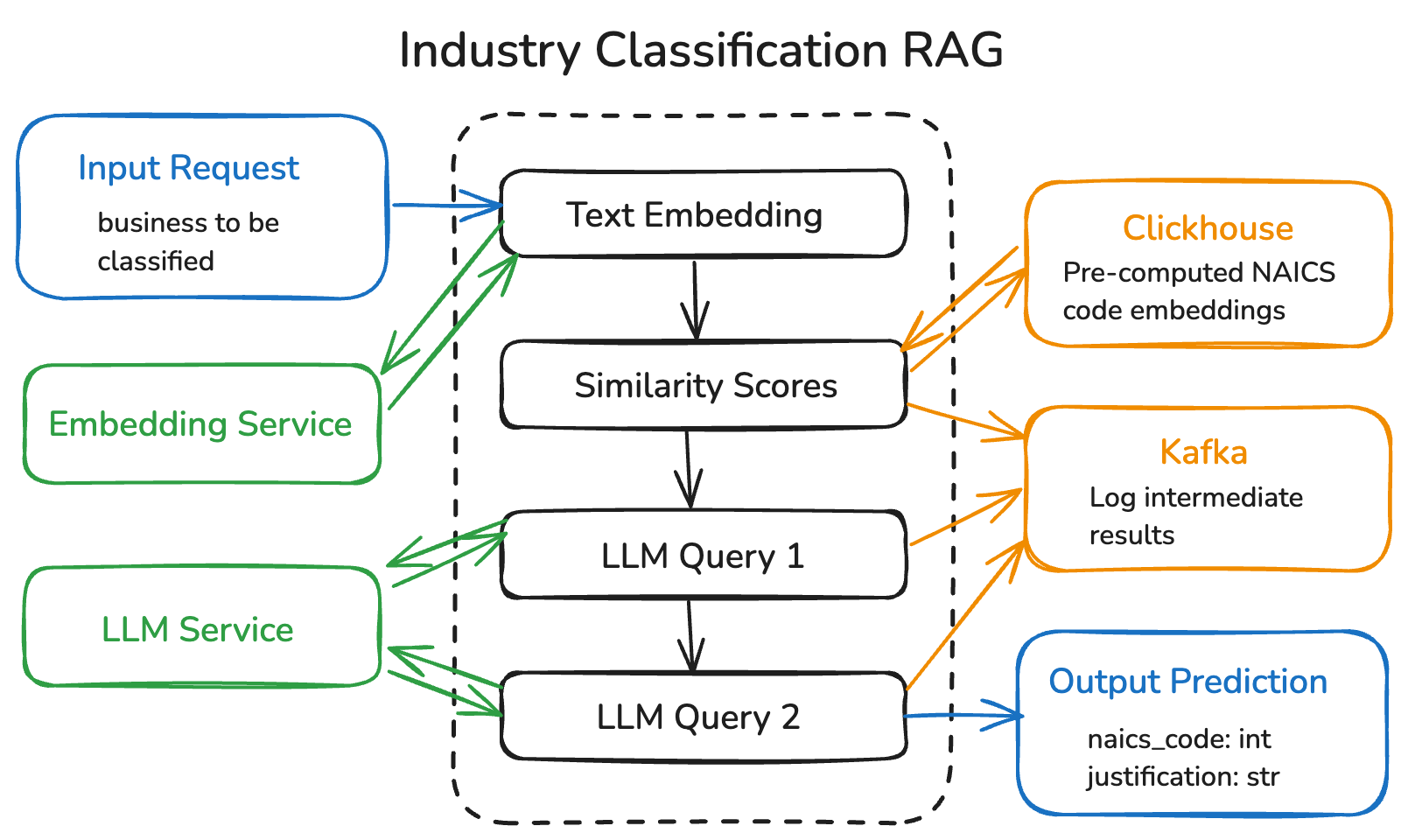

В итоге Ramp разработала систему на базе RAG, которая помогает перейти к единому стандарту — Североамериканской системе отраслевой классификации (NAICS). Основной принцип таков:

– Сначала информация о бизнесе клиента переводится во векторное представление, позволяющее улавливать смысловой контекст.

– Эти векторы сверяются с базой кодов NAICS, чтобы найти самые близкие варианты.

– Рекомендуемые коды передаются в LLM, который формирует финальное решение.

Ramp задействует внутренние сервисы для генерации эмбеддингов и оценки промптов, базу Clickhouse для вычисления сходств и Kafka для записи промежуточных результатов. Дополнительно компания установила «ограничители», чтобы быть уверенной, что финальные выводы представляют собой корректные NAICS-коды.

Поиск внутренних политик в Королевском банке Канады (RBC)

Королевский банк Канады (RBC) создал систему Arcane на основе RAG, которая помогает специалистам банка быстро находить нужные внутренние регламенты среди множества документов. Финансовые операции сложны, и сотрудникам требуются годы, чтобы досконально изучить все внутренние протоколы, поэтому быстрый поиск нужной информации повышает эффективность и качество обслуживания клиентов.

Выглядит это так: специалист формирует вопрос в чат-боте, а система сканирует внутренние базы данных и извлекает полезные сведения из документов, предоставляя сжатое изложение с указанием источников.

Одной из основных задач RBC при разработке Arcane стало правильно парсить и разбивать данные на фрагменты. Информация оказалась рассеяна по многочисленным платформам, внутренним хранилищам, PDF-файлам и таблицам Excel, что усложняло её поиск и извлечение. Тем не менее, эффективная реализация RAG помогла банкам объединить разрозненные ресурсы и повысить продуктивность сотрудников.

Автор: technokratiya