Вот и прошла Google I/O 2025. Не будем ходить вокруг да около — знаем, как вам не терпится узнать обо всех горячих новинках. Вместе с Surf Android Team проанализируем ожидания от Google I/O 2025 Keynote, сравним их с реальностью и расскажем о своих впечатлениях от увиденного. Го погружаться!

Наша любимая Google I/O ежегодно задаёт технологические тренды, которые определяют вектор развития экосистемы Google. И вчерашнее выступление не стало исключением — все ждали Google Keynote — на фоне бурного развития ИИ и новых аппаратных инициатив компании и отсутствия слухов о грядущих анонсах этот запуск был едва ли не самым интригующим.

Перед Keynote сформировался вполне чёткие ожидания: от прорывных анонсов в области искусственного интеллекта и новых возможностей Gemini, до обновлений Android и первой демонстрации платформы Android XR. Но сможет ли Google не просто тыкнуть пальчиком в направление, но представить реальные шаги к будущему, которым правит ИИ?

Чего мы ждали от Google I/O 2025 Keynote

Сумасшедший ажиотаж вокруг ИИ и конкуренция в сфере аппаратного обеспечения заставили Google обратить на них своё внимание. Так к чему же были прикованы все взгляды?

Gemini и экосистема в целом

Все мы ждали, когда Google превратит семейство моделей Gemini из фантастических исследовательских проектов в полезные инструменты. И нам было интересно, последуют ли они примеру Microsoft, которая плотно интегрировала ИИ в новую версию Windows.

-

Интеграция Gemini

Все ждали активного внедрения ИИ во флагманские продукты Google: Поиск, Gmail, Google Docs, да и вообще всю экосистему Workspace. Хотелось увидеть новые возможности, которые автоматизировали бы рутинные задачи и предлагали иные сценарии взаимодействия.

-

Инструменты для разработчиков

Тут ждали расширения Gemini API и SDK, более гибких и мощных инструментов для создания ИИ-приложений и демонстрацию возможностей Firebase Studio для ИИ-разработки.

-

ИИ в Android Studio

Ожидали, что Google улучшат ИИ-помощь в основной IDE для Android — это классно помогло бы ускорить кодирование, отладку и оптимизацию.

-

Мультимодальный ИИ и «умные» агенты

На фоне намёков на мультимодальные возможности Gemini, многие ожидали увидеть демонстрации продвинутых ИИ-агентов. Таких, которые не просто обрабатывают текст, но и понимают контекст, взаимодействуют с изображениями, видео и звуком.

Android XR — вперёд, в смешанную реальность

Слухи о скором выходе аппаратных решений Google для смешанной реальности накаляли атмосферу. А I/O 2025 — идеальная площадка для таких анонсов.

-

Первая полноценная демонстрация платформы

Тут всё просто — все ждали подробности про Android XR. Очень хотелось увидеть, как платформа работает в реальных сценариях и как пользователи будут взаимодействовать с цифровым контентом в физическом мире.

-

Инструменты для разработчиков XR

Ждали анонсы SDK, API и других инструментов, которые позволили бы создавать приложения для новой платформы.

-

Стратегия Google в XR

Интересно было понять долгосрочные планы Google в области смешанной реальности — что они планирует делать с этой технологией, возлагают ли на неё надежды, и когда мы уже увидим её массовое внедрение.

Облачные и веб-технологии

-

ИИ-сервисы в Google Cloud

В лист ожидания попали новые сервисы и улучшения существующих в Google Cloud — они пригодились бы для развертывания, масштабирования и управления ИИ-моделями в облаке для корпоративных клиентов.

-

Улучшения для веб-платформ

Нового Android мы, разумеется, не ждали, но было бы неплохо увидеть постепенные улучшения в веб-стандартах и инструментах для разработчиков. Особенно тех, которые касаются производительности и безопасности.

В общем, мы много чего ждали от Google I/O 2025 Keynote. Конечно, не обычных обновлений в духе «Мы все поправили, и стало лучше», а демонстрации видения компании, прогнозирования, взгляда в будущее, в конце концов. Но насколько реальность совпала с этими надеждами? Идём читать дальше.

Ожидание — реальность: ИИ и ИИ. И ещё раз ИИ

Главное выступление Google I/O 2025 стало очередной демонстрацией тотального фокуса компании на искусственном интеллекте. Практически каждый крупный анонс был связан с ИИ, подтверждая новую стратегию Google.

Gemini и ИИ: что показали на самом деле

Семейство моделей Gemini стало звездой большинства презентаций.

-

Gemini 2.5 с режимом Deep Think

Google анонсировали обновленную версию Gemini 2.5 с режимом Deep Think. Он нужен для более глубокого анализа сложных задач. Что говорит о стремлении Google к созданию более «думающих» и компетентных ИИ.

-

Специализированные модели Gemma

Компания представила специализированные модели Gemma: Gemma 3n, MedGemma, SignGemma. Они применяются в достаточно узких областях — здравоохранении (MedGemma) и переводе языка жестов (SignGemma) — и это подчеркивает стремление Google к созданию ИИ, адаптированного для конкретных, часто чувствительных, задач.

-

AI Mode в Google Поиске

Для всех пользователей в США развернут AI Mode в Google Поиске. Этот режим позволяет обрабатывать сложные, многосоставные запросы, генерировать графики на основе данных и отвечать на дополнительные вопросы, по сути, превращая Поиск в интерактивного ИИ-ассистента на базе Gemini 2.5.

-

ИИ для шопинга

Пользователи смогут виртуально примерять одежду по одной своей фотографии — и не надо идти в магазин — удобно, правда?

-

Project Astra: видение универсального помощника

Project Astra — концепция универсального ИИ-помощника, способного понимать и взаимодействовать с окружающим миром в реальном времени через камеру смартфона.

-

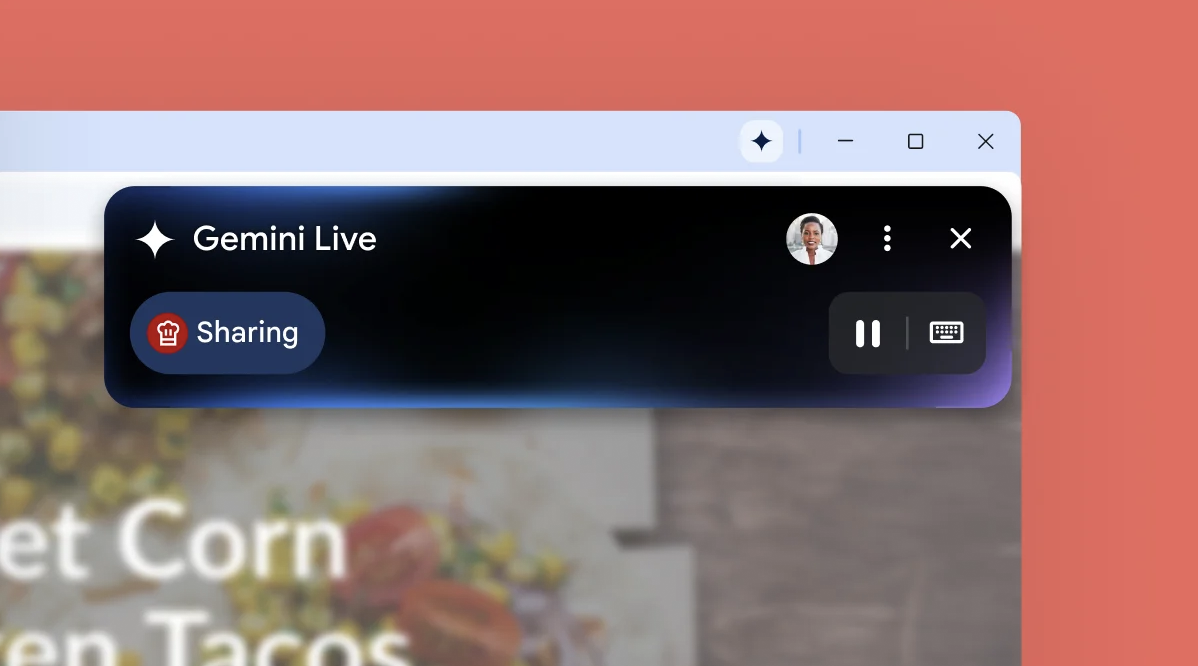

Gemini Live для всех

Доступный только на устройствах Pixel, Gemini Live расширили до всех совместимых устройств Android и iOS. Это позволяет пользователям задавать вопросы по скриншотам и видео с камеры в реальном времени.

-

Генерация медиаконтента нового поколения

-

Veo 3 — новая версия модели для генерации видео. Она способная генерировать видео со звуком, что является значительным шагом к реалистичности и погружению.

-

Imagen 4 — модель получила улучшения в фотореалистичности и детализации. Что особенно примечательно, она показала улучшенную способность работать с орфографией и типографикой внутри генерируемых изображений, что было проблемой для многих предыдущих моделей.

-

Flow — новый инструмент для создания видеоконтента на основе ИИ, который расширяет возможности VideoFX. Он может управлять движением камеры, редактирования и расширения существующих кадров.

-

Итак, мы видим доминирование ИИ. Google не просто показала новые модели, а продемонстрировала их интеграцию в ключевые продукты. В отличие от Microsoft, которая сфокусировалась на создании ИИ-компаньонов — Copilot — внутри операционной системы Windows, подход Google кажется шире. Он охватывает интеграцию Gemini и в сервисы — от поиска до Gmail, и в кроссплатформенные решения, включая iOS (как в случае с Gemini Live).

А Project Astra и возможности генерации медиаконтента подтверждают, что Google стремится сделать ИИ активным помощником, который всегда с вами. К тому же, способным к персонализации на основе пользовательских данных.

И всё бы хорошо, но после таких заявлений очень ярко встаёт вопрос приватности и безопасности персональных данных. Если ИИ действительно «знает о нас всё», Google придётся очень сильно постараться обеспечить комфортную конфиденциальность и контроль над информацией.

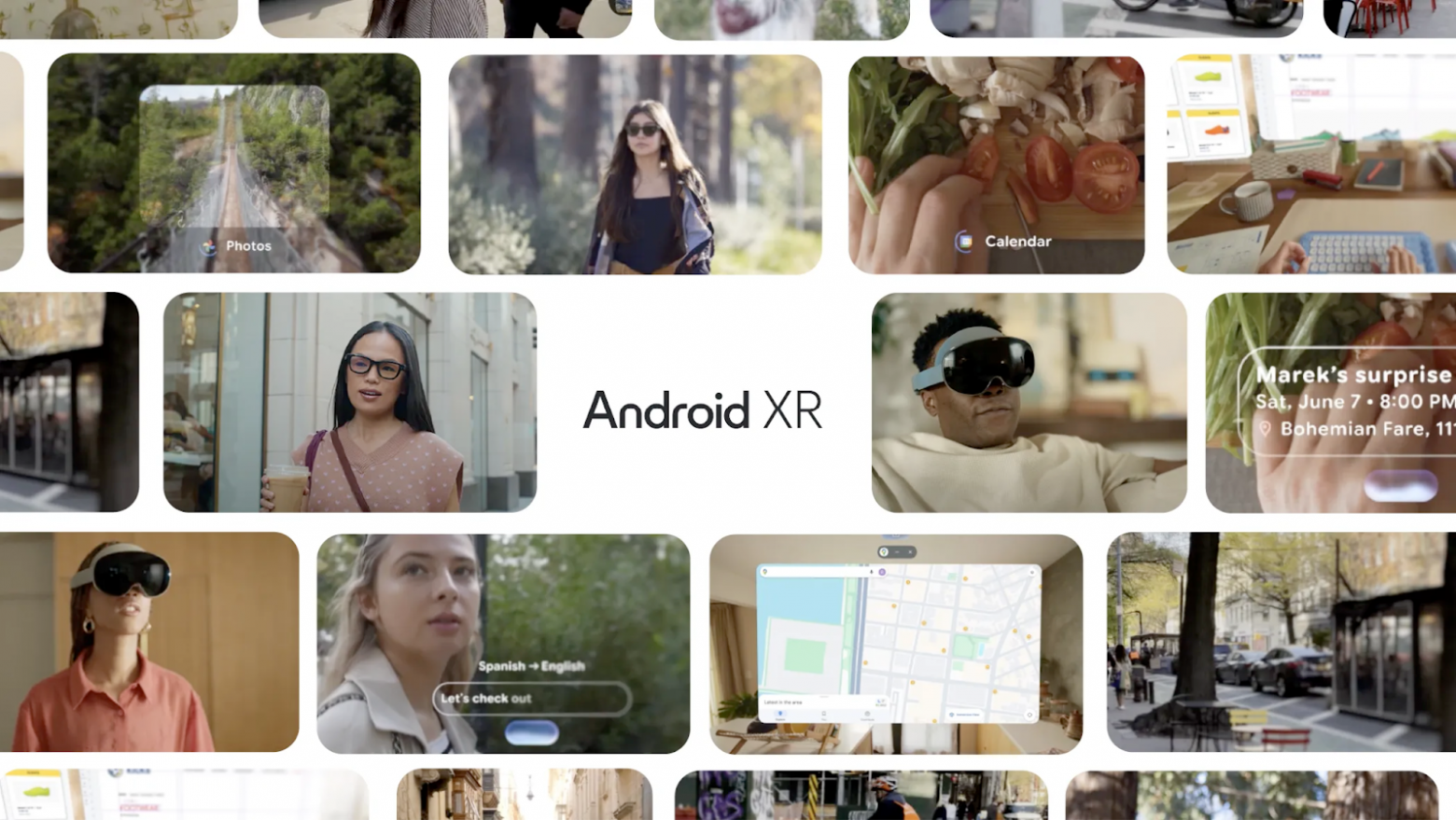

Android XR: Первые устройства и развитие платформы

Вот он — «One more thing» от Google: Android XR. И хотя многие ждали анонса собственного устройства смешанной реальности, Google преподнесла нечто большее и, возможно, гораздо более дальновидное, чем мы предполагали.

-

Android XR Glasses

В отличие от громоздкой и дорогой Apple Vision Pro, которая позиционируется как компьютер для лица, подход Google оказался совершенно иным — ориентированным на повседневность.

-

Project Moohan от Samsung — всё серьёзно

В рамках Android XR представили гарнитуру Samsung Project Moohan, созданную, кстати, в тесном сотрудничестве с Qualcomm. Это устройство позиционируется как конкурент Vision Pro, обещая быть более лёгким — чтобы шея не просила пощады через полчаса ношения — и удобным. Обещают запустить чуть «позже в этом году».

-

Project Aura от Xreal

Второе официальное устройство на Android XR, что подтверждает расширение аппаратной экосистемы за счёт сторонних производителей, которые готовы работать в рамках нового видения Google.

Тут Google не просто оправдала, а превзошла ожидания. Project Moohan и акцент на компактных и стильных «умных» очках кажутся неплохой попыткой избавиться от недостатков Google Glass и воплотить концепцию «носимой» электроники.

Так что вектор развития Android XR выглядит гораздо более перспективным для массового рынка по сравнению с текущими предложениями.

Новые инструменты для разработчиков: от Gemini SDK до Google Beam

Для разработчиков Google представила новые и улучшенные инструменты, которые помогут облегчить работу с ИИ и новыми технологиями.

-

Gemini SDK с Model Context Protocol (MCP)

Поддержка MCP упростит использование open-source инструментов и расширит возможности работы с Gemini.

-

ML Kit GenAI API

Новые API, использующие Gemini Nano для выполнения ИИ-задач непосредственно на устройстве.

-

Gemini Code Assist

Инструмент для помощи в кодировании на базе Gemini 2.5 теперь доступен для использования. Обещают ускорить процесс разработки — вот и проверим.

-

Google Beam (бывший Project Starline)

Платформа для 3D-видеосвязи, которая использует ИИ для превращения стандартных 2D-потоков в иммерсивные видеозвонки, создавая ощущение присутствия.

В этом блоке — как платформа для ИИ-разработки — Google укрепила свои позиции. Анонсированные инструменты, особенно расширения Gemini SDK и Gemini Code Assist, помогут более просто и эффективно воспользоваться возможностям ИИ.

Другие важные анонсы

-

Google Meet получил функцию перевода речи в реальном времени. Больше не нужно судорожно искать слова в переводчике на переговорах с иностранными клиентами.

-

AI Ultra — премиум-план подписки с расширенным доступом к самым мощным ИИ-моделям Google.

-

SynthID Detector — портал для идентификации контента, сгенерированного ИИ. Отличный шаг к повышению прозрачности и борьбы с дезинформацией.

Эти «маленькие» анонсы тоже показывают, что Google стремится внедрить ИИ в максимальное число своих продуктов.

Первые впечатления: а что мы думаем на этот счёт?

Итак, занавес Google I/O 2025 Keynote опустился. Насколько амбиции Google совпали с реальностью? Было ли это действительно «будущее уже здесь», или, скорее, «мы с ИИ ходим парой»?

ИИ, ИИ, кругом ИИ

Наши ожидания тотального господства ИИ оправдались. Мы получили не просто много ИИ — это была буквально лавина. Gemini 2.5 с Deep Think, Gemma, AI Mode в Поиске, Project Astra, генерация медиаконтента — выглядит мощно.

Я должен был быть антагонистом этой встречи, но Google сделали сильный ход. Особенно поразило, сколько контекста удерживает модель и как качественно она с ним работает. Плюс — продуманная интеграция ИИ во все сервисы.

Кирилл Давыдов, iOS Team Lead в Surf

Но истинная ли это революция или просто агрессивная ИИ-маскировка существующих сервисов? Если Microsoft строит Copilot как центральную сущность ОС, Google вставляет Gemini буквально везде. Да, это делает ИИ вездесущим, но не всегда ясно, как изменится опыт пользователя — да и изменится ли? А если вспомнить о суперперсонализации, о которой так много говорили, то встаёт вопрос: если ИИ «знает о нас всё», что насчёт приватности?

Самое ценное для меня — персонализация. Хочется, чтобы ассистент общался со мной как с другом и понимал с полуслова. А ещё — очки. Перевод реализован на уровне. Можно спокойно путешествовать без знания языка и понимать окружающих.

Лёша Сарайкин, Android-разработчик в Surf

Носи очки — будь модным

Google преподнесла не тот one more thing в виде собственной гарнитуры, а скорее one more approach. Вместо прямой конкуренции с Apple Vision Pro, Google сфокусировалась на очках, которые можно носить повседневно.

И эти очки смогут стать тем прорывом, которым не смогли стать Google Glass. Переход от нишевого гаджета к незаметной, стильной электронике, которую действительно захочется носить каждый день. Особенно, если они будут от известных дизайнерских брендов.

Больше всего впечатлила работа с голосом — звучит как настоящая речь, а не синтез. И, конечно, очки. Приятно видеть, как Google Glass возвращаются — пусть и в новом виде. Как пользователь подобных очков от XReal, очень жду момента, когда ими можно будет пользоваться вне дома. И когда они станут привычным повседневным устройством, как умные часы или смартфон.

Лёша Рябков, Android Team Lead в Surf

Инструменты для разработчиков

Gemini SDK, ML Kit GenAI API, Gemini Code Assist подарят новые возможности. Они призваны упростить интеграцию ИИ.

Однако возникает вопрос: действительно ли это упростит жизнь разработчикам или только сильнее привяжет его к экосистеме Google? Скоро узнаем, станут ли эти инструменты настоящим благом или новой «золотой клеткой».

Google I/O 2025 Keynote однозначно показал нам будущее. И, по версии Google, это будущее, управляемое ИИ.

Реальность, в целом, совпала с нашими ожиданиями, а в некоторых моментах даже превзошла. Устройства на Android XR выглядят невероятно круто, и мы искренне надеемся, что благодаря интеграции ИИ они станут чем-то новым, свежим и гораздо более прикладным к реальным задачам, чем всё, что мы видели до сих пор.

Кейсы и лучшие практики в области системной и бизнес-аналитики, новости, вакансии и стажировки Surf — в телеграм-канале Surf Tech.

Автор: Surf_Studio