Крупное обновление в моем курсе Разработка LLM с нуля.

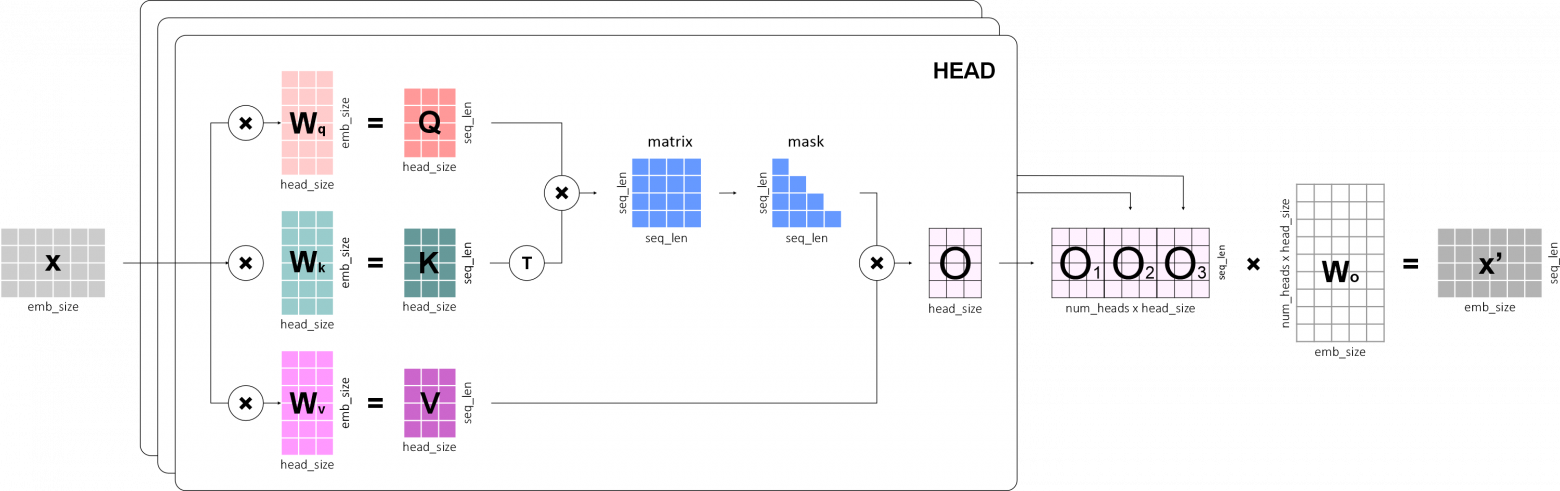

Напомню, в курсе мы с нуля разрабатываем модель GPT-1 и все необходимые для ее работы компоненты: токенизатор, эмбединги, механизм внимания и т.д. Вся разработка ведется на Python и низкоуровневых компонентах PyTorch.

Теперь, помимо GPT-1, нам предстоит реализовать кучу новых LLM:

-

GPT-2

-

Llama

-

Mistral

-

Mixtral

-

Gemma

В процессе их разработки мы изучим новые архитектурные фишки:

-

Pre-norm, RMSNorm — новые способы нормализации

-

GELU, SiLU, SwiGLU, GeGLU — новые функции активации

-

KV-cache, SWA — механизмы, позволяющие оптимизировать инференс

-

RoPE — новый способ кодирования позиционных эмбедингов

-

GQA, MQA — новые экономичные механизмы внимания

-

MoE — новая экономичная архитектура для FNN

Курс платный. Следующие две недели по промокоду TRIO предоставляется скидка 30%.

Мои курсы: Разработка LLM с нуля | Алгоритмы Машинного обучения с нуля

Автор: slivka_83