Начнем с боли, знакомой каждому. У любой уважающей себя компании есть своя цифровая «антресоль» — растущая гора DOCX-документов, неструктурированные PDF-файлы, раздувшийся Confluence и километры переписки в почтовых ящиках. Найти там что-то часто попросту невозможно. И тут на сцену выходят LLM и RAG-системы.

Retrieval-Augmented Generation — это технология, которая обещает превратить информационную свалку в упорядоченную библиотеку. Идея простая: даем мощному ИИ доступ к корпоративным знаниям, а поисковик в нужный момент находит релевантный документ и подает его модели. Должен получиться идеальный корпоративный ассистент, который знает все о продуктах, помнит каждую инструкцию и отвечает клиентам мгновенно и без ошибок.

Но есть загвоздка. Что если этот умный помощник, вдруг начнет галлюцинировать?

Мы с командой решили устроить тест пяти RAG-системам на реальных данных. От корпоративных платформ до open-source решений — AutoFAQ Xplain, Yandex, AnythingLLM, Witsy и Onyx. Мы заставили их работать с неудобными форматами, включая отсканированные PDF и устроили слепой экзамен на точность ответов. В роли экзаменаторов выступили два независимых эксперта и две нейросети-оценщика.

В этой статье расскажем:

-

Кто наши испытуемые и чем они отличаются под капотом.

-

Как мы построили полосу препятствий из типичных корпоративных документов.

-

Кто споткнулся уже на этапе подключения к данным.

-

И главное — кто оказался самым точным и стабильным.

Результаты вас удивят. Также будет ссылка на GitHub — вы сможете повторить наш эксперимент.

Знакомьтесь, наши олимпийцы: 5 RAG-систем на арене

Прежде чем начать испытания на реальных данных, представим наших участников публике. Мы специально выбрали RAG-системы из разных лиг: от коммерческих платформ до open-source решений, которые порой требуют ритуальных «танцев с бубном» для запуска.

AutoFAQ Xplain — корпоративный атлет

Наш первый герой — наш собственный продукт, который мы выпустили на рынок в 2023 году. AutoFAQ Xplain — это коммерческая платформа уровня enterprise. Ее можно использовать как облачный сервис или развернуть полностью on-premise, у себя на сервере. Это ценят в крупных компаниях.

Под капотом все серьезно: поддержка разных источников данных, готовые интеграции с мессенджерами и веб-виджетами, инструменты для управления правами доступа. Это наш претендент на звание самого системного и подготовленного участника соревнований.

Мы взяли в тест своего олимпийца, так как хотели проверить его атлетизм в честном соревновании с конкурентами и сделали всё для того, чтобы условия были для всех равны, а судейские решения независимы.

Нейроэксперт — проворный спринтер

На противоположной стороне арены — Нейроэксперт от Яндекса. Интуитивно понятный, бесплатный веб-инструмент, который не требует установки и запускается в один клик в браузере.

Его философия — максимальная простота для личного использования. Как швейцарский нож среди RAG-систем: удобен для быстрых задач, чтобы попробовать технологию и проверить гипотезы на своих документах, но решать на его базе корпоративные задачи — все равно что пытаться построить дом одним мультитулом.

AnythingLLM и Witsy — независимые энтузиасты

Эта пара спортсменов из мира open-source с общей идеологией. И AnythingLLM, и Witsy — десктопные приложения, которые устанавливаются на компьютер. Их главный козырь — гибкость и возможность «поиграться» с технологией на локальном уровне. Witsy, например, поддерживает локальные модели и эмбеддеры через популярный фреймворк Ollama.

Это классические конструкторы: в умелых руках можно собрать что-то интересное для личных проектов. Но для использования в компании их придется серьезно дорабатывать и поддерживать, то есть, самостоятельно делать из хобби-проекта рабочий инструмент.

Onyx — мощный, но строптивый

Последний участник — еще один представитель open-source, но с прицелом на корпоративный уровень. Onyx — это полноценная веб-система, которая разворачивается через Docker. В ней есть функции управления пользователями, настройки доступов и совместной работы.

Потенциально это мощный инструмент, который можно настроить под свои нужды, но его освоение — задача, требующая серьезных DevOps-компетенций и готовности к сюрпризам. Это выбор для тех, кто готов засучить рукава.

Полоса препятствий: на чем мы проводили тесты

Итак, наши олимпийцы на арене, и зрители замерли в ожидании. Но чтобы соревнование было честным, нужна по-настоящему сложная полоса препятствий.

Бессмысленно тестировать RAG-системы на идеально структурированных текстовых файлах, в реальном мире таких почти не бывает. Поэтому мы создали одинаковый набор испытаний для всех участников, который имитирует тот зоопарк форматов, с которым сталкиваешься на работе.

Вот наш набор спортивных снарядов:

-

DOCX-документ: классика жанра — фрагмент увесистой технической документации. Базовое упражнение, с которым должны справиться все. Провалить его, значит расписаться в полной непригодности.

-

Сканированный PDF: задачка со звездочкой. Мы взяли документ, отсканировали и сохранили как набор картинок. Это ночной кошмар многих систем, потому что здесь нужно оптическое распознавание символов (OCR). Если OCR-движок слабый, файл превращается в набор бессмысленных изображений, а ведь именно так часто хранятся старые инструкции, договоры и архивные документы.

-

База знаний в Confluence: святая святых большинства IT-компаний. Динамичная среда со своей структурой, таблицами, вложенными страницами и правами доступа. Мы проверяли, сможет ли система не просто подключиться к Confluence, но и эффективно извлекать знания из корпоративного wiki.

-

Публичный веб-сайт: типичный источник данных для клиентского ассистента. Здесь проверяется способность системы обходить сайт, корректно извлекать контент из HTML, игнорируя баннеры, меню и визуальный мусор, а затем превращать его в базу знаний.

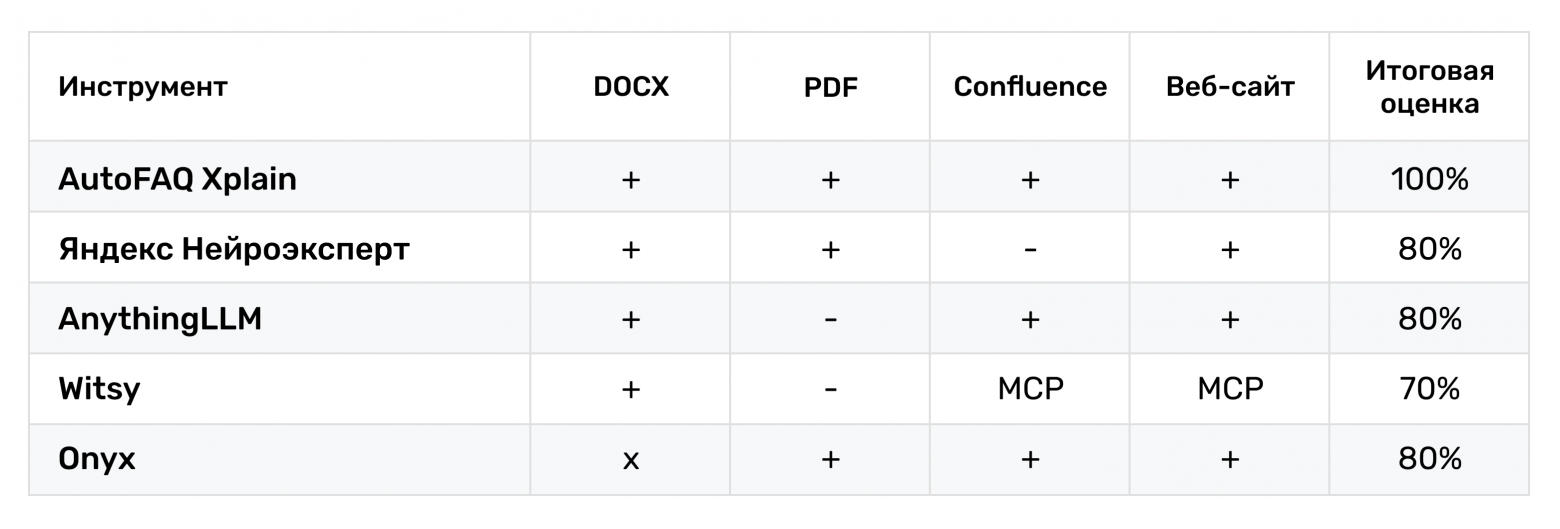

Разминка: Кто смог подключиться?

Первый подход к снарядам и самое базовое испытание — просто «съесть» предложенные источники. Если система не может прочитать и индексировать данные, то о качестве ответов говорить бессмысленно.

Уже на этом начальном этапе результаты оказались неоднородными. Например, амбициозный Onyx, который позиционируется как серьезное решение, по необъяснимой причине не смог загрузить базовый DOCX-файл.

AnythingLLM и Witsy дружно спасовали перед сканированным PDF — их встроенные инструменты оказались не готовы к распознаванию текста с изображений. Более того, Witsy для подключения к Confluence и веб-сайтам потребовал ручной настройки через отдельный компонент MCP (Managed Content Platform). Тут точно потребуются дополнительные технические навыки и время для настройки.

Стометровка с препятствиями: экзамен на точность и полноту

Часть претендентов не справилась с загрузкой данных, но это была лишь разминка. Теперь начинается главное — проверка качества ответов. Это самый критичный критерий, потому что RAG-система, которая врет, недоговаривает или фантазирует, это не инструмент, а скорее вредитель.

Мы сразу решили, что субъективных оценок в духе «нравится — не нравится» будет недостаточно. Чтобы получить объективные данные, разработали и применили систему слепого тестирования.

Каждой из пяти систем мы задавали одинаковые вопросы по каждому источнику данных. Полученные ответы анонимизировали и передали на оценку четырем «судьям»:

-

Два независимых эксперта (Человек 1 и Человек 2): Живые специалисты, которые оценивают не только формальное соответствие текста источнику, но и смысловые нюансы, логику и адекватность ответа. Чтобы минимизировать риск предвзятости, все ответы систем передавались экспертам в обезличенном текстовом виде. Таблицы с результатами формировались так, что в них отсутствовали любые указания на то, какой системой сгенерирован тот или иной ответ, без скриншотов интерфейса. Таким образом, человек видел только текст ответа и исходный документ, что исключало влияние бренда или ожиданий от конкретной модели.

-

Две нейросети-оценщика (GPT-4.1 и o4-mini): AI-экзаменаторы, настроенные на поиск фактических несоответствий, оценку полноты и выявление «галлюцинаций».

Каждый ответ оценивался по двум ключевым метрикам:

-

Точность (Precision): Насколько информация в ответе соответствует исходному документу? Нет ли выдуманных фактов или искажений?

-

Полнота (Recall): Раскрывает ли ответ все аспекты вопроса? Не упустила ли система важные детали и ссылается ли на источник?

На основе этих метрик мы вычисляли F1-меру — гармоническое среднее, интегральный показатель, который учитывает и точность, и полноту. Он не позволяет «схитрить», выдав точный, но бесполезный короткий ответ.

Примеры ответов разных систем на один и тот же вопрос, а также все исходные данные, код и инструкции по повторению эксперимента можно скачать GitHub.

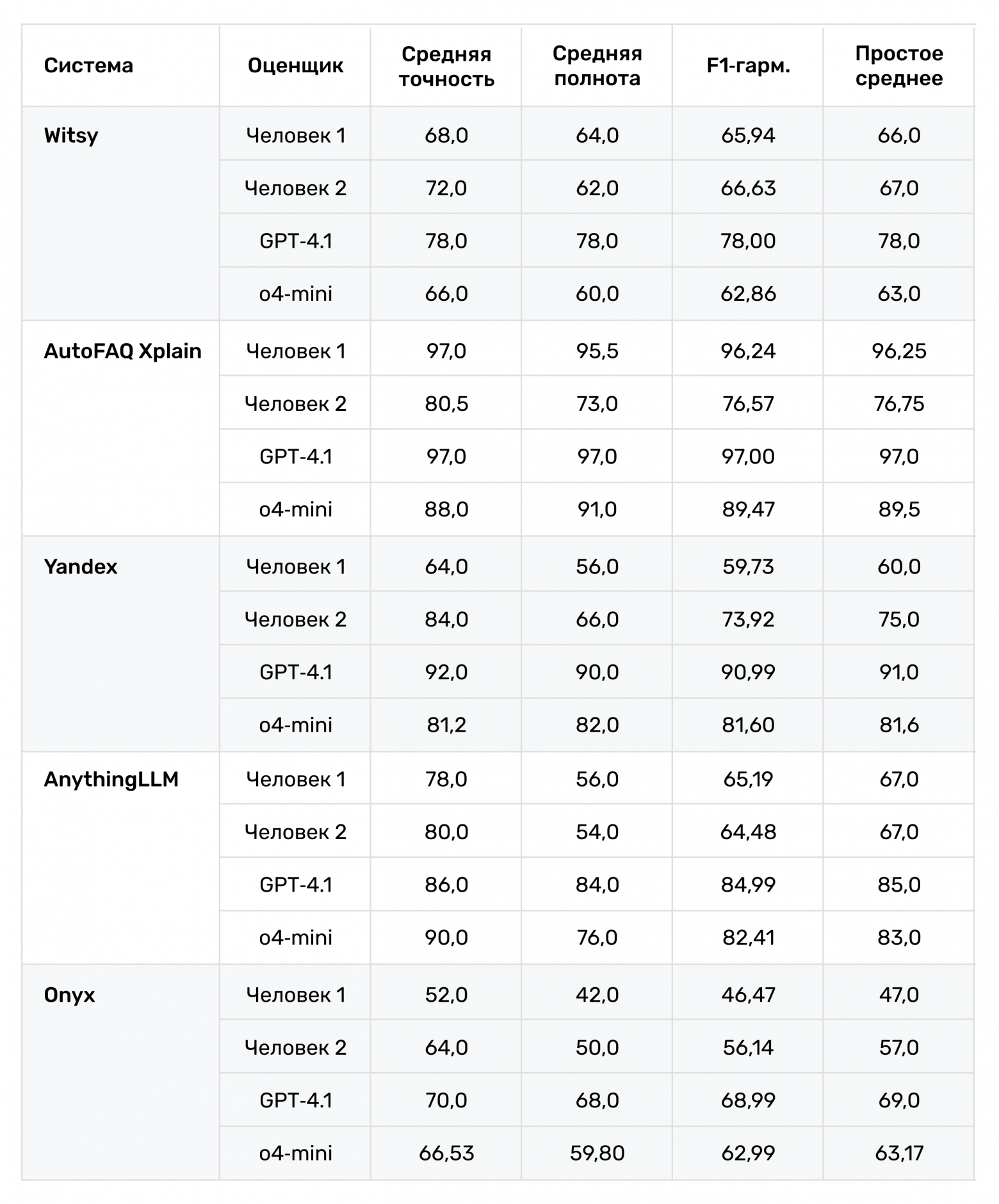

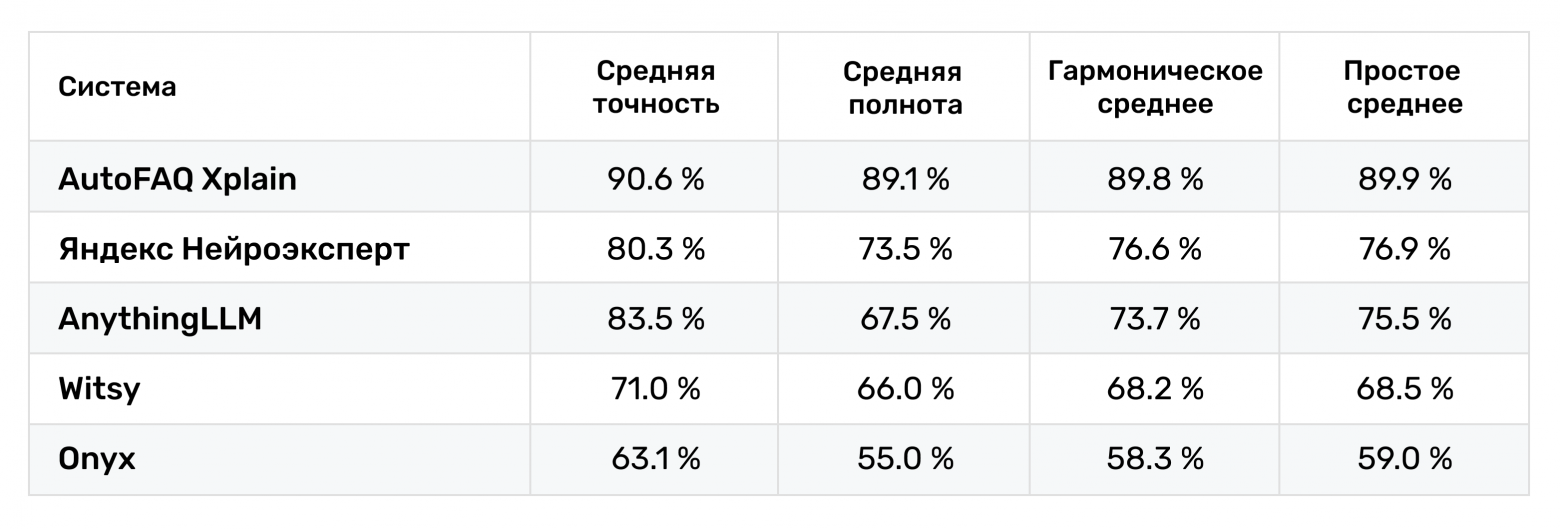

Результаты: стабильность решает все

После сбора и обработки всех оценок от людей и нейросетей картина стала предельно ясной и местами неожиданной.

Но средний бал, как средняя температура по больнице: он скрывает много интересного. Например, он не отражает, насколько стабильно работала система. Может, высокий средний балл — результат одного отличного ответа и пяти провальных? Тут нам поможет боксплот, или диаграмма размаха.

Этот график — самая интересная часть исследования. Посмотрите на AutoFAQ Xplain: его «ящик» не просто находится выше всех, он еще и самый компактный. Это значит, что ответы были не просто хорошими в среднем, а стабильно хорошими. Разброс оценок минимален.

А теперь проанализируем остальных. У Witsy, AnythingLLM и Onyx огромные «хвосты» и отдельные точки-выбросы в нижней части графика. Это наглядная иллюстрация нестабильности: ответы были как удачными, так и откровенно провальными. Система могла выдать хороший ответ, а на следующем вопросе получалось нечто совершенно нерелевантное.

Стабильность — ключевая характеристика любой бизнес-системы. Вам нужен инструмент, который работает надежно всегда, а не только когда у него хорошее настроение. Этот график безжалостно показывает, кто склонен к непредсказуемым результатам, а кто просто стабильно делает свою работу.

Финишная прямая: сложность запуска и скрытые возможности

Итак, у нас есть явный лидер по качеству и стабильности ответов, но даже самый умный ИИ-ассистент бесполезен, если его невозможно внедрить в рабочие процессы. Можно ли вообще пользоваться системой без команды DevOps-инженеров и многомесячной подготовки?

Давайте быстро разберем важные практические аспекты: простоту развертывания и наличие enterprise-функций, которые отличают игрушку от рабочего инструмента.

Простота развертывания

Разброс здесь оказался ничуть не меньше, чем в качестве ответов. Путь от «скачать» до «работает» у каждого участника свой, и порой весьма длинный.

-

Проще всего стартовать с Яндекс Нейроэксперта: открыл, загрузил документ, начал задавать вопросы. Идеально для быстрого поиска информации и простых задач, но вряд ли можно внедрить в масштабах крупной компании.

-

Десктопные Witsy и AnythingLLM чуть сложнее: нужно скачать и установить приложение, получить API-ключ от нужной LLM.

-

А вот дальше начинаются нюансы. Onyx — история для любителей хардкора. Он разворачивается через Docker Compose, и мы столкнулись с проблемами прокси и необходимостью ручной настройки. Без технической подготовки и готовности читать документацию не обойтись.

-

AutoFAQ Xplain в облачной версии запускается по заявке и сразу готов к работе, а on-premise вариант, естественно, потребует ресурсов на развертывание, но это ожидаемо для корпоративного решения.

Enterprise-готовность: неожиданно узкий круг

Даже если вы успешно развернули систему, это не конец истории. Если нужен ассистент для команды, а не для личных экспериментов, с разделением прав, интеграцией в корпоративные мессенджеры и гарантиями безопасности, круг претендентов сужается практически до одного.

Когда мы заглянули под капот, оказалось, что большинство участников — инструменты для индивидуального использования. Яндекс Нейроэксперт полностью ориентирован на персональные задачи. AnythingLLM и Witsy позволяют подключать локальные модели через Ollama, что хорошо для энтузиастов, но у них нет средств для командной работы.

Onyx делает шаг в нужную сторону: позволяет управлять пользователями и работать через браузер. Теоретически на его базе можно построить командное решение, но это потребует значительных усилий по настройке и доработке.

И только AutoFAQ Xplain предлагает полный набор enterprise-функций «из коробки». Он разворачивается как в облаке, так и полностью в локальной инфраструктуре (on-premise). Изначально спроектирован для командной работы: есть разграничение прав доступа, управление пользователями и готовые интеграции с Telegram, WhatsApp и веб-виджетами. Это единственный участник, который готов к внедрению в бизнес-процессы без долгой доработки.

Выводы: так что же выбрать?

Наше расследование подошло к концу. Мы не просто изучили лендинги, а прогнали пять RAG-систем через реалистичную полосу препятствий. Проверили их способность подключаться к разнородным корпоративным данным и главное измерили качество ответов с беспристрастностью машины, используя как человеческих экспертов, так и AI-оценщиков. Признаемся, волновались на старте, что наша система уступит более известным аналогам, по итогам гордимся такими классными показателями.

Пора подводить итоги и отвечать на главный вопрос: что выбрать для своих задач?

Но сухие цифры — лишь часть истории. Наш финальный вердикт основан на совокупности всех факторов: от качества ответов до готовности к реальному внедрению.

-

Для корпоративного внедрения: Если нужна надежная, стабильная и точная система для решения бизнес-задач, которая переваривает разные источники данных, готова к интеграции с каналами общения и обеспечивает необходимый уровень безопасности, тогда выбор очевиден: AutoFAQ Xplain. Наши тесты, и особенно детальный анализ точности и стабильности, показали, что это самое сбалансированное и готовое к продакшену решение.

-

Для быстрых экспериментов и личных задач: Яндекс Нейроэксперт — ваш выбор. Максимально простой, бесплатный и не требующий установок. Идеальный инструмент, чтобы быстро попробовать технологию, проверить гипотезу на своих документах и понять, нужен ли вам RAG в принципе.

-

Для энтузиастов: Если любите копаться в коде, мечтаете подключить к документам локальную LLM через Ollama и не боитесь ручной настройки — смотрите в сторону AnythingLLM и Witsy. Отличные «песочницы» для экспериментов и личных проектов, но их использование в серьезном продакшене потребует значительных доработок.

-

Для опытных DevOps-команд: Onyx может стать мощным инструментом в правильных руках, но готовьтесь вложить существенные усилия в развертывание, настройку и поддержку. Это выбор для тех, кто любит полный контроль над системой, но низкие оценки качества ответов говорят о том, что работы предстоит много.

Взгляд в будущее

Выбор RAG-инструмента — это поиск компромисса между простотой, стоимостью, гибкостью и надежностью. Но наше исследование ясно показывает: дьявол кроется в деталях. И главная деталь, не длина списка поддерживаемых функций, а стабильность и доказуемая точность ответов.

По мере того как ажиотаж вокруг LLM будет спадать, именно эти метрики станут главным полем битвы за корпоративного клиента. Потому что в бизнесе цена одной «галлюцинации» может перечеркнуть все преимущества технологии.

А как и какими RAG-системами пользуетесь вы? С какими проблемами или приятными открытиями сталкивались? Делитесь опытом в комментариях.

Автор: lytr